26 أغسطس 2025·8 دقيقة

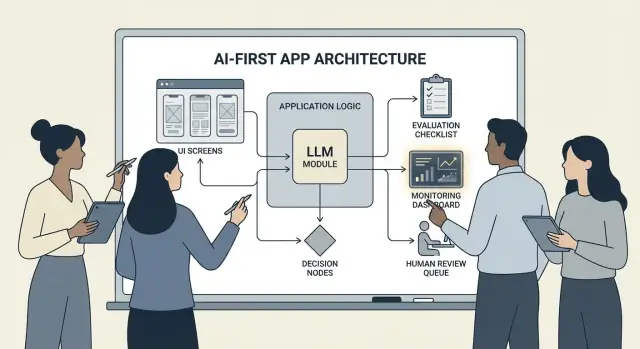

كيفية بناء منتجات تركز على الذكاء الاصطناعي عبر تضمين النماذج في منطق التطبيق

دليل عملي لبناء منتجات تعتمد على الذكاء الاصطناعي بحيث يقود النموذج القرارات: الهندسة المعمارية، المطالبات، الأدوات، البيانات، التقييم، السلامة، والمراقبة.

ماذا يعني بناء منتج يضع الذكاء الاصطناعي في المقام الأول

بناء منتج يضع الذكاء الاصطناعي في المقام الأول لا يعني "إضافة دردشة روبوت" فحسب. المقصود أن يكون النموذج جزءًا حقيقيًا وفعّالًا من منطق التطبيق — تمامًا مثل محرك قواعد، أو فهرس بحث، أو خوارزمية توصية.

تطبيقك لا يقتصر على استخدام الذكاء الاصطناعي؛ بل مصمم حول حقيقة أن النموذج سيفسر المدخلات، يختار الإجراءات، وينتج مخرجات مُنظمة يعتمد عليها بقية النظام.

عمليًا: بدلًا من ترميز كل مسار قرار يدويًا ("إذا حدث X فافعل Y"), تترك للنموذج التعامل مع الأجزاء الغامضة — اللغة، النوايا، الالتباس، الأولويات — بينما يتولى كودك ما يجب أن يكون دقيقًا: الأذونات، المدفوعات، عمليات الكتابة في قاعدة البيانات، وتطبيق السياسات.

متى يكون نهج "الذكاء الاصطناعي أولًا" مناسبًا (ومتى لا يكون)

ينجح هذا النهج عندما تكون المشكلة:

- تتضمن مدخلات عديدة وصعبة (نص حر، مستندات فوضوية، أهداف مستخدم متباينة)

- يوجد عدد كبير من حالات الحافة التي يصعب صيانتها بقواعد يدوية

- تكون القيمة في الحكم، التلخيص، أو التوليف بدلًا من الحتمية المطلقة

الأتمتة القائمَة على القواعد غالبًا ما تكون أفضل عندما تكون المتطلبات مستقرة ودقيقة — حسابات ضريبية، منطق المخزون، فحوص الأهلية، أو سير عمل الامتثال حيث يجب أن تكون النتيجة نفسها دائمًا.

أهداف المنتج الشائعة التي يدعمها نهج "الذكاء الاصطناعي أولًا"

الفرق عادةً تعتمد منطقًا مدفوعًا بالنموذج من أجل:

- زيادة السرعة: مسودات الردود، استخراج الحقول، توجيه الطلبات بشكل أسرع

- تخصيص التجارب: تكييف الشروحات، الخطط، أو التوصيات

- دعم القرارات: إبراز مقايضات، توليد خيارات، تلخيص الأدلة

المقايضات التي يجب قبولها (وتصميم حلول لها)

النماذج يمكن أن تكون غير متوقعة، أحيانًا تُخطئ بثقة، وقد يتغير سلوكها مع تغيّر المطالبات، المزودين، أو السياق المسترجَع. كما أنها تزيد التكلفة لكل طلب، قد تضيف زمن استجابة، وتثير مخاوف تتعلق بالسلامة والثقة (الخصوصية، المخرجات الضارة، انتهاكات السياسات).

العقلية الصحيحة: اعتبر النموذج مكوّنًا، لا صندوق إجابات سحري. عاملها كاعتمادية لها مواصفات، أوضاع فشل، اختبارات ومراقبة — حتى تحصل على المرونة دون أن تراهن على المنتج بأملٍ بلا أساس.

اختر حالة الاستخدام المناسبة وعرّف النجاح

ليس كل ميزة تستفيد من وضع النموذج في مقعد السائق. أفضل حالات "الذكاء الاصطناعي أولًا" تبدأ بمهمة واضحة وتنتهي بنتيجة قابلة للقياس يمكنك تتبعها أسبوعًا بعد أسبوع.

ابدأ بالمهمة، لا بالنموذج

اكتب جملة قصة مهمة واحدة: "عندما ___ أرغب في ___ لكي أتمكن من ___". ثم اجعل النتيجة قابلة للقياس.

مثال: "عندما أتلقى بريدًا طويلًا من عميل، أرغب في اقتراح رد يتوافق مع سياساتنا، لأتمكن من الرد خلال أقل من دقيقتين." هذا أوضح بكثير من "أضف نموذجًا".

ارسم نقاط القرار

حدّد اللحظات التي سيختار فيها النموذج الإجراءات. يجب أن تكون هذه نقاط القرار صريحة حتى تتمكن من اختبارها.

تشمل نقاط القرار الشائعة:

- تصنيف النية وتوجيهها لسير العمل الصحيح

- تقرير ما إذا كان يجب طرح سؤال توضيحي أم المتابعة

- اختيار الأدوات (بحث، استعلام CRM، صياغة، إنشاء تذكرة)

- تقرير متى يتم تصعيد المسألة إلى إنسان

إن لم تستطع تسمية القرارات، فلا تكون جاهزًا لإطلاق منطق مدفوع بالنموذج.

اكتب معايير قبول للسلوك

عامل سلوك النموذج كأي متطلب منتج آخر. حدّد ما يعني "جيد" و"سيء" بلغة بسيطة.

على سبيل المثال:

- جيد: يستخدم السياسة الأحدث، يستدل على رقم الطلب الصحيح، يطلب سؤالًا واحدًا واضحًا عند نقص المعلومات

- سيء: يخترع خصومات، يشير إلى ولايات/بلدان غير مدعومة، أو يجيب دون التحقق من البيانات المطلوبة

تصبح هذه المعايير أساس مجموعة التقييم لاحقًا.

حدد القيود مبكرًا

سجّل القيود التي تشكّل اختيارات التصميم:

- الوقت (أهداف زمن الاستجابة)

- الميزانية (تكلفة كل مهمة)

- الامتثال (معالجة المعلومات الشخصية، متطلبات السجل)

- اللغات المدعومة (اللغات، النبرة، التوقعات الثقافية)

عرّف مقاييس النجاح التي يمكنك مراقبتها

اختر مجموعة صغيرة من المقاييس المرتبطة بالمهمة:

- معدل إتمام المهام

- الدقة (أو الالتزام بالسياسة) في حالات ممثلة

- رضا العملاء أو تقييمات نوعية

- الوقت الموفر لكل مهمة (أو زمن حلّ المسألة)

إن لم تستطع قياس النجاح، ستنتهي بالمجادلة حول الانطباعات بدل تحسين المنتج.

صمم تدفّق المستخدم المدفوع بالنموذج وحدود النظام

تدفّق "الذكاء الاصطناعي أولًا" ليس مجرد "شاشة تستدعي نموذجًا". هو رحلة شاملة حيث يتخذ النموذج قرارات معينة، ينفّذ المنتج هذه القرارات بأمان، ويبقى المستخدم متمركزًا.

ارسم الحلقة الشاملة من البداية للنهاية

ابدأ برسم أنبوب المعالجة كسلسلة بسيطة: المدخلات → النموذج → الإجراءات → المخرجات.

- المدخلات: ما يقدمه المستخدم (نص، ملفات، اختيارات) بالإضافة إلى سياق التطبيق (فئة الحساب، مساحة العمل، النشاط الأخير).

- خطوة النموذج: ما الذي يتحمّله النموذج من قرارات (تصنيف، صياغة، تلخيص، اختيار الإجراء التالي).

- الإجراءات: ماذا قد يفعل نظامك (بحث، إنشاء مهمة، تحديث سجل، إرسال بريد إلكتروني).

- المخرجات: ما يراه المستخدم (مسودة، شرح، شاشة تأكيد، خطأ مع خطوات لاحقة).

خرائط كهذه تجبرك على وضوح أين يكون عدم اليقين مقبولًا (الصياغة) وأين لا يكون (تغييرات الفوترة).

ارسم حدود النظام: النموذج مقابل الشيفرة الحتمية

فصل المسارات الحتمية (فحوص الأذونات، قواعد الأعمال، الحسابات، عمليات كتابة قواعد البيانات) عن القرارات المدفوعة بالنموذج (التفسير، الأولويات، التوليد باللغة الطبيعية).

قاعدة مفيدة: يمكن للنموذج أن يُوصي، لكن يجب أن يتحقق الكود قبل أي إجراء لا رجعة فيه.

قرّر أين سيعمل النموذج

اختَر وقت التشغيل بناءً على القيود:

- الخادم: أفضل للبيانات الخاصة، أدوات ثابتة، وسجلات التدقيق.

- العميل: مفيد للمساعدة الخفيفة والخصوصية المحلية، لكن أصعب في التحكم.

- الطرف الحافة: زمن استجابة أسرع عالميًا، لكن اعتماديات محدودة.

- هجينة: قسّم الكشف السريع عن النية على الحافة والأعمال الثقيلة على الخادم.

أدِر ميزانية زمن الاستجابة، التكلفة، وأذونات البيانات

حدّد ميزانية زمن/تكلفة لكل طلب (تشمل محاولات الإعادة واستدعاءات الأدوات)، ثم صمم تجربة المستخدم حولها (البث التدريجي، نتائج متدرجة، "استمر في الخلفية").

وثّق مصادر البيانات والأذونات المطلوبة في كل خطوة: ما الذي يمكن للنموذج قراءته، ما الذي يمكنه كتابته، وما الذي يتطلّب موافقة صريحة من المستخدم. هذا يصبح عقدًا لكلٍّ من الهندسة والثقة.

أنماط البنية: التنسيق، الحالة، والتتبّعات

عندما يصبح النموذج جزءًا من منطق التطبيق، "البنية" ليست مجرد خوادم وواجهات برمجة تطبيقات — بل كيفية تشغيل سلسلة من قرارات النموذج بشكل موثوق دون فقدان السيطرة.

التنسيق: قائد عمل المهام الذكية

التنسيق هو الطبقة التي تدير كيفية تنفيذ مهمة الذكاء الاصطناعي من البداية للنهاية: المطالبات والقوالب، استدعاءات الأدوات، الذاكرة/السياق، محاولات الإعادة، مهلات زمنية، وخطط الطوارئ.

المنسقون الجيدون يعاملون النموذج كمكوّن واحد في خط أنابيب. يقرّرون أي مطالبة تُستخدم، متى تُستدعى أداة (بحث، قاعدة بيانات، بريد إلكتروني، دفع)، كيف يُضغط أو يُجلب السياق، وماذا يحدث لو أعاد النموذج شيئًا غير صالح.

إذا رغبت في التحرك بسرعة من فكرة إلى تنسيق عملٍ شغّال، فإن سير عمل prototyping عبر واجهة محادثة قد يساعدك على نمذجة هذه الأنابيب دون إعادة بناء هيكل التطبيق من الصفر. على سبيل المثال، Koder.ai تتيح للفرق إنشاء تطبيقات ويب (React)، وخلفيات (Go + PostgreSQL)، وحتى تطبيقات موبايل (Flutter) عبر الدردشة — ثم التكرار على تدفقات مثل "المدخلات → النموذج → استدعاءات الأدوات → التحقق → واجهة المستخدم" مع ميزات مثل وضع التخطيط، اللقطات، والتراجع، بالإضافة لتصدير كود المصدر عند الاستعداد لامتلاك المستودع.

آلات الحالة للمهام متعددة الخطوات

التجارب متعددة الخطوات (الفرز → جمع المعلومات → التأكيد → التنفيذ → التلخيص) تعمل بشكل أفضل عندما تُنمذج كمسار عمل أو آلة حالة.

نمط بسيط: كل خطوة لها (1) المدخلات المسموح بها، (2) المخرجات المتوقعة، و(3) الانتقالات. هذا يمنع المحادثات الشرودة ويجعل حالات الحافة صريحة — مثل ماذا يحدث إذا غيّر المستخدم رأيه أو قدّم معلومات جزئية.

التفكير لمرة واحدة مقابل التفكير متعدد الجولات

المهام المنجزة في طلقة واحدة مناسبة للمهام المحصورة: تصنيف رسالة، صياغة رد قصير، استخراج حقول من مستند. أرخص، أسرع، وأسهل للتحقق.

التفكير متعدد الجولات أفضل عندما يحتاج النموذج لطرح أسئلة توضيحية أو عندما تكون الأدوات مطلوبة تكراريًا (مثل: التخطيط → البحث → الصقل → التأكيد). استخدمه بتعمّد، وحدّ الحلقات بحدود زمن/خطوات.

قابلية التكرار Idempotency: تجنّب الآثار الجانبية المتكررة

النماذج قد تعيد المحاولة. الشبكات تفشل. المستخدمون ينقرون مرتين. إذا كانت خطوة الذكاء الاصطناعي يمكن أن تُولّد آثارًا جانبية — إرسال بريد إلكتروني، حجز، تحصيل مبلغ — اجعلها قابلة للتكرار بلا تأثير مضاعف.

تكتيكات شائعة: ربط كل إجراء تنفيذي بمفتاح قابلية التكرار، تخزين نتيجة الإجراء، والتأكد أن المحاولات تعيد نفس النتيجة بدلًا من تكرارها.

التتبّعات: اجعل كل خطوة قابلة للتصحيح

أضف تتبّعًا حتى تتمكن من الإجابة: ماذا رأى النموذج؟ ماذا قرّر؟ ما الأدوات التي تم تشغيلها؟

سجّل تتبّعًا مُهيكلاً لكل تنفيذ: نسخة المطالبة، المدخلات، معرفات السياق المُسترجَع، طلبات الأدوات/استجاباتها، أخطاء التحقق، المحاولات، والمخرجات النهائية. هذا يحوّل "النموذج فعل شيئًا غريبًا" إلى سجل قابل للتدقيق والإصلاح.

المطالبات كمَنْطق منتج: عقود وصيغ واضحة

عندما يصبح النموذج جزءًا من منطق التطبيق، تتوقف المطالبات عن كونها "نصًا" وتصبح مواصفات قابلة للتنفيذ. عاملها كمُتطلبات منتج: نطاق صريح، مخرجات متوقعة، وضبط للتغيير.

ابدأ بمطالبة نظام تحدد العقد

يجب أن تحدد مطالبة النظام دور النموذج، ما الذي يمكنه ولا يمكنه فعله، وقواعد السلامة المهمة لمنتجك. اجعلها مستقرة وقابلة لإعادة الاستخدام.

أدرج:

- الدور والهدف: من يكون (مثلاً: "مساعد فرز الدعم") وما شكل النجاح

- حدود النطاق: ما الطلبات التي يجب رفضها أو تصعيدها

- قواعد السلامة: معالجة المعلومات الشخصية، إخلاءات المسؤولية الطبية/القانونية، عدم التخمين

- سياسة الأدوات: متى يستدعي الأدوات مقابل الإجابة مباشرة

هيكل المطالبات بمداخل/مخرجات واضحة

اكتب المطالبات كتعريف واجهة برمجة: عيّن المدخلات الدقيقة التي تقدمها (نص المستخدم، فئة الحساب، اللغة، مقتطفات السياسة) والمخرجات المتوقعة بالضبط. أضف 1–3 أمثلة تتطابق مع حركة المرور الحقيقية، بما في ذلك حالات الحافة الصعبة.

نمط مفيد: السياق → المهمة → القيود → صيغة المخرجات → أمثلة.

استخدم صيغًا مقيدة لنتائج قابلة للقراءة برمجيًا

إذا كان الكود سيعمل على المخرج، فلا تعتمد على النثر. اطلب JSON مطابقًا لمخطط وارفض غير ذلك.

{

"type": "object",

"properties": {

"intent": {"type": "string"},

"confidence": {"type": "number", "minimum": 0, "maximum": 1},

"actions": {

"type": "array",

"items": {"type": "string"}

},

"user_message": {"type": "string"}

},

"required": ["intent", "confidence", "actions", "user_message"],

"additionalProperties": false

}

version المُطالبات وطرِحها بأمان

خزن المطالبات في نظام مراقبة الإصدارات، ضع وسمًا للإصدار، واطرحها مثل الميزات: نشر تدريجي، اختبار A/B عند الاقتضاء، وتراجع سريع. سجّل نسخة المطالبة مع كل استجابة للتصحيح.

ابنِ مجموعة اختبار للمطالبات

أنشئ مجموعة صغيرة وممثلة من الحالات (مسار السعادة، طلبات غامضة، انتهاكات سياسة، مدخلات طويلة، لغات مختلفة). شغّلها تلقائيًا عند كل تغيير في المطالبات، وافشل البناء عندما تُخرق المخرجات العقد.

استدعاء الأدوات: دع النموذج يقرر ودع الكود ينفّذ

أنشئ نموذجًا أوليًا للذكاء الاصطناعي بسرعة

ابنِ سير عمل مُركّز على الذكاء الاصطناعي عبر المحادثة، ثم طوِّره بأمان باستخدام لقطات والتراجع.

استدعاء الأدوات هو أنظف طريقة لتقسيم المسؤوليات: النموذج يقرر ماذا يجب أن يحدث وأي قدرة تُستخدم، بينما كود التطبيق ينفّذ الإجراء ويعيد نتائج مُحقّقة.

وهذا يُبقي الحقائق، الحسابات، والآثار الجانبية (إنشاء تذاكر، تحديث سجلات، إرسال بريد) في كود حتمي، قابل للمراجعة، بدل الاعتماد على نصٍ حر.

صمّم مجموعة أدوات صغيرة ومقصودة

ابدأ بقِلة من الأدوات التي تغطّي 80% من الطلبات وسهلة التأمين:

- بحث (مركز المساعدة/الوثائق) للإجابة عن أسئلة المنتج

- استعلام قاعدة بيانات (قراءة فقط أولًا) لحالة المستخدم/الحساب/الطلب

- حاسبة للأسعار، الإجماليات، التحويلات، والرياضيات القائمة على قواعد

- نظام تذاكر لفتح طلبات دعم عندما يحتاج المستخدم متابعَة بشرية

اجعل غرض كل أداة ضيقًا. الأداة التي تفعل "كل شيء" تصبح صعبة الاختبار وسهلة الإساءة.

تحقق من المدخلات ونقّح المخرجات

عامل النموذج كمتصل غير موثوق.

- تحقق من مدخلات الأدوات بمخططات صارمة (أنواع، نطاقات، قوائم ثابتة). ارفض أو صحّح الوسائط غير الآمنة (مثلاً، معرفات مفقودة، استعلامات واسعة جدًا).

- نقّح مخرجات الأدوات قبل إرجاعها للنموذج: أزل الأسرار، ونوّع الصيغ، وارجع الحقول التي يحتاجها النموذج فقط.

هذا يقلل مخاطر حقن المطالبات عبر النص المسترجَع ويحد من تسرب البيانات العرضي.

أضف أذونات وحدود معدل لكل أداة

ينبغي لكل أداة أن تفرض:

- فحوص أذونات (من يستطيع الوصول لأي سجل، لأي إجراء)

- حدود معدل (لكل مستخدم/جلسة/أداة) لتقليل الإساءة والحلقات المفتوحة

إذا كانت الأداة تغيّر الحالة (تذاكر، ردود مالية)، فاطلب تفويضًا أقوى وسجل سجل تدقيق.

دائمًا ادعم مسار "لا أداة"

أحيانًا يكون أفضل إجراء هو لا إجراء: الإجابة من السياق المتاح، طرح سؤال توضيحي، أو شرح القيود. اجعل خيار "عدم استدعاء أداة" نتيجة مُعترفًا بها كي لا يستدعي النموذج الأدوات ليبدو مشغولًا.

البيانات وRAG: اجعل النموذج مؤسَّسًا على واقعك

إذا كانت إجابات منتجك يجب أن تطابق سياساتك، المخزون، العقود، أو المعرفة الداخلية، تحتاج طريقة لتأصيل النموذج في بياناتك — وليس فقط في تدريبه العام.

RAG مقابل الضبط الدقيق مقابل السياق البسيط

- السياق البسيط (لصق بضعة فقرات في المطالبة) يعمل عندما تكون المعلومة صغيرة، مستقرة، ويمكن إرسالها كل مرة (مثل جدول أسعار قصير).

- RAG (التوليد المعزز بالاسترجاع) أفضل عندما تكون المعلومات كبيرة، متغيرة بكثرة، أو تحتاج استشهادات (مقالات مركز المساعدة، وثائق المنتج، بيانات حسابية).

- الضبط الدقيق (fine-tuning) مفيد عندما تريد أسلوبًا/صيغة ثابتة أو أنماط متخصصة — ليس كطريقة أساسية لتخزين الحقائق. استخدمه لتحسين طريقة كتابة النموذج واتباع قواعدك؛ وامزجه مع RAG للحفاظ على الحقائق حتى اللحظة.

أساسيات الاستخلاص: التقسيم، البيانات الوصفية، والحداثة

جودة RAG هي في الغالب مشكلة استيعاب.

قسم المستندات إلى قطع مناسبة لحجم النموذج (غالبًا بضع مئات من الرموز)، ويفضل أن تكون متوافقة مع حدود طبيعية (عناوين، إدخالات الأسئلة الشائعة). خزّن بيانات وصفية مثل: عنوان المستند، عنوان القسم، إصدار المنتج/النسخة، الجمهور، اللغة، والأذونات.

خطط للـحداثة: جدولة إعادة الفهرسة، تتبّع "آخر تحديث"، وانتهاء صلاحية القطع القديمة. قطعة قديمة تحتل مرتبة عالية ستضعف الميزة بصمت.

الاستشهادات والإجابات المعيَّرة

اطلب من النموذج الاستشهاد بالمصادر بإرجاع: (1) الإجابة، (2) قائمة بمعرفات/روابط المقتطفات، و(3) عبارة عن الثقة.

إذا كان الاسترجاع ضعيفًا، ارشد النموذج ليقول ما لا يستطيع تأكيده ويقترح خطوات لاحقة ("لم أعثر على هذه السياسة؛ تواصل مع..."). تجنّب السماح له بملء الفراغات.

البيانات الخاصة: ضوابط الوصول والتنقيح

نفّذ التحكم في الوصول قبل الاسترجاع (تصفية بحسب أذونات المستخدم/المنظمة) ومرةً أخرى قبل التوليد (تنقيح الحقول الحساسة).

عامل المتجهات والفهارس كمخزن بيانات حساس مع سجلات تدقيق.

عند فشل الاسترجاع: تراجعات أنيقة

إذا كانت النتائج العليا غير ملائمة أو خالية، تراجع إلى: طرح سؤال توضيحي، توجيه إلى دعم بشري، أو التحول إلى وضع استجابة غير RAG يشرح القيود بدل التخمين.

الاعتمادية: قواعد حماية، التحقق، والتخزين المؤقت

عندما يجلس النموذج داخل منطق تطبيقك، "جيد في معظم الأوقات" لا يكفي. الاعتمادية تعني أن المستخدمين يرون سلوكًا متسقًا، وأن نظامك يمكنه استهلاك المخرجات بأمان، وأن الأعطال تتدهور برفق.

عرّف أهداف الاعتمادية (قبل إضافة الإصلاحات)

سجّل ما يعنيه "موثوق" للميزة:

- مخرجات متسقة: المدخلات المماثلة يجب أن تنتج إجابات متقاربة (النبرة، مستوى التفاصيل، القيود).

- صيغ مستقرة: يجب أن تكون الاستجابة قابلة للمعالجة دائمًا (JSON، قائمة، حقول محددة).

- سلوك محدود: حدود واضحة لما يجب أن يفعله النموذج (لا تخمين، الاستشهاد بالمصادر، طرح سؤال عند عدم اليقين).

تصبح هذه الأهداف معايير قبول لكل من المطالبات والكود.

قواعد الحماية: تحقق، فلترة، وفرض السياسات

عامل مخرجات النموذج كمدخل غير موثوق.

- التحقق بمخطط: اطلب صيغة صارمة (مثل JSON بمفاتيح مطلوبة) وارفُض أي شيء لا يمرّ.

- مرشحات المحتوى: شغّل فحوص سبّ، كاشفات بيانات شخصية، أو مدققات سياسة على كل من مدخلات المستخدم ومخرجات النموذج.

- قواعد الأعمال: فرض القيود في الشيفرة (نطاقات الأسعار، قواعد الأهلية، الإجراءات المسموح بها)، حتى لو ذُكرت في المطالبة.

إن فشل التحقق، أعد مخرجًا آمنًا (اطرح سؤال توضيحي، انتقل إلى قالب أبسط، أو وجّه إلى إنسان).

محاولات الإعادة التي تفيد فعلاً

تجنّب التكرار الأعمى. أعد المحاولة بمطالبة معدّلة تعالج وضع الفشل:

- "أرجو إرجاع JSON صالح فقط. لا يوجد ماركداون."

- "إذا لم تكن متأكدًا، ضع

confidenceمنخفض واطرح سؤالًا واحدًا."

حدد حدًا لعدد المحاولات وسجّل سبب كل فشل.

معالجة حتمية ما بعد المعالجة

استخدم الكود لتطبيع ما يُنتجه النموذج:

- توحيد الوحدات، التواريخ، والأسماء

- إزالة التكرارات

- تطبيق قواعد الترتيب أو العتبات

هذا يقلل التباين ويجعل المخرجات أسهل للاختبار.

التخزين المؤقت دون خلق مشكلات خصوصية

خزّن النتائج المتكررة (طلبات متطابقة، تضمينات مشتركة، استجابات الأدوات) لخفض التكلفة وزمن الاستجابة.

فضّل:

- TTL قصير للبيانات الخاصة بالمستخدم

- مفاتيح تخزين لا تحتوي على بيانات شخصية خام (أو تجزئها بعناية)

- علامات "لا يخزن" للمسارات الحساسة

مُنفَّذٌ جيدًا، التخزين المؤقت يعزز الاتساق ويحافظ على ثقة المستخدم.

السلامة والثقة: خفّف المخاطر دون قتل تجربة المستخدم

ابنِ خطوط سير للتنسيق

حوّل المدخلات → النموذج → استدعاءات الأدوات إلى تدفق تطبيق حقيقي يمكن اختباره من الطرف إلى الطرف.

السلامة ليست طبقة امتثال تُثبت لاحقًا. في منتجات "الذكاء الاصطناعي أولًا"، النموذج قد يؤثر على الأفعال، الصياغة، والقرارات — لذا يجب أن تكون السلامة جزءًا من عقد المنتج: ما المسموح للمساعد القيام به، ما الذي يجب رفضه، ومتى يجب طلب المساعدة.

مخاوف السلامة الأساسية التي صمِّم من أجلها

سمّ المخاطر التي يواجهها تطبيقك فعليًا، ثم وضّح لكل منها ضابطًا:

- البيانات الحساسة: هويات شخصية، بيانات اعتماد، مستندات خاصة، وأي شيء تنظمه القوانين

- الإرشادات الضارة: تعليمات قد تُمكّن إيذاء الذات أو الآخرين، أنشطة غير قانونية، أو نصائح طبية/مالية خطيرة

- التحيّز والنتائج غير العادلة: تفاوت جودة الخدمة أو التوصيات بين المجموعات

المواضيع المسموحة/المقيّدة/المحجوبة ومسارات التصعيد

اكتب سياسة صريحة يمكن للمنتج فرضها. اجعلها ملموسة: فئات، أمثلة، والاستجابات المتوقعة.

استخدم ثلاثة مستويات:

- مسموح: أجب بشكل طبيعي.

- مقيَّد: أجب مع قيود (مثلاً معلومات عامة فقط، دون تعليمات خطوة بخطوة).

- محجوب: ارفض ووجّه إلى مسار تصعيد (دعم، موارد، أو إنسان).

يجب أن يكون التصعيد سيرَ تسليمٍ فعليًا، لا مجرد رسالة رفض. قدّم خيار "التحدث إلى شخص" وتأكد أن عملية التسليم تشتمل على السياق الذي شاركه المستخدم (بموافقته).

مراجعة بشرية للأفعال ذات التأثير العالي

إذا كان للنموذج القدرة على إحداث عواقب حقيقية — مدفوعات، ردِّ مبالغ، تغييرات حساب، إلغاء، حذف بيانات — أضف نقطة فحص بشري.

أنماط جيدة: شاشات تأكيد، "مسودة ثم اعتمد"، حدود (حدود مبالغ)، وطابور مراجعة بشرية للحالات الحافّة.

الإفصاحات والموافقة وسياسات قابلة للاختبار

أخبر المستخدمين عندما يتعاملون مع ذكاء اصطناعي، وما البيانات المستخدمة، وما المخزن. اطلب الموافقة عند الحاجة، خصوصًا عند حفظ المحادثات أو استخدام البيانات لتحسين النظام.

عامل سياسات السلامة الداخلية ككود: وازِن الإصدارات، وثّق المنطق، وأضِف اختبارات (مطالبات أمثلة + نتائج متوقعة) حتى لا تتراجع السلامة مع كل تغيير في المطالبات أو النماذج.

التقييم: اختبر النموذج كأي مكوّن حرج آخر

إذا كان نموذج اللغة يمكن أن يغيّر ما يفعله منتجك، فأنت بحاجة لطريقة قابلة للتكرار لإثبات أنه لا يزال يعمل — قبل أن يكتشف المستخدمون الانحدار.

عامل المطالبات، إصدارات النماذج، مخططات الأدوات، وإعدادات الاسترجاع كأجزاء تستحق اختبارًا قبل الإصدار.

ابنِ مجموعة تقييم من الواقع

اجمع نوايا المستخدمين الحقيقية من تذاكر الدعم، استعلامات البحث، سجلات الدردشة (بالموافقة)، ومكالمات المبيعات.حوّلها إلى حالات اختبار تتضمن:

- طلبات شائعة في مسار السعادة

- مطالب غامضة تتطلب أسئلة توضيحية

- حالات حافة (بيانات مفقودة، قيود متضاربة، صيغ غير عادية)

- سيناريوهات حساسة للسياسة (بيانات شخصية، محتوى ممنوع)

يجب أن تتضمن كل حالة السلوك المتوقع: الإجابة، القرار المتخذ (مثلاً: "استدعاء الأداة A"), وأي بنية مطلوبة (وجود حقول JSON، تضمين الاستشهادات، إلخ).

اختر مقاييس تتناسب مع مخاطر المنتج

لا تكفي نتيجة واحدة لقياس الجودة. استخدم مجموعة صغيرة من المقاييس التي تربط بنتائج المستخدم:

- الدقة / نجاح المهمة: هل حقق الهدف؟

- التأسيس: هل الادعاءات مدعومة بالسياق أو المصادر؟

- صلاحية الصيغة: هل المخرج مطابق للعقد (JSON، جدول، نقاط)؟

- معدل الرفض: هل يرفض عندما يجب—ويتجنب الرفض غير المبرر؟

تتبّع التكلفة وزمن الاستجابة مع الجودة؛ فالنموذج "الأفضل" الذي يضاعف زمن الاستجابة قد يضر التحويل.

شغّل تقييمات غير متصلة لكل تغيير

شغّل تقييمات غير حية قبل الإصدار وبعد كل تغيير في المطالبات، النموذج، الأدوات، أو الاسترجاع. خزّن النتائج لكي تقارن التشغيلات وسرعان ما تحدد ما انكسر.

أضف اختبارات مباشرة مع ضوابط أمان

استخدم اختبارات A/B لقياس نتائج حقيقية (معدل الإكمال، التعديلات، تقييمات المستخدم)، لكن أضف حواجز أمان: عرّف شروط التوقف (مثل ارتفاع مفاجئ في المخرجات غير الصالحة، الرفض، أو أخطاء الأدوات) وارجع تلقائيًا عند تجاوز العتبات.

المراقبة في الإنتاج: الانحراف، الإخفاقات، والتغذية الراجعة

أطلق تحت علامتك التجارية

ضع تطبيقك الموجه للذكاء الاصطناعي على نطاقك الخاص عندما يكون جاهزًا للمستخدمين.

إطلاق ميزة تعتمد على النموذج ليس النهاية. عند قدوم المستخدمين الحقيقيين، سيواجه النموذج تعابير جديدة، حالات حافة، وبيانات متغيرة. المراقبة تحوّل "عمل في البيئة التجريبية" إلى "استمرار العمل بعد شهر".

سجّل ما يهم (دون جمع أسرار)

التقط سياقًا كافيًا لإعادة إنتاج الأخطاء: نية المستخدم، نسخة المطالبة، استدعاءات الأدوات، والمخرجات النهائية للنموذج.

سجّل المدخلات/المخرجات مع تنقيح يحمي الخصوصية. عامل السجلات كبيانات حساسة: اقطع عناوين البريد، أرقام الهواتف، الرموز، والنصوص الحرة التي قد تحتوي بيانات شخصية. احتفظ بوضع "تصحيح" يمكنك تمكينه مؤقتًا للجلسات المحددة بدل تسجيل كل شيء افتراضيًا.

راقب الإشارات الصحيحة

راقب معدلات الخطأ، فشل الأدوات، خروقات الصيغة، والانحراف. تتبع بوضوح:

- نجاح استدعاءات الأدوات ومهلاتها (هل اختار النموذج الأداة الصحيحة؟ وهل نُفّذت؟)

- الامتثال لصيغة/المخطط (هل رفض المحقّق المخرجات?)

- استخدام التراجعات (كم مرة اضطررتم إلى مسار أبسط أو آمن)

- حجب المحتوى السلامي (كم مرة رفضتم أو نُقّحت)

للانحراف، قارن حركة المرور الحالية بالخط الأساس: تغيّرات في مزيج الموضوعات، اللغة، متوسط طول المطالبة، ونوايا "مجهولة". الانحراف ليس دائمًا سيئًا — لكنه دائمًا مؤشر لمراجعة.

التنبيهات، أدلة التشغيل، والاستجابة للحوادث

حدد عتبات تنبيه وأدلة تشغيل. يجب أن تُربط التنبيهات بإجراءات: تراجع عن نسخة المطالبة، تعطيل أداة متعرّجة، تشديد التحقق، أو الانتقال إلى مسار بديل.

خطّط لاستجابة للحوادث لسلوك غير آمن أو غير صحيح. عرّف من يمكنه تشغيل مفاتيح السلامة، كيف تُخطر المستخدمين، وكيف ستوثّق وتتعلم من الحدث.

أغلق الحلقة بتغذية المستخدمين

استخدم دوائر تغذية راجعة: تقييمات الإبهام (إبهام لأعلى/لأسفل)، رموز الأسباب، تقارير الأخطاء. اطلب خيارات "لماذا؟" خفيفة (معلومات خاطئة، لم يتبع التعليمات، غير آمن، بطيء) حتى توجه المشكلات للإصلاح المناسب — مطالبة، أدوات، بيانات، أم سياسة.

تجربة المستخدم لمنطق مدفوع بالنموذج: الشفافية والتحكم

الميزات المدفوعة بالنموذج تبدو سحرية عندما تعمل — وهشة عندما لا تعمل. يجب على تجربة المستخدم أن تفترض عدم اليقين وتظل تساعد المستخدمين على إنجاز المهمة.

أظهر "لماذا" دون إغراق المستخدمين

يثق المستخدمون بمخرجات الذكاء الاصطناعي أكثر عندما يرون مصدرها — ليس لأنهم يريدون محاضرة، بل لأنها تساعدهم في اتخاذ قرار.

استخدم الكشف التدريجي:

- ابدأ بالنتيجة (إجابة، مسودة، توصية).

- قدّم زر "لماذا؟" أو "عرض العمل" يكشف المدخلات الرئيسية: طلب المستخدم، الأدوات المستخدمة، والمصادر أو السجلات التي استُشيرت.

- إذا استخدمت الاسترجاع، اعرض الاستشهادات التي تقفز إلى المقتطف الدقيق (مثلاً: "بناءً على: سياسة §3.2"). اجعلها سهلة التصفح.

إن كان لديك شرح أعمق، اربطه داخليًا (مثلاً: /blog/rag-grounding) بدلًا من حشر التفاصيل في واجهة المستخدم.

صمّم للشك دون تحذيرات مرعبة

النموذج ليس آلة حاسبة. الواجهة يجب أن تُبلّغ عن الثقة وتدعو للتحقق.

أنماط عملية:

- دلائل الثقة بلغة بسيطة ("مرجّح صحيح"، "يحتاج مراجعة") بدلًا من دقة زائفة.

- خيارات بدل إجابة واحدة: "إليك 3 طرق للرد." هذا يقلّل تكلفة الخطأ الأول.

- تأكيدات للأفعال ذات التأثير العالي (إرسال رسالة إلى 12 مستلمًا؟)

اجعل التصحيح والاسترداد سهلين

يجب أن يتمكن المستخدمون من توجيه المخرجات دون البدء من الصفر:

- تحرير ساحر داخل الواجهة مع "تطبيق التغييرات" ليكمل النموذج من تعديل المستخدم.

- "إعادة توليد" مع عناصر تحكم (النبرة، الطول، القيود) بدل تدوير عشوائي.

- "تراجع" وسجل ظاهر لخطوات سابقة لتصحيح الأخطاء بسهولة.

قدّم منفذ هروب

عندما يفشل النموذج — أو لا يثق المستخدم — قدّم طريقًا حتميًا أو مساعدة بشرية.

أمثلة: "التحول إلى نموذج يدوي"، "استخدام قالب"، أو "الاتصال بالدعم" (مثل /support). هذا ليس تراجعًا مخزًا؛ بل طريقة لحماية إتمام المهمة والثقة.

من النموذج الأولي إلى الإنتاج (دون إعادة بناء كل شيء)

معظم الفرق لا تفشل لأن نماذج اللغة غير قادرة؛ بل لأنها تقلل الطريق من النموذج الأولي إلى ميزة موثوقة، قابلة للاختبار، ومراقبة أكثر مما توقعت.

طريقة عملية لتقصير ذلك المسار هي توحيد "هيكل المنتج" مبكرًا: آلات الحالات، مخططات الأدوات، التحقق، التتبّعات، وقصة النشر/التراجع. منصات مثل Koder.ai قد تكون مفيدة هنا عندما تريد إطلاق سير عمل "ذكاء اصطناعي أولًا" بسرعة — بناء واجهة المستخدم، الخلفية، وقاعدة البيانات معًا — ثم التكرار بأمان مع لقطات/تراجع، نطاقات مخصصة واستضافة. وعند الاستعداد للتشغيل الرسمي، يمكنك تصدير كود المصدر والمتابعة مع أنبوب CI/CD وأدوات الرصد المفضلة لديك.