03 مايو 2025·7 دقيقة

كيف تُكمّل اختبارات التوليد الآلي الكود المكتوب بواسطة الذكاء الاصطناعي

اكتشف لماذا الاختبارات المولَّدة آليًا تكمل منطق التطبيقات الذي يكتبه الذكاء الاصطناعي وكيف تبني سير عمل يجعِل الكود والاختبارات وCI يتحسَّنون معًا.

اكتشف لماذا الاختبارات المولَّدة آليًا تكمل منطق التطبيقات الذي يكتبه الذكاء الاصطناعي وكيف تبني سير عمل يجعِل الكود والاختبارات وCI يتحسَّنون معًا.

الكود المكتوب بمساعدة AI يعني أن أجزاء العمل في قاعدة الشيفرة تُصاغ بمساعدة مساعد: دوال جديدة، ميزات صغيرة، إعادة هيكلة، معالجة حالات حافة، وحتى إعادة كتابة وحدات قائمة. أنت لا تزال تُقرّر ما ستبني، لكن النسخة الأولى من التنفيذ تظهر أسرع—وأحيانًا بافتراضات قد لا تلاحظها إلا لاحقًا.

التوليد الآلي للاختبارات هو القدرة المتممة على جانب التحقق. بدل كتابة كل اختبار يدويًا، يمكن للأدوات اقتراح حالات اختبار وتأكيدات بناءً على الكود، مواصفات، أو أنماط مستفادة من أخطاء سابقة. في الممارسة العملية، يمكن أن يبدو ذلك كـ:

قد يكون الاختبار المولَّد مضللاً: قد يثبت السلوك الحالي حتى لو كان السلوك خاطئًا، أو قد يغفل قواعد المنتج الموجودة في رؤوس الناس وتعليقات التذاكر. لذلك المراجعة البشرية ضرورية. يجب أن يتأكد شخص ما أن اسم الاختبار، الإعداد، والافتراضات تعكس النية الحقيقية—لا ما يفعله الكود الآن فقط.

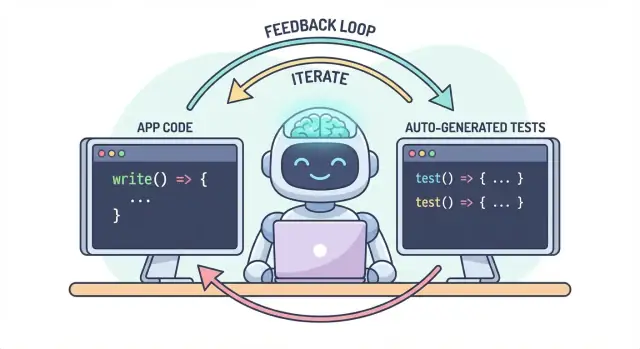

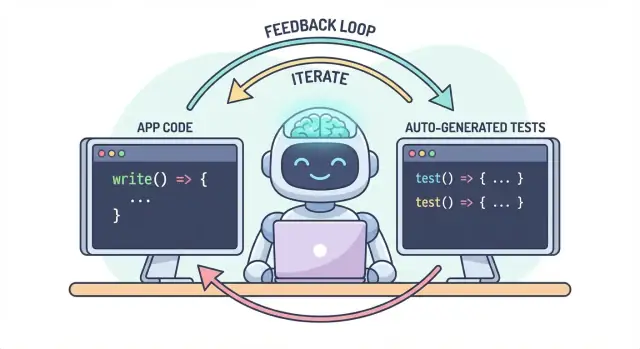

الفكرة الأساسية بسيطة: يجب أن يتطور الكود والاختبارات معًا كسير عمل واحد. إذا ساعدك AI على تغيير المنطق بسرعة، فإن التوليد الآلي للاختبارات يساعدك على تثبيت السلوك المقصود بنفس السرعة—بحيث تكون التغييرات التالية (بشرية أو AI) مصحوبة بتعريف واضح وقابل للتنفيذ لـ "ما يزال صحيحًا".

عمليًا، يكون هذا الأسلوب الأسهل للصيانة عندما يكون سير التطوير لديك قائمًا على المحادثة. على سبيل المثال، في Koder.ai (منصة vibe-coding لبناء تطبيقات الويب والباكند والمحمول عبر الدردشة)، من الطبيعي اعتبار "الميزة + الاختبارات" كمخرَج واحد: تصف السلوك، تولد التنفيذ، ثم تولد وتراجع الاختبارات في نفس الحلقة المحادثية قبل النشر.

الكود المكتوب بواسطة AI قد يشعر كما لو أنه قوة خارقة: تظهر الميزات بسرعة، يختفي البُنى التكرارية، وإعادة الهيكلة التي كانت تستغرق ساعات قد تحدث قبل أن يبرد فنجان قهوتك. لكن السرعة تغيّر شكل الخطر. عندما يصبح إنتاج الكود أسهل، يصبح شحن الأخطاء أسهل أيضًا—أحيانًا بطريقة دقيقة.

المساعدات الذكية جيدة في إنتاج تنفيذ "معقول"، لكن المعقول ليس بالضرورة صحيحًا لمجالك المحدد.

حالات الحافة هي أولى الضحايا. غالبًا ما يتعامل الكود المولَّد جيدًا مع المسار السعيد، ثم يتعثر عند حالات الحدود: المدخلات الفارغة، غرائب المناطق الزمنية، التقريب، القيم null، سلوك إعادة المحاولة، أو حالات "هذا لا يجب أن يحدث" التي تحدث في الإنتاج.

الافتراضات الخاطئة سبب شائع آخر. قد يستنتج المساعد متطلبات لم تُذكر ("المستخدمون دائمًا مصدقون"، "المعرفات رقمية"، "هذا الحقل دائمًا موجود"), أو قد ينفّذ نمطًا مألوفًا لا يتطابق مع قواعد نظامك.

الانحدارات الصامتة هي الأكثر مكلفة أحيانًا. تطلب تغييرًا صغيرًا، يعيد المساعد كتابة جزء من المنطق، ويتعطل شيء غير ذي صلة—دون أخطاء واضحة. الكود لا يزال يترجم، والواجهة لا تزال تُحمّل، لكن قاعدة تسعير أو فحص أذونات أو تحويل بيانات أصبح الآن مختلفًا قليلًا.

عندما تتسارع تغييرات الكود، يصبح الاختبار اليدوي عنق زجاجة ومقامرة. إما تنفق وقتًا أطول في النقر (تبطيء التسليم) أو تختبر أقل (تزيد الهروب). حتى فرق QA المنضبطة لا يمكنها تغطية كل متغير يدويًا عندما تكون التغييرات متكررة وواسعة النطاق.

والأسوأ أن الفحوص اليدوية صعبة التكرار بثبات. تعتمد على ذاكرة شخص أو قائمة مرجعية، وسهلة التجاوز عندما تضيق المواعيد—تمامًا عندما يكون الخطر في أعلى مستوياته.

الاختبارات المؤتمتة تخلق شبكة أمان دائمة: تجعل التوقعات قابلة للتنفيذ. الاختبار الجيد يقول: "بناءً على هذه المدخلات وهذا السياق، هذه النتيجة التي نعتمد عليها." هذا ليس مجرد تحقق؛ إنه تواصل للمستقبل لك، للزملاء وحتى للمساعد AI.

عندما توجد اختبارات، تصبح التغييرات أقل رعبًا لأن رد الفعل فوري. بدل اكتشاف المشاكل بعد مراجعة الكود، في الستيجينغ، أو من العملاء، تجدها بعد دقائق من التغيير.

كلما اكتشفنا الخطأ أبكر، كان إصلاحه أرخص. الاختبارات تقصر حلقة التغذية الراجعة: تُظهر الافتراضات غير المتطابقة وحالات الحافة المفقودة بينما لا يزال القصد طازجًا. هذا يقلل إعادة العمل، يتجنب التصحيحات المؤقتة، ويمنع سرعة AI من التحوّل إلى دوران متكرر مدفوع بالـ AI.

الكود المكتوب بالـ AI يكون الأسرع عندما تعاملَه كمحادثة، لا كمُخرَج لمرة واحدة. الاختبارات هي ما يجعل تلك المحادثة قابلة للقياس.

المواصفات: تصف ماذا يجب أن يحدث (مدخلات، مخرجات، حالات الحافة).

الكود: يكتب الـ AI التنفيذ الذي يدّعي أنه يطابق الوصف.

الاختبارات: أنت (أو الـ AI) تولد فحوصًا تثبت أن السلوك فعلاً صحيح.

كرر هذه الحلقة ولن تكون فقط تنتج المزيد من الكود—ستُضيّق باستمرار تعريف "مكتمل".

متطلب غامض مثل "تعامل مع المستخدمين غير الصالحين بشكل لائق" سهل التجاوز في الكود. الاختبار لا يمكن أن يكون غامضًا. يفرض تفاصيل:

بمجرد أن تحاول التعبير عن هذه التفاصيل في اختبار، تظهر الأجزاء غير الواضحة فورًا. تلك الوضوح يُحسّن الـ prompt الذي تعطيه للـ AI وغالبًا ما يؤدي إلى واجهات أبسط وأكثر ثباتًا.

قد يبدو كود الـ AI صحيحًا بينما يخفي افتراضات. الاختبارات المولَّدة طريقة عملية للتحقق من ادعاءات الكود:

الهدف ليس الثقة العمياء بالاختبارات المولَّدة—بل استخدامها كشك منظم للتشكيك السريع.

الاختبار الفاشل هو ملاحظات قابلة للتنفيذ: يشير إلى عدم تطابق محدد بين المواصفات والتنفيذ. بدل أن تطلب من الـ AI "إصلاحه" بصورة عامة، يمكنك لصق الفشل وتقول: "حدّث الكود بحيث ينجح هذا الاختبار دون تغيير الواجهة العامة." هذا يحوّل تصحيح الأخطاء إلى تكرار مركز بدلاً من لعبة تخمين.

التوليد الآلي للاختبارات مفيد بشكل أكبر عندما يدعم استراتيجية الاختبار الحالية—وبالأخص هرم الاختبار الكلاسيكي. الهرم ليس قاعدة من أجلها فقط؛ إنه طريقة للحفاظ على ردود فعل سريعة وموثوقة مع رصد الأخطاء الواقعية.

يمكن للـ AI مساعدتك في إنشاء اختبارات على كل طبقة، لكن ستحصل على أفضل النتائج عندما تولّد المزيد من الاختبارات الرخيصة (قاع الهرم) وعددًا أقل من المكلفة (القمة). هذا التوازن يحافظ على سرعة خط CI مع حماية تجربة المستخدم.

اختبارات الوحدة هي فحوص صغيرة لدوال أو طرق أو وحدات فردية. تعمل بسرعة، لا تحتاج أنظمة خارجية، ومثالية لتوليد تغطية حالات الحافة بواسطة AI.

استخدام عملي لتوليد الاختبارات هنا:

بسبب نطاق اختبارات الوحدة الضيق، فهي أسهل للمراجعة وأقل عرضة للتقطع.

اختبارات التكامل تتحقق من كيفية تفاعل الأجزاء معًا: واجهتك البرمجية مع قاعدة البيانات، خدمة تستدعي خدمة أخرى، معالجة الطوابير، المصادقة، وهكذا.

يمكن أن تكون اختبارات التكامل المولَّدة ذات قيمة، لكنها تتطلب انضباطًا أكبر:

فكر فيها كـ "فحوص عقدية" تثبت أن الحدود بين المكوّنات لا تزال صامدة.

اختبارات E2E تتحقق من مسارات المستخدم الرئيسية. هي أيضًا الأكثر تكلفة: أبطأ في التشغيل، أكثر هشاشة، وأصعب في التصحيح.

يمكن للتوليد الآلي أن يساعد في صياغة سيناريوهات E2E، لكن يجب التحفّظ بقسوة. احتفظ بمجموعة صغيرة من المسارات الحرجة (التسجيل، إنهاء الشراء، سير العمل الأساسي) وتجنّب محاولة توليد E2E لكل ميزة.

لا تهدف إلى توليد كل شيء. بدلاً من ذلك:

هذا يحافظ على سلامة الهرم—ويجعل التوليد الآلي للاختبارات قوة مُضاعِفة بدلاً من مصدر ضوضاء.

التوليد الآلي للاختبارات لا يقتصر على "اكتب اختبارات وحدة لهذه الدالة". أكثر المولدات فائدة تسحب من ثلاث مصادر: الكود الموجود، النية ورائه، والفشلات التي شهدتها مسبقًا.

بناءً على دالة أو وحدة، يمكن للأدوات استنتاج حالات اختبار من المدخلات/المخرجات، الفروع، ومسارات الاستثناء. عادةً يشمل ذلك:

هذا الأسلوب ممتاز لحماية المنطق المولَّد من قبل AI بفحوص تؤكد ما يفعله اليوم.

إذا كان لديك معايير قبول، قصص مستخدم، أو جداول أمثلة، يمكن للمولدين تحويلها إلى اختبارات تقرأ كمواصفات. هذا غالبًا ذو قيمة أعلى من الاختبارات المستمدة من الكود لأنّه يثبت "ما يجب أن يحدث" وليس "ما يحدث الآن".

نمط عملي: زود المولد ببعض الأمثلة العملية (مدخلات + مخرجات متوقعة) واطلب إضافة حالات الحافة المتسقة مع تلك القواعد.

التوليد المبني على الأخطاء هو أسرع طريقة لبناء مجموعة انحدار ذات معنى. قدم خطوات إعادة الإنتاج (أو سجلات وحِمل دنيا) وولّد:

اختبارات اللقطة قد تكون فعّالة للمخرجات الثابتة (واجهة مستخدم مصوّرة، استجابات مسلسلة). استخدمها بحذر: اللقطات الكبيرة قد "توافق" على أخطاء دقيقة. فضّل لقطات صغيرة ومركزة وأقرنها بتأكيدات على الحقول الأساسية التي يجب أن تكون صحيحة.

التوليد الآلي للاختبارات يكون أكثر فعالية عندما تعطيه أولويات واضحة. إذا سمت المولد على مستودع كامل وطلبت "كل الاختبارات"، ستحصل على ضوضاء: الكثير من الفحوص قليلة القيمة، تغطية مكررة، واختبارات هشة تبطئ التسليم.

ابدأ بالمسارات التي سيكون كسرها مكلفًا أكثر—ماليًا، قانونيًا، أو سمعة. فلتر قائم على المخاطر يبقي النطاق واقعيًا ويُحسّن الجودة بسرعة.

ركّز أولًا على:

لكل مسار تختاره، ولِّد اختبارات عبر الطبقات: بعض اختبارات الوحدة السريعة للمنطق المعقّد، بالإضافة لاختبارَي تكامل يؤكدان أن المسار كله يعمل.

اطلب تغطية تُطابق الأخطاء الحقيقية، لا التباديل النظرية. مجموعة بداية جيدة:

يمكنك التوسيع لاحقًا بناءً على الأخطاء، تقارير الحوادث، أو ملاحظات المستخدم.

اجعل القاعدة صريحة: الميزة ليست مكتملة حتى توجد اختبارات. تعريف النهاية هذا مهم أكثر مع الكود المولَّد بالـ AI، لأنه يمنع "الشحن السريع" من التحول بهدوء إلى "انحدارات سريعة".

إذا أردت لترسخ هذه العادة، اربطها بسير العمل (مثلًا، اشرط وجود اختبارات ذات صلة قبل الاندماج في CI) وارْبط التوقع في مستندات الفريق (مثل /engineering/definition-of-done).

يمكن للـ AI توليد الاختبارات بسرعة، لكن الجودة تعتمد كثيرًا على كيفية الطلب. الهدف هو توجيه النموذج نحو اختبارات تحمي السلوك—وليس اختبارات تنفّذ الكود فقط.

ابدأ بتثبيت "شكل" الاختبارات حتى يتوافق الناتج مع مستودعك.

ضمّن:

should_<behavior>_when_<condition>)src/ و tests/, أو __tests__/)هذا يمنع النموذج من اختراع أنماط لا يستخدمها فريقك.

ألصق ملف اختبار موجود (أو مقتطفًا قصيرًا) وقل صراحة: "طابق هذا الأسلوب." هذا يرسّخ قرارات مثل ترتيب بيانات الاختبار، تسمية المتغيّرات، وهل تفضل اختبارات جدولية.

إذا كان المشروع لديك يحتوي على مساعدات (مثل buildUser() أو makeRequest())، أدرج هذه المقتطفات أيضًا حتى تُعيد الاختبارات المُولَّدة استخدامهم بدل إعادة تنفيذها.

كن صريحًا بشأن ماذا يعني "جيد":

سطر مفيد في الـ prompt: "يجب أن يحتوي كل اختبار على تأكيد واحد على الأقل حول السلوك التجاري (ليس فقط 'لم يُلقَ استثناء')."

تميل معظم مجموعات الاختبارات المولَّدة إلى التحيز نحو "مسار السعادة". قاوم ذلك بطلب:

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

ملاحظة: احفظ الكتلة المحاطة بـ``` كما هي—لا تترجم نص الكود الموضح بداخلها.

يمكن للـ AI صياغة الكثير من الاختبارات بسرعة، لكنه لا يستطيع أن يكون الحَكَم النهائي فيما إذا كانت تلك الاختبارات تمثل نيتك. المراجعة البشرية هي ما يحوّل "اختبارات تعمل" إلى "اختبارات تحمينا". الهدف ليس التدقيق في الشكل—بل التأكد من أن مجموعة الاختبارات ستكتشف انحدارات ذات معنى دون أن تصبح عبء صيانة.

ابدأ بسؤالين:

أحيانًا تثبّت الاختبارات المولَّدة سلوكًا عرضيًا (تفاصيل التنفيذ) بدل القاعدة المقصودة. إذا بدا الاختبار كنسخة من الكود بدل وصف النتائج المتوقعة، ادفعه نحو تأكيدات على مستوى أعلى.

مصادر الشيوع للهشاشة تشمل الإفراط في المحاكاة، الطوابع الزمنية المضمنة، والقيم العشوائية. فضّل مدخلات حتمية وتأكيدات مستقرة (مثال: تأكيد على تاريخ مُحلل أو نطاق بدل سلسلة Date.now() خام). إذا تطلّب الاختبار محاكاة مفرطة لكي ينجح، فقد يختبر الربط بدل السلوك.

اختبار "ناجح" قد يكون عديم الفائدة إذا كان سيمرّ حتى عندما تُكسر الميزة (إيجابي كاذب). ابحث عن تأكيدات ضعيفة مثل "لم تُلقَ استثناء" أو التحقق فقط من أن دالة ما دُعيت. قوِّها بتأكيدات على المخرجات، تغيّرات الحالة، الأخطاء المرجعية، أو البيانات المخزنة.

قائمة بسيطة تحافظ على اتساق المراجعات:

عامل الاختبارات المولَّدة كأي كود آخر: ادمج فقط ما ستتحمّله بعد ستة أشهر.

يمكن للـ AI مساعدتك في كتابة الكود بسرعة، لكن الفوز الحقيقي هو إبقاء ذلك الكود صحيحًا مع مرور الوقت. أبسط طريقة لـ "تثبيت" الجودة هي جعل الاختبارات والفحوص تعمل تلقائيًا على كل تغيير—حتى تُلتقط الانحدارات قبل الشحن.

سير عمل خفيف تتبناه فرق كثيرة:

الخطوة الأخيرة مهمة: الكود المكتوب بالـ AI بدون اختبارات تميل إلى الانجراف. مع الاختبارات، تسجّل السلوك المقصود بطريقة يمكن لـ CI فرضها.

اضبط خط CI ليعمل على كل طلب سحب (ومثاليًا على الاندماجات إلى main). على الأقل، يجب أن:

هذا يمنع مفاجآت "عمل على جهازي" ويلتقط الكسر العرضي عندما يغيّر زميلك (أو طلب AI لاحق) الكود في مكان آخر.

الاختبارات ضرورية، لكنها لا تكتشف كل شيء. أضف بوابات صغيرة وسريعة تكمل توليد الاختبارات:

اجعل هذه الفحوص سريعة—إذا بدا CI بطيئًا أو مزعجًا، سيبحث الناس عن طرق لتجنبه.

إذا كنت توسع تشغيل CI لأنك تولّد المزيد من الاختبارات، فتأكد من أن ميزانيتك تتناسب مع الإيقاع الجديد. إذا كنت تتابع دقائق CI، من المفيد مراجعة الحدود والخيارات (انظر /pricing).

طريقة فعالة للعمل مع الكود المولَّد بالـ AI هي اعتبار الاختبارات الفاشلة كـ "الـ prompt التالي". بدل أن تطلب من النموذج "تحسين الميزة" بشكل واسع، تعطيه فشلًا ملموسًا وتدعه يقيد التغيير.

بدلًا من:

استخدم:

shouldRejectExpiredToken. هذه مخرجات الفشل والكود ذي الصلة. حدّث التنفيذ حتى ينجح هذا الاختبار دون تغيير السلوك العام. إذا لزم، أضف اختبار انحدار يلتقط الخلل."الاختبارات الفاشلة تُزيل التخمين. هي تُعرّف ما يعنيه "صحيح" بشكل قابل للتنفيذ، لذا لست تفاوض على المتطلبات في الدردشة. كما أنك تتجنب التعديلات الواسعة: كل تهيئة محددة لنتيجة قابلة للقياس، مما يُسرّع المراجعة البشرية ويُسهّل اكتشاف ما إذا كان الـ AI "عالج" العرض فقط وكسّر شيئًا آخر.

هذا أيضًا حيث يمكن لسير عمل من نوع الوكلاء أن يضيف قيمة: وكيل يركز على التغيير الأدنى في الكود، وآخر يقترح تعديل الاختبار الأصغر، وأنت تراجع الفرق. منصات مثل Koder.ai مبنية حول هذا النوع من التطوير المتكرر والمتمحور حول الدردشة—مما يجعل "الاختبارات كـ prompt التالي" وضعًا افتراضيًا بدلاً من تقنية خاصة.

يمكن لتوليد الاختبارات الآلي أن يُكثّر مجموعة الاختبارات بين عشية وضحاها—لكن "أكبر" ليس مرادفًا لـ "أفضل". الهدف هو الثقة: اكتشاف الانحدارات مبكرًا، تقليل عيوب الإنتاج، والحفاظ على حركة الفريق.

ابدأ بإشارات تربط بالنتائج التي تهتم بها:

التغطية مفيدة كإنذار عام—خاصة لإيجاد المسارات غير المُختبرة—لكن من السهل التلاعب بها. قد تُضخم الاختبارات المولَّدة التغطية بينما تُثبت القليل فعليًا. فضّل مؤشرات مثل:

إذا كنت تتتبع فقط عدد الاختبارات أو التغطية، ستُحسّن الحجم. تتبّع العيوب المكتشفة قبل الإصدار: الأخطاء التي اكتُشفت في CI، QA، أو الستيجينغ والتي كانت لتصل للمستخدمين. عندما يعمل التوليد الآلي جيدًا، يرتفع هذا العدد (المكتشفة قبل الإصدار) بينما تنخفض حوادث الإنتاج.

مجموعات الاختبارات المولَّدة تحتاج صيانة. ضع مهمة متكررة في الجدول لـ:

النجاح هو CI أكثر هدوءًا، ردود فعل أسرع، وأقل مفاجآت—ليس لوحة تحكم مبهرة.

التوليد الآلي للاختبارات يمكن أن يرفع الجودة بسرعة—لكن فقط إن عاملته كمساعد وليس كمرجع نهائي. تبدو أكبر الإخفاقات متشابهة عبر الفرق، ويمكن تجنّبها.

الاعتماد المفرط هو الفخ الكلاسيكي: قد تخلق الاختبارات المولَّدة وهماً للأمان بينما تُفقد المخاطر الحقيقية. إذا توقف الناس عن التفكير النقدي ("الأداة كتبت اختبارات، إذًا نحن مغطّون"), ستشحن أخطاء أسرع—مع المزيد من العلامات الخضراء.

مشكلة متكررة أخرى هي اختبار تفاصيل التنفيذ بدل السلوك. أدوات الـ AI غالبًا ما تتمسك بأسماء الدوال الحالية، المساعدات الداخلية، أو رسائل الخطأ الدقيقة. تلك الاختبارات تصبح هشة: تغييرات إعادة الهيكلة تكسرها حتى لو بقيت الميزة تعمل. فضّل الاختبارات التي تصف ماذا يجب أن يحدث، لا كيف يحدث.

توليد الاختبارات غالبًا يتضمن نسخ كود، تتبعات، سجلات، أو مواصفات داخل الـ prompt. هذا قد يُعرّض أسرارًا (مفاتيح API)، بيانات العملاء، أو منطقًا ملكية.

حافظ على prompts وfixtures خالية من المعلومات الحساسة:

إذا كنت تستخدم منصة AI مستضافة، طبق نفس الحذر كجزء من سياسة الأمان.

ابدأ صغيرًا واجعلها روتينية:

الهدف ليس إنتاج أكبر عدد من الاختبارات—بل الحصول على ردود فعل موثوقة تحافظ على صدق الكود المولَّد بالـ AI.

لأن الذكاء الاصطناعي يسرّع تغييرات منطق التطبيق، فهو يسرّع أيضاً وتيرة الافتراضات الخاطئة والانكسارات الطفيفة. الاختبارات المولَّدة توفر وسيلة سريعة وقابلة للتشغيل لتثبيت السلوك المقصود، حتى تكون التغييرات المستقبلية (بشرية أو بواسطة AI) مصحوبة بردود فعل فورية عند حدوث كسر.

لا. قد تقوم الاختبارات المولَّدة بــ"تصديق" السلوك الحالي حتى لو كان هذا السلوك خاطئًا، أو قد تتجاهل قواعد المنتج غير الموضحة صراحة في الكود. اعتبر الاختبارات المولَّدة كمسودات: راجع أسماء الاختبارات، الإعداد، والافتراضات لتتأكد من أنها تعبّر عن قصد المنتج.

استعملها عندما تحتاج تغطية مُنظَّمة وسريعة حول منطق جديد أو مُعدَّل — خصوصًا بعد عمليات التعديل بمساعدة AI. تكون مفيدة بشكل خاص لـ:

ابدأ بطبقة التكلفة الأقل والإشارة الأعلى: اختبارات الوحدة.

استهدف اختبارات تركز على السلوك بحيث تفشل للسبب الصحيح. قوِّها عن طريق:

مصادر الهشاشة الشائعة تتضمّن الإفراط في المحاكاة، الطوابع الزمنية المضمَّنة، البيانات العشوائية، والاعتماد على استدعاءات داخلية. فضّل مدخلات ثابتة ونواتج مستقرة، واختبر السلوك العام بدل تفاصيل التنفيذ كي لا تكسر عمليات إعادة التنظيم البسيطة الاختبارات.

استخدم حلقة سريعة ومقاسة:

هذا يربط مفهوم "مكتمل" بتوقعات قابلة للتنفيذ بدلاً من فحوص يدوية فقط.

ضمّن قيودًا وسياق المستودع الحقيقي:

هذا يقلل النماذج المخترعة ويحسّن القابلية للمراجعة.

كن حذرًا بشأن ما تلصقه داخل الprompts (الكود، السجلات، تتبعات الأخطاء). تجنّب تسريب:

استخدم بيانات اختبار مُصطنعة، احذف المعلومات الحساسة، وقلّص السياق المشترك إلى أقل ما يلزم. إذا كنت تستخدم منصة مستضافة، اتّبع نفس الحذر كجزء من سياسة الأمان.

قِس الإشارات التي تعكس الثقة فعلاً، لا الحجم:

عامِل التغطية كدليل فقط، واحذف أو ثَبّت الاختبارات منخفضة الإشارة بانتظام للحفاظ على مجموعة قابلة للصيانة.