12 نوفمبر 2025·8 دقيقة

من مختبر غير ربحي إلى رائد في الذكاء الاصطناعي: تاريخ OpenAI

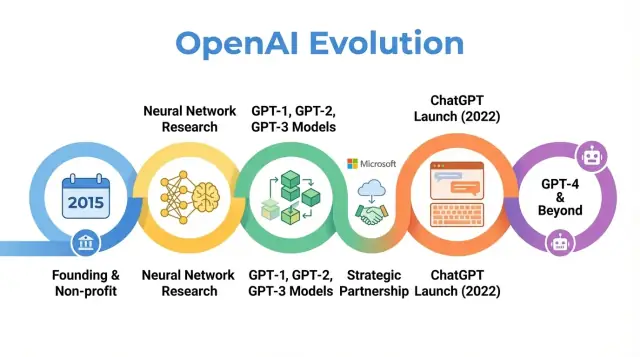

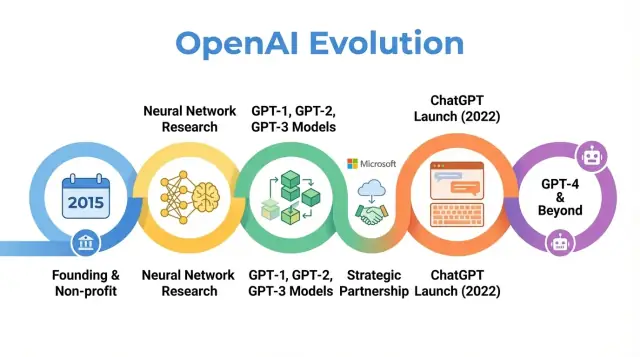

استكشف تاريخ OpenAI: من مختبر غير ربحي في 2015 ومحطات البحث الأساسية إلى إطلاق ChatGPT وGPT‑4 وتطوّر مهمتها وهيكلها المؤسسي.

استكشف تاريخ OpenAI: من مختبر غير ربحي في 2015 ومحطات البحث الأساسية إلى إطلاق ChatGPT وGPT‑4 وتطوّر مهمتها وهيكلها المؤسسي.

تعد OpenAI شركة بحث ونشر في مجال الذكاء الاصطناعي أثّرت في طريقة تفكير الناس حول الذكاء الاصطناعي—من أوراق البحث المبكرة إلى منتجات مثل ChatGPT. فهم كيف تطورت OpenAI—من مختبر غير ربحي صغير في 2015 إلى لاعب مركزي في مجال الذكاء الاصطناعي—يساعد على تفسير سبب شكل الذكاء الاصطناعي الحديث كما نراه اليوم.

قصة OpenAI ليست مجرد تسلسل لإصدارات النماذج. إنها دراسة حالة لكيفية تفاعل المهمة والدوافع والاختراقات التقنية والضغط العام. بدأت المنظمة بتأكيد قوي على البحث المفتوح والمنفعة العامة، ثم أعادت هيكلة نفسها لجذب رأس المال، وشكلت شراكة عميقة مع مايكروسوفت، وأطلقت منتجات يستخدمها مئات الملايين من الناس.

تتبع تاريخ OpenAI يسلط الضوء على عدة اتجاهات أوسع في الذكاء الاصطناعي:

المهمة والقيم: تأسست OpenAI بهدف ضمان أن الذكاء العام الاصطناعي يعود بالنفع على البشرية جمعاء. كيف فُسّرت هذه المهمة وعدلت بمرور الوقت يكشف التوترات بين الأهداف المثالية والواقعية التجارية.

الاختراقات البحثية: التقدم من المشاريع الأولى إلى أنظمة مثل GPT‑3، GPT‑4، DALL·E، وCodex يعكس تحوّلًا أوسع نحو نماذج أساس واسعة النطاق التي تشغل العديد من تطبيقات الذكاء الاصطناعي الحالية.

الحوكمة والبنية: الانتقال من منظمة غير ربحية خالصة إلى كيان محدود الربح، وظهور آليات حوكمة معقّدة، يبرز كيف تُجرَّب أشكال تنظيمية جديدة لإدارة تقنيات قوية.

التأثير العام والرقابة: مع ChatGPT وإصدارات أخرى، انتقلت OpenAI من مختبر بحثي معروف داخل دوائر الذكاء الاصطناعي إلى اسم مألوف، ما جلب الاهتمام بمواضيع السلامة والمحاذاة والتنظيم التي تشكّل الآن مناقشات السياسات عالميًا.

يتبع هذا المقال رحلة OpenAI من 2015 حتى أحدث مستجداتها، ويبيّن كيف يعكس كلّ مرحلة تحوّلات أوسع في البحث والاقتصاد والحوكمة في مجال الذكاء الاصطناعي—وماذا قد يعني ذلك لمستقبل المجال.

تأسست OpenAI في ديسمبر 2015، في وقت كان فيه التعلم الآلي—وخاصة التعلم العميق—يتحسّن بسرعة لكنه لا يزال بعيدًا عن الذكاء العام. كانت معايير التعرف على الصور تتحسّن، وأنظمة الكلام تتقدّم، وكانت شركات مثل Google وFacebook وBaidu تضخّ أموالًا في الذكاء الاصطناعي.

نشأ قلق متزايد بين الباحثين وقادة التقنية من أن تقنيات الذكاء المتقدمة قد تصبح تحت سيطرة عدد قليل من الشركات أو الحكومات. فُكِّرت OpenAI كقوة موازنة: منظمة بحثية تركز على السلامة على المدى الطويل وتوزيع فوائد الذكاء الاصطناعي على نطاق واسع بدلاً من ميزة تجارية ضيقة.

منذ اليوم الأول عرفت OpenAI مهمتها من منظور الذكاء العام الاصطناعي (AGI)، وليس مجرد تقدم تدريجي في التعلم الآلي. التصريح الأساسي كان أن OpenAI ستعمل لضمان أن AGI، إذا وُجد، "يعود بالنفع على البشرية جمعاء."

كانت لهذه المهمة تبعات عملية:

المشاركات العامة المبكرة وميثاق التأسيس أكدت على الانفتاح والحذر معًا: ستنشر OpenAI كثيرًا من أعمالها، لكنها ستفكّر أيضًا بتأنٍ في الأثر الاجتماعي لإطلاق قدرات قوية.

بدأت OpenAI كمختبر غير ربحي. تم الإعلان عن التزامات تمويلية بنحو مليار دولار كمبالغ موعودة على المدى الطويل، رغم أن هذا لم يكن نقدًا مقدمًا بالكامل. من الداعمين المبكرين: Elon Musk، Sam Altman، Reid Hoffman، Peter Thiel، Jessica Livingston، وYC Research، بالإضافة إلى دعم شركات مثل Amazon Web Services وInfosys.

جمع فريق القيادة الأول بين خبرات الشركات الناشئة والبحث والتشغيل:

هذا المزج بين روح ريادة وعمق البحث شكّل ثقافة OpenAI المبكّرة: طموح كبير لتقديم حدود جديدة لقدرات الذكاء الاصطناعي، ومنظمة كمختبر غير ربحي مُكرّس لتأثير طويل الأمد بدلًا من السعي التجاري القصير.

عند إطلاقها كمختبر غير ربحي في 2015، كان وعد OpenAI العام بسيطًا وطموحًا: تقدم الذكاء الاصطناعي بينما تشارك قدر الإمكان مع المجتمع الأوسع.

ميّزت السنوات الأولى فلسفة "الانفتاح افتراضيًا". نُشرت الأوراق البحثية بسرعة، وكانت الشيفرات تُطلق عادةً، وتحولت الأدوات الداخلية إلى مشاريع عامة. الفكرة كانت أن تسريع التقدّم العلمي العام—ومراجعته العامة—سيكون أكثر أمانًا وفائدة من ترك القدرات مركّزة داخل شركة واحدة.

في الوقت ذاته كان السلامة جزءًا من النقاش. ناقش الفريق متى قد يزيد الانفتاح من خطر الإساءة وبدأوا في رسم أفكار لإطلاقٍ مرحلي ومراجعات سياسات، حتى لو كانت هذه الأفكار غير رسمية مقارنة بعمليات الحوكمة اللاحقة.

امتد التركيز العلمي المبكّر لـ OpenAI إلى عدة مجالات أساسية:

كانت هذه المشاريع أقل ارتكازًا على منتجات مصقولة وأكثر على اختبار إمكانية ما يمكن تحقيقه عبر التعلم العميق والموارد الحاسوبية وأنظمة التدريب الذكية.

من أهم مخرجات هذه الحقبة كانت OpenAI Gym وUniverse.

كلا المشروعين عكسا التزامًا بالبنية التحتية المشتركة بدلًا من الميزة الملكية.

خلال الفترة غير الربحية، صوّرت OpenAI غالبًا كقوة دافعة ذات مهمة مقابلة لمختبرات الذكاء الاصطناعي في شركات كبيرة. قدّر الزملاء جودة أبحاثها، وتوافر الشيفرة والبيئات، واستعدادها لمناقشة السلامة.

ركزت التغطية الإعلامية على الجمع غير المألوف بين داعمين بارزين وبنية غير ربحية ووعد بالنشر المفتوح. هذه السمعة—كمختبر مفتوح التأثير مهتم بالتبعات طويلة الأمد—وضعت توقعات شكلّت لاحقًا ردود الفعل على كل تغيير استراتيجي قامت به المنظمة.

نقطة التحوّل في تاريخ OpenAI كانت تركيزها على نماذج اللغة الضخمة المبنية على المحوّلات. هذا التحوّل قلب OpenAI من مختبر بحثي إلى شركة معروفة بنماذج الأساس التي يبني عليها الآخرون.

كان GPT‑1 متواضعًا مقارنة بما تلاه—117 مليون معلمة، مدرّب على BookCorpus—لكنّه قدّم إثبات مفهوم حاسم.

بدل تدريب نماذج منفصلة لكل مهمة معالجة لغة طبيعية، أظهر GPT‑1 أن نموذجًا واحدًا من نوع المحوّل، مدرّبًا بهدف بسيط (توقّع الكلمة التالية)، يمكن تكييفه مع تعديلات صغيرة للقيام بمهام مثل الإجابة عن الأسئلة، تحليل المشاعر، واستنتاج النص.

لخريطة طريق OpenAI الداخلية، أكدت GPT‑1 ثلاث أفكار:

دفع GPT‑2 نفس الوصفة أبعد: 1.5 مليار معلمة وبيانات أكبر مشتقة من الويب. كانت مخرجاته غالبًا مترابطة بشكل مدهش—مقالات متعددة الفقرات، قصص خيالية، وملخّصات تبدو بشرية.

أثارت هذه القدرات إنذارات حول إمكانية الإساءة: الدعاية الآلية، الرسائل المزعجة، والمعلومات المضللة على نطاق واسع. بدلاً من إطلاق النموذج الكامل فورًا، تبنّت OpenAI استراتيجية إطلاق مرحلية:

كان هذا أحد الأمثلة الأولى البارزة لربط قرارات النشر بالسلامة والأثر الاجتماعي، وشكّل تفكير المنظمة حول الإفصاح والانفتاح والمسؤولية.

ارتفع GPT‑3 إلى 175 مليار معلمة. بدلًا من الاعتماد بشكل أساسي على التخصيص لكل مهمة، أظهر GPT‑3 قدرات "قليلة الأمثلة" وحتى "بدون أمثلة": كان النموذج قادرًا على أداء مهمة جديدة ببساطة من التعليمات وقليل من الأمثلة في المطالبة.

غيّر هذا المستوى من العمومية كيفية تفكير OpenAI والصناعة بأكملها في أنظمة الذكاء الاصطناعي. بدل بناء نماذج ضيقة متعددة، أصبح نموذج كبير واحد محركًا عامًا لـ:

الأهم من ذلك، اختارت OpenAI عدم إصدار GPT‑3 كمصدر مفتوح. قدّمته عبر API تجاري. شكّل هذا تحوّلًا استراتيجيًا:

رسمت GPT‑1 وGPT‑2 وGPT‑3 قوسًا واضحًا في تاريخ OpenAI: توسيع المحوّلات، اكتشاف القدرات الطارئة، الجدل حول السلامة والإساءة، ووضع الأساس التجاري الذي دعم لاحقًا منتجات مثل ChatGPT وتطوير GPT‑4 وما بعده.

بحلول 2018، اقتنع قادة OpenAI أن البقاء كمختبر صغير ممول بالتبرعات لن يكفي لبناء أنظمة ذكاء اصطناعي كبيرة جدًا وآمنة. كانت أعمال تدريب النماذج الحدودية تتطلّب بالفعل عشرات الملايين من الدولارات في الحوسبة والمواهب، ومع منحنى تكلفة متجه للارتفاع. لجذب الباحثين البارزين، وإجراء تجارب مقياسية، وتأمين وصول طويل الأمد للبنية السحابية، احتاجت OpenAI إلى هيكل يتيح جذب رأس مال جدي دون التخلي عن مهمتها الأصلية.

في 2019، أطلقت OpenAI OpenAI LP، شراكة محدودة "ذات ربحٍ محدود". الهدف كان فتح إمكانية استثمارات خارجية كبيرة مع الحفاظ على مهمة المنظمة—ضمان أن AGI يفيد البشرية—في مقدمة هرم صنع القرار.

الشركات الناشئة التقليدية ملتزمة في النهاية للمساهمين الباحثين عن عوائد غير محدودة. خشي مؤسسو OpenAI أن يؤدي ذلك إلى ضغط قوي لتفضيل الربح على السلامة أو الانفتاح أو النشر الحذر. كان هيكل LP حلًا وسطيًا: يمكنه إصدار حصص شبيهة بالأسهم وجمع الأموال على نطاق، لكن تحت قواعد مختلفة.

في نموذج الربح المحدود، يمكن للمستثمرين والموظفين جني عوائد على استثماراتهم، لكن فقط حتى مضاعف ثابت من الاستثمار الأصلي (للمستثمرين الأوائل ذُكر غالبًا حتى 100x، مع حدود أدنى في جولات لاحقة). عندما يُبلَغ ذلك الحد، يُفترض أن تتدفق القيمة الإضافية إلى الجهة الأم غير الربحية لاستخدامها وفق مهمتها.

هذا يختلف عن الشركات الناشئة التقليدية التي يمكن أن ترى نموًا غير محدود في قيمة الأسهم وحيث يكون تعظيم قيمة المساهمين الافتراض القانوني والثقافي.

تظل الجهة غير الربحية هي الكيان المسيطر. يراقب مجلسها OpenAI LP ومُكلّف بأن يفضّل مصالح الإنسانية على أي مجموعة استثمارية أو موظفين بعينهم.

رسميًا:

صُمِّم هذا الإطار لمنح OpenAI مرونة التوظيف والتمويل كمنظمة تجارية مع الحفاظ على السيطرة ذات الأولوية للمهمة.

أطلق إعادة الهيكلة نقاشًا داخل وخارج المؤسسة. رأى المؤيدون أنه السبيل العملي الوحيد لتأمين المليارات المطلوبة لأبحاث متقدمة مع الحفاظ على الضوابط. شكك النقّاد في ما إذا كان أي هيكل يقدم عوائد كبيرة يمكنه حقًا مقاومة الضغط التجاري، وما إذا كانت الحدود كافية أو مُطبّقة بوضوح.

عمليًا، فتحت OpenAI LP الباب أمام استثمارات استراتيجية كبيرة، أبرزها مايكروسوفت، ومكنت الشركة من تقديم حزم تعويضية تنافسية مرتبطة بعوائد محتملة. أتاحت هذه الخطوة توسيع فرق البحث، وتكثيف تجارب التدريب لنماذج مثل GPT‑3 وGPT‑4، وبناء البنية التحتية اللازمة لنشر أنظمة مثل ChatGPT على نطاق عالمي—كل ذلك مع الحفاظ على رابط حوكمي رسمي يعود للجهة غير الربحية الأصلية.

في 2019، أعلنت OpenAI ومايكروسوفت عن شراكة متعددة السنوات أعادت تشكيل دورَي الشركتين في الذكاء الاصطناعي. استثمرت مايكروسوفت نحو مليار دولار، مزيجًا من نقد وائتمانات Azure السحابية، لتصبح الشريك التجاري المفضّل لـ OpenAI.

الصفقة تلاءمت مع حاجة OpenAI إلى موارد حوسبة هائلة لتدريب نماذج متزايدة الحجم، بينما منحت مايكروسوفت إمكانية الوصول إلى ذكاء اصطناعي متقدّم يميّز منتجاتها ومنصتها السحابية. تعمّقت العلاقة في السنوات التالية من خلال تمويل إضافي وتعاون تقني.

اختارت OpenAI مايكروسوفت Azure كمنصة سحابية أساسية لعدة أسباب:

جعل هذا Azure البيئة الافتراضية لتدريب ونشر نماذج مثل GPT‑3 وCodex ولاحقًا GPT‑4.

أدى التعاون إلى أحد أكبر أنظمة الحوسبة الفائقة للذكاء الاصطناعي في العالم، مبنية على Azure لأعباء OpenAI. قدمت مايكروسوفت هذه العناقيد كنماذج رائدة لقدرات Azure في الذكاء الاصطناعي، بينما اعتمدت OpenAI عليها لتوسيع حجم النماذج وسرعة التجريب.

خففت هذه الجهود حدودًا فاصلة بين "العميل" و"الشريك": فقد أثرت OpenAI في خارطة طريق Azure، وصقلت Azure لتلبية احتياجات OpenAI.

حصلت مايكروسوفت على حقوق ترخيص حصرية لبعض تقنيات OpenAI، لا سيّما GPT‑3. سمح لها ذلك بدمج نماذج OpenAI في منتجاتها—Bing وOffice وGitHub Copilot وAzure OpenAI Service—بينما استطاعت شركات أخرى الوصول إليها عبر API الخاص بـ OpenAI.

أثار هذا الحصرية جدلاً: رأى المؤيدون أنها وفّرت التمويل والتوزيع اللازمين لتوسيع تكنولوجيا قوية بأمان؛ فيما أخاف النقّاد من تركيز النفوذ بشأن نماذج الحدود في يد شركة تقنية كبرى واحدة.

في الوقت نفسه، أعطت الشراكة OpenAI رؤية واسعة النطاق. ساهمت تسميات مايكروسوفت وإدماج المنتجات وقنوات المبيعات المؤسسية في نقل أنظمة OpenAI من عروض بحثية إلى أدوات يومية يستخدمها الملايين، مما شكّل تصور الجمهور لـ OpenAI كمختبر مستقل وشريك أساسي لمايكروسوفت في آنٍ واحد.

مع تحسّن النماذج في فهم وتوليد اللغة، دفع الفريق النماذج إلى وسائط جديدة: الصور والكود. وسّع هذا التحول عمل OpenAI من الكتابة والحوار إلى الإبداع البصري وتطوير البرمجيات.

CLIP (التدريب التبايني بين اللغة والصورة)، أعلن عنه أوائل 2021، كان خطوة كبيرة نحو نماذج تفهم العالم بطريقة أقرب للبشر.

بدل التدريب فقط على صور معنونة، تعلّم CLIP من مئات الملايين من أزواج الصورة‑التعليق المأخوذة من الويب العام. تدرّب على مطابقة الصور مع أوصافها النصية الأكثر احتمالًا وتمييزها عن أوصاف خاطئة.

منح هذا CLIP قدرات عامة مدهشة:

أصبح CLIP أساسًا للأعمال التوليدية اللاحقة للصور في OpenAI.

طبّق DALL·E (2021) بنى شبيهة بـ GPT على الصور، مولدًا صورًا من أوامر نصية: "كرسي بشكل أفوكادو" أو "لافتة متجر كتب تقول 'openai'". أظهر أن نماذج اللغة يمكن تمديدها لإنتاج صور متماسكة وغالبًا ما تكون خيالية.

حسّن DALL·E 2 (2022) الدقة والواقعية والتحكّم، وقدم ميزات مثل:

غيرت هذه الأنظمة طريقة عمل المصممين والمسوقين والفنانين، وحوّلت جزءًا من العمل الإبداعي إلى استكشاف تكراري مُوجَّه بالمطالبات.

أخذ Codex (2021) عائلة GPT‑3 وكيّفها مع الشيفرة المصدريّة، مدرّبًا على قواعد شيفرة عامة كبيرة. يمكنه تحويل اللغة الطبيعية إلى مقاطع شيفرة وظيفية بلغات مثل Python وJavaScript وغيرها.

جلب GitHub Copilot—المبني على Codex—هذه الفكرة إلى أدوات التطوير اليومية. بدأ المبرمجون يتلقون دوال كاملة، اختبارات، وقالب boilerplate كمقترحات عبر تعليقات طبيعية.

بالنسبة لتطوير البرمجيات، لمّح Codex إلى تحول تدريجي:

معًا برهن CLIP وDALL·E وCodex أن نهج OpenAI يمتد خارج النص إلى الرؤية والشيفرة، موسعًا تأثير أبحاثها عبر الفن والتصميم والهندسة.

أطلقت OpenAI ChatGPT كـ "معاينة بحثية" مجانية في 30 نوفمبر 2022، مع إعلان مُقتضب في مدوّنة وتغريدة بدل حملة منتجاتية كبيرة. اعتمد النموذج على GPT‑3 وتم تحسينه للحوار، مع ضوابط لرفض بعض الطلبات الضارة أو غير الآمنة.

ارتفع الاستخدام بسرعة هائلة. سجّل ملايين الأشخاص في أيام قليلة، وأصبح ChatGPT واحدًا من أسرع تطبيقات المستهلك نموًا على الإطلاق. انتشرت لقطات محادثات على وسائل التواصل بينما اختبر المستخدمون قدرته على كتابة المقالات، تصحيح الشيفرة، صياغة الرسائل، وشرح الموضوعات المعقّدة بلغة بسيطة.

جاءت جاذبية ChatGPT من تنوع استخداماته بدل حالة استخدام واحدة ضيّقة.

في التعليم، استخدم الطلاب ChatGPT لتلخيص القراءات، توليد أسئلة تدريبية، ترجمة أو تبسيط مقالات أكاديمية، والحصول على شروحات خطوة‑بخطوة لمسائل رياضيات أو علوم. جرب المدرّسون استخدامه لتصميم مناهج، صياغة معايير تقييم، وإنشاء مواد تعلم مختلفة المستويات، بينما ناقشت المدارس إذا وكيف يُسمح باستخدامه.

في أماكن العمل، استعان المحترفون به لصياغة رسائل إلكترونية، نسخ تسويقية، تقارير، وضع مخططات عروض، توليد مقاطع شيفرة، كتابة اختبارات، والعمل كشريك للعصف الذهني.

بالنسبة للمستخدم اليومي، لجأ الناس إلى ChatGPT لتخطيط السفر، اقتراح وصفات بناءً على مكونات الثلاجة، تفسيرات قانونية وطبية مبسطة (مع التنبيه لطلب استشارة مختص)، ومساعدة في تعلم مهارات ولغات جديدة.

كانت المعاينة البحثية مجانية لتقليل العوائق وجمع ملاحظات حول الأخطاء وسوء الاستخدام والقدرات المفقودة. مع تزايد الاستخدام، واجهت OpenAI تكاليف بنية تحتية عالية وطلبًا على وصول أكثر موثوقية.

في فبراير 2023، قدّمت OpenAI ChatGPT Plus، خطة اشتراك توفر استجابات أسرع، أولوية أثناء أوقات الذروة، والوصول المبكر إلى ميزات ونماذج جديدة مثل GPT‑4. ولّد ذلك تدفقًا إيراديًا متكررًا مع الإبقاء على مستوى مجاني للوصول الواسع.

مع مرور الوقت أضافت OpenAI خيارات موجهة للأعمال: وصول API إلى نفس نماذج المحادثة، أدوات للاندماج في المنتجات وسير العمل، وعروض مثل ChatGPT Enterprise وخطط للفِرق التي تحتاج أمانًا أعلى، ضوابط إدارية، وميزات امتثال.

كبّر ظهور ChatGPT الجدل القائم حول الذكاء الاصطناعي.

قلق المنظمون وصانعو السياسات بشأن الخصوصية وحماية البيانات والامتثال للقوانين، خاصةً في مناطق مثل الاتحاد الأوروبي. قيّدت بعض السلطات مؤقتًا أو حقّقت في ChatGPT أثناء تقييم مطابقة جمع البيانات ومعالجتها للمعايير القانونية.

واجه التعليم قضايا الانتحال والنزاهة الأكاديمية إذ يمكن للطلاب توليد مقالات وواجبات يصعب اكتشافها. قادت ذلك إلى حظر أو سياسات صارمة في بعض المدارس، بينما حولت مدارس أخرى التقييم ليركز على الإجراءات والاختبارات الشفوية أو الأعمال داخل الصف.

نبه الأخلاقيون والباحثون إلى مخاطر التضليل، الاعتماد المفرط على الذكاء الاصطناعي في القرارات الحرجة، التحيّز في الردود، وتأثيرها على وظائف الإبداع والمعرفة. وثار جدل حول بيانات التدريب وحقوق الفنانين والكتاب الذين قد تكون أعمالهم أثّرت على سلوك النموذج.

بالنسبة لـ OpenAI، شكّل ChatGPT نقطة تحول: حول المنظمة من مختبر بحثي إلى شركة في مركز نقاشات عالمية حول كيفية نشر نماذج اللغة القوية وحوكمتها ودمجها في الحياة اليومية.

أطلقت OpenAI GPT‑4 في مارس 2023 كخطوة كبيرة تتجاوز GPT‑3.5، النموذج الذي دفع ChatGPT مبدئيًا. حسّن GPT‑4 من قدرات الاستدلال، تنفيذ التعليمات المعقّدة، والحفاظ على تماسك المحادثات الطويلة. كما تحسّن في التعامل مع المطالبات الدقيقة مثل شرح بنود قانونية، تلخيص أوراق تقنية، أو توليد شيفرة من متطلبات غامضة.

مقارنة بـ GPT‑3.5، خفّف GPT‑4 العديد من أوضاع الفشل الواضحة: كان أقل ميلًا لاختلاق مصادر عند طلب الاستشهاد، تعامل مع الحالات الحافة في الرياضيات والمنطق بشكل أكثر موثوقية، وقدم مخرجات أكثر اتساقًا عبر استعلامات مكررة.

قدّم GPT‑4 قدرات متعددة الوسائط: إلى جانب النص، يمكنه استقبال الصور كمدخلات في بعض تهيئات الاستخدام. يمكّن ذلك حالات استخدام مثل وصف الرسوم البيانية، قراءة ملاحظات مكتوبة بخط اليد، تفسير لقطات واجهة المستخدم، أو تحليل صور لاستخراج معلومات منظمة.

على المقاييس المعيارية، تفوق GPT‑4 بشكل ملحوظ على النماذج السابقة. حقق نتائج قريبة من أعلى النسب المئوية في اختبارات مهنية محاكاة مثل امتحانات المحامين وامتحانات SAT واختبارات متقدمة أخرى. كما تحسّن في المعايير المتعلقة بالبرمجة والاستدلال.

أصبح GPT‑4 بسرعة قلب نظام OpenAI وموّجهًا لموجة جديدة من منتجات الطرف الثالث: مساعدو الذكاء الاصطناعي في حزم الإنتاجية، مساعدي الترميز، أدوات دعم العملاء، منصات التعليم، وتطبيقات متخصصة في القانون والتمويل والرعاية الصحية.

رغم هذه التقدّمات، يظل GPT‑4 معرضًا للهلوسة، يمكن توجيهه لإنتاج مخرجات متحيزة أو غير آمنة، ويفتقر إلى فهم حقيقي أو معلومات محدثة. ركّزت OpenAI كثيرًا على أبحاث المحاذاة لـ GPT‑4—باستخدام تقنيات مثل التعلم المعزز من تغذية راجع الإنسان، red‑teaming، وقواعد أمان على مستوى النظام—لكنها تؤكّد أن النشر الحذر، المراقبة، والبحث المستمر ضروريون لإدارة المخاطر والإساءة.

تأسست OpenAI في 2015 كمختبر بحثي غير ربحي بهدف ضمان أن الذكاء العام الاصطناعي (AGI)، إذا تم تصنيعه، يعود بالنفع على البشرية جمعاء.

العوامل التي شكّلت تأسيسها تشمل:

قصة النشأة هذه تواصل التأثير على هيكل OpenAI وشراكاتها والتزاماتها العلنية اليوم.

يشير مصطلح AGI (الذكاء العام الاصطناعي) إلى أنظمة ذكاء قادرة على أداء مجموعة واسعة من المهام المعرفية بمستوى يضاهي أو يتجاوز البشر، بدلاً من أن تكون أدوات ضيقة مُحسّنة لمهمة واحدة.

مهمة OpenAI تتضمن:

هذه المهمة مُؤَطَّرة في ميثاق OpenAI وتشكل قرارات رئيسية بشأن اتّجاهات البحث والنشر والنشر التدريجي للتقنيات.

انتقلت OpenAI من كيان غير ربحي خالص إلى شراكة محدودة "ذات ربحٍ محدود" (OpenAI LP) لتمكين جمع رأس مال كبير مطلوب لأبحاث الذكاء الاصطناعي المتقدمة، مع محاولة إبقاء المهمة الأصلية في صدارة الأولويات.

النقاط الأساسية:

إجراءٌ تجريبي في الحوكمة، ولا يزال قيد النقاش حول مدى فعاليته.

تزود مايكروسوفت OpenAI بقدرات حوسبة سحابية هائلة عبر Azure واستثمرت مليارات الدولارات في الشركة.

تشمل الفوائد المتبادلة:

مقابل ذلك تحصل OpenAI على الموارد اللازمة لتدريب ونشر النماذج المتطورة على نطاق عالمي، وتحصل مايكروسوفت على قدرات ذكاء اصطناعي تميّز منظومتها.

سلسلة GPT تُظهر تطورًا في الحجم والقدرات واستراتيجية النشر:

بدأت OpenAI بنهج "مفتوح افتراضيًا"—نشر الأبحاث، الأدوات، والمشروعات العامة. مع تزايد قدرات النماذج، انتقلت إلى سياسات أكثر تحفظًا:

تقول OpenAI إن هذا التحوّل ضروري للتقليل من مخاطر إساءة الاستخدام ولأسباب أمنية. وينتقدها آخرون لأن الاسم "OpenAI" يوحي بمستوى أعلى من الانفتاح مما هو حاصل اليوم.

تستخدم OpenAI مزيجًا من الهياكل التنظيمية والأساليب التقنية لإدارة السلامة وتقليل المخاطر:

تقلل هذه الإجراءات المخاطر لكنها لا تقضي عليها؛ ولا تزال تُواجه مشكلات مثل الهلوسة، التحيّز، وإمكانية الإساءة.

أطلق ChatGPT في أواخر 2022 واجتذب ملايين المستخدمين بسرعة، ما جعله نقطة تحوّل لأنه جعل نماذج اللغة الكبيرة متاحة مباشرة للعامة عبر واجهة دردشة بسيطة.

الأثر كان واسع النطاق:

زوّد هذا الانتشار OpenAI بوضوح واهتمام تنظيمي وأخلاقي متزايد.

نماذج OpenAI، لا سيما Codex وGPT‑4، بدأت تُغيّر أجزاءً من العمل المعرفي والإبداعي:

فوائد محتملة:

المخاطر:

يمكن المشاركة في نظام OpenAI بطرق مختلفة:

في كل الأحوال، يساعد السعي للشفافية والمساءلة والعدالة عند تزايد قدرة هذه النماذج.

كل مرحلة دفعت حدود التقنية وأجبرت OpenAI على اتخاذ قرارات جديدة بشأن السلامة والوصول والتجاريّة.

الأثر الصافي يعتمد على السياسات وخيارات الشركات وكيفية دمج الأفراد والمؤسسات لهذه الأدوات.