31 أكتوبر 2025·8 دقيقة

القرارات المبكرة لجو بيدا في Kubernetes التي شكلت منصات التطبيقات الحديثة

نظرة واضحة على قرارات جو بيدا المبكرة في Kubernetes—النموذج الإعلاني، حلقات التحكم، Pods، Services، والوسوم—وكيف شكلت منصات التطبيقات الحديثة.

نظرة واضحة على قرارات جو بيدا المبكرة في Kubernetes—النموذج الإعلاني، حلقات التحكم، Pods، Services، والوسوم—وكيف شكلت منصات التطبيقات الحديثة.

كان جو بيدا واحدًا من الأشخاص الأساسيين وراء تصميم Kubernetes المبكر—إلى جانب مؤسسين آخرين نقلوا دروسًا من أنظمة Google الداخلية إلى منصة مفتوحة. تأثيره لم يكن مطاردة ميزات رائجة؛ بل اختيار بدائيات بسيطة تستطيع الصمود في فوضى الإنتاج الحقيقية وتظل مفهومة لفرق يومية.

هذه القرارات المبكرة هي السبب في أن Kubernetes أصبح أكثر من "أداة للحاويات". لقد تحوّل إلى نواة قابلة لإعادة الاستخدام لمنصات التطبيقات الحديثة.

"تنسيق الحاويات" هو مجموعة القواعد والأتمتة التي تحافظ على تشغيل تطبيقك عندما تفشل الآلات أو ترتفع حركة المرور أو تنشر نسخة جديدة. بدل أن يقوم إنسان بمراقبة الخوادم، يقوم النظام بجدولة الحاويات على الحواسيب، ويعيد تشغيلها عند تعطلها، ويوزعها لتحقيق المرونة، ويربط الشبكات حتى يتمكّن المستخدمون من الوصول إليها.

قبل انتشار Kubernetes، غالبًا ما كانت الفرق تربط سكربتات وأدوات مخصّصة للإجابة عن أسئلة أساسية:

عملت تلك الأنظمة المخصّصة—إلى أن توقفت عن العمل. كل تطبيق أو فريق جديد أضاف منطقًا مخصصًا، وأصبح تحقيق اتساق تشغيلّي صعبًا.

يمر هذا المقال على قرارات تصميم Kubernetes المبكرة (شكل Kubernetes) ولماذا لا تزال تؤثّر في المنصات الحديثة: النموذج الإعلاني، الـ controllers، Pods، الوسوم، Services، واجهة API قوية، حالة مجموعة متسقة، جدولة قابلة للتوصيل، وقابلية التوسع. حتى إن لم تكن تشغّل Kubernetes مباشرة، فمن المرجح أنك تستخدم منصة مبنية على هذه الأفكار—أو تواجه نفس المشكلات.

قبل Kubernetes، "تشغيل الحاويات" كان يعني عادة تشغيل بعض الحاويات فقط. ربطت الفرق سكربتات bash، وظائف cron، صور ذهبية، وعددًا من الأدوات المؤقتة لنشر الأمور. عندما ينكسر شيء، كان الحل غالبًا في رأس شخص ما—أو في README لا يثق به أحد. كانت العمليات سلسلة من التدخّلات لمرة واحدة: إعادة تشغيل عمليات، إعادة توجيه موازنات التحميل، تنظيف القرص، والتخمين أي آلة آمنة للمس.

سهلت الحاويات التغليف، لكنها لم تزل الأجزاء الفوضوية من الإنتاج. على نطاق واسع، يفشل النظام بطرق أكثر وفي أوقات أكثر: تختفي العقد، تقطع الشبكات، تنتشر الصور بشكل غير متجانس، وتنحرف الأحمال عن ما تظن أنه يعمل. يمكن أن يتحول نشر "بسيط" إلى سلسلة من المشكلات—بعض النسخ تُحدّث وبعضها لا، بعضها عالق، بعضها يصلح لكنه لا يُرى.

المشكلة الحقيقية لم تكن بدء الحاويات، بل الحفاظ على تشغيل الحاويات الصحيحة بالشكل الصحيح رغم التغيّر المستمر.

كانت الفرق أيضًا تتعامل مع بيئات مختلفة: معدات داخلية، آلات افتراضية، مزوّدي سحابة مبكرة، وتشكيلات شبكات وتخزين متنوّعة. كل منصة لها مفرداتها ونماذج فشلها. دون نموذج مشترك، كل ترحيل كان يعني إعادة كتابة أدوات التشغيل وإعادة تدريب الناس.

سعى Kubernetes إلى تقديم طريقة واحدة ومتماسكة لوصف التطبيقات واحتياجاتها التشغيلية، بغض النظر عن مكان وجود الآلات.

كان المطورون يريدون خدمة ذاتية: النشر دون تذاكر، التكبير دون طلب سعة، والتراجع دون دراما. أرادت فرق التشغيل قابلية التنبؤ: فحوص صحّة موحّدة، عمليات نشر قابلة للتكرار، ومصدر حقيقة واضح لما يجب أن يكون شغّالًا.

لم يكن هدف Kubernetes أن يكون مجرّد مجدول أنيق. كان يهدف لأن يكون أساسًا لمنصة تطبيقات موثوقة—تحوّل الواقع الفوضوي إلى نظام يمكنك التفكير فيه.

أحد أكثر الاختيارات تأثيرًا كان جعل Kubernetes إعلانيًا: تَصِف ما تريد، والنظام يعمل لجعل الواقع يطابق ذلك الوصف.

الترموستات مثال يومي مفيد. لا تقوم بتشغيل المدفأة وإيقافها كل بضع دقائق يدويًا. تعيّن درجة حرارة مرغوبة—مثلاً 21°C—ويستمر الترموستات في فحص الغرفة وضبط المدفأة للبقاء قريبًا من الهدف.

يعمل Kubernetes بنفس الطريقة. بدل أن تقول للعنقود خطوة بخطوة "شغّل هذا الحاوية على هذه الآلة، ثم أعد تشغيلها إن تعطل"، تُعلن النتيجة: "أريد 3 نسخ من هذا التطبيق تعمل". تَفحص Kubernetes باستمرار ما يعمل فعليًا وتصحّح الانحراف.

التكوين الإعلاني يقلّل قائمة الإجراءات اليدوية التي غالبًا ما تكون في رأس شخص ما أو في دليل تشغيل مُحدّث جزئيًا. تطبّق التكوين، ويتعامل Kubernetes مع الآليات—المكان، وإعادة التشغيل، ومصالحة التغييرات.

كما يجعل مراجعة التغيير أسهل. يصبح التغيير مرئيًا كـ diff في التكوين، وليس كسلسلة أوامر آنيّة.

لأن الحالة المطلوبة مكتوبة، يمكنك إعادة استخدام نفس النهج في التطوير، والاختبار، والإنتاج. قد تختلف البيئة، لكن النية تبقى ثابتة، مما يجعل عمليات النشر أكثر قابلية للتنبؤ وأسهل للمراجعة.

الأنظمة الإعلانية لها منحنى تعلّم: تحتاج التفكير في "ما الذي يجب أن يكون صحيحًا" بدلًا من "ما الذي أفعله بعد ذلك". كما أنها تعتمد اعتمادًا كبيرًا على الافتراضات الجيدة والاتفاقيات الواضحة—بدونها قد تنتج فرق تكوينات تعمل تقنيًا لكنها صعبة الفهم والصيانة.

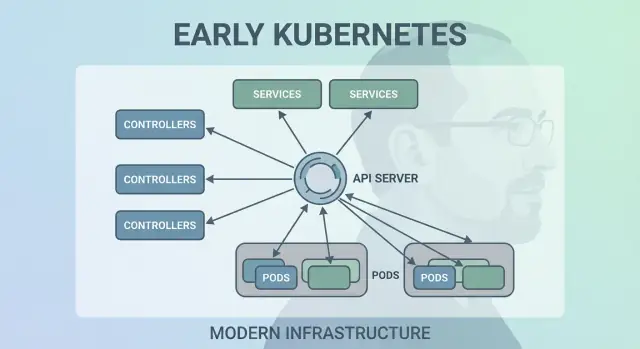

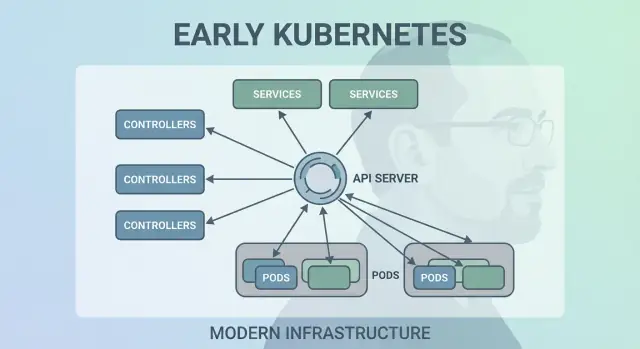

لم ينجح Kubernetes لأنه قادر على تشغيل الحاويات مرة واحدة—بل لأنه يحافظ على تشغيلها بشكل صحيح مع مرور الوقت. الحركية الكبرى في التصميم كانت جعل "حلقات التحكم" (controllers) المحرّك المركزي للنظام.

الـ controller هو حلقة بسيطة:

إنه أقل مثل مهمة لمرة واحدة وأكثر مثل الطيار الآلي. لا تُلاطف الأحمال؛ تصف ما تريد، وتستمر الـ controllers في توجيه العنقود نحو تلك النتيجة.

هذا النمط هو سبب مرونة Kubernetes عندما تحدث الأمور الحقيقية:

بدل التعامل مع الفشل كحالات خاصة، تعامل الـ controllers معها كـ "اختلاف حالة" روتيني ويصلحونه بنفس الطريقة في كل مرة.

السكربتات التقليدية تفترض غالبًا بيئة مستقرة: نفّذ الخطوة A ثم B ثم C. في الأنظمة الموزّعة تنهار تلك الافتراضات باستمرار. تتوسع الـ controllers أفضل لأنها قابلة للتكرار (آمنة للتشغيل مرارًا) ومتسقة في النهاية (تستمر بالمحاولة حتى الوصول إلى الهدف).

Deployment وReplicaSetإذا استخدمت Deployment، فقد اعتمدت على حلقات التحكم. تحت السطح، يستخدم Kubernetes ReplicaSet controller لضمان وجود عدد الـ pods المطلوب—وDeployment controller لإدارة التحديثات التدريجية والتراجع بشكل متوقع.

Pods كوحدة جدولة ذريةكان من الممكن أن يحدد Kubernetes جدولة "الحاويات فقط"، لكن فريق جو بيدا قدم مفهوم الـ Pod لتمثيل أصغر وحدة قابلة للنشر يضعها العنقود على آلة. الفكرة الأساسية: كثير من التطبيقات الحقيقية ليست عملية واحدة؛ إنها مجموعة صغيرة من العمليات المترابطة التي يجب أن تعيش معًا.

Pods بدل الحاويات الفردية؟الـ Pod هو غلاف حول حاوية واحدة أو أكثر تشترك في المصير: تبدأ معًا، تعمل على نفس العقدة، وتتكاثف معًا. هذا يجعل أنماطًا مثل sidecars طبيعية—فكر في مرسال سجلات، بروكسي، مُحدّث إعدادات، أو وكيل أمني يجب أن يرافق التطبيق الرئيسي دائمًا.

بدل أن تُعلم كل تطبيق كيف يندمج مع هذه المساعدات، يتيح Kubernetes حزمها كحاويات منفصلة لكنها تتصرف كوحدة واحدة.

Pods للشبكات والتخزينجعلت الـ Pods افتراضين مهمين عمليين:

Pod تشترك بهوية شبكة واحدة (IP واحد ومساحة منافذ واحدة). يمكن للتطبيق الرئيسي أن يتحدث مع الـ sidecar عبر localhost، وهو بسيط وسريع.Pod مشاركة الـ volumes. يكتب مساعد ملفات يقرأها التطبيق الرئيسي بدون قفزات خارجية محرجة.هذه الاختيارات قلّلت الحاجة إلى كود ربط مخصّص، بينما حافظت على عزل الحاويات على مستوى العمليات.

يتوقع المستخدمون الجدد غالبًا "حاوية واحدة = تطبيق واحد"، ثم يتعثّرون بمفاهيم مستوى الـ Pod: إعادة التشغيل، العناوين IP، والتوسع. كثير من المنصات تُسهّل ذلك من خلال توفير قوالب ذات آراء محدّدة (مثل "خدمة ويب"، "عامل"، أو "مهمة") التي تولّد Pods خلف الكواليس—حتى تحصل الفرق على فوائد sidecars والموارد المشتركة دون التفكير في آليات الـ Pod كل يوم.

اختيار هادئ وقوي في Kubernetes كان التعامل مع الوسوم كبيانات وصفية من الدرجة الأولى والـ selectors كطريقة أساسية "للعثور" على الأشياء. بدل القرائن الثابتة (مثل "هذه الثلاث آلات بالضبط تشغّل تطبيقي"), يشجّع Kubernetes على وصف المجموعات بصفات مشتركة.

الوسم هو زوج مفتاح/قيمة بسيط تلصقه بالموارد—Pods, Deployments, Nodes, Namespaces، وأكثر. تعمل كعلامات قابلة للاستعلام:

app=checkoutenv=prodtier=frontendلأن الوسوم خفيفة ومعرّفة من المستخدم، يمكنك نمذجة واقع مؤسستك: الفرق، مراكز التكلفة، مناطق الامتثال، قنوات الإصدار، أو أي ما يهم تشغيلك.

الـ selectors هي استعلامات على الوسوم (مثلاً "كل الـ Pods حيث app=checkout وenv=prod"). هذا أفضل من قوائم المضيفين الثابتة لأن النظام يستطيع التكيّف عندما تُعاد جدولة الـ Pods أو تُكبّر/تصغّر أو تُستبدل أثناء التحديثات. يبقى تكوينك مستقرًا حتى عندما تتغير الحالات الأساسية باستمرار.

يصميم كهذا يتوسع تشغيليًا: لا تدير آلاف هويات الحالات—تدير عددًا قليلاً من مجموعات الوسوم المعنوية. هذه جوهر الارتباط الضعيف: المكونات تتصل بـ مجموعات يمكن أن تتغير عضويتها بأمان.

بمجرد وجود الوسوم تصبح مفردة مشتركة عبر المنصة. تُستخدم لتوجيه المرور (Services)، حدود السياسات (NetworkPolicy)، فلاتر القياس/السجلات، وحتى تتبع التكلفة. فكرة بسيطة—وسم العناصر بشكل متسق—تفتح نظامًا من الأتمتة.

Services للشبكات الثابتةكان بحاجة Kubernetes إلى طريقة تجعل الشبكات تبدو متوقعة رغم أن الحاويات بعيدة عن ذلك. تُستبدل الـ Pods وتُعاد جدولة وتُكبّر وتُتصغّر—لذا تتغير عناوين IP وحتى الآلات. الفكرة الأساسية لـ Service بسيطة: قدّم "بابًا أماميًا" ثابتًا لمجموعة متغيرة من الـ Pods.

تعطيك الـ Service IP افتراضيًا واسم DNS ثابتًا (مثل payments). خلف هذا الاسم، يتتبّع Kubernetes باستمرار أي Pods تطابق selector الخاص بالـ Service ويوجّه المرور وفقًا لذلك. إذا مات Pod وظهر آخر جديد، تستمر الـ Service في الإحالة إلى المكان الصحيح من دون أن تغيّر إعدادات التطبيق.

أزالت هذه المقاربة الكثير من التوصيلات اليدوية. بدل وضع عناوين IP في ملفات التكوين، تعتمد التطبيقات على الأسماء. تنشر التطبيق وتُنشر الـ Service ويجده مكونات أخرى عبر DNS—دون مسجل خاص أو نقاط نهاية ثابتة.

قدّمت الـ Services سلوك موازنة تحميل افتراضيًا عبر النقاط النهائية الصحية. هذا يعني أن الفرق لم تضطر لبناء موازن تحميل خاص لكل خدمة داخلية. توزيع المرور يقلّل نصف قطر تأثير فشل Pod واحد ويجعل التحديثات التدريجية أقل خطورة.

الـ Service ممتاز لطبقة L4 (TCP/UDP)، لكنه لا يصف قواعد توجيه HTTP أو إنهاء TLS أو سياسات الحافة. هنا يأتي دور Ingress و، بشكل متزايد، Gateway API: يبنون على الـ Services للتعامل مع أسماء المضيفين، المسارات، ونقاط الدخول الخارجية بشكل أوضح.

أحد أكثر الخيارات جرأةً كان اعتبار Kubernetes كـ API تتعامل معه—وليس كأداة متمركزة لاستعمالها فقط. جعل واجهة الـ API هذه السطح الرئيسي جعل Kubernetes يبدو أقل كمنتج تنقر عليه وأكثر كمنصة يمكنك توسيعها وبرمجتها وإدارتها.

عندما تكون الـ API هي مساحة السطح، تستطيع فرق المنصة توحيد كيفية وصف التطبيقات وإدارتها، بغض النظر عن أي واجهة مستخدم، أو خط أنابيب، أو بوابة داخلية فوقها. "نشر تطبيق" يصبح "إرسال وتحديث كائنات API" مثل Deployments, Services, وConfigMaps، وهو عقد أنظف بين فرق التطبيقات والمنصة.

بما أن كل شيء يمر عبر نفس الـ API، لا تحتاج الأدوات الجديدة إلى ممرات خلفية مميّزة. يمكن للداشبوارات، متحكمات GitOps، محركات السياسات، وأنظمة CI/CD العمل كعملاء API عاديين بأذونات محدودة.

هذا التماثل مهم: تنطبق نفس القواعد، والمصادقة، والتدقيق، وضوابط القبول سواء جاءت الطلبات من شخص، سكربت، أو واجهة منصة داخلية.

سمح إصدار نسخ الـ API بتطوير Kubernetes دون كسر كل عنقود أو كل أداة بين ليلة وضحاها. يمكن جدولة الإهمالات؛ يمكن اختبار التوافق؛ ويمكن التخطيط للترقيات. للمؤسسات التي تشغل عناقيد لسنوات، هذا الفارق بين "نستطيع الترقية" و"علينا البقاء عالقين".

kubectl فعليًاkubectl ليس Kubernetes—إنه عميل. هذا النموذج الذهني يدفع الفرق للتفكير في سير عمل الـ API: يمكنك استبدال kubectl بأتمتة، أو واجهة ويب، أو بوابة مخصّصة، ويظل النظام متسقًا لأن العقد هو الـ API نفسه.

etcd) والتناسقكان بحاجة Kubernetes إلى "مصدر حقيقة" واحد لما يجب أن تبدو عليه المجموعة الآن: أي Pods موجودة، أي عقد صحية، إلى أي Services تُشير، وأي كائنات تُحدّث. هذا ما يوفره etcd.

etcd (بكلمات بسيطة)etcd هي قاعدة بيانات لوحة التحكم. عندما تنشئ Deployment، أو تكبّر ReplicaSet، أو تحدّث Service، تُكتب التهيئة المطلوبة في etcd. ثم تراقب الـ controllers وباقي مكونات لوحة التحكم هذه الحالة المخزنة وتعمل لجعل الواقع مطابقًا لها.

عنقود Kubernetes مليء بأجزاء متحرّكة: المجدول، controllers، kubelets، autoscalers، وفحوص القبول يمكن أن تتفاعل في آن واحد. إذا كانوا يقرؤون نسخًا مختلفة من "الحقيقة" تحصل سباقات—مثل عنصرين يتخذان قرارات متعارضة عن نفس الـ Pod.

تناسق etcd القوي يضمن أنه عندما تقول لوحة التحكم "هذه هي الحالة الحالية"، يكون الجميع متوافقين. هذا التوافق هو ما يجعل حلقات التحكم متوقعة بدلًا من كاوسية.

بما أن etcd يحوي تهيئة العنقود وتاريخ التغييرات، فهو أيضًا ما تحميه أثناء:

etcd، لا يمكنك استعادة كائنات العنقود بثقة.etcd واللقطات تقلّل مخاطر الترقية.etcd غالبًا أسرع طريق لإعادة لوحة التحكم مع نفس النية.عامل حالة لوحة التحكم كبيانات حرجة. التقط لقطات etcd دورية، اختبر الاستعادة، وخزن النسخ خارج العنقود. إذا تشغّل Kubernetes مدارًة، تعرّف على ما ينسخه المزود وما ينبغي أن تُنسخه بنفسك (مثلاً الأحجام الدائمة وبيانات التطبيقات).

لم يعامل Kubernetes "أين تعمل الحمولات" كأمر ثانوي. في وقت مبكر كان المجدول مكوّنًا مستقلًا بمهمة واضحة: مطابقة الـ Pods مع العقد القادرة على تشغيلها، باستخدام حالة العنقود ومتطلبات الـ Pod.

على مستوى عالٍ، التنسيق له خطوتان:

جعلت هذه البنية من الممكن تطوير جدولة Kubernetes دون إعادة كتابة كل شيء.

اختيار تصميمي رئيسي كان الحفاظ على فصل المسؤوليات:

لأن هذه المسؤوليات مفصولة، تحسين في مجال واحد (مثل إضافة مكون CNI جديد) لا يفرض نموذج جدولة جديد.

بدأ الوعي بالموارد بـ requests وlimits، مانحًا المجدول إشارات مفيدة بدل التخمين. من هناك أضيفت ضوابط أغنى—node affinity/anti-affinity، pod affinity، الأولويات والإزاحة، taints وتسامحات tolerations، والانتشار الواعي بالطوبولوجيا—كلها مبنية على نفس الأساس.

يمكن هذا النهج العناقيد المشتركة اليوم: يمكن للفرق عزل الخدمات الحرجة بالأولويات والـ taints، بينما يستفيد الجميع من استغلال أعلى للموارد. مع تعبئة أفضل والتحكم بالطوبولوجيا، تضع المنصات الحمولات بكفاءة أعلى من حيث التكلفة دون التضحية بالموثوقية.

كان بإمكان Kubernetes أن يشحن بتجربة منصة كاملة وذات رأي محدد—buildpacks، قواعد توجيه التطبيق، مهام خلفية، قواعد التكوين، وأكثر. بدلًا من ذلك، أبقى جو بيدا والفريق النواة مركزة على وعد أصغر: تشغيل الأحمال وإصلاحها موثوقًا، كشفها، وتوفير API متسق للتعامل معه.

كان سيجبر "PaaS كامل" على سير عمل واحد ومجموعة واحد من التنازلات على الجميع. استهدف Kubernetes أساسًا أوسع يمكنه دعم أنماط منصات متعددة—شبّه Heroku لسهولة المطور، أو حوكمة مؤسساتية، أو دفعات وأنابيب ML، أو تحكم بنيوي بسيط—دون اقفال فلسفة منتج واحدة.

خلقت آليات قابلية التوسّع في Kubernetes طريقة محكومة لنمو القدرات:

Certificate أو Database).هذا يعني أن فرق المنصة الداخلية والبائعين يمكنهم شحن ميزات كإضافات، بينما يزالون يستخدمون بدائيات Kubernetes مثل RBAC، الـ namespaces، وسجلات التدقيق.

للبائعين، يمكنهم تمييز منتجاتهم دون تشعب Kubernetes. للفرق الداخلية، يتيح "منصة على Kubernetes" مخصصة لاحتياجات المنظمة.

المقايضة هي تشتت النظام البيئي: الكثير من CRDs، أدوات متداخلة، واتفاقيات غير متسقة. تصبح الحوكمة—المعايير، الملكية، إصدار النسخ، وقواعد الإهمال—جزءًا من عمل المنصة.

لم تخلق قرارات Kubernetes المبكرة مجرد مجدول حاويات—خلقت نواة منصة قابلة لإعادة الاستخدام. لهذا السبب كثير من منصات المطورين الداخلية الحديثة (IDPs) في جوهرها "Kubernetes زائد سير عمل برأي محدد". جعل النموذج الإعلاني، الـ controllers، وواجهة API المتسقة الإمكانية لبناء منتجات أعلى مستوى—دون إعادة اختراع النشر، والمصالحة، واكتشاف الخدمات في كل مرة.

بما أن الـ API هو سطح المنتج، يمكن للبائعين وفرق المنصة توحيد لوحة تحكم واحدة وبناء تجارب مختلفة فوقها: GitOps، إدارة عناقيد متعددة، السياسات، كتالوجات الخدمات، وأتمتة النشر. هذا سبب كبير لأن Kubernetes أصبح معيارًا للمنصات السحابية النيتف: التكاملات تستهدف الـ API، لا أداة واجهة مستخدم محددة.

حتى مع التجريدات النظيفة، يبقى أصعب العمل تشغيليًا:

اطرح أسئلة تكشف النضج التشغيلي:

منصة جيدة تقلّل العبء المعرفي دون إخفاء لوحة التحكم الأساسية أو جعل ممرات الهروب مؤلمة.

عدسة عملية: هل تساعد المنصة الفرق على الانتقال من "فكرة → خدمة تعمل" دون إجبار الجميع على أن يصبحوا خبراء Kubernetes من اليوم الأول؟ أدوات في فئة "vibe-coding"—مثل Koder.ai—تتجه نحو هذا عبر تمكين الفرق من توليد تطبيقات حقيقية من الدردشة (واجهة ويب في React، واجهات خلفية بـ Go وPostgreSQL، موبايل بـ Flutter) ثم التكرار سريعًا مع ميزات مثل وضع التخطيط، اللقطة، والتراجع. سواء اعتمدت شيئًا مماثلًا أو بنت بوابتك الخاصة، الهدف واحد: الحفاظ على بدائيات Kubernetes القوية مع تقليل عبء سير العمل حولها.

قد يبدو Kubernetes معقّدًا، لكن معظم "غرابته" مقصودة: هي مجموعة بدائيات صغيرة مصممة لتتراكب لتكوين أنواع عديدة من المنصات.

أولًا: "Kubernetes مجرد تنسيق Docker." Kubernetes ليس مخصّصًا بالدرجة الأولى لبدء الحاويات. إنه لمصالحة الحالة المطلوبة (ما تريد تشغيله) مع الحالة الفعلية (ما يحدث فعلاً)، عبر الأعطال، والتحديثات، والطلب المتغير.

ثانيًا: "إذا استخدمنا Kubernetes، سيصبح كل شيء خدمات مصغّرة." يدعم Kubernetes الخدمات المصغّرة، لكنه يدعم أيضًا المونوليثات، مهام الدُفعات، والمنصات الداخلية. الوحدات (Pods, Services, الوسوم، الـ controllers، والـ API) محايدة؛ قراراتك المعمارية ليست مفروضة من الأداة.

الأجزاء الصعبة عادةً ليست YAML أو الـ Pods—بل الشبكات، الأمان، واستخدام الفرق المتعددة: الهوية والوصول، إدارة الأسرار، السياسات، الإنجرس، المراقبة، ضوابط سلسلة التوريد، وخلق حواجز تمنع الفرق من الإضرار ببعضها البعض.

عند التخطيط، فكّر في رهانات التصميم الأصلية:

طابق متطلباتك الحقيقية مع بدائيات Kubernetes وطبقات المنصة:

الأحمال → Pods/Deployments/Jobs

الاتصال → Services/Ingress

التشغيل → controllers، سياسات، والمراقبة

إذا كنت تُقيّم أو تُوحّد، اكتب هذا التطابق وراجعه مع أصحاب المصلحة—وابنِ منصتك تدريجيًا حول الفجوات، لا حول الصيحات.

إذا كنت تحاول أيضًا تسريع جانب "البناء" (وليس فقط جانب "التشغيل"), فكّر كيف يحول سير التوصيل النية إلى خدمات قابلة للنشر. لبعض الفرق يكون ذلك مجموعة من القوالب المُنقّحة؛ ولآخرين يكون سير عمل مدعومًا بالذكاء الاصطناعي مثل Koder.ai الذي يمكنه إنتاج خدمة عمل ابتدائية بسرعة ثم تصدير الشيفرة للمزيد من التخصيص—بينما تظل منصتك تستفيد من قرارات تصميم Kubernetes الأساسية تحت السطح.

تنظيم الحاويات هو الأتمتة التي تبقي التطبيقات قيد التشغيل عند فشل الآلات أو تغيّر حركة المرور أو حدوث عمليات نشر. عمليًا يتضمن:

شاع نموذج Kubernetes كطريقة متسقة للقيام بذلك عبر بيئات بنى تحتية مختلفة.

المشكلة الأساسية لم تكن تشغيل الحاويات—بل الحفاظ على الحاويات الصحيحة بالشكل الصحيح رغم التغيّر المستمر. عند النطاق الكبير تظهر أعطال وانحرافات روتينية:

Podsهدف Kubernetes كان جعل العمليات قابلة للتكرار والتنبؤ عبر توفير لوحة تحكم ومفردات تشغيل موحدة.

في نظام إعلاني (declarative) تصف النتيجة التي تريدها (مثلاً "شغّل 3 نسخة")، والنظام يعمل باستمرار ليجعل الواقع مطابقًا للوصف.

سير العمل العملي:

kubectl apply أو عبر GitOps)هذا يقلل من "قوائم تشغيل" غير مرئية ويجعل التغييرات قابلة للمراجعة كـ diffs بدل أوامر آنيّة.

الـ controllers هي حلقات تحكّم تكرارية تقوم بِـ:

هذا التصميم يجعل الأعطال الشائعة روتينية بدل استثناءات. مثلاً، إذا تحطم Pod أو اختفت عقدة، يلاحظ الـ controller "لدينا عدد أقل من النسخ المطلوبة" ويُنشئ بدائل.

يقوم Kubernetes بجدولة Pods (ليس الحاويات الفردية) لأن كثيرًا من الأحمال الواقعية تحتاج عمليات مساعدة متلاصقة.

تمكّن Pods أنماطاً مثل:

localhost)قاعدة عملية: اجعل الـ Pods صغيرة ومتماسكة — اجمع فقط الحاويات التي يجب أن تشترك في دورة حياة أو هوية الشبكة أو بيانات محلية.

الوسوم (labels) أزواج مفتاح/قيمة خفيفة الوزن (مثل app=checkout, env=prod) وتُستخدم selectors لاستعلام هذه الوسوم لتكوين مجموعات ديناميكية.

هذا مهم لأن العناصر عرضية: تتبدل الـ Pods أثناء إعادة الجدولة أو التحديثات. بالوسوم/selectors تكون العلاقات ثابتة ("كل الـ Pods ذات هذه الوسوم") حتى لو تغيّرت الأعضاء.

نصيحة تشغيلية: قيّم قائمة وسوم صغيرة وموحّدة (app, team, env, tier) وطبّق سياسة لفرضها لتجنّب الفوضى لاحقًا.

توفر الـ Service عنوانًا افتراضيًا ثابتًا (IP افتراضي واسم DNS) يوجّه إلى مجموعة متغيرة من الـ Pods المطابقة للـ selector.

استخدم Service عندما:

للتوجيه على مستوى HTTP، وإنهاء TLS، وقواعد الحافة، عادةً تضع أو تستخدم فوق الـ Services.

يتعامل Kubernetes مع API كواجهة المنتج الأساسية: كل شيء كائن API (Deployments, Services, ConfigMaps, ...). الأدوات مثل kubectl, CI/CD, GitOps أو الواجهات الرسومية هي مجرد عملاء لهذه الـ API.

فوائد عملية:

etcd هو قاعدة بيانات لوحة التحكم ومصدر الحقيقة للمجموعة: عندما تنشئ Deployment أو تحدّث Service تُكتب النية إلى etcd. ثم تراقب الـ controllers باقي مكونات التحكم هذه الحالة لتجعل الواقع مطابقًا لها.

إرشادات عملية:

يبقي Kubernetes نواة صغيرة ويركّز على تشغيل وإصلاح الأحمال بطريقة موثوقة، مع توفير آليات امتداد:

Certificate أو Database)IngressGateway APIإذا تبني منصة داخلية، صمم سير العمل حول عقود الـ API، لا حول أداة واجهة مستخدم محددة.

etcd بيانات حرجةفي Kubernetes المدار، تعرّف على ما ينسخه المزود وما الذي يجب أن تُنسخه أنت (مثل الأقراص الدائمة وبيانات التطبيقات).

هذا يمكّن الفرق من بناء "منصة فوق Kubernetes" لكن قد يؤدي أيضًا إلى توسع أدواتي. عند تقييم منصة مبنية على Kubernetes اسأل عن: