Gantikan, Perkuat, Tetap: Kerangka Sederhana

Pembicaraan tentang apa yang “akan dilakukan AI terhadap developer” cepat membingungkan karena kita sering mencampur alat dengan tanggung jawab. Sebuah alat bisa menghasilkan kode, merangkum tiket, atau menyarankan tes. Sebuah tanggung jawab adalah apa yang tim masih harus pertanggungjawabkan ketika saran itu salah.

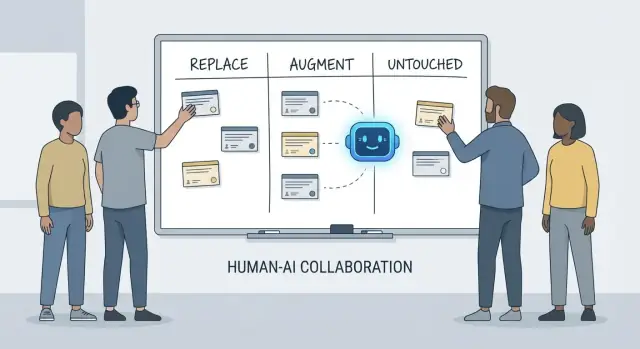

Artikel ini menggunakan kerangka sederhana—gantikan, perkuat, tetap—untuk menggambarkan pekerjaan sehari-hari di tim nyata dengan tenggat, kode warisan, insiden produksi, dan pemangku kepentingan yang mengharapkan hasil yang dapat diandalkan.

Apa arti “gantikan” (dan apa yang bukan)

Gantikan berarti AI dapat menyelesaikan tugas secara end-to-end sebagian besar waktu dengan pembatas yang jelas, dan peran manusia bergeser ke pengawasan dan pemeriksaan acak.

Contoh cenderung adalah pekerjaan terbatas: menghasilkan boilerplate, menerjemahkan kode antar bahasa, menyusun kasus uji berulang, atau membuat dokumentasi draf pertama.

Gantikan bukan berarti “tidak ada akuntabilitas manusia.” Jika keluaran merusak produksi, membocorkan data, atau melanggar standar, tanggung jawabnya tetap di tim.

Apa arti “perkuat”

Perkuat berarti AI membuat developer lebih cepat atau lebih teliti, tetapi tidak secara andal menyelesaikan pekerjaan tanpa penilaian manusia.

Ini adalah kasus umum dalam rekayasa profesional: Anda akan mendapat draf yang berguna, pendekatan alternatif, penjelasan cepat, atau daftar bug yang mungkin—tetapi developer masih memutuskan apa yang benar, aman, dan sesuai produk.

Apa yang tetap “tetap”

Tetap berarti tanggung jawab inti tetap dipimpin manusia karena membutuhkan konteks, trade-off, dan akuntabilitas yang tidak mudah dipadatkan ke dalam prompt.

Pikirkan: menegosiasikan kebutuhan, memilih batasan tingkat sistem, menangani insiden, menetapkan standar kualitas, dan membuat keputusan ketika tidak ada satu jawaban “benar”.

Mengapa tanggung jawab adalah unit analisis

Alat berubah cepat. Tanggung jawab berubah lambat.

Jadi daripada bertanya “Dapatkah AI menulis kode ini?”, tanyakan “Siapa yang memiliki hasilnya?” Framing itu menjaga ekspektasi tetap berdasar pada akurasi, keandalan, dan akuntabilitas—hal yang lebih penting daripada demo yang mengesankan.

Apa yang Dimaksud dengan “Tanggung Jawab Developer”

Ketika orang bertanya apa yang “digantikan” AI dalam pengembangan, mereka sering bermaksud tugas: menulis fungsi, menghasilkan tes, menyusun dokumentasi. Namun tim tidak mengirimkan tugas—mereka mengirimkan hasil. Di situlah tanggung jawab developer penting.

Paket tanggung jawab yang biasa

Pekerjaan developer biasanya melampaui waktu coding:

- Pengiriman: mengubah ide kabur menjadi perangkat lunak yang bekerja dan dikirim tepat waktu.

- Kualitas: ketepatan, keterpeliharaan, dan pencegahan regresi.

- Keamanan & privasi: default yang aman, penanganan data, dan kesadaran ancaman.

- Operasi: menjaga layanan berjalan, memahami mode kegagalan, dan merespons insiden.

- Komunikasi: menyelaraskan dengan produk, desain, dukungan, dan engineer lain.

Tanggung jawab ini tersebar di seluruh siklus hidup—dari “apa yang harus kita bangun?” hingga “apakah ini aman?” hingga “apa yang terjadi jam 3 pagi saat rusak?”

Mengapa ini lebih dari daftar periksa

Setiap tanggung jawab sebenarnya adalah banyak keputusan kecil: kasus tepi mana yang penting, metrik mana yang menandakan kesehatan, kapan memangkas ruang lingkup, apakah perbaikan aman untuk dikirim, bagaimana menjelaskan trade-off kepada pemangku kepentingan. AI dapat membantu menjalankan bagian-bagian pekerjaan ini (mendraf kode, mengusulkan tes, merangkum log), tetapi tanggung jawab berarti memiliki hasilnya.

Di mana serah terima gagal

Kegagalan sering terjadi pada batas serah terima:

- “QA akan menangkapnya” (tetapi tidak ada yang mendefinisikan apa arti kualitas).

- “Keamanan akan meninjau” (tetapi desain sudah mengunci pilihan yang berisiko).

- “Ops akan menangani” (tetapi layanan tidak dibangun agar mudah dioperasikan).

Saat kepemilikan tidak jelas, pekerjaan jatuh ke celah.

Hak keputusan: siapa yang memutuskan vs. yang mengeksekusi

Cara berguna berbicara tentang tanggung jawab adalah hak keputusan:

- Siapa yang memutuskan kebutuhan, trade-off, dan risiko yang dapat diterima?

- Siapa yang mengeksekusi implementasi dan verifikasi?

AI dapat mempercepat eksekusi. Hak keputusan—dan akuntabilitas atas hasil—masih perlu ada nama manusia di sampingnya.

Pekerjaan yang Sering Bisa Digantikan AI (dengan Pembatas)

Asisten pengkodean berbasis AI benar-benar berguna ketika pekerjaan dapat diprediksi, berisiko rendah, dan mudah diverifikasi. Anggap mereka sebagai rekan junior yang cepat: hebat menghasilkan draf pertama, tetapi masih membutuhkan instruksi jelas dan pengecekan hati-hati.

Di praktiknya, beberapa tim semakin sering menggunakan platform “vibe-coding” (seperti Koder.ai) untuk mempercepat potongan yang dapat digantikan ini: menghasilkan kerangka, menghubungkan alur CRUD, dan membuat draf awal UI dan backend dari chat. Intinya sama: pembatas, review, dan kepemilikan yang jelas.

Boilerplate berisiko rendah

Banyak waktu developer habis untuk menyiapkan proyek dan menghubungkan bagian. AI sering dapat menghasilkan:

- file dan folder starter (controller, route, DTO)

- "glue code" berulang antar lapisan

- endpoint CRUD sederhana yang mengikuti pola yang sudah ada

Pembatas di sini adalah konsistensi: pastikan cocok dengan konvensi yang sudah Anda pakai dan tidak menciptakan pola atau dependensi baru.

Refaktor mekanis dan migrasi

Ketika perubahan sebagian besar bersifat mekanis—mengganti nama simbol di seluruh codebase, memformat ulang, atau memperbarui penggunaan API yang sederhana—AI dapat mempercepat pekerjaan rutin.

Tetap perlakukan itu seperti edit massal: jalankan seluruh suite tes, pindai diff untuk perubahan perilaku yang tidak diinginkan, dan hindari membiarkan AI “memperbaiki” di luar ruang lingkup refaktor yang diminta.

Draf dokumentasi (harus direview)

AI dapat menyusun README, komentar inline, dan entri changelog berdasarkan kode dan catatan commit. Ini mempercepat klaritas, tetapi juga bisa menghasilkan ketepatan yang kelihatan meyakinkan namun salah.

Praktik terbaik: gunakan AI untuk struktur dan redaksi, lalu verifikasi setiap klaim—khususnya langkah setup, default konfigurasi, dan kasus tepi.

Pembuatan tes dasar sebagai titik awal

Untuk fungsi murni yang terdefinisi dengan baik, tes unit yang digenerasi AI bisa memberi cakupan awal dan mengingatkan tentang kasus tepi. Pembatasnya adalah kepemilikan: Anda tetap memilih apa yang penting, menambahkan assertion yang mencerminkan kebutuhan nyata, dan memastikan tes gagal karena alasan yang tepat.

Ringkasan thread dan log

Saat Anda punya thread Slack panjang, tiket, atau log insiden, AI dapat mengubahnya menjadi catatan ringkas dan item tindakan. Pegang itu dengan dasar konteks penuh lalu verifikasi fakta kunci, timestamp, dan keputusan sebelum dibagikan.

Pekerjaan yang Sebagian Besar AI Perkuat: Lebih Cepat, Bukan Selesai

Asisten pengkodean AI paling baik ketika Anda sudah tahu apa yang Anda inginkan dan perlu bantuan untuk melaju lebih cepat. Mereka bisa mengurangi waktu “mengetik” dan menonjolkan konteks yang berguna, tetapi mereka tidak menghilangkan kebutuhan akan kepemilikan, verifikasi, dan penilaian.

Mempercepat implementasi (draf awal yang kuat)

Dengan spesifikasi jelas—input, output, kasus tepi, dan batasan—AI dapat mendraf implementasi awal yang wajar: boilerplate, pemetaan data, handler API, migrasi, atau refaktor sederhana. Kemenangannya adalah momentum: Anda mendapatkan sesuatu yang bisa dijalankan dengan cepat.

Masalahnya, kode draf seringkali melewatkan persyaratan halus (semantik error, batasan performa, kompatibilitas mundur). Perlakukan itu seperti draf magang: berguna, tetapi bukan otoritatif.

Mengusulkan opsi—dengan trade-off yang harus Anda validasi

Saat memilih antara pendekatan (mis. caching vs. batching, optimistic vs. pessimistic locking), AI dapat mengusulkan alternatif dan daftar trade-off. Ini berguna untuk brainstorming, tetapi trade-off itu harus dicek terhadap realitas sistem Anda: bentuk lalu lintas, kebutuhan konsistensi data, batasan operasional, dan konvensi tim.

Pemahaman kode dan navigasi codebase

AI juga kuat dalam menjelaskan kode yang tidak dikenal, menunjukkan pola, dan menerjemahkan “apa ini lakukan?” ke bahasa biasa. Dipadukan dengan alat pencarian, AI dapat membantu menjawab “Di mana X digunakan?” dan menghasilkan daftar dampak dari situs panggilan, konfigurasi, dan tes yang perlu ditinjau.

Ergonomi developer: loop umpan balik lebih baik

Harapkan perbaikan kualitas hidup praktis: pesan error yang lebih jelas, contoh kecil, dan snippet siap-tempel. Ini mengurangi gesekan, tetapi tidak menggantikan review hati-hati, jalankan lokal, dan tes terarah—terutama untuk perubahan yang mempengaruhi pengguna atau sistem produksi.

Pemahaman Produk dan Kebutuhan: Masih Dipimpin Manusia

AI dapat membantu menulis dan menyempurnakan kebutuhan, tetapi ia tidak dapat secara andal memutuskan apa yang harus kita bangun atau mengapa itu penting. Pemahaman produk berakar pada konteks: tujuan bisnis, rasa sakit pengguna, kendala organisasi, kasus tepi, dan biaya jika salah. Input itu hidup dalam percakapan, sejarah, dan akuntabilitas—hal yang dapat dirangkum model, tetapi tidak benar-benar dimiliki.

Mengubah tujuan kabur menjadi sesuatu yang dapat dibangun

Permintaan awal sering terdengar seperti “Buat onboarding lebih mulus” atau “Kurangi tiket dukungan.” Tugas developer adalah menerjemahkan itu menjadi kebutuhan jelas dan kriteria penerimaan.

Terjemahan itu sebagian besar kerja manusia karena bergantung pada pertanyaan penggalian dan penilaian:

- Segment pengguna mana yang kita optimalkan, dan perilaku apa yang harus berubah?

- Apa yang dihitung sebagai “selesai”, dan bagaimana kita mengukurnya?

- Kendala mana yang tidak bisa ditawar (privasi, performa, tenggat)?

AI dapat menyarankan metrik atau mendraf kriteria penerimaan, tetapi ia tidak akan tahu kendala mana yang nyata kecuali seseorang menyediakannya—dan ia tidak akan menolak jika permintaan kontradiktif.

Trade-off dan manajemen ekspektasi

Pekerjaan kebutuhan adalah tempat trade-off yang tidak nyaman muncul: waktu vs. kualitas, kecepatan vs. keterpeliharaan, fitur baru vs. stabilitas. Tim perlu orang untuk menjelaskan risiko, mengusulkan opsi, dan menyelaraskan pemangku kepentingan pada konsekuensi.

Spesifikasi yang baik bukan hanya teks; ia adalah catatan keputusan. Itu harus dapat diuji dan diimplementasikan, dengan definisi tegas (input, output, kasus tepi, dan mode kegagalan). AI dapat membantu menyusun dokumen, tetapi tanggung jawab kebenaran—dan mengatakan “ini ambigu, kita perlu keputusan”—tetap di tangan manusia.

Keputusan Desain Sistem dan Arsitektur

Desain sistem adalah tempat “apa yang harus kita bangun?” berubah menjadi “di atas apa kita membangunnya, dan bagaimana perilakunya saat situasi buruk terjadi?” AI dapat membantu menjelajahi opsi, tetapi ia tidak dapat memikul konsekuensi.

Memilih arsitektur yang sesuai kenyataan

Memilih antara monolit, modular monolith, microservices, serverless, atau platform terkelola bukan soal kuis dengan satu jawaban benar. Ini soal kesesuaian: skala yang diharapkan, batasan anggaran, time-to-market, dan keterampilan tim.

Asisten dapat merangkum pola dan mengusulkan arsitektur referensi, tetapi ia tidak akan tahu bahwa tim Anda bergiliran on-call mingguan, bahwa rekrutmen lambat, atau bahwa kontrak vendor database diperbarui kuartal depan. Detail itu sering menentukan keberhasilan arsitektur.

Menjadikan trade-off eksplisit

Arsitektur yang baik sebagian besar adalah trade-off: kesederhanaan vs. fleksibilitas, performa vs. biaya, kecepatan hari ini vs. keterpeliharaan nanti. AI dapat menghasilkan daftar pro/kon dengan cepat, yang berguna—terutama untuk mendokumentasikan keputusan.

Yang tidak bisa dilakukannya adalah menetapkan prioritas ketika trade-off menyakitkan. Misalnya, “Kita menerima respons sedikit lebih lambat untuk menjaga sistem lebih sederhana dan mudah dioperasikan” adalah pilihan bisnis, bukan murni teknis.

Batas layanan, kepemilikan data, dan mode kegagalan

Mendefinisikan batas layanan, siapa yang memiliki data mana, dan apa yang terjadi selama gangguan parsial membutuhkan konteks produk dan operasional yang mendalam. AI dapat membantu brainstorming mode kegagalan (“Bagaimana jika penyedia pembayaran turun?”), tetapi Anda masih perlu memutuskan perilaku yang diharapkan, pesan ke pelanggan, dan rencana rollback.

API yang tetap dapat digunakan

Merancang API adalah merancang kontrak. AI dapat membantu menghasilkan contoh dan menemukan inkonsistensi, tetapi Anda harus memutuskan versioning, kompatibilitas mundur, dan apa yang siap Anda dukung jangka panjang.

Memutuskan kapan tidak membangun (atau kapan menghapus)

Mungkin keputusan arsitektural paling penting adalah mengatakan “tidak”—atau menghapus fitur. AI tidak dapat menilai biaya peluang atau risiko politik. Tim dapat, dan harus.

Debugging dan Analisis Akar Masalah dalam Praktik

Debugging seringkali tempat AI terlihat mengesankan—dan tempat ia diam-diam bisa membuang-buang waktu paling banyak. Asisten dapat memindai log, menunjuk jalur kode mencurigakan, atau menyarankan perbaikan yang “terlihat benar.” Namun analisis akar masalah bukan sekadar menghasilkan penjelasan; itu membuktikan satu.

AI dapat menyarankan; Anda yang mengonfirmasi akar masalah

Perlakukan keluaran AI sebagai hipotesis, bukan kesimpulan. Banyak bug punya beberapa penyebab yang mungkin, dan AI cenderung memilih cerita rapi yang cocok dengan potongan kode yang Anda tempel, bukan realitas sistem yang berjalan.

Alur kerja praktis:

- Minta AI untuk penyebab yang mungkin dan bukti apa yang akan membedakannya.

- Reproduksi masalah dan kumpulkan bukti itu.

- Baru kemudian terima perbaikan (dan verifikasi bahwa itu benar-benar menghilangkan kondisi kegagalan).

Reproduksi dan pengumpulan bukti tetap dipimpin manusia

Reproduksi yang andal adalah kekuatan debugging karena mengubah misteri menjadi tes. AI dapat membantu menulis reproduksi minimal, membuat skrip diagnostik, atau mengusulkan logging tambahan, tetapi Anda memutuskan sinyal apa yang penting: request ID, timing, perbedaan environment, feature flag, bentuk data, atau konkurensi.

Saat pengguna melaporkan gejala (“aplikasi macet”), Anda tetap harus menerjemahkan itu ke perilaku sistem: endpoint mana yang macet, timeout apa yang terjadi, sinyal error-budget mana yang berubah. Itu membutuhkan konteks: bagaimana produk digunakan dan apa yang normal.

Hindari penjelasan yang “masuk akal tapi salah”

Jika sebuah saran tidak bisa divalidasi, anggap itu salah sampai terbukti sebaliknya. Pilih penjelasan yang membuat prediksi teruji (mis. “ini hanya terjadi pada payload besar” atau “hanya setelah cache hangat”).

Patch, revert, atau redesign?

Bahkan setelah menemukan penyebab, keputusan sulit tetap ada. AI dapat menguraikan trade-off, tetapi manusia memilih responsnya:

- Patch cepat untuk menghentikan pendarahan.

- Revert untuk mengembalikan perilaku yang dikenal baik.

- Redesign jika kegagalan menunjukkan ketidaksesuaian yang lebih dalam (performa, model data, atau asumsi).

Analisis akar masalah pada akhirnya adalah akuntabilitas: memegang penjelasan, perbaikan, dan keyakinan bahwa masalah tidak akan kembali.

Tinjauan Kode: Penilaian dan Standar Tidak Terotomasi

Tinjauan kode bukan hanya daftar periksa untuk masalah gaya. Ini adalah momen tim memutuskan apa yang siap untuk dipelihara, didukung, dan dipertanggungjawabkan. AI dapat membantu Anda melihat lebih banyak, tetapi tidak dapat memutuskan apa yang penting, apa yang cocok dengan maksud produk, atau trade-off yang diterima tim Anda.

Apa yang AI bagus lakukan dalam review

Asisten pengkodean bisa bertindak seperti mata kedua yang tak kenal lelah. Mereka dapat dengan cepat:

- Menandai bug yang mungkin, pola mencurigakan, cek null yang hilang, atau penanganan string yang tidak aman.

- Menyarankan penamaan yang lebih jelas, refaktor, atau alur kontrol yang lebih sederhana.

- Menunjukkan format yang tidak konsisten atau duplikasi jelas.

- Menghasilkan pertanyaan review ("Apa yang terjadi jika API ini mengembalikan list kosong?").

Digunakan demikian, AI memendekkan jarak antara “membuka PR” dan “menyadari risikonya.”

Apa yang masih butuh penilaian manusia

Meninjau kebenaran bukan hanya soal apakah kode bisa dikompilasi. Manusia menghubungkan perubahan ke perilaku pengguna nyata, kendala produksi, dan pemeliharaan jangka panjang.

Reviewer masih perlu memutuskan:

- Apa yang dikirim: AI bisa daftar masalah, tetapi tidak bisa memilih mana yang menghalangi rilis.

- Keterbacaan dan pemeliharaan: Kode “teknis benar” bisa saja membingungkan, rapuh, atau sulit diperluas.

- Kasus tepi dan gap environment: Banyak kegagalan adalah masalah “bekerja di mesin saya”—konfigurasi, keanehan data, konkurensi, atau timing deployment. AI tidak bisa secara andal menyimpulkan realitas runtime Anda.

- Standar dan maksud: Hanya tim yang tahu konvensinya, toleransi risiko, dan tujuan produk. Sebuah perubahan bisa rapi secara teknis dan tetap salah perilaku.

Alur kerja praktis: AI sebagai co-reviewer

Perlakukan AI sebagai reviewer kedua, bukan penyetuju akhir. Minta pemeriksaan terfokus (cek keamanan, kasus tepi, kompatibilitas mundur), lalu buat keputusan manusia tentang ruang lingkup, prioritas, dan apakah perubahan sesuai standar tim dan maksud produk.

Strategi Pengujian dan Kepemilikan Kualitas

Asisten pengkodean AI dapat menghasilkan tes dengan cepat, tetapi mereka tidak memegang kepemilikan kualitas. Suite tes adalah kumpulan taruhan tentang apa yang bisa rusak, apa yang tidak boleh rusak, dan apa yang siap Anda kirim tanpa membuktikan setiap kasus tepi. Taruhan-taruhan itu adalah keputusan produk dan engineering—tetap dibuat oleh manusia.

AI bisa mendraf tes; manusia menetapkan target

Asisten baik dalam membuat scaffolding tes unit, mem-mock dependensi, dan menutup perilaku “happy path” dari implementasi. Yang tidak bisa mereka lakukan secara andal adalah menentukan cakupan yang penting.

Manusia menentukan:

- Modul mana yang butuh cakupan dalam karena bersifat safety-critical atau sering berubah.

- Apa arti “selesai” untuk refaktor berisiko vs. perbaikan kecil.

- Kapan berinvestasi pada tes regresi vs. monitoring dan rencana rollback.

Memilih campuran jenis tes yang tepat

Sebagian besar tim butuh strategi berlapis, bukan “lebih banyak tes.” AI dapat membantu menulis banyak dari ini, tetapi pemilihan dan batasnya dipimpin manusia:

- Unit test untuk aturan bisnis dan kasus tepi rumit.

- Integration test untuk interaksi database/queue/service.

- End-to-end test untuk alur pengguna kritis (sedikit, stabil, bernilai tinggi).

- Contract test untuk menjaga kompatibilitas API antar tim/layanan.

- Performance test untuk melindungi latensi dan biaya saat beban.

Menghindari tes flaky dan rasa percaya diri palsu

Tes yang digenerasi AI sering mencerminkan implementasi terlalu dekat, menciptakan assertion rapuh atau setup yang over-mocked sehingga lolos meski perilaku nyata gagal. Developer mencegah ini dengan:

- Menguji perilaku yang teramati, bukan detail implementasi internal.

- Menjaga data deterministik dan mengendalikan waktu, randomness, dan panggilan jaringan.

- Mereview kegagalan untuk memutuskan: bug nyata, bug tes, atau masalah lingkungan.

Menyelaraskan strategi dengan risiko dan ritme rilis

Strategi yang baik sesuai dengan cara Anda merilis. Rilis lebih cepat butuh pemeriksaan otomatis yang lebih kuat dan jalur rollback yang jelas; rilis lebih lambat bisa menanggung validasi pra-merge yang lebih berat. Pemilik kualitas adalah tim, bukan alat.

Mengukur hasil yang penting

Kualitas bukan persentase coverage. Lacak apakah pengujian memperbaiki hasil: lebih sedikit insiden produksi, pemulihan lebih cepat, dan perubahan lebih aman (rollback lebih kecil, deploy lebih cepat penuh keyakinan). AI dapat mempercepat pekerjaan, tetapi akuntabilitas tetap di developer.

Keamanan, Privasi, dan Kepatuhan

Pekerjaan keamanan lebih sedikit soal menghasilkan kode dan lebih banyak tentang membuat trade-off dalam batasan nyata. AI dapat membantu menampilkan daftar periksa dan kesalahan umum, tetapi tanggung jawab keputusan risiko tetap di tim.

Threat modeling butuh konteks

Threat modeling bukan latihan umum—yang penting tergantung pada prioritas bisnis Anda, pengguna, dan mode kegagalan. Asisten dapat menyarankan ancaman tipikal (injeksi, broken auth, default tidak aman), namun ia tidak akan secara andal tahu apa yang benar-benar mahal untuk produk Anda: pembajakan akun vs. kebocoran data vs. gangguan layanan, atau aset mana yang secara hukum sensitif.

Risiko spesifik aplikasi tidak selalu terlihat seperti pola

AI bagus mengenali anti-pola yang dikenal, tetapi banyak insiden muncul dari detail spesifik aplikasi: kasus tepi izin, endpoint admin “sementara”, atau workflow yang tanpa sengaja melewati persetujuan. Risiko itu membutuhkan pembacaan maksud sistem, bukan hanya kode.

Rahasia, izin, dan retensi adalah pilihan disengaja

Alat dapat mengingatkan agar tidak meng-hardcode kunci, tetapi mereka tidak dapat memikul kebijakan penuh:

- Di mana rahasia disimpan (vault, CI, runtime) dan bagaimana rotasinya.

- Peran least-privilege dan tinjauan akses.

- Retensi data: apa yang disimpan, berapa lama, dan siapa yang dapat mengekspornya.

Ketergantungan dan risiko supply-chain

AI mungkin menandai library usang, tetapi tim masih butuh praktik: pin versi, verifikasi asal-usul, meninjau dependensi transitif, dan memutuskan kapan menerima risiko vs. berinvestasi dalam perbaikan.

Kepatuhan dan audit butuh bukti

Kepatuhan bukan sekadar “tambahkan enkripsi.” Ini kontrol, dokumentasi, dan akuntabilitas: log akses, jejak persetujuan, prosedur insiden, dan bukti bahwa Anda mengikutinya. AI bisa mendraf template, tetapi manusia harus memvalidasi bukti dan menandatangani—karena itulah yang akhirnya diandalkan auditor (dan pelanggan).

Operasi, Keandalan, dan Respons Insiden

AI dapat membuat kerja ops lebih cepat, tetapi ia tidak mengambil kepemilikan. Keandalan adalah rantai keputusan dalam ketidakpastian, dan biaya keputusan salah biasanya lebih tinggi daripada biaya lambat.

Di mana AI membantu sehari-hari

AI berguna untuk mendraf dan memelihara artefak operasional—runbook, checklist, dan playbook “jika X maka coba Y”. Ia juga bisa merangkum log, mengelompokkan alert mirip, dan mengusulkan hipotesis awal.

Untuk pekerjaan keandalan, itu berarti iterasi lebih cepat pada:

- dashboard monitoring dan deskripsi alert.

- catatan kapasitas dan heuristik scaling.

- template pelaporan error-budget.

Ini akselerator bagus, tetapi bukan pekerjaan itu sendiri.

Bagian yang tetap dimiliki manusia

Insiden jarang berjalan sesuai naskah. Engineer on-call menghadapi sinyal tidak jelas, kegagalan parsial, dan trade-off berantakan sambil waktu berjalan. AI dapat menyarankan penyebab kemungkinan, tetapi ia tidak dapat secara andal memutuskan apakah akan paging tim lain, menonaktifkan fitur, atau menerima dampak pelanggan sementara untuk menjaga integritas data.

Keamanan deployment juga tetap tanggung jawab manusia. Alat dapat merekomendasikan rollback, feature flag, atau rilis bertahap, tetapi tim masih harus memilih jalan paling aman mengingat konteks bisnis dan blast radius.

Postmortem: belajar adalah tujuannya

AI dapat mendraf timeline dan menarik peristiwa utama dari chat, tiket, dan monitoring. Manusia masih melakukan bagian kritis: memutuskan apa yang kelihatan “baik”, memprioritaskan perbaikan, dan membuat perubahan yang mencegah pengulangan (bukan hanya gejala yang sama).

Jika Anda memperlakukan AI sebagai co-pilot untuk administrasi ops dan pencarian pola—bukan sebagai komandan insiden—Anda akan mendapatkan kecepatan tanpa menyerahkan akuntabilitas.

Komunikasi Tim, Mentoring, dan Kepemilikan

AI dapat menjelaskan konsep dengan jelas dan on-demand: “Apa itu CQRS?”, “Mengapa deadlock ini terjadi?”, “Ringkas PR ini.” Itu membantu tim bergerak lebih cepat. Tetapi komunikasi kerja tidak hanya mentransfer informasi—itu membangun kepercayaan, menetapkan kebiasaan bersama, dan membuat komitmen yang bisa diandalkan.

Onboarding: lebih dari dokumentasi

Developer baru tidak hanya butuh jawaban; mereka butuh konteks dan hubungan. AI dapat membantu dengan merangkum modul, menyarankan jalur bacaan, dan menerjemahkan jargon. Manusia masih harus mengajarkan apa penting di sini: trade-off yang tim pilih, apa itu “bagus” di codebase ini, dan siapa yang diajak bicara jika sesuatu terasa salah.

Penyelarasan antar peran

Sebagian besar gesekan proyek muncul antar peran: produk, desain, QA, keamanan, dukungan. AI dapat mendraf notulen rapat, mengusulkan kriteria penerimaan, atau merumuskan umpan balik dengan nada lebih netral. Orang tetap perlu menegosiasikan prioritas, menyelesaikan ambiguitas, dan menyadari saat pemangku kepentingan “setuju” tanpa benar-benar setuju.

Definisi selesai dan batas kepemilikan

Tim gagal ketika tanggung jawab kabur. AI dapat menghasilkan daftar periksa, tetapi tidak bisa menegakkan akuntabilitas. Manusia harus mendefinisikan apa arti “selesai” (tes? docs? rencana rollout? monitoring?), dan siapa yang bertanggung jawab setelah merge—terutama saat kode yang digenerasi AI menyembunyikan kompleksitas.

Daftar periksa: AI bertanggung jawab dalam alur kerja tim

- Ungkapkan penggunaan AI ketika memengaruhi keputusan, estimasi, atau kode yang ditulis.

- Verifikasi fakta: link, API, klaim keamanan, dan “praktik terbaik” sebelum dibagikan.

- Jaga prompt bebas dari rahasia (kunci, data pelanggan, detail insiden).

- Perlakukan keluaran AI sebagai draf; tetapkan pemilik manusia untuk setiap keputusan.

- Tulis norma tim: kapan AI diperbolehkan, kapan tidak, dan tinjau ekspektasi.

- Prioritaskan perubahan kecil yang bisa direview—hindari refaktor AI “big bang”.