30 Okt 2025·8 menit

Cara Membuat Aplikasi Web untuk Melacak Hasil Eksperimen per Produk

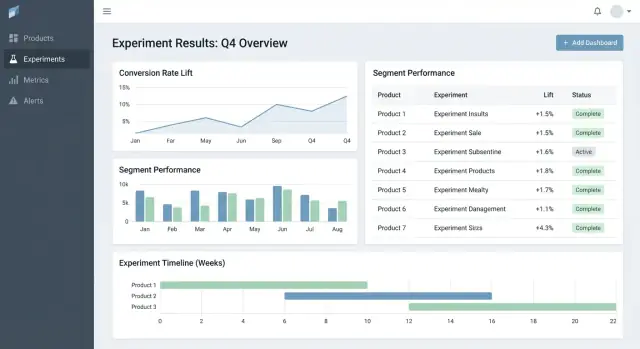

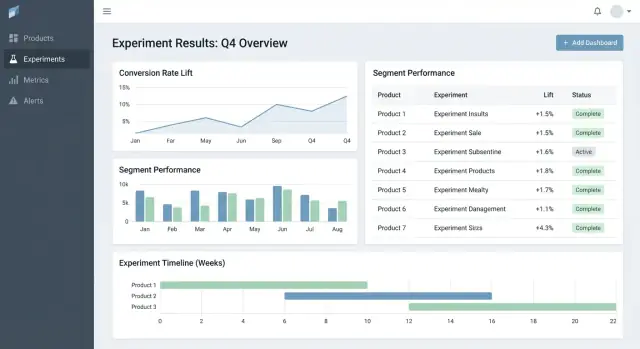

Pelajari cara membangun aplikasi web untuk melacak eksperimen lintas produk: model data, metrik, izin, integrasi, dasbor, dan pelaporan yang andal.

Pelajari cara membangun aplikasi web untuk melacak eksperimen lintas produk: model data, metrik, izin, integrasi, dasbor, dan pelaporan yang andal.

Kebanyakan tim tidak gagal dalam eksperimen karena kekurangan ide—mereka gagal karena hasilnya tersebar. Satu produk memiliki grafik di alat analitik, yang lain di spreadsheet, lagi satu di slide deck dengan screenshot. Beberapa bulan kemudian, tak ada yang bisa menjawab pertanyaan sederhana seperti “Apakah kita sudah menguji ini?” atau “Versi mana yang menang, menggunakan definisi metrik apa?”

Aplikasi pelacakan eksperimen harus memusatkan apa yang diuji, mengapa, bagaimana diukur, dan apa yang terjadi—di seluruh produk dan tim. Tanpa ini, tim membuang waktu membangun ulang laporan, berdebat soal angka, dan menjalankan ulang tes lama karena pembelajaran tidak dapat dicari.

Ini bukan hanya alat analis.

Tracker yang baik menciptakan nilai bisnis dengan memungkinkan:

Jelasakan: aplikasi ini terutama untuk melacak dan melaporkan hasil eksperimen—bukan untuk menjalankan eksperimen end-to-end. Ia dapat menautkan ke alat yang sudah ada (feature flagging, analitik, data warehouse) sambil memiliki rekaman terstruktur dari eksperimen dan interpretasi final yang disepakati.

Tracker eksperimen minimum yang layak harus menjawab dua pertanyaan tanpa harus berburu di dokumen atau spreadsheet: apa yang kita uji dan apa yang kita pelajari. Mulailah dengan sekumpulan entitas dan field kecil yang bekerja lintas produk, lalu kembangkan hanya ketika tim merasakan sakit nyata.

Sederhanakan model data sehingga setiap tim menggunakannya dengan cara yang sama:

Dukung pola paling umum sejak hari pertama:

Meski rollouts awalnya tidak selalu memakai statistik formal, melacaknya bersama eksperimen membantu tim menghindari mengulang “tes” tanpa catatan.

Saat pembuatan, minta hanya yang diperlukan untuk menjalankan dan menginterpretasikan tes nanti:

Buat hasil dapat dibandingkan dengan memaksa struktur:

Jika Anda membangun hanya ini, tim dapat menemukan eksperimen, memahami setup, dan mencatat hasil—bahkan sebelum Anda menambahkan analitik lanjutan atau automasi.

Tracker eksperimen lintas-produk berhasil atau gagal karena model datanya. Jika ID bertabrakan, metrik bergeser, atau segment tidak konsisten, dasbor Anda bisa “tampak benar” sementara menceritakan kisah yang salah.

Mulailah dengan strategi identifier yang jelas:

product_id: stabil saat rename (jangan gunakan display name sebagai kunci)experiment_key: slug yang ramah manusia (mis. checkout_free_shipping_banner) plus experiment_id yang tak dapat diubahvariant_key: label stabil seperti control, treatment_aIni memungkinkan Anda membandingkan hasil antar produk tanpa menebak apakah “Web Checkout” dan “Checkout Web” adalah hal yang sama.

Jaga entitas inti kecil dan eksplisit:

Meski komputasi terjadi di tempat lain, menyimpan output (results) memungkinkan dasbor cepat dan riwayat yang andal.

Metrik dan eksperimen tidak statis. Modelkan:

Ini mencegah eksperimen bulan lalu berubah saat seseorang memperbarui logika KPI.

Rencanakan segmen konsisten lintas produk: negara, perangkat, tier paket, baru vs kembali.

Terakhir, tambahkan audit trail yang menangkap siapa mengubah apa dan kapan (perubahan status, pembagian trafik, update definisi metrik). Ini penting untuk kepercayaan, review, dan governance.

Jika tracker eksperimen Anda salah menghitung metrik (atau tidak konsisten antar produk), “hasil” hanyalah opini dengan grafik. Cara tercepat mencegah ini adalah memperlakukan metrik sebagai aset produk bersama—bukan potongan query ad-hoc.

Buat katalog metrik sebagai satu sumber kebenaran untuk definisi, logika perhitungan, dan kepemilikan. Setiap entri metrik harus menyertakan:

Simpan katalog dekat dengan tempat orang bekerja (mis. ditautkan dari alur pembuatan eksperimen) dan versioning sehingga Anda dapat menjelaskan hasil historis.

Putuskan sejak awal unit analisis tiap metrik: per user, per session, per account, atau per order. Conversion rate “per user” bisa berbeda dari “per session” meski keduanya benar.

Untuk mengurangi kebingungan, simpan pilihan agregasi dengan definisi metrik, dan wajibkan saat eksperimen disiapkan. Jangan biarkan tiap tim memilih unit secara ad‑hoc.

Banyak produk punya jendela konversi (mis. mendaftar hari ini, membeli dalam 14 hari). Definisikan aturan atribusi konsisten:

Buat aturan ini terlihat di dasbor sehingga pembaca tahu apa yang mereka lihat.

Untuk dasbor cepat dan auditabilitas, simpan keduanya:

Ini memungkinkan rendering cepat sambil tetap memberi kemampuan recompute saat definisi berubah.

Adopsi standar penamaan yang menyandikan makna (mis. activation_rate_user_7d, revenue_per_account_30d). Wajibkan ID unik, terapkan alias, dan tandai near-duplicates saat pembuatan metrik untuk menjaga katalog tetap bersih.

Tracker eksperimen Anda hanya seandalan data yang masuk. Tujuannya adalah menjawab dua pertanyaan untuk setiap produk: siapa yang diekspos ke varian mana, dan apa yang mereka lakukan setelahnya? Semua hal lain—metrik, statistik, dasbor—bergantung pada pondasi itu.

Kebanyakan tim memilih salah satu pola ini:

Apa pun yang dipilih, standarkan set event minimum lintas produk: exposure/assignment, event konversi kunci, dan konteks cukup untuk join (user ID/device ID, timestamp, experiment ID, variant).

Definisikan peta jelas dari event mentah ke metrik yang dilaporkan tracker (mis. purchase_completed → Revenue, signup_completed → Activation). Pertahankan pemetaan ini per produk, tapi pakai penamaan konsisten agar dashboard A/B test membandingkan yang sepadan.

Validasi kelengkapan sejak awal:

Buat pengecekan yang berjalan tiap load dan memicu kegagalan keras:

Tampilkan ini di aplikasi sebagai peringatan yang terikat ke eksperimen, bukan disembunyikan di log.

Pipeline berubah. Saat Anda memperbaiki bug instrumentasi atau logika deduplikasi, Anda perlu memproses ulang data historis agar metrik dan KPI konsisten.

Rencanakan untuk:

Perlakukan integrasi sebagai fitur produk: dokumentasikan SDK yang didukung, skema event, dan langkah pemecahan masalah. Jika Anda punya area docs, tautkan sebagai path relatif seperti /docs/integrations.

Jika orang tidak mempercayai angka, mereka tidak akan menggunakan tracker. Tujuannya bukan memukau dengan matematika—tetapi membuat keputusan dapat diulang dan dapat dipertahankan lintas produk.

Putuskan sejak awal apakah aplikasi akan melaporkan hasil frequentist (p-values, confidence intervals) atau Bayesian (probabilitas meningkat, credible intervals). Keduanya bisa bekerja, tetapi mencampurnya antar produk menyebabkan kebingungan (“Kenapa tes ini menunjukkan 97% chance to win, sementara yang lain p=0.08?”).

Aturan praktis: pilih pendekatan yang organisasi Anda sudah pahami, lalu standarkan terminologi, default, dan ambang.

Setidaknya, tampilan hasil harus membuat item ini tidak ambigu:

Tampilkan juga jendela analisis, unit yang dihitung (users, sessions, orders), dan versi definisi metrik yang digunakan. Detail ini membedakan antara pelaporan konsisten dan perdebatan.

Jika tim menguji banyak varian, banyak metrik, atau memeriksa hasil tiap hari, false positive menjadi mungkin. Aplikasi Anda harus mengodekan kebijakan alih‑alih membiarkannya ke tiap tim:

Tambahkan flag otomatis yang muncul di samping hasil, bukan tersembunyi di log:

Di samping angka, tambahkan penjelasan singkat yang dapat dipercaya pembaca non-teknis, mis. “Estimasi terbaik adalah +2.1% lift, tetapi efek sebenarnya bisa berada antara -0.4% dan +4.6%. Kita belum memiliki bukti kuat untuk menyatakan pemenang.”

Alat eksperimen yang baik membantu orang menjawab dua pertanyaan cepat: Apa yang harus saya lihat selanjutnya? dan Apa yang harus kita lakukan? UI harus meminimalkan berburu konteks dan membuat “status keputusan” jelas.

Mulai dengan tiga halaman yang menutupi sebagian besar penggunaan:

Pada list dan halaman produk, buat filter cepat dan persistennya: product, owner, rentang tanggal, status, primary metric, dan segment. Orang harus bisa menyaring ke “Eksperimen Checkout, dimiliki Maya, berjalan bulan ini, metrik utama = conversion, segment = new users” dalam hitungan detik.

Perlakukan status sebagai kosakata terkontrol, bukan teks bebas:

Draft → Running → Stopped → Shipped / Rolled back

Tampilkan status di mana‑mana (baris list, header detail, dan tautan bagikan) dan catat siapa yang mengubahnya dan mengapa. Ini mencegah “peluncuran diam‑diam” dan hasil yang tidak jelas.

Di tampilan detail eksperimen, utamakan tabel hasil ringkas per metrik:

Simpan chart lanjutan di balik bagian “More details” agar pengambil keputusan tidak kewalahan.

Tambahkan CSV export untuk analis dan shareable links untuk pemangku kepentingan, tetapi terapkan akses: tautan harus menghormati peran dan izin produk. Tombol sederhana “Copy link” plus aksi “Export CSV” memenuhi sebagian besar kebutuhan kolaborasi.

Jika tracker Anda mencakup banyak produk, kontrol akses dan auditabilitas bukan opsional. Mereka adalah alasan alat ini aman diadopsi lintas tim dan dapat dipertanggungjawabkan saat review.

Mulai dengan set peran sederhana dan pertahankan konsistensi di seluruh aplikasi:

Pusatkan keputusan RBAC (satu lapisan kebijakan), sehingga UI dan API menegakkan aturan yang sama.

Banyak organisasi butuh akses berskala produk: Tim A bisa melihat eksperimen Produk A tapi bukan Produk B. Modelkan ini secara eksplisit (mis. user ↔ product memberships), dan pastikan setiap query difilter berdasarkan produk.

Untuk kasus sensitif (mis. data partner, segmen yang diatur), tambahkan pembatasan baris di atas pembatasan produk. Pendekatan praktis adalah memberi tag sensitivitas pada eksperimen (atau potongan hasil) dan memerlukan izin tambahan untuk melihatnya.

Log dua hal terpisah:

Tampilkan riwayat perubahan di UI untuk transparansi, dan simpan log lebih dalam untuk investigasi.

Tentukan aturan retensi untuk:

Buat retensi dapat dikonfigurasi menurut produk dan sensitivitas. Saat data harus dihapus, simpan catatan minimal (ID, waktu penghapusan, alasan) untuk mempertahankan integritas pelaporan tanpa menyimpan konten sensitif.

Tracker menjadi benar-benar berguna saat mencakup siklus hidup eksperimen penuh, bukan hanya p-value akhir. Fitur alur kerja mengubah docs, tiket, dan grafik yang tersebar menjadi proses yang dapat diulang yang meningkatkan kualitas dan membuat pembelajaran mudah digunakan ulang.

Modelkan eksperimen sebagai rangkaian state (Draft, In Review, Approved, Running, Ended, Readout Published, Archived). Setiap state harus memiliki “exit criteria” jelas sehingga eksperimen tidak hidup tanpa elemen esensial seperti hipotesis, metrik utama, dan guardrails.

Persetujuan tidak perlu berat. Langkah reviewer sederhana (mis. product + data) plus jejak audit siapa yang menyetujui apa dan kapan bisa mencegah kesalahan yang dapat dihindari. Setelah selesai, wajibkan post‑mortem singkat sebelum eksperimen ditandai “Published” agar hasil dan konteks tertangkap.

Tambahkan template untuk:

Template mengurangi gesekan “halaman kosong” dan mempercepat review karena semua orang tahu di mana mencari. Biarkan template bisa diedit per produk sambil mempertahankan inti yang sama.

Eksperimen jarang berdiri sendiri—orang butuh konteks sekitarnya. Biarkan pengguna melampirkan tautan ke tiket/spesifikasi dan tulis ulang terkait (mis. /blog/how-we-define-guardrails, /blog/experiment-analysis-checklist). Simpan field “Learning” terstruktur seperti:

Dukung notifikasi saat guardrails memburuk (mis. error rate, pembatalan) atau saat hasil berubah secara material setelah data terlambat atau perhitungan metrik ulang. Buat notifikasi bersifat actionable: tampilkan metrik, threshold, timeframe, dan pemilik untuk mengakui atau eskalasi.

Sediakan perpustakaan yang bisa disaring menurut produk, area fitur, audiens, metrik, hasil, dan tag (mis. “pricing,” “onboarding,” “mobile”). Tambahkan saran “eksperimen serupa” berdasarkan tag/metrik bersama agar tim tidak mengulang tes yang sama dan justru membangun dari pembelajaran sebelumnya.

Anda tidak perlu stack “sempurna” untuk membangun aplikasi pelacakan eksperimen—tetapi Anda butuh batasan yang jelas: di mana data tinggal, di mana perhitungan dijalankan, dan bagaimana tim mengakses hasil secara konsisten.

Untuk banyak tim, setup sederhana dan skalabel terlihat seperti:

Pembagian ini menjaga workflow transaksional tetap cepat sementara warehouse menangani komputasi skala besar.

Jika Anda ingin membuat prototipe UI workflow cepat (experiments list → detail → readout) sebelum commit ke siklus engineering penuh, platform vibe-coding seperti Koder.ai dapat membantu menghasilkan fondasi React + backend dari spesifikasi chat. Berguna untuk mengeluarkan entitas, form, scaffolding RBAC, dan CRUD yang audit‑friendly, lalu iterasi kontrak data dengan tim analitik Anda.

Umumnya ada tiga opsi:

Warehouse-first sering paling sederhana jika tim data sudah menguasai SQL tepercaya. Backend-heavy bekerja bila butuh update low-latency atau logika khusus, tapi menambah kompleksitas aplikasi.

Dasbor eksperimen sering mengulang query yang sama (KPI top-line, time series, potongan segment). Rencanakan untuk:

Jika Anda mendukung banyak produk atau unit bisnis, putuskan awal:

Kompromi umum adalah infrastruktur bersama dengan model tenant_id yang kuat dan enforcement akses baris.

Jaga surface API kecil dan eksplisit. Kebanyakan sistem butuh endpoint untuk experiments, metrics, results, segments, dan permissions (plus read yang audit-friendly). Ini memudahkan menambah produk tanpa menulis ulang plumbing.

Tracker eksperimen hanya berguna jika orang mempercayainya. Kepercayaan itu datang dari testing disiplin, monitoring jelas, dan operasi yang dapat diprediksi—terutama saat banyak produk dan pipeline memberi makan dashboard yang sama.

Mulai dengan logging terstruktur untuk setiap langkah penting: ingestion event, assignment, rollup metrik, dan komputasi hasil. Sertakan identifier seperti product, experiment_id, metric_id, dan pipeline run_id agar support bisa menelusuri satu hasil kembali ke inputnya.

Tambahkan metrik sistem (latensi API, runtime job, queue depth) dan metrik data (event diproses, % event terlambat, % drop karena validasi). Lengkapi dengan tracing antar layanan agar bisa menjawab, “Mengapa eksperimen ini kehilangan data kemarin?”

Pengecekan kelayakan data (data freshness) adalah cara tercepat mencegah kegagalan diam. Jika SLA “harian jam 9 pagi”, monitor freshness per produk dan sumber, dan alert saat:

Buat tes pada tiga level:

Simpan dataset kecil “golden” dengan output terknown agar Anda bisa mendeteksi regresi sebelum merilis.

Perlakukan migrasi sebagai bagian operasi: versioning definisi metrik dan logika komputasi hasil, dan hindari menulis ulang eksperimen historis kecuali diminta eksplisit. Saat perubahan diperlukan, berikan jalur backfill terkontrol dan dokumentasikan apa yang berubah di jejak audit.

Sediakan tampilan admin untuk menjalankan ulang pipeline untuk eksperimen/rentang tanggal spesifik, memeriksa error validasi, dan menandai insiden dengan pembaruan status. Tautkan catatan insiden langsung dari eksperimen terdampak agar pengguna memahami keterlambatan dan tidak membuat keputusan berdasarkan data yang tidak lengkap.

Meluncurkan aplikasi pelacakan eksperimen lintas produk lebih sedikit tentang “hari peluncuran” dan lebih banyak tentang mengurangi ambiguitas secara bertahap: apa yang dilacak, siapa yang memilikinya, dan apakah angka cocok dengan kenyataan.

Mulai dengan satu produk dan set metrik kecil dan tepercaya (mis. conversion, activation, revenue). Tujuannya adalah memvalidasi alur end-to-end—membuat eksperimen, menangkap exposure dan outcome, menghitung hasil, dan merekam keputusan—sebelum Anda menambah kompleksitas.

Setelah produk pertama stabil, perluas produk demi produk dengan ritme onboarding yang dapat diprediksi. Setiap produk baru harus terasa seperti setup yang dapat diulang, bukan proyek kustom.

Jika organisasi Anda cenderung tersangkut di siklus “pembangunan platform” panjang, pertimbangkan pendekatan dua‑jalur: bangun kontrak data yang tahan lama (event, ID, definisi metrik) paralel dengan lapisan aplikasi tipis. Tim kadang menggunakan Koder.ai untuk menyiapkan lapisan tipis itu dengan cepat—form, dasbor, izin, dan ekspor—lalu menguatkannya seiring adopsi (termasuk ekspor kode sumber dan rollback iteratif via snapshot saat kebutuhan berubah).

Gunakan checklist ringan untuk onboarding produk dan skema event secara konsisten:

Di mana membantu adopsi, tautkan “next steps” dari hasil eksperimen ke area produk terkait (mis. eksperimen terkait pricing dapat menautkan ke /pricing). Jaga tautan informatif dan netral—tanpa implikasi hasil.

Ukur apakah alat menjadi tempat default untuk keputusan:

Seringkali rollout tersandung pada beberapa masalah berulang:

Mulailah dengan memusatkan catatan akhir yang disepakati dari setiap eksperimen:

Anda bisa menautkan ke alat feature-flag dan sistem analitik, tetapi tracker harus memiliki riwayat terstruktur agar hasil tetap dapat dicari dan dibandingkan dari waktu ke waktu.

Tidak—fokuskan ruang lingkup pada pelacakan dan pelaporan hasil.

MVP praktis:

Ini menghindari membangun ulang seluruh platform eksperimen sambil memperbaiki masalah “hasil yang tersebar.”

Model minimum yang bekerja antar-tim adalah:

Gunakan ID yang stabil dan jadikan label tampilan dapat diubah:

product_id: tidak pernah berubah, walau nama produk berubahexperiment_id: ID internal yang tak dapat diubahBuat “kriteria keberhasilan” eksplisit saat setup:

Struktur ini mengurangi perdebatan kemudian karena pembaca melihat apa arti “menang” sebelum tes dijalankan.

Buat katalog metrik kanonis dengan:

Saat logika berubah, publikasikan versi metrik baru daripada mengubah sejarah—lalu simpan versi mana yang digunakan tiap eksperimen.

Minimal instrumentasi dan pengecekan kualitas data:

Otomatiskan pengecekan seperti:

Pilih satu “dialek” statistik dan konsisten:

Apa pun yang dipilih, selalu tampilkan:

Perlakukan kontrol akses sebagai fondasi:

Simpan dua jejak audit terpisah:

Urutkan rollout yang bisa diulang:

Hindari jebakan umum:

product_id)experiment_id + human-friendly experiment_key)control, treatment_a, dll.)Tambahkan Segment dan Time window lebih awal jika Anda mengharapkan pemotongan yang konsisten (mis. new vs returning, 7-day vs 30-day).

experiment_keyvariant_key: string stabil seperti control, treatment_aIni mencegah tabrakan dan membuat pelaporan lintas-produk lebih andal ketika konvensi penamaan berubah.

Tampilkan ini sebagai peringatan di halaman eksperimen sehingga sulit diabaikan.

Konsistensi lebih penting daripada kerumitan agar organisasi mempercayai angka.

Ini yang membuat tracker aman untuk diadopsi lintas produk dan tim.