12 Nov 2025·8 menit

Dari Lab Nonprofit ke Pemimpin AI: Sejarah OpenAI

Jelajahi sejarah OpenAI — dari asal nonprofit dan tonggak riset penting hingga peluncuran ChatGPT, GPT‑4, kemitraan Microsoft, dan evolusi misinya.

Jelajahi sejarah OpenAI — dari asal nonprofit dan tonggak riset penting hingga peluncuran ChatGPT, GPT‑4, kemitraan Microsoft, dan evolusi misinya.

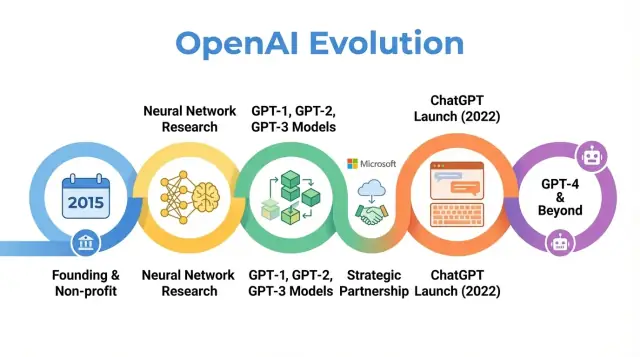

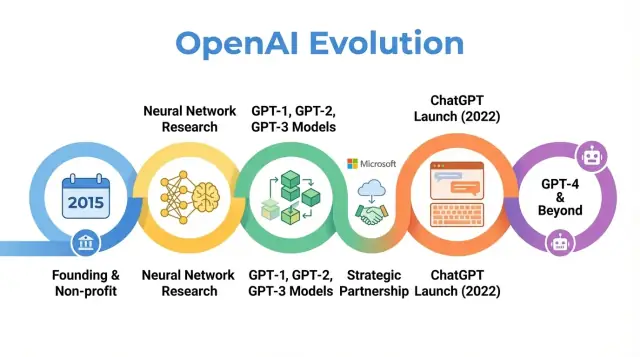

OpenAI adalah perusahaan riset dan penerapan AI yang karyanya telah membentuk cara orang memandang kecerdasan buatan—dari makalah riset awal hingga produk seperti ChatGPT. Memahami bagaimana OpenAI berevolusi—dari laboratorium nonprofit kecil pada 2015 menjadi pemain sentral dalam AI—membantu menjelaskan mengapa AI modern terlihat seperti sekarang.

Kisah OpenAI bukan sekadar urutan rilis model. Ini adalah studi kasus tentang bagaimana misi, insentif, terobosan teknis, dan tekanan publik saling berinteraksi. Organisasi ini dimulai dengan penekanan kuat pada riset terbuka dan manfaat luas, lalu direstrukturisasi untuk menarik modal, membentuk kemitraan mendalam dengan Microsoft, dan meluncurkan produk yang digunakan oleh ratusan juta orang.

Melacak sejarah OpenAI menerangi beberapa tren yang lebih luas dalam AI:

Misi dan nilai: OpenAI didirikan dengan tujuan agar kecerdasan umum buatan (AGI) memberi manfaat bagi seluruh umat manusia. Cara misi itu ditafsirkan dan direvisi dari waktu ke waktu memperlihatkan ketegangan antara tujuan idealis dan realitas komersial.

Terobosan riset: Perkembangan dari proyek awal ke sistem seperti GPT‑3, GPT‑4, DALL·E, dan Codex mengikuti pergeseran menuju model dasar skala besar yang menggerakkan banyak aplikasi AI saat ini.

Tata kelola dan struktur: Peralihan dari nonprofit murni ke entitas ber‑capped‑profit dan penciptaan mekanisme tata kelola kompleks menyoroti bagaimana bentuk organisasi baru dicoba untuk mengelola teknologi kuat.

Dampak publik dan pengawasan: Dengan ChatGPT dan rilis lain, OpenAI bergeser dari laboratorium riset yang dikenal di komunitas AI menjadi nama rumah tangga, menarik perhatian pada keselamatan, alignment, dan regulasi yang kini membentuk diskusi kebijakan global.

Artikel ini mengikuti perjalanan OpenAI dari 2015 hingga perkembangan terbarunya, menunjukkan bagaimana setiap fase mencerminkan pergeseran lebih luas dalam riset AI, ekonomi, dan tata kelola—dan apa arti itu bagi masa depan bidang ini.

OpenAI didirikan pada Desember 2015, ketika pembelajaran mesin—terutama deep learning—sedang meningkat pesat tetapi masih jauh dari kecerdasan umum. Benchmark pengenalan gambar turun drastis, sistem ucapan membaik, dan perusahaan seperti Google, Facebook, dan Baidu mengucurkan banyak dana ke AI.

Kekhawatiran yang tumbuh di antara peneliti dan pemimpin teknologi adalah bahwa AI canggih mungkin dikendalikan oleh segelintir korporasi atau pemerintah. OpenAI dipandang sebagai penyeimbang: organisasi riset yang fokus pada keselamatan jangka panjang dan distribusi manfaat AI secara luas, bukan keuntungan komersial sempit.

Sejak hari pertama, OpenAI mendefinisikan misinya dalam istilah artificial general intelligence (AGI), bukan sekadar kemajuan pembelajaran mesin inkremental. Pernyataan inti adalah OpenAI akan bekerja untuk memastikan AGI, jika tercipta, “memberi manfaat bagi seluruh umat manusia.”

Misi itu memiliki beberapa implikasi konkret:

Posting blog publik awal dan piagam pendiri menekankan baik keterbukaan maupun kehati‑hatian: OpenAI akan menerbitkan banyak karyanya, tetapi juga mempertimbangkan dampak sosial sebelum merilis kapabilitas kuat.

OpenAI dimulai sebagai laboratorium riset nonprofit. Komitmen pendanaan awal diumumkan sekitar $1 miliar dalam janji dukungan, meskipun itu merupakan janji jangka panjang dan bukan uang tunai langsung. Pendukung awal termasuk Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston, dan YC Research, serta dukungan dari perusahaan seperti Amazon Web Services dan Infosys.

Tim kepemimpinan awal menggabungkan pengalaman startup, riset, dan operasional:

Perpaduan kewirausahaan Silicon Valley dan riset AI papan atas ini membentuk budaya awal OpenAI: sangat ambisius mendorong batas kemampuan AI, tetapi diorganisir sebagai nonprofit yang berorientasi misi untuk dampak global jangka panjang ketimbang komersialisasi jangka pendek.

Saat diluncurkan sebagai laboratorium nonprofit pada 2015, janji publik OpenAI sederhana namun ambisius: memajukan kecerdasan buatan sambil membagikan sebanyak mungkin dengan komunitas yang lebih luas.

Tahun‑tahun awal didefinisikan oleh filosofi "terbuka secara default." Makalah riset diposting cepat, kode biasanya dirilis, dan alat internal diubah menjadi proyek publik. Idenya adalah mempercepat kemajuan ilmiah luas—dan pengawasan—lebih aman dan lebih bermanfaat ketimbang memusatkan kapabilitas di dalam satu perusahaan.

Pada saat yang sama, keselamatan sudah menjadi bagian dari percakapan. Tim membahas kapan keterbukaan bisa meningkatkan risiko penyalahgunaan dan mulai menggambarkan ide rilis bertahap dan tinjauan kebijakan, meskipun ide‑ide itu masih informal dibandingkan proses tata kelola yang muncul kemudian.

Fokus ilmiah awal OpenAI mencakup beberapa bidang inti:

Proyek‑proyek ini lebih bertujuan menguji kemungkinan dengan deep learning, komputasi, dan rejimen pelatihan yang cerdik ketimbang membuat produk yang dipoles.

Dua keluaran paling berpengaruh era ini adalah OpenAI Gym dan Universe.

Kedua proyek mencerminkan komitmen pada infrastruktur bersama ketimbang keuntungan proprietari.

Selama periode nonprofit ini, OpenAI sering digambarkan sebagai penyeimbang berorientasi misi terhadap lab AI perusahaan besar. Rekan memandang tinggi kualitas risetnya, ketersediaan kode dan lingkungan, serta kesediaannya terlibat dalam diskusi keselamatan.

Liputan media menyoroti kombinasi tak biasa antara pendukung profil tinggi, struktur non‑komersial, dan janji publik untuk menerbitkan secara terbuka. Reputasi itu—sebagai laboratorium riset terbuka yang berpengaruh dan peduli pada konsekuensi jangka panjang—membentuk ekspektasi yang kelak memengaruhi reaksi terhadap setiap perubahan strategi organisasi.

Titik balik dalam sejarah OpenAI adalah keputusan untuk memfokuskan pada model bahasa berbasis transformer skala besar. Pergeseran ini mengubah OpenAI dari nonprofit yang berfokus pada riset menjadi perusahaan yang dikenal karena model dasar yang dipakai orang lain.

GPT‑1 terbilang sederhana menurut standar kemudian—117 juta parameter, dilatih pada BookCorpus—tetapi memberikan bukti konsep penting.

Alih‑alih melatih model terpisah untuk tiap tugas NLP, GPT‑1 menunjukkan bahwa satu model transformer, dilatih dengan tujuan sederhana (memprediksi kata berikutnya), dapat diadaptasi dengan sedikit fine‑tuning untuk tugas seperti question answering, analisis sentimen, dan textual entailment.

Untuk roadmap internal OpenAI, GPT‑1 memvalidasi tiga ide:

GPT‑2 mendorong resep dasar itu jauh lebih lanjut: 1,5 miliar parameter dan dataset web yang jauh lebih besar. Keluaran model sering mengejutkan koherennya: artikel multi‑paragraf, cerita fiksi, dan ringkasan yang sekilas tampak seperti tulisan manusia.

Kapabilitas itu menimbulkan alarm soal potensi penyalahgunaan: propaganda otomatis, spam, pelecehan, dan berita palsu berskala besar. Alih‑alih merilis model penuh segera, OpenAI mengadopsi strategi rilis bertahap:

Ini menjadi salah satu contoh profil tinggi pertama OpenAI yang menghubungkan keputusan penerapan dengan keselamatan dan dampak sosial, dan membentuk cara organisasi memikirkan pengungkapan, keterbukaan, dan tanggung jawab.

GPT‑3 meningkat lagi—kali ini menjadi 175 miliar parameter. Alih‑alih bergantung terutama pada fine‑tuning tiap tugas, GPT‑3 memperlihatkan "few‑shot" dan bahkan "zero‑shot" learning: model sering bisa melakukan tugas baru hanya dari instruksi dan beberapa contoh dalam prompt.

Tingkat generalitas itu mengubah cara OpenAI dan industri memandang sistem AI. Alih‑alih membangun banyak model sempit, satu model besar bisa berfungsi sebagai mesin serba guna untuk:

Pentingnya, OpenAI memilih untuk tidak membuka sumber GPT‑3. Akses ditawarkan melalui API komersial. Keputusan ini menandai pivot strategis:

GPT‑1, GPT‑2, dan GPT‑3 menelusuri busur yang jelas dalam sejarah OpenAI: skala transformer, menemukan kapabilitas emergen, bergulat dengan keselamatan dan penyalahgunaan, serta meletakkan dasar komersial yang kelak mendukung produk seperti ChatGPT dan pengembangan GPT‑4 dan seterusnya.

Menjelang 2018, pemimpin OpenAI yakin bahwa tetap sebagai lab kecil yang didanai donasi tidak akan cukup untuk membangun dan mengarahkan sistem AI berskala besar dengan aman. Melatih model perbatasan sudah memerlukan puluhan juta dolar untuk komputasi dan talenta, dengan kurva biaya yang jelas menuju angka jauh lebih tinggi. Untuk bersaing mendapatkan peneliti terbaik, eksperimen skala, dan akses jangka panjang ke infrastruktur cloud, OpenAI membutuhkan struktur yang bisa menarik modal besar tanpa meninggalkan misi aslinya.

Pada 2019, OpenAI meluncurkan OpenAI LP, sebuah kemitraan terbatas “capped‑profit.” Tujuannya membuka akses investasi eksternal besar sambil menjaga nonprofit di puncak hierarki pengambilan keputusan.

Startup yang didanai venture kapital pada umumnya bertanggung jawab kepada pemegang saham yang mengejar pengembalian tanpa batas. Pendiri OpenAI khawatir ini akan menciptakan tekanan kuat untuk memprioritaskan keuntungan ketimbang keselamatan, keterbukaan, atau penerapan hati‑hati. Struktur LP merupakan kompromi: dapat menerbitkan kepentingan mirip ekuitas dan mengumpulkan uang dalam skala besar, tetapi diatur oleh aturan berbeda.

Dalam model capped‑profit, investor dan karyawan bisa memperoleh imbal hasil dari kepemilikan mereka, tetapi hanya sampai kelipatan tetap dari investasi asli mereka (untuk investor awal sering disebut hingga 100x, dengan cap lebih rendah pada tranche berikutnya). Setelah batas itu tercapai, nilai tambahan yang tercipta dimaksudkan mengalir ke induk nonprofit untuk digunakan sesuai misinya.

Ini berbeda tajam dengan startup biasa, di mana nilai ekuitas dapat, setidaknya secara teori, tumbuh tanpa batas dan memaksimalkan nilai pemegang saham menjadi default hukum dan budaya.

OpenAI Nonprofit tetap menjadi entitas pengendali. Dewan nonprofit mengawasi OpenAI LP dan diberi piagam untuk memprioritaskan kepentingan umat manusia di atas kepentingan kelompok investor atau karyawan tertentu.

Secara formal:

Desain tata kelola ini dimaksudkan memberi OpenAI fleksibilitas penggalangan dana dan perekrutan seperti organisasi komersial sambil mempertahankan kontrol yang berorientasi misi.

Restrukturisasi memicu perdebatan di dalam dan luar organisasi. Pendukung berargumen itu satu‑satunya cara praktis untuk mengamankan miliaran yang diperlukan bagi riset AI tingkat lanjut sambil tetap membatasi insentif keuntungan. Kritikus mempertanyakan apakah struktur yang menawarkan pengembalian besar dapat benar‑benar menahan tekanan komersial, dan apakah capnya cukup tinggi atau diterapkan dengan jelas.

Secara praktis, OpenAI LP membuka pintu bagi investasi strategis besar, paling menonjol dari Microsoft, dan memungkinkan perusahaan menawarkan paket kompensasi kompetitif yang terkait dengan upside potensial. Itu, pada gilirannya, memungkinkan OpenAI memperbesar tim riset, memperluas run pelatihan untuk model seperti GPT‑3 dan GPT‑4, dan membangun infrastruktur untuk menerapkan sistem seperti ChatGPT pada skala global—semua sambil menjaga hubungan tata kelola formal kembali ke asal nonprofitnya.

Pada 2019, OpenAI dan Microsoft mengumumkan kemitraan multi‑tahun yang membentuk peran kedua perusahaan dalam AI. Microsoft menginvestasikan dilaporkan $1 miliar, menggabungkan uang tunai dan kredit Azure, sebagai imbalan menjadi mitra komersial pilihan OpenAI.

Kesepakatan itu selaras dengan kebutuhan OpenAI akan sumber daya komputasi besar untuk melatih model yang semakin besar, sementara memberi Microsoft akses ke AI terdepan yang bisa membedakan produknya dan platform cloudnya. Selama tahun‑tahun berikutnya, hubungan itu semakin mendalam lewat pendanaan tambahan dan kolaborasi teknis.

OpenAI memilih Microsoft Azure sebagai platform cloud utama karena sejumlah alasan:

Ini menjadikan Azure lingkungan default untuk melatih dan menyajikan model seperti GPT‑3, Codex, dan kemudian GPT‑4.

Kemitraan itu menghasilkan salah satu sistem superkomputer AI terbesar di dunia, dibangun di Azure untuk beban kerja OpenAI. Microsoft menonjolkan cluster‑cluster ini sebagai contoh unggulan kapabilitas AI Azure, sementara OpenAI mengandalkan mereka untuk mendorong ukuran model, data pelatihan, dan kecepatan eksperimen.

Upaya infrastruktur bersama ini mengaburkan garis antara “pelanggan” dan “mitra”: OpenAI efektif memengaruhi roadmap AI Azure, dan Azure disesuaikan dengan kebutuhan OpenAI.

Microsoft menerima hak lisensi eksklusif atas beberapa teknologi OpenAI, paling menonjol GPT‑3. Itu memungkinkan Microsoft menyematkan model OpenAI ke produk‑produknya—Bing, Office, GitHub Copilot, Azure OpenAI Service—sementara perusahaan lain mengaksesnya lewat API OpenAI sendiri.

Eksklusivitas ini memicu perdebatan: pendukung berargumen hal itu memberikan pendanaan dan distribusi yang diperlukan untuk menskalakan AI kuat secara aman; kritikus khawatir hal itu memusatkan pengaruh atas model‑model frontier pada satu perusahaan teknologi besar.

Pada saat sama, kemitraan memberi OpenAI visibilitas arus utama. Pencantuman merek Microsoft, integrasi produk, dan saluran penjualan enterprise membantu memindahkan sistem OpenAI dari demo riset ke alat sehari‑hari yang digunakan jutaan orang, membentuk persepsi publik tentang OpenAI sebagai lab independen sekaligus mitra AI utama Microsoft.

Seiring model OpenAI meningkat kemampuan memahami dan menghasilkan bahasa, tim mendorong ke modalitas baru: gambar dan kode. Pergeseran ini memperluas kerja OpenAI dari penulisan dan dialog ke kreativitas visual dan pengembangan perangkat lunak.

CLIP (Contrastive Language–Image Pretraining), diumumkan awal 2021, adalah langkah besar menuju model yang memahami dunia lebih mirip manusia.

Alih‑alih hanya melatih pada gambar berlabel, CLIP belajar dari ratusan juta pasangan gambar–keterangan yang dikumpulkan dari web publik. Ia dilatih untuk mencocokkan gambar dengan deskripsi teks yang paling mungkin dan membedakannya dari yang salah.

Ini memberi CLIP kemampuan umum yang mengejutkan:

CLIP menjadi fondasi bagi pekerjaan generatif gambar OpenAI selanjutnya.

DALL·E (2021) menerapkan arsitektur bergaya GPT pada gambar, menghasilkan gambar langsung dari prompt teks: “kursi berbentuk alpukat” atau “papan toko yang bertuliskan ‘openai’”. Ia menunjukkan bahwa model bahasa dapat diperluas untuk menghasilkan gambar yang koheren dan seringkali imajinatif.

DALL·E 2 (2022) meningkatkan resolusi, realisme, dan kendali. Ia memperkenalkan fitur seperti:

Sistem ini mengubah cara desainer, pemasar, seniman, dan hobiis membuat prototipe ide, memindahkan sebagian pekerjaan kreatif dari pembuatan manual ke eksplorasi iteratif berbasis prompt.

Codex (2021) mengambil keluarga GPT‑3 dan menyesuaikannya dengan kode sumber, melatih pada repositori kode publik besar. Ia dapat menerjemahkan bahasa alami menjadi potongan kerja untuk bahasa seperti Python, JavaScript, dan banyak lainnya.

GitHub Copilot, yang dibangun di atas Codex, membawa kemampuan ini ke alat pengembangan sehari‑hari. Programmer mulai menerima fungsi lengkap, tes, dan boilerplate sebagai saran, menggunakan komentar berbahasa alami sebagai panduan.

Untuk pengembangan perangkat lunak, Codex menandakan pergeseran bertahap:

Bersama CLIP, DALL·E, dan Codex, pendekatan OpenAI terbukti dapat meluas di luar teks ke visi dan kode, memperluas dampak risetnya di bidang seni, desain, dan rekayasa.

OpenAI meluncurkan ChatGPT sebagai "research preview" gratis pada 30 November 2022, mengumumkannya lewat posting blog singkat dan tweet daripada kampanye produk besar. Model ini berbasis GPT‑3.5 dan dioptimalkan untuk dialog, dengan aturan pengaman untuk menolak beberapa permintaan berbahaya atau tidak aman.

Penggunaan melonjak hampir segera. Jutaan orang mendaftar dalam beberapa hari, dan ChatGPT menjadi salah satu aplikasi konsumen dengan pertumbuhan tercepat yang pernah ada. Tangkapan layar percakapan memenuhi media sosial saat pengguna menguji kemampuannya menulis esai, debug kode, menyusun email, dan menjelaskan topik kompleks dengan bahasa sederhana.

Daya tarik ChatGPT datang dari fleksibilitasnya, bukan satu kasus penggunaan sempit.

Dalam pendidikan, siswa menggunakannya untuk meringkas bacaan, menghasilkan soal latihan, menerjemahkan atau menyederhanakan artikel akademik, dan mendapatkan penjelasan langkah‑demi‑langkah masalah matematika atau sains. Guru bereksperimen merancang silabus, menyusun rubrik, dan membuat materi pembelajaran yang terdiferensiasi, meski sekolah‑sekolah juga memperdebatkan apakah dan bagaimana penggunaannya diperbolehkan.

Di tempat kerja, profesional meminta ChatGPT menyusun email, salinan pemasaran, dan laporan, menyusun kerangka presentasi, menghasilkan potongan kode, menulis test case, dan menjadi mitra brainstorming untuk ide produk atau strategi. Freelancer dan bisnis kecil khususnya memanfaatkannya sebagai asisten berbiaya rendah untuk konten dan analisis.

Untuk pemecahan masalah sehari‑hari, orang menggunakan ChatGPT untuk rencana perjalanan, ide masak dari bahan yang ada, penjelasan hukum dan medis dasar (dengan penekanan untuk berkonsultasi profesional), dan bantuan belajar keterampilan atau bahasa baru.

Preview riset awal disediakan gratis untuk mengurangi friksi dan mengumpulkan umpan balik tentang kegagalan, penyalahgunaan, dan kekurangan kapabilitas. Saat penggunaan tumbuh, OpenAI menghadapi biaya infrastruktur tinggi dan permintaan pengguna untuk akses lebih andal.

Pada Februari 2023, OpenAI memperkenalkan ChatGPT Plus, paket langganan yang menawarkan respons lebih cepat, akses prioritas saat puncak, dan akses awal ke fitur dan model baru seperti GPT‑4. Ini menciptakan aliran pendapatan berulang sambil menjaga tier gratis untuk akses luas.

Seiring waktu, OpenAI menambahkan opsi lebih berorientasi bisnis: akses API ke model obrolan yang sama, alat untuk integrasi ke produk dan alur kerja, serta penawaran seperti ChatGPT Enterprise dan rencana tim yang menargetkan organisasi yang membutuhkan keamanan lebih tinggi, kontrol admin, dan fitur kepatuhan.

Visibilitas mendadak ChatGPT memperkuat perdebatan lama tentang AI.

Regulator dan pembuat kebijakan khawatir tentang privasi, perlindungan data, dan kepatuhan terhadap hukum yang ada, terutama di wilayah seperti Uni Eropa. Beberapa otoritas sempat membatasi atau menyelidiki ChatGPT saat menilai apakah pengumpulan dan pemrosesan data memenuhi standar hukum.

Pendidik menghadapi masalah plagiarisme dan integritas akademik karena siswa dapat menghasilkan esai dan tugas yang sulit dideteksi. Ini memicu larangan atau kebijakan ketat di beberapa sekolah, sementara lainnya menggeser penilaian ke tugas yang menekankan proses, ujian lisan, atau pekerjaan dalam kelas.

Etika dan peneliti mengangkat alarm tentang misinformasi, ketergantungan berlebihan pada AI untuk keputusan kritis, bias dalam jawaban, dan potensi dampak pada pekerjaan kreatif dan berbasis pengetahuan. Ada juga pertanyaan tentang data pelatihan, hak cipta, dan hak penulis serta seniman yang karya‑karyanya mungkin memengaruhi perilaku model.

Bagi OpenAI, ChatGPT menandai titik balik: organisasi bergeser dari lab riset yang sebagian besar dikenal di kalangan AI menjadi perusahaan di pusat diskusi global tentang bagaimana model bahasa kuat harus diterapkan, diatur, dan diintegrasikan ke kehidupan sehari‑hari.

OpenAI merilis GPT‑4 pada Maret 2023 sebagai langkah besar melampaui GPT‑3.5, model yang awalnya menggerakkan ChatGPT. GPT‑4 meningkatkan penalaran, mengikuti instruksi kompleks, dan menjaga koherensi dalam percakapan lebih panjang. Ia juga jauh lebih baik menangani prompt bernuansa, seperti menjelaskan klausul hukum, merangkum makalah teknis, atau menyusun kode dari kebutuhan yang samar.

Dibandingkan GPT‑3.5, GPT‑4 mengurangi banyak mode kegagalan yang jelas: ia lebih jarang membuat sumber fiktif saat diminta kutipan, menangani kasus tepi dalam soal matematika dan logika lebih andal, dan menghasilkan keluaran lebih konsisten pada permintaan berulang.

GPT‑4 memperkenalkan kapabilitas multimodal: selain teks, dalam beberapa konfigurasi ia dapat menerima gambar sebagai input. Ini membuka kasus penggunaan seperti mendeskripsikan grafik, membaca catatan tulisan tangan, menafsirkan tangkapan layar UI, atau menganalisis foto untuk mengekstrak informasi terstruktur.

Pada benchmark standar, GPT‑4 secara signifikan mengungguli model sebelumnya. Ia mencapai skor hampir di puncak persentil pada ujian profesional simulasi seperti bar exam, SAT, dan berbagai tes tingkat lanjut. Ia juga meningkat pada benchmark pengkodean dan penalaran, mencerminkan kemampuan lebih kuat dalam pemahaman bahasa dan pemecahan masalah.

GPT‑4 dengan cepat menjadi inti dari API OpenAI dan menggerakkan gelombang produk pihak ketiga baru: copilots AI dalam suite produktivitas, asisten pengkodean, alat dukungan pelanggan, platform pendidikan, dan aplikasi khusus vertikal di bidang hukum, keuangan, dan kesehatan.

Meski kemajuan ini, GPT‑4 masih dapat berhalusinasi, dipicu menghasilkan keluaran tak aman atau bias, dan tidak memiliki pemahaman sejati atau pengetahuan terkini. OpenAI menaruh perhatian besar pada riset alignment untuk GPT‑4—menggunakan teknik seperti reinforcement learning from human feedback, red‑teaming, dan aturan keselamatan tingkat sistem—tetapi menekankan bahwa penerapan hati‑hati, pemantauan, dan riset berkelanjutan masih diperlukan untuk mengelola risiko dan penyalahgunaan.

Sejak tahun‑tahun awal, OpenAI menempatkan keselamatan dan alignment sebagai inti misinya, bukan pemikiran belakangan untuk peluncuran produk. Organisasi secara konsisten menyatakan tujuannya membangun sistem AI yang sangat kapabel yang selaras dengan nilai manusia dan diterapkan sedemikian rupa sehingga memberi manfaat bagi semua orang, bukan hanya pemegang saham atau mitra awal.

Pada 2018, OpenAI menerbitkan OpenAI Charter, yang memformalkan prioritasnya:

Piagam berfungsi sebagai kompas tata kelola, membentuk keputusan tentang arah riset, kecepatan penerapan, dan kemitraan eksternal.

Seiring model makin mampu, OpenAI membangun fungsi keselamatan dan tata kelola khusus di samping tim riset inti:

Kelompok‑kelompok ini memengaruhi keputusan peluncuran, tingkatan akses, dan kebijakan penggunaan untuk model seperti GPT‑4 dan DALL·E.

Pendekatan teknis penentu telah berupa reinforcement learning from human feedback (RLHF). Pelabel manusia meninjau keluaran model, memberi peringkat, dan melatih model reward. Model utama lalu dioptimalkan untuk menghasilkan respons yang lebih dekat dengan perilaku yang disukai manusia, mengurangi keluaran beracun, bias, atau berbahaya.

Seiring waktu, OpenAI melapisi RLHF dengan teknik tambahan: kebijakan keselamatan tingkat sistem, filter konten, fine‑tuning untuk domain spesifik, dan alat pemantauan yang dapat membatasi atau menandai penggunaan berisiko tinggi.

OpenAI berpartisipasi dalam kerangka keselamatan publik, seperti komitmen sukarela dengan pemerintah, praktik pelaporan model, dan standar keselamatan model frontier. Ia bekerja sama dengan akademisi, organisasi masyarakat sipil, dan peneliti keamanan pada evaluasi, red‑teaming, dan audit.

Kolaborasi ini, bersama dokumen formal seperti Piagam dan kebijakan penggunaan yang berkembang, membentuk tulang punggung pendekatan OpenAI terhadap tata kelola sistem AI yang semakin kuat.

Kenaikan cepat OpenAI dibayangi kritik dan ketegangan internal, banyak berfokus pada seberapa jauh organisasi masih selaras dengan misi awalnya untuk manfaat luas dan aman.

Awalnya, OpenAI menekankan publikasi dan pembagian. Seiring model seperti GPT‑2, GPT‑3, dan GPT‑4 menjadi lebih kapabel, perusahaan bergeser ke rilis terbatas, akses hanya lewat API, dan lebih sedikit detail teknis.

Kritikus berargumen langkah ini bertentangan dengan janji yang tersirat dari nama “OpenAI” dan pesan nonprofit awal. Pendukung di dalam perusahaan berpendapat menahan bobot model dan detail pelatihan diperlukan untuk mengelola risiko penyalahgunaan dan keamanan.

OpenAI merespons dengan menerbitkan evaluasi keselamatan, system card, dan dokumen kebijakan, sambil tetap menjaga bobot model inti proprietary. Mereka menyajikannya sebagai penyeimbang antara keterbukaan, keselamatan, dan tekanan kompetitif.

Saat OpenAI memperdalam kemitraan dengan Microsoft—mengintegrasikan model ke Azure dan produk seperti Copilot—pengamat menyuarakan kekhawatiran tentang konsentrasi komputasi, data, dan pengambilan keputusan.

Kritikus khawatir segelintir perusahaan kini mengontrol model general‑purpose paling maju dan infrastruktur besar di belakangnya. Lainnya berpendapat komersialisasi agresif (ChatGPT Plus, penawaran enterprise, dan lisensi eksklusif) menyimpang dari misi nonprofit awal tentang manfaat yang dibagi luas.

Kepemimpinan OpenAI memframing pendapatan sebagai kebutuhan untuk mendanai riset mahal sambil mempertahankan struktur capped‑profit dan piagam yang memprioritaskan kepentingan umat manusia di atas pengembalian investor. Mereka juga memperkenalkan program seperti tier akses gratis, kemitraan riset, dan beberapa alat sumber terbuka untuk menunjukkan manfaat publik.

Perbedaan pendapat internal tentang kecepatan bergerak, tingkat keterbukaan, dan prioritas keselamatan muncul berulang kali.

Dario Amodei dan lainnya hengkang pada 2020 untuk mendirikan Anthropic, mengutip pandangan berbeda soal keselamatan dan tata kelola. Kemudian, pengunduran diri peneliti keselamatan kunci, termasuk Jan Leike pada 2024, secara publik menyoroti kekhawatiran bahwa tujuan produk jangka pendek mengalahkan pekerjaan keselamatan jangka panjang.

Kisah yang paling terlihat terjadi pada November 2023, ketika dewan sempat memecat CEO Sam Altman karena alasan kehilangan kepercayaan. Setelah reaksi karyawan yang intens dan negosiasi yang melibatkan Microsoft serta pemangku kepentingan lain, Altman kembali, dewan direstrukturisasi, dan OpenAI berjanji reformasi tata kelola, termasuk pembentukan Komite Keselamatan dan Keamanan baru.

Episode‑episode ini menegaskan bahwa organisasi masih bergulat menyelaraskan penerapan cepat, kesuksesan komersial, dan tanggung jawab yang dinyatakan terkait keselamatan serta manfaat luas.

OpenAI telah bergeser dari lab riset kecil menjadi penyedia infrastruktur sentral untuk AI, memengaruhi cara alat baru dibangun, diatur, dan dipahami.

Alih‑alih sekadar menerbitkan model, OpenAI kini mengoperasikan platform penuh yang dipakai startup, perusahaan besar, dan pengembang solo. Melalui API untuk model seperti GPT‑4, DALL·E, dan sistem masa depan, ia menjadi:

Peran platform ini berarti OpenAI tidak hanya memajukan riset—ia juga menetapkan default bagi bagaimana jutaan orang pertama kali mengalami AI yang kuat.

Karya OpenAI mendorong kompetitor dan komunitas sumber terbuka merespons dengan model baru, metode pelatihan, dan pendekatan keselamatan. Kompetisi itu mempercepat kemajuan sekaligus mengasah perdebatan tentang keterbukaan, sentralisasi, dan komersialisasi AI.

Pemerintah dan regulator semakin melihat praktik OpenAI, laporan transparansi, dan riset alignment ketika merancang aturan untuk penerapan AI, evaluasi keselamatan, dan penggunaan bertanggung jawab. Percakapan publik tentang ChatGPT, GPT‑4, dan sistem masa depan sangat memengaruhi cara masyarakat membayangkan risiko dan manfaat AI.

Seiring model menjadi lebih kapabel, isu yang belum terjawab mengenai peran OpenAI menjadi semakin penting:

Pertanyaan‑pertanyaan ini akan menentukan apakah sistem AI masa depan memperkuat ketidaksetaraan yang ada atau membantu menguranginya.

Pengembang dan bisnis dapat:

Individu dapat:

Pengaruh masa depan OpenAI akan bergantung tidak hanya pada keputusan internalnya, tetapi juga pada bagaimana pemerintah, pesaing, masyarakat sipil, dan pengguna sehari‑hari memilih untuk terlibat, mengkritik, dan menuntut akuntabilitas dari sistem yang dibangunnya.

OpenAI didirikan pada 2015 sebagai laboratorium riset nonprofit dengan misi memastikan bahwa kecerdasan umum buatan (AGI), jika tercipta, memberi manfaat bagi seluruh umat manusia.

Beberapa faktor yang membentuk pembentukannya:

Kisah asal ini terus memengaruhi struktur, kemitraan, dan komitmen publik OpenAI hingga hari ini.

AGI (artificial general intelligence) mengacu pada sistem AI yang mampu melakukan beragam tugas kognitif pada atau di atas tingkat manusia, bukan sekadar alat sempit yang dioptimalkan untuk satu pekerjaan.

Misi OpenAI adalah:

Misi ini diformalkan dalam OpenAI Charter dan membentuk keputusan besar tentang arah riset dan penerapan.

OpenAI bertransisi dari nonprofit murni ke struktur "capped‑profit" (OpenAI LP) untuk mengumpulkan modal besar yang diperlukan bagi riset AI mutakhir sambil mencoba menjaga misi di posisi utama.

Poin utama:

Ini merupakan eksperimen tata kelola, dan efektivitasnya masih menjadi perdebatan.

Microsoft menyediakan OpenAI dengan kapasitas komputasi awan besar lewat Azure dan telah berinvestasi miliaran dolar.

Kemitraan ini meliputi:

Sebagai imbalan, OpenAI mendapat sumber daya yang dibutuhkan untuk melatih dan menyebarkan model frontier pada skala global, sementara Microsoft mendapatkan kapabilitas AI yang membedakan ekosistemnya.

Seri GPT menunjukkan kemajuan dalam skala, kapabilitas, dan strategi penerapan:

OpenAI awalnya mengadopsi pendekatan “terbuka secara default”—merilis makalah, kode, dan alat seperti OpenAI Gym. Saat model menjadi lebih kuat, kebijakan bergeser ke arah:

OpenAI berargumen ini perlu untuk mengurangi risiko penyalahgunaan dan mengelola keamanan. Kritikus menyatakan langkah ini mengikis janji awal yang tersirat dari nama “OpenAI” dan dapat memusatkan kekuatan di satu perusahaan.

OpenAI menggunakan kombinasi struktur organisasi dan metode teknis untuk mengelola keselamatan dan penyalahgunaan:

Langkah‑langkah ini mengurangi risiko tetapi tidak menghilangkan masalah seperti halusinasi, bias, dan potensi penyalahgunaan—yang tetap menjadi tantangan riset dan tata kelola aktif.

ChatGPT, diluncurkan akhir 2022, membuat model bahasa besar dapat diakses publik lewat antarmuka obrolan sederhana.

Mengapa ini titik balik:

Visibilitas ini juga memperketat pengawasan terhadap tata kelola, model bisnis, dan praktik keselamatan OpenAI.

Model‑model OpenAI, terutama Codex dan GPT‑4, sudah mengubah sebagian pekerjaan berbasis pengetahuan dan kerja kreatif.

Manfaat potensial:

Risiko dan perhatian:

Anda dapat berinteraksi dengan ekosistem OpenAI dengan beberapa cara:

Setiap langkah mendorong batas teknis sekaligus memaksa keputusan baru tentang keselamatan, akses, dan komersialisasi.

Dampak bersih akan sangat bergantung pada kebijakan, pilihan organisasi, dan bagaimana individu serta perusahaan mengintegrasikan AI ke alur kerja mereka.

Dalam semua kasus, penting untuk tetap mendapat informasi tentang cara model dilatih dan diatur, serta mendorong transparansi, akuntabilitas, dan akses yang adil saat sistem ini berkembang.