19 Okt 2025·8 menit

Cara Membangun Aplikasi Web untuk Memantau Cakupan Otomasi Internal

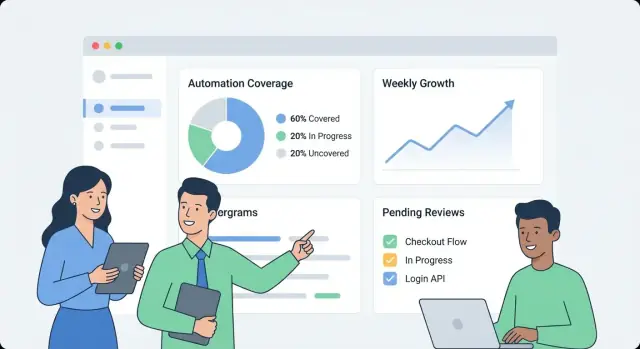

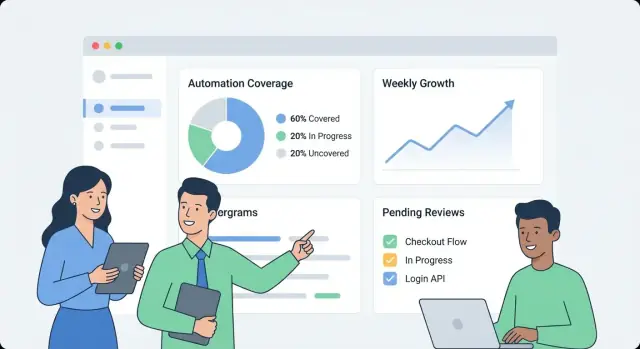

Pelajari cara merancang dan membangun aplikasi web yang melacak cakupan otomasi internal: metrik, model data, integrasi, UX dashboard, dan peringatan.

Pelajari cara merancang dan membangun aplikasi web yang melacak cakupan otomasi internal: metrik, model data, integrasi, UX dashboard, dan peringatan.

Sebelum membangun apa pun, tuliskan apa arti “cakupan otomasi” di organisasi Anda. Jika tidak, dashboard akan berubah menjadi kumpulan angka yang tidak terkait yang ditafsirkan berbeda oleh tim yang berbeda.

Mulailah dengan memilih unit yang Anda ukur. Opsi umum meliputi:

Pilih satu definisi utama untuk v1, lalu catat tipe sekunder yang mungkin ditambahkan kemudian. Jelaskan kasus tepi, seperti langkah “semi-otomatis” yang masih memerlukan persetujuan.

Audiens yang berbeda menanyakan hal berbeda:

Tulis 5–10 “pertanyaan teratas” dan perlakukan itu sebagai persyaratan produk.

Tentukan hasil utama: visibilitas (apa yang ada), prioritisasi (apa yang diotomasi selanjutnya), akuntabilitas (siapa yang memilikinya), dan pelacakan tren (apakah ini membaik).

Tetapkan batasan yang jelas untuk v1. Contoh: “Kita tidak akan menilai kualitas dulu,” “Kita tidak akan mengukur waktu yang dihemat,” atau “Kita hanya memasukkan tes berbasis CI, bukan skrip lokal.”

Akhirnya, putuskan seperti apa keberhasilan: adopsi konsisten (pengguna aktif mingguan), kesegaran data tinggi (mis. pembaruan dalam 24 jam), lebih sedikit blind spot (cakupan terpetakan untuk semua sistem kritis), dan tindak lanjut yang terukur (pemilik ditetapkan dan celah menyusut bulan ke bulan).

Sebelum Anda bisa mengukur cakupan otomasi, Anda perlu tahu di mana “bukti otomasi” sebenarnya berada. Di kebanyakan organisasi, otomasi tersebar di banyak alat yang diadopsi di waktu berbeda oleh tim berbeda.

Mulailah dengan inventaris pragmatis yang menjawab: Sinyal apa yang membuktikan suatu aktivitas otomatis, dan dari mana kita bisa mengambilnya?

Sumber tipikal termasuk pipeline CI (job build/test), framework pengujian (hasil unit/integrasi/E2E), alat workflow (persetujuan, deployment, transisi ticket), runbook (skrip dan prosedur terdokumentasi), dan platform RPA. Untuk tiap sumber, catat identifier yang bisa di-join nanti (repo, nama layanan, environment, tim) dan “bukti” yang akan Anda simpan (run job, laporan suite test, aturan automasi, eksekusi skrip).

Selanjutnya, daftarkan sistem pencatat yang menentukan apa yang “seharusnya ada”: hosting repo, pelacak issue, dan CMDB/katalog layanan. Sumber-sumber ini biasanya memberi daftar otoritatif layanan, pemilik, dan kritikalitas—yang penting untuk menghitung cakupan, bukan sekadar menghitung aktivitas.

Cocokkan tiap sumber dengan metode ingestion yang paling tidak rapuh:

Catat rate limit, metode autentikasi (PAT, OAuth, service accounts), jendela retensi, dan masalah kualitas data yang diketahui (layanan diubah nama, penamaan tidak konsisten, pemilik hilang).

Rencanakan juga skor keandalan sumber per connector (dan opsional per metrik) sehingga pengguna dapat melihat apakah sebuah angka berlabel “kepercayaan tinggi” atau “usaha terbaik.” Ini mencegah presisi palsu dan membantu memprioritaskan perbaikan connector nanti.

Dashboard cakupan yang berguna dimulai dari model data yang memisahkan apa yang diharapkan untuk diotomasi dari apa yang benar-benar berjalan baru-baru ini. Jika Anda mencampurkannya, angka bisa terlihat baik meskipun otomasi sudah usang.

Mulailah dengan blok bangunan ini:

Pilih satu level pelaporan utama dan patuhi itu:

Anda bisa mendukung banyak tampilan nanti, tetapi versi pertama harus memiliki satu level “sumber kebenaran”.

Gunakan ID yang bertahan saat refactor:

Perlakukan display name sebagai dapat diedit, bukan sebagai identifier.

Pola praktis:

Ini memungkinkan Anda menjawab: "Apa yang seharusnya ditutupi?", "Apa yang mengklaim menutupinya?", dan "Apa yang benar-benar berjalan?"

Tangkap:

last_seen_at (asset masih ada)last_run_at, last_failure_atlast_reviewed_at (seseorang mengonfirmasi klaim masih valid)Field kesegaran memudahkan menyorot item yang “tertutup tapi usang” tanpa perdebatan.

Jika metrik cakupan Anda samar, setiap grafik menjadi bahan perdebatan. Mulailah dengan memilih satu metrik utama untuk ringkasan eksekutif, lalu tambahkan rincian pendukung untuk tim.

Sebagian besar organisasi memilih salah satu dari ini:

Anda masih bisa menampilkan ketiganya, tetapi jelaskan mana yang menjadi angka “headline”.

Tulis aturan eksplisit supaya tim menilai item secara konsisten:

Jaga agar aturan terukur. Jika dua orang tidak bisa memberi skor yang sama pada item yang sama, perbaiki definisi.

Gunakan skala integer kecil (1–5) untuk input seperti risiko, dampak bisnis, frekuensi run, dan waktu yang dihemat. Contoh: weight = risk + impact + frequency.

Jangan hitung item sebagai “otomatis” kecuali memiliki bukti, seperti:

Ini mengubah cakupan dari klaim yang dilaporkan sendiri menjadi sinyal yang dapat diamati.

Tempatkan aturan skor dan contoh di satu halaman bersama (tautan dari dashboard). Interpretasi yang konsisten adalah apa yang membuat tren dapat dipercaya.

Aplikasi cakupan otomasi internal sebaiknya membosankan dalam arti baik: mudah dioperasikan, mudah diubah, dan jelas dari mana angka berasal. Bentuk sederhana “API + database + dashboard” biasanya lebih baik daripada sistem terdistribusi sampai Anda benar-benar membutuhkannya.

Pilih stack yang tim Anda sudah dukung. Baseline umum:

Jika ingin bergerak lebih cepat pada versi internal pertama, pendekatan vibe-coding dapat bekerja dengan baik: misalnya, Koder.ai dapat membantu menghasilkan dashboard React plus backend Go + PostgreSQL dari spesifikasi terstruktur, lalu biarkan tim iterasi via chat sambil tetap menjaga ekspor kode sumber penuh dan deployment konvensional.

Bahkan dalam sistem “sederhana”, pisahkan tanggung jawab:

Gunakan tabel relasional untuk entitas kanonis (tim, layanan, automasi, bukti, pemilik). Untuk tren (run dari waktu ke waktu, cakupan per minggu), pertahankan:

Jika banyak tim berbagi aplikasi, tambahkan field org_id/team_id sejak awal. Ini memungkinkan izin dan menghindari migrasi menyakitkan nanti ketika kepemimpinan minta “satu dashboard, tetapi tersegmentasi.”

Jalankan dev/staging/prod dan definisikan bagaimana data berpindah:

Untuk lebih lanjut tentang membuat UI mudah dinavigasi, lihat /blog/design-dashboard-ux.

Dashboard cakupan cepat menjadi sumber kebenaran, jadi kontrol akses dan penanganan data sama pentingnya dengan grafik. Mulailah sederhana, tetapi rancang agar keamanan bisa diperketat tanpa rewrite besar.

Jika perusahaan Anda sudah punya SSO, integrasikan sejak hari pertama (OIDC sering paling mudah; SAML umum di organisasi besar). Jika perlu peluncuran internal cepat, Anda bisa mulai di belakang auth proxy internal yang menyuntik header identitas, lalu ganti ke SSO native kemudian.

Normalisasikan identitas ke kunci pengguna stabil (email bisa berubah). Simpan profil pengguna minimal dan ambil keanggotaan grup/tim sesuai permintaan bila memungkinkan.

Definisikan set peran kecil dan jaga otorisasi konsisten di UI dan API:

Utamakan izin berbasis scope (per tim/layanan) daripada “super user.” Ini mengurangi risiko dan menghindari bottleneck.

Bukti cakupan sering kali mencakup link ke log CI, tiket insiden, atau dokumen internal. Batasi akses ke URL tersebut dan ke log mentah. Simpan hanya yang Anda perlukan untuk verifikasi (mis. build ID, timestamp, dan ringkasan status) daripada menyalin seluruh log ke database.

Setiap edit manual pada klaim cakupan atau metadata harus membuat record audit: siapa yang mengubah apa, kapan, dan kenapa (alasan teks bebas). Terakhir, tetapkan kebijakan retensi untuk riwayat run dan bukti—tentukan berapa lama disimpan, dan terapkan penghapusan aman sehingga record lama bisa dihapus tanpa memecah perhitungan cakupan saat ini.

Dashboard cakupan berhasil ketika seseorang bisa menjawab tiga pertanyaan dalam kurang dari semenit: Bagaimana kondisi kita? Apa yang berubah? Apa yang harus diperbaiki selanjutnya? Rancang UX di sekitar keputusan tersebut, bukan di sekitar sumber data.

Buat layar pertama sebagai ringkasan sederhana:

Jaga label bahasa sehari-hari (“Terotomasi baru-baru ini” lebih baik daripada “Recency bukti”), dan hindari memaksa pembaca menafsirkan status teknis.

Dari metrik ringkasan, biarkan pengguna klik ke halaman layanan/proses yang menjawab “apa” dan “oleh apa”:

Rancang setiap baris/kartu untuk menyertakan “mengapa di balik angka”: link bukti, pemilik, status run terakhir, dan tindakan selanjutnya yang jelas (“Jalankan ulang job”, “Tetapkan pemilik”, “Tambahkan bukti yang hilang”).

Sediakan filter yang memetakan cara kerja organisasi:

Jaga status filter terlihat dan dapat dibagikan (parameter URL), sehingga seseorang bisa mengirim tautan seperti “Prod + Tier-1 + 14 hari terakhir” ke pemangku kepentingan.

Gunakan definisi inline, bukan dokumentasi panjang:

Integrasi adalah tempat aplikasi cakupan Anda menjadi nyata. Tujuannya bukan mereplikasi setiap fitur CI atau alat test—melainkan mengekstrak sekumpulan fakta yang konsisten: apa yang dijalankan, kapan dijalankan, apa yang dicakup, dan siapa pemiliknya.

Mulailah dengan sistem yang sudah menghasilkan sinyal automasi: CI (GitHub Actions, GitLab CI, Jenkins), runner test (JUnit, pytest), dan alat kualitas (laporan coverage, linter, scan keamanan).

Sebuah connector harus mengambil (atau menerima via webhook) payload minimal:

Jaga connector idempotent: pull berulang tidak boleh membuat duplikat.

Beberapa gap cakupan disengaja (sistem lama, batasan pihak ketiga, inisiatif yang ditangguhkan). Sediakan record “exception” ringan yang memerlukan:

Ini mencegah blind spot permanen dan menjaga pandangan kepemimpinan tetap jujur.

Sumber yang berbeda jarang setuju pada identifier: satu sistem berkata “payments-service,” yang lain “payments,” dan yang ketiga menggunakan slug repo.

Buat aturan normalisasi untuk:

Lakukan ini sejak awal; setiap metrik downstream bergantung padanya.

Perkenalkan tabel alias (mis. service_aliases, repo_aliases) yang memetakan banyak nama eksternal ke satu entitas kanonik. Saat data baru tiba, cocokkan ke ID kanonik terlebih dahulu, lalu alias.

Jika nama baru tidak cocok, buat saran merge (mis. “payments-api” mirip dengan “payments-service”) bagi admin untuk menyetujui.

Jadwalkan job berkala yang memeriksa timestamp run terakhir per sumber dan menandai apa pun yang usang (mis. tidak ada run CI dalam 7 hari). Ekspos ini di UI agar cakupan rendah tidak disamakan dengan data hilang.

Dashboard berguna, tetapi alert dan workflow ringanlah yang mengubah data menarik menjadi perbaikan berkelanjutan. Tujuannya sederhana: beri tahu orang yang tepat pada waktu yang tepat, dengan konteks cukup untuk bertindak.

Mulailah dengan set kecil alert bernilai tinggi:

Setiap alert harus menaut langsung ke view drill-down terkait (mis. /services/payments?tab=coverage atau /teams/platform?tab=owners) sehingga orang tidak perlu mencari.

Hindari aturan satu-ukuran-untuk-semua. Biarkan tim mengatur aturan seperti:

Ini menjaga sinyal tetap bermakna dan mengurangi kelelahan alert.

Kirim alert ke saluran yang sudah dipakai (email dan Slack), dan sertakan: apa yang berubah, mengapa penting, dan siapa pemiliknya. Di samping alert real-time, tambahkan ringkasan mingguan yang mencakup:

Perlakukan alert seperti tugas: izinkan acknowledgement, penugasan, dan status (open/triaged/resolved). Jejak komentar singkat (“diperbaiki di PR #1234”) membuat pelaporan kredibel dan mencegah masalah yang sama muncul kembali tanpa terlihat.

Dashboard pemantauan terasa cepat ketika API menjawab pertanyaan yang benar-benar diminta UI—tanpa memaksa browser menggabungkan puluhan panggilan. Mulailah dengan surface API minimal yang diarahkan pada dashboard, lalu tambahkan job latar untuk pra-hitung apa pun yang mahal.

Jaga versi pertama fokus pada layar inti:

GET /api/services (filter seperti tim, bahasa, tier)GET /api/services/{id}/coverage (skor keseluruhan + breakdown utama)GET /api/services/{id}/evidence?status=passed&since=...PATCH /api/services/{id}Rancang respons sehingga dashboard bisa langsung merender: sertakan nama layanan, pemilik, waktu bukti terakhir, dan skor saat ini dalam satu payload daripada mengharuskan lookup tambahan.

Daftar dan tabel drill-down harus selalu dipaginasi (limit + cursor). Untuk endpoint yang sering dipanggil, tambahkan caching di lapisan API (atau cache bersama) yang dikunci oleh filter dan scope akses pemanggil.

Untuk apa pun yang memerlukan pemindaian banyak bukti (mis. “cakupan per tim”), pra-hitung rollup dalam job malam. Simpan rollup di tabel terpisah (atau materialized view) sehingga baca sederhana dan dapat diprediksi.

Tren paling mudah ketika Anda menyimpan snapshot harian:

GET /api/services/{id}/trend?days=90.Snapshot menghindari perhitungan ulang metrik historis tiap kali halaman dimuat dan mempermudah menggambar grafik “kesegaran”.

Onboarding massal lebih mulus dengan:

POST /api/import/services (unggah CSV)GET /api/export/services.csvTerakhir, tegakkan aturan validasi saat penulisan: pemilik wajib, nilai status yang diizinkan, dan timestamp yang masuk akal (tidak ada bukti di masa depan). Menolak data buruk sejak awal mencegah perbaikan lambat dan membingungkan nanti—terutama saat rollup bergantung pada input konsisten.

Dashboard cakupan hanya berguna bila orang bisa mempercayainya. Perlakukan deployment dan operasi sebagai bagian produk: rilis yang dapat diprediksi, sinyal kesehatan yang jelas, dan pemulihan sederhana saat sesuatu rusak.

Untuk aplikasi internal, optimalkan untuk overhead rendah dan iterasi cepat.

Jika menggunakan platform seperti Koder.ai untuk mempercepat pengembangan, manfaatkan ekspor kode sumber dan workflow deployment sejak awal, sehingga aplikasi internal tetap mengikuti praktik promosi, review, dan rollback standar.

Anda tidak memerlukan stack kompleks untuk mendapatkan sinyal andal.

Atur backup database otomatis dan kebijakan retensi yang sesuai kebutuhan Anda.

Dokumentasikan runbook untuk:

Sedikit disiplin operasional mencegah "cakupan" berubah menjadi tebakan.

Aplikasi pemantauan hanya membantu jika tim mempercayainya dan menggunakannya. Perlakukan rollout seperti peluncuran produk: mulai kecil, tetapkan kepemilikan jelas, dan benamkan ritme yang dapat diprediksi untuk pembaruan.

Jaga onboarding ringan dan dapat diulang:

Tujuan yang baik: “tampilan dashboard pertama dalam 30 menit,” bukan proyek konfigurasi yang memakan minggu.

Tetapkan dua ritme:

Skor cakupan bisa menjadi politik jika aturan berubah tanpa pemberitahuan. Bentuk kelompok tata kelola kecil (seringnya Eng Productivity + Security/Quality) yang bisa:

Publikasikan perubahan di changelog sederhana seperti /docs/scoring-changelog.

Lacak adopsi dengan beberapa metrik sederhana: pengguna aktif, layanan yang dilacak, dan kepatuhan kesegaran (berapa banyak layanan yang punya bukti up-to-date). Gunakan ini untuk mengarahkan iterasi: pembobotan yang lebih baik, tipe bukti yang lebih kaya, dan connector tambahan—selalu prioritaskan perbaikan yang mengurangi pekerjaan manual tim.

Jika Anda memutuskan membagikan pembelajaran internal secara publik, pertimbangkan menstandarkan catatan build dan template: tim yang menggunakan Koder.ai juga bisa mendapatkan kredit dengan membuat konten tentang alur pengembangan mereka atau merujuk pengguna lain lewat link referral, yang dapat membantu mendanai iterasi berkelanjutan pada tooling internal.

Cakupan otomasi adalah apa yang organisasi Anda putuskan untuk diukur sebagai “pekerjaan yang ditangani otomatis” versus manual. Untuk menghindari kebingungan, pilih unit utama untuk versi pertama (misalnya: proses, requirement/kontrol, suite pengujian, atau runbook) dan tuliskan aturan jelas untuk kasus tepi seperti langkah “setengah otomatis” yang masih memerlukan persetujuan.

Definisi yang baik adalah definisi di mana dua orang akan menilai item yang sama dengan cara yang sama.

Mulailah dengan menulis 5–10 “pertanyaan utama” yang perlu dijawab pengguna Anda, dan jadikan itu sebagai persyaratan produk. Contoh umum:

Audiens berbeda (QA, Ops, kepemimpinan) memerlukan pemotongan data yang berbeda, jadi putuskan kebutuhan siapa yang dioptimalkan oleh versi pertama.

Inventarisasikan di mana bukti otomasi berada dan di mana daftar otoritatif 'seharusnya ada' berada.

Tanpa sistem pencatat, Anda bisa menghitung aktivitas, tetapi tidak bisa menghitung cakupan secara andal (karena Anda tidak tahu semua target yang harus dihitung).

Pilih metode yang paling tahan terhadap gangguan untuk tiap sumber:

Dokumentasikan juga batasan connector (rate limit, autentikasi, jendela retensi) sehingga pengguna memahami kesegaran data dan tingkat kepercayaan.

Pisahkan intent, klaim, dan bukti sehingga metrik tidak terlihat 'hijau' sementara otomasi sudah usang.

Pola praktis:

Gunakan timestamp kesegaran dan aturan bukti.

Field umum:

last_seen_at (asset masih ada)last_run_at, last_failure_atlast_reviewed_at (seseorang mengonfirmasi klaim masih berlaku)Kemudian terapkan aturan seperti “dianggap otomatis hanya jika ada N run sukses dalam 30 hari terakhir.” Ini membedakan antara “ada” dan “berfungsi baru-baru ini.”

Pilih satu metrik headline dan buat aturan pemeringkatan (scoring) yang eksplisit.

Opsi headline umum:

Jaga bobot tetap sederhana (mis. skala 1–5) dan dokumentasikan apa yang dimaksud dengan “otomatis / setengah otomatis / manual” beserta contoh konkrit.

Normalisasi identifier sedini mungkin dan tangani rename secara eksplisit.

Langkah praktis:

service_aliases, repo_aliases) untuk memetakan nama eksternal ke ID kanonik.Ini mencegah duplikasi dan menjaga tren historis tetap utuh saat tim merombak atau mengganti nama repo.

Mulai dengan SSO (OIDC/SAML) jika tersedia, atau sementara gunakan auth proxy internal yang menyuntikkan header identitas. Definisikan set peran kecil dan jaga konsistensi izin di UI dan API:

Simpan bukti sensitif seminimal mungkin: gunakan build ID, timestamp, dan ringkasan singkat daripada menyalin seluruh log. Audit setiap edit manual (siapa/apa/kapan/kenapa) dan tentukan retensi untuk riwayat run.

Buat notifikasi yang dapat ditindaklanjuti dan hindari kebisingan global.

Jenis alert bernilai tinggi:

Biarkan ambang batas berbeda per tim/service (jendela “usang” berbeda, aturan paging berbeda). Sertakan deep link ke halaman drill-down (mis. ) dan dukung acknowledgement/assignment/status sehingga isu bisa ditutup dengan rapi.

Tambahkan kepemilikan (tim/orang) dan identifier yang stabil supaya rename tidak merusak riwayat.

/services/payments?tab=coverage