29 Mar 2025·8 menit

Membangun Aplikasi Web untuk Menjalankan Alur Kerja Moderasi Konten

Pelajari cara merancang dan membangun aplikasi web untuk moderasi konten: antrian, peran, kebijakan, eskalasi, log audit, analitik, dan integrasi aman.

Pelajari cara merancang dan membangun aplikasi web untuk moderasi konten: antrian, peran, kebijakan, eskalasi, log audit, analitik, dan integrasi aman.

Sebelum merancang alur kerja moderasi, putuskan apa yang sebenarnya Anda moderasi dan seperti apa yang dianggap “baik”. Cakupan yang jelas mencegah antrian moderasi terisi dengan kasus pinggiran, duplikat, dan permintaan yang tidak seharusnya ada di sana.

Tuliskan setiap tipe konten yang dapat menimbulkan risiko atau bahaya bagi pengguna. Contoh umum termasuk teks yang dibuat pengguna (komentar, posting, ulasan), gambar, video, livestream, field profil (nama, bio, avatar), pesan langsung, grup komunitas, dan listing pasar (judul, deskripsi, foto, harga).

Catat juga sumber: pengiriman pengguna, impor otomatis, edit pada item yang ada, dan laporan dari pengguna lain. Ini menghindari membangun sistem yang hanya bekerja untuk “posting baru” sementara melewatkan edit, unggahan ulang, atau penyalahgunaan DM.

Kebanyakan tim menyeimbangkan empat tujuan:

Jelaskan secara eksplisit tujuan mana yang menjadi prioritas di tiap area. Misalnya, penyalahgunaan berkeparahan tinggi mungkin memprioritaskan kecepatan dibandingkan konsistensi sempurna.

Daftar seluruh hasil yang produk Anda butuhkan: setujui, tolak/hapus, edit/sensor, beri label/age-gate, batasi visibilitas, tempatkan dalam peninjauan, eskalasikan ke lead, dan tindakan tingkat akun seperti peringatan, penguncian sementara, atau ban.

Tentukan target yang dapat diukur: median dan persentil 95 waktu peninjauan, ukuran backlog, tingkat pembalikan pada banding, akurasi kebijakan dari sampling QA, dan persentase item bernilai tinggi yang ditangani dalam SLA.

Libatkan moderator, team lead, kebijakan, dukungan, engineering, dan legal. Ketidaksinkronan di sini menyebabkan pekerjaan ulang nanti—terutama seputar apa yang dimaksud dengan “eskalasi” dan siapa yang memegang keputusan akhir.

Sebelum Anda membangun layar dan antrian, gambarkan siklus hidup penuh dari satu konten. Alur kerja yang jelas mencegah “status misterius” yang membingungkan reviewer, merusak notifikasi, dan mempersulit audit.

Mulailah dengan model status sederhana end-to-end yang bisa Anda masukkan ke diagram dan ke database:

Submitted → Queued → In review → Decided → Notified → Archived

Jaga agar status saling eksklusif, dan definisikan transisi yang diizinkan (dan oleh siapa). Misalnya: “Queued” hanya bisa berpindah ke “In review” ketika ditugaskan, dan “Decided” harus tak dapat diubah kecuali melalui alur banding.

Klasifier otomatis, pencocokan kata kunci, batas laju, dan laporan pengguna harus diperlakukan sebagai sinyal, bukan keputusan. Desain “manusia-dalam-loop” menjaga sistem tetap jujur:

Pemecahan ini juga memudahkan peningkatan model nanti tanpa menulis ulang logika kebijakan.

Keputusan akan ditantang. Tambahkan alur kelas-satu untuk:

Modelkan banding sebagai event review baru daripada mengedit histori. Dengan begitu Anda bisa menceritakan keseluruhan peristiwa yang terjadi.

Untuk audit dan sengketa, definisikan langkah mana yang harus dicatat dengan cap waktu dan aktor:

Jika Anda tidak bisa menjelaskan keputusan nanti, anggap saja keputusan tersebut tidak pernah terjadi.

Alat moderasi hidup atau mati oleh kontrol akses. Jika semua orang bisa melakukan segala hal, Anda akan mendapatkan keputusan yang tidak konsisten, kebocoran data yang tidak disengaja, dan tidak ada akuntabilitas yang jelas. Mulailah dengan mendefinisikan peran yang sesuai dengan cara tim trust & safety Anda bekerja, lalu terjemahkan ke dalam izin yang dapat ditegakkan aplikasi Anda.

Kebanyakan tim membutuhkan satu set peran yang jelas:

Pemishian ini membantu menghindari “perubahan kebijakan secara tidak sengaja” dan menjaga tata kelola kebijakan terpisah dari penegakan sehari-hari.

Terapkan kontrol akses berbasis peran sehingga tiap peran hanya mendapatkan yang diperlukan:

can_apply_outcome, can_override, can_export_data) daripada berdasarkan halaman.Jika nanti Anda menambahkan fitur baru (ekspor, automasi, integrasi pihak ketiga), Anda bisa melampirkannya ke izin tanpa mendefinisikan ulang struktur organisasi.

Rencanakan untuk beberapa tim lebih awal: language pods, grup berbasis wilayah, atau jalur terpisah untuk produk berbeda. Modelkan tim secara eksplisit, lalu skalakan antrian, visibilitas konten, dan penugasan berdasarkan tim. Ini mencegah kesalahan peninjauan lintas-wilayah dan menjaga beban kerja terukur per kelompok.

Admin kadang perlu meng-impersonate pengguna untuk debug akses atau mereproduksi isu reviewer. Perlakukan impersonasi sebagai tindakan sensitif:

Untuk tindakan yang tidak dapat diubah atau berisiko tinggi, tambahkan persetujuan admin (atau review dua orang). Gesekan kecil ini melindungi dari kesalahan dan penyalahgunaan orang dalam, sambil menjaga moderasi rutin tetap cepat.

Antrian membuat pekerjaan moderasi menjadi terkelola. Alih-alih satu daftar tak berujung, bagi pekerjaan menjadi antrian yang mencerminkan risiko, urgensi, dan niat—lalu buat agar item sulit jatuh dari celah.

Mulai dengan set kecil antrian yang sesuai dengan cara tim Anda bekerja:

Jaga agar antrian saling eksklusif jika memungkinkan (sebuah item sebaiknya punya satu “rumah”), dan gunakan tag untuk atribut sekunder.

Dalam tiap antrian, tentukan aturan scoring yang menentukan apa yang muncul di atas:

Buat prioritas dapat dijelaskan di UI (“Mengapa saya melihat ini?”) agar reviewer mempercayai pengurutan.

Gunakan claiming/locking: ketika seorang reviewer membuka item, itu ditugaskan ke mereka dan disembunyikan dari orang lain. Tambahkan timeout (mis. 10–20 menit) agar item yang ditinggalkan kembali ke antrian. Selalu log event claim, release, dan completion.

Jika sistem memberi penghargaan pada kecepatan, reviewer mungkin memilih kasus cepat dan melewatkan yang sulit. Atasi ini dengan:

Tujuannya adalah cakupan yang konsisten, bukan hanya throughput tinggi.

Kebijakan moderasi yang hanya ada sebagai PDF akan ditafsirkan berbeda oleh setiap reviewer. Untuk membuat keputusan konsisten (dan dapat diaudit), terjemahkan teks kebijakan menjadi data terstruktur dan pilihan UI yang dapat ditegakkan oleh alur kerja Anda.

Mulai dengan memecah kebijakan menjadi kosakata bersama yang bisa dipilih reviewer. Taksonomi yang berguna biasanya mencakup:

Taksonomi ini menjadi dasar untuk antrian, eskalasi, dan analitik nanti.

Daripada meminta reviewer menulis keputusan dari nol setiap kali, sediakan template keputusan yang terikat ke item taksonomi. Template bisa mengisi otomatis:

Template membuat “happy path” cepat, sambil tetap memungkinkan pengecualian.

Kebijakan berubah. Simpan kebijakan sebagai catatan berversion dengan tanggal berlaku, dan catat versi mana yang diterapkan untuk tiap keputusan. Ini mencegah kebingungan ketika kasus lama diajukan banding dan memastikan Anda bisa menjelaskan hasil beberapa bulan kemudian.

Teks bebas sulit dianalisis dan mudah terlupakan. Wajibkan reviewer memilih satu atau lebih alasan terstruktur (dari taksonomi Anda) dan opsional menambah catatan. Alasan terstruktur meningkatkan penanganan banding, sampling QA, dan pelaporan tren tanpa memaksa reviewer menulis esai.

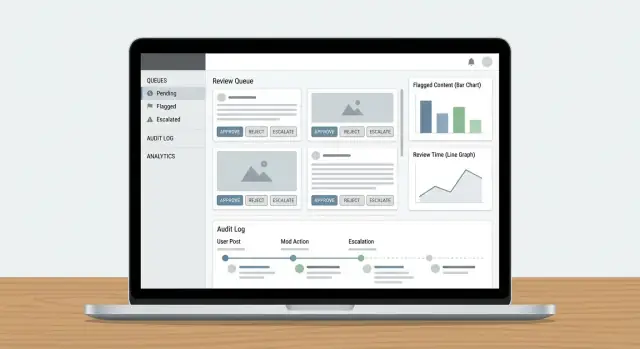

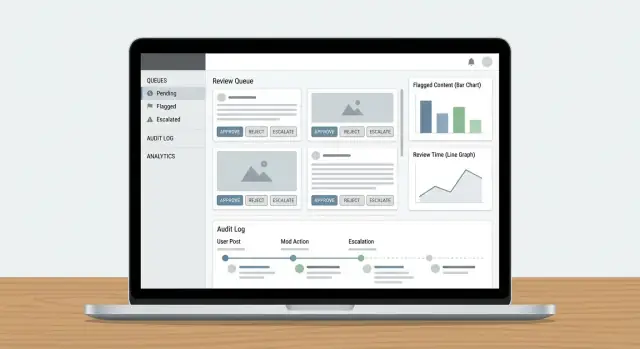

Dasbor reviewer berhasil ketika meminimalkan “mencari” informasi dan memaksimalkan keputusan yang percaya diri dan dapat diulang. Reviewer harus bisa memahami apa yang terjadi, mengapa penting, dan apa yang harus dilakukan selanjutnya—tanpa membuka lima tab.

Jangan tampilkan posting terisolasi dan harapkan hasil yang konsisten. Sajikan panel konteks kompak yang menjawab pertanyaan umum sekilas:

Jaga tampilan default ringkas, dengan opsi perluas untuk pemeriksaan lebih dalam. Reviewer sebaiknya jarang perlu meninggalkan dasbor untuk memutuskan.

Bar tindakan Anda harus sesuai dengan hasil kebijakan, bukan tombol CRUD generik. Pola umum meliputi:

Buat tindakan terlihat dan langkah irreversible dibuat eksplisit (konfirmasi hanya bila diperlukan). Tangkap kode alasan singkat plus catatan opsional untuk audit nanti.

Pekerjaan volume tinggi menuntut gesekan rendah. Tambahkan shortcut keyboard untuk tindakan utama (approve, reject, next item, add label). Tampilkan cheat-sheet shortcut di dalam UI.

Untuk antrian dengan pekerjaan repetitif (mis. spam jelas), dukung pilihan massal dengan pengaman: tampilkan jumlah preview, minta kode alasan, dan log aksi batch.

Moderasi dapat mengekspos orang ke materi berbahaya. Tambahkan default keselamatan:

Pilihan ini melindungi reviewer sambil menjaga keputusan tetap akurat dan konsisten.

Log audit adalah “sumber kebenaran” ketika seseorang bertanya: Mengapa posting ini dihapus? Siapa yang menyetujui banding? Model atau manusia siapa yang membuat keputusan akhir? Tanpa keterlacakan, investigasi berubah menjadi tebak-tebakan, dan kepercayaan reviewer cepat turun.

Untuk setiap tindakan moderasi, log siapa yang melakukannya, apa yang berubah, kapan itu terjadi, dan mengapa (kode kebijakan + catatan teks). Sama pentingnya: simpan snapshot before/after dari objek relevan—teks konten, hash media, sinyal terdeteksi, label, dan hasil akhir. Jika item bisa berubah (edit, hapus), snapshot mencegah “rekaman” bergeser.

Pola praktis adalah catatan event append-only:

{

"event": "DECISION_APPLIED",

"actor_id": "u_4821",

"subject_id": "post_99102",

"queue": "hate_speech",

"decision": "remove",

"policy_code": "HS.2",

"reason": "slur used as insult",

"before": {"status": "pending"},

"after": {"status": "removed"},

"created_at": "2025-12-26T10:14:22Z"

}

Di luar keputusan, log mekanik workflow: claimed, released, timed out, reassigned, escalated, dan auto-routed. Event ini menjelaskan “mengapa butuh 6 jam” atau “mengapa item ini bolak-balik antar tim,” dan penting untuk mendeteksi penyalahgunaan (mis. reviewer memilih kasus mudah).

Berikan filter untuk investigator berdasarkan pengguna, ID konten, kode kebijakan, rentang waktu, antrian, dan tipe aksi. Sertakan ekspor ke file kasus, dengan cap waktu yang immutable dan referensi ke item terkait (duplikat, unggahan ulang, banding).

Tetapkan jendela retensi jelas untuk event audit, snapshot, dan catatan reviewer. Tuliskan kebijakan eksplisit (mis. 90 hari untuk log antrian rutin, lebih lama untuk legal hold), dan dokumentasikan bagaimana redaksi atau permintaan penghapusan memengaruhi bukti yang disimpan.

Alat moderasi hanya berguna jika menutup lingkaran: laporan menjadi tugas peninjauan, keputusan mencapai pihak yang tepat, dan tindakan tingkat pengguna dieksekusi konsisten. Di sini banyak sistem gagal—seseorang menyelesaikan antrian, tapi tidak ada perubahan lain yang terjadi.

Perlakukan laporan pengguna, flag otomatis (spam/CSAM/pencocokan hash/sinyal toksisitas), dan eskalasi internal (dukungan, community manager, legal) sebagai objek inti yang sama: sebuah report yang dapat memicu satu atau lebih tugas peninjauan.

Gunakan router report tunggal yang:

Jika eskalasi dari dukungan adalah bagian alur, tautkan langsung (mis. /support/tickets/1234) agar reviewer tidak perlu pindah konteks.

Keputusan moderasi harus menghasilkan notifikasi template: konten dihapus, peringatan dikeluarkan, tidak ada tindakan, atau tindakan akun diberlakukan. Jaga pesan konsisten dan minimal—jelaskan hasil, referensikan kebijakan terkait, dan berikan instruksi banding.

Secara operasional, kirim notifikasi melalui event seperti moderation.decision.finalized, sehingga email/in-app/push bisa berlangganan tanpa memperlambat reviewer.

Keputusan sering memerlukan tindakan di luar satu konten:

Jadikan tindakan ini eksplisit dan dapat dibalik, dengan durasi dan alasan yang jelas. Tautkan setiap tindakan kembali ke keputusan dan report dasar untuk keterlacakan, dan sediakan jalur cepat ke Banding sehingga keputusan dapat ditinjau ulang tanpa pekerjaan detektif manual.

Model data Anda adalah “sumber kebenaran” untuk apa yang terjadi pada tiap item: apa yang diperiksa, oleh siapa, di bawah kebijakan mana, dan apa hasilnya. Jika Anda mengatur lapisan ini dengan benar, semuanya—antrian, dasbor, audit, dan analitik—menjadi lebih mudah.

Hindari menyimpan semuanya di satu catatan. Pola praktis adalah menyimpan:

HARASSMENT.H1 atau NUDITY.N3, disimpan sebagai referensi sehingga kebijakan bisa berevolusi tanpa menulis ulang histori.Ini menjaga penegakan kebijakan konsisten dan membuat pelaporan lebih jelas (mis. “kode kebijakan yang paling sering dilanggar minggu ini”).

Jangan masukkan gambar/video besar langsung ke database. Gunakan object storage dan simpan hanya kunci objek + metadata pada tabel konten.

Untuk reviewer, buat signed URL berumur pendek sehingga media dapat diakses tanpa dibuat publik. Signed URL juga memungkinkan kontrol kadaluarsa dan pencabutan akses bila perlu.

Antrian dan investigasi bergantung pada lookup cepat. Tambahkan index untuk:

Modelkan moderasi sebagai status eksplisit (mis. NEW → TRIAGED → IN_REVIEW → DECIDED → APPEALED). Simpan event transisi status (dengan cap waktu dan aktor) sehingga Anda dapat mendeteksi item yang tidak bergerak.

Sebuah pengaman sederhana: field last_state_change_at plus alert untuk item yang melewati SLA, dan job perbaikan yang mengembalikan item IN_REVIEW setelah timeout.

Alat Trust & Safety sering menangani data paling sensitif produk Anda: konten yang dibuat pengguna, laporan, identifier akun, dan kadang permintaan hukum. Perlakukan aplikasi moderasi sebagai sistem berisiko tinggi dan desain keamanan serta privasi sejak hari pertama.

Mulailah dengan autentikasi kuat dan kontrol sesi ketat. Untuk kebanyakan tim, itu berarti:

Padukan ini dengan RBAC sehingga reviewer hanya melihat yang diperlukan (mis. satu antrian, satu wilayah, atau satu tipe konten).

Enkripsi data in transit (HTTPS) dan at rest (enkripsi terkelola). Lalu fokus pada minimisasi eksposur:

Jika Anda menangani data sensitif atau kategori khusus, buat flag terlihat oleh reviewer dan terapkan di UI (mis. tampilan terbatas atau aturan retensi khusus).

Endpoint laporan dan banding sering menjadi target spam dan pelecehan. Tambahkan:

Akhirnya, buat setiap tindakan sensitif dapat ditelusuri dengan jejak audit (lihat /blog/audit-logs) sehingga Anda dapat menyelidiki kesalahan reviewer, akun terkompromi, atau penyalahgunaan terkoordinasi.

Alur moderasi hanya meningkat jika Anda bisa mengukurnya. Analitik harus memberi tahu apakah desain antrian, aturan eskalasi, dan penegakan kebijakan menghasilkan keputusan konsisten—tanpa membakar reviewer atau membiarkan konten berbahaya menunggu terlalu lama.

Mulai dengan set kecil metrik yang terkait hasil:

Masukkan ini ke dasbor SLA sehingga ops lead bisa melihat antrian mana tertinggal dan apakah hambatannya staf, aturan yang tidak jelas, atau lonjakan laporan.

Ketidaksepakatan tidak selalu buruk—itu bisa menunjukkan kasus pinggiran. Lacak:

Gunakan log audit untuk menghubungkan setiap keputusan sampel ke reviewer, aturan yang diterapkan, dan bukti. Ini memberi Anda explainability saat coaching reviewer dan saat menilai apakah UI dasbor mendorong orang ke pilihan yang tidak konsisten.

Analitik moderasi harus membantu menjawab: “Apa yang kita lihat yang kebijakan kita tidak tutupi dengan baik?” Cari klaster seperti:

Ubah sinyal ini menjadi tindakan konkret: tulis ulang contoh kebijakan, tambahkan pohon keputusan di dasbor reviewer, atau perbarui preset penegakan (mis. timeout default vs peringatan).

Perlakukan analitik sebagai bagian dari sistem manusia-dalam-loop. Bagikan performa tingkat antrian secara publik di dalam tim, tetapi tangani metrik individu dengan hati-hati agar tidak mendorong kecepatan di atas kualitas. Pasangkan KPI kuantitatif dengan sesi kalibrasi reguler dan pembaruan kebijakan kecil yang sering—sehingga tooling dan orang berkembang bersama.

Alat moderasi paling sering gagal di tepi: posting aneh, jalur eskalasi langka, dan momen ketika beberapa orang menyentuh kasus yang sama. Perlakukan pengujian dan rollout sebagai bagian produk, bukan checklist akhir.

Buat "paket skenario" kecil yang mencerminkan pekerjaan nyata. Sertakan:

Gunakan volume data mirip produksi di lingkungan staging sehingga Anda bisa menemukan perlambatan antrian dan masalah pagination/search lebih awal.

Pola rollout yang lebih aman adalah:

Shadow mode berguna untuk memvalidasi aturan penegakan dan otomasi tanpa risiko false positive.

Tulis playbook singkat berbasis tugas: “Bagaimana memproses laporan,” “Kapan eskalasikan,” “Bagaimana menangani banding,” dan “Apa yang dilakukan ketika sistem tidak pasti.” Kemudian latih dengan paket skenario yang sama agar reviewer mempraktikkan alur yang akan mereka gunakan.

Rencanakan pemeliharaan sebagai pekerjaan berkelanjutan: tipe konten baru, aturan eskalasi yang diperbarui, sampling periodik untuk QA, dan perencanaan kapasitas saat antrian melonjak. Miliki proses rilis jelas untuk pembaruan kebijakan sehingga reviewer bisa melihat apa yang berubah dan kapan—dan Anda bisa mengkorelasikan perubahan dengan analitik moderasi.

Jika Anda mengimplementasikan ini sebagai aplikasi web, sebagian besar upaya adalah scaffolding yang repetitif: RBAC, antrian, transisi status, log audit, dasbor, dan glue event-driven antara keputusan dan notifikasi. Koder.ai dapat mempercepat pembangunan itu dengan membiarkan Anda mendeskripsikan alur kerja moderasi di antarmuka chat dan menghasilkan fondasi kerja yang bisa Anda iterasi—biasanya dengan frontend React dan backend Go + PostgreSQL.

Dua cara praktis menggunakannya untuk tooling trust & safety:

Setelah baseline ada, Anda bisa mengekspor kode sumber, menghubungkan sinyal model yang ada sebagai “input”, dan menjaga keputusan reviewer sebagai otoritas terakhir—sesuai arsitektur manusia-dalam-loop yang dijelaskan di atas.

Mulailah dengan mencantumkan setiap tipe konten yang akan Anda tangani (postingan, komentar, DM, profil, listing, media), ditambah setiap sumber (pengiriman baru, edit, impor, laporan pengguna, flag otomatis). Kemudian tentukan apa yang di luar cakupan (mis. catatan admin internal, konten yang dihasilkan sistem) sehingga antrian Anda tidak menjadi tempat pembuangan.

Pengecekan praktis: jika Anda tidak bisa menyebut tipe konten, sumber, dan tim penanggung jawab, kemungkinan besar itu belum layak menjadi tugas moderasi.

Pilih satu set KPI operasional kecil yang mencerminkan kecepatan dan kualitas:

Tetapkan target per antrian (mis. high-risk vs backlog) agar Anda tidak sengaja mengoptimalkan pekerjaan berprioritas rendah sementara konten berbahaya menunggu.

Gunakan model status yang sederhana dan eksplisit, lalu paksa transisi yang diizinkan, misalnya:

SUBMITTED → QUEUED → IN_REVIEW → DECIDED → NOTIFIED → ARCHIVEDBuat status mutually exclusive, dan perlakukan “Decided” sebagai tidak dapat diubah kecuali melalui alur banding/re-review. Ini mencegah “status misterius”, notifikasi rusak, dan edit yang sulit diaudit.

Anggap sistem otomatis sebagai sinyal, bukan keputusan akhir:

Pendekatan ini menjaga penegakan kebijakan tetap dapat dijelaskan dan mempermudah peningkatan model nanti tanpa menulis ulang logika kebijakan.

Bangun banding sebagai objek kelas satu yang terhubung ke keputusan asli:

Mulai dengan set RBAC kecil dan jelas:

Gunakan multi-antrian dengan kepemilikan “home” yang jelas:

Prioritaskan di dalam antrian menggunakan sinyal yang dapat dijelaskan seperti severity, reach, unique reporters, dan SLA timers. Di UI, tampilkan “” agar reviewer percaya urutan dan Anda bisa mendeteksi permainan sistem.

Implementasikan claiming/locking dengan timeout:

Ini mengurangi usaha ganda dan memberi data untuk mendiagnosis kemacetan atau perilaku cherry-picking.

Ubah kebijakan Anda menjadi taksonomi terstruktur dan template:

Ini meningkatkan konsistensi, membuat analitik bermakna, dan menyederhanakan audit serta banding.

Log semua yang diperlukan untuk merekonstruksi cerita:

Buat log dapat dicari berdasarkan actor, content ID, policy code, queue, dan rentang waktu, serta definisikan aturan retensi (termasuk legal holds dan bagaimana permintaan penghapusan memengaruhi bukti yang disimpan).

Selalu catat versi kebijakan yang diterapkan awalnya dan versi yang diterapkan saat banding.

Lalu tambahkan izin least-privilege berdasarkan kapabilitas (mis. can_export_data, can_apply_account_penalty) sehingga fitur baru tidak merusak model akses Anda.