Apa yang Harus Diselesaikan Pelaporan SLA Terpusat

Pelaporan SLA terpusat dibuat karena bukti SLA jarang berada di satu tempat. Uptime mungkin ada di alat monitoring, insiden di status page, tiket di helpdesk, dan catatan eskalasi di email atau chat. Ketika setiap klien memiliki tumpukan yang sedikit berbeda (atau konvensi penamaan berbeda), pelaporan bulanan berubah menjadi pekerjaan spreadsheet manual — dan perselisihan tentang “apa yang sebenarnya terjadi” menjadi umum.

Siapa yang menggunakannya (dan apa yang mereka butuhkan)

Aplikasi pelaporan SLA yang baik melayani beberapa audiens dengan tujuan berbeda:

- Account manager membutuhkan ringkasan siap-klien yang cepat dan dapat dipercaya, serta export untuk QBR.

- Support lead dan pemilik layanan membutuhkan drill-down untuk memvalidasi perhitungan dan menemukan akar penyebab.

- Pemangku kepentingan klien membutuhkan metrik yang jelas dan dapat dibaca dengan definisi yang tidak ambigu — dan cara mengaudit insiden dan tiket yang disertakan.

Aplikasi harus menampilkan kebenaran dasar yang sama pada level detail berbeda, tergantung peran.

Hasil inti yang perlu dicapai

Dashboard SLA terpusat harus memberikan:

- Satu sumber kebenaran untuk metrik SLA, insiden, dan bukti pendukung.

- Pelaporan lebih cepat (menit, bukan hari) melalui perhitungan konsisten dan template yang dapat dipakai ulang.

- Lebih sedikit perselisihan dengan menunjukkan secara tepat bagaimana tiap metrik dihitung dan event mana yang berkontribusi.

Dalam praktiknya, setiap angka SLA harus dapat ditelusuri ke event mentah (alert, tiket, garis waktu insiden) dengan timestamp dan kepemilikan.

Tetapkan batasan: apa yang dihitung sebagai “SLA” di sini

Sebelum membangun apa pun, definisikan apa yang in scope dan out of scope. Contoh:

- Apakah “availability” mengecualikan pemeliharaan terjadwal?

- Apakah outage pihak ketiga dihitung atau dilaporkan terpisah?

- Jam resmi mana yang dipakai: waktu lokal klien, UTC, atau zona waktu kontrak?

Batasan yang jelas mencegah debat di kemudian hari dan menjaga konsistensi pelaporan antar klien.

Alur kerja utama yang harus didukung aplikasi

Minimal, pelaporan SLA terpusat harus mendukung lima alur kerja:

- Lihat performa SLA klien untuk periode yang dipilih.

- Filter berdasarkan klien, layanan, wilayah, kontrak, atau tingkat keparahan.

- Ekspor (PDF/CSV) untuk dibagikan dan diarsipkan.

- Jadwalkan laporan otomatis ke pemangku kepentingan.

- Audit setiap metrik hingga ke event dan aturan di baliknya.

Rancang di sekitar alur-alur ini dari hari pertama agar sisa sistem (model data, integrasi, dan UX) selaras dengan kebutuhan pelaporan nyata.

Definisikan Metrik SLA, Aturan, dan Periode Pelaporan

Sebelum membuat layar atau pipeline, tentukan apa yang akan diukur aplikasi Anda dan bagaimana angka-angka itu harus diinterpretasikan. Tujuannya adalah konsistensi: dua orang yang membaca laporan yang sama harus sampai pada kesimpulan yang sama.

Pilih metrik SLA yang akan didukung

Mulailah dengan kumpulan kecil yang banyak klien kenal:

- Uptime / availability (mis. 99,9% per bulan)

- Response time (waktu sampai balasan manusia pertama, atau pembaruan bermakna pertama)

- Resolution time (waktu sampai masalah diselesaikan dan dikonfirmasi)

Jelaskan secara eksplisit apa yang diukur setiap metrik dan apa yang tidak. Panel definisi singkat di UI (dan link ke /help/sla-definitions) mencegah kesalahpahaman.

Tulis aturan perhitungan dengan bahasa biasa

Aturan adalah tempat pelaporan SLA biasanya rusak. Dokumentasikan aturan dalam kalimat yang bisa divalidasi klien, lalu terjemahkan ke logika.

Cakup hal-hal penting:

- Jam kerja vs 24/7: kalender mana yang berlaku untuk tiap layanan/klien?

- Hari libur: kalender wilayah mana yang dipakai, dan bagaimana dipelihara?

- Pengecualian: pemeliharaan terjadwal, keterlambatan akibat klien, menunggu pelanggan, outage pihak ketiga

- Event mulai/berhenti: timestamp apa yang memulai jam; event apa yang menghentikannya

Tentukan periode pelaporan dan ambang pelanggaran

Pilih periode default (bulanan dan kuartalan umum) dan apakah Anda akan mendukung rentang kustom. Jelaskan zona waktu yang dipakai untuk cutoff.

Untuk pelanggaran, tentukan:

- Ambang per layanan (mis. target uptime berbeda per tier)

- Override per klien (kontrak khusus)

- Apakah pelanggaran dipicu oleh insiden tunggal, hasil agregat, atau keduanya

Dokumentasikan sumber data per metrik

Untuk setiap metrik, daftar input yang dibutuhkan (event monitoring, catatan insiden, timestamp tiket, jendela pemeliharaan). Ini jadi blueprint untuk integrasi dan pemeriksaan kualitas data.

Sebelum mendesain dashboard atau KPI, jelaskan dari mana bukti SLA sebenarnya berasal. Kebanyakan tim menemukan “data SLA” terpisah di banyak alat, dimiliki oleh kelompok berbeda, dan dicatat dengan sedikit perbedaan makna.

Sistem sumber umum yang harus diinventarisasi

Mulailah dengan daftar sederhana per klien (dan per layanan):

- Monitoring/observability (cek ping, synthetic monitor, APM): sinyal uptime dan timestamp

- Manajemen insiden (setara PagerDuty/Opsgenie): lifecycle insiden, tingkat keparahan, acknowledgements

- Ticketing/helpdesk (Jira Service Management, Zendesk, ServiceNow): waktu respons/resolve, field dampak pelanggan

- Status pages (publik atau internal): insiden yang diumumkan dan jendela pemeliharaan terjadwal

- Log cloud/provider (opsional): health load balancer, jejak audit untuk outage

Untuk tiap sistem, catat pemiliknya, periode retensi, limit API, resolusi waktu (detik vs menit), dan apakah data bersifat skop-klien atau dibagi bersama.

Pilih metode integrasi (dan kombinasikan)

Sebagian besar aplikasi pelaporan SLA menggunakan kombinasi:

- API pulls untuk backfill historis dan rekonsiliasi malam hari

- Webhooks/event streams untuk pembaruan near-real-time dan deteksi pelanggaran lebih cepat

- Impor CSV untuk klien kecil, alat legacy, atau migrasi sekali

Aturan praktis: gunakan webhooks ketika freshness penting, dan API pulls ketika kelengkapan penting.

Alat berbeda mendeskripsikan hal yang sama dengan cara berbeda. Normalisasikan ke sekumpulan kecil event yang dapat diandalkan aplikasi, seperti:

incident_opened / incident_closeddowntime_started / downtime_endedticket_created / first_response / resolved

Sertakan field konsisten: client_id, service_id, source_system, external_id, severity, dan timestamps.

Zona waktu dan cakupan yang hilang

Simpan semua timestamp dalam UTC, dan konversi saat ditampilkan berdasarkan zona waktu favorit klien (terutama untuk cutoff pelaporan bulanan).

Rencanakan juga untuk gap: beberapa klien tidak punya status page, beberapa layanan tidak dimonitor 24/7, dan beberapa alat bisa kehilangan event. Tampilkan “cakupan parsial” di laporan (mis. “data monitoring tidak tersedia selama 3 jam”) supaya hasil SLA tidak menyesatkan.

Rancang Arsitektur Multi-Klien dan Multi-Tenant

Jika aplikasi Anda melaporkan SLA untuk banyak pelanggan, keputusan arsitektur menentukan apakah Anda bisa skala aman tanpa kebocoran data antar-klien.

Definisikan apa arti “klien” di sistem Anda

Mulailah dengan menamai lapisan yang perlu Anda dukung. “Klien” bisa berarti:

- Tenant (perusahaan/akun): batas utama pelanggan

- Sub-akun: departemen atau merek di bawah satu tenant

- Lingkungan: prod/stage/region

- Layanan: API, web app, database, antrean support

Tulis ini sejak awal, karena memengaruhi permission, filter, dan cara Anda menyimpan konfigurasi.

Pilih model multi-tenancy

Sebagian besar aplikasi pelaporan SLA memilih salah satu:

- Database bersama + tenant IDs: satu set tabel, setiap baris diberi tag

tenant_id. Hemat biaya dan lebih mudah dioperasikan, tapi membutuhkan disiplin query ketat.

- Database terpisah per tenant: isolasi lebih kuat dan lebih mudah kebijakan retensi per-tenant, tapi overhead operasional lebih tinggi (migrasi, monitoring, backup) dan menyulitkan view admin lintas-tenant.

Kompromi umum adalah DB bersama untuk sebagian besar tenant dan DB terdedikasi untuk pelanggan “enterprise”.

Terapkan isolasi data ketat di semua tempat

Isolasi harus berlaku pada:

- Query dan dashboard: selalu scope dengan tenant, bukan hanya filter UI

- Export dan email terjadwal: pastikan job export berjalan dengan konteks tenant

- Background jobs: retry dan antrian harus membawa

tenant_id supaya hasil tidak tertulis ke tenant yang salah

Gunakan guardrail seperti row-level security, scope query wajib, dan tes otomatis untuk batas tenant.

Dukung konfigurasi SLA spesifik-klien

Klien berbeda akan punya target dan definisi berbeda. Rencanakan setting per-tenant seperti:

- Target SLA (mis. 99.9% uptime, respon 1 jam)

- Layanan dan endpoint yang disertakan

- Jam kerja, hari libur, dan zona waktu

- Pemetaan tingkat keparahan dan aturan pengecualian (jendela pemeliharaan)

Safe client switching untuk pengguna internal

Pengguna internal sering perlu “impersonate” tampilan klien. Implementasikan pergantian yang disengaja (bukan filter bebas), tampilkan tenant aktif dengan jelas, log pergantian untuk audit, dan cegah link yang bisa melewati pengecekan tenant.

Bangun Model Data untuk Event Mentah dan Hasil SLA

Aplikasi pelaporan SLA terpusat hidup atau mati pada model datanya. Jika Anda hanya memodelkan “% SLA per bulan”, Anda akan kesulitan menjelaskan hasil, menangani perselisihan, atau memperbarui perhitungan nanti. Jika hanya memodelkan event mentah, pelaporan jadi lambat dan mahal. Tujuannya: dukung keduanya: bukti mentah yang dapat ditelusuri dan rollup cepat siap-klien.

Entitas inti yang perlu dimodelkan

Jaga pemisahan bersih antara siapa yang dilaporkan, apa yang diukur, dan bagaimana ia dihitung:

- Client: organisasi yang menerima laporan.

- Service: sistem atau komponen (API, web app, antrean support).

- SLA definition: aturan seperti target uptime, target response time, jam kerja, pengecualian, dan metode pengukuran.

- Incident / ticket: catatan yang dilacak manusia (dari alat ITSM) yang menjelaskan downtime atau keterlambatan respons.

- Measurement / event: event mesin (cek monitoring, perubahan status, sinyal dari log).

Simpan event mentah dan hasil terhitung

Rancang tabel (atau koleksi) untuk:

- Raw events: record immutable dari sistem sumber (alert monitoring, insiden status page, transisi status tiket). Simpan ID asli dan snapshot payload bila memungkinkan.

- Normalized facts: representasi standar Anda (mis. “service_down started_at/ended_at”).

- SLA results: output terhitung pada granularitas berbeda—per insiden, harian, mingguan, bulanan.

- Rollups: pra-agregat harian/bulanan untuk membuat dashboard cepat (mis. menit downtime, menit valid, menit yang dikecualikan).

Versi perhitungan

Logika SLA berubah: jam kerja diperbarui, pengecualian diklarifikasi, aturan pembulatan berkembang. Tambahkan calculation_version (dan idealnya referensi “rule set”) ke setiap hasil terhitung. Dengan begitu laporan lama bisa direproduksi persis meskipun aturan diperbarui.

Tambah field audit untuk kepercayaan dan pemecahan masalah

Masukkan field audit di tempat yang penting:

- source_system, source_record_id, dan import_job_id

- timestamp seperti ingested_at, normalized_at, calculated_at

- created_by/updated_by untuk edit manual (dengan change log untuk override manual)

Bukti dan lampiran

Klien sering meminta “tunjukkan alasannya”. Rencanakan skema untuk bukti:

- link ke postmortem, status page, atau thread tiket

- metadata lampiran file (nama, tipe, storage key)

- memetakan bukti ke insiden tertentu dan periode SLA

Struktur ini menjaga aplikasi dapat dijelaskan, dapat direproduksi, dan cepat — tanpa kehilangan bukti dasar.

Buat Pipeline Data yang Andal dan Lapisan Normalisasi

Luncurkan pilot dengan cepat

Rilis versi yang berfungsi untuk klien pilot, lalu iterasi dengan percaya diri.

Jika input Anda berantakan, dashboard SLA Anda juga akan berantakan. Pipeline yang andal mengubah data insiden dan tiket dari banyak alat menjadi hasil SLA yang konsisten dan dapat diaudit — tanpa double-counting, gap, atau kegagalan diam-diam.

Pisahkan pipeline menjadi tahap yang jelas

Perlakukan ingestion, normalisasi, dan rollup sebagai tahap terpisah. Jalankan sebagai background job agar UI tetap cepat dan Anda bisa retry dengan aman.

- Ingestion jobs menarik raw events (tiket, insiden, perubahan status) dan menyimpannya tanpa perubahan.

- Normalization jobs menstandarkan field dan memetakan ke kosakata siap-SLA Anda.

- Rollup jobs menghitung metrik harian/mingguan/bulanan dan cache hasil untuk dashboard dan export.

Pemisahan ini juga membantu ketika sumber salah satu klien down: ingestion bisa gagal tanpa merusak perhitungan yang sudah ada.

Buat retry aman dengan idempotensi

API eksternal bisa time out. Webhook bisa dikirim dua kali. Pipeline harus idempoten: memproses input yang sama lebih dari sekali tidak boleh mengubah hasil.

Pendekatan umum:

- Gunakan source event ID (atau hash field kunci) sebagai kunci unik.

- Simpan processing ledger (event_id + client + source + timestamp) untuk mendeteksi duplikat.

- Rancang rollup agar bisa dibangun ulang untuk jendela waktu (mis. “recompute last 14 days”) daripada menambah counter secara membabi-buta.

Normalisasikan nama sehingga metrik berarti sama

Di antara klien dan alat, “P1,” “Critical,” dan “Urgent” mungkin semua berarti sama — atau tidak. Bangun lapisan normalisasi yang menstandarkan:

- Nama layanan (mis. “Payments API” vs “Payments”)

- Prioritas / severity

- Status tiket (mis. “Resolved” vs “Done” vs “Closed”)

Simpan nilai asli dan nilai yang dinormalisasi untuk ketertelusuran.

Tambahkan aturan validasi (timestamp hilang, durasi negatif, transisi status yang tidak mungkin). Jangan buang data buruk secara diam-diam — arahkan ke antrian karantina dengan alasan dan workflow “perbaiki atau peta”.

Tampilkan indikator kesegaran data

Untuk tiap klien dan sumber, hitung “last successful sync”, “oldest unprocessed event”, dan “rollup up-to date through.” Tampilkan ini sebagai indikator kesegaran data sederhana supaya klien percaya angkanya dan tim Anda cepat menemukan masalah.

Otentikasi, Peran, dan Kontrol Akses

Jika klien menggunakan portal Anda untuk meninjau performa SLA, otentikasi dan permission perlu dirancang sebaik matematika SLA. Tujuannya sederhana: setiap pengguna hanya melihat apa yang seharusnya — dan Anda bisa membuktikannya nanti.

Peran yang mencerminkan alur kerja nyata

Mulailah dengan set peran kecil dan jelas, dan perluas hanya bila perlu:

- Admin: mengelola tenant/klien, integrasi, pengguna, dan pengaturan global.

- Internal analyst: melihat semua data klien, menyelidiki insiden, membuat laporan, tapi tidak mengubah pengaturan keamanan.

- Client viewer: akses read-only ke dashboard dan export mereka sendiri.

- Client editor: dapat mengelola pengguna organisasi mereka, preferensi notifikasi, dan (opsional) template laporan.

Jaga prinsip least privilege: akun baru harus default ke viewer kecuali dinaikkan secara eksplisit.

SSO dulu, password kedua

Untuk tim internal, SSO mengurangi akun tersebar dan risiko offboarding. Dukung OIDC (umum untuk Google Workspace/Azure AD/Okta) dan, bila perlu, SAML.

Untuk klien, tawarkan SSO sebagai opsi upgrade, tapi tetap izinkan email/password dengan MFA untuk organisasi yang lebih kecil.

Isolasi per-klien dan kontrol granular

Terapkan batas tenant di semua lapisan:

- Setiap query dan export harus di-scope ke client ID.

- Tambahkan permission project/service-level jika klien punya unit bisnis terpisah.

- Batasi akses ke artefak sensitif (tiket mentah, catatan, lampiran) secara terpisah dari ringkasan SLA.

Audit log dan onboarding aman

Log akses ke halaman sensitif dan unduhan: siapa mengakses apa, kapan, dan dari mana. Ini membantu kepatuhan dan kepercayaan klien.

Bangun alur onboarding di mana admin atau editor klien bisa mengundang pengguna, menetapkan peran, mewajibkan verifikasi email, dan mencabut akses seketika saat seseorang keluar.

UX Dashboard: Filter, Drill-Down, dan Definisi Jelas

Iterasi tanpa takut

Gunakan snapshot dan rollback saat aturan atau perhitungan SLA berubah di tengah iterasi.

Dashboard SLA terpusat berhasil ketika klien dapat menjawab tiga pertanyaan dalam kurang dari satu menit: Apakah kita memenuhi SLA? Apa yang berubah? Apa penyebab kegagalan? UX Anda harus mengarahkan mereka dari tampilan tingkat tinggi ke bukti — tanpa memaksa mereka mempelajari model data internal Anda.

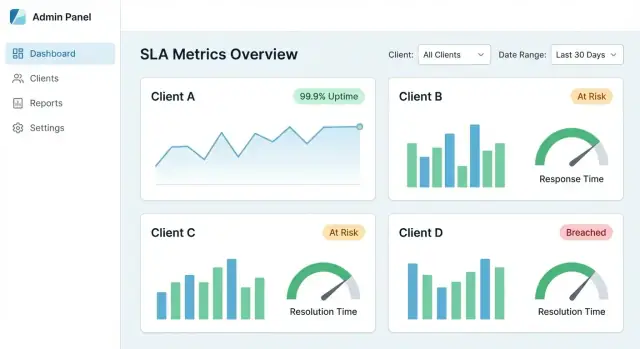

"Tampilan utama" yang membangun kepercayaan

Mulailah dengan sekumpulan kartu dan grafik kecil yang cocok untuk percakapan SLA umum:

- Kepatuhan SLA (%) untuk periode yang dipilih (sekarang vs sebelumnya)

- Garis tren (harian/mingguan) untuk menunjukkan perbaikan atau drift

- Top breaches yang diurutkan berdasarkan dampak (menit di atas SLO, penalti, atau pengguna terdampak)

Buat setiap kartu bisa diklik sehingga menjadi pintu ke detail, bukan dead end.

Filter yang terasa dapat diprediksi

Filter harus konsisten di semua halaman dan “menempel” saat pengguna bernavigasi.

Default yang disarankan:

- Client → Service → Environment (prod/stage)

- Rentang tanggal dengan pilihan cepat (7/30/90 hari terakhir, Bulan ini)

- Severity / priority (berguna saat mencampur insiden dan tiket)

Tampilkan chip filter aktif di atas sehingga pengguna selalu mengerti apa yang sedang mereka lihat.

Drill-down dari ringkasan ke bukti

Setiap metrik harus punya jalur menuju “kenapa”. Alur drill-down yang kuat:

- Grafik kepatuhan → klik titik rendah

- Daftar insiden/tiket yang berkontribusi untuk slice itu

- Halaman detail yang menunjukkan timestamp, perubahan status, link ke record sumber, dan catatan

Jika sebuah angka tidak bisa dijelaskan dengan bukti, angka itu akan diperdebatkan — terutama selama QBR.

Definisi yang jelas (tanpa ambiguitas)

Tambahkan tooltip atau panel “info” untuk setiap KPI: bagaimana cara menghitungnya, pengecualian, zona waktu, dan kesegaran data. Sertakan contoh seperti “Jendela pemeliharaan dikecualikan” atau “Uptime diukur di gateway API.”

Tampilan yang bisa dibagikan dengan link stabil

Buat view yang difilter bisa dibagikan lewat URL stabil (mis. /reports/sla?client=acme&service=api&range=30d). Ini menjadikan dashboard SLA terpusat Anda portal siap-klien yang mendukung check-in berulang dan jejak audit.

Laporan Otomatis, Ekspor, dan Ringkasan Siap-Klien

Dashboard SLA terpusat berguna sehari-hari, tapi klien sering menginginkan sesuatu yang bisa mereka teruskan: PDF untuk pimpinan, CSV untuk analis, dan link yang bisa mereka bookmark.

Dukung tiga output dari hasil SLA yang sama:

- PDF: ringkasan bersih dan bermerek untuk pemangku kepentingan

- CSV: data tingkat baris (per layanan, wilayah, atau kontrak) untuk analisis lebih dalam

- Live link reports: URL aman ke tampilan yang sama di portal Anda, selalu mutakhir

Untuk laporan berbasis link, buat filter eksplisit (rentang tanggal, layanan, severity) sehingga klien tahu persis apa yang diwakili angka tersebut.

Pengiriman terjadwal per klien dan frekuensi

Tambahkan penjadwalan agar tiap klien bisa menerima laporan otomatis—mingguan, bulanan, kuartalan—dikirim ke daftar alamat klien atau inbox bersama. Simpan jadwal dengan scope tenant dan audit (siapa membuat, terakhir dikirim, run berikutnya).

Jika butuh titik awal sederhana, luncurkan dengan “ringkasan bulanan” plus tombol unduh satu-klik dari /reports.

Template siap-QBR/MBR

Buat template yang terbaca seperti slide QBR/MBR dalam bentuk tertulis:

- Sorotan (uptime, perbaikan utama)

- Pelanggaran (apa yang terjadi, durasi, dampak)

- Catatan (pemeliharaan terjadwal, tindak lanjut)

Catatan kepatuhan, pengecualian, dan persetujuan

SLA nyata termasuk pengecualian (pemeliharaan, outage pihak ketiga). Biarkan pengguna melampirkan catatan kepatuhan dan menandai pengecualian yang membutuhkan persetujuan, dengan jejak persetujuan.

Isolasi tenant dan permission pada export

Export harus menghormati isolasi tenant dan permission per peran. Pengguna hanya boleh mengekspor klien, layanan, dan periode yang mereka boleh lihat — dan export harus cocok persis dengan tampilan portal (tanpa kolom tambahan yang bocor).

Alerts dan Notifikasi untuk Pelanggaran SLA

Alert adalah tempat aplikasi pelaporan SLA berubah dari “dashboard menarik” menjadi alat operasional. Tujuan bukan mengirim lebih banyak pesan — tetapi membantu orang yang tepat bereaksi lebih awal, mendokumentasikan apa yang terjadi, dan menjaga klien terinformasi.

Pilih tipe alert yang sesuai dengan cara SLA gagal

Mulailah dengan tiga kategori:

- Impending breach: Anda sedang tren menuju kegagalan target (mis. burn rate menunjukkan uptime akan turun di bawah 99.9% pada akhir periode, atau sisa anggaran response-time tipis).

- Confirmed breach: SLA dipastikan terlewati untuk periode yang didefinisikan.

- Data pipeline failure: data hilang, import tertunda, atau error integrasi yang bisa menggugurkan pelaporan.

Hubungkan tiap alert ke definisi yang jelas (metrik, jendela waktu, ambang, scope klien) agar penerima dapat mempercayainya.

Pilih saluran — dan buatlah sadar-klien

Tawarkan beberapa opsi pengiriman agar tim bertemu klien di tempat mereka sudah bekerja:

- Email untuk eksekutif dan tim yang berhubungan dengan klien

- Slack / MS Teams untuk on-call dan operasi

- Webhook untuk memicu sistem internal (PagerDuty, ServiceNow, tooling insiden kustom)

Untuk pelaporan multi-klien, rute notifikasi menggunakan aturan tenant (mis. “Pelanggaran Klien A ke Channel A; pelanggaran internal ke on-call”). Hindari mengirim detail klien ke channel bersama.

Kurangi kebisingan: deduplication, quiet hours, dan eskalasi

Alert fatigue akan membunuh adopsi. Terapkan:

- Deduplication (konsolidasikan pemicu berulang menjadi satu alert aktif)

- Quiet hours (tunda notifikasi non-darurat di luar jam kerja)

- Escalation (jika tak diakui dalam X menit, beri tahu grup lebih luas)

Buat alert dapat ditindaklanjuti dengan acknowledgment dan catatan

Setiap alert harus mendukung:

- Acknowledgment (siapa yang mengambil tanggung jawab)

- Resolution notes (apa yang terjadi, link ke insiden/tiket, ringkasan komunikasi klien)

Ini menciptakan jejak audit ringan yang dapat digunakan kembali dalam ringkasan siap-klien.

Editor aturan sederhana per klien

Sediakan editor aturan dasar untuk ambang per-klien dan routing (tanpa mengekspose logika query kompleks). Guardrail membantu: default, validasi, dan preview (“aturan ini akan memicu 3 kali bulan lalu”).

Pertahankan kepemilikan penuh kode

Ekspor kode sumber agar tim Anda bisa memperluas logika dan menguasai stack.

Aplikasi pelaporan SLA terpusat cepat menjadi misi-kritis karena klien menggunakannya untuk menilai kualitas layanan. Itu membuat kecepatan, keamanan, dan bukti (untuk audit) sama pentingnya dengan grafik.

Klien besar dapat menghasilkan jutaan tiket, insiden, dan event monitoring. Untuk menjaga halaman responsif:

- Gunakan paginasi di mana-mana (tabel, daftar event, view drill-down). Hindari memuat semua hasil secara default.

- Cache query umum seperti “30 hari terakhir uptime per layanan” atau “alasan breach teratas.” Cache berbatas waktu (mis. 5–15 menit) sering menjaga data terasa segar sambil mengurangi beban DB.

- Pra-agregat hasil SLA untuk view berat (ringkasan bulanan, uptime per-layanan, jumlah breach). Hitung ini terjadwal atau setelah ingestion agar dashboard tidak menghitung ulang dari event mentah setiap kali.

Retensi data dan arsitektur arsip

Event mentah bernilai untuk investigasi, tetapi menyimpan semuanya selamanya menaikkan biaya dan risiko.

Tentukan aturan jelas seperti:

- Simpan normalized raw events untuk periode pendek (mis. 90–180 hari).

- Simpan SLA results dan ringkasan lebih lama (mis. 2–7 tahun) untuk tren dan kontrak.

- Arsipkan event lama ke storage murah (object storage atau cold tier) dengan proses pengambilan terdokumentasi.

Dasar-dasar keamanan yang diharapkan klien

Untuk portal pelaporan klien, anggap konten sensitif: nama pelanggan, timestamp, catatan tiket, dan kadang PII.

- Enkripsi data in transit (HTTPS/TLS) dan at rest (DB dan backup). Perlakukan token API dan kredensial integrasi sebagai secret, disimpan di vault atau layanan secret-managed.

- Tambahkan rate limiting dan validasi input pada endpoint publik (login, export, API). Ini mengurangi penyalahgunaan, overload tidak sengaja, dan serangan injeksi umum.

Kepatuhan dan kesiapan audit

Bahkan jika Anda tidak mengejar standar tertentu, bukti operasional yang baik membangun kepercayaan.

Pertahankan:

- Audit log immutable (login, export, perubahan permission, perubahan integrasi).

- Backup dengan uji restore (jangan hanya “kita backup”). Jadwalkan drill restore periodik dan catat hasilnya.

- Kebijakan dasar akses data: siapa bisa melihat apa, berapa lama data disimpan, dan bagaimana permintaan penghapusan ditangani.

Rencana Peluncuran, Monitoring, dan Roadmap Iterasi

Meluncurkan aplikasi pelaporan SLA lebih sedikit tentang rilis besar-besaran dan lebih banyak tentang membuktikan akurasi, lalu skala secara berulang. Rencana peluncuran yang kuat mengurangi perselisihan dengan membuat hasil mudah diverifikasi dan direproduksi.

1) Mulai dengan klien pilot (dan validasi akurasi)

Pilih satu klien dengan set layanan dan sumber data yang terkelola. Jalankan perhitungan SLA aplikasi Anda paralel dengan spreadsheet, export tiket, atau laporan vendor yang ada.

Fokus pada area mismatch umum:

- Zona waktu dan batas cutoff periode (end-of-month)

- Apa yang dihitung sebagai downtime vs degraded

- Bagaimana jendela pemeliharaan diperlakukan

Dokumentasikan perbedaan dan putuskan apakah aplikasi harus menyesuaikan perilaku klien saat ini atau menggantinya dengan standar yang lebih jelas.

2) Operasionalisasikan onboarding dengan checklist

Buat checklist onboarding yang dapat diulang sehingga pengalaman setiap klien baru dapat diprediksi:

- Akses sumber data (API keys, scopes, IP allowlists)

- Aturan pemetaan (nama layanan, kategori tiket, severity)

- Konfirmasi definisi SLA (target, pengecualian, pembulatan)

- Test run + sign-off (periode sampel, insiden yang diketahui)

- Penunjukan owner (siapa yang bisa menyetujui perubahan)

Checklist juga membantu memperkirakan usaha dan mendukung diskusi di /pricing.

3) Tambahkan monitoring untuk kepercayaan dan dukungan

Dashboard SLA hanya kredibel jika data segar dan lengkap. Tambahkan monitoring untuk:

- Kegagalan job terjadwal dan retry

- Error rate-limit API dan kegagalan autentikasi

- Data stale (tidak ada event yang diingest selama X jam)

- Penurunan/kenaikan tak terduga volume insiden

Kirim alert internal terlebih dulu; setelah stabil, Anda bisa memperkenalkan catatan status yang terlihat klien.

4) Iterasi berbasis kejelasan, bukan sekadar fitur

Kumpulkan umpan balik pada titik kebingungan: definisi, perselisihan (“kenapa ini breach?”), dan “apa yang berubah” sejak bulan lalu. Prioritaskan perbaikan UX kecil seperti tooltip, change log, dan catatan kaki yang jelas pada pengecualian.

5) Bangun lebih cepat dengan workflow pengembangan modern

Jika ingin mengirim MVP internal cepat (model tenant, integrasi, dashboard, export) tanpa menghabiskan minggu pada boilerplate, pendekatan vibe-coding bisa membantu. Misalnya, Koder.ai memungkinkan tim menyusun dan iterasi aplikasi web multi-tenant via chat—lalu mengekspor kode sumber dan deploy. Itu praktis untuk produk pelaporan SLA, di mana kompleksitas inti adalah aturan domain dan normalisasi data alih-alih scaffolding UI satu-satu.

Anda bisa menggunakan mode planning Koder.ai untuk menguraikan entitas (tenants, services, SLA definitions, events, rollups), lalu menghasilkan UI React dan backend Go/PostgreSQL yang bisa Anda kembangkan dengan integrasi dan logika perhitungan spesifik.

6) Publikasikan roadmap singkat

Simpan dokumen hidup dengan langkah berikutnya: integrasi baru, format export, dan jejak audit. Link ke panduan terkait di /blog agar klien dan rekan bisa mencari detail sendiri.