Mengapa kode yang dihasilkan AI dan tes yang dihasilkan otomatis cocok bersama

Logika aplikasi yang ditulis oleh AI berarti bagian “bekerja” dari basis kode Anda drafnya dibuat dengan bantuan asisten: fungsi baru, fitur kecil, refaktor, penanganan edge-case, dan bahkan penulisan ulang modul yang ada. Anda tetap memutuskan apa yang dibangun, tetapi versi pertama implementasi sering tiba lebih cepat—dan kadang membawa asumsi yang tidak Anda sadari sampai nanti.

Pembuatan tes otomatis adalah kemampuan padanan di sisi verifikasi. Alih-alih menulis setiap tes dengan tangan, alat bisa mengusulkan kasus uji dan assertion berdasarkan kode Anda, spes, atau pola yang dipelajari dari bug sebelumnya. Dalam praktiknya, ini bisa terlihat seperti:

- “Diberikan tanda tangan fungsi dan cabang ini, berikut tes yang menutupi input tipikal, batas, dan jalur error.”

- “Berikut tes regresi yang mereproduksi crash yang kita lihat di produksi.”

Harapan kunci: tes yang dihasilkan tidak otomatis "bagus"

Tes yang dihasilkan bisa menyesatkan: ia mungkin mengasert perilaku saat ini padahal perilaku itu salah, atau mungkin melewatkan aturan produk yang hidup di kepala orang dan komentar tiket. Itulah mengapa tinjauan manusia penting. Seseorang perlu memastikan bahwa nama tes, setup, dan assertion mencerminkan maksud nyata—bukan sekadar apa yang kebetulan dilakukan kode hari ini.

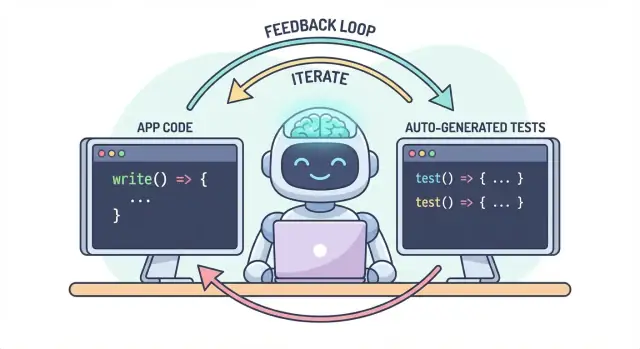

Satu alur kerja, dua keluaran

Ide inti sederhana: kode dan tes harus berkembang bersama sebagai satu alur kerja. Jika AI membantu Anda mengubah logika dengan cepat, pembuatan tes otomatis membantu Anda mengunci perilaku yang dimaksud dengan sama cepatnya—sehingga perubahan berikutnya (manusia atau AI) punya definisi “tetap benar” yang jelas dan dapat dijalankan.

Dalam praktik, pendekatan “keluaran berpasangan” ini lebih mudah dipertahankan ketika alur pengembangan Anda sudah berbasis chat. Misalnya, di Koder.ai (platform vibe-coding untuk membangun aplikasi web, backend, dan mobile lewat chat), wajar memperlakukan “fitur + tes” sebagai deliverable tunggal: Anda mendeskripsikan perilaku, menghasilkan implementasi, lalu menghasilkan dan meninjau tes dalam loop percakapan yang sama sebelum deploy.

Kode yang ditulis AI bisa terasa seperti kekuatan super: fitur muncul cepat, boilerplate hilang, dan refaktor yang dulu makan waktu berjam-jam bisa terjadi sebelum kopi Anda mendingin. Catanya adalah bahwa kecepatan mengubah bentuk risiko. Ketika kode lebih mudah dibuat, juga lebih mudah mengirimkan kesalahan—kadang yang halus.

Mode kegagalan umum pada logika yang ditulis AI

Asisten AI pandai menghasilkan implementasi yang “masuk akal”, tetapi masuk akal bukan berarti benar untuk domain spesifik Anda.

Edge case adalah korban pertama. Logika yang dihasilkan AI sering menangani jalur bahagia dengan baik, lalu tersandung pada kondisi batas: input kosong, kekeliruan zona waktu, pembulatan, nilai null, perilaku retry, atau keadaan “ini tidak boleh terjadi” yang ternyata terjadi di produksi.

Asumsi yang salah adalah masalah lain. Asisten bisa menafsirkan persyaratan yang tidak dinyatakan (“pengguna selalu terautentikasi”, “ID selalu numerik”, “field ini selalu ada”), atau mengimplementasikan pola yang familiar tapi tidak cocok dengan aturan sistem Anda.

Regresi senyap sering paling mahal. Anda minta perubahan kecil, asisten menulis ulang potongan logika, dan sesuatu yang tidak terkait rusak—tanpa error yang jelas. Kode masih kompilasi, UI masih muncul, tetapi aturan harga, pemeriksaan permission, atau konversi data kini sedikit meleset.

Mengapa pengujian manual tidak skala dengan kode yang lebih cepat

Saat perubahan kode mempercepat, pengujian manual menjadi hambatan dan taruhan. Anda atau menghabiskan lebih banyak waktu mengklik (memperlambat pengiriman) atau menguji lebih sedikit (meningkatkan keluarnya bug). Bahkan tim QA yang disiplin tidak bisa menutupi setiap varian secara manual ketika perubahan sering dan luas.

Lebih buruk, pemeriksaan manual sulit diulang secara konsisten. Mereka hidup di ingatan seseorang atau checklist, dan mudah terlewat saat tenggat mengetat—tepat ketika risiko paling tinggi.

Tes sebagai jaring pengaman dan alat komunikasi

Tes otomatis menciptakan jaring pengaman yang tahan lama: mereka membuat ekspektasi dapat dijalankan. Tes yang baik mengatakan, “Diberikan input dan konteks ini, inilah hasil yang kami andalkan.” Itu bukan sekadar verifikasi; itu komunikasi untuk diri Anda di masa depan, rekan tim, dan bahkan asisten AI.

Saat tes ada, perubahan jadi kurang menakutkan karena umpan balik langsung. Alih-alih menemukan masalah setelah code review, di staging, atau dari pelanggan, Anda menemukannya beberapa menit setelah perubahan.

Menangkap isu lebih awal untuk mengurangi pengerjaan ulang

Semakin awal bug tertangkap, semakin murah perbaikannya. Tes memendekkan loop umpan balik: mereka menampilkan asumsi yang tidak cocok dan kasus tepi yang terlewat saat niat masih segar. Itu mengurangi pengerjaan ulang, menghindari patch “fix-forward”, dan mencegah kecepatan AI berubah menjadi churn yang digerakkan AI.

Bagaimana tes menciptakan loop umpan balik untuk logika yang ditulis AI

Kode yang ditulis AI paling cepat ketika Anda memperlakukannya seperti percakapan, bukan deliverable sekali jalan. Teslah yang membuat percakapan itu terukur.

Loop “spec → code → tests” (dengan kata-kata sederhana)

-

Spec: Anda mendeskripsikan apa yang harus terjadi (input, output, kasus tepi).

-

Code: AI menulis implementasi yang mengklaim sesuai deskripsi itu.

-

Tests: Anda (atau AI) menghasilkan pemeriksaan yang membuktikan perilaku itu benar.

Ulangi loop ini dan Anda tidak hanya memproduksi lebih banyak kode—Anda terus-menerus mengencangkan definisi “selesai.”

Tes memaksa persyaratan dan antarmuka menjadi lebih jelas

Persyaratan samar seperti “tangani pengguna tidak valid dengan anggun” mudah diabaikan dalam kode. Tes tidak bisa samar. Tes memaksa spesifikasi:

- Apa yang dihitung sebagai “tidak valid”? ID hilang, status diblokir, email salah format?

- Apa arti “dengan anggun”? Pesan error, status code, nilai fallback?

- Seperti apa antarmuka? Tanda tangan fungsi, bentuk return, exception?

Begitu Anda mencoba mengekspresikan detail itu dalam tes, bagian yang tidak jelas langsung muncul. Kejelasan itu memperbaiki prompt yang Anda berikan ke AI dan sering mengarah ke antarmuka yang lebih sederhana dan stabil.

Tes yang dihasilkan memvalidasi klaim yang dibuat kode

Kode AI bisa terlihat benar sementara menyembunyikan asumsi. Tes yang dihasilkan adalah cara praktis untuk memverifikasi klaim yang dibuat kode:

- “Fungsi ini murni” → uji agar tidak ada efek samping eksternal.

- “Menangani edge case” → uji null, list kosong, nilai batas.

- “Kompatibel mundur” → uji input lama dan output yang diharapkan.

Tujuannya bukan mempercayai tes yang dihasilkan secara membabi buta—tetapi menggunakannya sebagai skeptisisme terstruktur dan cepat.

Tes yang gagal menjadi prompt berikutnya

Tes yang gagal adalah umpan balik yang dapat ditindaklanjuti: ia menunjuk pada ketidakcocokan spes dengan implementasi. Alih-alih meminta AI “perbaiki”, Anda bisa menempelkan kegagalan itu dan mengatakan: “Perbarui kode sehingga tes ini lulus tanpa mengubah API publik.” Itu mengubah debugging menjadi iterasi terfokus daripada tebakan.

Tempat pembuatan tes otomatis cocok dalam piramida tes Anda

Pembuatan tes otomatis paling berguna ketika mendukung strategi tes yang sudah ada—terutama piramida tes klasik. Piramida bukan aturan untuk kepentingan itu sendiri; ia adalah cara menjaga umpan balik cepat dan dapat dipercaya sambil tetap menangkap kegagalan dunia nyata.

AI dapat membantu Anda membuat tes di setiap lapisan, tetapi Anda akan mendapat hasil terbaik jika Anda menghasilkan lebih banyak tes murah (dasar piramida) dan lebih sedikit tes mahal (puncak). Keseimbangan itu menjaga pipeline CI cepat sambil tetap melindungi pengalaman pengguna.

Tes unit: cepat, fokus, dan sangat mudah digenerasi

Tes unit adalah pemeriksaan kecil untuk fungsi, metode, atau modul individu. Mereka berjalan cepat, tidak butuh sistem eksternal, dan ideal untuk cakupan kasus tepi yang dihasilkan AI.

Penggunaan pembuatan tes otomatis yang baik di sini:

- Mengeksersis input validasi dan nilai batas yang “aneh”

- Memvalidasi aturan bisnis (diskon, permission, transisi state)

- Mengunci perbaikan bug dengan tes regresi yang mudah terlupakan

Karena tes unit berjangkauan sempit, mereka lebih mudah direview dan cenderung tidak flaky.

Tes integrasi: lebih sedikit, tapi bernilai tinggi

Tes integrasi memvalidasi bagaimana bagian bekerja bersama: API Anda dengan database, service memanggil service lain, pemrosesan queue, autentikasi, dan sebagainya.

Tes integrasi yang dihasilkan AI bisa bernilai, tetapi memerlukan disiplin lebih:

- Setup/teardown yang jelas supaya tes tidak bocor data

- Lingkungan tes yang stabil (container, DB tes, mock yang sesuai)

- Asersi yang fokus pada hasil, bukan detail implementasi internal

Anggap ini sebagai “cek kontrak” yang membuktikan sambungan antar komponen masih utuh.

End-to-end: hasilkan seperlunya

Tes end-to-end (E2E) memvalidasi alur pengguna utama. Mereka juga paling mahal: lebih lambat dijalankan, lebih rapuh, dan lebih sulit di-debug.

Pembuatan E2E otomatis dapat membantu mendraf skenario, tetapi Anda harus mengkurasinya dengan agresif. Pertahankan set kecil jalur kritis (signup, checkout, alur inti) dan hindari mencoba menghasilkan E2E untuk setiap fitur.

Rekomendasi praktis: hasilkan campuran yang seimbang

Jangan bermaksud menghasilkan semuanya. Sebagai gantinya:

- Hasilkan banyak tes unit untuk menjaga kejujuran logika yang ditulis AI di tingkat fungsi

- Tambahkan tes integrasi terarah untuk melindungi jahitan berisiko (DB, auth, payments)

- Pelihara suite E2E minimal untuk beberapa jalur pengguna yang tak boleh rusak

Pendekatan ini menjaga piramida tetap utuh—dan menjadikan pembuatan tes otomatis sebagai multiplikator tenaga daripada sumber kebisingan.

Apa saja yang bisa digenerasikan: dari kode, spes, dan bug nyata

Pembuatan tes otomatis tidak terbatas pada “tulis tes unit untuk fungsi ini.” Generator paling berguna menarik dari tiga sumber: kode yang Anda punya, niat di baliknya, dan kegagalan yang sudah terjadi.

1) Dari struktur kode: uji perilaku, bukan hanya baris

Diberikan fungsi atau modul, alat bisa menginfer kasus uji dari input/output, cabang, dan jalur exception. Itu biasanya berarti:

- Input "happy path" yang harus menghasilkan hasil yang diketahui

- Nilai batas (string kosong, nol, panjang maksimum)

- Cakupan cabang (if/else)

- Penanganan error (input tidak valid, field hilang, timeout)

Gaya ini bagus untuk dengan cepat mengelilingi logika yang ditulis AI dengan pemeriksaan yang mengonfirmasi apa yang sebenarnya dilakukannya hari ini.

2) Dari requirements: ubah niat menjadi contoh executable

Jika Anda punya acceptance criteria, user story, atau tabel contoh, generator bisa mengubahnya menjadi tes yang terbaca seperti spes. Ini sering bernilai lebih tinggi daripada tes yang berasal dari kode karena mengunci “apa yang seharusnya terjadi,” bukan “apa yang terjadi saat ini.”

Polanya: berikan beberapa contoh konkret (input + hasil yang diharapkan) dan minta generator menambahkan kasus tepi yang konsisten dengan aturan tersebut.

3) Dari laporan bug: reproduksi dulu, lalu cegah

Generasi berbasis bug adalah cara tercepat untuk membangun suite regresi yang bermakna. Masukkan langkah reproduksi (atau log dan payload minimal) dan hasilkan:

- sebuah tes yang gagal pada perilaku buggy saat ini, lalu

- tes yang sama lulus setelah diperbaiki—selamanya menjaga agar bug tidak kembali

Snapshot/golden tests: membantu, dengan peringatan

Snapshot (golden) tests bisa efisien untuk output yang stabil (UI yang dirender, response yang diserialisasi). Gunakan dengan hati-hati: snapshot besar bisa “menyetujui” kesalahan halus. Lebih suka snapshot kecil dan fokus serta padukan dengan asersi pada field kunci yang harus benar.

Memilih apa yang diuji dulu (tanpa merebus lautan)

Pembuatan tes otomatis paling efektif ketika Anda memberi prioritas yang jelas. Jika Anda menunjuk ke seluruh basis kode dan meminta “semua tes,” Anda akan mendapatkan kebisingan: banyak pemeriksaan bernilai rendah, duplikasi cakupan, dan tes rapuh yang memperlambat pengiriman.

Mulai dari tempat bisnis akan merasakan sakit

Mulai dengan alur yang paling mahal bila rusak—secara finansial, legal, atau reputasi. Filter berbasis risiko sederhana menjaga ruang lingkup realistis sambil cepat meningkatkan kualitas.

Fokus dulu pada:

- Jalur kritis bisnis (signup, checkout, alur inti) dan area yang sering berubah (fitur aktif, refaktor, integrasi baru).

- Domain berisiko tinggi: pembayaran, autentikasi, integritas data, permission/roles, dan apa pun yang memengaruhi apa yang bisa dilihat atau dilakukan pengguna.

Untuk setiap alur terpilih, hasilkan tes berlapis: beberapa tes unit cepat untuk logika sulit, plus satu atau dua tes integrasi yang mengonfirmasi seluruh jalur berfungsi.

“Happy path + kasus tepi utama” mengalahkan kombinasi ekstensif

Minta cakupan yang sesuai dengan kegagalan nyata, bukan kombinasi teoretis. Set awal yang baik:

- Satu tes happy path yang membuktikan perilaku yang diharapkan.

- Kasus tepi utama yang benar-benar Anda khawatirkan: input hilang/tidak valid, token kadaluwarsa, permission tidak cukup, konflik konkurensi, dan data “kosong”.

Anda selalu dapat memperluas nanti berdasarkan bug, laporan insiden, atau umpan balik pengguna.

Definisikan “selesai” agar tetap selesai

Buat aturan eksplisit: fitur tidak lengkap sampai ada tesnya. Definisi done itu makin penting dengan kode yang ditulis AI, karena mencegah “fast shipping” berubah diam-diam menjadi “fast regressions.”

Jika ingin aturan ini terjaga, hubungkan ke alur kerja (mis. wajibkan tes relevan sebelum merge di CI) dan cantumkan ekspektasi di dokumen tim (mis. /engineering/definition-of-done).

Pola prompt yang menghasilkan tes lebih baik

AI bisa menghasilkan tes dengan cepat, tetapi kualitasnya sangat bergantung pada cara Anda meminta. Tujuannya adalah mengarahkan model ke tes yang melindungi perilaku—bukan tes yang sekadar mengeksekusi kode.

Taruh standar coding Anda langsung di prompt

Mulailah dengan menentukan bentuk tes sehingga output cocok dengan repo Anda.

Cantumkan:

- Bahasa + framework test (mis. TypeScript + Jest, Python + pytest)

- Aturan penamaan (mis.

should_<behavior>_when_<condition>)

- Lokasi file dan struktur (mis.

src/ dan tests/, atau __tests__/)

- Konvensi (fixtures, factory helpers, library mocking)

Ini mencegah model membuat pola yang tim Anda tidak gunakan.

Beri 1–2 contoh tes nyata untuk ditiru

Tempel sebuah file tes yang ada (atau cuplikan kecil) dan katakan eksplisit: “Cocokkan gaya ini.” Ini menjadi jangkar untuk keputusan seperti pengaturan data, penamaan variabel, dan apakah Anda suka table-driven tests.

Jika proyek Anda punya helper (mis. buildUser() atau makeRequest()), sertakan snippet itu juga agar tes yang dihasilkan memakai kembali helper alih-alih mengimplementasikan ulang.

Minta asersi yang bermakna (jangan hanya “jalan”)

Jelaskan apa itu “bagus”:

- Asersi terhadap output dan perubahan state

- Verifikasi efek samping (mis. penulisan DB, event yang dipancarkan)

- Asersi tipe error/pesan saat perlu

Baris prompt yang berguna: “Setiap tes harus mengandung setidaknya satu asersi tentang perilaku bisnis (bukan hanya ‘tidak melempar exception’).”

Minta kasus negatif dan batas

Sebagian besar suite yang dihasilkan AI condong ke “happy path.” Lawan itu dengan meminta:

- Input tidak valid dan kegagalan yang diharapkan

- Nilai batas (string kosong, nol, panjang maksimum)

- Kegagalan permission/otorisasi

- Dependensi hilang (mis. response null, timeout)

Template prompt praktis

Generate unit tests for \u003cfunction/module\u003e.

Standards: \u003clanguage\u003e, \u003cframework\u003e, name tests like \u003cpattern\u003e, place in \u003cpath\u003e.

Use these existing patterns: \u003cpaste 1 short test example\u003e.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

(Blok kode di atas harus dipertahankan apa adanya saat Anda meminta generator; ini adalah contoh prompt yang baik.)

Tinjauan manusia: memastikan tes yang dihasilkan benar-benar membantu

AI bisa mendraf banyak tes dengan cepat, tapi ia tidak bisa menjadi hakim akhir apakah tes itu merepresentasikan niat Anda. Tinjauan manusialah yang mengubah “tes yang lari” menjadi “tes yang melindungi kita.” Tujuannya bukan mengkritik gaya—melainkan memastikan suite akan menangkap regresi bermakna tanpa menjadi beban perawatan.

Tinjau untuk kebenaran dan relevansi

Mulailah dengan dua pertanyaan:

- Apakah tes mengasert perilaku yang benar-benar dibutuhkan produk?

- Apakah Anda akan senang jika tes ini gagal setelah perubahan—karena ia menandakan masalah nyata?

Tes yang dihasilkan terkadang mengunci perilaku kebetulan (detail implementasi) bukan aturan yang dimaksud. Jika sebuah tes membaca seperti penyalinan kode daripada deskripsi hasil yang diharapkan, dorong agar asersi berada pada tingkat yang lebih tinggi.

Waspadai kerapuhan (pembunuh produktivitas terselubung)

Sumber flaky umum: over-mocking, timestamp yang di-hardcode, dan nilai acak. Pilih input deterministik dan asersi stabil (mis. asert pada tanggal yang diparse atau rentang, bukan string Date.now() mentah). Jika sebuah tes membutuhkan mocking berlebihan supaya lulus, mungkin ia menguji wiring bukan perilaku.

Pastikan kegagalan terjadi karena alasan yang tepat

Sebuah tes "lulus" bisa saja tidak berguna jika ia akan lulus meskipun fitur rusak (false positive). Cari asersi lemah seperti “tidak melempar” atau hanya memeriksa bahwa fungsi dipanggil. Perkuat dengan asersi pada output, perubahan state, error yang dikembalikan, atau data yang dipersistenkan.

Gunakan checklist review ringan

Checklist sederhana menjaga konsistensi review:

- Readability: nama jelas, setup minimal, maksud tampak

- Coverage of intent: kasus tepi kunci dan jalur error terikut

- Maintainability: menghindari overspesifikasi internal; mocking minimal

- Signal quality: akan gagal pada regresi nyata, bukan refaktor yang aman

Perlakukan tes yang dihasilkan seperti kode lain: merge hanya yang mau Anda pertanggungjawabkan dalam enam bulan.

Membuatnya bertahan: pemeriksaan CI yang menjaga kode AI tetap jujur

AI bisa membantu menulis kode cepat, tapi kemenangan sebenarnya adalah menjaga kode itu tetap benar seiring waktu. Cara termudah “mengunci” kualitas adalah menjalankan tes dan pemeriksaan otomatis pada setiap perubahan—sehingga regresi tertangkap sebelum dikirim.

Alur praktis yang bekerja

Alur ringan yang banyak tim pakai:

- Hasilkan atau edit kode fitur (dibantu AI atau tidak).

- Hasilkan tes untuk perilaku baru (dan untuk bug yang baru saja Anda perbaiki).

- Jalankan semuanya lokal untuk memastikan hijau.

- Commit kode + tes bersama.

Langkah terakhir penting: kode yang ditulis AI tanpa tes yang menyertainya cenderung melenceng. Dengan tes, Anda merekam perilaku yang dimaksud sehingga CI bisa menegakkannya.

CI sebagai jaring pengaman tak boleh dinegosiasikan

Konfigurasikan pipeline CI Anda untuk berjalan di setiap pull request (dan idealnya saat merge ke main). Minimal, CI harus:

- Install dependensi di lingkungan bersih

- Jalankan unit/integrasi tests

- Gagalkan build jika ada test gagal

Ini mencegah kejutan “berfungsi di mesin saya” dan menangkap kerusakan tak sengaja ketika rekan tim (atau prompt AI berikutnya) mengubah kode di tempat lain.

Tambahkan beberapa gerbang kualitas (tetap ringan)

Tes penting, tetapi mereka tidak menangkap semuanya. Tambahkan gerbang kecil dan cepat yang melengkapi pembuatan tes:

- Linting (style + kesalahan umum)

- Pemeriksaan tipe (jika berlaku)

- Pemeriksaan format (supaya diff tetap terbaca)

Jaga checks ini cepat—jika CI terasa lambat atau berisik, orang cenderung mencari jalan memotongnya.

Perencanaan biaya dan kapasitas

Jika Anda memperluas run CI karena menghasilkan lebih banyak tes, pastikan anggaran cocok dengan ritme baru. Jika Anda memantau menit CI, layak meninjau batas dan opsi (lihat /pricing).

Menggunakan tes yang gagal untuk memandu iterasi AI berikutnya

Cara yang efektif: perlakukan tes yang gagal sebagai “prompt berikutnya.” Daripada meminta model untuk secara luas “memperbaiki fitur,” Anda memberinya kegagalan konkret dan membiarkan kegagalan itu membatasi perubahan.

Alur kerja: gagal → prompt → perbaiki → ulang

- Jalankan suite (atau CI) dan tangkap satu kegagalan. Salin nama tes yang gagal dan pesan assertion/stack trace yang relevan.

- Minta AI hanya untuk menangani kegagalan itu. Berikan konteks kode minimal (tes yang gagal dan fungsi/modul yang diuji), plus aturan bisnis yang mungkin dilanggar.

- Minta tes regresi dulu. Jika kegagalan berasal dari laporan bug atau produksi, prompt AI untuk menambah atau menyesuaikan tes yang mereproduksi bug sebelum mengubah implementasi.

- Terapkan perubahan terkecil yang membuat tes lulus. Jalankan ulang tes segera.

- Lanjut ke kegagalan berikutnya. Satu kegagalan per iterasi menjaga iterasi tetap ketat dan mudah dipahami.

Pola prompt: kecil dan dapat diverifikasi

Alih-alih:

- “Perbaiki logika login dan perbarui tes.”

Gunakan:

- “Tes ini gagal:

shouldRejectExpiredToken. Ini output kegagalan dan kode relevan. Perbarui implementasi sehingga tes ini lulus tanpa mengubah perilaku terkait. Jika perlu, tambahkan tes regresi yang menangkap bug.”

Mengapa ini mengurangi bolak-balik

Tes yang gagal menghilangkan tebakan. Mereka mendefinisikan apa yang “benar” dalam bentuk executable, jadi Anda tidak bernegosiasi soal persyaratan di chat. Anda juga menghindari edit yang meluas: setiap prompt dibatasi pada satu hasil yang terukur, membuat review manusia lebih cepat dan lebih mudah mendeteksi ketika AI “memperbaiki” gejala tapi merusak hal lain.

Di sinilah alur kerja bergaya agent bisa berguna: satu agent fokus pada perubahan kode minimal, agent lain mengusulkan penyesuaian tes terkecil, dan Anda meninjau diff. Platform seperti Koder.ai dibangun di sekitar pengembangan iteratif berbasis chat seperti itu—membuat “tes sebagai prompt berikutnya” terasa seperti mode default daripada teknik khusus.

Mengukur keberhasilan tanpa mengejar metrik kesia-siaan

Pembuatan tes otomatis bisa membuat suite Anda tumbuh dalam semalam—tetapi “lebih besar” bukan sama dengan “lebih baik.” Tujuannya adalah kepercayaan: menangkap regresi lebih awal, mengurangi cacat produksi, dan menjaga tim bergerak.

Metrik yang benar-benar mencerminkan kualitas

Mulailah dengan sinyal yang memetakan ke hasil yang Anda pedulikan:

- Tingkat build lulus (di main): Jika merge sering rusak, tes yang dihasilkan mungkin terlalu rapuh atau prompt Anda menghasilkan asumsi yang salah.

- Tingkat flaky test: Lacak seberapa sering tes gagal lalu berhasil ulangi. Tingkat flaky yang naik adalah pajak pada kepercayaan pengembang dan membuat tim mengabaikan kegagalan.

- Waktu untuk mendeteksi regresi: Ukur waktu dari memperkenalkan bug sampai CI gagal. Tes yang dihasilkan harus memperpendek jendela ini dengan menutupi kasus tepi dan perubahan baru.

Anggap cakupan sebagai petunjuk, bukan skor

Cakupan bisa jadi alarm sederhana—khususnya untuk menemukan jalur kritis yang belum dites—tetapi mudah dimanipulasi. Tes yang dihasilkan bisa menaikkan cakupan sambil mengasert sangat sedikit (atau mengasert hal yang salah). Lebih suka indikator seperti:

- Asersi per tes (cek dasar, bukan KPI)

- Hasil mutation testing (jika dipakai)

- Apakah tes gagal ketika Anda sengaja merusak perilaku

Fokus pada “cacat yang tertangkap sebelum rilis”

Jika Anda hanya melacak jumlah tes atau cakupan, Anda akan mengoptimalkan volume. Lacak cacat yang tertangkap sebelum rilis: bug yang ditemukan di CI, QA, atau staging yang seharusnya sampai ke pengguna. Saat pembuatan tes otomatis bekerja, angka ini naik sementara insiden produksi turun.

Jadwalkan pembersihan agar keuntungan nyata

Suite yang dihasilkan perlu pemeliharaan. Buat tugas berkala untuk:

- Menghapus tes redundan yang tidak menambah perlindungan unik

- Menstabilkan atau menghapus tes flaky

- Mengonsolidasikan kasus yang tumpang tindih menjadi tes yang lebih jelas dan menggambarkan niat

Keberhasilan adalah CI yang lebih tenang, umpan balik lebih cepat, dan lebih sedikit kejutan—bukan dashboard yang terlihat impresif.

Kesalahan umum dan rencana peluncuran praktis

Pembuatan tes otomatis bisa meningkatkan kualitas dengan cepat—tapi hanya jika Anda memperlakukannya sebagai pembantu, bukan otoritas. Kegagalan terbesar cenderung serupa antar tim, dan mudah dihindari.

Kesalahan umum yang harus diwaspadai

Ketergantungan berlebihan adalah jebakan klasik: tes yang dihasilkan dapat menciptakan ilusi keamanan sementara melewatkan risiko nyata. Jika orang berhenti berpikir kritis (“alat menulis tes, jadi kita aman”), Anda akan mengirimkan bug lebih cepat—dengan tanda centang hijau lebih banyak.

Masalah lain adalah menguji detail implementasi bukan perilaku. Alat AI sering menempel pada nama metode saat ini, helper internal, atau pesan error yang tepat. Tes seperti itu menjadi rapuh: refaktor memecahnya meski fitur masih bekerja. Pilih tes yang menjelaskan apa yang harus terjadi, bukan bagaimana.

Keamanan dan privasi: jangan bocorkan yang tidak seharusnya

Pembuatan tes sering melibatkan menempel kode, stack trace, log, atau spes ke prompt. Itu bisa mengekspos rahasia (API key), data pelanggan, atau logika proprietari.

Jaga prompt dan fixture tes bebas dari informasi sensitif:

- Redaksi token, kredensial, dan URL internal.

- Hindari menempel log produksi yang mungkin berisi data pribadi.

- Gunakan contoh sintetis (akun palsu, ID palsu) untuk data tes.

- Jika harus berbagi kasus nyata, minimalkan dan anonimisasi.

Jika Anda menggunakan platform AI yang dihosting, terapkan disiplin yang sama. Bahkan saat platform mendukung deployment regional, prompt dan fixture tetap bagian dari postur keamanan Anda.

Rencana peluncuran praktis (yang tim benar-benar ikuti)

Mulailah kecil dan buat kebiasaan:

- Pilih satu service atau modul yang sering berubah.

- Hasilkan tes unit untuk jalur berisiko tertinggi (pergerakan uang, permission, transformasi data).

- Tambahkan aturan CI sederhana: fitur baru yang ditulis AI harus menyertakan tes (lihat /blog/ci-checks-for-ai-code).

- Wajibkan checklist review cepat: “Apakah tes ini mengasert perilaku? Apakah ia akan gagal karena alasan yang tepat?”

- Lacak regresi yang dicegah (bukan hanya cakupan), lalu perluas ke tes integrasi setelah tes unit terasa stabil.

Tujuannya bukan tes sebanyak-banyaknya—melainkan umpan balik yang dapat diandalkan yang menjaga logika yang ditulis AI tetap jujur.