Mengapa Pilihan Pemodelan Data Mengunci Arsitektur Anda Jangka Panjang

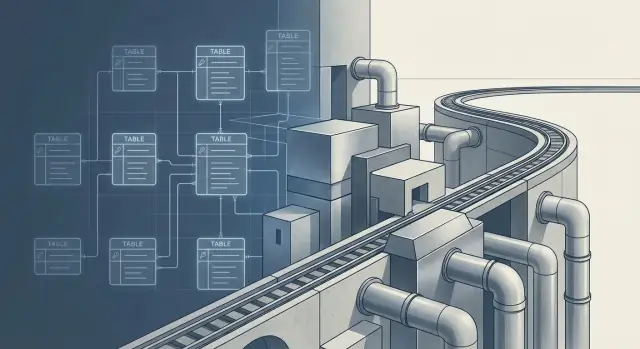

“Keterikatan” dalam arsitektur data bukan hanya soal vendor atau alat. Itu terjadi ketika mengubah skema menjadi begitu berisiko atau mahal sehingga Anda berhenti melakukannya—karena akan merusak dashboard, laporan, fitur ML, integrasi, dan pengertian bersama tentang apa arti data itu.

Sebuah model data adalah salah satu keputusan yang bertahan melewati segala hal lain. Gudang data diganti, alat ETL diswap, tim direorganisasi, dan konvensi penamaan meluntur. Tetapi begitu puluhan konsumen downstream bergantung pada kolom, kunci, dan grain sebuah tabel, model itu menjadi kontrak. Mengubahnya bukan sekadar migrasi teknis; itu masalah koordinasi lintas orang dan proses.

Mengapa pilihan pemodelan bertahan lebih lama daripada alat

Alat bisa saling dipertukarkan; dependensi tidak. Metrik yang didefinisikan sebagai “revenue” di satu model mungkin disebut “gross” di model lain. Kunci pelanggan bisa berarti “akun penagihan” di satu sistem dan “orang” di sistem lain. Komitmen tingkat makna seperti itu sulit untuk dibalik begitu menyebar.

Titik keputusan utama yang menciptakan keterikatan

Sebagian besar keterikatan jangka panjang berasal dari beberapa pilihan awal:

- Grain (tingkat granularitas): satu baris mewakili apa (per event, per hari, per pelanggan, per baris pesanan)

- Kunci dan identitas: bagaimana Anda mengidentifikasi hal secara unik, dan apakah identitas itu bisa berubah

- Histori: apakah Anda menyimpan perubahan seiring waktu, dan bagaimana (snapshot, slowly changing dimensions, log event)

- Semantik: di mana definisi bisnis berada (metrik, dimensi, dan logika bersama)

- Pola akses: apakah dioptimalkan untuk analis, alat BI, aplikasi, atau ML

Trade-off itu normal. Tujuannya bukan menghindari komitmen—melainkan membuat komitmen terpenting dengan sengaja, dan menjaga sebanyak mungkin komitmen lain dapat dibalik. Bagian berikut fokus pada cara praktis mengurangi kerusakan saat perubahan tak terelakkan.

Apa yang Dipegang Model Data (Lebih Dari yang Anda Pikirkan)

Model data bukan hanya sekumpulan tabel. Ia menjadi kontrak yang banyak sistem bergantung padanya secara diam-diam—seringkali sebelum versi pertama selesai.

Dependensi yang jelas

Begitu sebuah model “diberkati,” ia cenderung menyebar ke:

- Dashboard dan laporan (query tersimpan, logika chart, filter)

- Fitur ML (feature store, pipeline pelatihan, input scoring online)

- Reverse ETL (sinkronisasi “status pelanggan” atau “risiko churn” kembali ke CRM)

- API internal atau mitra (layanan yang membaca gudang data langsung)

- Berbagi data (shares, Delta sharing, ekspor ke vendor)

Setiap dependensi menggandakan biaya perubahan: Anda tidak lagi mengedit satu skema—Anda mengoordinasikan banyak konsumen.

Bagaimana satu metrik menjadi banyak salinan

Satu metrik yang dipublikasikan (mis. “Active Customer”) jarang tetap terpusat. Seseorang mendefinisikannya di alat BI, tim lain membuat ulang di dbt, analis growth meng-hardcode di notebook, dan dashboard produk menyematkannya lagi dengan filter sedikit berbeda.

Setelah beberapa bulan, “satu metrik” sebenarnya menjadi beberapa metrik serupa dengan aturan edge-case berbeda. Mengubah model sekarang berisiko merusak kepercayaan, bukan hanya kueri.

Ketergantungan tersembunyi yang tidak Anda lihat di ER diagram

Keterikatan sering bersembunyi di:

- Konvensi penamaan yang diasumsikan oleh alat downstream (mis.

*_id, created_at)

- Jalur join yang dianggap kanonik (“orders selalu join customers pada X”)

- Aturan bisnis tersirat yang dibenamkan ke kolom (mis. mengecualikan pengembalian, logika zona waktu)

Dampak operasional: biaya, latensi, dan respons insiden

Bentuk model memengaruhi operasi harian: tabel lebar mendorong biaya scan, model event granular meningkatkan latensi, dan lineage yang tidak jelas membuat insiden lebih sulit untuk ditelusuri. Saat metrik melenceng atau pipeline gagal, respons on-call Anda bergantung pada seberapa dapat dipahami—dan dapat dites—model itu.

Keputusan Grain: Komitmen Arsitektur Pertama

“Grain” adalah tingkat detail yang diwakili sebuah tabel—satu baris per apa, tepatnya. Kedengarannya kecil, tetapi sering kali menjadi keputusan pertama yang diam-diam mengunci arsitektur Anda.

Grain, dalam contoh sederhana

- Orders (grain): satu baris per pesanan (

order_id). Bagus untuk total pesanan, status, dan reporting tingkat tinggi.

- Order items (grain): satu baris per baris item (

order_id + product_id + line_number). Perlu untuk mix produk, diskon per item, pengembalian per SKU.

- Sessions (grain): satu baris per sesi pengguna (

session_id). Berguna untuk analisis funnel dan atribusi.

Masalah dimulai ketika Anda memilih grain yang tidak bisa menjawab pertanyaan yang akan ditanyakan bisnis.

Bagaimana grain yang salah menciptakan data canggung (dan tabel ekstra)

Jika Anda hanya menyimpan orders tetapi kemudian butuh “produk teratas berdasarkan pendapatan”, Anda dipaksa untuk:

- memasukkan array/JSON item ke baris orders (sulit di-query), atau

- membuat tabel

order_items kemudian dan melakukan backfill (sakit migrasi), atau

- membuat beberapa tabel turunan dengan logika duplikat (

orders_by_product, orders_with_items_flat), yang akan melenceng seiring waktu.

Demikian juga, memilih sessions sebagai fact utama membuat “pendapatan bersih per hari” canggung kecuali Anda menjembatani pembelian ke sesi dengan hati-hati. Anda akan mendapat join yang rapuh, risiko penghitungan ganda, dan definisi metrik “spesial”.

Relasi yang menentukan join masa depan Anda

Grain sangat terkait dengan relasi:

- One-to-many (order → items): jika Anda memodelkan di sisi “one”, Anda kehilangan detail atau membuat kolom ulang.

- Many-to-many (sessions ↔ campaigns, products ↔ categories): Anda akan membutuhkan tabel jembatan. Jika Anda mengabaikannya awalnya, solusi di kemudian hari cenderung meng-hardcode makna bisnis ke ETL.

Checklist validasi grain singkat

Sebelum membangun, tanyakan kepada pemangku kepentingan pertanyaan yang bisa mereka jawab:

- “Saat Anda mengatakan ‘satu order’, apakah Anda maksud keseluruhan order atau tiap item di dalamnya?”

- “Apakah Anda pernah perlu melaporkan di kedua level (order dan item)? Mana yang utama?”

- “Apa 5 pertanyaan teratas yang akan Anda tanyakan kuartal depan? Apakah memerlukan detail per item?”

- “Bisakah satu event terkait ke beberapa hal (beberapa campaign, beberapa kategori)?”

- “Apa yang tidak boleh dihitung dua kali (pendapatan, pengguna, sesi), dan pada grain apa itu aman?”

Kunci dan Identitas: Natural vs Surrogate, dan Mengapa Itu Penting

Kunci adalah bagaimana model Anda memutuskan “baris ini adalah hal dunia nyata yang sama dengan baris itu.” Salah pilih dan Anda akan merasakannya di mana-mana: join berantakan, load incremental melambat, dan mengintegrasikan sistem baru menjadi sebuah negosiasi bukannya checklist.

Natural keys vs surrogate keys (dengan bahasa sederhana)

Natural key adalah pengenal yang sudah ada di bisnis atau sistem sumber—seperti nomor invoice, SKU, alamat email, atau customer_id di CRM. Surrogate key adalah ID internal yang Anda buat (sering bilangan bulat atau hash) yang tidak punya makna di luar gudang data.

Natural key menarik karena sudah ada dan mudah dipahami. Surrogate key menarik karena stabil—jika Anda mengelolanya dengan baik.

Stabilitas seiring waktu: apa yang terjadi ketika ID berubah

Keterikatan muncul saat sistem sumber pasti berubah:

- Migrasi CRM mengubah penetapan customer ID.

- Katalog produk menomori ulang SKU.

- Akuisisi membawa namespace

customer_id lain yang tumpang tindih.

Jika gudang memakai natural key sumber di mana-mana, perubahan itu bisa berimbas ke fact, dimension, dan dashboard downstream. Tiba-tiba, metrik historis bergeser karena “customer 123” dulu berarti satu orang dan kini berarti orang lain.

Dengan surrogate key, Anda bisa menjaga identitas gudang tetap stabil sambil memetakan ID sumber baru ke identitas surrogate yang sudah ada.

Logika merge/dedup: identitas bukan sekadar join, tapi kebijakan

Data nyata butuh aturan merge: “email sama + telepon sama = pelanggan sama”, atau “utamakan record terbaru”, atau “simpan kedua sampai terverifikasi.” Kebijakan dedup itu memengaruhi:

- Join: kalau resolusi identitas dilakukan terlambat (di BI), setiap join menjadi kondisional dan tidak konsisten.

- Incremental loads: jika merge bisa menulis ulang sejarah, Anda mungkin butuh backfill atau logika “re-keying”, yang mahal dan berisiko.

Polanya yang praktis adalah menyimpan tabel pemetaan terpisah (kadang disebut identity map) yang melacak bagaimana banyak kunci sumber bergabung menjadi satu identitas gudang.

Konsekuensi untuk berbagi data dan integrasi produk baru

Saat Anda membagikan data ke mitra, atau mengintegrasikan perusahaan yang diakuisisi, strategi kunci menentukan usaha yang dibutuhkan. Natural key yang terikat ke satu sistem seringkali tidak mudah diperbawa. Surrogate key nyaman dipakai secara internal, tapi perlu mempublikasikan crosswalk jika pihak lain perlu join dengannya.

Bagaimanapun, kunci adalah komitmen: Anda tidak hanya memilih kolom—Anda memutuskan bagaimana entitas bisnis Anda bertahan terhadap perubahan.

Memodelkan Waktu dan Perubahan: Diri Masa Depan Anda Akan Berterima Kasih

Waktu adalah tempat model “sederhana” menjadi mahal. Kebanyakan tim mulai dengan tabel current-state (satu baris per pelanggan/pesanan/tiket). Mudah di-query, tetapi diam-diam menghapus jawaban yang mungkin Anda perlukan nanti.

Putuskan apa arti “histori” (sebelum Anda membutuhkannya)

Biasanya ada tiga opsi, dan masing-masing mengunci tooling dan biaya berbeda:

- Overwrite (snapshot saat ini): penyimpanan paling kecil, tabel paling sederhana, jejak audit paling lemah.

- Append-only events (log immutable): audit terbaik, tetapi query sering butuh lebih banyak kerja (dedup, sessionize, “latest state”).

- Slowly Changing Dimensions (SCD): jalan tengah untuk entitas, biasanya dengan

effective_start, effective_end, dan flag is_current.

Jika Anda mungkin butuh "apa yang kita tahu saat itu?"—Anda butuh lebih dari sekadar overwrite.

Saat current state tidak cukup

Tim biasanya menemukan histori yang hilang saat:

- Audit dan finance: “Berapa harga/diskon/pajak saat penagihan?”

- Customer support: “Alamat atau paket apa yang aktif saat insiden terjadi?”

- Kepatuhan dan kepercayaan: “Siapa yang memiliki akses pada tanggal itu?”

Merekonstruksi ini setelah fakta karena sistem hulu mungkin sudah menimpa kebenaran membuatnya menyakitkan.

Waktu punya tepi tajam: zona, tanggal efektif, data terlambat

Pemodelan waktu bukan hanya kolom timestamp.

- Zona waktu: simpan momen yang tidak ambigu (UTC) dan, bila perlu, zona waktu lokal asli untuk laporan.

- Tanggal efektif vs waktu event: “effective” adalah realitas bisnis (mulai kontrak), “event” adalah saat dicatat.

- Data terlambat dan backfill: pola append-only dan SCD menangani koreksi; overwrite sering memaksa rebuild rapuh.

Trade-off biaya dan kesederhanaan

Histori meningkatkan penyimpanan dan komputasi, tetapi juga dapat mengurangi kompleksitas di masa depan. Log append-only bisa membuat ingest murah dan aman, sementara tabel SCD memudahkan kueri “as of” umum. Pilih pola yang cocok dengan pertanyaan bisnis, bukan hanya dashboard hari ini.

Normalized vs Dimensional: Memilih untuk Siapa Anda Dioptimalkan

Validasi migrasi dengan aplikasi kecil

Buat dashboard rekonsiliasi untuk model paralel tanpa berminggu-minggu kode kustom.

Normalisasi dan pemodelan dimensional bukan sekadar “gaya.” Mereka menentukan siapa yang sistem Anda ramah—data engineer yang memelihara pipeline, atau orang yang menjawab pertanyaan setiap hari.

Model ternormalisasi: kurangi duplikasi, kurangi masalah update

Model ternormalisasi (sering 3rd normal form) memecah data menjadi tabel kecil terkait agar setiap fakta disimpan sekali. Tujuannya menghindari duplikasi dan masalah yang menyertainya:

- Jika alamat pelanggan berubah, Anda memperbaruinya di satu tempat—bukan di sepuluh tabel laporan.

- Jika nama produk dikoreksi, tidak akan salah eja di dashboard yang berbeda.

Struktur ini bagus untuk integritas data dan sistem di mana update sering terjadi. Cocok untuk tim yang engineering-heavy yang menginginkan batas kepemilikan jelas dan kualitas data yang dapat diprediksi.

Model dimensional (star schema): kecepatan dan kegunaan

Pemodelan dimensional membentuk ulang data untuk analisis. Star schema tipikal punya:

- Fact table (event atau pengukuran seperti orders, sessions, payments)

- Dimension tables (konteks deskriptif seperti customer, product, date, region)

Layout ini cepat dan intuitif: analis bisa memfilter dan mengelompokkan berdasarkan dimensi tanpa join kompleks, dan alat BI umumnya “memahami” format ini. Tim produk juga diuntungkan—eksplorasi self-serve jadi lebih realistis ketika metrik umum mudah di-query dan sulit disalahartikan.

Siapa yang diuntungkan dari masing-masing pilihan?

Model ternormalisasi mengoptimalkan untuk:

- pemelihara platform data (update bersih, kurang duplikasi)

- konsistensi di berbagai penggunaan downstream

Model dimensional mengoptimalkan untuk:

- analis dan analytics engineer (SQL lebih sederhana)

- alat BI (relasi langsung)

- tim produk (jawaban lebih cepat, lebih self-serve)

Keterikatannya nyata: begitu puluhan dashboard bergantung pada star schema, mengubah grain atau dimensi menjadi mahal secara politik dan operasional.

Hibrida praktis: staging ternormalisasi + mart terkurasi

Pendekatan anti-drama yang umum adalah menjaga kedua lapisan dengan tanggung jawab jelas:

- Staging/core ternormalisasi: landing dan standardisasi data dengan reshaping minimal, menjaga sumber dan mengurangi duplikasi.

- Curated dimensional marts: publikasikan star schema untuk kasus penggunaan bernilai tinggi (pendapatan, growth, retensi), dengan definisi metrik yang stabil.

Hibrida ini menjaga “sistem pencatatan” Anda fleksibel sekaligus memberi bisnis kecepatan dan kegunaan yang diharapkan—tanpa memaksa satu model melakukan semua pekerjaan.

Model Berbasis Event vs Berbasis Entitas

Model berbasis event menggambarkan apa yang terjadi: klik, percobaan pembayaran, pembaruan pengiriman, balasan tiket support. Model berbasis entitas menggambarkan apa sesuatu itu: pelanggan, akun, produk, kontrak.

Untuk apa Anda mengoptimalkan

Pemodelan entitas (tabel pelanggan, produk, subscription dengan kolom “state saat ini”) bagus untuk reporting operasional dan pertanyaan sederhana seperti “Berapa akun aktif?” atau “Paket apa yang dimiliki setiap pelanggan saat ini?” Juga intuitif: satu baris per entitas.

Pemodelan event (append-only facts) mengoptimalkan analisis seiring waktu: “Apa yang berubah?” dan “Dalam urutan apa?” Sering lebih dekat ke sistem sumber, sehingga lebih mudah menambah pertanyaan baru nanti.

Mengapa model event bisa lebih fleksibel

Jika Anda menyimpan stream event yang terdokumentasi dengan baik—setiap event dengan timestamp, actor, object, dan konteks—Anda bisa menjawab pertanyaan baru tanpa memodel ulang tabel inti. Misalnya, jika nanti Anda peduli tentang “first value moment”, “drop-off antara langkah”, atau “waktu dari awal percobaan ke pembayaran pertama”, itu bisa diturunkan dari event yang ada.

Batasnya: jika payload event tidak pernah menangkap atribut kunci (mis. campaign pemasaran mana yang berlaku), Anda tidak bisa menciptakannya kemudian.

Biaya tersembunyi

Model event lebih berat:

- Volume: baris lebih banyak, penyimpanan dan komputasi lebih tinggi.

- Event terlambat/urutan salah: butuh aturan untuk koreksi dan backfill.

- Sessionization dan rekonstruksi state: mengubah event menjadi “sesi”, “pengguna aktif”, atau “status saat ini” bisa kompleks dan mahal.

Di mana entitas masih penting

Arsitektur event-first biasanya tetap membutuhkan tabel entitas stabil untuk akun, kontrak, katalog produk, dan data referensi lain. Event menceritakan kisah; entitas mendefinisikan pemeran. Keputusan keterikatan adalah berapa banyak makna yang Anda encode sebagai “state saat ini” vs menurunkannya dari sejarah.

Lapisan Semantik dan Metrik: Keterikatan di Tingkat Makna Bisnis

Rencanakan perubahan skema yang lebih aman

Gunakan Mode Perencanaan untuk memetakan granularitas, riwayat, dan perubahan metrik sebelum mengubah tabel.

Lapisan semantik (kadang disebut metrics layer) adalah “lembar terjemahan” antara tabel mentah dan angka yang digunakan orang. Daripada setiap dashboard (atau analis) mengimplementasikan logika seperti “Revenue” atau “Active customer”, lapisan semantik mendefinisikan istilah tersebut sekali—bersama dimensi yang bisa digunakan untuk slice (tanggal, region, produk) dan filter yang selalu berlaku.

Definisi metrik menjadi API

Begitu metrik dipakai luas, ia berperilaku seperti API untuk bisnis. Ratusan laporan, alert, eksperimen, perkiraan, dan skema bonus mungkin bergantung padanya. Mengubah definisi nanti bisa merusak kepercayaan meski SQL masih berjalan.

Keterikatan bukan cuma teknis—itu sosial. Jika “Revenue” selalu mengecualikan pengembalian, mengganti ke net revenue tiba-tiba akan membuat tren terlihat salah dalam semalam. Orang akan berhenti percaya pada data sebelum bertanya apa yang berubah.

Di mana makna mengeras

Pilihan kecil mengeras dengan cepat:

- Penamaan: metrik bernama

orders mengimplikasikan hitungan order, bukan line item. Nama ambigu mengundang penggunaan yang tidak konsisten.

- Dimensi: memutuskan apakah metrik bisa dikelompokkan berdasarkan

order_date vs ship_date mengubah narasi dan keputusan operasional.

- Filter: default seperti “kecualikan akun internal” atau “hanya invoice berbayar” mudah terlupakan dan sulit dibalik.

- Aturan atribusi: “Signup by channel” bisa default ke first-touch, last-touch, atau window 7 hari. Default tunggal itu dapat menentukan tim mana yang terlihat sukses.

Versioning dan komunikasi perubahan

Perlakukan perubahan metrik seperti rilis produk:

- Versioning eksplisit:

revenue_v1, revenue_v2, dan sediakan keduanya selama transisi.

- Dokumentasikan kontrak: definisi, inklusi/eksklusi, window atribusi, dan dimensi yang diperbolehkan.

- Umumkan perubahan breaking lebih awal: catatan rilis di docs, timeline migrasi, dan dashboard validasi berdampingan.

- Depresiasi dengan tanggal: “v1 dihapus setelah Q2” lebih jelas daripada “gunakan v2 mulai sekarang.”

Jika Anda merancang lapisan semantik dengan sengaja, Anda mengurangi sakitnya keterikatan dengan membuat makna dapat berubah tanpa mengejutkan semua orang.

Evolusi Skema: Menghindari Perubahan yang Memecah

Perubahan skema tidak semuanya sama. Menambahkan kolom nullable baru biasanya berisiko rendah: query lama mengabaikannya, job downstream tetap jalan, dan Anda bisa backfill nanti.

Mengubah makna kolom yang ada adalah jenis yang mahal. Jika status dulu berarti “payment status” dan kini berarti “order status”, setiap dashboard, alert, dan join yang mengandalkannya menjadi salah secara diam-diam—meski tidak ada yang rusak keras. Perubahan makna menciptakan bug data tersembunyi, bukan kegagalan yang berisik.

Perlakukan tabel bersama seperti kontrak

Untuk tabel yang dikonsumsi banyak tim, definisikan kontrak eksplisit dan uji itu:

- Skema yang diharapkan: nama kolom, tipe, dan apakah kolom boleh dihapus.

- Null yang diperbolehkan: field mana yang harus selalu ada vs opsional.

- Nilai yang diperbolehkan: enums (mis.

pending|paid|failed) dan rentang untuk numeric.

Ini pada dasarnya adalah contract testing untuk data. Mencegah drift tidak sengaja dan menjadikan “breaking change” kategori yang jelas, bukan perdebatan.

Pola backward compatibility yang bekerja

Saat perlu mengubah model, bidik periode di mana konsumen lama dan baru bisa koeksis:

- Deprecate, jangan hapus: biarkan kolom lama ada untuk window yang ditentukan dan tandai di docs.

- Dual-write: isi baik field/ tabel lama maupun baru hingga konsumen bermigrasi.

- Alias views: publikasikan view stabil yang mempertahankan nama lama sementara tabel bawah berubah.

Kepemilikan dan persetujuan

Tabel bersama butuh kepemilikan jelas: siapa yang menyetujui perubahan, siapa yang diberitahu, dan apa proses rollout. Kebijakan perubahan ringan (owner + reviewer + timeline deprecate) lebih banyak mencegah kerusakan daripada alat apa pun.

Kinerja dan Batasan Biaya yang Membentuk Model

Model data bukan hanya diagram logis—itu taruhan fisik tentang bagaimana kueri berjalan, berapa biayanya, dan apa yang menyakitkan untuk diubah nanti.

Partisi dan clustering diam-diam menentukan perilaku kueri

Partisi (sering berdasarkan tanggal) dan clustering (berdasarkan kunci yang sering difilter seperti customer_id atau event_type) memberi imbalan pada pola kueri tertentu dan menghukum lainnya.

Jika Anda partisi berdasarkan event_date, dashboard yang memfilter “30 hari terakhir” tetap murah dan cepat. Tetapi jika banyak pengguna mengiris berdasarkan account_id sepanjang rentang waktu panjang, Anda mungkin tetap memindai banyak partisi—biaya membengkak, dan tim mulai merancang solusi (tabel ringkasan, ekstrak) yang semakin mengukuhkan model.

Tabel lebar vs banyak join: kecepatan vs fleksibilitas

Tabel lebar (denormalized) ramah untuk alat BI: lebih sedikit join, lebih sedikit kejutan, waktu ke chart pertama lebih cepat. Mereka juga bisa lebih murah per kueri ketika menghindari join ulang di tabel besar.

Trade-off: tabel lebar menggandakan data. Itu meningkatkan penyimpanan, mempersulit pembaruan, dan bisa membuat konsistensi definisi lebih susah ditegakkan.

Model sangat ternormalisasi mengurangi duplikasi dan dapat meningkatkan integritas data, tetapi join berulang bisa memperlambat kueri dan menciptakan pengalaman pengguna yang buruk—terutama saat pengguna non-teknis membuat laporan sendiri.

Incremental loads membatasi pilihan skema

Sebagian besar pipeline melakukan load incremental (baris baru atau baris yang berubah). Itu bekerja paling baik ketika Anda punya kunci stabil dan struktur yang ramah append. Model yang memerlukan sering “menulis ulang masa lalu” (mis. rebuild banyak kolom turunan) cenderung mahal dan berisiko operasional.

Cek kualitas data, backfill, dan reprocessing

Model Anda memengaruhi apa yang bisa Anda validasi dan apa yang bisa Anda perbaiki. Jika metrik bergantung pada join kompleks, cek kualitas menjadi lebih sulit dilokalisir. Jika tabel tidak dipartisi sesuai cara Anda melakukan backfill (per hari, per batch sumber), reprocessing bisa berarti scan dan rewrite jauh lebih banyak data—mengubah koreksi rutin menjadi insiden besar.

Seberapa Sulit Mengubah Nanti? Realitas Migrasi

Buat evolusi skema terlihat

Buat aplikasi catatan perubahan internal untuk penonaktifan, pemilik, dan tanggal peluncuran.

Mengubah model data nanti jarang merupakan “refactor.” Lebih mirip memindahkan sebuah kota sementara orang masih tinggal di dalamnya: laporan harus terus berjalan, definisi harus tetap konsisten, dan asumsi lama tertanam di dashboard, pipeline, bahkan rencana kompensasi.

Apa yang biasanya memaksa migrasi

Beberapa pemicu sering muncul:

- Gudang/lakehouse baru (biaya, performa, strategi vendor) yang tidak cocok dengan skema saat ini.

- M&A atau divestiture, di mana dua bisnis membawa ID pelanggan, hirarki produk, dan definisi metrik yang tidak kompatibel.

- Garis produk atau kanal baru yang memecah grain asli (mis. Anda memodelkan subscription, lalu menambahkan billing berbasis pemakaian).

Playbook yang lebih aman daripada “big bang”

Pendekatan risiko terendah adalah menganggap migrasi sebagai proyek engineering dan change-management.

- Jalankan model paralel: biarkan skema lama stabil sambil membangun model baru bersisian.

- Rekonsiliasi terus-menerus: publikasikan output berdampingan dan investigasi perbedaan sejak dini (bukan di akhir).

- Rencanakan cutover dengan sengaja: migrasikan use case bernilai tinggi dan kompleksitas rendah terlebih dulu; beku definisi; komunikasikan tanggal.

Jika Anda juga memelihara aplikasi data internal (admin tools, metric explorer, QA dashboard), memperlakukan mereka sebagai konsumen migrasi kelas satu membantu. Tim kadang menggunakan workflow pembuatan aplikasi cepat—seperti Koder.ai—untuk membuat UI “cek kontrak”, dashboard rekonsiliasi, atau alat tinjau pemangku kepentingan selama run paralel, tanpa menyita minggu engineer.

Bagaimana mengetahui apakah berhasil

Sukses bukan “tabel baru ada.” Itu:

- Paritas kueri: kueri kritis mengembalikan jawaban yang sama dalam toleransi yang disepakati.

- Paritas metrik: KPI utama cocok menurut definisi, bukan kebetulan.

- Adopsi pengguna: analis dan pemangku kepentingan benar-benar berpindah, dan dashboard lama dipensiunkan.

Penganggaran dan timeline

Migrasi model menghabiskan waktu lebih banyak dari perkiraan karena rekonsiliasi dan persetujuan pemangku kepentingan adalah bottleneck sebenarnya. Perlakukan perencanaan biaya sebagai alur kerja kelas satu (waktu orang, compute paralel, backfill). Jika Anda perlu cara untuk merangkum skenario dan trade-off, lihat /pricing.

Merancang untuk Reversibilitas: Taktik Praktis Anti-Lock-In

Reversibilitas bukan soal meramalkan setiap kebutuhan masa depan—melainkan membuat perubahan menjadi murah. Tujuannya memastikan perpindahan alat (warehouse → lakehouse), pendekatan pemodelan (dimensional → event-centric), atau definisi metrik tidak memaksa penulisan ulang penuh.

Prinsip “Buat Bisa Dibalik”

Perlakukan model Anda sebagai lapisan modular dengan kontrak jelas.

- Pisahkan fakta mentah dari tabel siap-bisnis: pertahankan lapisan ingest immutable, lalu core entities/events terkurasi, lalu marts.

- Definisikan kontrak di batas-batas: nama kolom, tipe, dan grain yang stabil untuk tabel bersama; sisanya boleh berubah.

- Versioning dengan sengaja: saat harus memecah kontrak, dorong

v2 berdampingan, migrasikan konsumen, lalu pensiunkan v1.

Checklist pra-komit (pakai sebelum merilis model baru)

- Apa grain, dinyatakan dalam satu kalimat?

- Apa primary key (atau aturan keunikan) dan bagaimana itu dihasilkan?

- Field mana yang immutable vs dapat dikoreksi?

- Bagaimana Anda merepresentasikan waktu (tanggal efektif, event time, snapshot time)?

- Siapa konsumen yang diharapkan (dashboard, ML, reverse ETL) dan kebutuhan latensinya?

- Apa rencana migrasi jika grain atau strategi kunci berubah?

Tata kelola ringan yang mencegah kejutan

Jaga governance kecil tapi nyata: kamus data dengan definisi metrik, pemilik bernama untuk setiap tabel inti, dan changelog sederhana (bahkan file Markdown di repo) yang mencatat apa yang berubah, mengapa, dan siapa kontaknya.

Langkah praktis selanjutnya

Pilotkan pola-pola ini di satu domain kecil (mis. “orders”), publikasikan kontrak v1, dan jalankan setidaknya satu perubahan terencana melalui proses versioning. Setelah berhasil, standarkan template dan skala ke domain berikutnya.