2025年6月17日·1 分

AIが開発者の仕事で置き換えるもの(置き換えないもの)

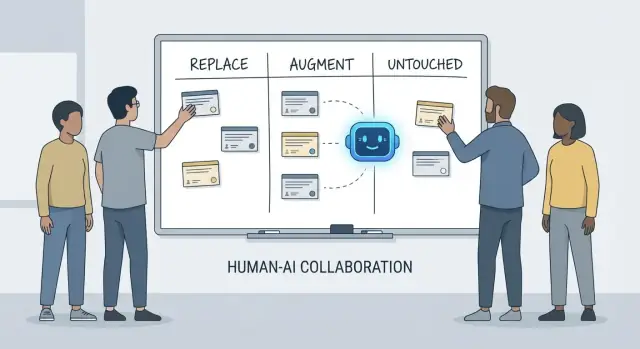

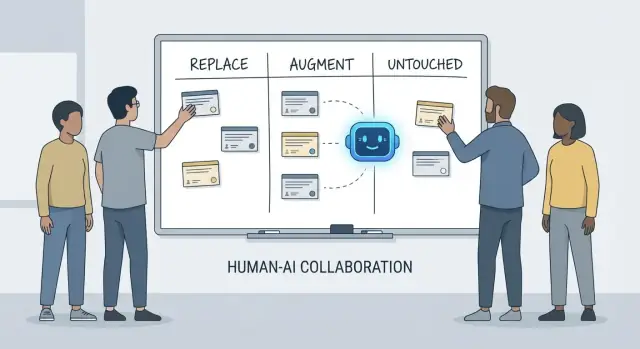

AIが置き換えられる開発作業、主に拡張する領域、実チームで依然として人間が完全に所有すべきタスクを実践的に分解して説明します。

AIが置き換えられる開発作業、主に拡張する領域、実チームで依然として人間が完全に所有すべきタスクを実践的に分解して説明します。

「AIが開発者に何をするか」という議論はすぐに混乱します。理由はしばしばツールと責任を混同するからです。ツールはコードを生成したり、チケットを要約したり、テストを提案したりできます。責任とは、提案が間違っていたときにチームが依然として説明できることです。

この記事では、置き換え(replace)、拡張(augment)、**そのまま(untouched)**というシンプルなフレームワークを使い、締め切り、レガシーコード、本番インシデント、信頼できる成果を期待するステークホルダーがいる実際のチームでの日常業務を説明します。

置き換えとは、AIが明確なガードレールの下でタスクを大部分はエンドツーエンドで完了でき、人間の役割は監督とスポットチェックに移ることを指します。

例としては境界がはっきりした仕事が多い:ボイラープレート生成、言語間のコード翻訳、繰り返しのテストケースの草案、一次的なドキュメントの作成など。

ただし「置き換え」が意味するのは「人間の責任がなくなる」ということではありません。出力が本番を壊したり、データを漏らしたり、基準に違反した場合、最終的な責任はチームにあります。

拡張とは、AIが開発者をより速く、またはより丁寧にするが、人間の判断なしに信頼して完了できるわけではないことを指します。

これはプロフェッショナルなエンジニアリングで最も一般的なケースです:有用な草案、代替アプローチ、短い説明、または考えられるバグの候補リストを得られますが、何が正しく安全で製品に適切かを決めるのは開発者です。

**そのまま(untouched)**は、コアの責任が人間主導のままであることを意味します。なぜならそれらは文脈、トレードオフ、説明責任を必要とし、プロンプトでは十分に圧縮できないからです。

例:要件の交渉、システムレベルの制約の選定、インシデント対応、品質基準の設定、正解が一つでない場面での判断など。

ツールは速く変わりますが、責任はゆっくりと変わります。

だから「AIはこのコードを書けるか?」と聞く代わりに「結果の責任は誰にあるか?」と問うべきです。この視点は精度、信頼性、説明責任に基づいた期待を保ち、印象的なデモより重要な点に着目させます。

人々がAIが開発に「何を置き換えるか」と尋ねるとき、しばしばタスク(関数を書く、テストを生成する、ドキュメントを下書きする)を指します。しかしチームはタスクを出荷するのではなく、成果を出荷します。そこで開発者の責任が重要になります。

開発者の仕事は単なるコーディング以上に広がります:

これらの責任はライフサイクル全体にまたがります—「何を作るべきか?」から「安全か?」、「壊れたときに3時に何が起きるか?」まで。

各責任は実際には多くの小さな判断の集合です:どのエッジケースが重要か、どの指標が健全性を示すか、いつスコープを切るか、修正が安全に出荷できるか、ステークホルダーにどのようにトレードオフを説明するか。AIは作業の一部(コード下書き、テスト提案、ログの要約)を助けることはできますが、責任は結果を所有することに関わります。

障害は多くの場合、引き渡し境界で発生します:

所有権が不明確だと、仕事は隙間に落ちます。

責任を語る有用な方法は決定権です:

AIは実行を速められます。決定権と成果に対する説明責任には、依然として人の名前が必要です。

AIコーディングアシスタントは、作業が予測可能で低リスク、検証が容易な場合に本当に役立ちます。高速なジュニアのチームメイトのような存在と考えてください:一次的な成果物は得意ですが、明確な指示と慎重なチェックが必要です。

実務では、一部のチームが“vibe-coding”プラットフォーム(例:Koder.ai)を使い、置き換え可能なチャンクを高速化しています:スキャフォールド生成、CRUDフローの配線、チャットからのUI/バックエンドの初期ドラフト作成。肝心なのは一貫性、レビュー、明確な所有権です。

多くの時間はプロジェクトのスキャフォールディングやレイヤー間のつなぎに費やされます。AIはしばしば以下を生成できます:

ガードレールは一貫性です:既存の規約に合っていること、新たなパターンや依存を勝手に導入しないことを確認してください。

変更がほとんど機械的な場合—シンボルの一括リネーム、フォーマット変更、単純なAPI利用の更新—AIは単純作業を加速します。

それでもバルク編集として扱ってください:フルテストスイートを実行し、差分をスキャンして意図しない振る舞いの変更を探し、要求されたリファクタ以外の“改善”は避けましょう。

AIはREADME、インラインコメント、変更履歴をコードやコミットノートから下書きできます。これは明瞭さを速めますが、自信満々に聞こえる誤りを生むこともあります。

ベストプラクティス:構造や表現はAIに任せ、特にセットアップ手順、構成デフォルト、エッジケースの主張は全て検証してください。

仕様が明確な純粋関数に対して、AI生成のユニットテストは初期カバレッジを与え、エッジケースの注意喚起になります。ガードレールは所有権です:何が重要かを選び、要件を反映するアサーションを追加し、テストが正しい理由で失敗することを確認してください。

長いSlackスレッド、チケット、インシデントログを簡潔なノートとアクションアイテムに変換できます。全コンテキストを与え、重要な事実、タイムスタンプ、決定を共有する前に検証してください。

AIコーディングアシスタントは、何をしたいかが既にわかっている場合に最も力を発揮します。タイプ作業を減らし、有用な文脈を提示しますが、所有、検証、判断の必要性を取り除きません。

入力、出力、エッジケース、制約が明確な仕様を与えると、AIは実行可能な出発実装(ボイラープレート、データマッピング、APIハンドラ、マイグレーション、単純なリファクタ)を下書きできます。得られるのは勢いです:素早く動くものが手に入ります。

ただし、ファーストパスのコードは微妙な要件(エラーの意味論、性能制約、後方互換)を見落としがちです。インターンの下書きのように扱い、権威あるものとしては扱わないでください。

キャッシング対バッチ処理、楽観的ロック対悲観的ロックなどのアプローチ選択で、AIは代替案とトレードオフのリストを出せます。ブレインストーミングには有益ですが、トレードオフはあなたのシステムの現実(トラフィックの形、データ整合性の必要性、運用制約、チームの慣習)に照らして検証する必要があります。

AIは不慣れなコードを説明したり、パターンを指摘したり、「これは何をしているのか?」を平易な言葉に翻訳したりするのが得意です。検索ツールと組み合わせれば、「Xはどこで使われているか?」や、見直すべき呼び出しサイト、設定、テストの影響リストを生成する助けになります。

実用的なQOL改善に期待してください:明確なエラーメッセージ、小さな使用例、貼り付け可能なスニペット。これらは摩擦を減らしますが、ユーザーや本番システムに影響する変更については慎重なレビュー、ローカル実行、ターゲットテストを置き換えません。

AIは要件を書いたり洗練したりする手助けはできますが、何を作るべきかやなぜそれが重要かを信頼して決定することはできません。プロダクト理解は文脈に根ざしています:ビジネスゴール、ユーザーの痛み、組織上の制約、エッジケース、間違った場合のコスト。これらは会話、歴史、説明責任に生きており、モデルは要約はできても真に所有はできません。

初期の要求は「オンボーディングを滑らかにして」や「サポートチケットを減らして」といった曖昧さを帯びがちです。開発者の仕事はそれを明確な要件と受け入れ基準に翻訳することです。

その翻訳は主に人間の仕事です。なぜなら以下のような判断を引き出す探りが必要だからです:

AIは測定指標の提案や受け入れ基準の草案を出せますが、どの制約が現実的かを知るのは人間であり、要求が矛盾しているときに突き返すのも人間です。

要件作業は不快なトレードオフが表面化する場です:時間対品質、スピード対保守性、新機能対安定性。チームにはリスクを明示し、選択肢を提案し、ステークホルダーを結果に合わせて整合させる人が必要です。

良い仕様は単なるテキストではなく決定記録です。テスト可能で実装可能、入力・出力・エッジケース・失敗モードが明確であるべきです。AIは文書の構成を助けますが、正確性と「これは曖昧だから決定が必要だ」という指摘の責任は人間にあります。

システム設計は「何を作るか」が「何に基づいて作るか、そして壊れたときにどう振る舞うか」に変わる部分です。AIは選択肢を探るのに役立ちますが、結果に対する責任を持つことはできません。

モノリス、モジュラーモノリス、マイクロサービス、サーバーレス、マネージドプラットフォームのどれが合うかはクイズではありません。期待スケール、予算、タイム・トゥ・マーケット、チームのスキルがフィットするかどうかの問題です。

アシスタントはパターンを要約し参照アーキテクチャを提案できますが、あなたのチームが週替わりでオンコールしているか、採用が遅いか、データベースベンダーの契約更新が来期にあるかなどは知りません。そうした詳細がアーキテクチャの成否を決めることが多いのです。

良いアーキテクチャは主にトレードオフです:単純さ対柔軟性、性能対コスト、今の速さ対将来の保守性。AIは素早く利点/欠点リストを出せるので、決定のドキュメント化に有用です。

しかし、トレードオフが痛みを伴うときに優先順位を付けるのはビジネス的判断であり、純粋な技術判断ではありません(例:「わずかに遅い応答を受け入れて単純さと運用のしやすさを優先する」)。

サービスの境界定義、誰がどのデータを所有するか、部分的な障害時に何が起きるかは深いプロダクトと運用の文脈を要します。AIは失敗モードをブレインストーミングできますが(「支払いプロバイダが落ちたら?」)、期待される挙動、顧客向けのメッセージ、ロールバック計画を決めるのは人間です。

API設計は契約設計です。AIは例を生成したり矛盾を見つけたりできますが、バージョニング、後方互換性、長期的に何をサポートするかを決めるのはあなたです。

最も建築的な判断の一つは「作らない」と言うか、機能を削除することです。AIは機会費用や政治的リスクを測れません。チームが判断すべきです。

デバッグはAIが印象的に見えることが多い領域であり、同時に最も時間を無駄にしやすい領域でもあります。アシスタントはログをスキャンし、怪しいコードパスを指摘し、「正しそうな」修正を提案するかもしれません。しかし根本原因分析は説明を生成するだけではなく、それを証明することです。

AIの出力は結論ではなく仮説として扱ってください。多くのバグには複数の妥当な原因があり、AIは貼り付けたコードスニペットに合致するきれいな説明を選びがちで、稼働中のシステムの現実を反映していないことがあります。

実用的なワークフロー:

信頼できる再現はデバッグのスーパー・パワーです。謎をテストに変えます。AIは最小再現例を書いたり診断スクリプトを下書きしたり追加ログを提案したりできますが、どのシグナルが重要か(リクエストID、タイミング、環境差、フィーチャーフラグ、データ形状、同時実行性)はあなたが決めます。

ユーザーが「アプリが固まった」と報告したとき、その症状をどのエンドポイントが停滞したか、どのタイムアウトが発生したか、どのエラーバジェットのシグナルが変化したかに翻訳するのは人間の文脈です。

提案が検証できない場合は、それが間違っていると仮定してください。検証可能な予測をする説明を好みましょう(例:「大きなペイロードでのみ起きるはず」や「キャッシュウォームアップ後のみ発生する」など)。

原因を特定しても、ハードな判断は残ります。AIはトレードオフを概説できますが、人間が対応を選びます:

根本原因分析は最終的に説明責任です:説明、修正、再発防止への自信を所有すること。

コードレビューはスタイルのチェックリストだけではありません。チームが何を保守し、サポートし、説明責任を負うかを決める瞬間です。AIはより多くを「見つける」手助けはできますが、何が重要か、プロダクトの意図に合うか、チームが許容するトレードオフかを決められません。

AIコーディングアシスタントは疲れ知らずの第二の目のように振る舞えます。すばやく:

このように使えば、PRの「オープンからリスク発見まで」の時間を短縮できます。

正しさのレビューは単にコンパイルするかどうかではありません。人間は変更を実際のユーザ行動、本番制約、長期保守性に結び付けます。レビュワーが決めるべきこと:

AIを最終承認者ではなく第二のレビュワーとして扱ってください。ターゲットを絞ったチェックを依頼(セキュリティ、エッジケース、後方互換)し、その後人間がスコープ、優先度、チーム基準とプロダクト意図への整合を判断します。

AIはテストを素早く生成できますが、品質を所有するわけではありません。テストスイートは何が壊れ得るか、何を決して壊してはいけないか、どのエッジケースを証明せずに出荷するかという賭けの集合です。その賭けはプロダクトとエンジニアリングの判断であり、依然として人が行います。

アシスタントはユニットテストの足場、依存のモック、実装からのハッピーパスのカバレッジ生成が得意です。しかしどのカバレッジが重要かを決めることはできません。

人間が定義すること:

ほとんどのチームは「より多くのテスト」ではなく層状戦略を必要とします。AIはこれらの多くを書けますが、選択と境界は人間主導:

AI生成のテストは実装に寄り過ぎる傾向があり、壊れやすいアサーションや過剰なモックセットアップを生み、本番での振る舞いが失敗してもテストが通ってしまうことがあります。開発者は次を心掛けて防ぎます:

良い戦略はあなたの出荷方法に合致します。リリースが速いほど自動化チェックと明確なロールバック経路が必要で、ゆっくりなら事前検証を重くできる。品質のオーナーはツールではなくチームです。

品質はカバレッジ割合ではありません:テストが改善しているかを次で測りましょう:本番インシデントの減少、復旧の迅速化、より安全な変更(小さなロールバック、速やかなデプロイ自信)。AIは作業を速めますが、説明責任は開発者に残ります。

セキュリティ作業はコード生成ではなく、現実的な制約の下でトレードオフを行うことに関するものです。AIはチェックリストや一般的な間違いを浮かび上がらせることはできますが、リスク判断の責任はチームに残ります。

脅威モデリングは一般論的な運動ではありません—重要なのはあなたのビジネス優先度、ユーザー、失敗モードに依存します。アシスタントは典型的な脅威(インジェクション、認証破壊、安全でないデフォルト)を提案できますが、あなたのプロダクトにとって真に高コストなもの(アカウント乗っ取りかデータ漏洩か、サービス中断か)を確実に知ることはできません。

AIは既知のアンチパターンを認識するのが得意ですが、多くのインシデントはアプリ固有の詳細(権限のエッジケース、一時的な管理エンドポイント、承認を迂回するワークフロー)から発生します。こうしたリスクはシステムの意図を読む必要があります。

ツールはキーをハードコードしないように促せますが、完全なポリシーを所有することはできません:

AIは古いライブラリを指摘するかもしれませんが、チームはバージョンの固定、出所の検証、推移的依存のレビュー、リスクを受け入れるか修復に投資するかを決める実践が必要です。

コンプライアンスは「暗号化を追加する」だけではありません。コントロール、ドキュメント、説明責任が必要です:アクセスログ、承認の記録、インシデント手順とそれに従った証拠。AIはテンプレートを下書きできますが、証拠を検証し署名するのは人間です—監査人や顧客が最終的に頼るのはその証拠です。

AIは運用作業を速くできますが、所有権を奪うものではありません。信頼性は不確実性の下での意思決定の連鎖であり、誤った判断のコストは遅さのコストよりも高いことが多いです。

AIは運用資料(ランブック、チェックリスト、「もしXならYを試す」プレイブック)の下書きや維持、ログ要約、類似アラートのクラスタリング、一次的な仮説提案に有用です。これにより以下が速くなります:

これらは迅速化のアクセラレータですが、作業そのものではありません。

インシデントは脚本通りに進まないことがほとんどです。オンコールエンジニアは不明確なシグナル、部分的な障害、限られた時間でのトレードオフに対処します。AIは可能性のある原因を示唆できますが、別チームを呼ぶべきか、機能を無効化すべきか、データ整合性を守るために一時的な顧客影響を受け入れるべきかを確実に決めることはできません。

デプロイの安全性も人間の責任です。ツールはロールバック、フィーチャーフラグ、段階的リリースを勧められますが、チームはビジネス文脈と影響範囲を踏まえて最も安全な道を選ぶ必要があります。

AIはタイムラインの草案とチャット、チケット、監視からの主要イベント抽出を下書きできます。人間が行う重要な部分は「良い状態とは何か」を決め、修正事項の優先順位をつけ、再発を防ぐために実際に変更することです(単に同じ症状を繰り返さないための対処ではなく)。

AIをオペスの書類作成とパターン発見のコパイロットとして扱えば、速度を得つつ説明責任を手放すことはありません。

AIは「CQRSって何?」「なぜこれでデッドロックが起きるのか?」「このPRを要約して」といった概念を即座に説明できます。これはチームの高速化に寄与します。しかし職場でのコミュニケーションは情報伝達だけではなく、信頼を築き、共有された習慣を確立し、人々が頼れる約束をすることでもあります。

新人は答えだけでなくコンテキストと関係性を必要とします。AIはモジュールの要約、読書パスの提案、専門用語の翻訳で助けられますが、「ここで重要なこと」「このコードベースでの良いとは何か」「何かおかしいと感じたら誰に聞くか」を教えるのは人間です。

プロジェクトの摩擦は大抵、役割間(プロダクト、デザイン、QA、セキュリティ、サポート)で発生します。AIは会議ノートを下書きし、受け入れ基準を提案し、フィードバックを中立的に言い換えることはできます。優先順位を交渉し、曖昧さを解消し、ステークホルダーが「同意しているように見えて実は同意していない」ことに気付くのは人です。

責任があいまいだとチームは失敗します。AIはチェックリストを生成できますが、強制はできません。人間が「完了」の定義(テスト?ドキュメント?ロールアウト計画?モニタリング?)と、マージ後に誰が何を所有するかを定義する必要があります—特にAI生成コードが複雑さを隠している場合は重要です。

ツールが実行を助けるタスクと、チームが成果として責任を負う責任を分けて考えるためのフレームワークです。

なぜなら、チームは“タスク”を出荷するのではなく“成果”を出荷するからです。

アシスタントがコードやテストを下書きしても、チームが依然として負うものは:

つまり、責任に焦点を当てるべきです。

「置き換え」と呼べるのは、境界が明確で検証しやすく低リスクな作業です。

代表例:

エラーを明白かつ安価にするガードレールを使うこと:

プロフェッショナルな開発では隠れた制約が多いため、多くの場合AIは「拡張」になるからです。モデルが推測しにくいもの:

AIの出力は下書きとして扱い、自分のシステムに合わせて手を入れてください。

AIを結論ではなく仮説と証拠プランを出す道具として使ってください。

実用的なループ:

検証できない提案は、証明されるまで間違っていると仮定してください。

AIは問題を見つける手助けをするが、人間が何を出荷するかを決める。

有効なAIレビューの使い方:

その後、人間が意図、保守性、リリースリスク(ブロッキングかフォローアップか)を判断する。

AIは多くのテストを下書きできるが、どのカバレッジが重要かを決める責任は負えない。

人間が引き続き責任を持つこと:

AIはスキャフォールディングやエッジケースの検討に使い、品質責任者は人間であるべきです。

というのも、これらの決定はビジネス文脈や長期的な説明責任に依存するため、自動化に向かないからです。

AIができること:

しかし人間が決めるべきこと:

秘密情報や顧客データをプロンプトに貼り付けないでください。

実践的ルール: