2025年11月10日·1 分

AI構築システムにおけるスキーマ変更とマイグレーション:ガイド

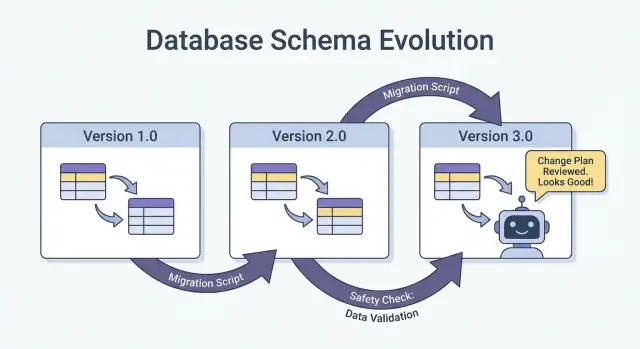

AIで生成されたシステムでスキーマ変更を安全に扱う方法:バージョン管理、後方互換のロールアウト、データマイグレーション、テスト、可観測性、ロールバック戦略を実践的に解説します。

AI構築システムにおける「スキーマ」の意味

スキーマとは、簡単に言えばデータの形と各フィールドが何を意味するかについての共通合意です。AIで生成されたシステムでは、その合意はデータベースのテーブルだけでなく、もっと多くの場所に現れ、チームが想定するより頻繁に変わります。

スキーマはデータベースだけの話ではない

スキーマは少なくとも次の4つの層で出会います:

- データベース:テーブル/カラム名、データ型、制約、インデックス、リレーション。

- API:リクエスト/レスポンスのJSONの形、必須/任意フィールド、列挙型、エラーフォーマット、ページネーションの慣習。

- イベントやメッセージ:ストリーム、キュー、Webhookを通るペイロード(消費者を通じて暗黙にバージョン管理されることが多い)。

- 設定と契約:機能フラグ、環境変数、YAML/JSON設定、ファイル形式や命名規則のような「暗黙の契約」。

システムの二つの部分がデータをやり取りするなら、誰も書いていなくてもスキーマが存在します。

なぜAI構築システムではスキーマ変更が増えるのか

AI生成コードは開発を大幅に加速しますが、同時に変更の頻度も高めます:

- 生成されたコードは最新のプロンプトやコンテキストを反映するため、プロンプトの小さな調整でフィールド名、ネスト、デフォルト、バリデーションが変わることがあります。

- 要件が速く進化する:新しいエンドポイントやパイプラインのステップを出すコストが低いと、変更が頻繁になります。

- 慣習の不一致(snake_caseとcamelCase、

idとuserIdなど)が、複数の生成やリファクタリングで混在しやすくなります。

結果として、プロデューサーとコンシューマーの間で「契約のズレ(contract drift)」が起きやすくなります。

もしあなたのワークフローが(例えばハンドラ、DBアクセス層、統合をチャットで生成するような)vibe-codingであるなら、初日からスキーマの規律をワークフローに組み込む価値があります。Koder.aiのようなプラットフォームはReact/Go/PostgreSQLやFlutterアプリをチャットから生成してチームの作業を早めますが、出荷が早いほどインターフェースをバージョン管理し、ペイロードを検証し、意図的にロールアウトすることが重要になります。

本ガイドの目的

本記事は、本番を安定させつつ素早くイテレーションするための実践的方法に焦点を当てます:後方互換性の維持、安全なロールアウト、データの予期せぬ問題なく移行する方法です。

ここでは扱わないこと

理論重視のモデリングや形式手法、ベンダー固有の機能に深くは踏み込みません。強調するのは、手書きコードでもAI支援でも、あるいはほとんどAI生成であっても適用できるパターンです。

なぜAI生成コードだとスキーマ変更が増えるのか

AI生成コードはスキーマ変更を「普通」に感じさせます。これはチームが不注意だからではなく、システムへの入力がより頻繁に変わるからです。アプリの振る舞いがプロンプト、モデルバージョン、生成されたグルーコードに部分的に依存すると、データの形は時間とともにドリフトしやすくなります。

実務でよく見るトリガー

繰り返しスキーマの変化を起こすパターン:

- 新機能:新しいフィールドを追加(例:

risk_score、explanation、source_url)したり、ある概念を分割(例:addressをstreet、city、postal_codeに分ける)。 - モデル出力の変化:新しいモデルがより詳細な構造や異なる列挙値、わずかな命名の違い(「confidence」対「score」)を出す。

- プロンプトの更新:品質改善を目的としたプロンプトの調整が、意図せずフォーマットや必須フィールド、ネストを変えてしまう。

AIシステムを脆弱にする危険なパターン

AI生成コードは短時間で「動く」ことが多い一方で、壊れやすい前提を組み込みがちです:

- 暗黙的な仮定:フィールドが常に存在する、常に数値である、特定の範囲内にある、とコードが勝手に仮定する。

- 隠れた結合:あるサービスが別のサービスの内部フィールド名や順序に依存し、定義されたインターフェースを使わない。

- 未文書化のフィールド:モデルが新しいプロパティを吐き出し、下流のコードが誰の合意もなくそれに依存し始める。

なぜAIは変更頻度を増幅するか

コード生成は迅速な反復を促します:ハンドラ、パーサー、DBアクセス層を要件の変化に合わせて再生成しがちです。その速さは有益ですが、小さなインターフェース変更を繰り返し出荷することを容易にし、気づかずに進めてしまうことがあります。

より安全な考え方は、すべてのスキーマを契約として扱うことです:データベーステーブル、APIペイロード、イベント、さらには構造化されたLLMの応答も。消費者が依存するなら、バージョン管理し、検証し、意図的に変更してください。

スキーマ・インターフェースのバージョニング戦略

バージョニングは他のシステム(と将来の自分)に「ここが変わった、リスクはこうだ」と伝える方法です。目的は書類作成ではなく、クライアント、サービス、データパイプラインが異なる速度で更新される際の無音の破壊を防ぐことです。

平易な意味論的バージョン思考

実際に1.2.3のように公開しなくても、major / minor / patchの観点で考えてください:

- Major(メジャー):破壊的な変更。古い消費者は修正なしでは失敗する可能性がある。

- Minor(マイナー):安全な追加。古い消費者は動作し続け、新しい消費者が新機能を使える。

- Patch(パッチ):意味を変えないバグ修正や明確化。

チームを救うシンプルなルール:既存フィールドの意味を黙って変えない。たとえば status="active" が「支払い中の顧客」を意味していたのに、それを「アカウントが存在する」に再定義しないでください。新しいフィールドか新バージョンを追加しましょう。

バージョン付きエンドポイント vs フィールド単位のバージョン

実務では二つの現実的な選択肢があります:

- バージョン付きエンドポイント(例:

/api/v1/ordersと/api/v2/orders)

- 破壊的または大規模な変更に適する。明示的だが、複製と長期的なメンテナンスを生む可能性がある。

- フィールド単位でのバージョン/付加的な進化(例:

new_fieldを追加し、old_fieldを残す)

- 付加的に変更できる場合に有効。古いクライアントは未知のフィールドを無視し、新しいクライアントが新フィールドを読む。時間をかけて古いフィールドを非推奨にして削除する計画を立てる。

イベントスキーマとレジストリ

ストリーム、キュー、Webhookでは、消費者があなたのデプロイ制御外にいることが多い。スキーマレジストリ(または中央化されたスキーマカタログ)を使い、「追加のみ許可」などのルールを強制すると、どのプロデューサーとコンシューマーがどのバージョンに依存しているかが明確になります。

安全なロールアウト:展開/縮小(Expand/Contract)(最も確実なパターン)

特に複数のサービスやジョブ、AI生成コンポーネントがある場合、スキーマ変更の最も安全な出し方はexpand → backfill → switch → contractパターンです。ダウンタイムを最小化し、一つの遅れている消費者が本番を壊す事態を避けます。

4つのステップ(なぜ機能するか)

1) Expand(拡張):後方互換な方法で新スキーマを導入します。既存のリーダー/ライターは変更なしで動き続けるべきです。

2) Backfill(バックフィル):過去データに新フィールドを埋め、システムを一貫させます。

3) Switch(切替):ライターとリーダーを新フィールド/フォーマットに切り替えます。カナリアや割合ロールアウトで徐々に行うことができます。スキーマが両方をサポートしているため安全です。

4) Contract(収束):依存がなくなったと確信したら古いフィールド/フォーマットを取り除きます。

二段階(expand → switch)や三段階(expand → backfill → switch)のロールアウトはダウンタイムを低減します。ライターを先に動かし、リーダーを後から動かす、またはその逆が可能だからです。

例:カラムを追加し、バックフィルして必須にする

customer_tierを追加したいとします。

- Expand:

customer_tierをNULL許容で追加。 - Backfill:既存行に対してティアを計算して埋めるジョブを実行。

- Switch:アプリとパイプラインを更新して常に

customer_tierを書くようにし、リーダーはそれを優先するようにする。 - Contract:監視後、

NOT NULLに変更(必要ならレガシーロジックを除去)。

調整:ライターとリーダーは合意すること

すべてのスキーマをプロデューサー(ライター)とコンシューマー(リーダー)間の契約として扱ってください。AI生成されたコードは新しいコードパスを素早く出すため、見落としがちです。ロールアウトを明示化し、どのバージョンが何を書くか、どのサービスが両方を読めるか、古いフィールドを取り除く「契約日」を文書化しましょう。

データベースマイグレーション:本番を壊さずにデータを変える方法

ロールバック対応でリリース

リスクのあるマイグレーション前にスナップショットを取得しておけば、問題が発生しても迅速に復旧できます。

データベースマイグレーションは、本番データと構造を安全な状態から次の状態へ移すための「手順書」です。AI生成システムでは、生成コードがカラムの存在を仮定したり、フィールド名を不整合にリネームしたり、既存行を無視した制約を変えたりするため、より重要になります。

マイグレーションファイル vs 自動マイグレーション

マイグレーションファイル(ソース管理にチェックイン)は「Xカラムを追加」「Yインデックスを作成」「AからBへデータコピー」のような明示的なステップです。監査可能でレビューでき、ステージングや本番で再生できます。

自動マイグレーション(ORMやフレームワークによる)は、初期開発やプロトタイピングには便利ですが、本番に触れると危険な操作(カラム削除やテーブル再構築)を行ったり、意図しない順序で変更したりすることがあります。

実務的なルール:本番に影響する変更は、自動マイグレーションでドラフトし、その後レビュー済みのマイグレーションファイルに変換して使ってください。

冪等性と順序

可能な限りマイグレーションを冪等にしてください:再実行してもデータを壊さない、途中で失敗しても安全であることが望ましい。「存在しない場合に作成する」や、新しいカラムはまずNULL許容で追加、データ変換にはチェックを入れるとよいです。

また明確な順序を保ちましょう。すべての環境(ローカル、CI、ステージング、本番)は同じマイグレーションシーケンスを適用すること。手作業で本番を直した場合は、そのSQLをマイグレーションに取り込んで記録してください。

テーブルロックを伴わない長時間実行のマイグレーション

大きなテーブルでロックが発生すると書き込み(あるいは読み取り)がブロックされることがあります。リスクを減らす方法:

- データベースがサポートするオンライン/ロック最小化操作を使う(例:並列インデックス構築)。

- 変更を分割する:まず新しい構造を追加し、バッチでバックフィルしてからアプリを切り替える。

- 重い操作はトラフィックの少ない時間帯にスケジュールし、タイムアウトと監視を設定する。

マルチテナントやシャード構成

マルチテナントでは各テナントごとに制御されたループでマイグレーションを実行し、進捗追跡と安全な再試行を行ってください。シャードでは各シャードを独立した本番環境のように扱い、シャードごとにロールしてヘルスを確認してから次へ進めます。これにより障害範囲が限定され、ロールバックが現実的になります。

バックフィルと再処理:既存データの更新

バックフィルは、新しく追加したフィールド(や修正された値)を既存レコードに埋める操作です。再処理は履歴データをパイプラインに再投入することで、ビジネスルールの変更、バグ修正、モデル/出力フォーマットの更新が理由になります。

スキーマ変更後には両方が一般的です:新しい形で「新データ」を書き始めるのは簡単ですが、本番システムは過去データの一貫性にも依存します。

よくあるアプローチ

オンラインバックフィル(本番で段階的に実行):小さなバッチでレコードを更新し、本番を稼働させたまま進めます。負荷を抑え、停止や再開が容易です。

バッチバックフィル(オフラインやスケジュール実行):低トラフィック時に大きな塊を処理します。運用は単純ですがDB負荷がスパイクする可能性があり、失敗からの回復に時間がかかることがあります。

読み取り時の遅延バックフィル(Lazy backfill):古いレコードを読み取った際にアプリが欠損フィールドを計算して書き戻します。コストを時間で分散できる一方、初回読み取りが遅くなり、長期間変換されないデータが残ることがあります。

実際には、遅延バックフィルをロングテールに使い、最も頻繁にアクセスされるデータにはオンラインジョブを併用することが多いです。

バックフィルの検証方法

検証は明示的かつ測定可能であるべきです:

- 件数:更新されるべき行/イベント数と実際に更新された数。

- チェックサム/集計:前後で合計(例:金額の合計、ユニークIDの数)を比較。

- サンプリング:統計的に意味のあるサンプルでスポットチェックし、エッジケースを含める。

また、ダッシュボード、検索インデックス、キャッシュ、エクスポートなど下流影響も検証してください。

コスト、時間、受け入れ基準

バックフィルは速さ(短時間で完了)とリスク/コスト(負荷、計算、運用)のトレードオフです。事前に「完了」の定義、想定実行時間、許容エラー率、検証失敗時の対応(停止、再試行、ロールバック)を決めておきましょう。

イベント・メッセージスキーマの進化(ストリーム、キュー、Webhook)

スキーマはデータベースだけにあるわけではありません。システム間でデータを送るとき—Kafkaトピック、SQS/RabbitMQキュー、Webhookペイロード、オブジェクトストレージに書かれた「イベント」—には常に契約があります。プロデューサーとコンシューマーが独立して動くため、これらの契約は単一アプリの内部テーブルより壊れやすい傾向があります。

最も安全なデフォルト:イベントは後方互換的に進化させる

イベントストリームやWebhookペイロードでは、古いコンシューマーが無視できる変更を優先してください。

実践ルール:フィールドを追加し、削除や名前変更を避ける。非推奨にする場合も一定期間は送信し続け、ドキュメントに明記しましょう。

例:OrderCreatedイベントに任意フィールドを追加する。

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

古いコンシューマーはorder_idとcreated_atだけを読み、残りを無視します。

コンシューマ駆動の契約(プレーンな英語版)

プロデューサーが他者を想像で壊すより、消費者が依存する内容(フィールド、型、必須・任意のルール)を公開する方が良いです。プロデューサーは出荷前にその期待値に対して検証を行います。これは、モデルがフィールド名を勝手に変えたり型を変えたりしがちなAI生成コードベースで特に有効です。

「未知のフィールド」を安全に扱う

パーサーを寛容にする:

- 未知のフィールドはデフォルトで無視する(新しいキーが出たからといって失敗しない)。

- 新フィールドは必須にせず任意とし、真に必要になるまで扱いを厳しくしない。

- 予期しないフィールドは低レベルでログに残し、アダプション状況を観察する。

破壊的変更が必要な場合は、新しいイベントタイプやバージョン名(例:OrderCreated.v2)を使い、すべてのコンシューマーが移行するまで両方を並行して送る。

AI出力をスキーマとして扱う:プロンプト、モデル、構造化レスポンス

次のスキーマ変更を計画する

コード生成前に、プランニングモードで expand-backfill-switch-contract をマッピングします。

LLMをシステムに組み込むと、その出力は形式的な仕様がなくても事実上のスキーマになります。下流コードは「summaryフィールドがある」「最初の行がタイトルだ」「箇条書きはダッシュで区切られる」といった前提を持ち、それが時間とともに硬直化します。モデルの振る舞いが少し変わるだけで、データベースのカラム名変更と同じように壊れます。

明示的な構造を好み、検証する

「見た目のテキスト」をパースする代わりに、構造化された出力(通常JSON)を要求し、それを下流に渡す前に検証してください。これはベストエフォートから契約へ移行することに相当します。

実践手順:

- モデル応答のJSONスキーマ(あるいは型定義)を定義する。

- 無効な応答は拒否または隔離する(黙って補正しない)。

- 検証エラーをログに残し、何が変わっているかを可視化する。

これは特に、LLM応答がデータパイプライン、自動化、ユーザー向けコンテンツに使われる場合に重要です。

モデルドリフトに備える

同じプロンプトでも応答が時間とともに変わることがあります:フィールドが欠落したり、余分なキーが出たり、型が変わったり("42" と 42、配列と文字列の違い)。これらをスキーマ進化の一種として扱ってください。

有効な軽減策:

- 合理的にフィールドを任意にし、明示的なデフォルトを設定する。

- 不明なキーを許容して安全に無視する(コンプライアンス上厳格でない限り)。

- ガードレールチェックを追加する(必須フィールド、最大長、列挙値など)。

プロンプト変更をAPI変更のように扱う

プロンプトもインターフェースです。変更するならバージョン管理してください。prompt_v1、prompt_v2を保ち、機能フラグ、カナリア、テナントごとのトグルで段階的にロールアウトしましょう。変更を昇格する前に固定評価セットでテストし、下流が適応するまで古いバージョンを動かし続けてください。安全なロールアウトの仕組みの詳細については /blog/safe-rollouts-expand-contract にあなたの方法を紐づけてください。

スキーマ変更のテストと検証

スキーマ変更は退屈で高価な失敗(ある環境でカラムが欠ける、消費者が古いフィールドを期待する、空のデータでマイグレーションは通るが本番でタイムアウトする)で失敗しがちです。テストはそれらの「驚き」を予測可能で修正可能な作業に変えます。

検出するための3レベルのテスト

ユニットテスト:マッピング関数、シリアライザ/デシリアライザ、バリデータ、クエリビルダなどローカルロジックを保護します。フィールド名や型が変わればユニットテストはコードに近いところで失敗します。

統合テスト:実際の依存関係(実DBエンジン、実マイグレーションツール、実際のメッセージフォーマット)とアプリがまだ動くか確認します。ORMモデルが変わったがマイグレーションがない、といった問題をここで捕まえます。

エンドツーエンドテスト:サービス間をまたいだユーザーワークフローをシミュレーションします:データ作成、マイグレーション適用、APIで読み返し、下流の動作が正しいか検証します。

プロデューサーとコンシューマーのための契約テスト

スキーマ進化は境界で壊れることが多い:サービス間API、ストリーム、キュー、Webhook。契約テストを両側に導入しましょう:

- プロデューサーは合意された契約に合うイベント/応答を出せることを証明する。

- コンシューマーはロールアウト中に古いバージョンと新しいバージョンの両方を解析できることを証明する。

マイグレーションテスト:クリーン環境での適用とロールバック

マイグレーションはデプロイ手順通りにテストする:

- クリーンなデータベーススナップショットから開始。

- すべてのマイグレーションを順に適用。

- アプリが読み書きできることを検証。

- ロールバック(サポートされていれば)やダウンマイグレーションを実行して、元の動作に戻ることを確認。

旧スキーマと新スキーマ用のフィクスチャ

小さなフィクスチャセットを保管:

- 以前のスキーマで書かれたデータ(レガシー行/イベント)。

- 新スキーマで書かれたデータ。

これらは回帰を明白にし、AI生成コードが微妙にフィールド名やオプショナル性を変えたときに役立ちます。

可観測性:壊れを早期に検出する

APIのスキーマをバージョン管理

加法的に進化するエンドポイントを生成し、本番前にペイロードを検証します。

スキーマ変更はデプロイ直後に大声で失敗することは稀です。多くの場合、パースエラーのゆっくりした増加、未知フィールドの警告、データ欠落、バックグラウンドジョブの遅延として現れます。良い可観測性はそれらの弱いシグナルを、ロールアウトを停止できるうちに対処可能なフィードバックに変えます。

ロールアウト中に監視すべきこと

まず基本(アプリの健全性)を押さえ、次にスキーマ固有の指標を加えます:

- エラー:4xx/5xxの急増だけでなく、JSONパース失敗、デシリアライズ失敗、リトライも。

- レイテンシ:p95/p99の応答時間、キュー処理時間。スキーマ変更はジョイン増加や大きなペイロード、追加バリデーションを招くことがある。

- データ品質指標:重要カラムのNULL率増加、イベント量の急落、新しい「デフォルト」値の頻出、旧・新表現の不一致。

- パイプライン遅延:コンシューマーラグ、Webhook配信のバックログ、マイグレーションジョブのスループット。

重要なのは前後比較と、クライアントバージョン、スキーマバージョン、トラフィックセグメント(カナリア対安定)でスライスすることです。

役立つダッシュボード

2つのビューを作ると良いです:

-

アプリ挙動ダッシュボード

- リクエスト率、エラー率、レイテンシ(RED)

- 上位例外(メッセージでグルーピング)

- バリデーション/パースエラーの件数と割合

- ペイロードサイズ分布(異常に大きなメッセージ検出)

-

マイグレーションとバッチジョブのダッシュボード

- マイグレーション進捗(%完了)、処理行/sec、ETA

- 失敗率とリトライ数

- キュー深度/コンシューマーラグ

- デッドレターキューのボリューム

expand/contractロールアウトを行うなら、旧スキーマ/新スキーマ別の読み書き比率を示すパネルを含めると、次のフェーズに進んで良いか判断しやすくなります。

スキーマ固有の失敗に対するアラート

データが落ちたり誤読されていることを示す問題でページを鳴らす設定:

- スキーマ検証エラー率が低い閾値を超えたとき(しばしば0.1%未満でも意味がある)

- パース/デシリアライズ失敗(特定のプロデューサー/コンシューマーに偏っている場合は重要)

- 予期しないフィールド/必須フィールド欠落の警告が増加しているとき

- マイグレーションジョブが停滞(N分間進捗なし)やラグがスループットより速く増加しているとき

生の500エラーだけのノイズアラートは避け、スキーマロールアウトのタグ(スキーマバージョンやエンドポイント)で関連づけてください。

デバッグを早くするためにバージョンをログに残す

移行期間中は次を含めてログに残してください:

- スキーマバージョン(例:

X-Schema-Versionヘッダー、メッセージのメタデータフィールド) - プロデューサー/コンシューマーのアプリバージョン

- モデルバージョン/プロンプトバージョン(AI生成出力が構造化データを供給する場合)

この1点があれば「なぜこのペイロードが失敗したのか?」を数分で解明でき、数日を要する問題を避けられます—特に異なるサービスや異なるAIモデルバージョンが同時に稼働しているときに有効です。

ロールバック、復旧、チェンジマネジメント

スキーマ変更の失敗には二種類あります:変更自体が間違っている場合、または変更周辺のシステムが期待と異なる振る舞いをする場合(特にAI生成コードが微妙な前提を導入したとき)。どちらにせよ、すべてのマイグレーションは出荷前にロールバック方針を持つべきです—それが「ロールバックなし」という判断であってもです。

「ロールバックなし」を選ぶのは、カラム削除や識別子の書き換え、重複除去のように不可逆な変更で妥当な場合があります。しかし「ロールバックなし」でも計画が不要なわけではありません。前向きな修正(forward fixes)、バックアップからの復元、影響の封じ込めなどの方針を明示してください。

実用的なロールバックオプション

機能フラグ/設定ゲート:新しいリーダー、ライター、APIフィールドをフラグでラップし、再デプロイせずに新挙動をオフにできます。AI生成コードが構文的には正しくても意味的に誤っている場合に有効です。

デュアルライトを無効化する:expand/contractロールアウトで古い・新しいスキーマに同時書き込みする場合、新しい書き込み経路を停止するキルスイッチを用意しておくと、さらなる乖離を止められます。

リーダーのロールバック(ライターだけでなく):多くの障害は消費者が新しいフィールドやテーブルを早く読み始めることから起きます。サービスが前のスキーマバージョンに戻す、または新フィールドを無視するのを容易にしておきましょう。

可逆性の限界を知る

元に戻せないマイグレーションもあります:

- 破壊的変換(ハッシュ化、ロスのある正規化)

- バックアップを残さない削除/リネーム

- ソース・オブ・トゥルースを書き換えるバックフィル

これらの場合はバックアップからの復元、イベントからの再生、原始入力からの再計算を計画し、必要な入力がまだ手元にあるかを確認してください。

出荷前チェックリスト(事前確認)

- ロールバック方針を文書化(「revert」「forward fix」「no rollback + restore path」など)。

- 明確な停止ボタン:フラグやデュアルライト無効スイッチ。

- バックアップ/スナップショットの検証;復元を少なくとも一度テスト済み。

- マイグレーションは冪等;再実行してデータを壊さない。

- エラー率、スキーマ検証失敗、ラグの監視とアラート設定。

- 責任範囲の明確化:誰が承認し、誰が実行し、誰がオンコールか。

優れたチェンジマネジメントはロールバックを稀にし、発生時には退屈な作業にします。

もしチームがAI支援で速くイテレーションしているなら、これらの実践を安全な実験を支援するツールと組み合わせると効果的です。たとえばKoder.aiは事前の変更設計のためのplanning modeや、生成された変更が契約をずらしたときのためのスナップショット/ロールバック機能を提供します。迅速なコード生成と規律あるスキーマ進化を組み合わせれば、本番をテスト環境にすることなくスピードを出せます。