2025年5月03日·1 分

自動テスト生成がAI生成ロジックを補完する理由と実践

自動生成テストがAI生成のアプリロジックと相性が良い理由と、コード・テスト・CIを連携させて品質を向上させるワークフローの作り方を学ぶ。

自動生成テストがAI生成のアプリロジックと相性が良い理由と、コード・テスト・CIを連携させて品質を向上させるワークフローの作り方を学ぶ。

AIが書いたアプリケーションロジックとは、アシスタントの助けでコードベースの“動く部分”が下書きされることを指します:新しい関数、小さな機能、リファクタ、エッジケース処理、既存モジュールの書き換えなど。何を作るかは依然あなたが決めますが、最初の実装は速く届き、時には後で気づくような仮定を含んでいることがあります。

自動テスト生成は検証側のマッチング能力です。すべてのテストを手で書く代わりに、ツールがコード、仕様、あるいは過去のバグから学んだパターンに基づいてテストケースやアサーションを提案できます。実務では次のようになります:

生成されたテストは誤解を招くことがあります。現在の振る舞いをアサートしてしまい、その振る舞い自体が間違っている場合や、人間の頭の中やチケットコメントにあるプロダクトルールを見落とすことがあります。だからこそ人間によるレビューが重要です。テスト名、セットアップ、アサーションが実際の意図を反映しているかを確認する人が必要です—単に現行コードがやっていることをそのまま写しているだけではいけません。

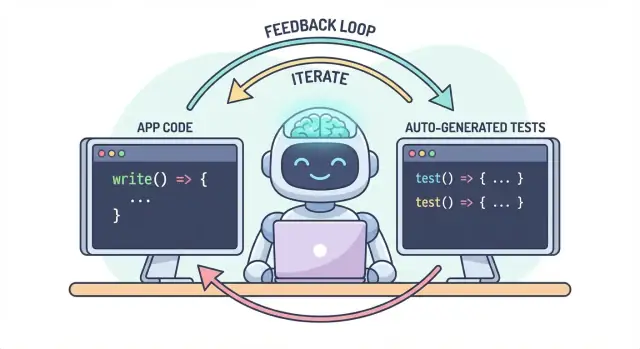

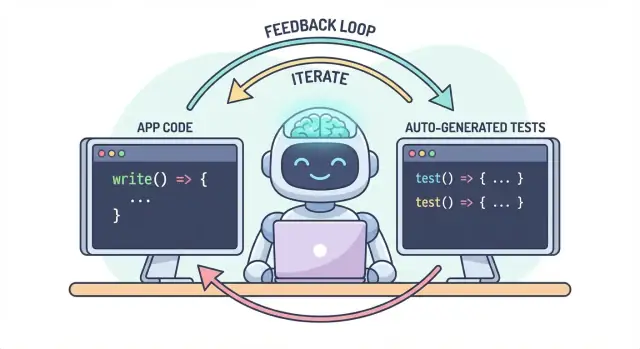

コアの考え方はシンプルです:コードとテストは一つのワークフローとして一緒に進化すべきです。AIがロジック変更を手早く手伝うなら、自動テスト生成は意図した振る舞いを同じ速さで固定化します—次の変更(人間でもAIでも)が「正しいまま」かどうかの実行可能な定義が明確になります。

実務では、この「ペア出力」アプローチはチャット駆動の開発フローが既にあるときに維持しやすいです。たとえば、Koder.ai のようなチャットでウェブ・バックエンド・モバイルアプリを作るプラットフォームでは、「機能+テスト」を単一の成果物として扱うのが自然です:振る舞いを説明して、実装を生成し、同じ会話のループ内でテストを生成してレビューしてからデプロイします。

AI生成コードはスーパーパワーのように感じられます:機能が素早く現れ、ボイラープレートが消え、かつて何時間もかかったリファクタがコーヒーが冷める前に終わることもあります。問題は、速度がリスクの形を変えることです。コードが簡単に作れると、ミスを出荷するのも簡単になります—しかも時に微妙なものです。

AIアシスタントは「合理的な」実装を生成するのが得意ですが、合理的=あなたのドメインで正しい とは限りません。

エッジケースが最初の犠牲になります。AI生成ロジックはハッピーパスをうまく扱う一方で境界条件でつまずくことが多いです:空入力、タイムゾーンの問題、丸め誤差、null値、リトライ挙動、あるいは「起きないはず」の状態が本番で起きるケースなど。

間違った仮定も頻出します。アシスタントは明言されていない要件を推測するかもしれません(「ユーザーは常に認証されている」「IDは数値」「このフィールドは常に存在する」など)、あるいは馴染みのあるパターンを実装してあなたのシステムのルールに合わないことがあります。

サイレントな回帰は最も高コストになることが多いです。小さな変更を求めるとアシスタントがロジックの一部を丸ごと書き換え、別の部分が目に見えるエラーなしに壊れることがあります。コンパイルは通り、UIは読み込まれるが、価格ルールや権限チェック、データ変換が微妙に変わっている――こうしたケースが怖いのです。

コード変更が加速すると、手動テストはボトルネックか賭けになります。クリック検証に時間をかければ納期が遅れ、テストを減らせば抜けが増えます。規律あるQAチームでさえ、頻繁で広範な変更を手動でカバーするのは難しいです。

さらに、手動チェックは再現が難しいです。誰かの記憶かチェックリストに残り、締め切りが厳しくなると簡単にスキップされます—まさにリスクが高まるときに。

自動化テストは耐久性のある安全網を作ります:期待を実行可能にします。良いテストは「この入力とこのコンテキストではこうなる」ということを示します。これは検証だけでなく、将来のあなた、チームメイト、あるいはAIアシスタントへのコミュニケーションでもあります。

テストがあると変更が怖くなくなります。フィードバックが即時だからです。コードレビューやステージング、本番のお客様から問題を知るのではなく、変更から数分で問題を発見できます。

バグは早く見つかるほど修正が安くなります。テストはフィードバックループを短くします:意図がまだ鮮明なうちに矛盾や見落としを表面化させます。それにより手戻りが減り、“fix-forward”のようなパッチを避け、AIの速度がAIによるチャーンに変わるのを防ぎます。

AI生成コードは会話として扱うと最も速くなります。テストはその会話を測定可能にします。

仕様:何が起きるべきかを記述する(入力、出力、エッジケース)。

コード:AIがその説明に合う実装を書く。

テスト:あなた(あるいはAI)がその振る舞いが実際に正しいことを証明するチェックを生成する。

このループを繰り返すことで、単にコードを増やすのではなく「完了」の定義を継続的に厳密にしていきます。

「無効なユーザーを優雅に扱う」といった曖昧な要求はコードだと見落とされがちです。テストは曖昧さを許しません。具体性を強制します:

テストに表現しようとすると、曖昧な部分がすぐに表面化します。その明確さはAIへのプロンプトを改善し、よりシンプルで安定したインターフェースにつながることが多いです。

AIコードは正しく見えても仮定を隠していることがあります。生成テストはコードが主張することを検証する現実的手段です:

目的は生成テストを盲信することではなく、構造化された速い疑いとして使うことです。

失敗したテストは実行可能なフィードバックです:仕様と実装の具体的な不一致を指し示します。「修正して」とAIに漠然と頼む代わりに、失敗を貼り付けて「公開APIを変えずにこのテストが通るようにコードを更新して」と指示できます。こうするとデバッグは推測ゲームではなく、焦点を絞った反復になります。

自動テスト生成は既存のテスト戦略、特に古典的な「テストピラミッド」を補強するときに最も有益です。ピラミッドはそれ自体がルールなのではなく、フィードバックを速く信頼できるものに保ちながら現実的な障害も捉えるための考え方です。

AIは各層のテスト生成を助けられますが、最良の成果は安価なテスト(ピラミッドの底)を多く、コストの高いテスト(上部)を少なく生成することで得られます。このバランスがCIを迅速に保ちつつユーザー体験を守ります。

ユニットテストは個別の関数・メソッド・モジュールを小さくチェックします。実行が速く外部システムを必要とせず、AI生成による境界値カバレッジに最適です。

自動生成テストの有効な使い方:

ユニットテストは範囲が狭いためレビューしやすく、フレークになりにくいです。

統合テストは部品がどのように連携するかを検証します:APIとDB、サービス間呼び出し、キュー処理、認証など。

AI生成の統合テストは有用ですが、より規律が必要です:

これらはコンポーネント間の契約チェックとして考えてください。

E2Eは主要なユーザーフローを検証しますが最も高コストです:実行が遅く壊れやすくデバッグが難しい。

自動生成はE2Eシナリオの草案作成に役立ちますが、厳選して使うべきです。サインアップ、チェックアウト、コアワークフローなど重要なパスを少数残し、すべての機能に対してE2Eを生成しようとしないでください。

すべてを生成しようとしないでください。代わりに:

このアプローチはピラミッドを保持し、自動テスト生成を雑音ではなく力の乗数にします。

自動テスト生成は「この関数のユニットテストを書け」だけに限りません。最も有用なジェネレーターはコード、そこに込められた意図、そして既に起きた失敗の三つを引き出します。

関数やモジュールを与えると、入力/出力、分岐、例外パスからテストケースを推論できます。一般に:

これはAI生成ロジックの周りを素早くチェックで囲むのに適しています。

受け入れ基準やユーザーストーリー、例示表がある場合、ジェネレーターはそれらをテストに変換できます。これはコード由来のテストより価値が高いことが多いです—「現在の挙動」ではなく「あるべき挙動」を固定化するからです。

実用パターン:具体例(入力+期待結果)を数件与え、それに沿ったエッジケースを追加するよう頼む。

バグベースの生成は意味のある回帰スイートを素早く構築する最短ルートです。再現手順(あるいはログや最小ペイロード)を与えると:

レンダリングされたUIやシリアライズされたレスポンスのように出力が安定している場合、スナップショットテストは効率的です。だが大きなスナップショットは微妙な間違いを「承認」してしまうことがあります。小さく焦点を絞ったスナップショットを好み、正しくなければならない主要フィールドに対するアサーションを併用してください。

自動テスト生成は明確な優先順位を与えると最も効果的です。コードベース全体に対して「すべてのテストを作れ」と指示するとノイズが増え、価値の低いチェックや重複、保守しにくいテストが増えます。

壊れたときのコストが最も高いフローから始めます—金銭的、法的、評判に関わるものを優先します。単純なリスクベースのフィルタでスコープを現実的に保ちつつ品質を素早く向上させられます。

まず焦点を当てるべきは:

各フローについて、レイヤーごとにテストを生成します:トリッキーなロジックのためのいくつかの高速ユニットテスト、そして全経路が動くことを確認する1〜2本の統合テスト。

理論的なすべての組み合わせではなく、実際に起きる失敗に合わせたカバレッジを求めてください。良い出発点は:

必要ならバグやインシデントを基に拡張できます。

ルールを明示にします:テストが存在するまで機能は完了としない。AI生成コードではこの定義はさらに重要です。これにより「速く出荷する」ことが「速い回帰」に変わるのを防げます。

この期待を定着させるにはワークフローに組み込みます(例:マージ前に関連テストを必須にするCIルール)やチームドキュメントにリンクしておく(例:/engineering/definition-of-done)。

AIはテストを素早く生成できますが、品質は尋ね方に大きく依存します。目標はモデルを「振る舞いを守るテスト」へ導くこと—単にコードを実行するだけのテストではありません。

まずテストの“形”をピン留めして出力がリポジトリのスタイルに合うようにします。

含めるべきもの:

should_<behavior>_when_<condition>)src/ と tests/ または __tests__/)これによりモデルがチームで使わないパターンを勝手に作るのを防げます。

既存のテストファイル(または短い抜粋)を貼って「このスタイルに合わせて」と明示します。これでテストデータの配置、変数命名、テーブル駆動テストの好みなどが固定されます。

プロジェクトにヘルパー(buildUser() や makeRequest())がある場合、それらのスニペットも含めて、生成されたテストがそれらを再利用するようにしてください。

「良い」テストとは何かを明示してください:

便利なプロンプト行例:「各テストは少なくとも一つのビジネス振る舞いに関するアサーションを含めること('例外が投げられない'だけでは不可)。」

AI生成スイートはハッピーパスに偏りがちです。これに対抗するために:

を要求します。

Generate unit tests for \u003cfunction/module\u003e.

Standards: \u003clanguage\u003e, \u003cframework\u003e, name tests like \u003cpattern\u003e, place in \u003cpath\u003e.

Use these existing patterns: \u003cpaste 1 short test example\u003e.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

(注:上のコードブロックは翻訳せず、そのままリポジトリ用のプロンプトテンプレートとして使ってください。)

AIは大量のテストを素早く草案しますが、それがあなたの意図を表しているかの最終判断はできません。人間のチェックが「実行されるテスト」を「我々を守るテスト」に変えます。目的はスタイルを細かく潰すことではなく、テストスイートが意味ある回帰を捕え、保守コストにならないことを確認することです。

まず次の2点を問いかけてください:

生成テストは偶発的な実装(現在の実装詳細)を固定化することがあります。テストがコードの写しのように読める場合は、より上位のアサーションに押し上げてください。

フレークや壊れやすさの原因は過剰モッキング、ハードコードされたタイムスタンプ、ランダム値などです。決定論的な入力と安定したアサーション(例えば生の Date.now() 文字列ではなく解析した日付や許容範囲)を好みます。テストが合格するために過剰なモックが必要なら、それは配線をテストしているだけかもしれません。

「パスしている」テストでも無意味な場合があります(偽陽性)。“例外が投げられない”や単に関数が呼ばれたことをチェックするような弱いアサーションを探してください。出力、状態変化、返されたエラー、永続化されたデータなどをアサートして強化します。

一貫したレビューのために簡単なチェックリストを用意します:

生成テストも他のコード同様に扱い、6か月後も持てるものだけをマージしてください。

AIはコードを速く書く手助けをしますが、長期的な勝利はそのコードを正しく維持することです。最も簡単に品質を「固定化」する方法は、テストとチェックをすべての変更で自動実行することです—回帰はリリース前に捕まえられます。

多くのチームが採用する軽量ワークフロー:

最後のステップが重要です:AI生成ロジックにテストが伴わないと、挙動が徐々に逸脱します。テストがあれば意図した振る舞いをCIに記録できます。

CIをすべてのプルリクで(できれば main へのマージ時にも)動くように設定してください。最低限:

これにより「私のマシンでは動く」問題を防ぎ、他の誰かや後のAIプロンプトがコードを変えたときの偶発的な破壊を捕らえます。

テストは必須ですが、すべてを捕えられるわけではありません。テスト生成を補う高速なゲートを追加します:

これらは速く保ってください—CIが遅い・ノイジーだと皆が回避方法を探します。

生成テストでCI実行が増えるなら、予算を調整してください。CI分が課金対象なら制限やオプションを見直す価値があります(参照:/pricing)。

意外に効果的な方法は、失敗したテストを次のプロンプトとして扱うことです。モデルに広く「機能を改善して」と頼む代わりに、具体的な失敗を与えてその失敗を制約にすることで無駄な往復を減らせます。

代わりに:

使うべきパターンは:

shouldRejectExpiredToken。失敗出力と関連コードはこちら。公開APIを変えずにこのテストが通るように実装を更新してください。必要ならバグを捉える回帰テストを追加してください。」失敗テストは何が「正しい」かを実行可能に定義します。交渉ではなく測定可能な目標があるので推測を減らせます。さらに各プロンプトは単一の測定可能な成果にスコープされるため、人間のレビューが速くなり、AIが症状を直すだけで別の箇所を壊すようなケースを見つけやすくなります。

これはエージェントスタイルのワークフローが効果を発揮する場面でもあります:一方のエージェントは最小のコード変更に集中し、別のエージェントが最小のテスト調整を提案し、あなたは差分をレビューします。Koder.ai のようなプラットフォームはこうした反復指向のチャット開発を前提に作られており、「次のプロンプトとしてのテスト失敗」をデフォルトの手法にしやすくします。

自動テスト生成は一夜でスイートを大きくできるかもしれませんが、“大きい”と“良い”は同義ではありません。目標は信頼性です:回帰を早期に捕らえ、本番不具合を減らし、チームの速度を保つこと。

以下のような結果に結びつく指標から始めます:

カバレッジは未テスト領域を見つけるためのスモークアラームになり得ますが、簡単に操作可能です。生成テストはカバレッジを膨らませつつ内容の薄いアサーションを追加することがあります。代替指標として:

テスト数やカバレッジだけを追うとボリュームを最適化してしまいます。代わりに リリース前に捕まえた不具合 を追いましょう:CI、QA、ステージングで見つかったバグでユーザーに達したものをゼロに近づけます。自動テスト生成が機能していれば、この数は増え(CIで捕まるように)、本番インシデントは減ります。

生成スイートはメンテが必要です。定期タスクを入れて:

成功とは派手なダッシュボードではなく、穏やかなCIと早いフィードバック、驚きの少ない日常です。

自動テスト生成は品質を素早く上げられますが、あくまで補助ツールとして扱わないと失敗します。多くのチームに共通する失敗は回避可能です。

過度の依存が古典的な罠です:生成テストがあるから安全だと人が判断を放棄すると、より速くバグを出荷しますが、より多くの緑のチェックマークが付くだけになってしまいます。

もう一つの問題は実装の詳細をテストしてしまうことです。AIツールは現在のメソッド名、内部ヘルパー、正確なエラーメッセージに固執しがちです。そうしたテストは脆く、リファクタで壊れます。何をすべきかをテストし、どのようにはテストしない方が良いです。

テスト生成はプロンプトにコードやスタックトレース、ログを貼ることを伴いますが、これがシークレット(APIキー)、顧客データ、専有ロジックを漏らすリスクになります。

ホスト型のAI開発プラットフォームを使う場合も同様の注意を払い、プロンプトとフィクスチャはセキュリティ方針の一部として扱ってください。

小さく始めてルーチン化します:

目標は最大数のテストを作ることではなく、AI生成ロジックを正直に保つ信頼できるフィードバックを得ることです。

AIはアプリのロジック変更を高速化しますが、そのぶん誤った仮定や微妙な回帰も速く発生します。生成されたテストは意図した振る舞いを素早く実行可能にして、将来の変更(人間やAIによる)に対して即時のフィードバックを提供します。

いいえ。生成テストは現行の振る舞いを“承認”してしまうことがあり、その振る舞い自体が間違っている可能性があります。また、コードから明示されないビジネスルールを見落とすこともあります。生成テストは草案と考え、名前・セットアップ・アサーションがプロダクトの意図を反映しているかをレビューしてください。

新規や修正されたロジックの周りで素早く構造化されたカバレッジが必要なときに有用です。特に:

まずコストが低く信号が強い層、つまりユニットテストから始めます。

“正しい理由”で失敗する振る舞い中心のテストを目指してください。弱いチェックを強化するには:

過度のモッキング、ハードコードされたタイムスタンプ、ランダムデータ、内部メソッド呼び出しのアサートが主な原因です。決定論的な入力と安定したアサーションを好み、パブリックな振る舞いをテストして無害なリファクタがテストを壊さないようにします。

短いループを使います:

これにより「完了」が実行可能な期待値に紐づきます。

次を含めてプロンプトに制約とリポジトリの文脈を与えてください:

これにより不適切なパターンやレビューしにくい出力を減らせます。

プロンプトに貼るコードやログが、シークレットや顧客データ、内部URLを漏洩するリスクがあります。対策:

ホスト型のAI開発プラットフォームを使う場合でも、プロンプトとフィクスチャはセキュリティ方針の一部として扱ってください。

ボリュームではなく効果を見ます。着目すべき指標:

カバレッジはヒントとして使い、定期的に冗長なテストを削除してスイートを維持してください。