2025年5月18日·2 分

ビジネス仮説を時間経過で追跡するウェブアプリの作り方

ビジネス仮説を記録し、証拠を紐付け、時間経過で変化を追跡してチームに見直し・検証を促すウェブアプリの設計と構築方法を学ぶ。

アプリが解決する問題(誰が使うか)

ビジネス仮説とは、チームが完全に証明されていない状態で基にしている信念です。例えば:

- 市場: 「このセグメントは十分に成長していて我々のプロダクトを支えられる」

- 顧客: 「セットアップが10分以内ならユーザーはスプレッドシートから乗り換える」

- 価格: 「この機能セットならチームは月49ドルを払う」

- 運用: 「オンボーディングは1人で対応できる」

- リスク: 「この手法はコンプライアンス問題を生まない」

こうした仮説はピッチ、ロードマップ議論、営業の会話、廊下での雑談など至る所に現れ、そのまま見失われがちです。

なぜチームは仮説を見失うのか

多くの場合、チームが仮説を放置するのは無関心だからではありません。ドキュメントの陳腐化、役割交代、知識の“部族化”によって散逸するのです。最新の「真実」はドキュメント、Slack、数件のチケット、そして誰かの記憶に分散します。

そうなると、同じ議論を繰り返したり、同じ実験を再実行したり、まだ検証されていないことに基づいて意思決定をしてしまいます。

目指す成果

シンプルな仮説追跡アプリがもたらすもの:

- 明確さ:何を信じているか、何が証明されたか、何が保留か

- 説明責任:誰が各仮説を担当しているか、最後にいつレビューしたか

- 学習の高速化:仮説→実験→証拠のループを短くする

- 再議論の削減:共有記録により同じ議論の循環を減らす

誰が使うか(どれくらいの規模が必要か)

プロダクトマネージャー、創業者、グロース、リサーチ、セールスリーダーなど、賭けをする人全般が恩恵を受けます。まずは軽量な「仮説ログ」から始め、常に最新に保ちやすいものにして、利用状況に応じて機能を拡張してください。

コアデータモデルを定義する

画面設計や技術選定の前に、何を保存するかを決めてください。明確なデータモデルはプロダクトの一貫性を保ち、後で集計・レポートを可能にします。

コアオブジェクト(小さく保つ)

チームがアイデアを検証する流れに沿って、まずは5つから始めましょう:

- Assumption: 検証される前の主張

- Evidence: 証拠(リンク、ノート、ファイル、指標)

- Experiment: インタビュー、アンケート、A/Bテスト、プロトタイプなどの構造化テスト

- Review: 定期的なチェックポイントで最新のステータス/信頼度を確認する記録

- Comment: 仮説に紐づく軽い議論(必要に応じて証拠や実験にも紐付け)

推奨されるAssumptionフィールド

Assumptionは素早く作成でき、かつ実行可能であるべきです:

- Statement(必須):単一でテスト可能な文

- Category(必須):例:顧客、問題、価格、チャネル、実現可能性

- Owner(必須):誰が推進するか

- Confidence(必須):低/中/高(または1–5)

- Status(必須):Draft, Active, Validated, Invalidated, Archived

レビューワークフローを動かすためにタイムスタンプも必要です:

- Created at, Last updated at(システム生成)

- Last reviewed at, Next review date(編集可能または導出)

リレーション

検証の流れをモデル化します:

- One Assumption → many Evidence items

- One Assumption → many Experiments

- One Assumption → many Reviews and Comments

必須 vs 任意(摩擦を減らす)

必須は最小限に: statement、category、owner、confidence、status のみ。タグ、impact、リンクなどは任意にして、人が素早くログできるようにし、証拠が集まってから詳細化できるようにします。

ステータス、信頼度、レビュー規則の設定

ログが役立ち続けるためには、各エントリに一目で意味が伝わる必要があります:ライフサイクルの位置、どれだけ信じているか、いつ再確認すべきか。このルールはチームが無意識に推測を事実扱いするのを防ぎます。

シンプルで一貫したライフサイクル

全ての仮説に対して1つのステータスフローを使います:

Draft → Active → Validated / Invalidated → Archived

- Draft: 記録されたが、追跡する価値があると合意されていない状態

- Active: チームが依存している、または検証・監視する意図がある状態

- Validated: 証拠が事前に定義した基準を満たした状態

- Invalidated: 証拠が明確に反証した状態(学びとして保持)

- Archived: もはや関連性がない状態(プロダクト変更、市場移動、戦略転換)

信頼度スコア(1–5)

1–5のスケールを取り、各値を平易に定義します:

- Speculation(推測)(証拠なし)

- Weak signal(弱いシグナル)(データポイント1件)

- Some support(ある程度の裏付け)(複数のシグナル、依然ギャップあり)

- Strong support(強い裏付け)(一貫した証拠、疑念が少ない)

- Very strong(非常に強い)(再現可能な結果、時間経過で安定)

“confidence”は「どれだけそれを望んでいるか」ではなく「証拠の強さ」についてにしてください。

意思決定への影響度:何を先に検証するか

Decision impact: Low / Medium / High を追加します。高影響の仮説は価格、ポジショニング、Go-to-market、主要な開発判断に影響するため優先的に検証すべきです。

“Validated”の定義

各仮説ごとに具体的な基準を書きます:どの結果が“合格”を意味するのか、最低限の証拠は何か(例:30件以上のアンケート回答、10件以上の営業通話で一貫したパターン、事前定義の成功指標を満たすA/Bテスト、3週間のリテンションデータ)。

再検討とレビュー規則

自動レビューのトリガーを設定します:

- High-impact の仮説は 2–4週間ごと にレビュー

- コア指標(コンバージョン、解約率、CAC)が変動したときにレビュー

- 主要な製品や市場の変更後にレビュー

これにより “validated” が「永遠の真実」にならないようにします。

ユーザー体験と主要画面の設計

仮説追跡アプリはスプレッドシートより速く感じられることが成功の鍵です。人が週に何度も繰り返す数少ない操作に合わせて設計してください:仮説を追加する、信念を更新する、学びを添付する、次のレビュー日を設定する。

主なフロー(ワンクリックで終わること)

ループを短く保ちます:

- 仮説を作成:テンプレート(Problem、Customer、Pricing、Channel)を用意し、妥当なデフォルトを設定

- ステータスを更新:Draft → Active → Validated/Invalidated を素早く移動、任意でメモ

- 証拠を添付:ファイルドラッグ&ドロップやリンク貼付け、複数の仮説にタグ付け

- レビューをスケジュール:変更の直後に next review を設定し、放置を防ぐ

実際に必要なコア画面

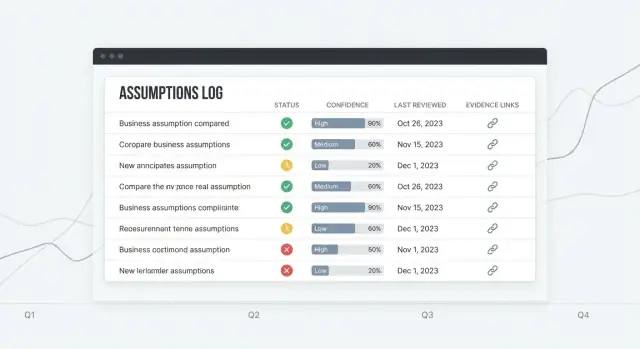

Assumptions list はホームベース:読みやすいテーブル(Status、Confidence、Owner、Last reviewed、Next review)と、目立つ“Quick add”行を用意して完全なフォームを要求しない。

Assumption detail は意思決定が行われる場所:上部に短い要約、その下に更新のタイムライン(ステータス変更、信頼度変更、コメント)、専用の Evidence パネル。

Evidence library は学びの再利用を支援:タグ、ソース、日付で検索し、複数の仮説に証拠を紐付け可能。

Dashboard は「注意が必要なもの」を答える:予定されているレビュー、最近変更された仮説、低信頼度のハイインパクト項目を表示。

フィルタ、検索、雑多さの抑制

フィルタは永続化して高速に:category、owner、status、confidence、last reviewed date。テンプレート、デフォルト値、段階的表示(詳細フィールドは必要になるまで非表示)で雑多さを減らす。

アクセシビリティの基本

高コントラストテキスト、明確なラベル、キーボード操作対応。テーブルは行フォーカス、ソート可能なヘッダ、読みやすい余白をサポートする(特にステータスと信頼度のバッジ)。

実用的な技術スタックの選択

仮説追跡アプリは大半がフォーム、フィルタ、検索、監査トレイルです。これは良いニュース:単純で確実なスタックで価値を早く出し、ワークフロー(レビュー規則、証拠、意思決定)に注力できます。

実務的なスタック例

一般的で実用的な構成:

- Frontend: React(Next.js)

- Backend: Node.js(Express/Nest)またはPython(FastAPI/Django)

- Database: Postgres

チームが既に知っている技術を選ぶことを優先してください。整合性は新技術より重要です。

プロトタイプを早く作りたい場合は、Koder.ai のようなビブコーディングプラットフォームを使うと、チャットでデータモデルや画面を記述し、Planning Modeで反復してReact UIと本番対応のバックエンド(Go + PostgreSQL)を生成し、後でソースコードとしてエクスポートできます。

なぜPostgresが適しているか

Postgresは各仮説がワークスペースに属し、オーナーや証拠、実験とリンクするような「つながりのある」データを扱うのに向いています。ステータス、信頼度、レビュー期限、タグ、オーナーでの検索に対してインデックスが効き、バージョン履歴や変更ログを追加する場合にも監査に適しています。変更イベントは別テーブルに格納してレポーティング可能にできます。

ホスティングと運用を軽く保つ

マネージドサービスを目標に:

- Managed Postgres(自動バックアップ、アップグレード、リードレプリカ)

- Next.js と API のアプリホスティング(またはフルスタックNext.js)

運用負荷を減らすことで「運用するだけで週が潰れる」リスクを低減します。

Koder.ai はデプロイやホスティング、カスタムドメイン、スナップショット/ロールバックなどを提供して早期のワークフロー改良を支援できます。

APIの方針:まずはREST

CRUD、検索、アクティビティフィードのために RESTエンドポイント から始めましょう。デバッグやドキュメントが簡単です。多数の関連オブジェクトをまたぐクライアント主導の複雑なクエリが本当に必要になったらGraphQLを検討してください。

明確な環境を用意する

初日から3つの環境を想定します:

- Local(開発者マシン)

- Staging(インポート、通知、権限周りを安全にテスト)

- Production(本番データ、厳格なアクセス、監視)

この構成は過剰設計せずに仮説追跡を支えます。

認証、ロール、ワークスペースの実装

安全にデプロイして繰り返し改善

ホスティング、カスタムドメイン、簡単なロールバック機能付きで、社内ツールをデプロイして反復できます。

共有されるログなら、アクセス制御は退屈で予測可能であるべきです。誰が見られるか、編集できるか、承認できるかを明確にしつつ、チームの速度を落とさないようにします。

認証:まずはシンプルに、必要に応じてSSO

多くのチームでは メール+パスワード で十分にローンチできます。大企業やITポリシーが厳しい場合は Google / Microsoft SSO を追加してください。両方サポートする場合はワークスペースごとに管理者が選べると良いです。

ログインの表面は最小限に:サインアップ、サインイン、パスワードリセット、(必要なら)MFAを後から強制できるように。

ロールと権限(Admin / Editor / Viewer)

ロールは一度定義してアプリ全体で一貫させます:

- Admin:ワークスペース設定、メンバー管理、統合管理、レコード削除(または削除申請)

- Editor:仮説の作成・編集、証拠添付、実験記録、ステータス/信頼度変更

- Viewer:仮説、証拠、実験結果、ダッシュボードの閲覧のみ

権限チェックはUIだけでなくサーバー側で必ず行ってください。将来「承認」ワークフローを追加する場合、それは新しいロールではなく権限として扱うべきです。

ワークスペース:チーム・プロダクト・クライアントの分離

ワークスペース はデータとメンバーの境界です。各仮説、証拠、実験は正確に1つのワークスペースに所属させ、代理店や複数プロダクトを持つ企業が誤って共有しないようにします。

招待、オフボーディング、最低限の監査

メール招待に有効期限を付け、オフボーディング時はアクセスを削除しつつ履歴は残す方針にします:過去の編集は元の実行者を表示するべきです。

最低限の監査ログを保持してください:誰がいつ何を変更したか(ユーザーID、タイムスタンプ、オブジェクト、アクション)。これは信頼性、説明責任、後で意思決定が問われた時のデバッグに役立ちます。

バージョン履歴とチェンジログを伴うCRUDの構築

CRUDは仮説ログを単なるドキュメントではなくシステムに変えます。目的は単に作成・編集することではなく、あらゆる変更を理解可能かつ元に戻せるようにすることです。

CRUDエンドポイントとUIアクション

最低限サポートすべき操作:

- 仮説の作成、閲覧、編集、アーカイブ(ソフトデリート)、復元

- 証拠アイテムの添付(リンク、ファイル、ノート)とメタデータ編集

- ステータス変更(Draft → Active → Validated/Invalidated など)

UIではこれらの操作を仮説詳細ページの近くに配置:明確な「編集」、専用の「ステータス変更」、意図的にクリックしにくい「アーカイブ」ボタンなど。

バージョニング:スナップショットか追記ログか

実務的な戦略は2つあります:

- フルリビジョンを保存(保存ごとにスナップショット)— 復元が容易

- 追記型チェンジログ(イベントストリーム)— 監査に強いが過去状態の再構築が必要

多くのチームはハイブリッドを採用:主要な編集はスナップショット、細かい操作はイベントとして記録。

履歴を読みやすくする

各仮説に タイムライン を提供:

- 誰がいつ何を変更したか

- テキストフィールド(statement 等)の差分ビュー

- 過去バージョンを復元するボタン(確認プロンプト付き)

文脈:コメントと決定ノート

重要な編集(ステータス/信頼度の変更、アーカイブ等)には短い「理由」を必須にして、軽い意思決定ログとして扱いましょう:何が変わったか、どの証拠がトリガーか、その次に何をするかを残します。

誤操作を防ぐ

破壊的なアクションには確認を入れる:

- 仮説をクローズするようなステータス変更

- アーカイブ

- 古いバージョンの復元(復元が新しいリビジョンを作る旨の警告)

これにより、急いで作業しても履歴が信頼できるものになります。

証拠の添付と実験の追跡

証拠がない仮説は危険です。チームが証拠を添付し、軽量な実験を記録できるようにして、すべての主張にトレース可能な軌跡を持たせます。

証拠:散らかさずに何を保存するか

一般的な証拠タイプをサポートします:インタビューノート、アンケート結果、製品や収益の指標、ドキュメント(PDF、スライド)、単純なリンク(分析ダッシュボード、サポートチケット等)。

証拠を添付する際には、数点のメタデータを取得して数か月後でも有用にします:

- Source(顧客名、データセット、ツール、社内ドキュメントの所有者)

- Date collected(収集日)と(任意で)date uploaded

- Method(インタビュー、ユーザビリティテスト、A/Bテスト、デスクリサーチ等)

- Quality / strength rating(下記参照)

重複アップロードを避けるため、証拠は独立したエンティティとして扱い、many-to-many の関係で仮説に紐付けます。ファイルは一度保存するか、リンクのみ保持して複数の仮説と関連付けるべきです。

実験トラッキング:検証を記録に変える

簡単に記入できる Experiment オブジェクトを追加:

- Hypothesis(期待と理由)

- Method(何を行うか)

- Key metric(見るべき数値)

- Result(何が起きたか)

- Conclusion(仮説を維持、変更、破棄のいずれか)

実験はテストする仮説に紐付け、生成された証拠(チャート、ノート、指標スナップショット)を自動的に添付できると便利です。

証拠の強さ:誤った確信を防ぐガイダンス

簡単なルブリック(Weak / Moderate / Strong)を使い、ツールチップで説明します:

- Weak: 意見、単一の逸話、未検証のリンク

- Moderate: 複数のインタビュー、一貫したアンケート信号、初期の指標トレンド

- Strong: セグメントを越えた再現結果、明確な指標インパクト、対照実験

目的は完璧さではなく“確信”を明示化し、感覚での判断が意思決定を左右しないようにすることです。

リマインダーとレビューのワークフローを追加

コードの完全な所有権を保持

準備ができたらソースコードをエクスポートして、自社チームで開発を続けられます。

仮説は静かに陳腐化します。シンプルなレビューのワークフローがあれば「再検討すべき」が習慣になり、ログが有用であり続けます。

リスクに合わせたレビュー頻度を設定する

レビュー頻度は 影響度 と 信頼度 に紐づけます:

- 週次:高影響+低信頼度(例:主要な価格、主要獲得チャネル)

- 月次:高影響+中信頼度、または中影響+低信頼度

- 四半期:低影響+高信頼度(任意)

次回レビュー日は仮説に保存し、impact/confidence が変わったら自動再計算します。

スパムにならないリマインダー

メール と アプリ内 通知の両方をサポート。デフォルトは保守的にして、期限超過時に1回の催促、続いて穏やかなフォローアップにします。

ユーザー/ワークスペースごとに設定可能に:

- チャネルの好み(メール/アプリ内)

- リマインダー頻度(日次/週次)

- 静音時間/タイムゾーン

- 低影響項目のオプトアウト

行動を促すダイジェスト

長いリストを送る代わりに、焦点を絞ったダイジェストを作成:

- Needs review(期限切れまたはまもなく期限)

- High impact + low confidence(最大リスク)

- Recent changes(編集された仮説、信頼度低下、証拠削除)

これらはUIのフィルタと同じロジックを共有し、ダッシュボードと通知の両方で使えるようにします。

単純なエスカレーションルール

エスカレーションは予測可能で軽量に:

- 期限超過時に Owner に通知

- X日経っても未対応なら チームリード(またはワークスペース管理者)に通知

各リマインダーやエスカレーションは仮説のアクティビティ履歴に記録して、いつ何が起きたか見えるようにします。

ダッシュボードとレポーティングの作成

ダッシュボードは仮説ログをチームが実際に参照するものに変えます。目的は派手な分析ではなく、何がリスクか、何が陳腐化しているか、何が変化しているかを素早く見えるようにすることです。

「安全か?」に答えるKPI

小さなタイル群から始めます:

- Assumptions by status(Draft, Active, Validated, Invalidated, Archived の分布)

- Confidence distribution(1–5の分布または Low/Medium/High)

- Overdue reviews(件数+期限切れリストへの直リンク)

各KPIはクリックでアクション可能なビューへ遷移できるようにします。

トレンドチャート(有用だが慎重に)

検証済み vs 無効化 の推移を単純な折れ線で表示すると、学習の加速・停滞がわかります。注意点:

- トレンドはシグナルであり、成果の証明ではない

- サンプルサイズ(例:「今月の結果 8 件」)を表示して単発の結果を過大評価しない

ステークホルダー別の保存ビュー

役割ごとに異なる問いがあるため、保存されたフィルタを提供します:

- Product: アクティブな発見に紐づく仮説をプロダクト領域別に

- Sales/CS: 価格、反論、ターゲットセグメントに関する仮説

- Leadership: ハイインパクト項目、トップリスク、レビュー健全性

保存ビューは共有可能な安定URL(例:/assumptions?view=leadership-risk)で提供します。

リスクの強調:高影響+弱い証拠

Impact が High で Evidence strength が Low(または confidence が低い)項目を「Risk Radar」テーブルで浮き彫りにします。計画やプレモーテムの議題になります。

会議用のエクスポート可能なサマリ

レポートは持ち運べる形にします:

- 表示中のビューを PDF/CSV にワンクリックでエクスポート

- 「週間仮説サマリ」:主要な変更点、最近の無効化、期限切れレビューを一覧化

これにより会議中に全員がログインする必要がなくなります。

インポート、エクスポート、統合のサポート

モデルからアプリへ

データモデルと画面を、Go と Postgres をバックエンドにした React アプリに変換します。

アプリは既存の運用に馴染む必要があります。インポート/エクスポートで素早く始められ、軽量な統合で手作業を減らします。ただしMVPを統合プラットフォームにしないよう注意。

実際に使われるエクスポート

まずはCSVエクスポートを提供します:assumptions、evidence/experiments、change logs の3テーブル。列は予測可能に(ID、statement、status、confidence、tags、owner、last reviewed、timestamps)。

UX上の小さな配慮:

- 現在のビュー(適用中のフィルタ)と フルワークスペース をエクスポート

- アーカイブ済み を含めるか選べる

- スプレッドシートで結合可能な安定した Assumption ID を含める

スプレッドシートからのインポート(痛みを減らす)

多くのチームは乱雑なGoogleシートから始めます。以下のインポートフローを提供しましょう:

- CSVアップロード

- カラムマッピング(例:「Hypothesis」→ Statement、"Risk" → Impact)

- バリデーション(必須フィールド欠如、未知のステータス、無効な日付などの明確なエラー)

- 作成される/更新される件数のプレビュー

インポートは初期導入の最速ルートになることが多いので、ファーストクラス機能として扱い、期待フォーマットとルールを /help/assumptions に文書化してください。

オプショナル統合:シンプルに保つ

統合は任意にしてコアアプリをシンプルに保ちます。実務的なパターンは2つ:

- Webhooks:

assumption.created、status.changed、review.overdue等のイベントを発火 - Link-out references:Jira、Notion、リサーチフォルダへのURLを仮説の「関連リンク」として保存

即時価値のために、Slackへの基本的なアラート統合(Webhook)をサポートすると良いです:ハイインパクト仮説のステータス変更やレビュー期限超過時にポストして認知を促します。

セキュリティ、プライバシー、データ保護の基本

仮説ログは機密情報を含むことがあるため、初期から“安全がデフォルト”となる設計をしてください。人は会話のメモや内部決定を貼り付けるため、取り扱いに注意が必要です。

データ保護の基本

- TLSを全面的に使用(HTTPSのみ)、HTTPはHTTPSへリダイレクト

- セキュアなクッキー(HttpOnly、Secure、SameSite)を設定

- パスワードはArgon2id(推奨)または強コストのbcryptでハッシュ化。平文保存は絶対にしない

- 認証トークンはログに残さない

最小権限の原則を適用:

- 書き込みアクションごとに権限チェック

- 統合にはスコープ付きAPIキーを使用し、ユーザーが取り消せるように

- DBの認証情報は必要最小限のテーブルしか読めないように制限

行レベルアクセスルール(ワークスペース)

マルチテナントアプリでの漏洩は認可バグが原因です。ワークスペース隔離を第一級のルールにしましょう:

- すべてのレコード(assumption、evidence、experiment、comment)に

workspace_idを含める - アクセスはアプリコードだけでなくDBレイヤーで(RLS等)強制する

- テストで2つのワークスペースを作り、AのユーザーがBのデータを読めないことを検証する

バックアップと保持(実行計画)

実行可能なシンプルな計画を定義:

- 毎日の自動DBバックアップを別保管先に保存

- 保持ポリシー(例:日次バックアップは30日分、月次バックアップは12か月分を保持)

- 四半期ごとのリストア演習:ステージングへ復元し主要フローを検証

ログと機微データの扱い

保存する内容は慎重に:ノートや添付に秘密情報(APIキー、パスワード、プライベートリンク)が入らないよう注意喚起を出すか、一般的なパターンの自動マスキングを検討してください。

診断のためにリクエストボディ全体をログに残すべきではありません。必要ならメタデータ(workspace ID、record ID、エラーコード)をログに残してください。

インタビュー・ノートのプライバシー

インタビューノートは個人データを含む可能性があります。対応策:

- 「個人データを含む」フィールドをマークし、閲覧権限を制限する

- 要求があればノートを削除または匿名化する仕組みを作る

/settingsや/helpへの短いプライバシーノートで何を保存し、なぜ保存するかを説明する

ローンチ、監視、次の反復計画

仮説アプリの出荷は「完成」ではなく、安全に実ワークフローに組み込み、利用に基づいて学習することがゴールです。

実務的なデプロイチェックリスト

ユーザー公開前に繰り返して実行できるチェックリスト:

- DBマイグレーションを適用(巻き戻し可能性を検証)

- シードデータを投入(ステータス、信頼度レベル、レビュー間隔)

- 最初の管理者アカウントとデフォルトワークスペースを作成

- レビューメール/通知設定を確認

- バックアップを有効化し、復元を一度検証

ステージングがあるなら、特にバージョン履歴やチェンジログに関わるリリースはそこで試してください。

エラーとパフォーマンスの監視(軽量で)

シンプルに始めましょう:

- エラートラッカー(Sentry等)でクラッシュ、失敗API、バックグラウンドジョブの例外をキャプチャ

- 基本的なパフォーマンス監視(APMやサーバーメトリクス)でダッシュボードやレポートの遅延を検出

コアルールを守るテスト

ミスが高コストになる箇所にテストを集中:

- ステータストランジション、信頼度ルール、レビュースケジューリングの単体テスト

- 統合テスト:作成→証拠添付→実験記録→ステータス変更→監査トレイルの主要フロー

アンボーディングでアプリが「使える」ようにする

テンプレートとサンプル仮説を用意し、空の画面で途方に暮れないようにします。短いガイドツアー(3–5ステップ)で:どこに証拠を追加するか、レビューがどう働くか、決定ログの読み方を示します。

次の反復を計画する

ローンチ後は実際の行動に基づいて優先順位を付け:

- スコアリングモデル(impact × uncertainty、またはカスタム信頼度式)

- ハイリスク変更の承認フロー

- 証拠や実験結果のAI要約支援(任意)

迅速に反復するなら、チャットブリーフから画面とバックエンド変更を起こせるツール(例:Koder.ai)を使い、スナップショットとロールバック で安全に実験を出し、製品方針が固まったらコードをエクスポートするワークフローが有効です。

よくある質問

What is a business assumption in the context of an assumption-tracking app?

チームが十分に証明されていない状態で行動している、単一でテスト可能な信念を追跡します(例:市場需要、支払い意欲、オンボーディングの実現可能性)。重要なのは、それを明示化し、所有者を決め、定期的に見直せるようにして、“なんとなく事実”になってしまうことを防ぐことです。

Why do teams lose track of assumptions (and why does an app help)?

仮説(assumption)がドキュメント、チケット、チャットなどに散らばり、役割の変化で記憶が失われるためです。専用のログは「最新の真実」を一箇所に集め、同じ議論や実験の繰り返しを防ぎ、何がまだ未検証かを可視化します。

Who should use an assumption-tracking app, and how big should the MVP be?

プロダクト、創業者、グロース、リサーチ、営業リーダーなど、週次で仮説に賭けている人たちに向いています。

MVPは軽量に始めましょう:

- 仮説を素早く記録する

- 証拠/実験を添付する

- レビューをスケジュールする

- 注目すべき項目を表示する(ダッシュボード)

実際の利用が増えたら必要に応じて機能を拡張してください。

What core data model should I implement first?

最初に実装すべき実用的なコアは5つのオブジェクトです:

- Assumption(主張)

- Evidence(リンク/ファイル/ノート/指標)

- Experiment(証拠を生む構造化されたテスト)

- Review(定期的なチェックポイント)

- Comment(軽い議論)

このモデルはトレーサビリティを確保しつつ、初期構築を複雑にしすぎません。

Which fields should be required vs. optional on an Assumption?

アクション可能にするために最低限必要な項目だけを必須にしましょう:

- Statement(記述)、Category(カテゴリ)、Owner(担当)、Confidence(信頼度)、Status(状態)

他はオプションにして摩擦を下げます(タグ、影響度、リンクなど)。また、リマインダーやワークフローのために last reviewed や next review といったタイムスタンプは保持してください。

How should I define status, confidence, and impact so the team uses them consistently?

一貫したフローと明確な定義を使ってチームが共通認識を持てるようにします:

- ステータス:Draft → Active → Validated / Invalidated → Archived(ドラフト→アクティブ→検証済み/無効化→アーカイブ)

信頼度は1–5のスケールを用い、証拠の強さに基づいて定義してください。また、Decision impact(低/中/高) を付けて優先度を決めます。

What does “validated” mean, and how do we set evidence criteria?

各仮説ごとに検証基準を明確に書き出します。例:

- 30件以上のアンケート回答で一貫したシグナル

- 10件以上の営業通話で同じパターン

- 事前定義した成功指標を満たすA/Bテスト

- 目標を満たす3週間分のリテンションデータ

検証基準を決めることで“誰かの感覚で検証済み”になるのを防ぎます。

What screens and user flows are essential for a first version?

初期に必要な画面とフロー:

- Assumptions list(テーブル+クイック追加)

- Assumption detail(要約+タイムライン+証拠パネル)

- Evidence library(検索可能で再利用可能)

- Dashboard(レビュー期限、ハイインパクト/低信頼度)

日常的に行われる操作(追加、ステータス変更、証拠添付、次回レビュー設定)を最短でできるように最適化してください。

What tech stack is practical for building this kind of app?

安定して導入できる堅実なスタック例:

- フロントエンド:React(Next.js)

- バックエンド:Node.js(Express/Nest)またはPython(FastAPI/Django)

- DB:Postgres

Postgresはリレーション(assumptions ↔ evidence/experiments)やインデックス、監査に向きます。まずはCRUDとアクティビティフィードのために REST を使うのが簡単です。

How should I handle authentication, roles, and workspace security?

早期はシンプルに始め、必要に応じて SSO を追加します:

- 認証:まずはメール+パスワード、組織向けには Google/Microsoft SSO を追加

- ロール:Admin / Editor / Viewer を定義し、サーバー側で権限チェックを行う

- ワークスペース:データの境界(各レコードに

workspace_id) - 監査ログ:誰がいつ何を変更したかを保存

マルチテナントではデータ隔離をデータベースレイヤー(RLS 等)で保護してください。