2025年5月14日·1 分

Intelとx86の優位性、そしてプラットフォーム移行がこれほど難しい理由

Intel x86 が何十年にもわたり互換性を積み上げてきた経緯、エコシステムがロックインする仕組み、そして産業全体でプラットフォーム移行がこれほど難しい理由を分かりやすく解説します。

Intel x86 が何十年にもわたり互換性を積み上げてきた経緯、エコシステムがロックインする仕組み、そして産業全体でプラットフォーム移行がこれほど難しい理由を分かりやすく解説します。

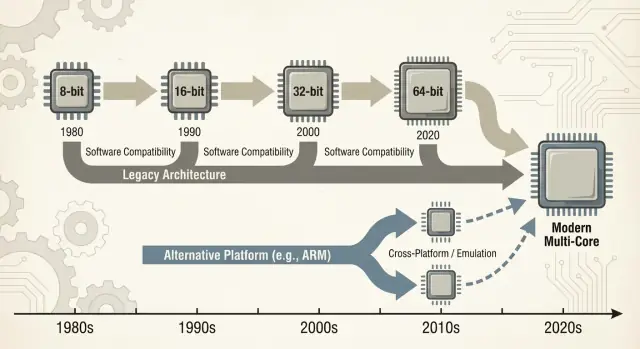

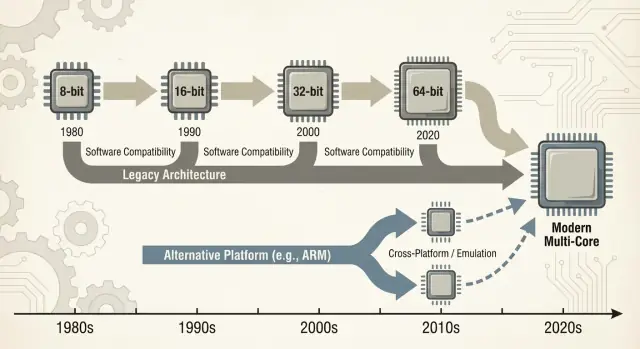

人々が「x86」と言うとき、多くはIntelの8086チップから始まり何十年にわたって発展してきたCPU命令群を指します。これらの命令はプロセッサが理解する基本的な動詞──加算、比較、データ移動など──です。その命令セットは**ISA(命令セットアーキテクチャ)**と呼ばれます。ISAは、ある種のCPUで動作させるためにソフトウェアが最終的に話す必要がある「言語」と考えられます。

x86: 過去40年近くPCで最も一般的に使われてきたISA。主にIntelが実装し、AMDなども互換実装を行ってきました。

後方互換性: 新しいコンピュータが古いソフトウェア(時には数十年前のプログラム)を大きな書き換えなしに動かし続けられる能力。完全ではない場合もありますが、PC世界では「あなたのソフトは動き続けるはずだ」という前提になっています。

ここでの「優位性」は単なる性能自慢ではありません。次のような複合的で積み重なる利点を指します。

これらが組み合わさると相互に強化します。機械が増えればソフトが増え、ソフトが増えれば機械が増えます。

支配的なISAからの切り替えは、単に部品を替えるような話ではありません。アプリケーション、ドライバ(プリンタ、GPU、オーディオ機器、特殊な周辺機器)、開発ツールチェーン、日常の運用慣行(イメージング、ITスクリプト、セキュリティエージェント、デプロイパイプライン)などを壊すか複雑にします。多くの依存は何かが失敗するまで見えないままです。

この投稿は主にPCとサーバーに焦点を当てます。x86が長らくデフォルトであった領域です。合わせて近年の変化、特にARMへの移行を参照します。これらは何がスムーズに変わるか、何が問題になるかをわかりやすく示す実例です。「ただリコンパイルすればいい」はめったに全ての話ではありません。

初期のPC市場は壮大な設計図から始まったわけではなく、実務的な制約から生まれました。企業は安価で量産可能、かつ保守しやすいマシンを求めました。これがベンダーを複数の入手可能なCPUや標準的な周辺機器へ向かわせ、カスタム設計を避ける傾向を強めました。

IBMのオリジナルPC設計は、汎用部品と比較的安価なIntel 8088クラスのプロセッサに大きく依存していました。その選択は重要で、PCを単一製品ではなくレシピのように感じさせました:CPUファミリ、拡張スロット、キーボード/ディスプレイ方式、再現可能なソフトウェアスタック。

IBM PCが需要を証明すると、市場はクローンによって拡大しました。Compaqのような企業は互換機を作って同じソフトを動かせることを示し、価格競争を生み出しました。

またセカンドソース生産も重要でした。複数のサプライヤーが互換プロセッサや部品を提供できることで、購入者は単一ベンダーに賭けるリスクを減らし、OEMにとっては供給と競争が増えて普及が加速しました。

そうした環境で互換性は人々が理解し評価する機能になりました。買い手は命令セットが何かを知る必要はなく、Lotus 1-2-3(後のWindowsアプリ)が動くかどうかだけを気にしました。

ソフトの可用性は単純な購買ヒューリスティックに変わりました:もし他のPCと同じプログラムが動くなら安全な選択だと。

ハードウェアとファームウェアの慣行も目に見えない仕事をしました。一般的なバスや拡張方式、BIOS/ファームウェアの期待や共有されるシステム挙動は、ハードウェアメーカーやソフト開発者が「PC」を安定したターゲットにしやすくしました。

その安定性がx86を成長するエコシステムの下地として確かなものにしました。

x86が勝ったのは単にクロックや巧みなチップ設計のためだけではありません。ソフトウェアがユーザーに従い、ユーザーがソフトに従ったからです──経済的な「ネットワーク効果」です。

プラットフォームが初期にリードすると、開発者はより大きな市場と収益の見込みを見ます。これがより多くのアプリ、より良いサポート、サードパーティ拡張を生み、次の買い手の魅力を高めます。

このループが何年も繰り返されると、技術的に魅力的な代替があってもデフォルトのプラットフォームは置き換えにくくなります。

プラットフォーム移行はCPUを作り直すだけでなく、アプリ、インストーラ、更新チャネル、周辺機器、ITプロセス、数百万のユーザーの蓄積されたノウハウを再現することを意味します。

企業はしばしば重要なアプリを長期間使い続けます:カスタムDB、内部ツール、ERPアドオン、業界特化ソフト、誰も触りたがらないワークフローマクロなど。安定したx86ターゲットは次をもたらしました:

新しいプラットフォームがコスト削減や性能向上を約束しても、収益を生むワークフローを壊すリスクが利点を上回ることが多いのです。

開発者は孤立した「最良」プラットフォームよりも、サポート負担を最小化しリーチを最大化するプラットフォームに最適化します。

顧客の90%がx86のWindows上にいるなら、そこが最初のテスト対象であり最初に出荷され、バグが最速で直されます。第二のアーキテクチャをサポートすることは追加のビルドパイプライン、QAマトリクス、デバッグの増加、サポート作業を意味します。

結果としてリードプラットフォームはより良いソフトをより速く手に入れやすくなります。

小規模事業を想像してください。会計パッケージはx86専用で、テンプレートや給与プラグインが十年分積み重なっています。さらに特定のラベルプリンタやスキャナの微妙なドライバに依存しています。

ここでプラットフォームの切り替えを提案すると、コアアプリが存在しても端の部分が重要になります:プリンタドライバ、スキャナユーティリティ、PDFプラグイン、銀行取り込みモジュール。これらの「地味な」依存が揃わないと移行は頓挫します。

これがフライホイールの作用です:勝ったプラットフォームは誰もが静かに依存する長い尾の互換性を蓄積していきます。

後方互換性は単なるx86の副次的な特徴ではなく、意図的な製品戦略になりました。IntelはISAを十分に安定させることで、古いソフトウェアが動き続ける一方で内部は何度も変化させてきました。

重要なのは何が互換性を持ち続けたかです。ISAはプログラムが依存する機械命令を定義し、マイクロアーキテクチャはチップがそれらをどう実行するかを表します。

Intelは単純なパイプラインからアウト・オブ・オーダー実行へ、キャッシュの増加、分岐予測の改善、製造プロセスの進化などを行っても、開発者にアプリを書き直させる必要はありませんでした。

これが「新しいPCは発売日に古いソフトを動かすべきだ」という強力な期待を生みました。

x86は機能を層として積み重ねてきました。MMX、SSE、AVXなどの命令セット拡張は付加的で、古いバイナリはそのまま動き、対応する新しいアプリだけが追加命令を利用します。

大きな遷移も互換性メカニズムで和らげられました:

欠点は複雑さです。何十年分の挙動をサポートすることは多くのCPUモード、エッジケース、重い検証負担を意味します。新世代のたびに旧アプリやドライバ、インストーラが動くことを証明しなければなりません。

時間が経つにつれて「既存アプリを壊すな」は指針から戦略的制約になり、徹底的なISA変更やシステム設計の根本的変更が正当化されにくくなります。

「Wintel」はWindowsとIntelチップのキャッチーなラベル以上の意味を持ちます。PC業界の各部分が同じデフォルトターゲット(Windows on x86)に張り付くことで相互に利益を受ける自己強化ループを指します。

多くの消費者や企業向けソフトベンダーにとって実践的な問いは「最適なアーキテクチャは何か?」ではなく「顧客はどこにいて、サポートはどうなるか?」でした。

Windows PCは家庭、オフィス、学校で広く展開され、主にx86ベースでした。この組み合わせに出荷することがリーチを最大化し驚きを最小化します。

一度十分な数のアプリがWindows + x86を前提にすると、新しい買い手は必須ソフトが既に動くという理由でこの組合せを選び、それがさらに開発者を引き寄せます。

PCメーカーは多様なモデルを迅速に作り、複数のサプライヤーから部品を調達し、「すぐ動く」マシンを出荷できると成功します。共通のWindows + x86ベースラインはその単純化に貢献しました。

周辺機器のメーカーもボリュームに従いました。大半の買い手がWindows PCを使うなら、プリンタやスキャナ、オーディオ機器、Wi‑FiチップはまずWindows向けドライバを優先します。ドライバの可用性がWindows PC体験を向上させ、OEMはより多くを売り、ボリュームが維持されます。

企業や政府の調達は予測可能性を評価する傾向があります:既存アプリとの互換性、管理可能なサポートコスト、ベンダー保証、実績あるデプロイ手法など。

魅力的な代替があっても、低リスクの選択が研修コストを減らし、エッジケースの故障を避け、既存のITプロセスに沿うために勝つことが多いのです。

その結果は陰謀というよりはインセンティブの整合であり、それぞれが摩擦を減らす道を選んだために移行が非常に難しくなったのです。

「プラットフォーム遷移」は単にCPUを交換する話ではありません。ISA、OS、コンパイラ/ツールチェーン、ハードを動かすドライバスタックの束を移動することです。どれか一つを変えるだけで他が乱れます。

多くの破損は劇的にアプリが起動しなくなるというより、千切れた紙のように小さな不具合が積み重なる形で現れます:

コアアプリの新ビルドがあっても、その周辺の『接着剤』が対応していないことがよくあります。

プリンタ、スキャナ、ラベルメーカー、特定のPCIe/USBカード、医療機器、POS機器、USBドングルはドライバに依存しています。ベンダーが消えていたり興味を持たなければ、新OSや新アーキテクチャ向けドライバが存在しないことがあります。

多くの企業では200ドルの機器一つが2,000ドルのPC群の移行を止めることがあります。

最大の阻害要因は多くの場合「小さな」内部ツールです:カスタムAccessデータベース、Excelマクロ、2009年に作られたVBアプリ、3人しか使わないニッチな製造ユーティリティ。

これらは製品ロードマップに載っていないことが多い一方でミッションクリティカルです。移行が失敗するのは、このロングテールを誰かが移行・テスト・保守する責任を持たないときです。

移行はベンチマークだけで判断されません。投入する総費用(お金、時間、リスク、失われる勢い)が得られる利益を上回らないかで判断されます。外から見るよりも、その請求書は高くつくことが多いのです。

ユーザーのコストは明白なもの(新しいハードウェア、周辺機器、保証)から始まり、そこから筋肉記憶の再訓練、ワークフローの再構成、日常的なツールの再検証へと拡がります。

アプリが「動く」場合でも、プラグインが読み込まれない、プリンタドライバがない、マクロの振る舞いが変わる、アンチチートがフラグを立てる、ニッチなアクセサリが動かない、などの細かな不具合が積み重なるとアップグレードの価値が吹き飛びます。

ベンダーはテストマトリクスの爆発で費用を払います。問うべきは「起動するか」だけではありません:

組み合わせが増えるごとにQA時間、ドキュメント、サポートチケットが増えます。移行は予測可能だったリリースを恒常的なインシデント対応の連続に変えることがあります。

開発者はライブラリの移植、ISAに合わせた性能クリティカルなコードの書き直し(しばしば手作業での最適化)、自動テストの再構築を負担します。最も難しいのは信頼の回復です:新ビルドが正しく、十分に高速で、実負荷で安定していることを示す必要があります。

移行作業は新機能開発と競合します。チームが2四半期を使って「動くようにする」作業をしている間、その2四半期は製品改善に使えません。多くの組織は古いプラットフォームがブロックにならない限り、移行を先延ばしにします。

新しいCPUアーキテクチャが来るとき、ユーザーが気にするのは命令セットではなく自分のアプリが開くかどうかです。だからこそ“橋”が重要です:新しい機械で古いソフトを動かし、エコシステムが追いつくまでの時間を稼ぎます。

エミュレーションはCPU全体をソフトウェアで模倣します。最も互換性が高い一方で、通常は遅くなります。

バイナリ翻訳(動的に行うことが多い)はx86コードの断片を実行時に新しいCPUのネイティブ命令へ書き換えます。多くの現代的な遷移はこれで“発売日に使える”体験を提供します:既存アプリをインストールすれば互換レイヤーが裏で翻訳します。

価値は単純です:全てのベンダーがネイティブビルドを出すのを待たずに新しいハードを使い始められます。

互換レイヤーは一般的で振る舞いが良いアプリにはうまく動きますが、端では苦戦します:

多くの場合、ハードウェアサポートが本当の制約になります。

仮想化は特定の古いOSやJavaスタック、業務アプリのために丸ごとのレガシー環境が必要な場合に有効です。スナップショット、隔離、簡単なロールバックができ運用上はクリーンですが、何を仮想化するかに依存します。

同一アーキテクチャのVMはほぼネイティブに近い速度ですが、異アーキテクチャのVMは通常エミュレーションに頼って遅くなります。

橋渡しは通常オフィス系アプリやブラウザ、日常生産性ソフトでは十分に機能します(「十分速ければよい」)。しかしリスクが高いのは:

実務では、橋渡しは時間を稼ぎますが、移行作業を完全になくすことはめったにありません。

CPUの議論はしばしば単一のスコアボードのように聞こえますが、実際はデバイスの制約と人々が実際に走らせるワークロードに合うことが勝敗を決めます。

x86がPCのデフォルトになったのは、壁コンセント電源下で強いピーク性能を出し、業界がその前提で周辺を構築したためでもあります。

デスクトップやノートの購入者は素早い対話性能(アプリ起動、コードコンパイル、ゲーム、大規模なスプレッドシート)を評価してきました。これが高いブーストクロック、幅広いコア、アグレッシブなターボ挙動を重視する方向へ働きます。

一方で省電力は全く別物です。バッテリ、熱、ファンノイズ、薄型筐体が制約になれば、1ワットあたりの仕事量を継続的にこなせるCPUが優れます。効率は単にエネルギーの節約だけでなく、熱制限内で持続的に性能を保てることを意味します。

スマホやタブレットは厳しい電力封筒と大量生産のコスト敏感性の中で進化しました。そこで評価されるのは効率に最適化された設計、統合コンポーネント、予測可能な熱挙動です。

同時にOS、アプリ、シリコンがモバイル優先の前提で一緒に進化したエコシステムが形成されました。

データセンターではCPU選択は単なるベンチスコアではありません。オペレータは信頼性機能、長いサポート期間、安定したファームウェア、監視、成熟したハイパーバイザ/管理ツールを重視します。

新しいアーキテクチャがperf/wattで魅力的に見えても、運用面の不確実性が利点を上回ることがあります。

現代のサーバーワークロードは多様です:ウェブサービングは高スループットと効率的なスケーリングを好み、データベースはメモリ帯域やレイテンシの一貫性を重視し、AIはアクセラレータとソフトウェアスタックへ価値をシフトさせています。

ワークロードの混合が変われば勝つプラットフォームも変わり得ますが、周辺のエコシステムが追いつかなければ実際には変わりません。

新しいCPUアーキテクチャが技術的に優れていても、日常ツールがソフトをビルド、出荷、サポートしやすくしなければ失敗します。多くのチームにとって「プラットフォーム」とは命令セットだけでなく配信パイプライン全体です。

コンパイラ、デバッガ、プロファイラ、コアライブラリは開発者行動を静かに形成します。ベストなコンパイラフラグやスタックトレース、サニタイザ、パフォーマンスツールが遅れて到着するか挙動が異なれば、チームはリリースを賭けるのをためらいます。

小さな欠落も重要です:ライブラリがない、デバッガプラグインが不安定、CIビルドが遅いなどで「移植できる」は「今四半期はやらない」へ変わります。x86ツールチェーンがIDE、ビルドシステム、CIテンプレートのデフォルトである限り、最小抵抗の道が開発者を引き戻します。

ソフトはインストーラ、アップデータ、リポジトリ、アプリストア、コンテナ、署名バイナリといったパッケージ慣行を通じてユーザーに届きます。プラットフォーム移行は次の不快な問いを突きつけます:

配布が混乱すればサポートコストが跳ね上がり、多くのベンダーは対応を避けます。

企業は大規模に管理できるプラットフォームを買います:イメージング、デバイス登録、ポリシー、エンドポイントセキュリティ、EDR、VPNクライアント、コンプライアンス報告。これらのツールのどれかが新しいアーキテクチャで遅れているとパイロットは止まります。

「私のマシンでは動く」はITが展開・保護できない限り無意味です。

開発者とITは結局「どれだけ早く出荷してサポートできるか」という実用的な問いに収束します。ツールと配布が生産性に与える影響はベンチマークよりも決定的なことが多いのです。

チームが移行の摩擦を減らす現実的な方法の一つは、アイデアからテスト可能なビルドまでの時間を短縮することです。特に同じアプリを異なる環境(x86対ARM、異なるOSイメージ、あるいは異なるデプロイ対象)で検証する際に有効です。

Koder.aiのようなプラットフォームは、チャットインターフェースを通じてリアルなアプリ(Reactベースのフロントエンド、Goバックエンド、PostgreSQLデータベース、モバイルにはFlutter)を素早く生成・反復できる点でこのワークフローにフィットします。移行作業に特に関連する2つの機能は:

Koder.aiはソースコードのエクスポートをサポートするため、実験から従来のエンジニアリングパイプラインへの橋渡しにもなります。実験で速く進めつつ、最終的に保守可能なコードを自分たちで管理するための助けになります。

ARMがラップトップやデスクトップに進出する動きは、プラットフォーム移行がいかに難しいかを再確認させます。理屈の上では簡単です:ワット当たりの性能向上、静音化、長いバッテリ駆動時間。

しかし実際の成功はCPUコアよりも、まわりを取り巻くすべて──アプリ、ドライバ、配布方法、そして誰がインセンティブを整えるか──に依存します。

AppleがIntelからApple Siliconへ移行できたのは、ハード設計、ファームウェア、OS、開発ツール、主要な配布チャネルを自社で制御していたからです。

その制御により多数の独立パートナーの動きを待たずにクリーンな移行ができました。開発者には明確なターゲットが与えられ、ユーザーには互換性の道筋が示され、Appleは主要ベンダーにネイティブビルドを出すよう圧力をかけられました。アプリがネイティブでない場合でも、移行計画自体が製品として設計されていたためユーザー体験はしばしば許容範囲に収まりました。

Windows on ARMは別の側面を示します。Microsoftはハードウェアエコシステムを完全に制御しておらず、Windows PCはOEMの選択や長い尾のデバイスドライバに大きく依存します。

これが一般的な失敗点を生みます:

ARMの最近の進展は重要な教訓を強化します:スタックの多くを制御するほど遷移は速く、断片化が少なく済むということです。

パートナーに依存する場合、チップベンダー、OEM、開発者、IT買い手が同時に動く理由と明確な調整が必要になります。

プラットフォームの変化が失敗するのは退屈な理由からです:古いプラットフォームはまだ機能している、既に多くのコスト(お金と習慣)が支払われている、そして実際のビジネスはエッジケースに生きているからです。

新しいプラットフォームが定着するには三つが揃うことが多いです:

成功する移行はスイッチを切るようなものではなく、管理された重複です。段階的な導入(まずパイロットグループ)、二重ビルド(旧+新)、テレメトリによる監視(クラッシュ率、性能、機能利用率)で問題を早期に捕捉します。

同じくらい重要なのは旧プラットフォームのサポート期間の公表、社内の明確な期限、移動できないユーザー向けの計画です。

x86は依然として巨大な勢いを持っています:何十年もの互換性、企業ワークフローの深い根付き、幅広いハードウェアオプション。

しかし、電力効率、統合のしやすさ、AI向けの計算需要、シンプルなデバイス運用といった新たな要求からの圧力が高まっています。最も難しい争いは生の速度の差ではなく、切り替えが安全で予測可能で価値あると感じさせることなのです。

x86 はCPUの命令セットアーキテクチャ(ISA)で、ソフトウェアが最終的に実行される機械語命令の集合です。

この投稿での「優位性」は、大量の出荷数、最大級のソフトウェアカタログ、そして**デフォルトの認識(マインドシェア)**という複合的な利点を指しており、単なるベンチマーク上の優位ではありません。

ISAはCPUが理解する「言語」です。

もしアプリがx86向けにコンパイルされていれば、x86 CPU上でネイティブに動きます。別のISA(例:ARM)に移る場合は、通常ネイティブ再ビルドが必要か、古いバイナリを動かすために翻訳/エミュレーションに頼ることになります。

後方互換性があると、新しいマシンでも古いソフトが最小限の変更で動き続けます。

PCの世界ではそれが製品期待になっており、アップグレードがアプリを書き直すことやワークフローを捨てることを強いるべきではない、という前提になっています。

チップは命令を実行する『やり方』(マイクロアーキテクチャ)を変えられますが、**命令そのもの(ISA)**を安定させておけば既存プログラムを壊さずに性能や機能を向上できます。

このため、キャッシュや分岐予測、実行方式が大きく変わっても古いバイナリは動作します。

典型的に壊れるのは次のような箇所です:

多くの場合、主要アプリ自体は動くことがある一方で、周辺の『接着剤』が動かなくなることが問題になります。

移行を阻むのは多くの場合『欠けているドライバ』やサポートされない周辺機器です。

互換レイヤーはアプリを翻訳できますが、ベンダーが新しいOSやアーキテクチャ向けの安定したカーネルドライバを出していなければ、ニッチなスキャナやPOS機器、USB鍵などは動かせません。

インストールベースが開発優先度を決めます。

顧客の大半がWindows x86にいるなら、開発者はまずそこに出荷し、テストし、問題を直します。別のアーキテクチャをサポートすることはCIビルド、QAマトリクス、ドキュメント、サポート負荷を増やすため、需要が明確になるまで保留されがちです。

それだけでは不十分です。

リコンパイルは一部分に過ぎません。必要になるのは:

最も難しいのは、新ビルドが実環境で正しく、十分に速く、安定していることを証明する作業です。

それらは“橋渡し”であり、万能薬ではありません:

これらはエコシステムが追いつくまでの時間を稼ぐ手段ですが、ドライバや低レイヤーの問題は依然として移行の限界になります。

移行は単純なベンチマーク勝負ではありません。ユーザーは総コスト(時間、習慣の変更、小さな故障の連鎖)で判断します。

実務的には、次をチェックするパイロットが重要です:

ロールアウトは「一斉切替」ではなく、ロールバック可能な制御された展開で行うべきです。