2025年11月24日·1 分

技術的比較マトリクス用ウェブサイトの作り方

明確な評価基準、スコアリング、フィルタ、SEOに配慮したページを備えた技術的意思決定向け比較マトリクスの計画・設計・構築方法を学びます。

明確な評価基準、スコアリング、フィルタ、SEOに配慮したページを備えた技術的意思決定向け比較マトリクスの計画・設計・構築方法を学びます。

比較マトリクスは、それが誰のどんな決定を助けるかによって有用さが決まります。テーブルやフィルタ、スコアリングを設計する前に、誰がサイトを使い、何を決めようとしているのか具体化してください。これを怠ると、誰も求めていない質問に答える美しいグリッドを作ってしまいがちです。

異なる利用者は同じ「機能比較」を非常に違う観点で見ます:

最初のバージョンでは主要な対象を一つ選んでください。副次的なユーザーをサポートすることは可能ですが、サイトのデフォルトビュー、用語、優先順位は主要ユーザーに合わせるべきです。

マトリクスが実際に支援する具体的な決定を書き出します。例:

これらが、どの基準をトップレベルのフィルタにするか、どれを「詳細」にまわすか、何を省けるかを決めます。

「エンゲージメントを増やす」のような曖昧な目標は避け、意思決定の進捗を反映する指標を選びます:

“技術評価”は多面的です。ユーザーにとって重要な項目に合意してください。例:

これらの優先度を平易な言葉で記録してください。後のデータモデル、スコアリングルール、UX、SEOの羅針盤になります。

データモデル次第で、マトリクスが一貫性を保ち、検索可能で、更新しやすいかが決まります。画面設計の前に、比較する「もの」、計測する内容、証拠の保存方法を決めてください。

多くの技術比較サイトは次の基本ブロックを必要とします:

基準は再利用可能なオブジェクトとしてモデル化し、各ベンダー/製品の値を別レコード(しばしば“アセスメント”や“基準結果”と呼ぶ)として保存してください。こうすると基準リストを複製せずに新しいベンダーを追加できます。

すべてをただのテキストに押し込まないでください。人々がフィルタや比較で使う方法に合わせた型を選びます:

また「不明」「該当なし」「計画中」をどのように表現するか決めて、空白が「ない」と誤解されないようにしてください。

基準は進化します。次を保存してください:

内部のコメント、交渉メモ、レビュアの信頼度は別フィールド(あるいは別テーブル)にしておきます。公開ページには値とエビデンスを表示し、内部ビューには率直な文脈やフォローアップタスクを含められるようにします。

訪問者がコンテンツの所在と辿り方を予測できることが、比較マトリクスサイトの成功要因です。人々がどのように選択肢を評価するかを反映する情報設計を決めてください。

四半期ごとに変わらない、シンプルで安定した分類を初めに作ります。ベンダー名ではなく「問題領域」で考えてください。

例:

ツリーは浅め(通常は2レベルで十分)に保ち、さらに細かくしたければタグやフィルタ(例:「オープンソース」「SOC 2」「セルフホスト」)を使ってください。これにより閲覧が容易になり、後で重複コンテンツが生まれるのを防げます。

サイトは繰り返し使えるテンプレートを中心に設計します:

混乱を減らし信頼性を高める補助ページも用意します:

URLルールは早めに決めて、あとで面倒なリダイレクトを増やさないようにします。よくあるパターン:

/compare/a-vs-b(多者は/compare/a-vs-b-vs-c)/category/ci-cdURLは短く、小文字で、一貫させます。製品には正規のスラッグ(安定した名前)を使い、同じツールが/product/oktaと/product/okta-iamの両方に出ないようにしてください。

最後に、フィルタやソートがURLにどう影響するかを決めます。共有可能なフィルタビューを望む場合はクリーンなクエリ文字列の方針(例:?deployment=saas&compliance=soc2)を決め、ベースページはパラメータ無しでも有用に保ちます。

マトリクスが役に立つのは、ルールが一貫しているときです。ベンダーや基準を増やす前に「計算方法」と各フィールドの意味を固定してください。これにより後の議論(「SSOのサポートって何を指している?」)を避け、結果の正当性を担保できます。

基準は正式な仕様として扱います。各基準には:

「コンプライアンス」と「認証」のような近似重複は、区別が明確でない限り避けてください。必要なら(例:「保存時の暗号化」と「通信時の暗号化」)は別々の基準として定義します。

同じ尺度を使わないと比較に意味がありません。基準に合うスコアリングルーブリックを書いてください:

各点数が何を意味するかを書きます。例えば「3」は“制限はあるが要件を満たす”、「5」は“高度なオプションを持ち実運用で実績あり”などです。"N/A"の使用可否と条件も明記してください。

重み付けはマトリクスの物語を変えます。意図的に選んでください:

カスタム重みをサポートする場合はガードレール(例:重みの合計は100、低/中/高のプリセット)を用意します。

データ欠損は避けられません。方針を文書化して一貫適用します:

こうした方針があると、成長しても公正で再現可能、信頼できるマトリクスを維持できます。

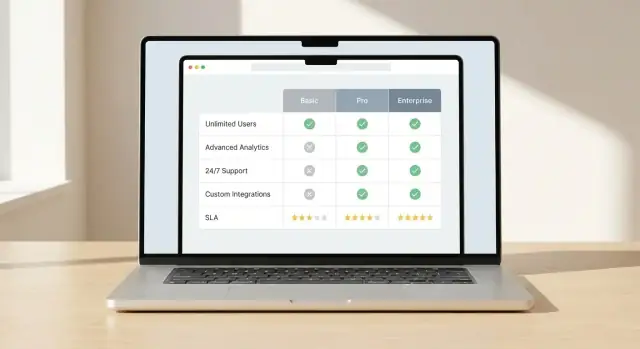

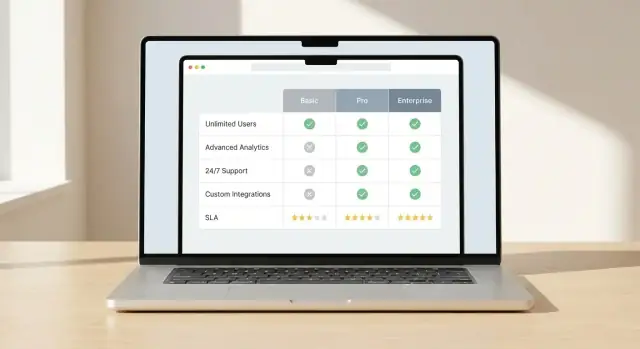

比較UIの成功は一つの点にかかっています:読者が意味のある差を瞬時に見分けられるか。主要な比較ビューと差を際立たせる視覚的合図を決めてください。

一つの主要パターンを選び、それに沿ってすべてを設計します:

一貫性が重要です。ユーザーがある領域で差の見せ方を学んだら、同じルールを他でも適用してください。

すべてのセルを逐一スキャンさせない工夫をします:

色の意味はシンプルかつアクセシブルに:良い/悪い/中立の1色ずつ。色だけに頼らずアイコンや短いラベルも使ってください。

技術的なマトリクスは長くなりがちです。使いやすさを保つ:

モバイルでは小さなグリッドは受け入れられません。次を提供します:

差が見やすければ読者はマトリクスを信頼して使い続けます。

人がリストを絞り、意味のある差を短時間で見つけられるとき、マトリクスは「速い」と感じます。フィルタ、ソート、サイドバイサイドはその中核的な操作です。

保存できる質問に基づいた小さなフィルタセットから始めます。よく有用なのは:

フィルタは組み合わせ可能にし、マッチ数を表示してクリアが簡単にできるようにします。互いに排他的なフィルタがあるなら、無効な組合せを防ぐ方が、"0件"を出して説明のない状態にするより親切です。

ソートは客観的・対象者別の優先順位の両方を反映すべきです。明快なオプションをいくつか提供します:

「ベストスコア」を表示するなら、それが総合スコアなのかカテゴリスコアなのかを示し、ユーザーがスコアリングビューを切り替えられるようにします。隠れたデフォルトは避けてください。

通常2〜5件を選んで固定列レイアウトで比較できるようにします。重要な基準は上部近くに固定し、残りは折りたたみ可能なセクションにまとめて圧倒を減らします。

選択、フィルタ、ソートを保持する共有リンクを提供して、チームが同じショートリストを再現できるようにします。

エクスポートは内部レビューや調達で有用です。必要な場合はCSV(分析用)とPDF(共有用)を提供します。エクスポートには選択したアイテム、基準、タイムスタンプ、スコア注記を含め、後で誤解を生まないようにします。

ユーザーが意思決定にマトリクスを使うには、信頼が必要です。根拠を示さず強い主張をすると、偏っているか古いと見なされます。

事実に関する各セルは裏付けが必要です。事実値の横に“ソース”フィールドを持たせます:

UIでは小さな“Source”ラベルをツールチップや展開行に置くなど、煩雑にならない見せ方を工夫してください。

「いつ更新されたか」と「誰が担保しているか」を答えるメタデータを追加します。製品ごと(必要なら基準ごと)に「最終検証日」と、レビュー担当者(チーム/人)を表示します。頻繁に変わる項目(機能フラグ、統合、SLA条項など)では特に重要です。

すべてが二値でない場合があります。主観的な基準(導入のしやすさ、サポート品質)や不完全な情報には次のような信頼度を表示します:

これにより過度の精度を避け、読者が注記を掘るよう促せます。

各製品ページに主要フィールドの変更履歴(価格、主要機能、セキュリティ姿勢の変更)を小さく置いておくと、何が新しいかが一目で分かり、リピーターは古い情報で比較していないと確認できます。

マトリクスは現行性が命です。公開前に誰がデータを変えられるか、どうレビューするか、スコア付けの一貫性をどう保つかを決めてください。

まずはマトリクスデータの格納場所を決めます:

重要なのは技術ではなく、チームが壊さずに信頼性持って更新できるかどうかです。

変更は単なる編集ではなく、プロダクトリリースのように扱います。実用的なワークフローの例:

更新が頻繁なら、変更要求フォーム、"更新理由"フィールドの標準化、定期レビュ―サイクル(月次/四半期)などの軽量な慣行を導入してください。

バリデーションで静かな劣化を防ぎます:

手動編集は拡張しません。多くのベンダーや頻繁なフィードがあるなら:

ワークフローが明確で強制されれば、マトリクスは信頼性を維持し、ユーザーはそれに基づいて行動します。

表面的には単純に見えますが、多量の構造化データを遅延なく取得・レンダリング・更新する実装が体験の良し悪しを決めます。ページを高速に保ちつつチームが変更を出しやすくすることが目標です。

データの更新頻度とインタラクティビティに応じてモデルを選択します:

マトリクスは(多数のベンダー×多数の基準)ですぐ重くなります。早期に対策を:

検索はベンダー名と別名、主要な基準ラベルをカバーするべきです。インデックスに含める項目:

結果はユーザーをベンダー行や基準セクションへ直接ジャンプさせるように返すとよいです。

次のようなイベントを追跡して、意図と障害を見ます:

イベントペイロードにはアクティブなフィルタと比較中のベンダーIDを含め、どの基準が意思決定を駆動しているか学べるようにします。

比較サイトを短時間で立ち上げたい場合、CRUD管理画面や基本的なテーブルUXを一から作る代わりに、vibe-coding系のプラットフォーム(例:Koder.ai)のようなツールを使うのは実用的な近道です。エンティティ(製品、基準、エビデンス)、必要なワークフロー(レビュー/承認)、主要ページ(カテゴリハブ、製品ページ、比較ページ)をチャットで記述し、生成されたアプリを反復して調整できます。

Koder.aiはターゲットスタックがそのデフォルトに合う場合に特に有用です:ウェブはReact、バックエンドはGo+PostgreSQL、モバイルの将来的需要があればFlutterも選べます。ソースコードのエクスポート、スナップショット/ロールバック、スコアリングロジックの調整やカスタムドメインでのデプロイも可能です。

比較ページは高い購買意図を持つ訪問者の最初の接点であることが多い("X vs Y"、"best tools for…"、"feature comparison")。SEOは各ページに明確な目的があり、安定したURLで、実際に差別化されたコンテンツがある場合に効果的です。

各比較ページに固有のページタイトルとH1を与え、意図に合わせます:

冒頭で誰向けの比較か、何を比較しているか、主要な差は何かを短く述べ、コンパクトな結論(例:"XはAに向く、YはBに向く")を入れるとページが単なる自動生成表に見えません。

構造化データは可視コンテンツを正確に反映する場合に検索結果で有利に働きます。

全てのページに無理にスキーマを詰め込んだり、裏付けのないフィールドを追加したりするのは避けてください。量よりも一貫性と正確さが重要です。

フィルタやソートは多くの類似URLを生成します。どれをインデックスさせるかを決めてください:

検索エンジンと人が同じ辿り方で閲覧できるように:

アンカーテキストは「価格モデルを比較」「セキュリティ機能」のような説明的な文言を使い、“ここをクリック”のような反復的な文言は避けてください。

大規模なマトリクスでは、SEO成功は何をインデックスさせないかにかかっています。サイトマップには価値の高いページだけを含め(ハブ、主要製品、キュレーションされた比較)、自動生成され薄い内容の組合せページはインデックスから外し、クロール統計を監視して検索エンジンが実際に役立つページを巡回するようにします。

マトリクスは正確で使いやすく、信頼できる状態を保ってこそ機能します。ローンチはスタートに過ぎません:テスト→リリース→学習→更新のサイクルを続けてください。

ユーザビリティテストでは結果に焦点を当てます:ユーザーはより早く、より自信を持って決められるか?現実的なシナリオ(例:「厳格なセキュリティ要件の50人チーム向けに最適な選択を選んでください」)を与え、次を測ります:

比較UIは基本的なアクセシビリティで失敗しがちです。ローンチ前に確認:

最も閲覧されるベンダー/製品と重要な基準を優先してスポットチェックし、次のようなエッジケースをテストします:

社内と外向けにデータは変わることを明示します:

ユーザーが問題報告や更新提案を出せる方法を定義します。データエラー、欠落機能、UX問題などカテゴリを選べる簡単なフォームを提供し、応答目標(例:2営業日以内に受付を確認)を設定してください。時間をかけてこれが最も有益な改修のソースになります。

まずは主要な対象ユーザーと、彼らが下そうとしている具体的な意思決定(ショートリスト作成、置換、RFP、要件の検証)を定義します。その後、そのユーザーの制約に合わせて基準やUXのデフォルトを選びます。

内部チェックの目安:ランディングからスコアリング全体を覚えさせることなく、ユーザーが速やかに妥当なショートリストを作れるか?

各セルを裏付けのある主張として扱ってください。値の横にエビデンス(ドキュメントの該当箇所、リリースノート、内部テストなど)を保存し、UIではツールチップや展開可能な注記で表示します。

また次を表示してください:

比較を一貫させるためのコアエンティティを使います:

基準を再利用可能なオブジェクトとしてモデル化し、各製品の値を個別に保存すると、ベンダー追加時に基準を複製せずに済みます。

人々がフィルタや比較で使う方法に合わせたデータ型を選びます:

Unknown(不明)、Not applicable(該当なし)、Planned(計画中) の明確な状態を定義し、空欄が“いいえ”と解釈されないようにします。

少数の再利用できるテンプレートを中心に設計します:

信用性と明瞭さを高めるために、メソドロジー、用語集、問い合わせ・訂正ページを用意します。

拡張性があり一貫したURLルールを早期に決めます:

/compare/a-vs-b(多者比較は-vs-cを追加)/category/ci-cd共有可能なフィルタビューをサポートするなら、ベースページは安定させ、クエリ文字列(例:?deployment=saas&compliance=soc2)でフィルタを表現します。フィルタやソートによる重複コンテンツ対策として正規URLも計画してください。

各基準ごとにルーブリックを書き、基準に合ったスコアリング方式を選びます:

未知値が合計にどう影響するか(0/中立/除外)を明確にし、サイト全体で一貫して適用します。

重み付けは物語を変えます。意図的に決めてください:

カスタム重みを許可する場合は合計が100になるなどのガードレールや、低/中/高のプリセットを用意します。

ショートリスト化の速度を重視した設計にします:

調達やオフライン検討が必要ならCSV/PDFエクスポートを用意し、タイムスタンプやスコア注記を含めて誤解を防ぎます。

大規模なマトリクスでの一般的なパフォーマンス対策:

実用的なアプローチはハイブリッドレンダリング:安定したページは事前生成し、インタラクティブなマトリクスデータはAPI経由で読み込む方法です。