2025年10月19日·1 分

内部オートメーションのカバレッジを監視するウェブアプリの作り方

内部の自動化カバレッジを追跡するウェブアプリの設計と構築方法:指標、データモデル、統合、ダッシュボードUX、アラートについて解説します。

内部の自動化カバレッジを追跡するウェブアプリの設計と構築方法:指標、データモデル、統合、ダッシュボードUX、アラートについて解説します。

何かを作る前に、組織内で「オートメーションカバレッジ」が何を意味するかを書き出してください。そうしないと、ダッシュボードが無関係な数値の寄せ集めになり、チームごとに解釈が分かれてしまいます。

まず、測定する単位を選びます。一般的な選択肢:

v1では1つの定義を主に選び、将来追加する可能性のある副次的なタイプをメモしておきます。承認が必要な「半自動化」ステップのようなエッジケースについても明確にしてください。

利用者ごとに知りたいことは異なります:

5〜10個の「トップ質問」を書き、プロダクト要件として扱ってください。

主要な成果を定義します:可視化(何が存在するか)、優先付け(次に何を自動化すべきか)、説明責任(誰が所有しているか)、トレンド追跡(改善しているか)。

v1の明確な境界を設定しましょう。例:「品質はまだスコア化しない」「工数削減は測らない」「CIベースのテストのみ含め、ローカルスクリプトは除外する」など。

成功の定義例:継続的な採用(週次アクティブユーザー)、高いデータ鮮度(例:24時間以内の更新)、盲点の減少(重要システムのカバレッジがマッピングされている)、および実行の測定(オーナーが割り当てられ、ギャップが月ごとに縮小している)。

オートメーションカバレッジを測るには、まず「自動化の証拠」がどこにあるかを把握する必要があります。多くの組織では、自動化はさまざまなツールに散在しています。

実用的なインベントリで次に答えられるようにします:何が自動化の証拠になるのか、どこから取得できるのか?

典型的なソース:CIパイプライン(ビルド/テストジョブ)、テストフレームワーク(ユニット/統合/E2Eの結果)、ワークフローツール(承認、デプロイ、チケットの遷移)、ランブック(スクリプトや手順書)、RPAプラットフォーム。各ソースについて、後で結合できる識別子(リポジトリ、サービス名、環境、チーム)と保存する「証拠」(ジョブ実行、テストレポート、自動化ルール、スクリプト実行)を記録してください。

次に、「あるべき姿」を定義するシステム(リポジトリホスティング、課題管理、CMDB/サービスカタログ)をリストアップします。これらは通常、サービス、オーナー、重要度の正当な一覧を提供し、単に活動を数えるだけでなくカバレッジを計算するために不可欠です。

各ソースに対して、最も壊れにくい取り込み方法を対応させます:

レート制限、認証方法(PAT、OAuth、サービスアカウント)、保持期間、データ品質の既知の問題(サービス名の変更、命名不整合、オーナー不在)を記録してください。

さらに各コネクタ(およびオプションで各指標)に対してソース信頼度スコアを計画し、数値が「高信頼」か「ベストエフォート」かをユーザーが見られるようにします。これにより誤った精度の提示を防ぎ、後のコネクタ改善の優先度付けに役立ちます。

有用なカバレッジダッシュボードは、"自動化するつもりのもの"と"実際に最近動いたもの"を分離するデータモデルから始まります。これらを混ぜると、自動化が古くても数値が良く見えてしまいます。

以下のビルディングブロックから始めてください:

主要な報告レベルを1つ選び、まずはそれに固執してください:

複数のビューは後からサポートできますが、最初のバージョンは1つの「真実のソース」を持つべきです。

リファクタリングに耐えるIDを使ってください:

表示名は編集可能であり識別子にはしないでください。

実用的なパターン:

これにより「何がカバーされるべきか」「それをカバーすると主張しているものは何か」「実際に何が動いたか」を答えられます。

次のような項目をキャプチャします:

last_seen_at(アセットがまだ存在している)last_run_at、last_failure_atlast_reviewed_at(誰かが主張を確認した日時)鮮度フィールドのおかげで、議論なしに「カバーされているが古い」アイテムをハイライトできます。

カバレッジ指標が曖昧だと、すべてのチャートが議論の種になります。まずはエグゼクティブ向けの主要な指標を1つ選び、チーム向けに補助的な内訳を追加してください。

多くの組織は次のいずれかを選びます:

すべて表示しても良いですが、どれが「見出し」かは明確にしておきます。

チームが一貫してスコアできるよう、明確なルールを書いてください:

二人が同じ項目を同じように評価できないなら、定義を洗練させてください。

リスク、ビジネスインパクト、実行頻度、時間削減などの入力には小さな整数スケール(1–5)を使ってください。例:weight = risk + impact + frequency。

次のような証拠がないと「自動化」とカウントしないでください:

これによりカバレッジは自己申告ではなく観測可能な信号になります。

採点ルールと具体例を1つの共有ページにまとめ、ダッシュボードからリンクしてください。一貫した解釈がトレンドの信頼性を生みます。

社内向けのカバレッジアプリは「退屈」であるべきです:運用しやすく、変更しやすく、数値の由来が明確であること。多くの場合、分散システムよりもシンプルな「API + DB + ダッシュボード」が最初は強いです。

チームが既にサポートしているスタックを選んでください。典型的なベースライン:

初期の内部版を素早く出すために、vibe-codingアプローチも有効です。たとえば Koder.ai は構造化された仕様からReactダッシュボードとGo + PostgreSQLのバックエンドを生成し、チャット経由の反復をしつつソースコードの完全エクスポートと通常のデプロイを保てます。

シンプルなシステムでも責務は分けてください:

カノニカルなエンティティ(チーム、サービス、自動化、証拠、所有者)はリレーショナルに。トレンド(時系列の実行、週次カバレッジ)は次のどちらかで保存してください:

複数チームで共有するなら早めに org_id/team_id フィールドを追加してください。これにより権限設計が容易になり、後で「1つのダッシュボードをセグメントしてほしい」と求められたときのマイグレーションが楽になります。

dev/staging/prod を運用し、データの移動方法を定義します:

UIの使いやすさについては /blog/design-dashboard-ux を参照してください。

カバレッジダッシュボードは真実のソースになり得るため、アクセス制御とデータ取り扱いはチャートと同じくらい重要です。シンプルに始め、後から厳格にできる設計にしてください。

社内にSSOがあれば最初から統合してください(OIDCが簡単、SAMLは大規模で一般的)。素早くローンチする必要があるなら、社内の認証プロキシでヘッダーにIDを注入する方法で始め、後でネイティブSSOに切り替えることも可能です。

いずれにしても、メールアドレスは変わる可能性があるので安定したユーザーキーに正規化し、最小限のユーザープロフィールを保存し、可能ならグループ/チーム情報はオンデマンドで取得してください。

小さなロールセットを定義し、UIとAPIで一貫させます:

スコープベースの権限を推奨します(スーパーアカウントを減らしボトルネックを避けるため)。

証拠にはCIログやインシデントチケット、内部ドキュメントのリンクが含まれることが多いので、それらのURLや生ログへのアクセスを制限してください。検証に必要な最小限(ビルドID、タイムスタンプ、短いステータス要約)だけを保存し、完全なログをDB内にコピーするのは避けます。

カバレッジ主張やメタデータへの手動編集は必ず監査記録を残してください:誰が、何を、いつ、なぜ変更したのか(自由記述の理由)。最後に、実行履歴と証拠の保持方針を定義し、古いレコードを安全に削除できるようにしておきます。

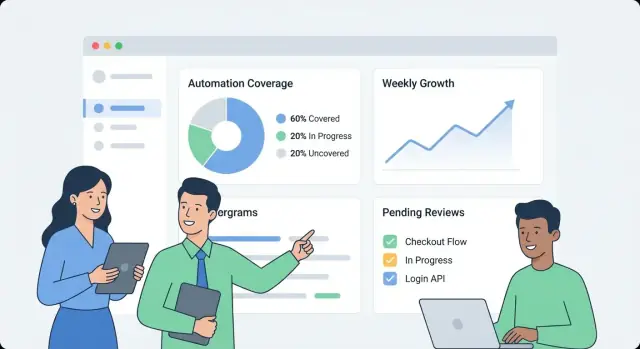

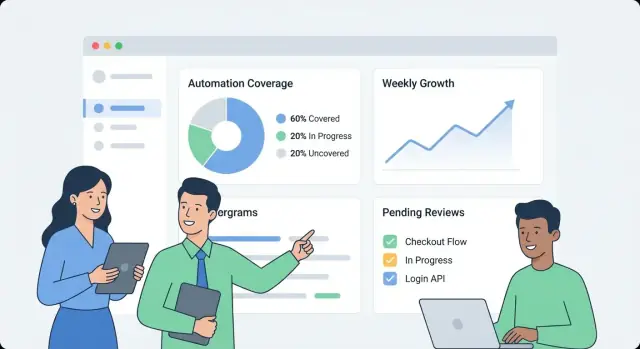

優れたカバレッジダッシュボードは、誰かが1分以内に次の3つに答えられることを目指します:今の状況は? 何が変わった? 次に何を直すべき? UXはデータソースではなく、これらの意思決定を中心に設計してください。

最初の画面はシンプルな概要にします:

ラベルは平易に(「最近自動化された」は「証拠の鮮度」より良い)、技術的ステータスを読み解かせないようにします。

概要からサービス/プロセスページに入ると「何が」「どのように」自動化されているかが分かるようにします:

各行/カードには「数値の裏側の理由」を含めます:証拠リンク、オーナー、最終実行ステータス、明確な次のアクション(「ジョブ再実行」「オーナー割当」「証拠追加」)。

組織の実務に合うフィルタを提供します:チーム、環境(prod/staging)、重要度、日付範囲、ソースシステムなど。

フィルタ状態はURLパラメータとして可視かつ共有可能にして、例えば「Prod + Tier-1 + last 14 days」のようなリンクを関係者に送れるようにします。

長いドキュメントではなくインライン定義を使います:

統合はカバレッジアプリを現実化する部分です。目標はCIやテストツールのあらゆる機能を鏡写しすることではなく、次の一貫した事実を取り出すことです:何が、いつ、何をカバーして実行されたか、誰が所有しているか。

まずは自動化の信号を出すシステム(GitHub Actions、GitLab CI、Jenkins、JUnit、pytestなど)から始めます。コネクタが取得(あるいはWebhookで受け取る)べきミニマムペイロード:

コネクタは冪等に保ち、繰り返し取得しても重複を作らないようにしてください。

一部のギャップは意図的(レガシー、サードパーティ制約、停止中の取り組み)です。軽量な「例外」レコードを用意し、次を必須にします:

これにより恒久的な盲点を防ぎ、経営陣のビューが正直になります。

異なるソースは通常一致しません:あるシステムは「payments-service」と呼び、別は「payments」、別はリポのスラッグを使います。

正規化ルールを作ってください:

早めに取り組んでください。下流のすべての指標がこれに依存します。

service_aliases、repo_aliases のようなエイリアステーブルを導入し、多くの外部名を1つのカノニカルエンティティにマッピングします。新しいデータが来たらまずカノニカルIDにマッチさせ、次にエイリアスを照合します。

一致しない新しい名前が来た場合は、管理者が承認できるマージ候補(例:「payments-api」は「payments-service」に似ている)を生成してください。

定期ジョブをスケジュールしてソースごとの最新実行タイムスタンプをチェックし、古くなっているものをフラグ付けします(例:7日間CI実行がない)。UIでこれを表示し、低いカバレッジが欠落データによるものかどうかを分かるようにしてください。

ダッシュボードは便利ですが、アラートと軽量ワークフローが興味あるデータを継続的な改善につなげます。目標は単純です:適切な人に適切なタイミングで行動可能な文脈を含む通知を送ること。

まず小さな高シグナルセットから始めます:

各アラートは関連ドリルダウンビュー(例:/services/payments?tab=coverage または /teams/platform?tab=owners)に直接リンクしてください。

ワンサイズの閾値は避けてください。チームが次のようなルールを設定できるようにします:

これによりシグナルが意味を持ち、アラート疲れを減らせます。

アラートは既存のチャネル(メール、Slack)に送信し、何が変わったか、なぜ重要か、誰がオーナーかを含めます。リアルタイム通知に加え、週次サマリを用意します:

アラートをタスクとして扱い、受領(ack)、割当、ステータス(open/triaged/resolved)を許可します。短いコメント履歴(「PR #1234で修正」)があれば報告は信頼でき、同じ問題が黙って再発するのを防げます。

ダッシュボードが速く感じるのは、UIが必要とする問いにAPIが効率よく答えるときです。最初はダッシュボード優先の最小API設計にし、重い処理はバックグラウンドで事前集計してください。

最初のバージョンではコア画面に合わせたエンドポイントに集中します:

GET /api/services(チーム、言語、ランク等のフィルタ)GET /api/services/{id}/coverage(全体スコア+主要内訳)GET /api/services/{id}/evidence?status=passed&since=...PATCH /api/services/{id}ダッシュボードが即座に描画できるよう、サービス名、オーナー、最終証拠時刻、現在のスコアを1つのペイロードで返す設計にしてください。

一覧とドリルダウンテーブルは常にページネーション(limit + cursor)を使います。頻繁に呼ばれるエンドポイントはAPIレイヤーか共有キャッシュでキャッシュしてください。チーム別のカバレッジのように大量の証拠を走査する処理は夜間バッチでロールアップし、ロールアップ結果は別テーブルやマテリアライズドビューに保存して読み取りを軽くします。

トレンドは日次スナップショットを保存するのが簡単です:

GET /api/services/{id}/trend?days=90 を提供する。スナップショットにより過去指標の再計算を避け、鮮度の可視化が容易になります。

一括オンボーディングを容易にするために:

POST /api/import/services(CSVアップロード)GET /api/export/services.csv書き込み時の検証ルール(必須オーナー、許可されるステータス、未来日付の禁止)を厳格にして、悪いデータを早めに拒否してください。ロールアップが一貫した入力に依存するため、これが後のトラブルを防ぎます。

ダッシュボードは信頼されて初めて役に立ちます。デプロイと運用をプロダクトの一部として扱い、予測可能なリリース、明確な健康指標、壊れたときの簡単な復旧手順を用意してください。

内部アプリは運用コストを抑え迅速に反復できることを優先します:

Koder.aiのようなプラットフォームを使う場合はソースコードのエクスポートとデプロイワークフローを早めに取り入れ、本番プロモーションやロールバックの慣行を守ってください。

複雑なスタックは不要です。重要な信号を出せば良い:

自動DBバックアップと保持ポリシーを設定し、復元が確実にできることを検証してください:

ランブックを用意してください:

少しの運用上の規律があれば、「カバレッジ」が推測になってしまうのを防げます。

モニタリングアプリはチームが信頼し使ってこそ役に立ちます。ローンチをプロダクトとして扱い、小さく始め、明確な所有権を定め、更新のリズムを組み込みます。

オンボーディングは軽量で再現可能に:

目標は「30分で最初のダッシュボードが見える」ことです。1週間もかけて設定させないでください。

2つのリズムを設けます:

スコアが政治化しないように、少人数のガバナンスグループ(例:Eng Productivity + Security/Quality)を定義し、次を担当させます:

変更は /docs/scoring-changelog のようなシンプルなチェンジログで公開してください。

採用は次のようなシンプルな指標で追います:アクティブユーザー数、追跡中のサービス数、鮮度コンプライアンス(最新の証拠があるサービス割合)。これらでイテレーションの優先度を決めます:重み付けの見直し、証拠タイプの拡張、追加コネクタ—常にチームの手作業を減らす改善を優先してください。

外部に学びを共有するなら、ビルドノートやテンプレートを標準化することを検討してください。Koder.aiを使うチームは、開発ワークフローに関するコンテンツ作成や紹介でクレジットを得られる場合があり、内部ツールの継続改良の資金になることがあります。

オートメーションカバレッジは、組織が「自動で処理される作業」と「手動で残る作業」をどう定義するかに依存します。混乱を避けるため、まずv1で測る主要な単位を決めてください(例:プロセス、要件/コントロール、テストスイート、ランブックなど)。承認が必要な「半自動化」ステップなどのエッジケースも明確に書き出します。

良い定義は、別の人が同じ項目を見ても同じ評価になるものです。

まずはユーザーが答えたい「トップ質問」5~10件を書き、それをプロダクト要件として扱ってください。よくある例:

QA、Ops、経営では見る切り口が異なるため、v1でどの層を優先するか決めてください。

「自動化の証拠」がどこにあるか、そして何が『存在すべきか』を定義するシステムを把握してください。

システムオブレコードがないと、活動量は数えられても対象の完全リストが取れないため「カバレッジ」を正しく計算できません。

ソースごとに最も壊れにくい手段を選びます:

また、コネクタの制約(レート制限、認証方式、保持期間)を記録して、データの鮮度と信頼度をユーザーに示せるようにしてください。

意図、主張、証拠を分離するデータモデルにすると、数値が“見せかけで良く見える”のを防げます。

実用的なモデル例:

所有者(チーム/個人)と安定識別子を加えれば、リネームで履歴が壊れるのを防げます。

「存在するだけ」ではなく「最近動いている」かを区別することが重要です。以下の鮮度フィールドを取り込み、必須の証拠ルールを適用します:

last_seen_at(アセットがまだ存在するか)last_run_at、last_failure_atlast_reviewed_at(誰かが主張を確認した時刻)例:『過去30日でN回の成功実行がある場合のみ「自動化済み」とみなす』というルールにすれば、紙上だけのカバレッジを防げます。

見出しとなる指標を1つ選び、採点ルールを明文化してください。代表的な選択肢:

入力重みは小さな整数(1–5)を使い、分類(自動化/半自動/手動)について具体例を示しておくと論争を防げます。

早めに正規化を行い、リネームや重複に備えることが重要です。対策の一例:

service_aliases/repo_aliases のようなエイリアステーブルを用意し、外部名をカノニカルIDにマッピングする。これでチーム再編や名前変更があっても履歴と集計が壊れにくくなります。

可能なら最初からS S O(OIDC/SAML)を統合し、短期的に素早く出したいなら社内認証プロキシを使う選択肢もあります。役割は少数に絞り、UIとAPIで一貫させてください:

証拠にはしばしばCIログやインシデントチケットのリンクが含まれるので、フルログを格納するのではなくビルドIDや短い要約だけ保持し、アクセス制御と監査ログ(誰が何をいつ変更したか)を用意してください。

アラートを行動に結びつけ、グローバルなノイズを避けることが肝心です。高シグナルなアラート例:

チームごとに閾値(最小カバレッジ、陳腐化ウィンドウ、ページング基準)を設定できるようにし、各アラートは該当のドリルダウンページ(例:/services/payments?tab=coverage)に直接リンクするようにします。アラートに対しては受領/割当/解決のワークフローを提供し、短いコメント(例:「PR #1234で修正」)を残せるようにしてください。