2025年11月15日·1 分

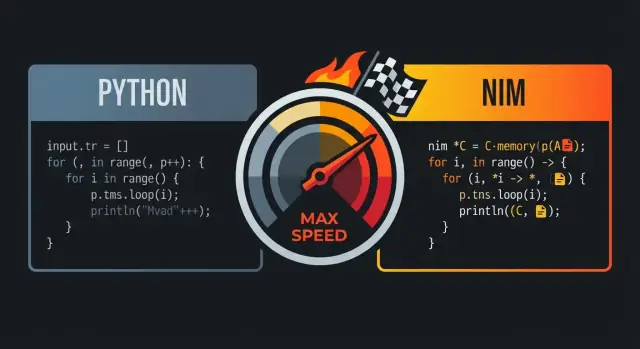

NimがPythonのように感じられてもCに近い速度で動く理由

NimがPythonのように読みやすいコードを保ちながら、高速なネイティブバイナリを生成する仕組みを解説します。実用的にCに近い速度を引き出す特徴と注意点を紹介。

なぜNimはPythonとCと比較されるのか

NimがPythonやCと比べられるのは、両者の「いいところ」を狙っているからです:読みやすく高水準な文法で書ける一方、コンパイルして高速なネイティブ実行ファイルを生成します。

中核の約束:読みやすさと速度の両立

見た目だけで言えば、Nimはしばしば「Python的」に感じられます:インデントによるブロック、分かりやすい制御フロー、明瞭で簡潔に書ける標準ライブラリ。重要な違いは書いた後に何が起きるかです—Nimは重いランタイム上で動くのではなく、効率的な機械語にコンパイルされるよう設計されています。

多くのチームにとって、この組み合わせが魅力です:Pythonでプロトタイプするような感覚でコードを書きつつ、単一のネイティブバイナリとして配布できます。

誰に関係するのか

この比較が刺さるのは主に次のような人たちです:

- 性能の壁に当たっているPython開発者(CPU集約的処理、密なループ、データ処理)

- 重いランタイムに頼らずに素早く反復したいプロダクトチーム

- 日常的なコードでCの速さは欲しいが、低レベルの面倒ごとは避けたいエンジニア

「Cレベルの性能」が実務で意味するもの

「Cレベルの性能」は、すべてのNimプログラムが手作業で最適化されたCと同等になるという意味ではありません。むしろ、数多くのワークロード(数値ループ、パース、アルゴリズム、予測可能なレイテンシを求めるサービス)でCと競えるコードを生成できる、という意味です。

特に効果が出やすいのは、インタプリタのオーバーヘッドを排し、割当てを最小化し、ホットパスを単純に保った場合です。

期待値:速度は選択次第

効率の悪いアルゴリズムはNimでも救えません。大量に割当てを行ったり、大きなデータ構造を不必要にコピーする書き方をすれば遅いコードになります。Nimの約束は、別のエコシステムに書き直すことなく、読みやすいコードから高速なコードへと移行できる道筋を提供することです。

結果として:Pythonのように扱いやすく、必要なときには“金属に近い”挙動を取れる言語、という印象になります。

Python風の構文:ランタイム税を払わずに可読性を得る

Nimは見た目と流れがPythonに似ていると言われます:インデントベース、最小限の句読点、読みやすい高水準の構成要素。違いはNimが静的型付けかつコンパイル言語である点で、表面上の簡潔さを持ちながらランタイムの“税”を負わないことです。

インデントベースのブロックと明快な構造

Python同様、Nimはインデントでブロックを定義します。レビューや差分で流れを追いやすく、あちこちに中括弧を書く必要はありません。括弧は必要に応じて使えば良い程度です。

let limit = 10

for i in 0..<limit:

if i mod 2 == 0:

echo i

視覚的な簡潔さは性能に敏感なコードを書くときに重要です:構文と戦う時間を減らし、意図を表現する時間を増やせます。

見慣れた構成要素:ループ、スライス、文字列

日常的な構成はPython利用者に親しみやすくマッピングされます。

- ループ:範囲やコレクションに対する

forは自然に感じられます。 - スライス:シーケンスや文字列はスライス操作をサポートします。

- 文字列:扱いはシンプルで、実用的な標準ライブラリがあります。

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

重要な違いは内部処理です:これらの構成はVMで解釈されるのではなく、効率的なネイティブコードにコンパイルされます。

邪魔にならない静的型付け

Nimは強い静的型付けですが、型推論を多用するため冗長な型注釈を書かずに済みます。

var total = 0 # intとして推論される

let name = "Nim" # stringとして推論される

パブリックAPIや性能境界で明示的な型が欲しい場合はサポートされていますが、全体に強制はされません。

有益なコンパイラエラーと警告

可読性の重要な一部は安全に保守できることです。Nimのコンパイラは型不整合、未使用変数、疑わしい変換を早期に検出し、実用的なメッセージを出すため、Python的な単純さを保ちつつコンパイル時チェックの恩恵を受けられます。

Pythonの可読性が好きなら、Nimの文法は親しみやすいでしょう。ただしNimのコンパイラは仮定を検証し、高速で予測可能なネイティブバイナリを生成します—冗長なボイラープレートに変わることなく。

Nimのコンパイル:ソースからネイティブバイナリへ

Nimはコンパイル言語です:.nimファイルを書き、コンパイラがそれをネイティブ実行ファイルに変換します。一般的にはNimのCバックエンドを経由し(C++やObjective-Cもターゲット可能)、生成されたバックエンドソースをGCCやClangがコンパイルします。

「ネイティブバイナリ」の実際の意味

ネイティブバイナリは言語の仮想マシンやインタプリタなしで動作します。これがNimが高水準に見えながらランタイムコストを避けられる理由の一つです:起動時間が早く、関数呼び出しは直接的で、ホットループはハードウェアに近い速度で実行されます。

プログラム全体に対する最適化機会

Nimは事前(AOT)コンパイルするため、ツールチェーンはプログラム全体を通じて最適化できます。インライン化、デッドコード除去、リンク時最適化(フラグ次第で)などが期待でき、結果としてランタイムやソースを同梱するよりも小さく速い実行ファイルになることが多いです。

典型的なワークフロー:コンパイル、実行、配布

開発中はnim c -r yourfile.nimのようなコマンドで反復し、デバッグとリリースモードを使い分けます。配布時は生成された実行ファイル(および必要な動的ライブラリ)を配り、インタプリタを別途デプロイする必要はありません。

コンパイル時の力:実行前に仕事を終わらせる

Nimの大きな利点の一つは、いくつかの処理をコンパイル時に実行できる点(CTFE)です。つまり、毎回の実行で計算する代わりに、ビルド時に一度だけ計算して結果をバイナリに埋め込めます。

コンパイル時処理が重要な理由

ランタイム性能はしばしば「セットアップコスト」に食われます:テーブル構築、既知フォーマットのパース、定数検証、変わらない値の事前計算。定数から予測可能な結果はコンパイル時に移せます。

その結果:

- 起動時間が短くなる

- 実行時の割当てや分岐が減る

- ランタイム経路が単純になりコンパイラ最適化が効きやすくなる

実用例

ルックアップテーブルの生成。 ASCIIクラスや既知文字列の小さなマップなどはコンパイル時に生成して定数配列として埋め込めます。実行時は初期化コストなしでO(1)検索が可能です。

定数の早期検証。 ポート番号や固定バッファサイズ、プロトコルバージョンが範囲外ならビルドを失敗させられます。

派生定数の事前計算。 マスクやビットパターン、正規化された設定値などを一度計算して再利用できます。

注意点:可読性を保つこと

コンパイル時ロジックは強力ですが、人が理解しなければ意味がありません。小さく分かりやすいヘルパーを使い、「なぜここで(ビルド時に)やるのか」をコメントで残しましょう。コンパイル時ヘルパーも通常関数と同じようにテストするのが安全です。

マクロとメタプログラミング:明瞭さを失わずに

Nimのマクロはコンパイル中にコードを生成します。ランタイムでリフレクションする代わりに、型に応じた特殊化されたNimコードを一度生成して高速なバイナリを出荷できます。

ボイラープレートの削減(とランタイムチェックの削除)

典型的な用途は冗長なパターンを置き換えることです:

- 型ごとのシリアライザを生成する

- コンパクトなスキーマから入力検証コードを生成する

- ランタイムのルックアップを不要にする最適化されたディスパッチを生成する

マクロ展開後は通常のNimコードになるため、コンパイラはインライン化や最適化、不要分岐の削除が可能で、抽象化が最終バイナリでは消えることがよくあります。

ドメイン固有構文(コンパイラを作らずに)

マクロは軽量のDSLを可能にします。典型的な利用例:

- 宣言的な文法から高速なパーサを生成する

- フィールドタグ/フォーマットルールからシリアライザを生成する

- ルーティングやSQL生成、設定マッピング用の小さなDSL

うまく使えば呼び出し側はPythonのように読みやすく、実際には効率的なループやポインタ安全な操作にコンパイルされます。

マクロを保守可能に保つには

メタプログラミングがプロジェクト内で迷路化するのを避けるための指針:

- マクロが生成するコードのサンプルをドキュメントに載せる

- マクロは狭い目的に限定する

- ジェネリクス/テンプレートで済む場合はそちらを先に試す

メモリ管理:ARC/ORCと予測可能な性能

さくっとパイロット運用

大規模構築に入る前に、小さなNim関連プロジェクトでKoder.aiを試す。

Nimのデフォルトのメモリ管理は、Python風の扱いやすさとシステム言語的な挙動の両立に寄与しています。古典的なトレーシングGCの代わりに、Nimは通常ARC(Automatic Reference Counting)やORC(Optimized Reference Counting)を使います。

ARC/ORCとトレーシングGC(概念)

トレーシングGCは周期的にメモリをスキャンして到達不能オブジェクトを回収するため、開発体験は良いものの一時停止が発生しやすいです。

ARC/ORCでは最後の参照が消えたときにその場でメモリが解放されるので、レイテンシの一貫性が増し、資源解放のタイミングを推測しやすくなります(メモリ、ファイル、ソケットなど)。

予測可能性が性能に効く理由

割当てと解放が局所的かつ連続的に発生すると、突発的な遅延が減りプログラムのタイミング制御がしやすくなります。ゲーム、サーバ、CLIツールなど応答性が重要な領域で効果的です。

またライフタイムが明確だとコンパイラがレジスタやスタックにデータを保持する最適化をしやすくなり、余分な管理コストを避けられることがあります。

スタック vs ヒープ、ライフタイム、コピーとムーブ

簡単に言うと:

- スタック値は短命で作成コストが低い(スコープ終了で消える)

- ヒープ値は長く生き、共有されることがあるが割当てコストは高い

Nimでは高水準のコードを書きつつライフタイムに注意できます。大きな構造をコピーしているのか、所有権を移す(ムーブ)ことで複製していないのかを意識し、意図しないコピーを避けましょう。

不要な割当てを避ける実践的なヒント

「Cライクの速度」が欲しいなら、最速の割当ては行わないことです:

- バッファ(文字列、シーケンス、IO)を再利用する

- ホットパスではインプレース更新を優先する

- 可能なら事前確保して段階的に構築する

これらの習慣はARC/ORCと相性がよく、ヒープオブジェクトが少なければ参照カウントの負荷も減り、実際の処理時間が増えます。

データ構造とレイアウト:単純さから速度を得る

Nimは高水準に見えますが、性能は多くの場合「何がどこに割り当てられるか、メモリ上の配置はどうか」に帰着します。適切な形を選べば可読性を損なわずに速度が得られます。

値型とref:割当てがどこで起きるか

多くのNim型は値型がデフォルトです:int、float、bool、enum、そして普通のobject値。値型はインライン(スタックや他の構造体に埋め込まれる)ことが多く、メモリアクセスがタイトで予測可能です。

ref(例:ref object)を使うと追加の間接参照が生じ、通常ヒープ上に値が置かれてポインタを操作することになります。共有や長寿命、オプショナルなデータには便利ですが、ホットループではCPUがポインタ追従をするため遅くなることがあります。

経験則:性能重視のデータは普通のobject値を優先し、参照セマンティクスが本当に必要な場合にのみrefを使う。

seqとstring:便利だがコストを知る

seq[T]とstringは動的に伸縮するコンテナで日常的に便利ですが、成長時に割当てや再割当てが起きます。注目すべきコストパターン:

- 追加時にリサイズ(既存要素のコピー)が発生することがある

- 小さな

seqや文字列を多数作るとヒープブロックが増える

サイズが分かっているなら事前にサイズを確保し、バッファを再利用してチューンしましょう。

レイアウトが重要な理由:CPUキャッシュの簡単なモデル

CPUは連続するメモリを読むのが速いです。値型MyObjのseq[MyObj]は要素が隣接しているためキャッシュフレンドリーです。

一方seq[ref MyObj]はポインタの列でヒープ上に散らばる値を参照するので反復処理でメモリジャンプが増え遅くなります。

ホットパス向けの実践アドバイス

- 固定長は

array、可変だが連続性が欲しいなら値型のseqを使う - よくアクセスするフィールドは一つの

objectにまとめる - 不要なポインタ連鎖(

refの中にref)は避ける

これらはデータを小さく密に保ち、現代CPUが得意とするパターンに合わせることです。

コンパイル時に消える抽象化

コードベースを所有

フルソースをエクスポートして、プラットフォーム外でも開発を続けられる。

Nimが高水準に見えてランタイム負担が少ない理由の一つは、多くの機能が最終的に直接的な機械語に落ちるよう設計されていることです。表現力のあるコードを書き、コンパイラがそれをタイトなループや直接呼び出しに下げてくれます。

Nimにおける「ゼロコスト抽象」の意味

ゼロコスト抽象は可読性や再利用性を高めながら、低レベル版と比べて実行時に余分な仕事を増やさない機能です。

直感的な例はイテレータ風APIで値をフィルタリングしても、最終的に単純なループが生成される場合です。

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

openArrayのような見た目は柔軟ですが、通常はメモリ上のインデックス走査にコンパイルされ、Python風のオブジェクトオーバーヘッドは発生しません。

インライン化、ジェネリクス、特殊化(平易な説明)

Nimは小さな手続きを積極的にインライン化し、呼び出しを消し、ボディを呼び出し元に貼り付けます。

ジェネリクスは複数型に対して1つの関数を書ける仕組みで、コンパイラは使用される具体型ごとに特殊化します。これにより手書きの型特化コードと同等の効率が得られます。

結果としての「良いAPI」がタイトなループに

mapやfilter相当のヘルパーや、範囲チェックなどは、コンパイラが透けて見えると単一のループと最小限の分岐に落ち着きます。

抽象化がコストを発生させる時

抽象化が無料でなくなるのは、それがヒープ割当てや隠れたコピーを生む場合です。毎回新しいseqやstringを返すAPIや、内側のループで一時文字列を作るようなパターンはオーバーヘッドになります。

経験則:イテレーションごとに割当てが発生する抽象は支配的になり得る。スタックフレンドリーなデータを選び、バッファを再利用し、ホットパスでの暗黙のコピーに注意すること。

Cとの相互運用性:速度とエコシステムの再利用

実用的な理由の一つは、NimがCを直接呼べる点です。既存のCライブラリをNimで再実装する代わりに、ヘッダを宣言してリンクすれば、ほぼネイティブの呼び出しオーバーヘッドで利用できます。

NimのC FFIの概観

NimのFFIは使いたいC関数や型を記述することに基づきます。通常は:

importcでCシンボルを宣言する、または- ツールでCヘッダからNim宣言を生成する

その後コンパイラはすべてを同じネイティブバイナリにリンクするため、呼び出しコストは小さいです。

なぜ実用的か:書き直し不要で再利用

圧縮(zlib)、暗号プリミティブ、コーデック、DBクライアント、OS APIなど成熟したエコシステムにアクセスできます。アプリロジックは読みやすいNimで書き、重い処理はCに任せる、という分担が可能です。

注意点:所有権と変換

FFIでのバグは期待の不一致から来ます:

- 所有権ルール:どちらが確保/解放するか?Cが返したポインタはNim側で

freeする必要があるか? - 文字列とバッファ:Nimの

stringはCのchar*と同じではありません。cstringへの変換やヌル終端、寿命に気をつける。バイナリデータは明示的なptr uint8/長さペアが安全。

安全にラップする(テストしやすく)

良いパターンは小さなNimラッパーレイヤを作ること:

- 慣習的なNimのproc/型を公開する

- 変換とエラー処理を集中させる

- 必要なら

deferやデストラクタでRAII風に生存期間を管理する

こうすれば単体テストが書きやすくなり、低レベルの詳細がコードベースに漏れるのを防げます。

性能ツールキット:ビルドモード、フラグ、プロファイリング

Nimはデフォルトで速く感じられることが多いですが、残りの20~50%は「どうビルドするか」「どう計測するか」に依存します。幸い、Nimのコンパイラは性能制御を扱いやすく公開しています。

重要なビルドモード

本気のベンチではデバッグビルドは避け、まずはリリースビルドで測定します。

# 性能測定のための堅実なデフォルト

nim c -d:release --opt:speed myapp.nim

# より攻める(ランタイムチェックを減らす;テスト済みで使う)

nim c -d:danger --opt:speed myapp.nim

# CPU依存のチューニング(単一マシン向けに有効)

nim c -d:release --opt:speed --passC:-march=native myapp.nim

経験則:ベンチと本番では-d:releaseを使い、信頼できる場合のみ-d:dangerを検討してください。

プロファイリングのワークフロー:まず計測してから最適化

実用的な流れ:

- まずエンドツーエンドで計測する(wall-clock、メモリ、スループット)。

hyperfineや単純なtimeで十分なことも多いです。 - 次にホットスポットを見つける。Nimの組み込みプロファイラ(

--profiler:on)や外部ツール(Linuxのperf、macOSのInstrumentsなど)を使います。 - 最も重い1~2関数を最適化し、再計測する。ホットスポットが移動したら進捗です。

外部プロファイラを使う場合はデバッグ情報を付けてシンボルが読めるようにしておくと解析が楽になります:

nim c -d:release --opt:speed --debuginfo myapp.nim

避けるべきマイクロ最適化

微細なトリック(手動ループ展開、式の並べ替え、奇抜なテクニック)に走る前にデータを持ちましょう。Nimで大きな改善を得るのは多くの場合:

- アルゴリズムの見直し

- 割当てやコピーの削減

- データレイアウトの改善(連続メモリを使う等)

- クリティカルループのオーバーヘッド削減

CIフレンドリーなベンチと回帰チェック

性能回帰は早期に検出するのが簡単です。小さなベンチスイート(nimble benchなど)をCIで走らせ、ベースラインを保存してしきい値を超えたら失敗させる、という運用が有効です。これで「今日速い」が「来月遅い」にならないようにできます。

Nimが得意な領域(と注意すべき点)

Nim採用アプリを公開

ゼロから作らずに、Nimバイナリの周りにReact UIとGo APIを素早く作成。

Nimは高水準に読みやすく、かつ単一の高速な実行ファイルとして配布したい場合に強みを発揮します。性能、デプロイの簡潔さ、依存関係の抑制を重視するチームに向いています。

適した用途

多くのケースでNimは「プロダクトらしい」ソフトウェアに適しています:

- CLIと開発ツール:単一バイナリを配布でき、起動が速くスタートアップコストが低い

- ネットワークツールとサービス:スループットと予測可能なレイテンシが得られやすい

- ゲームツールやパイプライン:アセット変換やビルドツール、エディタの補助ツールなど、速度が欲しいがC/C++の複雑さは避けたい場面

注意したいケース

ランタイムの動的性が成功条件に強く依存する場合は向かないことがあります。

- 大量のサードパーティ拡張を動的に読み書きするプラグインシステム

- その場限りの小さなスクリプト(編集→即実行→破棄)の高速反復が最優先のケース(Pythonやシェルの方が速い)

チーム面の考慮

Nimは取りつきやすい一方で学習コストがあります。

- 早めにスタイル規約(モジュール構成、エラーハンドリング、命名)を決める

- オンボーディングにはペアリングと小さな社内ガイドが有効

- エコシステムにはギャップがあるため、Pythonほど何でも揃うわけではない点を見積もる

パイロットプロジェクトの提案

遅いCLIステップやネットワークユーティリティなど、測定可能な小さなプロジェクトを選びます。成功の指標(実行時間、メモリ、ビルドサイズ)を定め、社内で少人数に配布して結果で判断してください。

もしNimで作ったコアを管理用ダッシュボードやベンチランナーUIと組み合わせたいなら、Koder.aiのようなツールでフロントエンドや周辺インフラを素早く作り、NimバイナリをHTTPサービスとして統合する使い方もあります。性能クリティカルな部分をNimにして、周辺を別の言語で素早く作る戦略です。

可読性を保ちながらC並みの速度を出すための実践チェックリスト

Nimが「Python風だが速い」と言われるのは、読みやすい文法と最適化するネイティブコンパイラ、予測可能なメモリ管理(ARC/ORC)、データレイアウトと割当てに注意する文化の組み合わせによります。速度を保ちながら可読性を失わないための反復可能なワークフローを以下に示します。

速度優先のチェックリスト(可読性を犠牲にしない)

- 本気でコンパイルする:実測はリリースビルドで行う。

-d:releaseと--opt:speedから始める。- リンク時最適化を有効化する(

--passC:-flto --passL:-flto)。

- データ構造を意図的に選ぶ:単純で連続的な表現を優先する。

seq[T]は便利だが、タイトなループではarrayやopenArray、事前確保が有利。- ホットデータは小さく密に、ポインタを減らすとキャッシュミスが減る。

- 割当てを意識する:ARC/ORCはあるが無駄な仕事は消えない。

- バッファ再利用、

newSeqOfCapで事前確保、ループでの一時文字列作成を避ける。 - スライスや連結での隠れたコピーに注意する。

- バッファ再利用、

- 抽象化をコンパイルで消す:きれいなコードを書き、結果を検証する。

- 表現力のためにイテレータやテンプレートを使うが、リリースビルドでインラインされることを確認する。

- 最適化する前に測る:プロファイルして本当のホットスポットを見つける。

- プロファイリング入門は /blog/performance-profiling-basics を参照してください。

次のステップ:自分のマシンで検証する

- 小さなベンチを試す:実際の処理(パース、フィルタ、数学処理)をベンチし、デバッグとリリースで比較する。

- 1機能を実装して出荷する:小さなモジュールを作り、ホットパスだけを絞って最適化する(コード全体を最初から最適化しない)。

言語選択で迷っているなら、/blog/nim-vs-python がトレードオフ整理に役立ちます。ツールやサポートの検討が必要なら /pricing を確認してください。

よくある質問

なぜNimはPythonとCの両方と比較されるのですか?

Nimは**インデント主体で読みやすい(Python風の制御フローや表現力豊かな標準ライブラリ)**コードを書くことを目指しつつ、ネイティブ実行ファイルを生成するため、PythonとCの“いいとこ取り”と比較されます。

プロトタイピングに向いた見た目で書けて、ホットパスにはインタプリタが介在しない――その点が両者の比較理由です。

Nimは本当に「Cレベルの性能」を実現しますか?

自動的にCと同等の速度が出るわけではありません。一般に「Cレベルの性能」とは、次の点を守ればNimが競争力のある機械語を生成できる、という意味です:

- 効率的なアルゴリズムを使う

- ホットループを単純に保つ

- 割当てやコピーを最小化する

- 実際のボトルネックをプロファイルして最適化する

大量の一時オブジェクトを作る、あるいは不適切なデータ構造を選ぶと、遅いNimコードになります。

Nimが「ネイティブバイナリを生成する」とはどういう意味ですか?

Nimは.nimファイルをコンパイルしてネイティブバイナリを生成します。最も一般的な経路はNimのCバックエンドに翻訳し、GCCやClangなどのシステムコンパイラでビルドする方法です。

実務上は、インタプリタが命令を逐次実行するのではなく、OSで直接実行できる実行ファイルが得られるため、起動時間やホットループの速度が改善されることが多いです。

コンパイル時実行(CTFE)はどのように性能に寄与しますか?

コンパイル時実行(CTFE)は、コンパイラがビルド時に計算を行いその結果を実行ファイルに埋め込める機能です。これによりランタイムのオーバーヘッドを減らせます。

よくある用途:

- ルックアップテーブルを起動時ではなくビルド時に生成する

- 定数の早期検証(ビルドで失敗させる)

- マスクやデフォルト値などの派生定数を事前計算する

CTFEのヘルパーは小さく、なぜビルド時にやるのかをコメントで説明しておくと分かりやすいです。

Nimのマクロは使う価値がありますか?可読性を損ないますか?

マクロはコンパイル時にコードを生成する(“コードがコードを書く”)仕組みです。適切に使えばボイラープレートを削り、ランタイムのリフレクション費用を回避できます。

向いているケース:

- シリアライズ/デシリアライズ関数の自動生成

- 宣言的スキーマからの入力検証コード生成

- ランタイムルックアップを不要にする最適化されたディスパッチ生成

運用上の注意点:

- 生成されるコードの例をドキュメント化する

- マクロは狭く、小さな問題に限定して使う

- ジェネリクス/テンプレートで済むならそちらを優先する

NimのARC/ORCによるメモリ管理は性能にどう影響しますか?

Nimは一般的に**ARC/ORC(参照カウント系)**を使うことが多く、古典的なトレーシングGCとは挙動が異なります。最後の参照がなくなった時点でメモリが解放されるため、レイテンシの予測がしやすくなります。

実務的な利点:

- 「ストップ・ザ・ワールド」的な長い一時停止が起きにくい

- メモリやファイル、ソケットなどの資源解放のタイミングを推測しやすい

ただし、ホットパスでの割当ては参照カウントのトラフィックを増やすので、割当て削減の習慣は重要です。

速度に影響するデータ構造の選び方は?

性能重視のコードでは連続的で値ベースなデータを優先します:

- ホットなデータ構造では

ref objectよりもobject値を使う - キャッシュフレンドリーな反復には値型の

seq[T]を使う - 共有参照が不要なら

seq[ref T]は避ける

サイズが分かっている場合は事前確保(, )してバッファを再利用し、再割当てを減らしましょう。

「コンパイル時に消える抽象化」とはNimではどういう意味ですか?

多くの言語機能は「コンパイル時に消える(ゼロコスト抽象)」ように設計されています:

- 小さなプロシージャはインライン化され呼び出しオーバーヘッドを残さない

- ジェネリクスは具体型ごとに特殊化され、手書きの型特化コードと同等の効率が得られる

openArrayなどの柔軟なAPIも単純なインデックス走査に落ちることが多い

ただし抽象化がヒープ割当てや隠れたコピーを生む場合は“無料”ではなくなるので注意してください。

実プロジェクトでのC連携は現実的ですか?

NimはCと直接やり取りできるため、既存のCライブラリを再実装せずに利用できます。importcで外部シンボルを宣言したり、ヘッダから宣言を生成するツールを使ってリンクすれば、呼び出しオーバーヘッドは最小限です。

気をつける点:

- 所有権ルール(誰が

freeするか)を明確にする stringとcstringの変換やヌル終端の扱い- C側で保持されるポインタの寿命管理

安全なパターンとしては、変換とエラー処理を一箇所にまとめる小さなラッパーモジュールを書くことです。

Nimの性能を出すための現実的なビルド/プロファイリング手順は?

真面目に性能を出すならリリースビルドで測定してからプロファイルするのが鉄則です。

よく使うコマンド例:

nim c -d:release --opt:speed myapp.nimnim c -d:danger --opt:speed myapp.nim(テスト済みの場合)nim c -d:release --opt:speed --debuginfo myapp.nim(プロファイリング用)

ワークフロー: