2025年11月12日·1 分

非営利ラボからAIリーダーへ:OpenAIの歴史

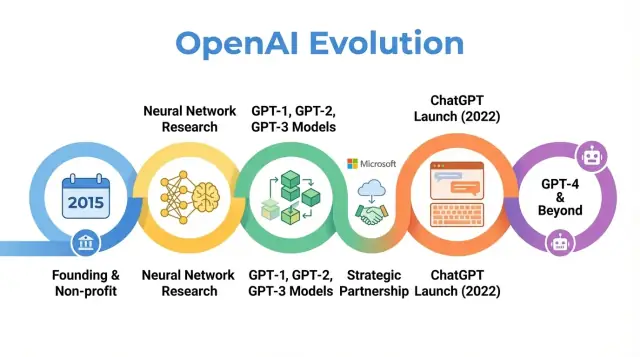

2015年の非営利ラボとしての出発からChatGPT、GPT‑4、Microsoftとの提携、キャップ付き利益構造への移行まで、OpenAIの歩みと主要な研究的・組織的節目を解説します。

概要:なぜOpenAIの歴史が重要なのか

OpenAIは研究と展開を行うAIの組織であり、初期の研究論文からChatGPTのような製品まで、人工知能に対する考え方に大きな影響を与えてきました。2015年の小さな非営利ラボから、AI分野の中心的なプレイヤーになるまでの変遷を知ることは、現代のAIがなぜ今の形になっているのかを理解する助けになります。

OpenAIの物語は単なるモデル公開の年表ではありません。使命、インセンティブ、技術的突破、世間のプレッシャーがどう相互作用したかのケーススタディでもあります。組織は当初、オープンな研究と広範な利益配分を強調していましたが、資金を集めるために再編し、Microsoftと深い提携を結び、何億もの人々が使う製品を発表しました。

この歴史が重要な理由

OpenAIの歩みをたどることで、より広いAIの潮流が見えてきます:

-

使命と価値観:OpenAIはAGIがもし生まれるなら「人類全体に利益をもたらす」ことを掲げて始まりました。時間とともにその解釈がどのように変化したかは、理想主義と商業的現実の間の緊張を示します。

-

研究の突破:初期プロジェクトからGPT‑3、GPT‑4、DALL·E、Codexのようなシステムへの移行は、現在の多くのAIアプリケーションを支える大規模な基礎モデルへの広いシフトを反映しています。

-

ガバナンスと構造:純粋な非営利からキャップ付き利益の組織形態への移行や複雑なガバナンスの導入は、強力な技術を管理するために試されている新しい組織形態を浮き彫りにします。

-

公共への影響と監視:ChatGPTなどのリリースにより、OpenAIはAI界隈だけの研究所から広く知られる存在へと変わり、安全性、アラインメント、規制に関する議論の中心になりました。

この記事では2015年から近年に至るOpenAIの旅路を追い、各フェーズがAI研究、経済、ガバナンスの変化をどう反映しているか、そしてそれが今後の分野に何を意味するかを示します。

OpenAIの創設:使命と初期メンバー

2015年のAIの局面

OpenAIは2015年12月に設立されました。当時、機械学習、特にディープラーニングは急速に進歩していましたが、汎用知能からはまだ距離がありました。画像認識のベンチマークは改善し、音声システムも向上しており、GoogleやFacebook、Baiduなどの企業が大量の投資を行っていました。

研究者やテックリーダーの間には、先進的なAIが少数の大企業や政府によって独占される懸念が高まっていました。OpenAIはその反重量(カウンターウェイト)として構想され、長期的な安全性と利益の広い分配に焦点を当てた研究組織として出発しました。

使命:すべての人類に利益をもたらすAGI

創設当初から、OpenAIは人工汎用知能(AGI)を念頭に置いた使命を掲げ、「AGIが実現した場合、それが人類全体に利益をもたらすようにする」ことを目標にしていました。

この使命は次のような具体的帰結を持ちました:

- 安全性研究や長期的なアラインメントの問題を優先すること

- 可能な限り研究やコード、知見を広く共有するコミットメント

- 単純な勝者総取りの競争を避け、他の機関と協力する姿勢

初期のブログ投稿や創設憲章は、オープン性と慎重さの双方を強調しており、強力な能力の公開が社会的にどのような影響を与えるかを考慮する姿勢を示していました。

創業者、初期リーダー、組織構成

OpenAIは非営利研究ラボとして始まり、発表時点で約10億ドル相当の支援が約束されました(すぐに現金化されたわけではありません)。初期の支援者にはElon Musk、Sam Altman、Reid Hoffman、Peter Thiel、Jessica Livingston、YC Researchなどが含まれ、Amazon Web ServicesやInfosysといった企業からの支援もありました。

初期の経営陣はスタートアップ経験と研究の実績を兼ね備えていました:

- Sam Altman – 共同創業者で初期の理事長(後にCEO)

- Elon Musk – 共同創業者にして初期の寄付者、当初は理事を務めた

- Greg Brockman – 旧Stripe CTO、CTOとして参加

- Ilya Sutskever – 深層学習の研究者、チーフサイエンティストとして参加

- Wojciech Zaremba、John Schulman – 共同創業者で研究リーダーの中核

このシリコンバレー的な起業家精神とトップクラスのAI研究者の組み合わせが、OpenAIの初期文化を形作りました:能力の限界を押し広げることに非常に野心的でありながら、短期的な商業化ではなく長期的な世界的影響を目指す非営利として組織されていました。

非営利期:初期研究とオープンサイエンス

2015年に非営利の研究ラボとして始まった当初、OpenAIの公的な約束は単純で野心的でした:可能な限り研究を前進させつつ、その成果を広くコミュニティと共有すること。

デフォルトでオープン

初期数年は「デフォルトでオープン」という哲学が支配的でした。研究論文は迅速に公開され、コードも多くの場合リリースされ、内部ツールは公開プロジェクトとして提供されました。科学的進展と監視を加速することが、能力を単一企業に集中させるよりも安全で有益だという考えです。

同時に、安全性の議論も早い段階から存在しました。どのタイミングで公開が誤用リスクを高めるかを議論し、段階的リリースや方針レビューのアイデアを描き始めましたが、これらは後のガバナンスプロセスに比べるとまだ形式化されていませんでした。

旗艦的研究領域

OpenAIの初期の研究は複数のコア領域を跨いでいました:

- 強化学習(RL): Dota 2のようなゲームや複雑な制御タスクでのエージェント学習は、RLアルゴリズムや探索手法、スケーラビリティを押し上げました。\n- ロボティクス: シミュレーションと転移学習を用いたロボットハンドの操作などは、物理世界への応用の可能性を示しました。\n- 教師なし・自己教師あり学習: 大規模なラベル無しデータから学ぶ研究は、後の基盤モデルを先取りする内容でした。

これらのプロジェクトは製品化よりも、深層学習・計算資源・巧妙な訓練手法で何が可能かを試すことに重きが置かれていました。

コミュニティを形作るツール

この時期に影響力の大きかった成果に、OpenAI GymとUniverseがあります。

- OpenAI Gymは共通のRL環境とベンチマークを提供し、アルゴリズム比較の標準化と新規研究者の参入障壁を下げました。\n- Universeは既存のソフトウェア環境(ゲームやウェブアプリなど)上でエージェントを訓練・評価する試みで、汎用的なエージェントへの関心を結晶化しました。\n どちらも専有の利点を狙うのではなく共有インフラを重視する姿勢を示していました。

同業者とメディアの見方

非営利期の間、OpenAIは大企業のAIラボに対するミッション志向の対抗勢力として描かれることが多く、同業者はその研究の質、コードや環境の公開、そして安全性議論への関与を高く評価しました。

メディアは高名な出資者、非商業的な構造、公開の約束という異例の組み合わせを強調し、その評判は後の戦略的変化に対する反応を形作る期待を作り出しました。

強力なモデルの構築:GPT‑1からGPT‑3へ

OpenAIの歴史における転換点は、トランスフォーマーをベースにした大規模言語モデルに注力する決断でした。このシフトによりOpenAIは、単なる研究重視の非営利から、多くの他者が組み立てる基盤モデルを提供する企業へと変貌しました。

GPT‑1:トランスフォーマーの検証(2018)

GPT‑1は現在と比べれば小さく(1.17億パラメータ)BookCorpusで学習されましたが、重要な概念実証でした。

個別タスクごとにモデルを作るのではなく、次単語予測という単純な目的で事前学習した単一のトランスフォーマーモデルが、少ない微調整で質問応答や感情分析、テキスト含意といった多様なタスクに適応できることを示しました。

社内のロードマップにとっての検証点は三つでした:

- スケールは効く:モデルを大きくしデータを増やすと意外に汎用的に性能が向上する。\n- 事前学習+微調整がタスク特化型を凌ぐことがある。\n- トランスフォーマーは言語処理に強力なアーキテクチャである。

GPT‑2:能力と悪用懸念(2019)

GPT‑2は同レシピを大幅に拡張し、15億パラメータと大規模なウェブ起源データで訓練されました。出力は往々にして驚くほど一貫性があり、数段落にわたる記事やフィクション、要約は一見すると人間の筆致に見えました。

その能力は悪用の懸念を呼び起こしました:自動化されたプロパガンダ、スパム、嫌がらせ、フェイクニュースの大量生成などです。OpenAIは全モデルを一度に公開するのではなく、段階的リリースを採用しました:

- 小さなモデルと技術論文、例示の初期公開\n- 内部外部のレッドチーミングで悪用リスクを検討\n- リスク評価に応じて順次大きなバージョンを公開

これは公開判断を安全性と社会的影響に結び付けた初期の目立つ例の一つであり、以後の開発方針に影響を与えました。

GPT‑3:スケール、汎用性、そしてAPI(2020)

GPT‑3はさらに規模を拡大し、1750億パラメータに到達しました。微調整に頼るより、プロンプト内の指示や少数の例で新タスクをこなす“few‑shot”や“zero‑shot”能力を示しました。

この汎用性はOpenAIや業界全体の考え方を変えました。多数の狭いモデルを作るのではなく、一つの大きなモデルが汎用エンジンとして機能する可能性が出てきたのです。具体的な応用例には:

- コピーライティングやコンテンツ生成\n- コードスニペットやオートコンプリート\n- 質問応答、チャット、検索支援

重要な点は、OpenAIがGPT‑3をオープンソース化せず、商業APIとして提供する道を選んだことです。この決定は戦略的な転換を示しました:

- モデルを公開するより運用して提供する方向へ\n- 研究所からプラットフォーム提供者へ\n- デモから開発者エコシステムの基盤へ

GPT‑1〜GPT‑3は一連の進化を描き、トランスフォーマーのスケール化、出現する能力、そして安全性と商用化に関する新たな課題を提示しました。

組織の再編:OpenAI LPとキャップ付き利益モデル

チャットでアプリを作る

普通の言葉のアイデアをチャットで入力して、動くアプリに変える。

2018年ごろまでに、OpenAIの指導者たちは、小さな寄付頼みのラボのままでは非常に大きなAIシステムを開発・安全に導くのに不十分だと判断しました。フロンティアモデルの訓練はすでに数千万ドルの計算資源と人材を要しており、そのコストはさらに上昇する見込みでした。トップ研究者を引きつけ、スケール実験を行い、クラウドインフラへ長期的にアクセスするには、相応の資本を呼び込む仕組みが必要でした。

なぜOpenAI LPが作られたのか

2019年、OpenAIはOpenAI LPという新しい「キャップ付き利益」型の有限責任事業体を立ち上げました。目的は、大規模な外部投資を可能にしつつ、非営利の使命—人工汎用知能が人類全体に利益をもたらすこと—を意思決定の最上位に保つことでした。

通常のベンチャーは無制限のリターンを追求する株主に最終的に責任を負いますが、OpenAIの創設者はそれが安全性や公開方針よりも利益追求を優先させる圧力を生むことを懸念しました。LP構造は妥協案であり、株のような持分を発行して資金を集められる一方で、異なるルール下に置こうという試みでした。

キャップ付き利益モデルの仕組み

キャップ付き利益モデルでは、投資家や従業員は元本に対して一定の倍率までリターンを得られます(初期投資家ではしばしば最大100倍などが引用されますが、後のトランシェでは低い上限が設定されることがあります)。その上限に達した後の追加的な価値は非営利親会社に流れることが想定されています。

これは理論上無制限に価値が増える通常のスタートアップとは対照的です。

非営利とLPの関係

OpenAI Nonprofitは支配的な親会社として残り、その理事会がOpenAI LPを監督します。理事会はミッションを優先するよう定められており、原則として特定の投資家や従業員の利益よりも人類全体の利益を優先することになっています。

形式的には:

- 非営利がOpenAI LPの支配権を保持する\n- 非営利理事会が主要リーダーを任命し、ミッションに反する決定を覆す権限を持つ\n- 法的な受託義務は非営利憲章に基づいている

このガバナンス設計は、商業組織としての資金調達・人材確保の柔軟性を持ちつつ、ミッション優先の統制を維持することを目指しています。

議論と資金・採用への影響

この再編は社内外で議論を呼びました。支持者は、最先端AI研究に必要な数十億ドルを確保しつつ利益誘導だけに陥らないための唯一の実用的手段だと主張しました。批判者は、大きなリターンを与える構造が本当に商業圧力に抵抗できるか、上限が十分に低く明確に運用されるか疑問視しました。

実務的にはOpenAI LPはMicrosoftとの大規模な戦略的投資への道を開き、競争力ある報酬体系を提供できるようになりました。それにより研究チームを拡大し、GPT‑3やGPT‑4のようなモデルの訓練をスケールさせ、ChatGPTのようなシステムをグローバルに展開するためのインフラを構築できるようになりました。

よくある質問

なぜOpenAIはそもそも設立されたのですか?

OpenAIは2015年に非営利の研究ラボとして設立され、人工汎用知能(AGI)がもし実現した場合に人類全体に利益をもたらすことを目的としました。

設立にはいくつかの背景があります:

- 強力なAIが少数の企業や政府に集中することへの懸念

- 短期的利益よりも長期的な安全性とアラインメントを重視する姿勢

- 閉ざされた独自システムではなく、オープンかつ協調的な研究を促進したいという意図

この出発点は、OpenAIの組織構造、パートナーシップ、公開に関する方針に現在も影響を与えています。

OpenAIはAGIをどう定義していて、ミッションは何ですか?

AGI(人工汎用知能)は、単一の狭いタスクに特化したツールではなく、人間レベルあるいはそれ以上に幅広い認知課題をこなせるAIシステムを指します。

OpenAIのミッションは:

- 捕らわれた少数の手に委ねられることなく、広く有益なAGIの実現を助けること

- 強力なシステムが人間の価値と整合するよう、安全性とアラインメントに注力すること

- 研究やパートナーシップ、アクセスプログラムを通じて利益を広く共有すること

このミッションはOpenAI Charterに明文化されており、研究方針や展開判断に影響を与えています。

なぜOpenAIは非営利からキャップ付き利益構造に切り替えたのですか?

純粋な非営利のままでは、最先端のAI研究に必要な巨額の資金や人材を確保しにくいという判断から、OpenAIは「キャップ付き利益(capped‑profit)」の有限責任事業体であるOpenAI LPを立ち上げました。

主なポイント:

- 投資家や従業員は投資額に対して上限付きのリターンを得られるが、その上限を超える価値は非営利親会社に還流する仕組み

- 非営利がOpenAI LPを支配し、ミッションを優先するガバナンスを維持することが法的・制度的に定められている

- 資金と人材を惹きつけつつ、利益最大化のみを最優先にする通常のベンチャー型圧力を緩和しようという試み

これは新しいガバナンス実験であり、有効性については賛否両論があります。

MicrosoftはOpenAIとの提携で具体的に何を得ているのですか?

MicrosoftはOpenAIに対して大規模なクラウドコンピュート(Azure)を提供し、数十億ドル規模の投資を行っています。

両者の関係は主に次のような内容です:

- GPT‑4のような大規模モデルを学習させるための専用スーパーコンピューティング基盤を共同で構築

- GPT‑3など一部技術の排他的ライセンスにより、Microsoftは自社製品(Bing、Office、GitHub Copilotなど)へ差別化要素として組み込める

- OpenAIは大規模な計算資源と資金を得て、最先端モデルの開発と展開を加速できる

要するに、Microsoftは先端AIを自社エコシステムに取り込み競争力を強化し、OpenAIはスケールと資源を確保するという相互利益の関係です。

GPT‑1〜GPT‑4はOpenAIの進路にどのような影響を与えましたか?

GPTシリーズはスケールと応用戦略の進化を示しています:

- GPT‑1(2018): 現在から見ると小規模(1億強パラメータ)でしたが、単一のTransformerを事前学習+微調整で多様なNLPタスクに適用できることを示しました。\n- GPT‑2(2019): 15億パラメータへ拡張され、非常に一貫した長文生成能力を示したため誤用の懸念が高まり、段階的な公開が行われました。\n- GPT‑3(2020): 1750億パラメータへ飛躍し、few‑shot/zero‑shotで新規タスクに対応できる汎用性を示したため、モデル自体は非公開にしてAPI経由で提供するビジネス戦略へ転換しました。\n- GPT‑4(2023): 推論力や指示理解が改善され、マルチモーダル(テキスト+画像)入力を扱えるようになり、ChatGPTや多くのサードパーティ製品の核心となりました。\n 各段階が技術的限界を押し上げると同時に、安全性・公開方針・商用化の判断を迫る契機にもなりました。

なぜOpenAIは創業時ほど“オープン”でなくなったのですか?

創業当初の「オープンを原則とする」姿勢から、より制限的な公開・API提供中心の運用へと方針が変わった理由は主に安全性と悪用リスクへの対応です。

具体的には:

- 高性能モデルの完全な重み(weights)や訓練データの詳細を公開すると、スパム・プロパガンダ・フェイクコンテンツなどの悪用が拡大する懸念が高まった

- そのため段階的公開、API経由の管理、運用上のフィルタや監視を重視するようになった

OpenAI側はこれを安全と責任のための現実的な判断だと説明しますが、批判者は「OpenAI」という名称や初期の約束と矛盾すると指摘し、力の集中を助長していると懸念しています。

OpenAIはどのようにしてシステムの安全性とアラインメントを保とうとしているのですか?

OpenAIは組織的・技術的な対策を組み合わせて安全性と整合性に取り組んでいます:

- 非常に重要な方針文書であるOpenAI Charterに基づき、AGIの有益性と協力を重視することを明示している

- アラインメント/安全性研究チーム、ポリシー・ガバナンスチーム、レッドチーミング(攻撃的な評価)グループを設け、モデル公開やアクセス制御に影響を与える

- 技術的にはRLHF(人間フィードバックによる強化学習)、コンテンツフィルタ、ドメインごとの微調整、モニタリングや段階的展開などを導入している

しかしながら、幻覚(hallucination)、バイアス、悪用の可能性などの問題は依然として残っており、継続的な研究とガバナンスが必要です。

なぜChatGPTの公開はOpenAIとAI全体にとって大きな出来事だったのですか?

ChatGPTは2022年11月に研究プレビューとして公開され、短期間で何百万人もの利用者を集める爆発的な採用を生みました。

転換点となった理由は:

- 研究技術を誰もが試せる会話形式のツールに変えたことで、日常の文章作成・コーディング・学習支援など幅広い用途が現実化したこと

- 一般利用の増加により教育現場や企業、規制当局が実務的な問題(盗用、プライバシー、偏向、依存)に対処せざるを得なくなったこと

この可視性はOpenAIのガバナンス、ビジネスモデル、安全対策への注目を一気に高め、AIに対する社会的議論を前面化させました。

OpenAIの技術は仕事や創作にどのような影響を与える可能性がありますか?

OpenAIのモデル、特にCodexやGPT‑4は知識労働や創造的作業に影響を与え始めています。

期待される利点:

- 反復的で単純な文章作成やコード作業の自動化

- 草案作成やブレインストーミング、翻訳の補助

- 会話型チューターとして学習や専門知識へのアクセスを広げる

懸念点:

- 一部のホワイトカラー職や創造職の再構成・代替が進む可能性

- 不完全なシステムに過度に依存するリスク

- 高品質ツールへのアクセスの格差が経済格差を拡大する恐れ

個人や組織は今日どのようにしてOpenAIと関わるべきですか?

OpenAIのエコシステムに責任を持って関わるには、立場ごとにできることがあります:

- 一般利用者として: ChatGPTなどを試し、強みと限界を理解した上で、出力を最終判断せずに下書きとして扱う。重要な事項は必ず専門家に確認する。\n- 開発者・企業として: APIを利用する際は独自の安全チェック、ログ記録、ドメイン固有のガードレールを導入し、過度な依存を避ける。\n- 市民・研究者として: ドキュメントや安全報告、OpenAI Charterを参照し、公的な協議や監査、批判的研究に参加する。

いずれの場合も、透明性・説明責任・公平なアクセスを求める声を上げ続けることが、技術の健全な発展に寄与します。