2025年11月10日·1 分

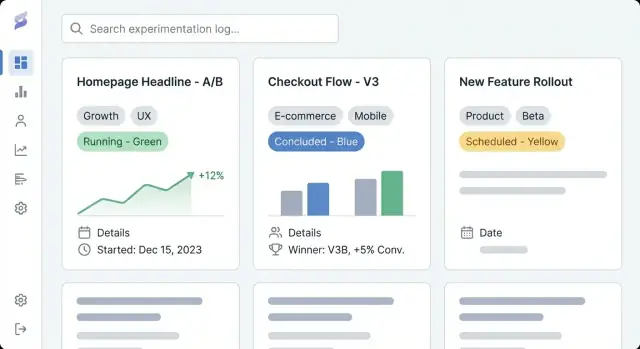

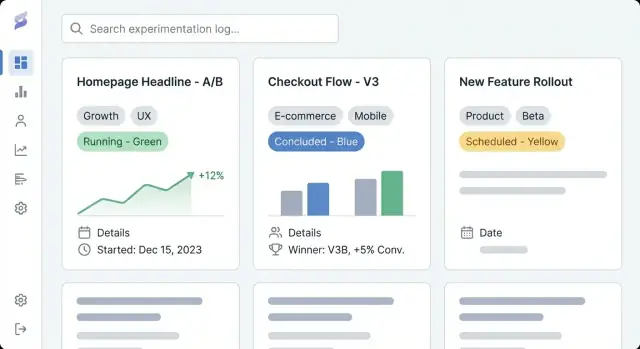

製品実験ログのためのウェブサイトを作る方法

実験エントリの一貫性、タグ付け、検索、明確な結果報告を備えた、プロダクト実験を記録するウェブサイトの計画、設計、ローンチ方法を学びます。

実験エントリの一貫性、タグ付け、検索、明確な結果報告を備えた、プロダクト実験を記録するウェブサイトの計画、設計、ローンチ方法を学びます。

プロダクト実験ログサイトは、チームが実行するすべての実験—A/Bテスト、価格テスト、オンボーディング調整、機能フラグ、メール実験、そして「失敗」したが学びのあったアイデアまで—を記録する共有の場所です。実験リポジトリとプロダクト学習ログを組み合わせたものと考えてください:何を試したか、なぜ試したか、何が起きたか、次に何を決めたかの記録です。

多くのチームでは実験追跡の断片がドキュメント、ダッシュボード、チャットに散らばっています。専用の実験追跡サイトはそれらを一つのナビゲート可能な履歴に引き寄せます。

実務上の効果は次の通りです:

このガイドは、実験ドキュメントの作成を簡単にし、活用しやすくするサイトの作り方に焦点を当てます。構造とナビゲーションの計画、実験エントリのデータモデルの定義(エントリの一貫性を保つため)、読みやすいページテンプレートの作成、速やかな発見のためのタグ付けと検索の設定、適切な実装アプローチ(CMS対カスタムアプリ)の選定について扱います。

読み終える頃には、仮説、指標と結果報告、意思決定を検索可能で信頼でき、長期に役立つ形で記録するA/Bテストドキュメンテーションサイトの明確な計画が手に入ります。

ツールやテンプレートを選ぶ前に、なぜこの実験追跡サイトが存在するのか、誰に向けているのかを明確にします。プロダクト実験ログは、チームの意思決定の方法に合っていなければ役に立ちません。

実験リポジトリのために2〜4つの測定可能な成果を書き出します。一般的な成功定義の例:

これらの目標が後のすべてに影響します:各エントリで必須とするフィールド、ワークフローの厳しさ、タグ付けと検索の高度さなど。

主要な利用者と、プロダクト学習ログで彼らが何をしたいかを列挙します:

検証の簡単な方法は、各グループに「30秒でどんな質問に答えたいか?」と尋ね、その質問にテンプレートとレイアウトが答えられるかを確かめることです。

実験ログ用のCMSを以下のどれにするか早めに決めます:

混合を選ぶ場合は、公開エントリで許可する内容(生データ不可、匿名化されたセグメント、未公開機能名の非表示など)と公開承認者を定義しておきます。これにより、将来チームが外部に学びを共有したいときの手戻りを防げます。

プロダクト実験ログは、人が「何を探しているか分からない」状態でも1分以内に適切な実験を見つけられることが重要です。ツールや画面設計を選ぶ前に、誰かが実験追跡サイトをどうブラウズするかを決めてください。

メインナビゲーションは限定的で予測可能にします。実用的な出発点は:

「Metrics」が重く感じられるなら、最初はExperimentsからリンクするだけにして後で拡張しても構いません。

ブラウズの「形」を決めます。多くのプロダクト学習ログは1つの主要ビューと残りはフィルタで扱う形がうまくいきます:

ステークホルダーが会話で既に使っているものを選び、その他はタグ(プラットフォーム、仮説テーマ、セグメント、実験タイプ)で補います。

URLは読みやすく安定させ、Slackやチケットで共有しやすくします:

/experiments/2025-12-checkout-free-shipping-thresholdExperiments → Checkout → Free shipping threshold のようなパンくずを追加して行き止まりを防ぎ、スキャンしやすくします。

初日に公開するものと後回しにするものをリストアップします:最近の実験、主要なプレイブック、コアな指標用語集、チームページなど。頻繁に参照されるエントリ(高インパクトテスト、代表的な実験テンプレート、結果報告で使う指標定義)を優先します。

有用なプロダクト実験ログは単なるリンク集ではなく、学びのデータベースです。データモデルはそのデータベースの「形」:何を保存するか、エントリがどう関連するか、どのフィールドが必須で時間を超えて比較可能にするかを定義します。

チームの実際の仕事に合わせて小さなセットから始めます:

これらを分けることで、各実験が新しい指標名を作ったり意思決定をフリーテキストに埋め込んだりするのを防げます。

「最低限のエントリ」を簡単に入力できるようにします。最小要件は:

オプションだが有用なフィールド:対象オーディエンス、トラフィック配分、テストタイプ(A/B、マルチバリアント)、チケットやデザインへのリンクなど。

結果はログが崩れやすい部分なので標準化します:

添付を許すならスクリーンショットの場所を一貫させ、読者がどこを見ればよいか分かるようにします。

後の検索やレポーティングのために関係性を明示的にモデル化します:

ステータスは標準化してソートやダッシュボードの意味を保ちます:proposed, running, concluded, shipped, archived のように「done」「complete」「finished」が複数の状態にならないようにします。

良いテンプレートは「誰かのメモ」を会社全体でスキャン可能で信頼でき再利用可能な記録に変えます。目的は一貫性を保ちながら著者に事務作業感を強いることなく入力させることです。

読者が読み続けるかを決めるのに必要な情報から始めます。

/docs/...)、主要指標。インデックスページはダッシュボードのように振る舞うべきです。ステータス、チーム、タグ、日付範囲、プラットフォームのフィルタ;最近更新順、開始日順、(可能なら)インパクト順でソート。クイックスキャン項目にはステータス、オーナー、開始/終了日、1行の結果を含めます。

1つのデフォルトテンプレートとオプションの派生(例:「A/Bテスト」「価格テスト」「オンボーディング実験」)を作成します。見出し、例文、必須フィールドをプレフィルして著者が白紙から始めなくて済むようにします。

シングルカラムレイアウト、ゆとりのある行間、明確なタイポグラフィを使います。要点をスティッキーなサマリブロックに置き(適切な箇所で)、表は横スクロール可能にしてスマホでも読みやすくします。

実験ログは人々が関連する学びを迅速に見つけられるときにのみ価値を発揮します。タグと分類は多数の実験ページをブラウズ・フィルタ・再利用可能にします。

チームが自然に検索する方法に合わせたタググループをいくつか定義します。実用的な基礎は:

グループ数は限定的に。次元が多すぎるとフィルタが混乱し、不一致なタグ付けを招きます。

制御されていないタグはすぐに「signup」「sign-up」「registration」のように分裂します。コントロールされた語彙を作ります:

簡単な方法はチームが管理する「タグ登録ページ」(例:/experiment-tags)と、実験作成時の軽いレビュープロセスです。

タグは発見性に優れるが、次のような属性は構造化フィールドにして一貫性を保ちます:

構造化フィールドは信頼できるフィルタとダッシュボードを可能にし、タグはニュアンスを補足する役割にします。

読者が関連作業を行き来できるようにします。Related experiments(同じ機能や指標の実験)やSimilar hypotheses(同じ仮説を別箇所で検証したもの)のセクションを設けます。最初は手動リンクで構わないので、のちに「共有タグ」に基づく自動推薦に拡張できます。

この選択が実験ログの到達可能性の上限を決めます。CMSは迅速な公開を可能にし、カスタムアプリは意思決定支援に密に統合されたシステムに成長させられます。

CMSは、主に読みやすい一貫したA/Bテスト文書化と軽い構造が必要なときに適しています。CMSを選ぶ理由の例:

典型的なパターンは、ヘッドレスCMS(コンテンツをCMSで保持し、サイトで表示)と静的サイトジェネレータの組合せです。これにより実験リポジトリは高速でホスティングコストが低く、非技術者に優しいものになります。

ログがプロダクトデータや内部ツールに直接つながる必要がある場合はカスタムアプリを検討します。次の要件があるならカスタムが向きます:

素早くプロトタイプしたい場合は、Koder.aiのようなプラットフォームがコアのスキャフォールド(React UI、Go API、PostgreSQLスキーマ)を生成してくれるので、ステークホルダーとテンプレート・ワークフローを反復するのに役立ちます。

実験データの保管場所を明確にします:

これを早めに文書化しないと、ドキュメントやスプレッドシート、ツール間でエントリが重複して信頼を失います。

実験ログに特別な技術は必要ありません。重要なのはチームが運用・保守しやすく、安全に保てて進化させられるスタックを選ぶことです。

静的サイト(事前ビルドページ)は多くの場合最も簡単です:高速で安価にホストでき、メンテナンス負荷が低い。実験が読み取り中心で、更新はCMSやプルリク経由が多い場合に向きます。

サーバーサイド生成アプリは強いアクセス制御や動的フィルタ、複雑なクライアントロジックなしでチーム別ビューが必要な場合に合います。サーバレベルでの権限強制も簡単です。

**シングルページアプリ(SPA)**はフィルタやダッシュボードで反応性が高く感じられますが、SEO、認証、初回ロードの複雑性を増します。本当にアプリ的な操作性が必要な場合のみ選びます。

カスタムアプリを作るなら、従来のビルドパイプラインと短期間でスキャフォールドを作れる加速アプローチのどちらにするかも決めます。例としてKoder.aiは仕様文からコアスキャフォールドを生成します。

信頼性(稼働率、監視、アラート)とバックアップ(自動・復元テスト済み)を優先します。環境分離(最低でもステージング)を用意して分類変更やテンプレート更新、権限ルールを本番前に検証できるようにします。

多くのチームは最終的にSSO(Okta、Google Workspace、Azure AD)と役割(閲覧者、編集者、管理者)、および機密学習のためのプライベート領域を必要とします。後から再設計する羽目にならないよう早めに計画してください。

キャッシュ(CDNとブラウザキャッシュ)を使い、ページを軽く保ち、メディアは圧縮・遅延読み込みするなど最適化します。会議中に過去のテストを探す場面で遅いサイトは使われなくなります。

人が数秒で「そのテスト」を見つけられることが本当に有益になる条件です。

エントリが数百件程度、チームが小さくニーズが単純ならサイト内検索(CMSやDB内)で十分です。保守が楽でベンダー設定が不要です。

数千件に達する、極めて高速な結果や誤字許容、同義語の対応、高度なランキングが必要なら外部検索サービス(Algolia、Elastic、OpenSearchなど)を検討します。複数ソース(ドキュメント+ログ+ウィキ)にまたがるコンテンツがある場合にも有効です。

検索だけでなく、実際の意思決定に合ったフィルタを用意します:

フィルタは組み合わせ可能にします(例:「Concluded + 過去90日 + Growthチーム + Activation指標」)。

保存ビューは繰り返しの問いにワンクリックで答えます:

チームが共有ビューをナビゲーションに固定できるようにし、個人もビューを保存できるようにします。

検索結果では短いスニペット(仮説、バリアント、対象、見出し結果)を表示し、タイトルとサマリでマッチしたキーワードをハイライトします。主要フィールド(ステータス、オーナー、主要指標)を見せることで、複数ページを開かずに目的の実験を判断できるようにします。

優れた実験追跡サイトはページとタグだけでなく、共有されたプロセスでもあります。明確な所有権と軽量なワークフローが、未完のエントリや欠落した結果、数か月後に何が起きたか分からない決定を防ぎます。

誰が作成、編集、承認、公開できるかをまず決めます。単純なモデルで十分なことが多いです:

アクセスレベル(内部/公開/制限)に合わせて権限を一貫させます。プライベート実験をサポートする場合は各エントリに明確なオーナーを必須にします。

公開前に満たす短いチェックリストを定義します:

このチェックリストをテンプレート内の必須フォームセクションに組み込むこともできます。

エントリを生きたドキュメントとして扱います。バージョン履歴を有効にし、重要な更新には簡潔な変更メモを必須にします(指標修正、分析の訂正、決定の取り消しなど)。これにより信頼性が保たれ、監査が容易になります。

機密情報の保存方法を事前に決めます:

ガバナンスは重くする必要はなく、ただ明確であれば十分です。

実験追跡サイトは人々が中身を見つけ信頼し再利用できると価値が出ます。軽量な分析はログが機能しているか、静かに失敗しているかを把握する手助けになりますが、監視ツールにする必要はありません。

まずは実用的なシグナルを選びます:

可能ならIPログは無効にし、ユーザー特定可能な識別子は避けて集計レベルのレポートを使います。

使用状況だけではエントリの完成度は分かりません。リポジトリ自体について報告する“コンテンツ健全性”チェックを追加します:

これはCMS/DBからの週次レポートや、小さなスクリプトでエントリをフラグする形で実装できます。目的はギャップを見える化してオーナーに修正を促すことです。

実験の書き起こしに個人情報を含めるべきではありません。避けるべきもの:

生データの埋め込みを避け、集計ダッシュボードへのリンクを使い、敏感な分析は承認済みのシステムに保存します。

A/Bテストの結果は文脈を失うと誤解されやすいので、テンプレート(あるいはフッター)に短い免責を入れてください:

これによりログの誠実性が保たれ、過去の結果の誤用を減らせます。

優れた実験ログはサイト公開で完了するものではありません。価値が出るのはチームがそれを信頼し、最新に保ち、6か月後でも学びが見つかるときです。

多くのチームはスプレッドシート、スライド、散在するドキュメントから始めます。小さなパイロットバッチ(例:過去四半期の実験)を選び、各ソースフィールドを新テンプレートにマッピングします。

可能なら一括インポート:スプレッドシートをCSVでエクスポートしてスクリプトやCMSのインポータでエントリを作成します。文書は重要なサマリ項目(目標、変更、結果、決定)を先に移し、補助情報への元ファイルリンクを残します。

一度に完璧を求めず、一貫性を重視した品質チェックを行います。よくある問題:

同時に、完了済みとマークされたものの必須フィールドを何にするか合意しておきます。

公開前に確認する項目:

軽いルーチンで運用を保ちます:月次クリーンアップ(古いドラフト、未完了の結果の整理)と四半期ごとの分類レビュー(タグ統合、新カテゴリの慎重な追加)を推奨します。

基本が安定したら統合を考えます:課題トラッカーと自動リンクさせる、各エントリに使用した正確なダッシュボードを引き込むなど。カスタムアプリへ進化させるなら、まず“planning mode”でワークフローや必須項目、承認ルールを文書化してから実装すると安全です。

Koder.aiのようなプラットフォームはデプロイ、スナップショット、ロールバックをサポートしているため、重い再設計なしにログを成熟させられます。

製品実験ログサイトは、実験(A/Bテスト、価格テスト、オンボーディング変更、機能フラグの展開、メール実験など)を記録するための共有で検索可能なリポジトリです。各エントリには「何を試したか」「なぜ試したか」「何が起きたか」「次に何を決めたか」が記録され、学びがドキュメントやダッシュボード、チャットに埋もれないようにします。

まず2〜4つの測定可能な成果を定義します。例:

これらの目標は、必須フィールド、ワークフローの厳しさ、分類/検索の必要度合いを決める指針になります。

主要な利用者と、各グループが“30秒で知りたいこと”を一覧にします。よくあるニーズ:

そのうえで、テンプレートやページレイアウトがそれらの質問に即答できるように設計します。

次の3つのモデルから選びます:

混合を選ぶ場合は、公開可能な内容(生データ不可、匿名化したセグメント、未公開機能名の非表示など)と公開承認者を事前に定義しておきます。

トップレベルのナビゲーションはシンプルで予測可能にします。例:

ブラウジングの主要軸はひとつ選び、残りはタグやフィルタで扱います(例:プロダクト領域、ファネル段階、チーム)。

各実験エントリに最低限必要なセットを定めます:

結果については標準化します:

実用的なデフォルトの順序例:

少数で予測可能なタグ戦略から始めます。基礎例:

タグの雑多化を防ぐために命名ルール(単数/複数、大文字化、略語使用)、新規タグ作成者の制限、曖昧なタグの短い説明を設けます。コア属性(ステータス、チーム/オーナー、実験タイプ)は構造化フィールドにして自由テキストにしないでください。

CMSは読みやすいA/Bテスト文書化と軽めの構造で十分な場合に適しています。CMSを選ぶ理由の例:

一方で、次のような要件がある場合はカスタムアプリが適します:

検索は現場で本当に使われるための要です。以下を用意します:

リスト結果では短い結果スニペット(仮説、バリアント、対象、見出し結果)と主要フィールド(ステータス、オーナー、主要指標)を表示し、何度もページを開かずに探せるようにします。

単純なモデルから始めると多くの場合うまくいきます:

必須の編集チェックリスト(例):

使用状況を追う際は過剰収集を避けつつ実用的な指標を取りましょう:

IPログやユーザーレベルの識別子は避け、集計されたページレベルのレポートを優先します。コンテンツの健全性チェック(必須フィールドの欠落、90日以上実行中の実験、結果が未定のままのエントリ等)も用意して、ギャップを見える化します。プライバシー観点では個人データ(氏名、メール、ユーザーID、生ログ等)や個人情報の含まれるスクリーンショットを避け、集計ダッシュボードへリンクする運用にします。

また、テンプレートやフッターに短い解釈に関する免責を置き、結果は母集団・期間・計測方法に依存し、信頼性基準はチームごとに異なる旨を明記しておくと誤用を減らせます。

ローンチ後も運用が鍵です。移行は段階的に行います:

ローンチ前の品質確認:

ローンチチェックリスト:

これにより、単なるメモが長期的に比較可能な記録になります。

この順にするとスキャンしやすく、深掘りも可能です。

プロトタイプを素早く作るなら、vibe-codingのようなプラットフォーム(例:Koder.ai)で、データモデル(experiments, metrics, decisions)やページテンプレート、ワークフローをチャットで記述して、React + Go + PostgreSQLのスキャフォールドを生成して反復するのも実用的です。

バージョン履歴と変更メモを有効にし、重要な更新には短い変更メモを必須にします。機密情報は赤字化や限定公開などの扱いルールを決めます。

運用リズムは月次のクリーンアップ(古い下書きや未完了の結果)と四半期ごとの分類見直しが軽量で効果的です。将来的にはチケット連携や分析コンテキストの自動引き込みなどの統合を検討します。カスタムアプリへ移行する場合は、まずプラン作成(ワークフロー、必須フィールド、承認ルール)を行ってから実装すると安全です。