02 ਦਸੰ 2025·8 ਮਿੰਟ

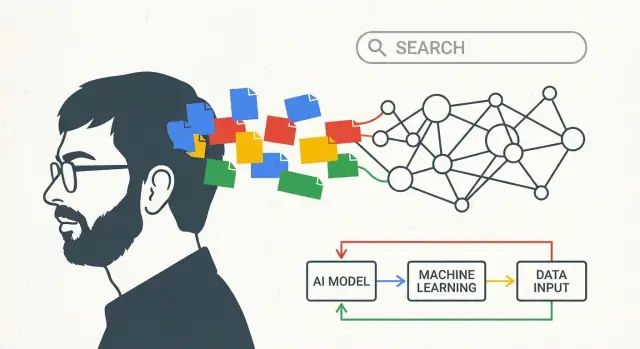

Larry Page ਦੀ ਅਸਲੀ AI ਦ੍ਰਿਸ਼ਟੀ ਜੋ Google ਦੀ ਲੰਬੀ ਰਣਨੀਤੀ ਦੇ ਪਿੱਛੇ ਸੀ

ਜਾਣੋ ਕਿ Larry Page ਦੇ ਸ਼ੁਰੂਆਤੀ AI ਅਤੇ ਗਿਆਨ-ਸਬੰਧੀ ਵਿਚਾਰਾਂ ਨੇ Google ਦੀ ਲੰਬੀ ਮਿਆਦ ਦੀ ਰਣਨੀਤੀ ਨੂੰ ਕਿਵੇਂ ਪ੍ਰਭਾਵਿਤ ਕੀਤਾ—ਸਰਚ ਦੀ ਗੁਣਵੱਤਾ ਤੋਂ ਲੈ ਕੇ moonshots ਅਤੇ AI-ਫਰਸਟ ਦਾਅਵਿਆਂ ਤੱਕ।

ਇਸ ਪੋਸਟ ਵਿੱਚ “Larry Page ਦੀ AI ਦ੍ਰਿਸ਼ਟੀ” ਦਾ ਕੀ ਮਤਲਬ ਹੈ

ਇਹ ਕਿਸੇ ਇੱਕ ਵੱਡੇ ਪ੍ਰਗਟਾਓ ਨੂੰ ਚਮਕਾਉਣ ਵਾਲਾ ਟੁਕੜਾ ਨਹੀਂ ਹੈ। ਗੱਲ ਲੰਬੀ ਰਣਨੀਤੀ ਦੀ ਹੈ: ਇੱਕ ਕੰਪਨੀ ਕਿਵੇਂ ਸ਼ੁਰੂ ਤੋਂ ਹੀ ਇਕ ਦਿਸ਼ਾ ਚੁਣ ਸਕਦੀ ਹੈ, ਕਈ ਤਕਨੀਕੀ ਬਦਲਾਵਾਂ ਦੌਰਾਨ ਨਿਵੇਸ਼ ਜਾਰੀ ਰੱਖ ਸਕਦੀ ਹੈ, ਅਤੇ ਇੱਕ ਵੱਡੀ ਸੋਚ ਨੂੰ ਦੇਰ ਨਾਲ ਰੋਜ਼ਮਰ੍ਹਾ ਉਤਪਾਦਾਂ ਵਿੱਚ ਬਦਲ ਸਕਦੀ ਹੈ।

ਜਦੋਂ ਇਹ ਪੋਸਟ ਕਹਿੰਦੀ ਹੈ “Larry Page ਦੀ AI ਦ੍ਰਿਸ਼ਟੀ,” ਤਾਂ ਮਰਦਨ ਨਹੀਂ ਕਿ "Google ਨੇ ਅੱਜ ਦੇ ਚੈਟਬੋਟਸ ਦੀ ਭਵਿੱਖਬਾਣੀ ਕੀਤੀ ਸੀ"। ਇਸਦਾ ਅਰਥ ਸਾਦਾ ਅਤੇ ਜ਼ਿਆਦਾ ਟਿਕਾਊ ਹੈ: ਅਜਿਹਾ ਸਿਸਟਮ ਬਣਾਉਣਾ ਜੋ ਅਨੁਭਵ ਤੋਂ ਸਿੱਖਦੇ ਹਨ।

ਸਧਾਰਨ-ਅੰਗਰੇਜ਼ੀ ਪਰਿਭਾਸ਼ਾ

ਇੱਥੇ “AI ਦ੍ਰਿਸ਼ਟੀ” ਕੁਝ ਜੁੜੀਆਂ ਮੰਨਤਾਂ ਨੂੰ ਦਰਸਾਉਂਦੀ ਹੈ:

- ਕੰਪਿਊਟਰ ਡੇਟਾ ਤੋਂ ਸਿੱਖ ਕੇ ਆਪਣੀ ਕਾਰਗੁਜ਼ਾਰੀ ਸੁਧਾਰਣ ਚਾਹੀਦੇ ਹਨ, ਸਿਰਫ਼ ਹੱਥ ਨਾਲ ਲਿਖੇ ਨਿਯਮਾਂ 'ਤੇ ਨਿਰਭਰ ਨਹੀਂ।

- ਸਭ ਤੋਂ ਵਧੀਆ ਸਿਸਟਮ ਸਮੇਂ ਦੇ ਨਾਲ ਬਿਹਤਰ ਹੁੰਦੇ ਹਨ ਕਿਉਂਕਿ ਅਸਲ ਦੁਨੀਆ ਦੀ ਵਰਤੋਂ ਫੀਡਬੈਕ ਬਣਾਉਂਦੀ ਹੈ (ਲੋਕ ਕਿਹੜੀ ਚੀਜ਼ ਤੇ ਕਲਿਕ ਕਰਦੇ ਹਨ, ਕੀ ਨਜ਼ਰਅੰਦਾਜ਼ ਹੁੰਦਾ ਹੈ, ਕੀ ਉਹ ਦੁਬਾਰਾ ਲਿਖਦੇ ਹਨ)।

- ਸਿੱਖਣਾ ਵਿਆਵਹਾਰਿਕ ਬਣਾਉਣ ਲਈ ਇਨਫਰਾਸਟ੍ਰੱਕਚਰ ਚਾਹੀਦਾ: ਤੇਜ਼ ਕੰਪਿਊਟਿੰਗ, ਭਰੋਸੇਯੋਗ ਸਟੋਰੇਜ, ਅਤੇ ਬਹੁਤ ਵੱਡੇ ਪੱਧਰ 'ਤੇ ਸੁਰੱਖਿਅਤ ਤਰੀਕੇ ਨਾਲ ਪ੍ਰਯੋਗ ਚਲਾਉਣ ਦਾ ਰਸਤਾ।

ਇਸਦਾ ਅਰਥ ਇਹ ਹੈ ਕਿ “ਦ੍ਰਿਸ਼ਟੀ” ਇਕ ਹੀ ਮਾਡਲ ਬਾਰੇ ਘੱਟ ਅਤੇ ਇੱਕ ਇੰਜਣ ਬਾਰੇ ਜ਼ਿਆਦਾ ਹੈ: ਸੰਕੇਤ ਇਕੱਤਰ ਕਰੋ, ਪੈਟਰਨ ਸਿੱਖੋ, ਸੁਧਾਰ ਜਾਰੀ ਕਰੋ, ਫੇਰ ਦੋਹਰਾਓ।

ਅਰਕ ਜੋ ਅਸੀਂ ਫਾਲੋ ਕਰਾਂਗੇ

ਇਸ ਵਿਚਾਰ ਨੂੰ ਗਠਿਤ ਕਰਨ ਲਈ, ਬਾਕੀ ਪੋਸਟ ਇੱਕ ਸਾਫ਼ ਤਰੱਕੀ ਦਿਖਾਉਂਦੀ ਹੈ:

- ਸਰਚ: ਇੱਕ ਸਪੱਸ਼ਟ ਸਮੱਸਿਆ ਨਾਲ ਸ਼ੁਰੂ ਕਰੋ—ਲੋਕਾਂ ਦੀ ਮਦਦ ਕਰੋ ਕਿ ਚੰਗੇ ਜਵਾਬ ਲੱਭਣ।

- ਦੇਟਾ + ਇਨਫਰਾਸਟ੍ਰੱਕਚਰ: ਅਸਲ ਵਰਤੋਂ ਤੋਂ ਇਹ ਸਿੱਖੋ ਕਿ “ਚੰਗਾ” ਕੀ ਹੈ, ਅਤੇ ਇਸਨੂੰ ਪ੍ਰੋਸੈਸ ਕਰਨ ਲਈ ਮਸ਼ੀਨਰੀ ਬਣਾਓ।

- AI-ਫਰਸਟ ਉਤਪਾਦ: ਸਿੱਖਣ ਵਾਲੇ ਸਿਸਟਮ ਨੂੰ ਡਿਫੌਲਟ ਦੋ—ਤਾਂ ਜੋ ਵਾਈਸ, ਚਿੱਤਰ ਅਤੇ ਨਵੇਂ ਇੰਟਰਫੇਸ ਬਿਨਾਂ ਰੀ-ਲਿਖੇ ਸਹੀ ਤਰੀਕੇ ਨਾਲ ਕੰਮ ਕਰਨ।

ਅੰਤ ਤੱਕ, “Larry Page ਦੀ AI ਦ੍ਰਿਸ਼ਟੀ” ਇੱਕ ਸ(plugin)ਲੋਗਨ ਤੋਂ ਘੱਟ ਅਤੇ ਇੱਕ ਰਣਨੀਤੀ ਵਾਂਗ ਜ਼ਿਆਦਾ ਮਹਿਸੂਸ ਹੋਵੇਗੀ: ਸਿੱਖਣ ਵਾਲੇ ਸਿਸਟਮਾਂ ਵਿੱਚ ਸ਼ੁਰੂਆਤੀ ਨਿਵੇਸ਼ ਕਰੋ, ਉਹਨਾਂ ਨੂੰ ਪੋਸ਼ਣ ਵਾਲੀਆਂ ਟੁੱਠੀਆਂ ਬਣਾਓ, ਅਤੇ ਸਾਲਾਂ ਤੱਕ ਧੀਰਜ ਰੱਖੋ ਤਾਂ ਜੋ ਪ੍ਰਗਟਿ ਮਿਲ ਕੇ ਵਧੇ।

ਉਹ ਮੁੱਢਲੀ ਸਮੱਸਿਆ ਜੋ Google ਨੇ ਹੱਲ ਕਰਨ ਦੀ ਕੋਸ਼ਿਸ਼ ਕੀਤੀ: ਚੰਗੇ ਜਵਾਬ ਲੱਭਣਾ

ਸ਼ੁਰੂਆਤੀ ਵੈੱਬ ਇੱਕ ਸਧਾਰਨ ਪਰ ਘਾਤਕ ਸਮੱਸਿਆ ਰੱਖਦਾ ਸੀ: ਇੱਕ уақытта ਬਹੁਤੀ ਜਾਣਕਾਰੀ ਆ ਗਈ ਸੀ, ਅਤੇ ਜ਼ਿਆਦਾਤਰ ਖੋਜ ਦੇ ਜੰਤਰ ਜੋ ਮਾਮੂਲੀ ਤੌਰ 'ਤੇ ਇਹ ਦਰਸਾ ਰਹੇ ਸਨ ਕਿ ਕੀ ਮਹੱਤਵਪੂਰਨ ਹੈ।

ਜੇ ਤੁਸੀਂ ਕੋਈ ਕਵੈਰੀ ਟਾਈਪ ਕਰਦੇ, ਤਾਂ ਬਹੁਤ ਸਾਰੇ ਇੰਜਨ ਸਪਸ਼ਟ ਸੰਕੇਤਾਂ ਉੱਤੇ ਨਿਰਭਰ ਕਰਦੇ—ਜਿਵੇਂ ਕਿ ਕਿਸੇ ਪੰਨੇ 'ਤੇ ਸ਼ਬਦ ਕਿੰਨੀ ਵਾਰੀ ਆਇਆ, ਕੀ ਉਹ ਟਾਈਟਲ 'ਚ ਹੈ, ਜਾਂ ਸਾਈਟ ਮਾਲਕ ਨੇ ਇਸ ਨੂੰ ਅਦਿੱਖ ਟੈਕਸਟ ਵਿੱਚ ਕਿੰਨ੍ਹਾਂ ਵਾਰੀ ਦਰਜ ਕੀਤਾ। ਇਸ ਨਾਲ ਨਤੀਜੇ ਗੇਮਿੰਗ ਲਈ ਖੁਲ੍ਹੇ ਬਣ ਜਾਂਦੇ ਸਨ ਅਤੇ ਭਰੋਸੇਯੋਗ ਹੋਣਾ ਔਖਾ ਸੀ।

PageRank, ਸਿਫਾਰਸ਼ ਵਾਂਗ ਸਮਝਾਇਆ

Larry Page ਅਤੇ Sergey Brin ਦੀ ਮੁੱਖ ਸਮਝ ਇਹ ਸੀ ਕਿ ਵੈੱਬ ਵਿੱਚ ਪਹਿਲਾਂ ਹੀ ਇਕ ਕਿਸਮ ਦਾ ਵੌਟਿੰਗ ਸਿਸਟਮ ਹੈ: ਲਿੰਕ।

ਇੱਕ ਪੰਨੇ ਤੋਂ ਦੂਜੇ ਪੰਨੇ 'ਤੇ ਲਿੰਕ ਇਕ ਕਾਗਜ਼ੀ ਹਵਾਲੇ ਜਾਂ ਦੋਸਤ ਦੀ ਸਿਫਾਰਸ਼ ਵਾਂਗ ਹੈ। ਪਰ ਹਰ ਸਿਫਾਰਸ਼ ਇਕੋ ਜਿਹੀ ਨਹੀਂ ਹੁੰਦੀ। ਜਿਸ ਪੰਨੇ ਨੂੰ ਹੋਰ ਬਹੁਤ ਸਾਰੇ ਕੀਮਤੀ ਮੰਨਦੇ ਹਨ, ਉਸ ਤੋਂ ਆਉਣ ਵਾਲਾ ਲਿੰਕ ਵੱਧ ਗਿਣਤੀ ਰੱਖਦਾ ਹੈ। PageRank ਨੇ ਇਸ ਵਿਚਾਰ ਨੂੰ ਗਣਿਤ ਵਿੱਚ ਬਦਲ ਦਿੱਤਾ: ਸਿਰਫ਼ ਪੇਜ ਆਪਣੇ ਬਾਰੇ ਕੀ ਕਹਿੰਦਾ ਉਸ ਦੁਆਰਾ ਹੀ ਰੈਂਕ ਨਾ ਕਰੋ, ਪਰ ਉਹ ਦੇਖੋ ਕਿ ਬਾਕੀ ਵੈੱਬ ਉਸ ਬਾਰੇ ਕੀ “ਕਹਿੰਦੀ” ਹੈ।

ਇਸ ਨੇ ਇਕੋ ਸਮੇਂ ਦੋ ਮਹੱਤਵਪੂਰਨ ਗੱਲਾਂ ਕੀਤੀਆਂ:

- ਇਹ ਪ੍ਰਭਾਵਸ਼ਾਲੀ ਪੰਨੇ ਉੱਪਰ ਲਿਆਏ, ਭਾਵੇਂ ਉਹ ਸਹੀ ਤੌਰ 'ਤੇ ਕਵੈਰੀ ਸ਼ਬਦ ਨਾ ਦੋਰਹਾਉਂਦੇ ਹੋਣ।

- ਰੈਂਕਿੰਗ ਨੂੰ ਮਾਨਗਣਾ ਔਖਾ ਬਣਾਇਆ, ਕਿਉਂਕਿ ਸਿਫਾਰਸ਼ੀਤੀਯਤਾ ਇਕ ਨੈਟਵਰਕ ਪੱਧਰ 'ਤੇ ਕਮਾਈ ਜਾਣੀ ਪੈਂਦੀ ਸੀ।

ਸ਼ੁਰੂ ਤੋਂ ਹੀ ਮਾਪ-ਨੁੰਕਤਾ ਅਤੇ ਇਟਰੈਸ਼ਨ ਕਿਉਂ ਮਹੱਤਵਪੂਰਨ ਸਨ

ਸਿਰਫ਼ ਇੱਕ ਚਤੁਰ ਰੈਂਕਿੰਗ ਵਿਚਾਰ ਹੋਣਾ ਕਾਫ਼ੀ ਨਹੀਂ ਅੱਗਾ। ਸਰਚ ਕੁਆਲਟੀ ਇੱਕ ਹਿਲਦਾ-ਡੁੱਲਦਾ ਟੀਚਾ ਹੈ: ਨਵੇਂ ਪੰਨੇ ਆਉਂਦੇ ਹਨ, ਸਪੈਮ ਅਨੁਕੂਲ ਹੁੰਦਾ ਹੈ, ਅਤੇ ਲੋਕਾਂ ਦਾ ਕਹਿਨਾ ਕਿ ਕਿਆ ਚਾਹੀਦਾ ਹੈ, ਬਦਲ ਸਕਦਾ ਹੈ।

ਇਸ ਲਈ ਸਿਸਟਮ ਨੂੰ ਮਾਪਯੋਗ ਅਤੇ ਅਪਡੇਟਯੋਗ ਹੋਣਾ ਚਾਹੀਦਾ ਸੀ। Google ਨੇ ਲਗਾਤਾਰ ਟੈਸਟਿੰਗ 'ਤੇ ਨਿਰਭਰ ਕੀਤਾ—ਉਦੇਸ਼ ਬਦਲੋ, ਮਾਪੋ ਕਿ ਨਤੀਜੇ ਸੁਧਰੇ ਕਿ ਨਹੀਂ, ਅਤੇ ਦੁਹਰਾਓ। ਇਹ ਇਤਰ ਅਤੇ ਤੱਕੜੀ ਰੀਤ ਰੰਗ ਕੰਪਨੀ ਦੀ ਲੰਬੀ ਮਿਆਦ ਦੀ “ਸਿੱਖਣ” ਪਹੁੰਚ ਨੂੰ ਗਠਿਤ ਕਰਦੀ ਹੈ: ਸਿਰਚ ਨੂੰ ਇੱਕ ਇਕ ਵਾਰੀ ਦਾ ਇੰਜੀਨੀਅਰਿੰਗ ਪ੍ਰੋਜੈਕਟ ਨ سمجھੋ, ਬਲਕਿ ਲਗਾਤਾਰ ਮੁਲਾਂਕਣ ਕਰਨ ਵਾਲੀ ਚੀਜ਼ ਸਮਝੋ।

ਡੇਟਾ ਇੱਕ ਫਲਾਈਵ੍ਹੀਲ ਵਾਂਗ: ਅਸਲ ਵਰਤੋਂ ਤੋਂ ਸਿੱਖਣਾ

ਉੱਤਮ ਸਰਚ ਸਿਰਫ਼ ਚਤੁਰ ਅਲਗੋਰਿਦਮਾਂ ਬਾਰੇ ਨਹੀਂ ਹੁੰਦੀ—ਇਹ ਉਸ ਸੰਕੇਤਾਂ ਦੀ ਗੁਣਵੱਤਾ ਅਤੇ ਮਾਤਰਾ ਬਾਰੇ ਹੈ ਜਿਨ੍ਹਾਂ ਤੋਂ ਉਹ ਅਲਗੋਰਿਦਮ ਸਿੱਖਦੇ ਹਨ।

ਸ਼ੁਰੂਆਤੀ Google ਕੋਲ ਇੱਕ ਸੁਭਾਵਿਕ ਫਾਇਦਾ ਸੀ: ਵੈੱਬ ਖੁਦ ਹੀ "ਵੋਟਾਂ" ਨਾਲ ਭਰਪੂਰ ਹੈ ਜੋ ਮਹੱਤਵਪੂਰਨ ਨੂੰ ਦਰਸਾਉਂਦੀਆਂ ਹਨ। ਪੰਨਿਆਂ ਦੇ ਵਿਚਕਾਰ ਲਿੰਕ (PageRank ਦੀ ਨੀਂਹ) ਇੱਕੋ ਜਿਹਾ ਹਵਾਲਾ ਵਾਂਗ ਕੰਮ ਕਰਦੇ ਹਨ, ਅਤੇ ਐਂਕਰ ਟੈਕਸਟ ("ਇੱਥੇ ਕਲਿਕ ਕਰੋ" ਵਸੂਲ "ਸਰੋਤ ਬੇਸਟ ਹਾਈਕਿੰਗ ਬੂਟਸ") ਮਤਲਬ ਜੋੜਦਾ ਹੈ। ਇਸ ਤੋਂ ਇਲਾਵਾ, ਪੰਨਿਆਂ 'ਤੇ ਭਾਸ਼ਾ ਦੇ ਢਾਂਚੇ ਸਿਸਟਮ ਨੂੰ ਸਹੀ ਸ਼ਬਦ-ਸਮਾਨार्थੀ, ਸਪੈਲਿੰਗ ਬਦਲਾਵ ਅਤੇ ਉਨ੍ਹਾਂ ਤਰੀਕਿਆਂ ਨੂੰ ਸਮਝਣ ਵਿੱਚ ਮਦਦ ਕਰਦੇ ਹਨ ਜਿਨ੍ਹਾਂ ਨਾਲ ਲੋਕ ਇੱਕੋ ਹੀ ਸਵਾਲ ਪੁੱਛਦੇ ਹਨ।

ਉਹ ਫੀਡਬੈਕ ਲੂਪ ਜੋ ਤਕਬੀਰ ਕਰਦਾ ਹੈ

ਜਦੋਂ ਲੋਕ ਕਿਸੇ ਸਰਚ ਇੰਜਨ ਨੂੰ ਪੈਮਾਨੇ 'ਤੇ ਵਰਤਦੇ ਹਨ, ਤਾਂ ਵਰਤੋਂ ਹੋਰ ਸੰਕੇਤ ਪੈਦਾ ਕਰਦੀ ਹੈ:

- ਕਲਿਕਸ ਦਿਖਾਉਂਦੇ ਹਨ ਕਿ ਕਿਸ ਨਤੀਜੇ ਨੂੰ ਅਸਲ ਯੂਜ਼ਰ ਕਿਸ ਕਵੈਰੀ ਲਈ ਪ੍ਰਭਾਵਸ਼ਾਲੀ ਲਭਦੇ ਹਨ।

- "ਲੰਬੇ ਕਲਿਕ" ਅਤੇ ਤੇਜ਼ ਬੈਕ-ਅਨ-ਫੋਰਥ ਸੰਤੁਸ਼ਟੀ ਦੀ ਸੂਚਨਾ ਦੇ ਸਕਦੇ ਹਨ।

- ਕਵੈਰੀ ਦੁਬਾਰਾ ਲਿਖਣਾ (reformulations) ਦਿਖਾਉਂਦਾ ਹੈ ਕਿ ਨਤੀਜੇ ਅਤੇ ਇਰਾਦੇ ਵਿੱਚ ਮੁismatch ਹੈ।

ਇਹੀ ਫਲਾਈਵ੍ਹੀਲ ਹੈ: ਚੰਗੇ ਨਤੀਜੇ ਹੋਰ ਵਰਤੋਂ ਖਿੱਚਦੇ ਹਨ; ਹੋਰ ਵਰਤੋਂ ਅਮੀਰ ਸੰਕੇਤ ਪੈਦਾ ਕਰਦੀ ਹੈ; ਅਮੀਰ ਸੰਕੇਤ ਰੈਂਕਿੰਗ ਅਤੇ ਸਮਝ ਨੂੰ ਸੁਧਾਰਦੇ ਹਨ; ਅਤੇ ਉਹ ਸੁਧਾਰ ਹੋਰ ਯੂਜ਼ਰਾਂ ਨੂੰ ਖਿੱਚਦਾ ਹੈ। ਸਮੇਂ ਦੇ ਨਾਲ, ਸਰਚ ਇੱਕ ਨਿਯਮਾਂ ਦੇ ਸੈੱਟ ਵਾਂਗ ਨਹੀਂ ਰਹਿੰਦੀ, ਬਲਕਿ ਇੱਕ ਸਿੱਖਣ ਵਾਲੀ ਪ੍ਰਣਾਲੀ ਬਣ ਜਾਂਦੀ ਹੈ ਜੋ ਲੋਕਾਂ ਵੱਲੋਂ ਵਰਤੋਂਯੋਗ ਚੀਜ਼ਾਂ ਦੇ ਅਨੁਸਾਰ ਅਡਜਸਟ ਹੁੰਦੀ ਹੈ।

ਡੇਟਾ ਵੇਰਾਈਟੀ ਕਿਉਂ ਮਹੱਤਵਪੂਰਨ ਹੈ

ਵੱਖ-ਵੱਖ ਕਿਸਮਾਂ ਦਾ ਡੇਟਾ ਇਕੱਠੇ ਹੋ ਕੇ ਇਕ ਦੂਜੇ ਦੀ ਪੂਸ਼ਟੀ ਕਰਦੇ ਹਨ। ਲਿੰਕਾਂ ਦੀ ਬਣਤਰ ਪ੍ਰਭਾਵਸ਼ਾਲੀ ਪੰਨੇ ਉੱਪਰ ਲਿਆ ਸਕਦੀ ਹੈ, ਜਦਕਿ ਕਲਿਕ ਵਿਹਾਰ ਮੌਜੂਦਾ ਪਸੰਦਾਂ ਨੂੰ ਦਰਸਾਉਂਦਾ ਹੈ, ਅਤੇ ਭਾਸ਼ਾਈ ਡੇਟਾ ਅਸਪਸ਼ਟ ਕਵੈਰੀਆਂ ਨੂੰ ਸਮਝਾਉਂਦਾ ਹੈ ("jaguar" ਜਾਨਵਰ ਹੈ ਜਾਂ ਕਾਰ)। ਇਕੱਠੇ ਇਹ ਸਮਰੱਥਾ ਬਣਾਉਂਦੇ ਹਨ ਕਿ ਸਿਰਫ਼ "ਇਹ ਸ਼ਬਦ ਕਿੱਥੇ ਹਨ" ਨਹੀਂ, ਪਰ "ਇਹ ਇਰਾਦੇ ਲਈ ਸਭ ਤੋਂ ਚੰਗਾ ਜਵਾਬ ਕੀ ਹੈ" ਨੂੰ ਜਵਾਬ ਦਿੱਤਾ ਜਾ ਸਕੇ।

ਪ੍ਰਾਈਵੇਸੀ 'ਤੇ ਇੱਕ ਨੋਟ

ਇਹ ਫਲਾਈਵ੍ਹੀਲ ਸਾਫ਼ ਤੌਰ 'ਤੇ ਪ੍ਰਾਈਵੇਸੀ ਸਵਾਲ ਖੜੇ ਕਰਦੀ ਹੈ। ਜਨਤਕ ਰਿਪੋਰਟਿੰਗ ਨੇ ਲੰਬੇ ਸਮੇਂ ਤੋਂ ਦਰਸਾਇਆ ਹੈ ਕਿ ਵੱਡੇ ਉਪਭੋਗਤਾ ਉਤਪਾਦ ਭਾਰੀ ਇੰਟਰਐਕਸ਼ਨ ਡੇਟਾ ਪੈਦਾ ਕਰਦੇ ਹਨ, ਅਤੇ ਕੰਪਨੀਆਂ ਸੰਖੇਪਤ ਸੰਕੇਤਾਂ ਨੂੰ ਕੁਆਲਟੀ ਸੁਧਾਰਨ ਲਈ ਵਰਤਦੀਆਂ ਹਨ। ਇਹ ਵੀ ਵਿਆਪਕ ਤੱਥ ਹੈ ਕਿ Google ਨੇ ਸਮੇਂ ਦੇ ਨਾਲ ਪਰਾਈਵੇਸੀ ਅਤੇ ਸੁਰੱਖਿਆ ਨਿਯੰਤਰਣਾਂ ਵਿੱਚ ਨਿਵੇਸ਼ ਕੀਤਾ, ਹਾਲਾਂਕਿ ਵਿਸਥਾਰ ਅਤੇ ਪ੍ਰਭਾਵੀਤਾ 'ਤੇ ਗੱਲ-ਬਾਤ ਚੱਲਦੀ ਰਹੀ।

ਸੰਦੇਸ਼ ਸਧਾਰਨ ਹੈ: ਅਸਲ ਵਰਤੋਂ ਤੋਂ ਸਿੱਖਣਾ ਸ਼ਕਤੀਸ਼ਾਲੀ ਹੈ—ਅਤੇ ਭਰੋਸਾ ਇਸ ਗੱਲ 'ਤੇ ਨਿਰਭਰ ਕਰਦਾ ਹੈ ਕਿ ਇਹ ਸਿੱਖਿਆ ਕਿੰਨੀ ਜ਼ਿੰਮੇਵਾਰ ਢੰਗ ਨਾਲ ਕੀਤੀ ਜਾਂਦੀ ਹੈ।

"ਮਸ਼ੀਨ" ਬਣਾਉਣਾ: وہ ਇਨਫਰਾਸਟ੍ਰਕਚਰ ਜੋ AI ਨੂੰ ਵਰਤੋਂਯੋਗ ਬਣਾਉਂਦਾ

Google ਨੇ distributed computing 'ਚ ਸ਼ੁਰੂ ਤੋਂ ਨਿਵੇਸ਼ ਇਸ ਲਈ ਨਹੀਂ ਕੀਤਾ ਕਿ ਇਹ ਫੈਸ਼ਨ ਸੀ—ਬਲਕਿ ਇਸ ਲਈ ਕਿ ਵੈੱਬ ਦੇ ਗੁੰਝਲਦਾਰ ਪੈਮਾਨੇ ਨਾਲ ਨਿਭਾਉਣ ਦਾ ਇਹ ਇਕਲੌਤਾ ਤਰੀਕਾ ਸੀ। ਜੇ ਤੁਸੀਂ ਬਿਲੀਅਨ ਪੰਨਿਆਂ ਨੂੰ ਕਰਾਲ ਕਰਨਾ ਚਾਹੁੰਦੇ ਹੋ, ਰੈਂਕਿੰਗ ਨੂੰ ਮੁੜ-ਅਪਡੇਟ ਕਰਨਾ ਹੈ, ਅਤੇ ਕਈਆਂ ਮਿਲੀਅਨ ਲੋਕਾਂ ਲਈ ਤੁਰੰਤ ਉੱਤਰ ਦੇਣਾ ਹੈ, ਤਾਂ ਇਕ ਵੱਡੇ ਕੰਪਿਊਟਰ 'ਤੇ ਨਿਰਭਰ ਨਹੀਂ ਕੀਤਾ ਜਾ ਸਕਦਾ। ਤੁਹਾਨੂੰ ਹਜ਼ਾਰਾਂ ਸਸਤੇ ਮਸ਼ੀਨਾਂ ਦੀ ਲੋੜ ਹੁੰਦੀ ਹੈ ਜੋ ਇਕੱਠੇ ਕੰਮ ਕਰਨ, ਅਤੇ ਸਾਫਟਵੇਅਰ ਜੋ ਨਿਫਸਾਨੀ ਤੌਰ 'ਤੇ ਫੇਲਿਅਰਾਂ ਨੂੰ ਸਹਿਮਾਨ ਸਵਭਾਵ ਮੰਨਦਾ ਹੋਵੇ।

###Distributed computing ਸ਼ੁਰੂ ਤੋਂ ਹੀ ਕਿਉਂ ਮਾਇਨੇ ਰੱਖਦੀ ਸੀ

ਸਰਚ ਨੇ Google ਨੂੰ ਉਹ ਸਿਸਟਮ ਬਣਾਉਣ ਲਈ ਮਜਬੂਰ ਕੀਤਾ ਜੋ ਵੱਡੇ ਡੇਟਾ ਨੂੰ ਭਰੋਸੇਯੋਗ ਤਰੀਕੇ ਨਾਲ ਸਟੋਰ ਅਤੇ ਪ੍ਰੋਸੈਸ ਕਰ ਸਕੇ। ਇਹੀ "ਕਈ ਕੰਪਿਊਟਰ, ਇਕ ਸਿਸਟਮ" ਨਜ਼ਰੀਆ ਬਾਅਦ ਵਿੱਚ ਹਰ ਚੀਜ਼ ਦੀ ਨੀਂਹ ਬਣਿਆ: ਇੰਡੈਕਸਿੰਗ, ਐਨਾਲਿਟਿਕਸ, ਪ੍ਰਯੋਗ, ਅਤੇ ਆਖਿਰਕਾਰ machine learning।

ਮੁੱਖ ਸਬਕ ਇਹ ਹੈ ਕਿ ਇਨਫਰਾਸਟ੍ਰੱਕਚਰ AI ਤੋਂ ਵੱਖ ਨਹੀਂ—ਉਹ ਨਿਰਧਾਰਿਤ ਕਰਦੀ ਹੈ ਕਿ ਕਿਸ ਤਰ੍ਹਾਂ ਦੇ ਮਾਡਲ ਸੰਭਵ ਹਨ।

ਕਿਵੇਂ ਇਨਫਰਾਸਟ੍ਰੱਕਚਰ AI ਨੂੰ ਡੈਮੋ ਤੋਂ ਉਤਪਾਦ ਬਣਾਉਂਦੀ ਹੈ

ਇਕ ਉਪਯੋਗੀ ਮਾਡਲ ਨੂੰ ਟ੍ਰੇਨ ਕਰਨ ਲਈ ਉਸਨੂੰ ਕਾਫ਼ੀ ਉਦਾਹਰਣਾਂ ਦੇਖਾਉਣੀਆਂ ਪੈਂਦੀਆਂ ਹਨ। ਉਸ ਮਾਡਲ ਨੂੰ ਸਰਵ ਕਰਨ ਦਾ ਮਤਲਬ ਹੈ ਕਿ ਉਸਨੂੰ ਮਿਲੀਅਨਾਂ ਲੋਕਾਂ ਲਈ ਤੁਰੰਤ ਚਲਾਇਆ ਜਾਵੇ, ਬਿਨਾਂ ਡਾਊਟ ਹੋਏ। ਦੋਹਾਂ "ਪੈਮਾਨਾ ਸਮੱਸਿਆਵਾਂ" ਹਨ:

- ਟ੍ਰੇਨਿੰਗ ਵਿੱਚ ਵੱਡੀ ਕਮਪਿਊਟ ਚਾਹੀਦੀ ਹੈ ਤਾਂ ਜੋ ਡੇਟਾ ਨੂੰ ਵਾਰ-ਵਾਰ ਸੰਭਾਲਿਆ ਜਾ ਸਕੇ।

- ਸਰਵਿੰਗ ਵਿੱਚ ਘੱਟ-ਲੈਟੈਂਸੀ ਸਿਸਟਮ ਚਾਹੀਦੇ ਹਨ ਤਾਂ ਜੋ ਭਵਿੱਖਵਾਣੀਆਂ ਤੇਜ਼ੀ ਨਾਲ (ਅਕਸਰ ਮਿਲੀਸੈਕੰਡਾਂ ਵਿੱਚ) ਕੀਤੀ ਜਾ ਸਕਣ, ਚਾਹੇ ਟ੍ਰੈਫਿਕ ਵਧੇ।

ਜਦੋਂ ਤੁਸੀਂ ਡੇਟਾ ਸਟੋਰ ਕਰਨ, ਗਣਨਾ ਵੰਡਣ, ਪ੍ਰਦਰਸ਼ਨ ਮੋਨੀਟਰ ਕਰਨ, ਅਤੇ ਸੁਰੱਖਿਅਤ ਤਰੀਕੇ ਨਾਲ ਅਪਡੇਟ ਰੋਲਆਉਟ ਕਰਨ ਦੀਆਂ ਪਾਈਪਲਾਈਨਾਂ ਬਣਾਉਂਦੇ ਹੋ, ਤਾਂ ਸਿੱਖਣ-ਆਧਾਰਿਤ ਸਿਸਟਮ ਲਗਾਤਾਰ ਸੁਧਾਰ ਸਕਦੇ ਹਨ ਬਜਾਏ ਇਸਦੇ ਕਿ ਉਹ ਕਦੇ-ਕਦੇ ਨਾਜ਼ੁਕ ਪੂਨਰਲੇਖ ਹੋਣ।

"ਪਲੰਬਿੰਗ" ਨਾਲ ਚੱਲਣ ਵਾਲੀਆਂ ਸਧਾਰਣ, ਰੋਜ਼ਾਨਾ ਉਦਾਹਰਣਾਂ

ਕੁਝ ਪਰਚਿੱਤ ਖਾਸੀਅਤਾਂ ਦਿਖਾਉਂਦੀਆਂ ਹਨ ਕਿ ਮਸ਼ੀਨ ਕਿੰਨੀ ਮਹੱਤਵਪੂਰਨ ਹੈ:

- ਸਪੀਲ ਸੁਧਾਰ: "restarant" → "restaurant" ਵਰਗੇ ਪੈਟਰਨ ਨੋਟ ਕਰਨਾ ਕਈ ਸਾਰੀਆਂ ਖੋਜਾਂ ਅਤੇ ਕਲਿਕਸ ਤੋਂ ਸਿੱਖਣਾ ਅਤੇ ਫਿਰ ਤੁਰੰਤ ਕੋਰੀਗੇਸ਼ਨ ਲਾਗੂ ਕਰਨਾ ਲੋੜੀਂਦਾ ਹੈ।

- ਆਟੋ-ਕੰਪਲੀਟ: ਤੁਸੀਂ ਜੋ ਲਿਖਣ ਜਾ ਰਹੇ ਹੋ ਉਸ ਦੀ ਅਗਾਂਹ ਦੀ ਭਵਿੱਖਵਾਣੀ aggregated ਵਿਹਾਰ ਤੇ ਤੇਜ਼ ਇੰਫਰੰਸ 'ਤੇ ਨਿਰਭਰ ਕਰਦੀ ਹੈ—ਨਹੀਂ ਤਾਂ ਸੁਝਾਅ ਡੇਰ ਨਾਲ ਅਤੇ ਗਲਤ ਮਹਿਸੂਸ ਹੁੰਦੇ।

- ਅਨੁਵਾਦ: ਵਧੀਆ ਅਨੁਵਾਦ ਗੁਣਵੱਤਾ ਵੱਡੇ datasets 'ਤੇ ਟ੍ਰੇਨਿੰਗ ਅਤੇ ਉਹ ਮਾਡਲ ਦੀਆਂ ਰੀਅਲ-ਟਾਈਮ ਸੇਵਾਵਾਂ ਲਈ ਦੌੜਾਉਣ ਯੋਗ ਹੋਣ 'ਤੇ ਆਧਾਰਿਤ ਹੁੰਦੀ ਹੈ।

Google ਦਾ ਲੰਬਾ ਫਾਇਦਾ ਸਿਰਫ਼ ਚਤੁਰ ਅਲਗੋਰਿਦਮ ਨਹੀਂ ਸੀ—ਉਸਨੇ ਓਪਰੇਸ਼ਨਲ ਇੰਜਣ ਬਣਾਇਆ ਜੋ ਅਲਗੋਰਿਦਮਾਂ ਨੂੰ ਇੰਟਰਨੈਟ ਪੈਮਾਨੇ 'ਤੇ ਸਿੱਖਣ, ਭੇਜਣ ਅਤੇ ਸੁਧਾਰਨ ਦੀ ਆਗਿਆ ਦਿੰਦਾ ਸੀ।

ਨਿਯਮਾਂ ਤੋਂ ਸਿੱਖਣ ਤੱਕ: ਕਿਵੇਂ ਸਰਚ ਚੁਪਚਾਪ ਵੱਧ "AI-ਵਾਂਗ" ਬਣੀ

ਇੰਫ੍ਰਾਸਟ੍ਰੱਕਚਰ ਨੂੰ ਪ੍ਰਾਇਕਟਿਕ ਬਣਾਓ

React, Go ਅਤੇ PostgreSQL ਦਾ ਇੱਕ ਐਸਾ ਐਪ ਸ਼ੁਰੂ ਕਰੋ ਜੋ ਅਸਲ ਮੈਟ੍ਰਿਕਸ ਅਤੇ ਇਟਰੈਸ਼ਨ ਦਾ ਸਮਰਥਨ ਕਰ ਸਕੇ।

ਸ਼ੁਰੂਆਤੀ Google ਪਹਿਲਾਂ ਹੀ "ਸਿਆਣਾ" ਲੱਗਦਾ ਸੀ, ਪਰ ਬਹੁਤ ਸਾਰੀ ਉਸ ਦੀ ਸਮਝ-engineered ਸੀ: link analysis (PageRank), ਹੱਥ ਨਾਲ ਟਿਊਨ ਕੀਤੇ ਰੈਂਕਿੰਗ ਸਿਗਨਲ, ਅਤੇ ਸਪੈਮ ਲਈ ਬਹੁਤ ਸਾਰੇ ਹਿਊਰਿਸਟਿਕਸ। ਸਮੇਂ ਦੇ ਨਾਲ, ਕੇਂਦਰ ਦਾ ਭਾਰ ਇਹੋ-ਬਦਲ ਗਿਆ ਕਿ ਸਿਸਟਮ ਸਪਸ਼ਟ ਨਿਯਮਾਂ ਤੋਂ ਉੱਠ ਕੇ ਡੇਟਾ ਤੋਂ ਪੈਟਰਨ ਸਿੱਖਣ ਵਾਲੇ ਸਿਸਟਮ ਬਣ ਗਇਆ—ਖਾਸ ਕਰਕੇ ਇਸ ਗੱਲ 'ਤੇ ਕਿ ਲੋਕ ਕੀ ਮਤਲਬ ਦੇ ਰਹੇ ਹਨ, ਨਾ ਕਿ ਸਿਰਫ਼ ਉਹ ਕੀ ਲਿਖਦੇ ਹਨ।

ML ਨੇ ਸਰਚ ਦਾ ਅੰਦਾਜ਼ ਕਿਵੇਂ ਬਦਲਿਆ

ਮਸ਼ੀਨ ਲਰਣਿੰਗ تدريجي طور تي ਉਹ ਤੀਨ ਗੱਲਾਂ ਸੁਧਾਰੀਆਂ ਜਿਨ੍ਹਾਂ ਨੂੰ ਰੋਜ਼ਾਨਾ ਯੂਜ਼ਰ ਮਹਿਸੂਸ ਕਰਦੇ ਹਨ:

- ਰੈਂਕਿੰਗ ਦੀ ਗੁਣਵੱਤਾ: ਨਿਸ਼ਚਿਤ ਫਾਰਮੂਲੇ ਨਾਲ ਸਿਗਨਲਾਂ ਨੂੰ ਭਾਰ ਦੇਣ ਦੀ ਥਾਂ, ਮਾਡਲ ਇਹ ਸਿੱਖਦੇ ਹਨ ਕਿ ਕਿਹੜੀਆਂ ਸਿਗਨਲਾਂ ਦੇ ਕਮੇਬੀनेਸ਼ਨ ਯੂਜ਼ਰਾਂ ਨੂੰ ਠੀਕ ਲੱਗਦੇ ਹਨ (ਗੋਪਨੀਯਤ ਤੌਰ 'ਤੇ agregated ਵਰਤੋਂ ਅਤੇ ਮਨੁੱਖੀ quality ਰੇਟਰ ਫੀਡਬੈਕ ਦੁਆਰਾ ਮਾਪਿਆ)।

- ਇਰਾਦਾ ਸਮਝਣਾ: "jaguar speed" ਜਾਂ "apple support" ਵਰਗੀਆਂ ਕਵੈਰੀਆਂ ਨੇ ਮਾਡਲਾਂ ਨੂੰ ਅਰਥ, ਸੰਦਰਭ ਅਤੇ ਅਸਪਸ਼ਟਤਾ ਨਿਕਾਲਣ ਲਈ ਮਜ਼ਬੂਰ ਕੀਤਾ। ਸਿੱਖਣ-ਆਧਾਰਿਤ ਸਿਸਟਮ ਸ਼ਬਦਾਂ ਨੂੰ ਧਾਰਣਾ ਅਤੇ ਸੰਭਾਵਿਤ ਲਕੜੇ ਨਾਲ ਜੋੜਨਾ ਬੇਹਤਰ ਕਰ ਗਏ।

- ਸਪੈਮ ਅਤੇ ਭਰੋਸਾ: ਜਦੋਂ 컨텐츠 ਫਾਰਮਸ ਅਤੇ ਮੈਨੇਜ ਕੀਤੀਆਂ SEO ਤਕਨੀਕਾਂ ਵਧੀਆਂ, ML ਨੇ ਅਸਭਿਆਚਾਰਿਕ ਲਿੰਕ ਪੈਟਰਨ, ਪਤਲਾ ਸਮੱਗਰੀ ਅਤੇ ਹੋਰ ਤਰੀਕਿਆਂ ਦੀ ਪਛਾਣ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕੀਤੀ—ਇਸ ਨਾਲ ਉੱਚ-ਗੁਣਵੱਤਾ ਨਤੀਜਿਆਂ ਵੱਲ ਧੱਕਾ ਮਿਲਿਆ।

ਪਾਠਕ-ਮਿਤਰ ਟਾਈਮਲਾਈਨ

- 1998: PageRank ਅਤੇ ਮੂਲ Google ਪੇਪਰ ਨੇ ਲਿੰਕ ਰਾਹੀਂ ਪ੍ਰਸੰਗਿਕਤਾ ਦੀ ਬੁਨਿਆਦ ਰੱਖੀ।

- ਸ਼ੁਰੂ 2000s: ਸਾਂਖਿਆਕਿਕ ਸਪੀਲ ਸਹੀ ਕਰਨ ਅਤੇ ਕੁਝ ਸੁਝਾਅ ਸੁਧਾਰ "did you mean" ਨੂੰ ਬਿਹਤਰ ਬਣਾਉਂਦੇ ਹਨ।

- 2011: Panda ਰੁਕਾਵਟ-ਘਟੀਆ ਸਮੱਗਰੀ 'ਤੇ ਨਿਸ਼ਾਨਾ ਲਾਂਦਾ ਹੈ; ਗੁਣਵੱਤਾ ਸਿਗਨਲ ਜ਼ਿਆਦਾ ਪ੍ਰਣਾਲੀਬੱਧ ਬਣਦੇ ਹਨ।

- 2012: Penguin ਲਿੰਕ ਮੈਨੀਪੂਲੇਸ਼ਨ ਨੂੰ ਸਜ਼ਾ ਦਿੰਦਾ, ਹੱਥ ਦੇ ਨਿਯਮਾਂ ਤੋਂ ਪਹਿਲਾਂ ਜ਼ਿਆਦਾ ਝੁਕਾਅ।

- 2015: RankBrain (ਸਿੱਖਣ-ਆਧਾਰਿਤ ਰੈਂਕਿੰਗ ਕੰਪੋਨੈਂਟ) ਅਜਿਹੀਆਂ ਕਵੈਰੀਆਂ 'ਤੇ ਮਦਦ ਕਰਦਾ ਜੋ ਅਣਜਾਣ ਜਾਂ ਅਸਪਸ਼ਟ ਹੁੰਦੀਆਂ ਹਨ।

- 2018–2019: neural matching ਅਤੇ BERT ਭਾਸ਼ਾਈ ਸਮਝ ਨੂੰ ਮਜ਼ਬੂਤ ਕਰਦੇ ਹਨ, ਖਾਸ ਕਰਕੇ ਲੰਬੀਆਂ ਕਵੈਰੀਆਂ ਅਤੇ ਪ੍ਰਿਪੋਜ਼ੀਸ਼ਨ ਲਈ।

- 2021+: MUM-ਕਾਲ ਦੇ ਮਲਟੀ-ਟਾਸਕ ਮਾਡਲ ਅਤੇ "helpful content" ਯਤਨਾਂ ਨੇ ਗਹਿਰੀ ਇਰਾਦਾ ਅਤੇ ਉਪਯੋਗੀਤਾ ਸਿਗਨਲ ਵੱਲ ਧੱਕਿਆ।

ਹਵਾਲਾ-ਯੋਗ ਸਰੋਤ

ਨਿਸ਼ਚਿਤਤਾ ਲਈ, ਪ੍ਰਾਇਮਰੀ ਰਿਸਰਚ ਅਤੇ ਸਰਵਜਨਿਕ ਉਤਪਾਦ ਵਰਣਨ ਦੇ ਮਿਲੇ-ਜੁਲੇ ਸਰੋਤ ਉਪਰੋਕਤ ਹਨ:

- ਰਿਸਰਚ ਪੇਪਰ: Brin & Page (PageRank, 1998), BERT (Devlin et al., 2018).

- ਆਧਿਕਾਰਿਕ ਸਰਚ ਐਲਾਨ: Google Search ਬਲੌਗ ਪੋਸਟਾਂ RankBrain, BERT, MUM, Panda/Penguin ਅਪਡੇਟਾਂ 'ਤੇ।

- ਟਾਕ/ਇੰਟਰਵਿਊ: ranking evolution 'ਤੇ Amit Singhal ਦੇ ਇੰਟਰਵਿਊ; Sundar Pichai ਦੀਆਂ ਮੁੱਖ ਭਾਸ਼ਣੀਆਂ (Google I/O); ਆਧੁਨਿਕ ਮੀਲ-ਪੱਥਰਾਂ ਲਈ "Search On" ਘਟਨਾਵਾਂ।

ਰਿਸਰਚ ਸੰਸਕ੍ਰਿਤੀ: ਲੰਬੇ ਸ਼ਟਾਂ ਨੂੰ ਉਪਯੋਗੀ ਪ੍ਰਣਾਲੀਆਂ ਵਿੱਚ ਬਦਲਣਾ

Google ਦਾ ਲੰਬਾ ਖੇਡ ਸਿਰਫ਼ ਵੱਡੇ ਵਿਚਾਰਾਂ ਦਾ ਹੋਣਾ ਨਹੀਂ ਸੀ—ਇਹ ਇੱਕ ਅਜਿਹੀ ਰਿਸਰਚ ਸੰਸਕ੍ਰਿਤੀ 'ਤੇ ਨਿਰਭਰ ਸੀ ਜੋ ਅਕਾਦਮਿਕ-ਲਗਦੀਆਂ ਪੇਪਰਾਂ ਨੂੰ ਲੱਖਾਂ ਲੋਕਾਂ ਵੱਲ ਵਰਤੇ ਜਾਣ ਵਾਲੀਆਂ ਚੀਜ਼ਾਂ ਵਿੱਚ ਬਦਲ ਸਕੇ। ਇਸਦਾ ਮਤਲਬ ਸੀ,好奇ਤ ਨੂੰ ਇਨਾਮ ਦੇਣਾ, ਪਰ ਇਨ੍ਹਾਂ ਪ੍ਰੋਟੋਟਾਈਪਾਂ ਨੂੰ ਭਰੋਸੇਯੋਗ ਉਤਪਾਦ ਤੱਕ ਲੈ ਜਾਣ ਦੇ ਰਸਤੇ ਵੀ ਬਣਾਉਣੇ।

"ਪਬਲਿਸ਼" ਤੋਂ "ਸ਼ਿਪ" ਤੱਕ

ਕਈ ਕੰਪਨੀਆਂ ਰਿਸਰਚ ਨੂੰ ਇੱਕ ਵਿਛੜੇ ਦਰਿਆਫ਼ਤੇ ਵਾਂਗ ਦੇਖਦੀਆਂ ਹਨ। Google ਨੇ ਇੱਕ ਨੇੜਲਾ ਲੂਪ ਬਣਾਉਣੇ 'ਤੇ ਜ਼ੋਰ ਦਿੱਤਾ: ਰਿਸਰਚਰ ਮਹਾਨ ਦਿਸ਼ਾਵਾਂ 'ਤੇ ਪੜ੍ਹ ਸਕਦੇ ਸਨ, ਨਤੀਜੇ ਪ੍ਰਕਾਸ਼ਿਤ ਕਰ ਸਕਦੇ ਸਨ, ਅਤੇ ਫਿਰ ਪ੍ਰੋਡਕਟ ਟੀਮਾਂ ਨਾਲ ਸਹਿਯੋਗ ਕਰ ਸਕਦੇ ਸਨ ਜਿਹੜੀਆਂ ਲੇਟੈਂਸੀ, ਭਰੋਸਾ ਅਤੇ ਯੂਜ਼ਰ ਟਰੱਸਟ ਦੀ ਫਿਕਰ ਕਰਦੀਆਂ। ਜਦੋਂ ਉਹ ਲੂਪ ਚੰਗਾ ਕੰਮ ਕਰਦਾ, ਤਾਂ ਇੱਕ ਪੇਪਰ ਖਤਮ ਲਕੀਰ ਨਹੀਂ ਹੁੰਦੀ—ਇਹ ਇੱਕ ਤੇਜ਼, ਬਿਹਤਰ ਸਿਸਟਮ ਦੀ ਸ਼ੁਰੂਆਤ ਹੁੰਦੀ ਹੈ।

ਇਸਨੂੰ ਅਮਲ ਵਿੱਚ ਮਿਲਦਾ ਹੈ ਕਿ ਮਾਡਲ ਦੇ ਵਿਚਾਰ "ਛੋਟੀਆਂ" ਖਾਸੀਅਤਾਂ ਵਿੱਚ ਕਿਵੇਂ ਆਉਂਦੇ ਹਨ: ਬਿਹਤਰ ਸਪੀਲ ਸੁਧਾਰ, ਸਿਆਣੀ ਰੈਂਕਿੰਗ, ਸੁਧਰੇ ਸਿਫ਼ਾਰਸ਼, ਜਾਂ ਘੱਟ-ਬੋਲਣ ਵਾਲਾ ਅਨੁਵਾਦ। ਹਰ ਪੜਾਅ ਇਨਕ੍ਰਿਮੈਂਟਲ ਲਗ ਸਕਦਾ ਹੈ, ਪਰ ਮਿਲ ਕੇ ਇਹ "ਸਰਚ" ਦੇ ਅਨੁਭਵ ਨੂੰ ਬਦਲ ਦਿੰਦੇ ਹਨ।

ਉਹ ਮੈਲ ਸਟੋਨ ਜਿਨ੍ਹਾਂ ਨੇ ਰਫ਼ਤਾ ਬਦਲੀ ਪਾਈ

ਕਈ ਉਪਰਾਲੇ ਉਸ ਪੇਪਰ-ਟੂ-ਪ੍ਰੋਡਕਟ ਪਾਈਪਲਾਈਨ ਦੇ ਨਿਸ਼ਾਨ ਬਣੇ। Google Brain ਨੇ ਕੰਪਨੀ ਵਿੱਚ deep learning ਨੂੰ ਅੱਗੇ ਧੱਕਿਆ, ਜਦੋਂ ਇਹ ਦਿਖਾਇਆ ਕਿ ਜੇ ਤੁਹਾਡੇ ਕੋਲ ਕਾਫ਼ੀ ਡੇਟਾ ਅਤੇ ਕਮਪਿਊਟ ਹੋਵੇ ਤਾਂ ਇਹ ਪੁਰਾਣੇ ਤਰੀਕਿਆਂ ਤੋਂ ਬਿਹਤਰ ਨਤੀਜੇ ਦੇ ਸਕਦਾ ਹੈ। ਬਾਅਦ ਵਿੱਚ TensorFlow ਨੇ ਟੀਮਾਂ ਲਈ ਮਾਡਲ ਟ੍ਰੇਨ ਅਤੇ ਡਿਪਲੌਇ ਕਰਨ ਨੂੰ ਆਸਾਨ ਬਣਾਇਆ—ਇਹ ਇੱਕ ਨਿਰਲਾਜ਼ੀ ਪਰ ਬਹੁਤ ਜਰੂਰੀ ਅੰਗ ਸੀ।

(neural machine translation, speech recognition, vision) 'ਤੇ ਹੋਇਆ ਰਿਸਰਚ ਵੀ ਲੈਬ ਦੇ ਨਤੀਜਿਆਂ ਤੋਂ ਰੋਜ਼ਾਨਾ ਅਨੁਭਵ ਤੱਕ ਆਇਆ, ਅਕਸਰ ਕਈ ਇਟਰੇਸ਼ਨਾਂ ਤੋਂ ਬਾਅਦ ਗੁਣਵੱਤਾ ਵਿੱਚ ਸੁਧਾਰ ਅਤੇ ਲਾਗਤ ਵਿੱਚ ਕਮੀ ਆਈ।

ਧੀਰਜ ਕਿਉਂ ਮਹੱਤਵਪੂਰਨ ਹੈ

ਫਾਇਦਾ-ਵਕਤਰਾ ਅਕਸਰ ਤੁਰੰਤ ਨਹੀਂ ਹੁੰਦਾ। ਸ਼ੁਰੂਆਤੀ ਵਰਜਨ ਮਹਿੰਗੇ, ਗਲਤ, ਜਾਂ ਇਕਠੇ ਕਰਨ ਵਿੱਚ ਮੁਸ਼ਕਿਲ ਹੋ ਸਕਦੇ ਹਨ। ਫਾਇਦਾ ਉਸ ਵਿਚਾਰ ਨਾਲ ਲੰਬੇ ਸਮੇਂ ਰਹਿਣ ਤੋਂ ਆਉਂਦਾ ਹੈ: ਇਨਫਰਾਸਟ੍ਰੱਕਚਰ ਬਣਾਉਣਾ, ਫੀਡਬੈਕ ਇਕੱਠਾ ਕਰਨਾ, ਅਤੇ ਇਸ ਤੱਕ ਮਾਡਲ ਨੂੰ ਸੁਧਾਰਨਾ ਜਦ ਤੱਕ ਇਹ ਭਰੋਸੇਯੋਗ ਨਹੀਂ ਬਣ ਜਾਂਦਾ।

ਉਹ ਧੀਰਜ—ਲੰਬੇ ਸ਼ਟਾਂ ਨੂੰ ਫੰਡ ਕਰਨਾ, ਡੇਟੂਰਾਂ ਨੂੰ ਸਵੀਕਾਰ ਕਰਨਾ, ਅਤੇ ਸਾਲਾਂ ਤੱਕ ਇਟਰੇਟ ਕਰਨਾ—ਹੋਰਿਆ AI ਸਮਝਾਵਾਂ ਨੂੰ Google ਪੈਮਾਨੇ 'ਤੇ ਉਪਯੋਗੀ ਪ੍ਰਣਾਲੀਆਂ ਵਿੱਚ ਬਦਲਣ ਵਿੱਚ ਮਦਦਗਾਰ ਰਹੀ।

ਨਵੇਂ ਇਨਪੁੱਟ: ਵਾਇਸ, ਚਿੱਤਰ ਅਤੇ ਵੀਡੀਓ ਨੇ ਮਾਡਲਾਂ ਨੂੰ ਹੋਰ ਸੋਚਣ ਲਈ ਮਜਬੂਰ ਕੀਤਾ

ਟੈਕਸਟ ਸਰਚ ਚਤੁਰ ਰੈਂਕਿੰਗ ਤਰਕੀਬਾਂ ਨੂੰ ਇਨਾਮ ਦਿੰਦੀ ਸੀ। ਪਰ ਜਦੋਂ Google ਨੇ ਵਾਇਸ, ਫੋਟੋਆਂ ਅਤੇ ਵੀਡੀਓ ਲੈਣੇ ਸ਼ੁਰੂ ਕੀਤੇ, ਤਾਂ ਪੁਰਾਣਾ ਤਰੀਕਾ ਠੋਕਰ ਖਾਣ ਲੱਗਾ। ਇਹ ਇਨਪੁੱਟ ਗੁੰਝਲਦਾਰ ਹਨ: ਉਚਾਰਨ, ਪਿਛੋਕੜ ਸ਼ੋਰ, ਧੁੰਦਲੇ ਚਿੱਤਰ, ਹਿਲ-ਡੁਲਾ ਵੀਡੀਓ, ਸਲੈੰਗ, ਅਤੇ ਉਹ ਸੰਦਰਭ ਜੋ ਲਿਖਿਆ ਨਹੀਂ ਹੁੰਦਾ। ਉਨ੍ਹਾਂ ਨੂੰ ਉਪਯੋਗੀ ਬਣਾਉਣ ਲਈ, Google ਨੂੰ ਐਸੇ ਸਿਸਟਮਾਂ ਦੀ ਲੋੜ ਪਈ ਜੋ ਹੱਥ ਨਾਲ ਲਿਖੇ ਨਿਯਮਾਂ ਦੀ ਥਾਂ ਡੇਟਾ ਤੋਂ ਪੈਟਰਨ ਸਿੱਖਣ।

ਵਾਇਸ: ਆਵਾਜ਼ ਨੂੰ ਇਰਾਦੇ ਵਿੱਚ ਬਦਲਣਾ

ਵਾਇਸ ਸਰਚ ਅਤੇ Android ਡਿਕਟੇਸ਼ਨ ਦੇ ਨਾਲ, ਮਨੋਰੱਥ ਸਿਰਫ਼ "ਸ਼ਬਦ ਟ੍ਰਾਂਸਕ੍ਰਾਈਬ ਕਰੋ" ਨਹੀਂ ਸੀ। ਮਕਸਦ ਸੀ ਕਿ ਕਿਸੇ ਦੀ ਮੁਰਾਦ ਨੂੰ ਸਮਝਣਾ—ਤੇਜ਼ੀ ਨਾਲ, ਡਿਵਾਈਸ 'ਤੇ ਜਾਂ ਕਮਜ਼ੋਰ ਕਨੈਕਸ਼ਨ 'ਤੇ ਵੀ।

Speech recognition ਨੇ Google ਨੂੰ ਵੱਡੇ ਪੱਧਰ ਦੀ machine learning ਵੱਲ ਧੱਕਿਆ ਕਿਉਂਕਿ ਗੁਣਵੱਤਾ ਉਹਨਾਂ ਮਾਡਲਾਂ 'ਤੇ ਸਭ ਤੋਂ ਜ਼ਿਆਦਾ ਸੁਧਰਦੀ ਸੀ ਜਿਨ੍ਹਾਂ ਨੂੰ ਵਿਭਿੰਨ ਅਤੇ ਵੱਡੇ ਆਡੀਓ datasets 'ਤੇ ਟ੍ਰੇਨ ਕੀਤਾ ਗਿਆ ਸੀ। ਇਸ ਉਤਪਾਦੀ ਦਬਾਅ ਨੇ ਟ੍ਰੇਨਿੰਗ ਲਈ ਗੰਭੀਰ ਨਿਵੇਸ਼ ਨੂੰ ਜਾਇਜ਼ ਠਹਿਰਾਇਆ: ਖਾਸ ਟੂਲਿੰਗ (ਡੇਟਾ ਪਾਈਪਲਾਈਨ, ਮੁਲਾਂਕਣ ਸੈੱਟ, ਡਿਪਲੌਇਮੈਂਟ ਸਿਸਟਮ) ਅਤੇ ਲੋਕ ਜੋ ਲਾਈਵ ਉਤਪਾਦਾਂ ਵਾਂਗ ਮਾਡਲਾਂ 'ਤੇ ਇਟਰੇਟ ਕਰ ਸਕਣ।

ਫੋਟੋਆਂ: ਮੈਟਾ-ਡੇਟਾ ਨਹੀਂ, ਮਤਲਬ

ਫੋਟੋਆਂ ਨਾਲ ਕੁਝ ਸ਼ਬਦ ਨਾਲ ਨਹੀਂ ਆਉਂਦੀਆਂ। ਯੂਜ਼ਰ ਉਮੀਦ ਕਰਦੇ ਹਨ ਕਿ Google Photos "ਕੁੱਤੇ", "ਸਮੁੰਦਰੀ ਤਟ", ਜਾਂ "ਮੇਰੀ ਪੈਰਿਸ ਯਾਤਰਾ" ਲੱਭੇਗਾ, ਭਾਵੇਂ ਉਹਨੇ ਕੁਝ ਟੈਗ ਨਾ ਕੀਤਾ ਹੋਵੇ।

ਇਹ ਉਮੀਦ ਵਧੀਆ ਚਿੱਤਰ ਸਮਝ ਦੀ ਮੰਗ ਕਰਦੀ ਹੈ: ਵਸਤੂ ਪਛਾਣ, ਚਿਹਰਾ ਗਰੁੱਪਿੰਗ, ਅਤੇ ਸਮਾਨਤਾ ਤੇ ਖੋਜ। ਫਿਰੋਂ, ਨਿਯਮ ਇਸ ਬਹੁਮੁੱਖਤਾ ਨੂੰ ਕਵਰ ਨਹੀਂ ਕਰ ਸਕਦੇ—ਇਸ ਲਈ ਸਿੱਖਣ ਵਾਲੇ ਸਿਸਟਮ ਸਭ ਤੋਂ ਪ੍ਰਯੋਗਿਕ ਰਸਤਾ ਸਾਬਿਤ ਹੋਏ। ਸੁਧਾਰ ਲਈ ਹੋਰ ਲੇਬਲਡ ਡੇਟਾ, ਵਧੀਆ ਟ੍ਰੇਨਿੰਗ ਇਨਫਰਾਸਟਰੱਕਚਰ, ਅਤੇ ਤੇਜ਼ ਪ੍ਰਯੋਗ ਚੱਕਰ ਲੋੜੇ।

ਵੀਡੀਓ ਅਤੇ ਸਿਫ਼ਾਰਸ਼: ਪੈਮਾਨਾ ਕਮਜ਼ੋਰੀਆਂ ਨੂੰ ਬੇਨਕਾਬ ਕਰਦਾ

ਵੀਡੀਓ ਇਕ ਦੁਹਰਾ ਚੈਲੈਂਜ ਲਿਆਉਂਦਾ: ਹੀ ਚਿੱਤਰਾਂ ਦੀ ਲੜੀ ਅਤੇ ਆਵਾਜ਼। YouTube 'ਚ ਮਦਦ (ਖੋਜ, ਕੈਪਸ਼ਨ, "ਅਗਲਾ", ਅਤੇ ਸੁਰੱਖਿਆ ਫਿਲਟਰ) ਦੇਣ ਲਈ ਮਾਡਲਾਂ ਦੀ ਲੋੜ ਸੀ ਜੋ ਵਿ 0ਸ਼ਯ ਅਤੇ ਭਾਸ਼ਾਵਾਂ ਦੀਆਂ ਵਿਸ਼ਾਲ ਰੇਂਜਾਂ 'ਤੇ ਜਨ਼ੇਰਲਾਈਜ਼ ਕਰ ਸਕਣ।

ਸਿਫ਼ਾਰਸ਼ਾਂ ਨੇ ML ਦੀ ਲੋੜ ਹੋਰ ਖੁਲਾਸਾ ਕਰ ਦਿੱਤੀ। ਜਦੋਂ ਲੱਖਾਂ-ਕਰੋੜਾਂ ਯੂਜ਼ਰ ਕਲਿਕ, ਦੇਖਦੇ, ਸਕਿਪ ਕਰਦੇ ਅਤੇ ਵਾਪਸ ਆਉਂਦੇ ਹਨ, ਤਾਂ ਸਿਸਟਮ ਨੂੰ ਲਗਾਤਾਰ ਅਡਜਸਟ ਕਰਨ ਦੀ ਲੋੜ ਹੁੰਦੀ ਹੈ। ਇਹ ਤਰ੍ਹਾਂ ਦਾ ਫੀਡਬੈਕ ਲੂਪ ਕੁੱਲ-ਮੁੜ ਨਿਵੇਸ਼, ਮੈਟ੍ਰਿਕਸ, ਅਤੇ ਟੈਲੈਂਟ ਨੂੰ ਇਨਾਮ ਦਿੰਦਾ ਹੈ ਤਾਂ ਜੋ ਮਾਡਲਾਂ ਬਿਨਾਂ ਭਰੋਸਾ ਖੋਏ ਸੁਧਰਦੇ ਰਹਿਣ।

AI-ਫਰਸਟ ਪਿਵਟ: AI ਨੂੰ ਫੀਚਰ ਨਹੀਂ, ਡਿਫੌਲਟ ਬਣਾਉਣਾ

ਉਤਪਾਦ ਦਰ ਪ੍ਰੋਡਕਸ਼ਨ ਤੱਕ ਪਹੁੰਚਾਓ

ਚੈਟ ਤੋਂ ਡਿਪਲੋਇਮੈਂਟ ਅਤੇ ਹੋਸਟਿੰਗ ਤੱਕ ਜਾਓ ਤਾਂ ਜੋ ਤੁਹਾਡੀ ਟੀਮ ਅਸਲ ਇਸਤੇਮਾਲ ਤੋਂ ਜਲਦੀ ਸਿੱਖ ਸਕੇ।

"AI-ਫਰਸਟ" ਸਭ ਤੋਂ ਆਸਾਨ ਤਰੀਕੇ ਨਾਲ ਇੱਕ ਉਤਪਾਦ ਫੈਸਲੇ ਵਾਂਗ ਸਮਝਿਆ ਜਾ ਸਕਦਾ ਹੈ: AI ਨੂੰ ਪਾਸੇ ਦੀ ਖਾਸ ਚੀਜ਼ ਵਜੋਂ ਨਾ ਲੈ ਕੇ, ਤੁਸੀਂ ਇਸਨੂੰ ਉਹਨਾਂ ਗੇਅਰਾਂ ਦੇ ਅੰਦਰ ਹਿੱਸਾ ਮੰਨਦੇ ਹੋ ਜੋ ਲੋਗ ਪਹਿਲਾਂ ਤੋਂ ਵਰਤਦੇ ਹਨ।

Google ਨੇ ਇਸ ਦਿਸ਼ਾ ਨੂੰ 2016–2017 ਦੇ ਆਸਪਾਸ ਜਨਤਕ ਰੂਪ ਵਿੱਚ ਦਰਸਾਇਆ, ਇਸਨੂੰ "mobile-first" ਤੋਂ "AI-first" ਵੱਲ ਬਦਲਣ ਵਜੋਂ ਪੇਸ਼ ਕੀਤਾ। ਮਕਸਦ ਇਹ ਨਹੀਂ ਸੀ ਕਿ ਹਰ ਫੀਚਰ ਇਕਦਮ "ਸਿਆਣਾ" ਬਣ ਜਾਵੇ, ਬਲਕਿ ਡਿਫੌਲਟ ਤਰੀਕਾ ਇਹ ਹੋਵੇ ਕਿ ਉਤਪਾਦਾਂ ਦਾ ਸੁਧਾਰ ਵੱਧ ਤੋਂ ਵੱਧ ਸਿੱਖਣ ਵਾਲੇ ਸਿਸਟਮਾਂ ਰਾਹੀਂ ਹੋਵੇ—ਰੈਂਕਿੰਗ, ਸਿਫਾਰਸ਼ਾਂ, ਸਪੀਚ ਰਿਕਗਨੀਸ਼ਨ, ਅਨੁਵਾਦ, ਅਤੇ ਸਪੈਮ ਡਿਟੈਕਸ਼ਨ—ਬਜਾਏ ਹੱਥ ਨਾਲ ਟਿਊਨ ਕੀਤੇ ਨਿਯਮਾਂ ਦੇ।

ਕੋਰ ਲੂਪ ਵਿੱਚ AI

ਵਹਵਾਰਕ ਤੌਰ 'ਤੇ, AI-ਫਰਸਟ ਦ੍ਰਿਸ਼ਟਿਕੋਣ ਤਦੋਂ ਦਿੱਸਦਾ ਹੈ ਜਦੋਂ ਕਿਸੇ ਉਤਪਾਦ ਦਾ "ਕੋਰ ਲੂਪ" ਚੁਪਚਾਪ ਬਦਲਦਾ ਹੈ:

- ਸਰਚ ਨਤੀਜੇ ਇਸ ਲਈ ਬਿਹਤਰ ਹੋ ਰਹੇ ਹਨ ਕਿ ਸਿਸਟਮ ਕਵੈਰੀਆਂ ਅਤੇ ਕਲਿਕਸ 'ਚ ਪੈਟਰਨ ਸਿੱਖਦਾ ਹੈ, ਨਾ ਕਿ ਟੀਮ ਹਜ਼ਾਰਾਂ if-then ਨਿਯਮ ਹੱਥ ਨਾਲ ਜੋੜ ਕੇ।

- ਫੋਟੋਆਂ ਆਪਣੇ ਅੰਦਰ ਇਸ ਲਈ ਸੰਗਠਿਤ ਹੁੰਦੀਆਂ ਹਨ ਕਿ ਉਹਨਾਂ 'ਚ ਕੀ ਹੈ, ਨਾ ਕਿ ਸਿਰਫ਼ ਫਾਇਲਨਾਂਅਮ ਅਤੇ ਫੋਲਡਰ।

- Gmail ਹੋਰ ਅਜਿਹੇ ਨਾ-ਚਾਹੇ ਸੁਨੇਹੇ ਨੂੰ ਫੜਦਾ ਹੈ ਕਿਉਂਕਿ ਇਹ ਵਿਕਸਤ ਵਰਤਾਰਿਆਂ ਤੋਂ ਸਿੱਖਦਾ ਹੈ, ਸਿਰਫ਼ ਜਾਣੇ-ਪਹਚਾਣੇ ਕੀਵਰਡ ਨਾਲ ਮੇਚ ਕਰਨ ਦੀ ਥਾਂ।

ਯੂਜ਼ਰ ਨੂੰ ਸ਼ਾਇਦ ਕਦੇ ਵੀ "AI" ਲਿਖਿਆ ਹੋਇਆ ਬਟਨ ਨਾ ਮਿਲੇ। ਉਹ ਸਿਰਫ਼ ਘੱਟ ਗਲਤ ਨਤੀਜੇ, ਘੱਟ ਰੁਕਾਵਟ, ਅਤੇ ਤੇਜ਼ ਉੱਤਰ ਮਹਿਸੂਸ ਕਰਦਾ ਹੈ।

అసਿਸਟੰਟ्स ਨੇ ਕੁਦਰਤੀ ਭਾਸ਼ਾ ਲਈ ਮਾਪਦੰਡ ਉਚਾ ਕੀਤਾ

ਵਾਇਸ ਅਸਿਸਟੈਂਟ ਅਤੇ ਗੱਲਬਾਤ ਵਾਲੇ ਇੰਟਰਫੇਸ ਨੇ ਉਮੀਦਾਂ ਨੂੰ ਬਦਲ ਦਿੱਤਾ। ਜਦੋਂ ਲੋਕ ਕਹਿ ਦੇਂਦੇ ਹਨ, "ਜਦੋਂ ਮੈਂ ਘਰ ਪਹੁੰਚਾਂ ਤਾਂ ਮਾਂ ਨੂੰ ਕਾਲ ਕਰਨ ਦੀ ਯਾਦ ਦਿਵਾਉ", ਉਹ ਉਮੀਦ ਕਰਦੇ ਹਨ ਕਿ ਸੌਫਟਵੇਅਰ ਇਰਾਦਾ, ਸੰਦਰਭ ਅਤੇ ਰੋਜ਼ਾਨਾ ਭਾਸ਼ਾ ਨੂੰ ਸਮਝੇ।

ਇਸ ਨੇ ਉਤਪਾਦਾਂ ਨੂੰ ਹਰੇਕ ਢੰਗ ਨਾਲ ਨੈਚਰਲ ਲੈਂਗਵੇਜ ਸਮਝ ਨੂੰ ਇਕ ਬੇਸਲਾਈਨ ਸਮਰੱਥਾ ਵਜੋਂ ਅਪਣਾਉਣ ਵੱਲ ਢਕਿਆ—ਵਾਇਸ, ਟਾਈਪਿੰਗ, ਅਤੇ ਇੰਝ ਵੀ ਕੈਮਰਾ ਇਨਪੁੱਟ 'ਤੇ (ਫੋਨ ਨੂੰ ਨੁਕਤਾ ਕਰਕੇ ਪੁੱਛਣਾ ਕਿ ਇਹ ਕੀ ਹੈ)। ਇਸ ਪਿਵਟ ਦਾ ਮਤਲਬ ਨਵੀਂ ਯੂਜ਼ਰ ਆਦਤਾਂ ਨੂੰ ਪੂਰਾ ਕਰਨਾ ਹੀ ਨਹੀਂ, ਬਲਕਿ ਰਿਸਰਚ ਮਹਾਂਕਾਂਢੀਆਂ ਨੂੰ ਵੀ ਹਨ।

ਸਭ ਤੋਂ ਜ਼ਰੂਰੀ ਗੱਲ ਇਹ ਹੈ ਕਿ "AI-ਫਰਸਟ" ਨੂੰ ਇੱਕ ਦਿਸ਼ਾ ਵਜੋਂ ਪੜ੍ਹਨਾ ਚਾਹੀਦਾ ਹੈ—ਇੱਕ ਐਲਾਨ ਕਿ AI ਹਰੇਕ ਤਰੀਕੇ ਨਾਲ ਹਰ ਚੀਜ਼ ਨੂੰ ਤੁਰੰਤ ਬਦਲ ਨਹੀਂ ਦਿਤਾ।

Alphabet ਅਤੇ ਲੰਬਾ ਖੇਡ: ਸਰਚ ਤੋਂ ਬਾਹਰ ਦਾਅਵਿਆਂ ਲਈ ਜਗ੍ਹਾ

2015 ਵਿੱਚ Alphabet ਦੀ ਬਣਤਰ ਇੱਕ ਰੀਬ੍ਰੈਂਡ ਨਹੀਂ, ਪਰ ਇੱਕ ਆਪਰੇਸ਼ਨਲ ਫੈਸਲਾ ਸੀ: ਪੱਕਾ ਕੋਰ (Google) ਨੂੰ ਉਚਿਤ ਤਰੀਕੇ ਨਾਲ ਸੁਤੰਤਰਿਤ ਰੱਖਣਾ ਅਤੇ ਜੋਖਿਮ-ਭਰੇ, ਲੰਬੇ ਸਮੇਂ ਦੇ ਪ੍ਰਯਾਸਾਂ (ਆਮ ਤੌਰ 'ਤੇ "Other Bets") ਨੂੰ ਵੱਖ ਕਰਨਾ। ਜੇ ਤੁਸੀਂ Larry Page ਦੀ AI ਦ੍ਰਿਸ਼ਟੀ ਨੂੰ ਇੱਕ ਦੇਕਾਡ-ਲੰਬੇ ਪ੍ਰੋਜੈਕਟ ਵਜੋਂ ਸੋਚ ਰਹੇ ਹੋ ਤਾਂ ਇਹ ਢਾਂਚਾ ਮਾਇਨੇ ਰੱਖਦਾ ਹੈ।

"ਕੋਰ" ਅਤੇ "ਬੇਟਸ" ਨੂੰ ਵੱਖ ਕਰਨ ਦਾ ਕਾਰਨ

Google Search, Ads, YouTube, ਅਤੇ Android ਨੂੰ ਧਿਆਨਪੂਰਵਕ ਚਲਾਉਣ ਦੀ ਲੋੜ ਹੈ: ਭਰੋਸੇਯੋਗਤਾ, ਲਾਗਤ ਕਾਬੂ, ਅਤੇ ਲਗਾਤਾਰ ਇਟਰੈਸ਼ਨ। ਮਹਾਨ-ਮਾਨਕ ਪ੍ਰਾਜੈਕਟ—self-driving cars, life sciences, connectivity—ਨੂੰ ਕੋਈ ਹੋਰ ਤਰੀਕਾ ਚਾਹੀਦਾ: ਅਣਨਿਸ਼ਚਿਤਤਾ ਲਈ ਬਰਦਾਸ਼ਤ, ਮਹਿੰਗੇ ਪ੍ਰਯੋਗਾਂ ਲਈ ਜਗ੍ਹਾ, ਅਤੇ ਗਲਤੀ ਕਰਨ ਦੀ ਆਗਿਆ।

Alphabet ਦੇ ਢਾਂਚੇ ਹੇਠ, ਕੋਰ ਨੂੰ ਸਾਫ਼ ਪ੍ਰਦਰਸ਼ਨ ਉਮੀਦਾਂ ਨਾਲ ਚਲਾਇਆ ਜਾ ਸਕਦਾ ਸੀ, ਜਦਕਿ ਬੇਟਸ ਨੂੰ ਸਿੱਖਣ ਮੀਲ ਪੱਥਰਾਂ 'ਤੇ ਅਨੁਕੂਲ ਤਰੀਕੇ ਨਾਲ ਮਾਪਿਆ ਜਾ ਸਕਦਾ ਸੀ: "ਕੀ ਅਸੀਂ ਇੱਕ ਮੁੱਖ ਤਕਨੀਕੀ ਧਾਰਣਾ ਸਾਬਤ ਕਰ ਲਈ?" "ਕੀ ਮਾਡਲ ਅਸਲ ਡੇਟਾ ਨਾਲ ਕਾਫ਼ੀ ਸੁਧਰਿਆ?" "ਕੀ ਸਮੱਸਿਆ ਸਹੀ ਸੁਰੱਖਿਆ ਪੱਧਰਾਂ 'ਤੇ ਹੱਲਯੋਗ ਹੈ?"

ਮੂਨਸ਼ਾਟ ਤਰਕ: ਪ੍ਰਯੋਗਵਾਦ ਨੂੰ ਰਣਨੀਤੀ ਵਜੋਂ ਲੈਣਾ

ਇਹ "ਲੰਬਾ ਖੇਡ" ਮਨੋਭਾਵ ਇਹ ਨਹੀਂ ਮੰਨਦਾ ਕਿ ਹਰ ਪ੍ਰੋਜੈਕਟ ਕਾਮਯਾਬ ਹੋਏਗਾ। ਇਹ ਮੰਨਤਾ ਰੱਖਦਾ ਹੈ ਕਿ ਲਗਾਤਾਰ ਪ੍ਰਯੋਗ ਹੀ ਇਹ ਦਿਖਾਉਂਦੇ ਹਨ ਕਿ ਬਾਅਦ ਵਿੱਚ ਕੀ ਮਹੱਤਵਪੂਰਨ ਹੋਵੇਗਾ।

X ਵਰਗਾ moonshot ਫੈਕਟਰੀ ਇੱਕ ਚੰਗਾ ਉਦਾਹਰਨ ਹੈ: ਟੀਮਾਂ ਬੋਲਡ ਮੁੱਢਲੇ ਤਜਰਬੇ ਕਰਦੀਆਂ ਹਨ, ਨਤੀਜੇ ਨੂੰ ਇੰਸਟ੍ਰੂਮੈਂਟ ਕਰਦੀਆਂ ਹਨ, ਅਤੇ ਜਦੋਂ ਸਬੂਤ ਕਮਜ਼ੋਰ ਹੋਵੇ ਤਾਂ ਤੇਜ਼ੀ ਨਾਲ ਖ਼ਤਮ ਕਰ ਦਿੰਦੀਆਂ ਹਨ। ਇਹ ਅਨੁਸ਼ਾਸਨ ਖਾਸ ਕਰਕੇ AI ਲਈ ਲਾਗੂ ਹੁੰਦਾ ਹੈ, ਜਿੱਥੇ ਤਰੱਕੀ ਅਕਸਰ iteration ਤੇ ਨਿਰਭਰ ਹੁੰਦੀ—ਚੰਗੇ ਡੇਟਾ, ਵਧੀਆ ਟ੍ਰੇਨਿੰਗ ਸੈਟਅਪ, ਅਤੇ ਸੁਧਰੇ ਮੁਲਾਂਕਣ—ਨਾ ਕਿ ਸਿਰਫ਼ ਇੱਕ ਹੀ ਵੱਡੀ ਝਲਕ।

ਕੀ ਲੈਣਾ (ਬਿਨਾਂ ਗੁਆਛੇ)

Alphabet ਭਵਿੱਖ ਵਿਚ ਜਿੱਤ ਦੀ ਗਾਰੰਟੀ ਨਹੀਂ ਸੀ। ਇਹ ਦੋ ਵੱਖ-ਵੱਖ ਕੰਮ ਕਰਨ ਦੇ ਢੰਗਾਂ ਨੂੰ ਬਚਾਉਣ ਦਾ ਤਰੀਕਾ ਸੀ:

- ਕੋਰ ਬਿਜਨਸ ਨੂੰ ਫੋਕਸ ਅਤੇ ਜਵਾਬਦੇਹ ਰੱਖੋ।

- ਉੱਚ-ਲੈਹਿਰੇ ਵਾਲੇ ਰਿਸਰਚ ਅਤੇ ਉਤਪਾਦ ਦਾਵਿਆਂ ਲਈ ਇੱਕ ਖਾਸ ਘਰ ਬਨਾਓ।

ਟੀਮਾਂ ਲਈ ਪਾਠ ਸੰਰਚਨਾਤਮਕ ਹੈ: ਜੇ ਤੁਸੀਂ ਲੰਬੇ ਸਮੇਂ ਵਾਲੇ AI ਨਤੀਜੇ ਚਾਹੁੰਦੇ ਹੋ, ਤਾਂ ਉਹਨਾਂ ਲਈ ਢਾਂਚਾ ਬਣਾਓ। ਨਜ਼ਦੀਕੀ ਡਿਲਿਵਰੀ ਨੂੰ ਖੋਜੀ ਕੰਮ ਤੋਂ ਵੱਖ ਰੱਖੋ, ਪ੍ਰਯੋਗਾਂ ਨੂੰ ਸਿੱਖਣ ਵਾਲੇ ਯੰਤਰ ਸਮਝ ਕੇ ਫੰਡ ਕਰੋ, ਅਤੇ ਸਿਰਫ਼ ਸਿਰਫ਼ ਸਿਰਫ਼ ਸਿਰਫ਼ ਹੈਡਲਾਈਨਜ਼ ਨਹੀਂ—ਬਲਕਿ ਮਨਜ਼ੂਰਸ਼ੁਦਾ ਅੰਕੜਿਆਂ 'ਤੇ ਅਧਾਰਤ ਪ੍ਰਗਟੀ ਨੂੰ ਮਾਪੋ।

ਮੁਸ਼ਕਲ ਹਿੱਸੇ: ਗੁਣਵੱਤਾ, ਸੁਰੱਖਿਆ, ਅਤੇ ਭਰੋਸਾ ਪੈਮਾਨੇ 'ਤੇ

ਜਦੋਂ ਤਿਆਰ ਹੋਵੋ ਤਾਂ ਸਕੇਲ ਕਰੋ

ਜਦੋਂ ਤੁਹਾਡੇ ਪ੍ਰਯੋਗ ਹੋਰ ਸਮਰੱਥਾ ਮੰਗਦੇ ਹਨ ਤਾਂ free ਤੋਂ pro, business ਜਾਂ enterprise ਤੇ ਜਾਓ।

ਜਦੋਂ AI ਸਿਸਟਮ ਲੱਖਾਂ-ਕਰੋੜਾਂ ਕਵੈਰੀਆਂ ਸੇਵਾ ਕਰਦੇ ਹਨ, ਤਾਂ ਛੋਟੇ ਗਲਤੀ ਦਰ ਰੋਜ਼ਾਨਾ ਸਿਰਲੇਖਾਂ ਵਿੱਚ ਤਬਦੀਲ ਹੋ ਜਾਂਦੇ ਹਨ। ਇੱਕ ਮਾਡਲ ਜੋ "ਅਧਿਕਤਮ ਸਹੀ" ਹੋ ਸਕਦਾ ਹੈ, ਫਿਰ ਵੀ ਲੱਖਾਂ ਨੂੰ ਭਰਮਾ ਸਕਦਾ ਹੈ—ਖਾਸ ਕਰਕੇ ਸਿਹਤ, ਵਿੱਤ, ਚੋਣਾਂ, ਜਾਂ ਤਾਜ਼ਾ ਖ਼ਬਰਾਂ ਉੱਤੇ। Google-ਪੈਮਾਨੇ ਤੇ, ਗੁਣਵੱਤਾ ਇੱਕ ਚੰਗੀ-ਹੁਲ ਨਹੀਂ; ਇਹ ਇੱਕ ਜੋੜੀ ਹੋਈ ਜ਼ਿੰਮੇਵਾਰੀ ਹੈ।

ਮੁੱਖ ਟਰੇਡ-ਆਫ

ਪੱਖਪਾਤ ਅਤੇ ਪ੍ਰਤੀਨਿਧਤਾ। ਮਾਡਲ ਡੇਟਾ ਤੋਂ ਪੈਟਰਨ ਸਿੱਖਦੇ ਹਨ, ਜਿਸ ਵਿੱਚ ਸਮਾਜਕ ਅਤੇ ਇਤਿਹਾਸਕ ਪੱਖਪਾਤ ਵੀ ਸ਼ਾਮਿਲ ਹੁੰਦੀ ਹੈ। "ਨਿਰਪੱਖ" ਰੈਂਕਿੰਗ ਵੀ ਪਹਿਲੂਆਂ ਵਾਲੀਆਂ ਰਾਏਆਂ ਨੂੰ ਬੜਾ ਸਕਦੀ ਹੈ ਜਾਂ ਘੱਟਬੋਲੀ ਭਾਸ਼ਾਵਾਂ ਅਤੇ ਖੇਤਰਾਂ ਨੂੰ ਘੱਟ ਸੇਵਾ ਦੇ ਸਕਦੀ ਹੈ।

ਗਲਤੀਆਂ ਅਤੇ ਜ਼ਿਆਦਾ ਆਤਮ-ਵਿਸ਼ਵਾਸ। AI ਅਕਸਰ ਆਪਣੀਆਂ ਗਲਤੀਆਂ ਐਸੇ ਢੰਗ ਨਾਲ ਵਿਆਖਿਆ ਕਰਦਾ ਹੈ ਜੋ ਭਰੋਸੇਯੋਗ ਲੱਗਦਾ ਹੈ। ਸਭ ਤੋਂ ਨੁਕਸਾਨਦਾਇਕ ਗਲਤੀਆਂ ਸਪੱਸ਼ਟ ਬੱਗ ਨਹੀਂ ਹੁੰਦੀਆਂ; ਉਹ ਹੈ ਪ੍ਰਭਾਵਸ਼ਾਲੀ-ਸੁਣਨ ਵਾਲੇ ਉੱਤਰ ਹੁੰਦੇ ਹਨ ਜਿਨ੍ਹਾਂ 'ਤੇ ਯੂਜ਼ਰ ਭਰੋਸਾ ਕਰ ਲੈਂਦਾ ਹੈ।

ਸੁਰੱਖਿਆ ਬਨਾਮ ਉਪਯੋਗੀਤਾ। ਕਠੋਰ ਫਿਲਟਰ ਨੁਕਸਾਨ ਘਟਾਉਂਦੇ ਹਨ ਪਰ ਕਈ ਵਾਰ ਵੈਧ ਕਵੈਰੀਆਂ ਨੂੰ ਰੋਕੇ ਵੀ ਰੱਖਦੇ ਹਨ। ਕਮਜ਼ੋਰ ਫਿਲਟਰ ਕਵਰੇਜ਼ ਵਧਾਉਂਦੇ ਹਨ ਪਰ ਧੋਖਾਧੜੀ, swa-harm ਜਾਂ ਗਲਤ ਜਾਣਕਾਰੀ ਦੇ ਖਤਰੇ ਵਧਾਉਂਦੇ ਹਨ।

ਜਵਾਬਦੇਹੀ। ਜਿਵੇਂ ਸਿਸਟਮ ਹੋਰ ਆਟੋਮੇਟਿਕ ਹੋ ਰਹੇ ਹਨ, ਉਸਨੇ ਬੁਨਿਆਦੀ ਸਵਾਲਾਂ ਦਾ ਜਵਾਬ ਦੇਣਾ ਔਖਾ ਹੁੰਦਾ: ਕਿਸਨੇ ਇਸ ਵਿਵਹਾਰ ਨੂੰ ਮਨਜ਼ੂਰ ਕੀਤਾ? ਇਹ ਕਿਵੇਂ ਟੈਸਟ ਕੀਤਾ ਗਿਆ? ਯੂਜ਼ਰ ਇਸਨੂੰ ਕਿਵੇਂ ਅਪੀਲ ਜਾਂ ਸਹੀ ਕਰ ਸਕਦੇ ਹਨ?

ਪੈਮਾਨੇ 'ਤੇ_guardrails_ ਦੀ ਲੋੜ ਕਿਉਂ ਵਧਦੀ ਹੈ

ਸਕੇਲ ਕਰਨ ਨਾਲ ਸਮਰੱਥਾ ਵਧਦੀ ਹੈ, ਪਰ ਇਹ ਵੀ:

- ਐਜ ਕੇਸਾਂ ਦੀ ਗਿਣਤੀ ਵਧਾਉਂਦਾ (ਭਾਸ਼ਾਵਾਂ, ਸਭਿਆਚਾਰਾਂ, ਸੰਵੇਦਨਸ਼ੀਲ ਸੰਦਰਭ)

- ਦੁਸ਼ਮਣੀਆਂ ਲਈ ਪ੍ਰੇਰਣਾ ਵਧਾਉਂਦਾ (ਸਪੈਮ, prompt injection, ਵਿਪਰੀਤ SEO)

- ਵਾਰ-ਵਾਰ ਇੰਟੈਗਰੇਟ ਹੋ ਚੁੱਕੇ ਸਿਸਟਮਾਂ ਵਿੱਚ ਫੇਲ੍ਹ ਬੰਦ ਕਰਨਾ ਔਖਾ ਹੋ ਜਾਂਦਾ ਹੈ

ਇਸ ਲਈ guardrails ਨੂੰ ਵੀ ਪੈਮਾਨੇ 'ਤੇ ਚਲਾਉਣਾ ਪੈਂਦਾ ਹੈ: ਮੁਲਾਂਕਣ ਸੂਟ, red-teaming, ਨੀਤੀ ਲਾਗੂ ਕਰਨਾ, ਸਰੋਤਾਂ ਦੀ ਪ੍ਰਮਾਣਿਕਤਾ, ਅਤੇ ਯੂਜ਼ਰ ਇੰਟਰਫੇਸ ਜੋ ਅਣਨਿਸ਼ਚਿਤਤਾ ਨੂੰ ਦਰਸਾਉਂਦੇ ਹਨ।

AI ਦਾਵਿਆਂ ਨੂੰ ਮੁਲਾਂਕਣ ਕਰਨ ਲਈ ਇੱਕ ਪ੍ਰਯੋਗਕਾਰੀ ਚੈੱਕਲਿਸਟ

ਕਿਸੇ ਵੀ "AI-ਚਲਿਤ" ਵਿਸ਼ੇਸ਼ਤਾ—ਚਾਹੇ ਉਹ Google ਤੋਂ ਹੋਵੇ ਜਾਂ ਕਿਸੇ ਹੋਰ ਤੋਂ—ਨੂੰ ਅੰਕੜਿਆਂ ਨਾਲ ਇਨਕਾਰ ਕਰਨ ਲਈ ਇਸਦੀ ਵਰਤੋਂ ਕਰੋ:

- ਫੈਲ੍ਹ ਹੋਣ ਵਾਲਾ ਢੰਗ ਕੀ ਹੈ? ਕੀ ਉਹ ਦਿਖਾਉਂਦੇ ਹਨ ਕਿ ਇਹ ਕਿੱਥੇ ਟੁਟਦਾ ਹੈ, ਸਿਰਫ ਡੈਮੋਜ਼ ਨਹੀਂ?

- ਇਹ ਕਿਵੇਂ ਮਾਪਿਆ ਜਾਂਦਾ ਹੈ? ਅਸਲੀ ਮੈਟ੍ਰਿਕਸ (accuracy, toxicity ਦਰ, hallucination ਰੇਟ) ਵੇਖੋ, ਧੁੰਦਲੇ "ਸੁਧਾਰ" ਨਹੀਂ।

- ਇਸਨੂੰ ਕਿੱਨ੍ਹੇ ਡੇਟਾ 'ਤੇ ਟ੍ਰੇਨ ਕੀਤਾ ਗਿਆ? ਘੱਟੋ-ਘੱਟ: ਵੱਡੇ ਸ਼੍ਰੇਣੀਆਂ, ਤਾਜ਼ਗੀ, ਅਤੇ ਬਾਹਰ ਰੱਖਣ ਨੀਤੀਆਂ।

- guardrails ਕੀ ਹਨ? ਸੁਰੱਖਿਆ ਨਿਯਮ, ਮਨੁੱਖੀ ਸਮੀਖਿਆ ਮਾਰਗ, ਅਤੇ ਦੁਰੁਪਯੋਗ ਨਿਗਰਾਨੀ।

- ਯੂਜ਼ਰ ਪੁਸ਼ਟੀ ਕਰ ਸਕਦੇ ਹਨ? ਹਵਾਲੇ, ਸਰੋਤ, ਜਾਂ ਵਿਆਖਿਆਵਾਂ ਜੋ ਤੁਹਾਨੂੰ ਦਾਅਵੇ ਦੀ ਜਾਂਚ ਕਰਨ ਦਿੰਦੀਆਂ ਹਨ।

- ਸੁਧਾਰ ਕਿਵੇਂ ਹੋਂਦੇ ਹਨ? ਸਪਸ਼ਟ ਰਿਪੋਰਟਿੰਗ, ਤੇਜ਼ ਅਪਡੇਟ, ਅਤੇ ਆਡੀਟਯੋਗਤਾ।

ਭਰੋਸਾ ਦੁਹਰਾਏ ਜਾਣ ਯੋਗ ਪ੍ਰਕਿਰਿਆਵਾਂ ਰਾਹੀਂ ਹੀ ਕਮਾਇਆ ਜਾਂਦਾ ਹੈ—ਨਾ ਕਿ ਇੱਕ ਹੀ ਵੱਡੇ ਮਾਡਲ ਤੋਂ।

ਟੀਮਾਂ ਲਈ ਸਬਕ: AI ਬਾਰੇ ਲੰਬੀ ਮਿਆਦ ਵਿਚਾਰ ਕਿਵੇਂ ਕਰਨਾ

Google ਦੇ ਲੰਬੇ ਕੁਰਕਸ਼ ਦੇ ਪਿੱਛੇ ਸਭ ਤੋਂ ਅਧਿਕ ਪ੍ਰਸਾਰਯੋਗ ਪੈਟਰਨ ਸਧਾਰਨ ਹੈ: ਸਪਸ਼ਟ ਨਿਸ਼ਾਨਾ → ਡੇਟਾ → ਇਨਫਰਾਸਟ੍ਰੱਕਚਰ → ਇਟਰੈਸ਼ਨ। ਤੁਹਾਨੂੰ Google ਦਾ ਪੈਮਾਨਾ ਲੋੜੀਦਾ ਨਹੀਂ ਕਿ ਤੁਸੀਂ ਇਸ ਲੂਪ ਨੂੰ ਵਰਤੋ—ਤੁਹਾਨੂੰ ਜੋ ਚਾਹੀਦਾ ਹੈ ਉਹ ਹੈ ਵਿਸ਼ੇ 'ਤੇ ਅਨੁਸ਼ਾਸਨ ਅਤੇ ਅਸਲ ਵਰਤੋਂ ਤੋਂ ਸਿੱਖਣ ਦਾ ਇੱਕ ਤਰੀਕਾ ਜੋ ਆਪਣੇ ਆਪ ਨੂੰ ਧੋਖਾ ਨਾ ਦੇਵੇ।

ਤੱਕੜਾ ਪੈਟਰਨ ਜੋ ਤੁਸੀਂ ਨਕਲ ਕਰ ਸਕਦੇ ਹੋ

ਇੱਕ ਮਾਪਯੋਗ ਯੂਜ਼ਰ ਵਾਅਦੇ (ਤੇਜ਼ੀ, ਘੱਟ ਗਲਤੀਆਂ, ਬਿਹਤਰ ਮੇਚ) ਨਾਲ ਸ਼ੁਰੂ ਕਰੋ। ਇਸਨੂੰ ਇੰਸਟ੍ਰੂਮੈਂਟ ਕਰੋ ਤਾਂ ਜੋ ਤੁਸੀਂ ਨਤੀਜੇ ਦੇਖ ਸਕੋ। ਉਹ ਘੱਟੋ-ਘੱਟ "ਮਸ਼ੀਨ" ਬਣਾਓ ਜੋ ਤੁਹਾਨੂੰ ਡੇਟਾ ਇਕੱਤਰ, ਲੇਬਲ, ਅਤੇ ਸੁਰੱਖਿਅਤ ਤਰੀਕੇ ਨਾਲ ਸੁਧਾਰ ਭੇਜਣ ਦੇ ਯੋਗ ਬਣਾਏ। ਫਿਰ ਛੋਟੇ, ਤੇਜ਼ ਕਦਮਾਂ ਵਿੱਚ ਇਟਰੈਟ ਕਰੋ—ਹਰ ਰਿਲੀਜ਼ ਨੂੰ ਸਿੱਖਣ ਦਾ ਮੌਕਾ ਮੰਨੋ।

ਜੇ ਤੁਹਾਡੀ ਰੁਕਾਵਟ ਸਿਰਫ਼ "ਵਿਚਾਰ" ਤੋਂ "ਇੰਸਟ੍ਰੂਮੈਂਟਡ ਉਤਪਾਦ" ਤੱਕ ਜਲਦੀ ਪਹੁੰਚ ਕਰਨ ਦੀ ਹੈ, ਤਾਂ ਆਧੁਨਿਕ ਬਣਾਉਣ ਵਾਲੀਆਂ ਵਰਕਫਲੋਜ਼ ਮਦਦ ਕਰ ਸਕਦੀਆਂ ਹਨ। ਉਦਾਹਰਣ ਲਈ, Koder.ai ਇੱਕ vibe-coding ਪਲੇਟਫਾਰਮ ਹੈ ਜਿੱਥੇ ਟੀਮਾਂ ਚੈਟ ਇੰਟਰਫ਼ੇਸ ਤੋਂ ਵੈਬ, ਬੈਕਐਂਡ ਜਾਂ ਮੋਬਾਈਲ ਐਪ ਬਣਾਉ ਸਕਦੀਆਂ—ਇਮਕਾਨੀ ਤੌਰ 'ਤੇ ਇੱਕ MVP ਸਪੀਨ-ਅਪ ਕਰਨ ਲਈ ਜੋ ਫੀਡਬੈਕ ਲੂਪ (ਥੰਬਜ਼ ਅਪ/ਡਾਊਨ, ਸਮੱਸਿਆ ਰਿਪੋਰਟ, ਛੋਟੇ ਸਰਵੇ) ਸ਼ੁਰੂ ਕਰਦਾ ਹੈ ਬਿਨਾਂ ਪੂਰਾ ਖਾਸ-ਕਸਟਮ ਪਾਈਪਲਾਈਨ ਦੀ ਉਡੀਕ ਕੀਤੇ। planning mode, snapshots/rollback ਵਰਗੀਆਂ ਖਾਸੀਅਤਾਂ ਵੀ "ਸੁਰੱਖਿਅਤ ਤਰੀਕੇ ਨਾਲ ਪ੍ਰਯੋਗ ਕਰੋ, ਮਾਪੋ, ਇਟਰੈਟ ਕਰੋ" ਦੇ ਨਿਯਮ ਨਾਲ ਵਧੀਆ ਮੇਲ ਖਾਂਦੀਆਂ ਹਨ।

ਲੀਡਰਾਂ ਲਈ 6 ਸਿੱਧੀਆਂ ਗੱਲਾਂ (Google ਹੋਣ ਬਿਨਾਂ ਲਾਗੂ ਕਰਨ ਯੋਗ)

- ਇੱਕ ਉੱਤਮ ਨਾਰਥ ਸਟਾਰ ਚੁਣੋ ਜੋ ਯੂਜ਼ਰ-ਸਾਮ੍ਹਣੇ ਹੋਵੇ। "ਸਰਚ ਅਨੁਭਵ ਸੁਧਾਰੋ" ਜਿਹੜਾ ਕਿ "AI ਅਪਣਾਉ" ਨਾਲੋਂ ਜ਼ਿਆਦਾ ਸਪਸ਼ਟ ਹੈ।

- ਆਪਣੇ ਉਤਪਾਦ ਨੂੰ ਸਿੱਖਣ ਵਾਲਾ ਡੇਟਾ ਪੈਦਾ ਕਰਨ ਲਈ ਡਿਜ਼ਾਈਨ ਕਰੋ। ਫੀਡਬੈਕ ਲੂਪ ਸ਼ਾਮਿਲ ਕਰੋ (ਥੰਬਜ਼, ਸੁਧਾਰ, "ਕੀ ਇਹ ਮਦਦਗਾਰ ਸੀ?") ਜੋ ਕੇਵਲ ਕਲਿਕ ਤੋਂ ਨਹੀਂ ਬਲਕਿ ਇਰਾਦਾ ਕੈਪਚਰ ਕਰਨ।

- ਮਾਡਲਾਂ ਵੱਲ ਨਾ ਕੇਵਲ ਇਨਵੈਸਟ ਕਰੋ—ਪਲੰਬਿੰਗ ਵਿੱਚ ਵੀ ਨਿਵੇਸ਼ ਕਰੋ। ਡੇਟਾ ਕੁਆਲਟੀ ਚੈਕ, ਇਵੈਲੂਏਸ਼ਨ ਡੈਸ਼ਬੋਰਡ, ਅਤੇ ਡਿਪਲੌਇਮੈਂਟ ਵਰਕਫਲੋਜ਼ ਇੱਕ-ਵਾਰਗੇ ਪ੍ਰੋਟੋਟਾਈਪ ਨਾਲੋਂ ਜ਼ਿਆਦਾ ਫਾਇਦੇਦੇਹ ਹਨ।

- ਮੁਲਾਂਕਣ ਨੂੰ ਇੱਕ ਉਤਪਾਦ ਖਾਸੀਅਤ ਸਮਝੋ। ਇੱਕ ਦੁਹਰਾਏ ਜਾਣ ਯੋਗ ਸਕੋਰਕਾਰਡ ਬਣਾਓ (ਗੁਣਵੱਤਾ, ਲੈਟੈਂਸੀ, ਲਾਗਤ, ਸੁਰੱਖਿਆ) ਤਾਂ ਜੋ ਇਟਰੈਸ਼ਨ ਅਟਕਣਾ ਨਾ ਬਣ ਜਾਵੇ।

- ਟੁਕੜਿਆਂ ਵਿੱਚ ਭੇਜੋ। ਸਿੱਧੇ ਕੇਸ ਨਾਲ ਸ਼ੁਰੂ ਕਰੋ, ਛੋਟੀ ਆਡੀਅੰਸ 'ਤੇ ਰੋਲਆਉਟ ਕਰੋ, ਮਾਪੋ, ਫਿਰ ਫੈਲਾਓ। ਗਤੀ ਮਹਾਨ ਹੈ—ਵੱਡਾ ਬੈਂਗ ਲਾਂਚ ਨਹੀਂ।

- ਲੰਬੇ ਦਾਅਵਿਆਂ ਨੂੰ ਜੀਵੰਤ ਰੱਖੋ। ਪ੍ਰਯੋਗਾਂ ਲਈ ਛੋਟੀ ਜੀਹੀ ਸਮਰੱਥਾ ਸੰਰਖਿਅਤ ਰੱਖੋ, ਪਰ ਉਹਨਾਂ ਨੂੰ ਸਾਫ਼ ਸਿੱਖਣ ਮੀਲ-ਪਥਰ ਨਾਲ ਜੋੜੋ ਤਾਂ ਕਿ ਉਹ ਇਮਾਨਦਾਰ ਰਹਿਣ।

ਸੰਬੰਧਤ ਪঢ়ਾਈ

ਜੇ ਤੁਸੀਂ ਪ੍ਰਾਇਕਟਿਕ ਅੱਗੇ ਦੇ ਕਦਮ ਚਾਹੁੰਦੇ ਹੋ, ਤਾਂ ਇਹਨਾਂ ਨੂੰ ਆਪਣੀ ਟੀਮ ਦੀ ਰੀਡਿੰਗ ਲਿਸਟ ਨਾਲ ਜੋੜੋ:

- /blog/ai-strategy-basics

- /blog/data-flywheels-for-product-teams

- /blog/evaluating-ml-models-without-a-phd

- /blog/ai-governance-lightweight