Co naprawdę oznacza „tanie i szybkie eksperymentowanie”

„Eksperymentowanie z pomysłami” to przeprowadzenie małego, niskozobowiązującego testu przed poważnym zaangażowaniem zasobów. Zamiast debatować, czy koncept jest dobry, robisz szybkie sprawdzenie, żeby dowiedzieć się, co ludzie faktycznie robią: klikają, zapisują się, odpowiadają albo ignorują.

Eksperymentowanie z pomysłami, prostym językiem

Eksperyment z pomysłem to miniwersja prawdziwej rzeczy — tyle, by odpowiedzieć na jedno pytanie.

Na przykład:

- Jeśli nie jesteś pewien komunikatu, przetestuj dwa nagłówki i zobacz, który zbiera więcej zapisów.

- Jeśli nie wiesz, jakie funkcje są potrzebne, pokaż prosty demo i zapytaj użytkowników, czego się spodziewali.

- Jeśli nie wiesz, czy ktoś tego chce, uruchom stronę „już wkrótce” i zmierz zainteresowanie.

Celem nie jest budowa; celem jest zmniejszenie niepewności.

Dlaczego eksperymenty kiedyś były drogie

Tradycyjnie nawet małe testy wymagały koordynacji wielu ról i narzędzi:

- Czas: pisanie tekstów, projektowanie ekranów, budowanie stron, konfiguracja analityki, umawianie wywiadów.

- Ludzie: marketerzy, projektanci, inżynierowie i badacze.

- Koszty pośrednie: narzędzia do stron lądowania, ankiety, wydatki na reklamy, oprogramowanie prototypowe, plus poprawki i uzgodnienia.

Ten koszt wypycha zespoły do „dużych zakładów”: buduj najpierw, ucz się później.

Jak wygląda „tanie i szybkie” z AI

AI zmniejsza wysiłek potrzebny do przygotowania materiałów testowych — szkiców, wariantów, skryptów, podsumowań — dzięki czemu możesz przeprowadzać więcej eksperymentów z mniejszymi przeszkodami.

- Tanie często oznacza walidację założenia bez angażowania wielu ról na kilka dni.

- Szybkie oznacza przejście od pytania → materiał testowy → pierwszy sygnał w godzinach, a nie tygodniach.

Ustal oczekiwania: szybsze uczenie, nie gwarantowane sukcesy

AI nie sprawia automatycznie, że pomysły są dobre i nie zastąpi rzeczywistego zachowania użytkowników. Co potrafi dobrze, to:

- szybko generować opcje (komunikaty, przepływy, pytania)

- ulepszać projekt eksperymentu (jasna hipoteza, jasna metryka sukcesu)

- szybciej analizować feedback (motywy, obiekcje, punkty niejasne)

Wciąż musisz wybrać właściwe pytanie, zebrać uczciwe sygnały i podejmować decyzje na podstawie dowodów — nie wyglądu eksperymentu.

Dlaczego tradycyjne testy pomysłów są wolne i kosztowne

Tradycyjne testowanie rzadko zawodzi, bo zespoły są niezaangażowane. Zawodzi, bo „prosty test” to w rzeczywistości łańcuch prac rozłożonych między różne role — każda z realnymi kosztami i czasem w kalendarzu.

Rzeczywista lista kosztów (nawet przy małym eksperymencie)

Podstawowy sprint walidacyjny zwykle obejmuje:

- Badania: konkurencja, cytaty klientów, hipotezy, rekrutacja.

- Pisanie: teksty na stronę, propozycje wartości, outreach, skrypty wywiadów, pytania do ankiet.

- Projekt: wireframe’y, kreacje, układy, prototypy.

- Kodowanie: strona testowa, zdarzenia analityczne, flagi eksperymentów, formularze.

- Analiza: czyszczenie wyników, synteza notatek, uzgodnienie, co oznacza „sukces”.

Nawet jeśli każda część jest „lekka”, sumaryczny wysiłek rośnie — zwłaszcza przy cyklach poprawek.

Opóźnienia mnożą koszty bardziej niż praca

Największym ukrytym wydatkiem jest czekanie:

- oczekiwanie na przekazania między produktem, projektem, inżynierią, marketingiem i prawem

- oczekiwanie na spotkania w celu uzgodnienia, co testować

- oczekiwanie na przeglądy, zatwierdzenia i kolejne poprawki

Te opóźnienia rozciągają 2-dniowy test do cyklu 2–3 tygodni. Gdy feedback pojawia się późno, zespoły często zaczynają od nowa, bo założenia zdążyły się zmienić.

Koszt utraconych okazji: dłuższe zgadywanie

Kiedy testowanie jest wolne, zespoły rekompensują to debatami i podejmowaniem zobowiązań na podstawie niepełnych dowodów. Budujesz, komunikujesz lub sprzedajesz wokół nieprzetestowanego pomysłu dłużej niż powinieneś — utrwalając decyzje, które są trudniejsze (i droższe) do odwrócenia.

Tradycyjne testy nie są „za drogie” samo w sobie; są drogie, bo spowalniają uczenie.

Jak AI zmienia ekonomię próbowania pomysłów

AI nie tylko przyspiesza zespoły. Zmienia koszt eksperymentowania — zwłaszcza koszt stworzenia wiarygodnej pierwszej wersji czegoś.

Kluczowa zmiana: pierwsze wersje są tanie

Tradycyjnie drogi element walidacji to dopracowanie czegokolwiek na tyle, by można było to przetestować: strona lądowania, e-mail sprzedażowy, skrypt demo, klikalny prototyp, ankieta czy jasne pozycjonowanie.

Narzędzia AI znacząco skracają czas (i wysiłek specjalistów) potrzebny do stworzenia tych wczesnych artefaktów. Kiedy koszt przygotowania spada, możesz sobie pozwolić na:

- przetestowanie więcej pomysłów przed zaangażowaniem się

- eksplorację większej liczby wariantów (odbiorcy, ceny, komunikaty)

- wcześniejsze włączanie interesariuszy (bo jest coś konkretnego do ocenienia)

Efekt to więcej „strzałów na bramkę” bez zatrudniania większego zespołu lub czekania tygodniami.

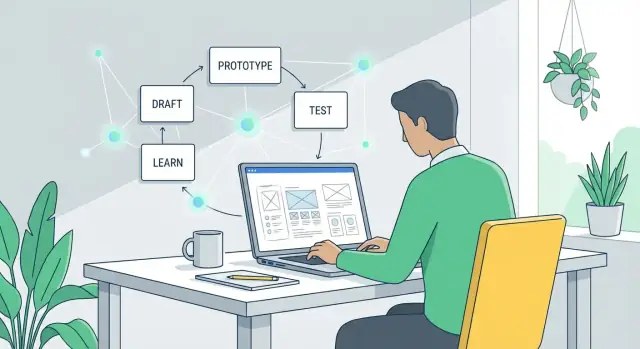

Skompresowane cykle: szkic → feedback → poprawa

AI skraca pętlę między myśleniem a uczeniem:

- Szkic: wygeneruj wiele opcji (copy, przepływy, opisy funkcji, FAQ, propozycje wartości).

- Feedback: podziel się z użytkownikami/prospektami/współpracownikami albo przeprowadź ustrukturyzowaną krytykę z checklistą.

- Poprawa: od razu iteruj, gdy obiekcje i pytania są świeże.

Gdy ta pętla działa w godzinach zamiast tygodni, zespoły spędzają mniej czasu na obronie półgotowych rozwiązań, a więcej na reagowaniu na dowody.

Szybkość ≠ lepsze decyzje

Szybkie generowanie może dawać fałszywe poczucie postępu. AI ułatwia produkcję wiarygodnych materiałów, ale wiarygodność nie zastępuje walidacji.

Jakość decyzji nadal zależy od:

- zadawania właściwych pytań (jakie ryzyko redukujesz?)

- testowania z odpowiednimi ludźmi

- mierzenia sygnałów przewidujących rezultaty (nie tylko „ładne” opinie)

Użyte dobrze, AI obniża koszt uczenia. Użyte lekkomyślnie, jedynie obniża koszt generowania większej liczby zgadnięć szybciej.

Szybkie szkice treści: testuj komunikaty w minutach

Przy walidacji pomysłu nie potrzebujesz idealnego copy — potrzebujesz wiarygodnych opcji, które możesz szybko pokazać ludziom. Generatywne AI świetnie nadaje się do produkcji pierwszych szkiców, które wystarczają do testu, a potem do dopracowania na podstawie nauki.

Co szybko szkicować (i dlaczego to ważne)

Możesz w kilka minut stworzyć materiały, które normalnie zajmają dni:

- Nagłówki i podtytuły dla różnych propozycji wartości

- Tekst strony lądowania (hero, korzyści, obiekcje, wezwanie do działania)

- Sekwencje e-maili (powitanie, follow-up, przypomnienie)

- FAQ które odpowiada na obiekcje i zmniejsza tarcie

Celem jest szybkość: uruchomić kilka wiarygodnych wersji i pozwolić rzeczywistemu zachowaniu (kliknięcia, odpowiedzi, zapisy) powiedzieć, co trafia.

Generuj różne kąty bez zaczynania od zera

Poproś AI o różne podejścia do tej samej oferty:

- Skoncentrowane na korzyści: „Osiągnij X bez Y.”

- Skoncentrowane na problemie: „Wciąż zmagasz się z X? Oto prostsze rozwiązanie.”

- Narracyjne: krótka historia pokazująca przed/po.

Ponieważ każdy kąt łatwo wygenerować, możesz testować szeroki zakres komunikatów wcześnie — zanim zainwestujesz w projekt, produkt czy długie cykle copywritingu.

Dostosuj ton do różnych odbiorców

Możesz dopasować ten sam pomysł do różnych czytelników (founderzy vs. zespoły operacyjne), określając ton i kontekst: „pewny i zwięzły”, „przyjazny i prosty” albo „formalny i zgodny z przepisami”. To pozwala na targetowane eksperymenty bez przepisywania od zera.

Wskazówka: trzymaj jedno „źródło prawdy”

Szybkość może powodować niespójność. Utrzymuj krótki dokument z głównym przekazem (1–2 akapity): do kogo, główna obietnica, kluczowe dowody i wyłączenia. Używaj go jako wejścia do każdego AI-szkicu, żeby warianty były spójne — testujesz kąty, nie sprzeczne twierdzenia.

Prototypy bez ciężkiej pracy projektowej

Nie potrzebujesz pełnego sprintu projektowego, żeby sprawdzić, czy pomysł „klika”. Z AI możesz stworzyć wiarygodny prototyp, który wystarczy do uzyskania reakcji — bez tygodni makiet, pętli przeglądów interesariuszy i debat o pixel-perfect.

Zacznij od zestawu prototypowego, nie od pustej kartki

Daj AI krótki brief produktu i poproś o elementy budulcowe:

- Listę funkcji (konieczne vs. dodatkowe)

- Prosty przepływ użytkownika (co się dzieje najpierw, potem, na końcu)

- Sugerowane ekrany (home, onboarding, ustawienia, checkout itp.)

- Teksty UI dla przycisków, podpowiedzi, stanów pustych i komunikatów o błędach

Z tego przepływu stwórz szybkie wireframe’y w prostych narzędziach (Figma, Framer lub nawet slajdy). Wygenerowane przez AI teksty sprawiają, że ekrany wydają się realne, co skutkuje bardziej konkretnym feedbackiem niż „wygląda dobrze”.

Stwórz klikalny prototyp w kilka godzin

Gdy masz ekrany, połącz je w klikalne demo i przetestuj kluczową akcję: zapis, wyszukiwanie, rezerwację, płatność lub udostępnienie.

AI może też wygenerować realistyczne treści zastępcze — przykładowe oferty, wiadomości, opisy produktów — żeby testerzy nie byli zdezorientowani przez „Lorem ipsum”.

Twórz warianty dla różnych użytkowników

Zamiast jednego prototypu, przygotuj 2–3 wersje:

- Nowi użytkownicy: więcej wskazówek, mniej wyborów, jaśniejsze etykiety

- Zaawansowani użytkownicy: skróty, operacje masowe, zaawansowane filtry

To pomaga zweryfikować, czy pomysł potrzebuje różnych ścieżek, a nie tylko innego języka.

Szybkie kontrole dostępności i jasności

AI może przeskanować tekst UI pod kątem żargonu, niespójnych etykiet, brakujących wskazówek w stanach pustych i zbyt długich zdań. Może też wskazać typowe problemy z dostępnością do przejrzenia (kontrast, niejasne linki, niejasne komunikaty o błędach), żebyś wyeliminował łatwe przeszkody przed pokazaniem czegokolwiek użytkownikom.

Szybkie MVP: od koncepcji do dema w mig

Włącz innych do procesu

Zaproś współpracowników lub znajomych do Koder.ai i współpracuj nad szybszymi testami pomysłów.

Szybkie MVP to nie pomniejszona wersja finalnego produktu — to demo potwierdzające (lub obalające) kluczowe założenie. Z AI możesz dotrzeć do takiego dema w dniach (a czasem godzinach), pomijając „idealne” i skupiając się na jednej funkcji: pokazaniu wartości na tyle jasno, by ktoś mógł zareagować.

Co AI przyspiesza

AI jest przydatne, gdy MVP potrzebuje tylko wystarczającej struktury, by wydawać się realnym:

- Proste skrypty i pseudo-kod do zamiany koncepcji w klikalny lub działający przepływ.

- Przykłady API do udawania „integracji” (nawet jeśli prawdziwy backend jeszcze nie istnieje).

- Szkielet małych narzędzi jak kalkulatory, estymatory, kreatory onboardingu, wewnętrzne dashboardy czy lekkie rozszerzenia Chrome.

Na przykład, jeśli pomysł to „sprawdzarka uprawnień do zwrotu pieniędzy”, MVP może być jedną stroną z kilkoma pytaniami i wygenerowanym wynikiem — bez kont, fakturowania czy obsługi skrajnych przypadków.

answers = collect_form_inputs()

score = rules_engine(answers)

result = generate_explanation(score, answers)

return result

Jeśli chcesz pójść dalej niż klikalny mock i pokazać coś, co przypomina prawdziwą aplikację, platforma vibe-coding taka jak Koder.ai może być praktycznym skrótem: opisujesz przepływ w czacie, generujesz działającą aplikację webową (często React na frontendzie z Go + PostgreSQL na backendzie) i szybko iterujesz — z opcją eksportu kodu źródłowego, jeśli eksperyment przejdzie dalej.

Trzymaj zakres bezpieczny: jakość prototypu vs jakość produkcyjna

AI może generować działający kod szybko, ale ta szybkość może zacierać granicę między prototypem a czymś, co kusi do wypuszczenia. Ustal oczekiwania:

- Jakość prototypu: udowadnia pożądanie, użyteczność i podstawową wykonalność.

- Jakość produkcyjna: obsługuje skalę, bezpieczeństwo, monitoring, skrajne przypadki, zgodność i długoterminowe utrzymanie.

Dobra zasada: jeśli demo służy głównie nauce, można ciąć rogi — pod warunkiem, że nie stwarzają one ryzyka.

Nie pomijaj przeglądu: bezpieczeństwo, prywatność, niezawodność

Nawet dema MVP potrzebują szybkiego sanity checku. Zanim pokażesz je użytkownikom lub podłączysz prawdziwe dane:

- Bezpieczeństwo: brak wystawionych kluczy, niebezpiecznych zależności ani otwartych paneli administracyjnych.

- Prywatność: unikaj danych osobowych, jeśli to możliwe; anonimizuj i ograniczaj.

- Niezawodność: obsłuż oczywiste błędy (puste dane, timeouty API), żeby test mierzył pomysł, a nie zepsute demo.

Zrobione dobrze, AI zamienia „koncepcję w demo” w powtarzalny nawyk: buduj, pokazuj, ucz się, iteruj — bez nadmiernych inwestycji na wczesnym etapie.

Tańsze badania użytkowników dzięki lepszym przygotowaniom

Badania użytkowników są drogie, gdy działasz „na czuja”: niejasne cele, słaba rekrutacja i chaotyczne notatki, które zajmują godziny, by je zinterpretować. AI może obniżyć koszty, pomagając dobrze przygotować się — zanim w ogóle zaplanujesz rozmowę.

Przygotuj solidne materiały jednym posiedzeniem

Zacznij od poproszenia AI o szkic przewodnika do wywiadów, a potem dopracuj go pod konkretny cel (jaką decyzję mają podjąć te badania?). Możesz także wygenerować:

- Pytania przesiewowe, by znaleźć właściwych uczestników (i wykluczyć niewłaściwych)

- Wiadomości outreach do e-maili, LinkedIn lub wewnętrznych powiadomień

- Krótki brief badawczy, który udostępnisz zespołowi, żeby wszyscy wiedzieli, co testujecie

To skraca przygotowania z dni do godziny, co sprawia, że małe, częste badania są bardziej realistyczne.

Spójniejsze notatki i szybsza synteza

Po wywiadach wklej notatki (lub transkrypt) do narzędzia AI i poproś o ustrukturyzowane podsumowanie: kluczowe bóle, obecne alternatywy, momenty zachwytu i bezpośrednie cytaty.

Możesz też poprosić o oznaczanie feedbacku według tematów, aby każde spotkanie było przetworzone w ten sam sposób — niezależnie od tego, kto prowadził rozmowę.

Następnie poproś o zaproponowanie hipotez na podstawie usłyszanych treści, wyraźnie oznaczonych jako hipotezy (nie fakty). Przykład: „Hipoteza: użytkownicy rezygnują, bo onboarding nie pokazuje wartości w pierwszej sesji.”

Zachowaj uczciwość badań (unikaj pytania sugerującego)

Poproś AI o przegląd pytań pod kątem stronniczości. Zamień pytania typu „Czy korzystałbyś z tego szybszego przepływu?” na neutralne „Jak robisz to dziś?” i „Co sprawiłoby, że byś zmienił?”.

Jeśli chcesz szybką listę kontrolną do tego kroku, umieść ją w firmowym wiki (np. /blog/user-interview-questions).

Szybkie eksperymenty: ankiety, testy A/B i smoke testy

Prototypuj bez narzutu

Uruchom wiarygodny interfejs i przepływ bez tygodni prac projektowych i przekazywania zadań.

Szybkie eksperymenty pomagają poznać kierunek decyzji bez pełnego budowania. AI pomaga je szybciej uruchamiać — szczególnie gdy potrzebujesz wielu wariantów i spójnych materiałów.

Ankiety: szybki feedback, lepsze pytania

AI świetnie nadaje się do szkicowania ankiet, ale prawdziwa wartość to poprawa jakości pytań. Poproś je o neutralne sformułowania (bez podpowiadania), jasne opcje odpowiedzi i logiczny przepływ.

Prosty prompt typu „Przeredaguj te pytania, by były bezstronne i dodaj opcje odpowiedzi, które nie zniekształcą wyników” może usunąć niezamierzoną perswazję.

Zanim wyślesz cokolwiek, zdefiniuj, co zrobisz z wynikami: „Jeśli mniej niż 20% wybierze opcję A, nie będziemy kontynuować tego pozycjonowania.”

Testy A/B: generuj warianty bez tracenia czasu

Do testów A/B AI może szybko wygenerować wiele wariantów — nagłówki, sekcje hero, tematy e-maili, teksty na stronach cenowych i wezwania do działania.

Bądź zdyscyplinowany: zmieniaj jedynie jeden element naraz, aby wiedzieć, co było przyczyną różnicy.

Zaplanuj metryki sukcesu z góry: CTR, zapisy, prośby o demo lub konwersje „strona cen → checkout”. Powiąż metrykę z decyzją, którą musisz podjąć.

Smoke testy: zweryfikuj popyt zanim zbudujesz

Smoke test to lekki eksperyment „udawaj, że istnieje”: strona lądowania, przycisk zakupu lub formularz na listę oczekujących. AI może napisać treść strony, FAQ i alternatywne propozycje wartości, abyś mógł sprawdzić, co rezonuje.

Zabezpieczenia przed fałszywą pewnością

Małe próbki mogą zwodzić. AI może pomóc interpretować wyniki, ale nie naprawi słabych danych. Traktuj wczesne rezultaty jako sygnały, nie dowód, i uważaj na:

- Bardzo małe próbki (łatwo przesadzić z wnioskami)

- Stronnicze źródła ruchu (znajomi, zespoły wewnętrzne)

- Metryki, które nie odzwierciedlają rzeczywistej intencji (kliknięcia vs. zapisy)

Użyj szybkich eksperymentów do zawężania opcji — a potem potwierdź je mocniejszym testem.

Szybsza analiza i jaśniejsze decyzje

Szybkie eksperymentowanie pomaga tylko wtedy, gdy potrafisz zmienić nieuporządkowane dane w decyzję, której ufasz. AI jest tu przydatne, bo potrafi podsumować, porównać i wydobyć wzorce z notatek, feedbacku i wyników — bez godzin w arkuszach.

Zamień surowe notatki w brief decyzyjny

Po rozmowie, ankiecie lub małym teście wklej luźne notatki i poproś AI o przygotowanie jednostronicowego „briefu decyzyjnego”:

- Co testowaliśmy (hipoteza, odbiorcy, kanał)

- Co się stało (główne sygnały, znaczące cytaty, liczby)

- Co to znaczy (interpretacja + poziom pewności)

- Rekomendowany następny krok (kontynuować, zmienić, zatrzymać)

To zapobiega sytuacji, w której wnioski żyją tylko w czyjejś głowie albo toną w dokumencie, do którego nikt nie wraca.

Porównuj opcje z zaletami/wadami i założeniami

Gdy masz kilka kierunków, poproś AI o porównanie obok siebie:

- Opcja A vs B: zalety, wady, ryzyka

- Założenia, które muszą być prawdziwe

- Najtańszy eksperyment testujący każde założenie

Nie prosisz AI o „wybór zwycięzcy”. Używasz go do jawnego przedstawienia rozumowania i ułatwienia krytyki.

Zdefiniuj kryteria „co zmieni moje zdanie”

Przed kolejnym eksperymentem zapisz reguły decyzyjne. Przykład: „Jeśli mniej niż 5% odwiedzających kliknie ‘Request access’, przestajemy z tym kątem.” AI może pomóc sformułować mierzalne kryteria powiązane z hipotezą.

Prowadź lekki dziennik eksperymentów

Prosty log (data, hipoteza, metoda, wyniki, decyzja, link do briefu) zapobiega powtarzaniu pracy i sprawia, że nauka jest kumulatywna.

Przechowuj go tam, gdzie zespół już pracuje (wspólny dokument, wiki wewnętrzne lub folder z linkami).

Ryzyka i zabezpieczenia: jak pozostać rzetelnym i etycznym

Praca z AI daje supermoc — ale może też potęgować błędy. Gdy możesz w 10 minut wygenerować 10 koncepcji, łatwo pomylić „dużo outputu” z „dobrymi dowodami”.

Gdzie najczęściej pojawiają się problemy

Halucynacje to oczywiste ryzyko: AI może pewnie zmyślać „fakty”, cytaty, dane rynkowe. W szybkim eksperymencie wymyślone detale mogą po cichu stać się podstawą MVP lub pitchu.

Inną pułapką jest dopasowanie do sugestii AI. Jeśli ciągle prosisz model o „najlepszy pomysł”, możesz gonić za tym, co brzmi spójnie w tekście, zamiast tym, czego chcą klienci. Model optymalizuje spójność, niekoniecznie prawdę.

AI ułatwia też niezamierzone kopiowanie konkurencji. Gdy pytasz o „przykłady z rynku”, możesz zbliżyć się do klonów istniejącego pozycjonowania lub funkcji — co jest ryzykowne dla wyróżnienia i potencjalnie dla własności intelektualnej.

Proste zabezpieczenia, które utrzymają cię w prawdzie

Poproś AI, by wskazało niepewności:

- „Wypisz założenia i ocenę pewności (niska/średnia/wysoka).”

- „Co zmieniłoby twoją odpowiedź? Jakich danych potrzebujesz?”

Dla twierdzeń wpływających na pieniądze, bezpieczeństwo lub reputację zweryfikuj krytyczne punkty. Traktuj output AI jako roboczy brief badawczy, nie jako badanie samo w sobie.

Jeśli model cytuje statystyki, wymagaj śledzalnych źródeł (a potem je sprawdź): „Podaj linki i cytaty z oryginalnego źródła.”

Kontroluj też wejścia, by zmniejszyć bias: używaj spójnego szablonu promptów, trzymaj wersjonowany dokument "faktów, w które wierzymy" i uruchamiaj małe eksperymenty z różnymi założeniami, żeby jeden prompt nie zdominował wyniku.

Podstawy prywatności i etyki

Nie wklejaj danych wrażliwych (dane klientów, przychody wewnętrzne, własny kod, dokumenty prawne) do niezatwierdzonych narzędzi. Używaj zanonimizowanych przykładów, danych syntetycznych lub bezpiecznych rozwiązań korporacyjnych.

Jeżeli testujesz komunikaty, ujawnij udział AI tam, gdzie to stosowne i unikaj fabrykowania rekomendacji czy cytatów użytkowników.

Praktyczny workflow do szybkiej iteracji

Wypuść uczące MVP

Stwórz cienkie MVP skupione na jednym jobie do wykonania, a następnie iteruj na podstawie feedbacku.

Szybkość to nie tylko „praca szybciej” — to powtarzalna pętla, która zapobiega szlifowaniu niewłaściwych rzeczy.

Prosty workflow to:

Hipoteza → Zbuduj → Testuj → Ucz się → Iteruj

1) Zacznij od jasnej hipotezy

Zapisz ją w jednym zdaniu:

„Wierzymy, że [odbiorcy] zrobią [akcję], ponieważ [powód]. Będziemy wiedzieć, że mamy rację, jeśli [metryka] osiągnie [próg].”

AI może pomóc przekształcić mglistą ideę w testowalne stwierdzenie i zasugerować mierzalne kryteria sukcesu.

2) Zdefiniuj „wystarczająco dobre do testu”

Zanim cokolwiek stworzysz, ustal minimalny pułap jakości:

- Jasna obietnica (jedno zdanie)

- Jedno główne wezwanie do działania

- Jeden realistyczny scenariusz użytkownika

- Brak wymogu idealnych materiałów wizualnych

Jeśli spełnia ten próg, wypuść do testu. Jeśli nie, popraw tylko to, co blokuje zrozumienie.

3) Biegaj w czasowych cyklach (wybierz jeden)

Cykl 2-godzinny: Szkic strony lądowania + 2 warianty reklam, uruchom mały budżet lub podziel się z małą grupą, zbierz kliknięcia + odpowiedzi.

Cykl 1-dniowy: Stwórz klikalny prototyp (surowy UI wystarczy), przeprowadź 5 krótkich rozmów z użytkownikami, zanotuj miejsca zawahania i oczekiwania.

Cykl 1-tygodniowy: Zbuduj cienkie demo MVP (lub wersję concierge), zrekrutuj 15–30 docelowych użytkowników, mierz aktywację i gotowość do dalszego korzystania.

4) Przydziel role — nawet jeśli to jedna osoba

- Założyciel: wybiera hipotezę i decyzję o wypuszczeniu.

- Marketer: definiuje odbiorców, kanały i metryki sukcesu.

- Projektant: dba, by przepływ był zrozumiały (nie piękny).

- Analityk: ustawia śledzenie, zapisuje wyniki, podsumowuje wnioski.

5) Zamknij pętlę decyzją

Po każdym teście napisz jednozdaniową „notatkę z nauki”: co się wydarzyło, dlaczego i co zmienisz dalej. Potem zdecyduj: iterować, zmienić hipotezę czy zatrzymać.

Przechowywanie tych notatek w jednym dokumencie sprawia, że postęp jest widoczny i powtarzalny.

Mierzenie wpływu: czy rzeczywiście uczysz się szybciej?

Szybkość ma sens tylko, jeśli prowadzi do jaśniejszych decyzji. AI pomoże przeprowadzić więcej eksperymentów, ale potrzebujesz prostego arkusza wyników, który pokaże, czy uczysz się szybciej — czy tylko generujesz więcej aktywności.

Główne metryki do śledzenia

Zacznij od małego zestawu miar porównywalnych między eksperymentami:

- Czas do pierwszego testu: dni (lub godziny) od pomysłu do czegoś realnego przed użytkownikami.

- Koszt na naukę: całkowite wydatki (narzędzia, reklamy, incentywy, czas) podzielone przez liczbę insightów decydującej jakości.

- Wzrost konwersji: poprawa względem bazowej (np. zapis z 2,0% → 2,6%).

- Sygnały retencji: wczesne wskaźniki jak powroty, powtarzalne użycie czy odpowiedź „byłbym rozczarowany, gdyby to zniknęło”.

Wskaźniki wiodące vs. jakość nauki

AI ułatwia gonienie kliknięć i zapisów. Prawdziwe pytanie brzmi, czy każdy test kończy się ostrym wynikiem:

- Czy potwierdziłeś lub obaliłeś konkretne założenie?

- Czy potrafisz sformułować wynik jednym zdaniem (np. „Cena 19 zł konwertowała o 30% lepiej niż 29 zł dla freelancerów”)?

- Czy wiesz, co zrobić dalej — budować, zmienić czy zatrzymać?

Jeśli wyniki są niejasne, dopracuj projekt eksperymentu: jaśniejsze hipotezy, precyzyjniejsze kryteria sukcesu lub lepsza grupa docelowa.

Reguły zatrzymania: zdecyduj przed testem

Zobowiąż się z góry, co się stanie po otrzymaniu danych:

- Zabij jeśli kluczowa metryka jest poniżej minimum (np. <1% zapisów po 500 kwalifikowanych odwiedzinach).

- Pivotuj jeśli jest zainteresowanie, ale komunikat, odbiorca lub przypadek użycia różnią się od założenia.

- Podwajaj jeśli osiągnięto próg i potraficie wyjaśnić, dlaczego to zadziałało.

Następny krok

Wybierz jeden pomysł i zaplanuj mały pierwszy test już dziś: zdefiniuj jedno założenie, jedną metrykę, jedną grupę docelową i jedną regułę zatrzymania.

Następnie postaraj się skrócić swój czas-do-pierwszego-testu o połowę przy następnym eksperymencie.