17 sie 2025·8 min

Dlaczego workflowy oparte na AI zmniejszają przedwczesną abstrakcję

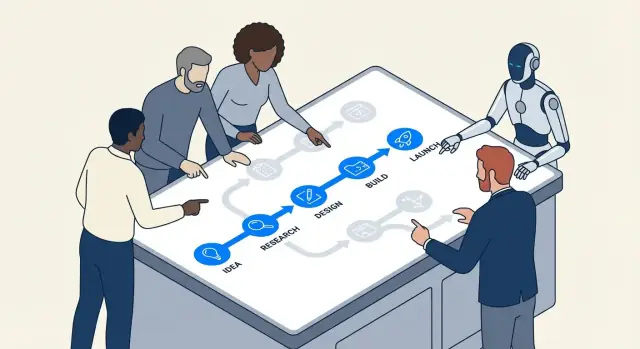

Workflowy oparte na AI skłaniają zespoły do konkretnych kroków, szybkiego feedbacku i mierzalnych wyników — co zmniejsza pokusę nadmiernej abstrakcji i przedwczesnego nadinżynieryjnego projektowania.

Co rozumiemy przez przedwczesną abstrakcję i nadinżynierię

Przedwczesna abstrakcja to sytuacja, gdy budujesz „ogólne rozwiązanie” zanim zobaczysz wystarczająco dużo rzeczywistych przypadków, żeby wiedzieć, co warto uogólnić.

Zamiast napisać najprostszy kod rozwiązujący dzisiejszy problem, wymyślasz framework: dodatkowe interfejsy, systemy konfiguracji, punkty wtyczek albo moduły wielokrotnego użytku — bo zakładasz, że będą potrzebne później.

Nadinżynieria to szerszy nawyk, który za tym stoi. To dokładać złożoność, która obecnie nie „spłaca się”: dodatkowe warstwy, wzorce, usługi czy opcje, które teraz nie obniżają kosztów ani ryzyka.

Przykłady prostym językiem

Jeśli produkt ma jeden plan rozliczeń, a budujesz wielotenancyjny silnik cenowy „na wszelki wypadek”, to jest to przedwczesna abstrakcja.

Jeśli funkcja mogłaby być pojedynczą, prostą funkcją, a ty dzielisz ją na sześć klas z fabrykami i rejestrami, żeby była „rozszerzalna”, to jest to nadinżynieria.

Dlaczego pojawia się to we wczesnych fazach projektów

Te nawyki są częste na początku, bo wczesne projekty są pełne niepewności:

- Strach przed przeróbką: Zespół boi się, że jeśli zrobi coś prosto, będzie trzeba to później przepisać.

- Niejasne wymagania: Gdy nikt nie jest pewien, czym produkt się stanie, kuszące jest zbudowanie elastycznego szkielettu, który „poradzi sobie ze wszystkim”.

- Presja społeczna: Inżynierowie często chcą patrzeć w przyszłość i „zrobić to dobrze”, nawet gdy „dobrze” nie jest jeszcze poznawalne.

Problem w tym, że „elastyczne” często znaczy „trudniejsze do zmiany”. Dodatkowe warstwy mogą spowolnić codzienne edycje, utrudnić debugowanie i wydłużyć wdrożenie nowych osób. Koszt złożoności płacisz od razu, a korzyści mogą nigdy nie nadejść.

Gdzie AI pomaga (a gdzie nie)

Workflowy wspierane przez AI mogą zachęcać zespoły do konkretnych działań — przyspieszając prototypowanie, szybko generując przykłady i ułatwiając testowanie założeń. To może zmniejszyć niepokój, który napędza spekulatywny design.

Ale AI nie zastępuje oceny inżynierskiej. Potrafi generować sprytne architektury i abstrakcje na żądanie. Twoje zadanie to wciąż pytać: Jaka jest najprostsza rzecz, która działa dziś, i jakie dowody uzasadniłyby dodanie struktury jutro?

Narzędzia takie jak Koder.ai są tu szczególnie skuteczne, bo ułatwiają przejście od promptu w czacie do uruchomialnego fragmentu rzeczywistej aplikacji (web, backend, mobile) — dzięki czemu zespoły mogą zweryfikować, co jest potrzebne, zanim „zabezpieczą przyszłość”.

Jak workflowy AI skłaniają zespoły ku konkretnemu działaniu

Rozwój wspomagany AI zwykle zaczyna się od czegoś namacalnego: konkretnego buga, małej funkcji, transformacji danych, ekranu UI. To ramowanie ma znaczenie. Gdy workflow zaczyna się od „oto dokładnie to, czego potrzebujemy”, zespoły rzadziej wymyślają uogólnioną architekturę, zanim nie nauczą się, czym naprawdę jest problem.

Konkretne promptu dają konkretny kod

Większość narzędzi AI odpowiada najlepiej, gdy podasz szczegóły: wejścia, wyjścia, ograniczenia i przykład. Prompt typu „zaprojektuj elastyczny system powiadomień” jest niejasny, więc model często „uzupełni luki” dodatkowymi warstwami — interfejsami, fabrykami, konfiguracją — bo nie widzi prawdziwych granic.

Gdy jednak prompt jest osadzony w konkretach, wynik też jest osadzony:

- Wejście: „Dla tych statusów zamówienia…”

- Wyjście: „Zwróć wiadomość widoczną dla użytkownika i CTA…”

- Ograniczenia: „Musi być szybkie; bez wywołań do bazy; z i18n…”

- Przykłady: „Dla

PENDING_PAYMENTpokaż …”

To naturalnie popycha zespoły do implementacji wąskiego kawałka, który działa end-to-end. Gdy możesz to uruchomić, przeglądnąć i pokazać, działasz w rzeczywistości, a nie w spekulacji.

„Zrób działające najpierw” staje się domyślną drogą

Programowanie w parze z AI obniża koszt iteracji. Jeśli pierwsza wersja jest nieco nieuporządkowana, ale poprawna, kolejny krok to zwykle „zrefaktoryzuj to” zamiast „zaprojektuj system na wszystkie przyszłe przypadki”. Ta sekwencja — najpierw działający kod, potem dopracowanie — zmniejsza impuls do budowania abstrakcji, które nie udowodniły swojej wartości.

W praktyce zespoły znajdują rytm:

- Poproś o minimalną implementację.

- Przetestuj ją na realnych przykładach.

- Dostosuj na podstawie tego, co się psuje lub jest niewygodne.

- Dopiero wtedy wydziel helper, moduł lub wzorzec.

Szczegółowość ujawnia brakujące wymagania wcześnie

Promptu zmuszają do stwierdzenia, co naprawdę masz na myśli. Jeśli nie potrafisz zdefiniować wejść/wyjść jasno, to sygnał, że nie jesteś gotów do abstrakcji — nadal odkrywasz wymagania. Narzędzia AI nagradzają klarowność, więc subtelnie uczą zespoły: najpierw wyjaśniaj, potem uogólniaj.

Krótkie pętle sprzężenia zwrotnego redukują spekulatywny design

Szybkie informacje zwrotne zmieniają to, jak wygląda „dobra inżynieria”. Gdy możesz przetestować pomysł w kilka minut, spekulatywna architektura przestaje być kojącym kocem bezpieczeństwa, a zaczyna wyglądać jak koszt, którego można uniknąć.

Pętla: szkic → uruchom → sprawdź → popraw

Workflowy oparte na AI kompresują cykl:

- Szkic: poproś asystenta o mały, działający fragment (skrypt, handler, zapytanie)

- Uruchom: wykonaj go natychmiast na rzeczywistych danych wejściowych

- Sprawdź: zobacz wyjścia, logi, przypadki brzegowe i jak to pada

- Popraw: dopracuj kod i wymaganie jednocześnie

Ta pętla nagradza konkretne postępy. Zamiast dyskusji „będziemy potrzebować systemu wtyczek” czy „to musi obsługiwać 12 źródeł danych”, zespół widzi, czego rzeczywiście wymaga aktualny problem.

Dlaczego prędkość redukuje spekulatywną architekturę

Przedwczesna abstrakcja często pojawia się, gdy zespoły boją się zmian: jeśli zmiany są drogie, starasz się przewidzieć przyszłość i zaprojektować ją. Przy krótkich pętlach koszt zmiany jest niski. To odwraca bodziec:

- Możesz odroczyć uogólnienie do momentu, gdy powtarzana praca udowodni jego potrzebę.

- Odkrywasz rzeczywiste ograniczenia (wydajność, kształt danych, zachowanie użytkownika) wcześnie.

- Przestajesz budować „na wszelki wypadek”, bo możesz iterować „na czas”.

Prosty przykład: endpoint zamiast frameworka

Załóżmy, że dodajesz wewnętrzną funkcję „eksport do CSV”. Ścieżka nadinżynieryjna zaczyna się od projektowania ogólnego frameworka eksportu, wielu formatów, kolejek zadań i warstw konfiguracji.

Szybka ścieżka to mniejsze rozwiązanie: wygeneruj pojedynczy endpoint /exports/orders.csv (lub jednorazowy skrypt), uruchom go na danych stagingowych i sprawdź rozmiar pliku, czas wykonania i brakujące pola. Jeśli po dwóch, trzech eksportach zobaczysz powtarzające się wzorce — ta sama logika paginacji, wspólne filtrowanie, wspólne nagłówki — wtedy abstrakcja zasługuje na swoje miejsce, bo jest ugruntowana w dowodach, nie w domysłach.

Przyrostowe zmiany sprawiają, że abstrakcje muszą się obronić

Dostarczanie krokami zmienia ekonomię projektowania. Gdy wydajesz małymi kawałkami, każda „miła do posiadania” warstwa musi udowodnić, że pomaga już teraz — nie w wyobrażonej przyszłości. Tu workflowy AI cicho ograniczają przedwczesną abstrakcję: AI jest świetne w proponowaniu struktur, ale te struktury najłatwiej zweryfikować, gdy zakres jest mały.

Mały zakres sprawia, że sugestie AI są testowalne

Jeśli poprosisz asystenta o zrefaktoryzowanie jednego modułu lub dodanie endpointu, możesz szybko sprawdzić, czy jego abstrakcja rzeczywiście poprawia czytelność, zmniejsza duplikację lub ułatwia kolejną zmianę. Przy małym diffie informacja zwrotna jest natychmiastowa: testy przechodzą lub nie, kod czyta się lepiej lub gorzej, funkcja działa poprawnie lub nie.

Gdy zakres jest duży, sugestie AI mogą wydawać się prawdopodobne bez bycia ewidentnie użytecznymi. Możesz przyjąć uogólniony framework, bo „wygląda czysto”, by później odkryć, że komplikuje prawdziwe przypadki brzegowe.

Małe komponenty ujawniają, co warto zachować (a co usunąć)

Praca przyrostowa zachęca do budowania małych, łatwych do wyrzucenia komponentów — helperów, adapterów, prostych kształtów danych. Po kilku iteracjach staje się jasne, które części są wykorzystywane w wielu funkcjach (warto je zachować), a które były potrzebne tylko do jednorazowego eksperymentu (bezpiecznie można je usunąć).

Abstrakcje wtedy stają się zapisem rzeczywistego ponownego użycia, a nie przewidywanego.

Przyrostowe dostarczanie zmniejsza ryzyko refaktora

Gdy zmiany są ciągle wdrażane, refaktoryzacja jest mniej przerażająca. Nie musisz „zrobić tego dobrze” od razu, bo możesz ewoluować projekt w miarę gromadzenia dowodów. Jeśli wzorzec naprawdę zasługuje na miejsce — redukuje powtarzaną pracę w kilku przyrostach — wyniesienie go do abstrakcji jest decyzją niskiego ryzyka i wysokiej pewności.

To nastawienie odwraca domyślną strategię: najpierw zbuduj najprostsze rozwiązanie, potem uogólniaj tylko gdy kolejny przyrost na tym skorzysta.

Łatwe eksperymentowanie sprzyja prostocie zamiast „wielkiego projektu"

Prove the app on mobile

Zweryfikuj flow na Flutterze zanim zainwestujesz w wielokrotne, reużywalne architektury.

Workflowy oparte na AI czynią eksperyment tak tanim, że „zbuduj jeden wielki system” przestaje być domyślną opcją. Gdy zespół może wygenerować, zmodyfikować i uruchomić kilka podejść w jedno popołudnie, łatwiej dowiedzieć się, co naprawdę działa, niż przewidywać, co mogłoby zadziałać.

AI sprawia, że małe warianty są prawie darmowe

Zamiast poświęcać dni na projektowanie uogólnionej architektury, zespoły mogą poprosić AI o kilka wąskich, konkretnych implementacji:

- wersję prostą, obsługującą dobrze happy path

- wersję zoptymalizowaną pod czytelność i utrzymanie

- wersję dodającą jedną dodatkową funkcjonalność (np. drugi format wejścia)

Ponieważ tworzenie tych wariantów jest szybkie, zespół może przetestować kompromisy bez zobowiązań do „wielkiego projektu” na start. Celem nie jest wypuszczenie wszystkich wariantów — chodzi o zebranie dowodów.

Porównywanie wariantów naturalnie faworyzuje prostsze rozwiązania

Gdy możesz postawić obok siebie dwie lub trzy działające opcje, złożoność staje się widoczna. Często prostszy wariant:

- spełnia te same rzeczywiste wymagania

- ma mniej elementów do debugowania

- ułatwia przyszłe zmiany, bo jest mniej ukrytych zależności

Tymczasem nadinżynieryjne opcje uzasadniają się hipotetycznymi potrzebami. Porównanie wariantów jest antidotum na to: jeśli dodatkowa abstrakcja nie daje jasnych, bliskoterminowych korzyści, wygląda jak koszt.

Lista kontrolna: co mierzyć przy porównywaniu opcji

Gdy prowadzisz lekkie eksperymenty, uzgodnij, co oznacza „lepsze”. Praktyczna lista:

- Czas do pierwszego działającego rezultatu: Ile czasu do podstawowych scenariuszy?

- Złożoność implementacji: Liczba plików/modułów, liczba wprowadzonych pojęć i ile „reguł” musi zapamiętać współpracownik.

- Koszt zmiany: Jak trudno dodać jedno nowe wymaganie (następne prawdopodobne, nie odległa fantazja)?

- Tryby awarii: Co się psuje, jak bardzo i jak łatwo to wykryć (czytelne błędy vs ciche złe wyjście).

- Ryzyko operacyjne: Nowe zależności, powierzchnia konfiguracji i miejsca, gdzie zachowanie produkcyjne może się zmieniać.

- Testowalność: Jak łatwo napisać mały zestaw testów, które wyjaśniają zachowanie.

Jeśli bardziej abstrakcyjny wariant nie wygra na przynajmniej jednym lub dwóch tych kryteriach, najprostsze działające podejście zwykle jest dobrym wyborem — na teraz.

AI pomaga wyjaśnić wymagania zanim zaczniesz abstraktować

Przedwczesna abstrakcja często zaczyna się od zdania: „Może będziemy tego potrzebować później.” To różni się od: „Potrzebujemy tego teraz.” Pierwsze to przypuszczenie o przyszłej zmienności; drugie to ograniczenie, które możesz dziś zweryfikować.

Workflowy oparte na AI utrudniają zignorowanie tej różnicy, bo świetnie zamieniają niejasne rozmowy w jawne stwierdzenia, które możesz przejrzeć.

Zamień niejednoznaczność w pisemny kontrakt (bez nadmiernego zobowiązywania)

Gdy prośba o funkcję jest niejasna, zespoły mają tendencję do „zabezpieczania na przyszłość” przez budowę ogólnego frameworka. Zamiast tego użyj AI, by szybko wygenerować jednostronicowy snapshot wymagań, który oddziela to, co realne, od tego, co wyobrażone:

- Co wiemy (obecne ograniczenia): docelowi użytkownicy, wspierane platformy, oczekiwania wydajności, wymagane integracje.

- Co zakładamy: „Użytkownicy będą mieć wiele kont”, „będziemy wspierać 10 lokalizacji”, „będą poziomy cenowe”.

- Czego jeszcze nie wiemy: przypadki brzegowe, ograniczenia prawne, skalowanie, potrzeby migracyjne.

To proste rozdzielenie zmienia rozmowę inżynierską. Przestajesz projektować pod nieznaną przyszłość i zaczynasz budować pod znaną teraźniejszość — jednocześnie trzymając widocznie listę niepewności do ponownego przejrzenia.

Planning Mode Koder.ai dobrze tu pasuje: możesz zamienić niejasną prośbę w konkretny plan (kroki, model danych, endpointy, stany UI) przed generowaniem implementacji — bez wiązania się z rozległą architekturą.

Lekki sposób „przyjazny na przyszłość"

Wciąż możesz zostawić miejsce na ewolucję, bez budowy głębokiego warstwowego rozwiązania. Faworyzuj mechanizmy łatwe do zmiany lub usunięcia:

- Feature flags żeby wypuścić wąską wersję i uczyć się z realnego użycia.

- Konfiguracja dla wartości, które się zmieniają (timeouts, progi, treści) zamiast systemów polimorficznych.

- Małe punkty rozszerzeń (jeden interfejs, jeden hook, jedno zdarzenie) tylko tam, gdzie wariacja jest już prawdopodobna.

Dobre reguła: jeśli nie potrafisz wymienić następnych dwóch konkretnych wariantów, nie buduj frameworka. Zapisz podejrzewane wariacje jako „nieznane”, wypuść najprostszy działający wariant, a potem pozwól realnemu feedbackowi uzasadnić późniejszą abstrakcję.

Jeśli chcesz sformalizować ten nawyk, zapisz te notatki w szablonie PR lub w wewnętrznym dokumencie „assumptions” powiązanym z ticketem (np. /blog/engineering-assumptions-checklist).

Testy i przykłady ujawniają niepotrzebne uogólnienia

Częstą przyczyną nadinżynierii jest projektowanie pod wyimaginowane scenariusze. Testy i konkretne przykłady odwracają to: zmuszają do opisania rzeczywistych wejść, wyjść i trybów błędów. Gdy to zapiszesz, „ogólne” abstrakcje często wydają się mniej użyteczne — i bardziej kosztowne — niż mała, czytelna implementacja.

Jak AI ujawnia przypadki brzegowe (bez wynajdywania architektury)

Gdy poprosisz asystenta AI o pomoc przy pisaniu testów, naturalnie popycha on ku szczegółowości. Zamiast „zrób to elastycznie” dostajesz pytania typu: Co ta funkcja zwraca, gdy lista jest pusta? Jaka jest maksymalna dozwolona wartość? Jak reprezentujemy nieprawidłowy stan?

To pytanie jest wartościowe, bo wyłapuje przypadki brzegowe wcześnie, gdy nadal decydujesz, czego funkcja naprawdę potrzebuje. Jeśli te przypadki są rzadkie lub poza zakresem, możesz je udokumentować i iść dalej — bez budowania abstrakcji „na wszelki wypadek”.

Pisanie testów najpierw ujawnia, czy abstrakcja jest potrzebna

Abstrakcje zasługują na miejsce, gdy wiele testów dzieli ten sam setup lub wzorce zachowania. Jeśli w suite testów masz tylko jeden lub dwa konkretne scenariusze, tworzenie frameworka lub systemu wtyczek zwykle oznacza optymalizację pod hipotetyczną przyszłość.

Prosta zasada: jeśli nie potrafisz wyrazić co najmniej trzech odrębnych zachowań, które potrzebują tego samego uogólnionego interfejsu, twoja abstrakcja prawdopodobnie jest przedwczesna.

Mini-szablon praktycznych przypadków testowych

Użyj tej lekkiej struktury zanim sięgniesz po „uogólniony” design:

- Happy path: typowe wejście → oczekiwane wyjście.

- Granica: minimalne/maksymalne wartości, puste kolekcje, limity (np. 0, 1, 1000).

- Błąd: nieprawidłowe wejście, brakujące zależności, timeouty, błędy uprawnień → oczekiwany błąd lub zachowanie zapasowe.

Gdy te testy są napisane, kod często chce być prosty. Jeśli pojawia się powtarzalność w kilku testach, to sygnał do refaktora — nie początek projektowania.

Widoczne koszty utrzymania zniechęcają do nadinżynierii

Prototype in minutes, not weeks

Dostarcz mały fragment end-to-end dla web, backendu lub mobile z poziomu czatu.

Nadinżynieria często kryje się pod dobrymi intencjami: „będziemy tego potrzebować później.” Problem polega na tym, że abstrakcje niosą ze sobą koszty bieżące, które nie wychodzą w pierwszym zadaniu implementacyjnym.

Rachunek za abstrakcję

Każda nowa warstwa zwykle generuje stałą pracę:

- Powierzchnia API: więcej metod, parametrów i przypadków brzegowych do obsługi (i utrzymania kompatybilności wstecznej).

- Dokumentacja i przykłady: onboarding innych osób oznacza wyjaśnianie abstrakcji, nie tylko funkcji.

- Migracje: gdy inny kod zależy od uogólnionego interfejsu, jego zmiana wymaga adapterów, deprecjacji i notatek o wydaniu.

- Macierz testów: „ogólny” kod rozszerza scenariusze — więcej implementacji, więcej mocków, więcej punktów integracji.

Workflowy oparte na AI utrudniają ignorowanie tych kosztów, bo szybko potrafią wypisać, na co się zgadzasz.

Używanie AI do oszacowania złożoności: policz ruchome elementy

Praktyczny prompt to: „Wypisz ruchome elementy i zależności wprowadzane przez ten projekt.” Dobry asystent AI potrafi rozbić plan na konkretne elementy, takie jak:

- nowe moduły/pakiety

- publiczne interfejsy i oczekiwania wersjonowania

- zmiany schematu bazy danych i kroki migracji

- wywołania międzyserwisowe i tryby błędów

- nowe flagi konfiguracyjne, uprawnienia lub kolejki

Widząc tę listę obok prostszej implementacji, „czysta architektura” staje się jaśniejszym kompromisem: czy chcesz utrzymywać osiem nowych pojęć, by uniknąć duplikacji, której może nigdy nie będzie?

Budżet złożoności, by pracować uczciwie

Jedna lekka polityka: ogranicz liczbę nowych pojęć na funkcję. Na przykład pozwól maksymalnie na:

- 1 nowe publiczne API

- 1 nową współdzieloną abstrakcję (interfejs/klasa bazowa)

- 1 nowy model danych/tabela

Jeśli funkcja przekracza budżet, wymaga uzasadnienia: jaką przyszłą zmianę to umożliwia i jakie masz dowody, że jest nieuchronna? Zespoły, które używają AI do przygotowania takiego uzasadnienia (i prognozowania prac utrzymaniowych), częściej wybierają mniejsze, odwracalne kroki — bo koszty bieżące widać przed wdrożeniem.

Kiedy AI może popychać w złą stronę (i jak temu zapobiec)

Workflowy AI często kierują zespoły ku małym, testowalnym krokom — ale mogą też zrobić odwrotnie. Ponieważ AI potrafi szybko wygenerować „kompletne” rozwiązania, może domyślnie tworzyć znajome wzorce, dodawać strukturę lub generować szkielety, o które nie prosiłeś. Efekt to więcej kodu niż potrzeba, wcześniej niż potrzeba.

Jak AI przypadkowo zachęca do nadinżynierii

Model jest nagradzany (przez percepcję ludzką) za brzmiące „dokładnie”. To może przełożyć się na dodatkowe warstwy, więcej plików i uogólnione projekty, które wyglądają profesjonalnie, ale nie rozwiązują realnego, aktualnego problemu.

Typowe sygnały ostrzegawcze:

- Nowe abstrakcje bez konkretnego przypadku użycia (np. „na przyszłość”)

- Dodatkowe warstwy: service → manager → adapter → factory, gdy wystarczyłaby funkcja

- Generyczne interfejsy z jedną implementacją

- Systemy wtyczek, magistrale zdarzeń czy DI wprowadzone zbyt wcześnie

- „Framework w frameworku” stworzony by ustandaryzować coś, czego jeszcze nie powtórzono

Środki zapobiegawcze, które trzymają output AI przy ziemi

Traktuj AI jak szybkie ręce programisty, nie komisję architektoniczną. Kilka ograniczeń dużo zmienia:

- Ogranicz prompt do teraźniejszości. Poproś o najmniejszą zmianę spełniającą dzisiejsze wymaganie i zabroń nowych wzorców, chyba że są konieczne.

- Wymagaj realnych przykładów. Zanim zaakceptujesz abstrakcję, żądaj 2–3 konkretnych miejsc wywołania (lub ścieżek użytkownika) i upewnij się, że abstrakcja je upraszcza.

- Limituj zmianę architektury na iterację. Pozwól na jedną zmianę strukturalną naraz (np. „wprowadź jeden nowy moduł” lub „bez nowych warstw w tym PR”).

- Przeglądaj pod kątem usuwalności. Jeśli usunięcie nowej warstwy zbytnio nie wpływa na zachowanie, prawdopodobnie jej nie potrzeba.

Prosta zasada: nie pozwól AI uogólniać, dopóki baza kodu nie wykaże powtarzającego się bólu.

Praktyczne ramy decyzji: najpierw buduj, potem uogólniaj

Get fast feedback loops

Wdrażaj wcześnie, by rzeczywiste użycie, a nie spekulacje, decydowało o tym, co warto uogólnić.

AI ułatwia generowanie kodu, refaktory i próby alternatyw. To dar — jeśli użyjesz go, by opóźnić abstrakcję, aż na nią zasłuży.

Krok 1: Zacznij konkretnie (optymalizuj pod naukę)

Zacznij od najprostszego rozwiązania, które rozwiązuje dzisiejszy problem dla jednego „happy path”. Nazwy rzeczy dawaj po tym, co robią, nie po tym, co mogą robić później, i trzymaj API wąskie. Jeśli nie jesteś pewien, czy parametr, interfejs lub system wtyczek jest potrzebny, wypuść bez niego.

Użyteczna reguła: wol preferować duplikację nad spekulacją. Zduplikowany kod jest widoczny i łatwy do usunięcia; spekulatywna ogólność ukrywa złożoność w pośrednictwie.

Krok 2: Wyodrębnij później (optymalizuj pod stabilność)

Gdy funkcja jest używana i zmienia się, refaktoruj na podstawie dowodów. Z pomocą AI możesz zrobić to szybko: poproś o propozycję ekstrakcji, ale wymagaj minimalnego diffu i czytelnych nazw.

Jeśli twoje narzędzia to wspierają, użyj safety netów, które zmniejszają ryzyko refaktora. Na przykład snapshoty i rollback Koder.ai ułatwiają eksperymenty z refaktorami, bo możesz szybko cofnąć zmiany, jeśli „czystszy” design okaże się gorszy w praktyce.

Kiedy abstrakcja jest uzasadniona (krótka lista kontrolna)

Abstrakcja zasługuje na miejsce, gdy większość z poniższego jest prawdziwa:

- Powtarzająca się logika: to samo zachowanie występuje w 2–3 miejscach, a aktualizacje już wymagały wielu poprawek.

- Udowodniona zmienność: zaobserwowano prawdziwe wariacje w produkcji lub zweryfikowanych prototypach (nie „może kiedyś”).

- Jasne powiernictwo: ktoś/osoba lub zespół opiekuje się abstrakcją, jej dokumentacją i przyszłymi zmianami.

- Stabilna granica: kształt wejścia/wyjścia pozostał spójny przez co najmniej kilka iteracji.

- Rzeczywiste uproszczenie: ekstrakcja redukuje łączną ilość kodu i obciążenie poznawcze, nie tylko go reorganizuje.

Prosty rytuał: przegląd „po tygodniu"

Dodaj przypomnienie kalendarzowe tydzień po wdrożeniu funkcji:

- Otwórz diff i przejrzyj, co się zmieniło od wydania.

- Wypisz ewentualne kopiuj-wklej edycje lub powtarzające się błędy.

- Zdecyduj jedno z trzech: pozostać przy konkretach, wydzielić mały helper lub wprowadzić współdzielony moduł.

To utrzymuje domyślną postawę: najpierw zbuduj, potem uogólniaj, tylko gdy rzeczywistość cię do tego zmusi.

Co mierzyć, by utrzymać zespół w leanie

Lean engineering to nie puste hasło — można to obserwować. Workflowy AI ułatwiają szybkie wysyłanie małych zmian, ale nadal potrzebujesz kilku sygnałów, by zauważyć, kiedy zespół wraca do spekulatywnego designu.

Mały zestaw metryk, które wcześnie łapią nadinżynierię

Śledź garść wskaźników zwiastujących niepotrzebną abstrakcję:

- Cycle time: czas od „startu pracy” do „merge i deployment”. Gdy rośnie bez jasnego wzrostu zakresu, często oznacza to dodatkowe pośrednictwa lub „future-proofing”.

- Rozmiar diffu: średnia liczba zmienionych linii (lub plików) na zmianę. Duże diffy są trudniejsze do przeglądu i sprzyjają uogólnieniom.

- Liczba wprowadzonych pojęć: licz nowe moduły/usługi/pakiety, nowe interfejsy, nowe przełączniki konfiguracyjne, nowe primity „frameworkowe”. Pojęcia to podatek, który płacisz na zawsze.

- Wskaźnik błędów: bugi produkcyjne lub zgłoszenia wsparcia na wydanie. Abstrakcje mogą ukrywać przypadki brzegowe; rosnące błędy po „uporządkowaniu” to czerwony sygnał.

- Czas onboardingu: ile czasu zajmuje nowemu inżynierowi dorzucenie pierwszej małej zmiany. Jeśli onboarding się wydłuża, system może optymalizować elegancję kosztem jasności.

Nie potrzebujesz perfekcji — wystarczą trendy. Przeglądaj je co tydzień lub na iterację i pytaj: „Czy dodaliśmy więcej pojęć niż produkt wymagał?”

Lekka dokumentacja, która zapobiega tajemniczym abstrakcjom

Wymagaj krótkiej notki „po co to istnieje” za każdym razem, gdy ktoś wprowadza nową abstrakcję (nowy interfejs, warstwę helpera, wewnętrzną bibliotekę itp.). Trzy krótkie punkty w README lub komentarzu przy wejściu:

- Jakie konkretne zadanie rozwiązało to dziś?

- Jakie alternatywy próbowano?

- Co uzasadniałoby usunięcie tego?

Plan działania, by zacząć

Pilotażowy AI-assisted workflow dla jednego zespołu na 2–4 tygodnie: rozbicie ticketów wspomagane AI, checklisty code review z AI i generowane testy przez AI.

Na końcu porównaj metryki wyżej i zrób krótki retro: zachowaj to, co skróciło cycle time i onboarding; cofnij to, co zwiększyło „liczbę wprowadzonych pojęć” bez wymiernej korzyści produktowej.

Jeśli chcesz praktyczne środowisko do przeprowadzenia takiego eksperymentu end-to-end, platforma vibes-coding jak Koder.ai pomoże przekuć te małe, konkretne kawałki w deployowalne aplikacje szybko (z możliwością eksportu źródeł), co wzmacnia nawyk, o którym mówi ten artykuł: wypuść coś realnego, ucz się i dopiero potem uogólniaj.