19 maj 2025·8 min

Zbuduj aplikację webową do analizy anulowań i testowania retencji

Dowiedz się, jak zaplanować, zbudować i wdrożyć aplikację webową śledzącą anulacje subskrypcji, analizującą przyczyny i prowadzącą eksperymenty retencyjne w kontrolowany sposób.

Co budujesz i dlaczego to ma znaczenie

Rezygnacje to jeden z najbardziej wymownych momentów w biznesie subskrypcyjnym. Klient jasno mówi: „to już mi się nie opłaca”, często tuż po napotkaniu tarcia, rozczarowania lub rozbieżności ceny/wartości. Jeśli potraktujesz rezygnację jako prostą zmianę statusu, tracisz rzadką okazję, by dowiedzieć się, co się psuje — i naprawić to.

Problem, który rozwiązujesz

Większość zespołów widzi churn jedynie jako liczbę miesięczną. To ukrywa historię:

- Kto rezygnuje (nowi użytkownicy vs. długoletni klienci, typ planu, segment)

- Kiedy rezygnują (dzień 1, po trialu, po podwyżce ceny, po nieudanej płatności)

- Dlaczego rezygnują (za drogo, brak funkcji, błędy, przejście do konkurencji, „nie używam”)

W praktyce analiza rezygnacji subskrypcji oznacza: zmienić kliknięcie „anuluj” w ustrukturyzowane dane, którym można ufać i które da się kroić.

Co oznaczają „eksperymenty retencyjne”

Gdy widzisz wzorce, możesz testować zmiany mające zmniejszyć churn — bez zgadywania. Eksperymenty retencyjne mogą dotyczyć produktu, cen lub komunikacji, np.:

- usprawnienie flow anulowania (jaśniejsze opcje, lepsze ścieżki downgrade)

- zaoferowanie pauzy lub rabatu w odpowiedniemu segmentowi

- naprawa luk w onboardingzie skorelowanych z wczesnymi rezygnacjami

Kluczowe jest mierzenie wpływu za pomocą czystych, porównywalnych danych (np. test A/B).

Co zbudujesz w tym przewodniku

Budujesz mały system składający się z trzech połączonych części:

- Śledzenie: zdarzenia wokół lifecycle subskrypcji i flow anulowania, w tym powody.

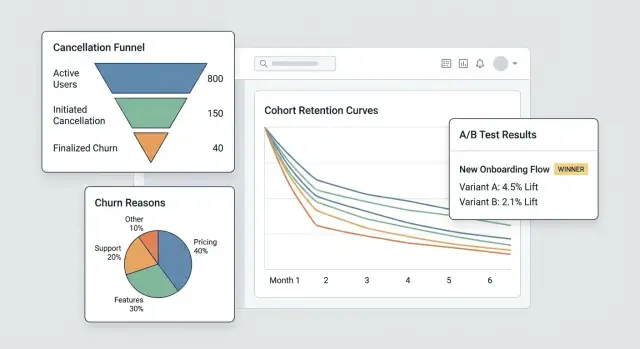

- Pulpit: lejki, kohorty i segmenty ujawniające źródła churnu.

- Pętla eksperymentów: możliwość uruchamiania ukierunkowanych testów i sprawdzania, czy churn faktycznie spada.

Na końcu będziesz mieć workflow, który przechodzi od „mieliśmy więcej rezygnacji” do „ten konkretny segment rezygnuje po 2 tygodniach z powodu X — i ta zmiana zmniejszyła churn o Y%”.

Jak wygląda sukces

Sukces to nie ładniejszy wykres — to szybkość i pewność:

- Szybsze wnioski (dni, nie miesiące)

- Mierzalne zmniejszenie churnu powiązane z konkretnymi zmianami

- Powtarzalna nauka: każda rezygnacja uczy cię czegoś, co możesz wykorzystać

Ustal cele, metryki i zakres MVP

Zanim zbudujesz ekrany, śledzenie czy dashboardy, dokładnie określ, jakie decyzje ma umożliwiać to MVP. Aplikacja do analizy rezygnacji odnosi sukces, gdy szybko odpowiada na kilka pytań o wysokiej wartości — nie gdy próbuje mierzyć wszystko.

Zacznij od pytań, które popychają do działania

Spisz pytania, na które chcesz odpowiedzieć w pierwszym wydaniu. Dobre pytania MVP są konkretne i prowadzą do oczywistych następnych kroków, np.:

- Jakie są główne powody rezygnacji i jak różnią się wg planu, regionu czy kanału pozyskania?

- Ile czasu zajmuje klientom rezygnacja (time-to-cancel) i jakie wzorce pojawiają się w pierwszych 7/30/90 dniach?

- Które plany (lub cykle rozliczeniowe) mają najwyższy współczynnik rezygnacji i czy użytkownicy wcześniej downgrade’ują?

Jeśli pytanie nie wpływa na zmianę produktu, playbook wsparcia lub eksperyment, odłóż je na później.

Wybierz 3–5 głównych metryk MVP

Wybierz krótką listę, które będziesz przeglądać co tydzień. Ustal jednoznaczne definicje, aby produkt, wsparcie i kierownictwo rozmawiały o tych samych liczbach.

Typowe metryki startowe:

- Wskaźnik anulowań (w zdefiniowanym okresie, np. tygodniowo/miesięcznie)

- Wskaźnik uratowań (odsetek prób anulowania, które skończyły się utrzymaniem klienta)

- Wskaźnik reaktywacji (klienci wracający po rezygnacji)

- Time-to-cancel (mediana dni od startu do anulowania)

- Rozkład powodów (top powody wg wolumenu i wpływu na przychód)

Dla każdej metryki udokumentuj dokładny wzór, okno czasowe i wykluczenia (triale, zwroty, nieudane płatności).

Wyznacz właścicieli i ograniczenia

Zidentyfikuj, kto będzie używał i utrzymywał system: produkt (decyzje), wsparcie/success (jakość powodów i follow-upy), dane (definicje i walidacja) oraz inżynieria (instrumentacja i niezawodność).

Uzgodnij też ograniczenia z góry: wymagania prywatności (minimalizacja PII, limity retencji), wymagane integracje (dostawca rozliczeń, CRM, narzędzie wsparcia), harmonogram i budżet.

Napisz jednostronicowy zakres, by zatrzymać rozrost funkcji

Krótko: cele, główni użytkownicy, 3–5 metryk, „must-have” integracje i jasna lista non-goals (np. „bez pełnego BI w v1”, „bez multi-touch attribution w v1”). Ta jedna strona staje się kontraktem MVP, gdy pojawią się nowe żądania.

Zamodeluj subskrypcje i zdarzenia lifecycle

Zanim zaczniesz analizować rezygnacje, potrzebujesz modelu subskrypcji odzwierciedlającego, jak klienci rzeczywiście poruszają się po produkcie. Jeśli dane przechowują tylko aktualny status subskrypcji, trudno będzie odpowiedzieć na pytania typu „jak długo byli aktywni przed anulowaniem?” czy „czy downgrade zapowiadał churn?”.

Zmapuj lifecycle, który będziesz mierzyć

Zacznij od prostego, jawnego mapowania lifecycle, z którym zgodzi się cały zespół:

Trial → Active → Downgrade → Cancel → Win-back

Możesz dodać więcej stanów później, ale nawet ten podstawowy łańcuch wymusza jasność, co liczy się jako „active” (płatne? w okresie karencji?) i co to znaczy „win-back” (reaktywacja w ciągu 30 dni? kiedykolwiek?).

Zdefiniuj podstawowe byty

Przynajmniej zamodeluj te byty, aby zdarzenia i pieniądze były spójnie powiązane:

- User: osoba korzystająca z aplikacji (może się zmieniać)

- Account: kontener billingowy/klienta (często właściwa jednostka do analizy churnu)

- Subscription: umowa, która może się zaczynać, odnawiać, przełączać lub kończyć

- Plan: poziom produktu (nazwa, cena, okres rozliczeniowy)

- Invoice: co i kiedy naliczono oraz czy opłacono/zwrócono

- Cancel event: kiedy żądanie anulowania i kiedy weszło w życie

Wybierz stabilne identyfikatory (account_id vs user_id)

Do analiz churnu account_id zwykle jest bezpieczniejszym identyfikatorem, bo użytkownicy mogą się zmieniać (odchodzą pracownicy, zmiana admina). Nadal możesz przypisywać akcje do user_id, ale agreguj retencję i rezygnacje na poziomie konta, chyba że naprawdę sprzedajesz subskrypcje osobiste.

Przechowuj historię statusów, nie tylko status

Wdróż status history (effective_from/effective_to), żeby móc zapytać o przeszłe stany. To umożliwia analizę kohortową i zachowań przed anulowaniem.

Zaplanuj z góry przypadki brzegowe

Zamodeluj je jawnie, żeby nie zanieczyszczały liczb churnu:

- Pauzy (tymczasowe zatrzymanie bez anulowania)

- Zwroty/chargebacki (odwrócenie płatności vs. dobrowolny churn)

- Zmiany planu (upgrade/downgrade jako zdarzenia, nie „nowe subskrypcje”)

- Okresy karencji (nieudana płatność vs. prawdziwe anulowanie)

Instrumentuj flow anulowania (zdarzenia i powody)

Jeśli chcesz rozumieć churn (i poprawiać retencję), flow anulowania to najcenniejszy „moment prawdy”. Instrumentuj go jak powierzchnię produktu, nie formularz — każdy krok powinien generować jasne, porównywalne zdarzenia.

Śledź kluczowe kroki (i upewnij się, że nie da się ich pominąć)

Przynajmniej zbieraj czysty ciąg zdarzeń, żeby później zbudować lejek:

cancel_started— użytkownik otwiera doświadczenie anulowaniaoffer_shown— pokazano ofertę uratowania, opcję pauzy, ścieżkę downgrade lub CTA „porozmawiaj z supportem”offer_accepted— użytkownik akceptuje ofertę (pauza, rabat, downgrade)cancel_submitted— potwierdzono anulowanie

Nazwy zdarzeń powinny być spójne między web/mobile i stabilne w czasie. Jeśli ewoluuje payload, podbij wersję schematu (np. schema_version: 2) zamiast cichej zmiany znaczeń.

Zbieraj kontekst wyjaśniający dlaczego to się zdarzyło

Każde zdarzenie związane z anulowaniem powinno zawierać te same pola kontekstowe, by można było segmentować bez domysłów:

- plan, staż, cena

- kraj, urządzenie

- kanał pozyskania

Trzymaj je jako properties na zdarzeniu (nie wywnioskowane później), żeby uniknąć zepsutej atrybucji, gdy inne systemy się zmienią.

Zbieraj powody churnu, które da się analizować i czytać

Użyj predefiniowanej listy powodów (do wykresów) oraz opcjonalnego pola tekstowego (dla niuansu).

cancel_reason_code(np.too_expensive,missing_feature,switched_competitor)cancel_reason_text(opcjonalny)

Przechowuj powód przy cancel_submitted, a rozważ także logowanie go już przy pierwszym wyborze (pomaga wykryć niezdecydowanie lub przepychanki).

Nie zatrzymuj się na anulowaniu: śledź outcome’y

Aby mierzyć interwencje retencyjne, loguj downstream outcome’y:

reactivateddowngradedsupport_ticket_opened

Majac te zdarzenia, połączysz intencję anulowania z wynikami i uruchomisz eksperymenty bez sporów o „co dane naprawdę znaczą”.

Zaprojektuj pipeline danych i magazyn

Dobra analityka churnu zaczyna się od nudnych, ale dobrych decyzji: gdzie żyją zdarzenia, jak są oczyszczane i jak wszyscy zgadzają się co do tego, co oznacza „anulowanie”.

Wybierz magazyn: OLTP + (opcjonalnie) hurtownia

Dla większości MVP przechowuj surowe zdarzenia śledzenia najpierw w głównej bazie aplikacji (OLTP). To proste, transakcyjne i łatwe do debugowania.

Jeśli spodziewasz się dużego wolumenu lub ciężkiego raportowania, dodaj hurtownię analityczną później (replica Postgresa, BigQuery, Snowflake, ClickHouse). Powszechny wzorzec: OLTP jako „źródło prawdy” + hurtownia dla szybkich dashboardów.

Główne tabele, które warto mieć

Projektuj tabele wokół „co się wydarzyło”, a nie „co myślisz, że będziesz potrzebować”. Minimalny zestaw:

events: jeden wiersz na zdarzenie śledzenia (np.cancel_started,offer_shown,cancel_submitted) zuser_id,subscription_id, znacznikami czasu i właściwościami JSON.cancellation_reasons: znormalizowane wiersze dla wybranych powodów, w tym opcjonalny tekst.experiment_exposures: kto widział którą wariantę, kiedy i w jakim kontekście (feature flag / nazwa testu).

To rozdzielenie utrzymuje analitykę elastyczną: możesz łączyć powody i eksperymenty z anulowaniami bez duplikowania danych.

Późne zdarzenia, duplikaty i idempotencja

Flow anulowania generuje retry (przycisk wstecz, problemy sieciowe, odświeżanie). Dodaj idempotency_key (lub event_id) i wymuś unikalność, żeby to samo zdarzenie nie było liczone dwa razy.

Zdecyduj też politykę dla zdarzeń późnych (mobile/offline): zwykle akceptuj je, ale używaj oryginalnego znacznika czasu do analiz i czasu ingestu do debugowania.

ETL/ELT dla wydajności raportowania

Nawet bez pełnej hurtowni zbuduj lekkie zadanie, które buduje „tabele raportowe” (agregaty dzienne, kroki lejkowe, snapshoty kohort). To utrzyma dashboardy szybkie i zmniejszy kosztownych joinów na surowych zdarzeniach.

Dokumentuj definicje, by metryki się zgadzały

Napisz krótką słownik danych: nazwy zdarzeń, wymagane właściwości i wzory metryk (np. „churn rate używa cancel_effective_at”). Umieść to w repozytorium lub wewnętrznych docs, żeby produkt, dane i inżynieria interpretowali wykresy tak samo.

Zbuduj pulpit: lejki, kohorty i segmenty

Zainstrumentuj ścieżkę anulowania

Zaimplementuj śledzenie cancel_started, offer_shown i cancel_submitted z czystymi payloadami.

Dobry pulpit nie próbuje odpowiadać na każde pytanie naraz. Ma pozwalać przejść od „coś wygląda źle” do „oto dokładna grupa i krok, który to powoduje” w paru kliknięciach.

Główne widoki, których będziesz używać co tydzień

Zacznij od trzech widoków, które odzwierciedlają sposób, w jaki ludzie badają churn:

- Lejek anulowań: od

cancel_started→ wybór powodu →offer_shown→offer_acceptedlubcancel_submitted. Pokazuje, gdzie ludzie odpadają i gdzie flow uratowania działa (lub nie). - Rozkład powodów: podział wybranych powodów anulowania, z kubełkiem „Inne (tekst)” do próbkowania. Pokaż liczniki i % dla łatwo widocznych skoków.

- Kohorty wg miesiąca startu: retencja lub wskaźnik anulowań wg miesiąca rozpoczęcia subskrypcji. Kohorty utrudniają złudzenia związane z sezonowością lub zmianą miksu pozyskania.

Segmenty, które czynią wnioski wykonalnymi

Każdy wykres powinien dawać możliwość filtrowania według atrybutów wpływających na churn i akceptację ofert:

- Plan lub poziom

- Staż (np. 0–7 dni, 8–30, 31–90, 90+)

- Region / kraj

- Kanał pozyskania (organic, paid, partner, sales)

- Metoda płatności (karta, faktura, PayPal itp.)

Utrzymaj domyślny widok „Wszyscy klienci”, ale pamiętaj: cel to znaleźć który wycinek się zmienia, a nie tylko czy churn się zmienił.

Kontrolki czasu i wydajność „save flow”

Dodaj szybkie presety dat (ostatnie 7/30/90 dni) plus zakres niestandardowy. Używaj tej samej kontroli czasu we wszystkich widokach, by unikać niespójnych porównań.

Dla pracy nad retencją śledź save flow jako mini-lejek z wpływem biznesowym:

- Wyświetlenia ofert

- Współczynnik akceptacji ofert

- Net retained MRR (MRR utrzymany po rabatach, kredytach lub downgrade’ach)

Drill-down bez łamania zaufania

Każdy agregowany wykres powinien umożliwiać przejście do listy dotkniętych kont (np. „klienci, którzy wybrali 'Za drogo' i anulowali w ciągu 14 dni”). Uwzględnij kolumny takie jak plan, staż i ostatnia faktura.

Ogranicz drill-down za pomocą uprawnień (role-based access) i rozważ maskowanie wrażliwych pól domyślnie. Pulpit ma umożliwiać dochodzenie przy zachowaniu prywatności i reguł dostępu.

Dodaj framework eksperymentów (A/B i targetowanie)

Aby zmniejszać rezygnacje, potrzebujesz wiarygodnego sposobu testowania zmian (kopii, ofert, czasu, UI) bez polegania na opiniach. Framework eksperymentów to „dyrygent ruchu”, który decyduje, kto co widzi, zapisuje to i wiąże wyniki z wariantem.

1) Zdefiniuj jednostkę eksperymentu (unikaj cross-contamination)

Zdecyduj, czy przypisanie dzieje się na poziomie account czy user.

- Na poziomie konta jest zwykle najbezpieczniejsze dla SaaS: wszyscy w tym samym workspace widzą ten sam wariant, co zapobiega mieszanym komunikatom i zanieczyszczeniu wyników.

- Na poziomie użytkownika działa w aplikacjach konsumenckich, ale uważaj na współdzielone urządzenia, wielokrotne loginy czy konta zespołowe.

Zapisz ten wybór dla każdego eksperymentu, by analiza była spójna.

2) Wybierz metodę przypisywania

Wspieraj kilka trybów targetowania:

- Losowy (klasyczny A/B): dobry default.

- Ważony (np. 90/10): przydatne przy ostrożnych rolloutach.

- Reguły: pokazuj wariant tylko konkretnym segmentom (poziom planu, kraj, staż, „jest bliski anulowania”). Trzymaj reguły proste i wersjonowane.

3) Loguj ekspozycję, gdy faktycznie nastąpi

Nie liczaj „assigned” jako „exposed”. Loguj ekspozycję, gdy użytkownik naprawdę zobaczy wariant (np. render ekranu anulowania, otwarcie modalnego okna oferty). Zapisz: experiment_id, variant_id, id jednostki (account/user), timestamp i kontekst (plan, liczba miejsc).

4) Zdefiniuj metryki: primary + guardrails

Wybierz jedną metrykę sukcesu, np. save rate (cancel_started → outcome utrzymania). Dodaj guardrails, by zapobiegać szkodliwym zwycięstwom: kontakty do supportu, żądania zwrotów, wskaźnik reklamacji, time-to-cancel czy churn po downgrade.

5) Zaplanuj czas trwania i założenia próby

Przed uruchomieniem zdecyduj:

- Minimalny czas trwania (często 1–2 cykle billingowe dla zachowań subskrypcyjnych)

- Minimalny rozmiar próby bazujący na obecnym wskaźniku uratowań i najmniejszym wzroście, który cię interesuje

To zapobiega wcześniejszemu zatrzymaniu na hałaśliwych danych i pomaga dashboardowi rozróżniać „ciągle się uczimy” od „statystycznie użyteczne”.

Projektuj interwencje retencyjne do testów

Wysyłaj szybciej do produkcji

Wdróż i hostuj aplikację analityczną, żeby zespół mógł korzystać z niej w produkcji szybciej.

Interwencje retencyjne to „opcje, które pokazujesz lub oferujesz” podczas anulowania, które mogą zmienić decyzję bez poczucia oszustwa. Celem jest dowiedzieć się, które opcje zmniejszają churn, zachowując zaufanie.

Typowe warianty interwencji do wypróbowania

Zacznij od niewielkiego menu wzorców, które możesz mieszać:

- Alternatywne oferty: ograniczony czas rabatu, darmowy miesiąc lub przedłużony trial

- Opcja pauzy: pozwól wstrzymać billing na 1–3 miesiące (z jasnymi oczekiwaniami co do re-aktywacji)

- Downgrade planu: przejście na tańszy poziom lub mniej miejsc zamiast pełnego anulowania

- Kopia komunikatu: krótka, konkretna wiadomość przypominająca o wartości („Eksportuj dane w każdej chwili”) vs. generyczna („Przykro nam, że odchodzisz”)

Projektuj oferty, które nie więżą użytkowników

Każdy wybór powinien być jasny i — tam gdzie możliwe — odwracalny. Ścieżka „Anuluj” powinna być widoczna i wymagać minimum zachodu. Jeśli oferujesz rabat, powiedz dokładnie, jak długo trwa i do jakiej ceny wróci. Jeśli oferujesz pauzę, pokaż co się stanie z dostępem i datami rozliczeń.

Dobre kryterium: użytkownik powinien móc opisać swój wybór jednym zdaniem.

Stosuj progressive disclosure

Utrzymuj flow lekkim:

- Zapytaj o powód (jedno dotknięcie)

- Pokaż dopasowaną odpowiedź (pauza dla „za drogo”, downgrade dla „nie używam”, support dla „błędy”)

- Potwierdź ostateczny wynik (pauza/downgrade/anulowanie)

To zmniejsza tarcie i utrzymuje kontekst trafny.

Dodaj stronę wyników i changelog

Stwórz wewnętrzną stronę wyników eksperymentu pokazującą: konwersję do outcome’u „uratowany”, churn, lift vs. kontrola i przedział ufności lub proste reguły decyzyjne (np. „deploy jeśli lift ≥ 3% i próba ≥ 500”).

Prowadź changelog testów i wypuszczeń, żeby nie powtarzać pomysłów i móc łączyć zmiany retencji z konkretnymi wdrożeniami.

Prywatność, bezpieczeństwo i kontrola dostępu

Dane o anulowaniach to jedne z najbardziej wrażliwych danych produktowych: często zawierają kontekst rozliczeniowy, identyfikatory i tekst, który może zawierać dane osobowe. Traktuj prywatność i bezpieczeństwo jako wymagania produktowe, nie dodatek.

Uwierzytelnianie i role

Zacznij od dostępu tylko po uwierzytelnieniu (SSO, jeśli możesz). Dodaj proste, jawne role:

- Admin: zarządza ustawieniami, retencją danych, dostępem i eksportami.

- Analityk: widzi pulpit, tworzy segmenty, uruchamia eksperymenty.

- Support: widzi historię klienta potrzebną do pomocy (ograniczone pola).

- Read-only: widzi agregaty bez możliwości drill-down.

Sprawdzaj role po stronie serwera, nie tylko w UI.

Minimalizuj ekspozycję danych wrażliwych

Ogranicz, kto może zobaczyć rekordy na poziomie klienta. Preferuj agregaty domyślnie, a drill-down za mocniejszymi uprawnieniami.

- Maskuj identyfikatory (email, customer ID) w UI tam, gdzie możliwe.

- Hashuj identyfikatory do łączeń i deduplikacji (np. SHA-256 z sekretowym saltem), by analitycy mogli segmentować bez dostępu do surowego PII.

- Oddziel tabele „billing/identity” od tabel analitycznych, łącząc je przez zahashowany klucz.

Zasady retencji danych

Zdefiniuj retencję z góry:

- Przechowuj dane zdarzeń tylko tak długo, jak potrzebne do analizy kohort (np. 13–18 miesięcy).

- Zastosuj krótszą retencję lub redakcję dla wolnotekstowych powodów anulowania, które mogą zawierać przypadkowe dane osobowe.

- Zapewnij workflow usuwania, by honorować żądania użytkowników i polityki wewnętrzne.

Logi audytu

Loguj dostęp do pulpitu i eksportów:

- Kto przeglądał strony na poziomie klienta

- Kto eksportował dane, kiedy i z jakimi filtrami

- Zmiany admina w retencji i uprawnieniach

Lista kontrolna bezpieczeństwa przed uruchomieniem

Zabezpiecz podstawy: OWASP top (XSS/CSRF/injection), TLS wszędzie, najmniejsze uprawnienia do bazy, zarządzanie sekretami (bez kluczy w kodzie), rate limiting na endpointach auth i przetestowane procedury backup/restore.

Plan implementacji (frontend, backend i testy)

Ta część mapuje budowę na trzy obszary — backend, frontend i jakość — żebyś mógł wypuścić MVP spójne, wystarczająco szybkie i bezpieczne do ewolucji.

Backend: subskrypcje, zdarzenia i eksperymenty

Zacznij od małego API obsługującego CRUD dla subskrypcji (create, update status, pause/resume, cancel) i przechowującego kluczowe daty lifecycle. Utrzymaj ścieżki zapisu proste i walidowane.

Następnie dodaj endpoint do ingestii zdarzeń dla akcji typu „otworzono stronę anulowania”, „wybrano powód” i „potwierdzono anulowanie”. Preferuj ingestię po stronie serwera (z backendu), by zmniejszyć wpływ adblockerów i manipulacji. Jeśli musisz akceptować zdarzenia z klienta, podpisuj żądania i ograniczaj rate.

Dla eksperymentów retencyjnych zaimplementuj przypisywanie eksperymentów po stronie serwera, by to samo konto zawsze otrzymywało ten sam wariant. Typowy wzorzec: pobierz eligible experiments → hash (account_id, experiment_id) → przypisz wariant → zapisz przypisanie.

Jeśli chcesz szybciej prototypować, platforma vibe-coding taka jak Koder.ai może wygenerować fundament (pulpit w React, backend w Go, schemat PostgreSQL) z krótkiego speca w czacie — potem możesz eksportować kod źródłowy i dopasować model danych, kontrakty zdarzeń i uprawnienia.

Frontend: pulpit, filtry i eksporty

Zbuduj kilka stron pulpitu: lejki (cancel_started → offer_shown → cancel_submitted), kohorty (wg miesiąca rejestracji) i segmenty (plan, kraj, kanał pozyskania). Trzymaj filtry spójne między stronami.

Dla kontrolowanego udostępniania zapewnij eksport CSV z ograniczeniami: domyślnie eksportuj agregaty, wymagaj podwyższonych uprawnień dla eksportów wierszowych i loguj eksporty do audytu.

Podstawy wydajności

Używaj paginacji dla list zdarzeń, indeksuj typowe filtry (data, subscription_id, plan) i dodaj pre-aggregacje dla ciężkich wykresów (dzienne liczniki, tabele kohort). Cache’uj podsumowania „ostatnich 30 dni” z krótkim TTL.

Testy i niezawodność

Napisz testy jednostkowe dla definicji metryk (np. co liczy się jako „cancelation started”) i dla spójności przypisywania (to samo konto zawsze trafia do tej samej warianty).

Dla błędów ingestii zaimplementuj retry i dead-letter queue, by zapobiec cichej utracie danych. Eksponuj błędy w logach i na stronie admina, żeby naprawić problemy zanim zniekształcą decyzje.

Wdróż, monitoruj i utrzymuj wiarygodność danych

Skaluj gdy będziesz gotowy

Przejdź dalej od podstaw, gdy Twoja liczba zdarzeń i wymagania dashboardów wzrosną.

Wypuszczenie aplikacji do analizy rezygnacji to połowa pracy. Druga połowa to utrzymanie jej dokładności, gdy produkt i eksperymenty zmieniają się co tydzień.

Wybierz sposób wdrożenia

Wybierz najprostsze rozwiązanie dopasowane do stylu operacyjnego zespołu:

- Managed hosting (PaaS): najszybsza droga do produkcji, jeśli chcesz wbudowane deploye, logi i autoskalowanie.

- Kontenery (Docker + orchestrator): gdy potrzebujesz powtarzalnych buildów i większej kontroli nad zależnościami.

- Serverless: dobre przy skokowych obciążeniach (ingest zdarzeń, zadania harmonogramowe), ale miej na oku cold starty i limity dostawcy.

Niezależnie od wyboru, traktuj aplikację analityczną jak system produkcyjny: wersjonuj ją, automatyzuj deploye i trzymaj konfigurację w zmiennych środowiskowych.

Jeśli nie chcesz od razu trzymać całego pipeline’u, Koder.ai może też pomóc z wdrożeniem i hostingiem (w tym obsługą domen), oraz obsługą snapshotów i rollbacków — przydatne, gdy szybko iterujesz nad wrażliwym flow anulowania.

Oddziel środowiska (i dane)

Stwórz dev, staging i production z jasną separacją:

- Oddzielne bazy i bucket’y, by testowe zdarzenia nie zanieczyściły metryk.

- Dedykowane staging odzwierciedlające schemat i routing produkcji.

- Osobne przestrzenie eksperymentów (np. prefixy experiment ID w nie-prod), by nie powstawały „fantomowe warianty” w dashboardzie.

Monitoring, który chroni decyzje

Monitorujesz nie tylko uptime — monitorujesz prawdę:

- Dostępność/health API, workerów i pulpitu

- Opóźnienie ingestii (czas zdarzenia vs. czas przetworzenia) z alertami, gdy dryfuje

- Błędy przypisywania eksperymentów: nagłe wzrosty „unassigned units”, zaburzenia równowagi wariantów lub zmiany przypisywania tego samego konta

Zautomatyzowane joby walidacyjne

Planuj lekkie checki, które głośno alarmują:

- Brak kluczowych zdarzeń (np.

cancel_startedbezcancel_submitted, gdy oczekiwane) - Zmiany schematu (nowe/usunięte właściwości, zmiana typów, niespodziewane enumy)

- Anomalie wolumenu (zdarzenia spadają do niemal zera po release)

Plan rollbacku dla UI eksperymentów

Dla każdego eksperymentu wpływającego na flow anulowania zaplanuj rollback:

- Feature flagi do natychmiastowego wyłączenia wariantów

- Szybka ścieżka do redeployu ostatniej znanej dobrej wersji

- Notatka w dashboardzie oznaczająca okno rollbacku, by analitycy nie źle interpretowali danych

Operuj systemem: od wniosku do ciągłych eksperymentów

Aplikacja do analizy rezygnacji zapłaci się tylko wtedy, gdy stanie się nawykiem, nie jednorazowym raportem. Cel to przekształcić „zauważyliśmy churn” w stałą pętlę insight → hipoteza → test → decyzja.

Prosta cotygodniowa rutyna

Wybierz stały czas w tygodniu (30–45 minut) i utrzymuj rytuał lekki:

- Przejrzyj pulpit pod kątem zmian kluczowych metryk (ogólny churn, churn wg planu, churn wg stażu, top powody).

- Wskaż jedną anomalię wartą zbadania (np. skok churnu wśród rocznych odnówień lub powód, który nagle awansował na #1).

- Wybierz dokładnie jedną hipotezę do przetestowania w następnym tygodniu.

Ograniczenie do jednej hipotezy wymusza jasność: co wierzymy, że się dzieje, kogo to dotyczy i jaka akcja może zmienić wynik?

Priorytetyzuj eksperymenty (wpływ × wysiłek)

Unikaj uruchamiania zbyt wielu testów naraz — zwłaszcza w flow anulowania — bo nakładające się zmiany utrudniają wiarygodność wyników.

Użyj prostej macierzy:

- Wysoki wpływ / niski wysiłek: rób jako pierwsze (zmiany copy, przekierowanie do supportu, oferta roczna).

- Wysoki wpływ / wysoki wysiłek: zaplanuj je (elastyczność billingowa, poprawki produktowe).

- Niski wpływ: odłóż.

Jeśli dopiero zaczynasz z eksperymentowaniem, uzgodnij podstawy i reguły decyzyjne przed wdrożeniem: /blog/ab-testing-basics.

Zamknij pętlę z wkładem jakościowym

Liczby mówią co się dzieje; notatki supportu i komentarze anulowania często mówią dlaczego. Co tydzień próbkuj kilka niedawnych rezygnacji z każdego segmentu i streszczaj tematy. Następnie przypisz tematy do testowalnych interwencji.

Zbuduj playbook „wygrywających interwencji”

Rejestruj wnioski w czasie: co działało, dla kogo i w jakich warunkach. Przechowuj krótkie zapisy typu:

- Definicja segmentu (plan, staż, użycie)

- Hipoteza i zmiana

- Wynik i stopień ufności

- Dalsze działanie (wdróż, iteruj lub wycofaj)

Gdy będziesz gotowy standaryzować oferty (i unikać ad-hoc rabatów), powiąż playbook z packagingiem i limitami: /pricing.