26 wrz 2025·7 min

Stwórz aplikację webową wykrywającą spadki użycia i ryzyko rezygnacji

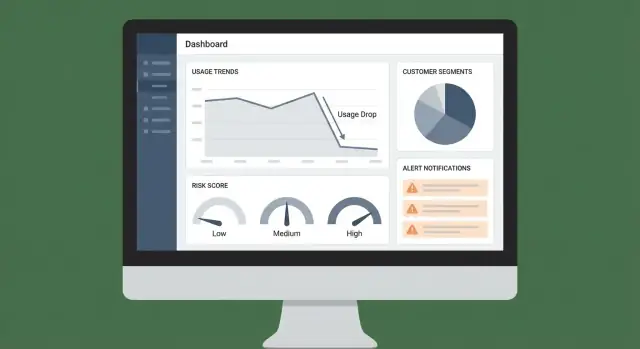

Dowiedz się, jak zbudować aplikację webową, która wykrywa spadki użycia klientów, oznacza sygnały ryzyka rezygnacji i uruchamia alerty, pulpity oraz procesy następcze.

Co budujesz i dlaczego ma to znaczenie

Ten projekt to aplikacja webowa, która pomaga wcześnie wykrywać istotne spadki użycia klientów — zanim przerodzą się w rezygnację. Zamiast czekać na rozmowę o odnowieniu, aplikacja wyświetla wyraźny sygnał (co się zmieniło, kiedy i o ile) i podpowiada właściwy zespół do reakcji.

Cel: wcześniejsze wykrywanie, lepsze utrzymanie

Spadki użycia często pojawiają się tygodnie przed prośbą o anulowanie. Twoja aplikacja powinna czynić te spadki widocznymi, wyjaśnialnymi i wykonalnymi. Praktyczny cel jest prosty: zmniejszyć churn, łapiąc ryzyko wcześniej i reagując konsekwentnie.

Dla kogo to jest (i czego potrzebuje każda grupa)

Różne zespoły szukają różnych „prawd” w tych samych danych. Projektowanie z myślą o użytkownikach zapobiega temu, by aplikacja stała się kolejnym bezużytecznym dashboardem.

- Customer Success potrzebuje priorytetyzowanego widoku kont wymagających uwagi oraz wystarczającego kontekstu do rozpoczęcia świadomego kontaktu.

- Sprzedaż (szczególnie AM) potrzebuje flag ryzyka z orientacją na odnowienia i punktów rozmowy wspierających ekspansję albo ratowanie umowy.

- Product i zespoły analityczne potrzebują zagregowanych trendów, które uwidaczniają tarcia, luki w adopcji lub funkcje, które nie dostarczają wartości.

Wyniki, które dostarczasz

Minimally aplikacja powinna generować:

- Panel zdrowia klienta z ostatnimi trendami użycia i wskaźnikami ryzyka

- Alerty, gdy konto przekroczy znaczący próg (spadek, inaktywność lub zmiana wzorca)

- „Następne najlepsze akcje” sugerujące, co zrobić dalej (wiadomość, telefon, szkolenie, naprawa lub eskalacja wewnętrzna)

To różnica między „danymi gdzieś dostępnymi” a „workflowem, którego ludzie faktycznie przestrzegają”.

Jak będziesz mierzyć sukces

Zdefiniuj sukces jak produkt: metrykami.

- Precyzja: spośród alertowanych kont, ile rzeczywiście było w ryzyku?

- Czas reakcji: jak szybko zespół angażuje się po sygnale?

- Wpływ biznesowy: odnowienia uratowane, churn zredukowany lub ekspansje ochronione

Jeśli aplikacja poprawia decyzje i przyspiesza działanie, zyska adopcję — i się zwróci.

Zdefiniuj spadki użycia i jednostkę klienta

Zanim wykryjesz „spadek użycia”, potrzebujesz precyzyjnej definicji użycia i spójnej jednostki pomiaru. To mniej kwestia żargonu analitycznego, a bardziej unikanie fałszywych alarmów (lub pominięcia prawdziwego ryzyka).

Co powinno oznaczać „użycie”

Wybierz jedną główną metrykę użycia, która odzwierciedla realną wartość dostarczaną. Dobre opcje zależą od produktu:

- Kluczowe zdarzenia: np. utworzone raporty, wysłane wiadomości, zakończone wdrożenia

- Sesje lub aktywne dni: przydatne, gdy wiele akcji jest lekkich

- Minuty / zużycie: typowe dla wideo, połączeń, compute lub narzędzi intensywnie korzystających z API

- Aktywne miejsca (seats): liczba odrębnych użytkowników, którzy wykonali znaczącą pracę

Celuj w metrykę trudną do „oszukania” i ściśle związaną z intencją odnowienia. Możesz śledzić wiele metryk później, ale zacznij od tej, którą potrafisz wyjaśnić w jednym zdaniu.

Jednostka klienta: kto „spada”?

Zdefiniuj byt, który będziesz oceniać i na który będziesz wysyłać alerty:

- Konto/workspace (najczęstsze w B2B)

- Subskrypcja (przydatne, gdy jedna firma ma wiele planów)

- Kohorta wewnątrz konta (np. dział) jeśli adopcja bardzo się różni

Wybór wpływa na wszystko: agregację, dashboardy, własność i kierowanie alertów do właściwego zespołu.

Co liczy się jako „spadek”

Ustal progi dopasowane do zachowań klientów:

- Zmiana tydzień-do-tygodnia (proste i wyjaśnialne)

- Średnia krocząca vs. poprzednia średnia krocząca (redukuje szum)

- Bazy uwzględniające sezonowość (istotne przy wzorcach dni roboczych/weekendów)

Zadecyduj też o oknie czasowym (dziennie kontra tygodniowo) i o tym, ile opóźnienia raportowania akceptujesz (np. „alerty do 9:00 następnego dnia” vs. w czasie rzeczywistym). Jasne definicje zapobiegają zmęczeniu alertami i budują zaufanie do wyników.

Wybierz źródła danych i podejście integracyjne

Twoja aplikacja jest tak wiarygodna, jak wejścia, które obserwuje. Zanim zbudujesz dashboardy czy punktowanie ryzyka, zdecyduj, które systemy definiują „użycie”, „wartość” i „kontekst klienta” dla twojego biznesu.

Wybierz minimalny zestaw systemów źródłowych

Zacznij od wąskiego zbioru źródeł danych, które możesz utrzymać w dobrej jakości:

- Zdarzenia produktowe: logowania, kluczowe akcje, wywołania API, używane miejsca, eksporty — cokolwiek koreluje z wartością

- Biling/subskrypcje: plan, data odnowienia, status płatności, rozszerzenia/obniżki, start/koniec triala

- CRM: właściciel konta, segment, etap cyklu życia, warunki umowy

- Zgłoszenia supportu: wolumen, ciężkość, czasy odpowiedzi, nierozwiązane problemy

- Historia statusu/incydentów: awarie i okresy pogorszonej wydajności, które mogą wyjaśnić spadki użycia

Jeśli nie jesteś pewien, priorytetyzuj zdarzenia produktowe + biling najpierw; CRM/support możesz dodać, gdy monitorowanie podstawowe zadziała.

Zdecyduj, jak dane będą napływać (i jak często)

Są trzy powszechne metody ingestii, a wiele zespołów używa mieszanki:

- Webhooks/streaming dla niemal w czasie rzeczywistym zdarzeń produktowych i zmian subskrypcji

- Importy batchowe (dziennie/godzinowo) dla CRM i narzędzi supportu, które nie wymagają sekundowej świeżości

- Konektory ETL/ELT gdy chcesz zarządzane synchronizacje z narzędzi jak Salesforce/Zendesk i wolisz spójność nad customowym kodem

Dopasuj kadencję do decyzji, które chcesz zautomatyzować. Jeśli planujesz ostrzegać CSM w ciągu godziny od nagłego spadku, ingestia zdarzeń nie może być „raz na dzień”.

Popraw identyfikatory (albo wszystko się rozbije)

Spadki wykrywa się per jednostkę klienta (konto/tenant). Zdefiniuj i utrwal mapowania wcześnie:

- Account ID (tenant/workspace) jako główny klucz grupujący

- User ID powiązane z kontem (użytkownicy mogą się przemieszczać — śledź historię)

- Plan ID / subscription ID powiązane z okresami bilingowymi

Utwórz jedną tabelę/serwis mapowania tożsamości, aby każda integracja rozwiązywała się do tego samego konta.

Udokumentuj własność i dostęp z wyprzedzeniem

Spisz, kto jest właścicielem każdego zbioru danych, jak jest aktualizowany i kto może go przeglądać. To zapobiega zablokowaniom przy uruchomieniu, gdy dodasz wrażliwe pola (szczegóły bilingowe, notatki supportu) lub będziesz musiał wytłumaczyć metryki interesariuszom.

Zamodeluj dane dla metryk, sygnałów i historii

Dobry model danych utrzymuje aplikację szybką, wyjaśnialną i łatwą do rozbudowy. Nie przechowujesz tylko zdarzeń — przechowujesz decyzje, dowody i ślad tego, co się wydarzyło.

Podstawowe encje (źródło prawdy)

Zacznij od kilku stabilnych tabel, do których będą odnosić się pozostałe elementy:

- accounts: account_id, name, plan, status, timezone, CSM owner

- users: user_id, account_id, role, created_at, last_seen_at

- subscriptions: account_id, start/end dates, MRR, seats, renewal date

- events: event_id, occurred_at, user_id, account_id, event_name, properties (JSON)

Utrzymuj ID spójne między systemami (CRM, biling, produkt), aby można było łączyć dane bez zgadywania.

Agregacja dla wydajności: metryki dzienne i użycie funkcji

Querywanie surowych zdarzeń dla każdego widoku dashboardu szybko staje się kosztowne. Zamiast tego precomputeuj migawki jak:

- account_daily_metrics: account_id, date, active_users, sessions, key_actions, time_in_product

- account_feature_daily: account_id, date, feature_key, usage_count (lub minuty, użyte miejsca, itd.)

Taka struktura wspiera zarówno widoki wysokiego poziomu, jak i szczegółowe dochodzenia („użycie spadło — gdzie dokładnie?”).

Przechowuj sygnały ryzyka osobno (z dowodami)

Traktuj detekcję ryzyka jako produktowy output. Stwórz tabelę risk_signals zawierającą:

- signal_type (np.

usage_drop_30d,no_admin_activity) - severity (low/med/high)

- timestamp i lookback window

- evidence (liczby, baselines, odnośniki do wierszy metryk)

To utrzymuje punktację przejrzystą: możesz pokazać dlaczego aplikacja oznaczyła konto.

Śledź historię dla audytów i nauki

Dodaj tabele typu append-only:

- health_score_history: account_id, computed_at, score, contributing_signals

- alert_history: triggered_at, channel, recipients, dedupe_key

- actions_taken: created_by, action_type, notes, outcome

Dzięki historii odpowiesz na pytania: „Kiedy wzrosło ryzyko?”, „Które alerty zostały zignorowane?” i „Które playbooki naprawdę zmniejszyły churn?”.

Instrumentuj zdarzenia produktowe i kontrole jakości danych

Pokaż to użytkownikom

Wdróż i hostuj prototyp, aby CS i Sales mogli przetestować go na prawdziwych kontach.

Aplikacja nie wykryje spadków, jeśli zdarzenia bazowe są niespójne lub niekompletne. Ta sekcja dotyczy uczynienia danych zdarzeniowych wystarczająco wiarygodnymi, by zasilały dashboardy, alerty i sygnały ryzyka.

Zdefiniuj prosty plan śledzenia

Zacznij od krótkiej listy zachowań reprezentujących wartość:

- Kluczowe akcje (np. „utworzono projekt”, „zaproszono współpracownika”, „opublikowano raport”)

- Użycie funkcji (które moduły są używane i jak często)

- Sygnały tarcia (błędy, nieudane płatności, odmowy uprawnień)

- Markery wydajności (wolne odpowiedzi API, czas ładowania strony, timeouty)

Bądź praktyczny: jeśli zdarzenie nie napędza metryki, alertu ani workflowu, nie śledź go jeszcze.

Ustandaryzuj schemat zdarzeń

Spójność bije kreatywność. Użyj wspólnego schematu dla każdego zdarzenia:

- event_name (czasownik + obiekt, jak

report_exported) - timestamp (UTC)

- account_id i user_id (wymagane tam, gdzie to stosowne)

- properties (feature, plan, environment, error_code, latency_ms itp.)

Udokumentuj wymagane właściwości dla każdego zdarzenia w lekkim specyfikacji śledzenia, którą zespół może przeglądać w pull requestach.

Preferuj śledzenie po stronie serwera dla krytycznych zdarzeń

Śledzenie po stronie klienta jest użyteczne, ale może być blokowane, gubione lub zdublowane. Dla wysokowartościowych zdarzeń (zmiany bilingowe, udane eksporty, zakończone workflowy) emituj zdarzenia z backendu po potwierdzeniu akcji.

Dodaj automatyczne kontrole jakości danych

Traktuj problemy z danymi jak bugi produktowe. Dodaj kontrole i alerty na:

- Brak lub null account_id/user_id

- Duplikaty (ten sam idempotency key wydarzenia)

- Dryft zegara (timestampy daleko w przyszłości/w przeszłości)

- Nagłe zmiany wolumenu po typie zdarzenia (często zepsute wydanie)

Mały dashboard jakości danych plus codzienny raport do zespołu zapobiegnie cichym awariom, które podkopują wykrywanie ryzyka rezygnacji.

Zaprojektuj system oceny zdrowia i ryzyka klienta

Dobra punktacja zdrowia to mniej „perfekcyjne przewidywanie churnu”, a bardziej pomoc w decyzji, co zrobić dalej. Zacznij prosto, tak aby była wyjaśnialna, i rozwijaj ją wraz z nauką, które sygnały naprawdę korelują z retencją.

Zacznij świadomie od punktacji opartej na regułach

Rozpocznij od niewielkiego zestawu jasnych reguł, które każdy z CS, Sales czy Support zrozumie i będzie mógł debugować.

Na przykład: „Jeśli tygodniowa aktywność spada o 40% w stosunku do poprzedniej 4-tygodniowej średniej, dodaj punkty ryzyka.” Takie podejście sprawia, że niezgodności stają się konstruktywne, bo można wskazać konkretną regułę i próg.

Dodaj ważone sygnały odzwierciedlające realne ryzyko

Gdy podstawowe reguły zadziałają, łącz wiele sygnałów z wagami. Typowe wejścia to:

- Spadek użycia (aktywność produktowa, adopcja kluczowych funkcji, wywołania API)

- Redukcja miejsc (usuwanie licencji, rosnąca liczba nieaktywnych miejsc)

- Nieudane płatności (błędy faktur, odrzucenia kart, zaległe płatności)

- Szczyty zgłoszeń (wolumen supportu, ciężkość, czas do rozwiązania)

Wagi powinny odzwierciedlać wpływ biznesowy i pewność. Niepowodzenie płatności może ważyć więcej niż łagodny spadek użycia.

Oddziel wskaźniki wiodące od opóźnionych

Traktuj wskazniki wiodące (ostatnia zmiana) inaczej niż opóźnione (wolno narastające ryzyko):

- Wiodące: zmiana użycia w ostatnich 7–14 dniach, nagłe skoki błędów

- Opóźnione: zbliżająca się data odnowienia, długoterminowo niska adopcja

To pozwala aplikacji odpowiadać na pytania „Co się zmieniło w tym tygodniu?” i „Kto jest strukturalnie w ryzyku?”.

Zdefiniuj pasma punktów z akcjami

Przekształć wynik liczbowy w pasma z prostymi definicjami:

- Healthy: stabilne lub rosnące użycie; brak krytycznych problemów

- Watch: istotny negatywny trend; monitorować i zachęcać

- At risk: utrzymujący się spadek lub krytyczne sygnały; pilny kontakt

Powiąż każde pasmo z domyślnym krokiem (właściciel, SLA i playbook), aby wynik powodował konsekwentne działania, a nie tylko czerwone oznaczenie na dashboardzie.

Wykrywaj anomalie i znaczące zmiany użycia

Uczyń to oficjalnym

Umieść narzędzie na własnej domenie, aby zespoły traktowały je jako codzienny workflow.

Wykrywanie anomalii jest użyteczne tylko wtedy, gdy odzwierciedla sposób, w jaki klienci faktycznie używają produktu. Celem nie jest oznaczanie każdego zawirowania — chodzi o wychwycenie zmian prognozujących ryzyko rezygnacji i wymagających kontaktu ludzkiego.

Buduj baseliny zgodne z rzeczywistością

Użyj więcej niż jednej bazy odniesienia, aby nie reagować przesadnie:

- Historia konta: porównaj ten tydzień z ostatnimi 4–8 tygodniami dla tego konta

- Średnie segmentu: porównaj do podobnych klientów (tier planu, branża, rozmiar, region), by wykryć „ciche odchodzenie”, które ukrywa się za niskim ogólnym użyciem

- Sezonowość: dopasuj porównania według dnia tygodnia lub miesiąca (np. weekendy, koniec kwartału). Proste podejście: porównaj do średniej tego samego dnia tygodnia z ostatnich N tygodni.

Te baseliny pomagają oddzielić „normalne dla nich” od „coś się zmieniło”.

Nagły spadek vs. stopniowy spadek

Traktuj je inaczej, bo naprawy będą różne:

- Nagłe spadki (np. -70% tydzień-do-tygodnia, nagłe zatrzymanie kluczowych zdarzeń) często wskazują na awarię: outage, rozłączone integracje, zmiany bilingowe, odpływ użytkowników lub problemy z uprawnieniami.

- Stopniowy spadek (np. -10% co tydzień przez miesiąc) zwykle wskazuje na erozję wartości: spadek zaangażowania, odejście championów, wdrożenie konkurencyjnego narzędzia lub nieukończony rollout.

Aplikacja powinna oznaczać wzorzec, ponieważ playbooki i właściciele będą się różnić.

Zmniejsz fałszywe alarmy

Fałszywe alarmy szybko podkopiają zaufanie. Dodaj zabezpieczenia:

- Minimalne progi aktywności: nie alertuj kont o zbyt małej bazie (np. mniej niż 20 kluczowych zdarzeń/tydzień)

- Okresy łaski: ignoruj krótkie przerwy po onboardingu, zmianie planu, świętach lub znanych incydentach

- Okna potwierdzenia: wymagaj, by spadek utrzymał się 2–3 dni (lub 1–2 tygodnie dla produktów o niskiej częstotliwości)

Spraw, by każdy flag był wyjaśnialny

Każdy sygnał ryzyka powinien zawierać dowód: „dlaczego oznaczono” i „co się zmieniło”. Dołącz:

- użytą bazę odniesienia (historia/segment/sezon)

- metrykę i ramy czasowe (np. „wywołania API, ostatnie 7 dni”)

- deltę i próg (np. „-62% vs poprzednia 4-tygodniowa średnia dni roboczych”)

- główne przyczyniające czynniki (np. „3/5 aktywnych użytkowników przestało”, „integracja X przestała wysyłać zdarzenia”)

To zmienia alerty w decyzje, a nie hałas.

Zbuduj UI aplikacji: dashboardy i widoki kont

Dobry UI zamienia chaotyczną telemetrię w codzienny workflow: „Kto wymaga uwagi, dlaczego i co robić dalej?” Trzymaj pierwsze ekrany stanowcze i szybkie — większość zespołów będzie w nich przebywać na co dzień.

Najważniejsze elementy dashboardu

Twój dashboard powinien odpowiadać na trzy pytania na pierwszy rzut oka:

- Trendy: prosty wykres ogólnego użycia (opcjonalnie po kluczowych funkcjach) z porównaniem tydzień-do-tygodnia

- Najbardziej zagrożone konta: posortowana tabela z bieżącym health score, największymi negatywnymi deltami i najsilniejszymi sygnałami ryzyka

- Ostatnie alerty: zwięzły feed pokazujący co odpaliło, kiedy i które jednostki klientów to dotyczy

Niech każdy wiersz będzie klikalny do widoku konta. Preferuj znane wzorce tabel: sortowalne kolumny, przypięte kolumny ryzyka i wyraźny znacznik ostatniego widoku.

Strona konta: pełna historia

Projektuj widok konta wokół osi czasu, aby CSM mógł zrozumieć kontekst w sekundach:

- Oś czasu użycia z adnotacjami (wdrożenia, zmiany planu, zdarzenia bilingowe)

- Kluczowe zdarzenia (kamienie milowe aktywacji, adopcja funkcji, eskalacje supportu)

- Dziennik sygnałów pokazujący każdy sygnał ryzyka: wartość, próg i czas ewaluacji

- Notatki i zadania aby praca była przypięta do konta, a nie rozrzucona po narzędziach

Dołącz wzorzec głębokiego linku wewnętrznego jak /accounts/{id}, aby alerty kierowały bezpośrednio do konkretnego widoku.

Filtry, eksport i udostępnianie

Filtrowanie to miejsce, gdzie dashboardy stają się wykonalne. Zapewnij globalne filtry dla planu, segmentu, branży, właściciela CSM, regionu i etapu cyklu życia, i zapisuj wybory w URL, aby widoki były łatwe do udostępnienia.

Dla eksportu pozwól na pobranie CSV z tabel (z zachowaniem filtrów) i dodaj „Kopiuj link” do udostępniania wewnętrznego — szczególnie z listy najbardziej zagrożonych i feedu alertów.

Twórz alerty, powiadomienia i trasowanie

Zachowaj kontrolę nad wdrożeniem

Eksportuj kod źródłowy, gdy będziesz gotów przenieść projekt do głównego repozytorium.

Alerty są użyteczne tylko wtedy, gdy trafiają do właściwej osoby we właściwym czasie — i nie uczą wszystkich ich ignorować. Traktuj powiadomienia jak część produktu, a nie dodatek.

Zdefiniuj wyzwalacze alertów (co wymaga uwagi)

Zacznij od małego zestawu wyzwalaczy, które mapują się na jasne działania:

- Progi punktów: np. score zdrowia spada poniżej 60 albo ryzyko rezygnacji przekracza 80

- Nagłe spadki użycia: np. 40% spadek tydzień-do-tygodnia w kluczowym zdarzeniu (logowania, wywołania API, aktywne miejsca)

- Wzorce wielosygnałowe: np. spadek użycia i wzrost zgłoszeń supportu, albo zatrzymanie adopcji kluczowej funkcji przez 14 dni

Użyj prostych reguł najpierw, potem dodawaj mądrzejszą logikę (np. detekcję anomalii), gdy zaufasz podstawom.

Wybierz kanały zgodne ze sposobem pracy zespołu

Wybierz jeden kanał główny i jeden zapasowy:

- Email dla podsumowań, dziennych digestów i interesariuszy, którzy nie żyją w chatcie

- Slack dla pilnych alertów kierowanych do #cs-alerts lub dedykowanej rotacji on-call

- Powiadomienia w aplikacji dla wewnętrznych narzędzi, gdzie CSM pracują (najlepsze do trybu „work queue”)

Jeśli nie jesteś pewien, zacznij od Slack + zadań w aplikacji. Email szybko może stać się głośny.

Dodaj trasowanie i deduplikację, aby zapobiec spamowi

Trasuj alerty według własności konta i segmentu:

- Jeśli konto ma właściciela, powiadom CSM

- Jeśli to konto wysokiej wartości, też powiadom liderów CS

- Jeśli sygnał jest techniczny (błędy API, awarie ingestii), powiadom engineering/on-call

Deduplikuj przez grupowanie powtarzających się alertów w jedną konwersację lub ticket (np. „spadek utrzymuje się 3 dni”). Dodaj okna chłodzenia, aby nie wysyłać tego samego alertu co godzinę.

Dołącz kontekst, aby alert był wykonalny

Każdy alert powinien odpowiadać: co się zmieniło, dlaczego to ważne, co zrobić dalej. Dołącz:

- Metrykę(y) które się poruszyły i porównanie do baseline

- Podejrzany driver (funkcja, workspace, grupa miejsc, region)

- Zalecany następny krok (np. „wyślij email sprawdzający” lub „przejrzyj ukończenie onboardingu”)

- Bezpośredni link do widoku konta:

/accounts/{account_id}

Gdy alerty prowadzą prosto do jasnego działania, zespół im zaufa — i będzie ich używać.

Automatyzuj workflowy następcze i playbooki

Wykrycie jest użyteczne tylko wtedy, gdy niezawodnie uruchamia następne najlepsze działanie. Automatyzacja follow-upów zamienia „widzimy spadek” w konsekwentną, mierzalną odpowiedź, która z czasem poprawia retencję.

Przekształć sygnały w playbooki

Zacznij od mapowania każdego sygnału na prosty playbook. Trzymaj playbooki stanowcze i lekkie, aby zespoły je faktycznie stosowały.

Przykłady:

- Spadek użycia kluczowej funkcji: email kontaktowy + propozycja 15-minutowej sesji roboczej

- Nowy admin, ale brak rolloutu: nudge enablement + lista kontrolna

- Szczyt błędów lub latencji: techniczny check-in + poproś logi + otwórz wewnętrzny incydent

Przechowuj playbooki jako szablony: kroki, rekomendowane komunikaty, wymagane pola (np. „root cause”) i kryteria zakończenia (np. „użycie powróciło do baseline przez 7 dni”).

Twórz zadania, których nie da się zignorować

Gdy sygnał odpali, automatycznie utwórz zadanie z:

- Właścicielem (CSM wg konta lub round-robin w kolejce)

- Termin: zależnie od ciężkości; np. wysoki risk w ciągu 4 godzin roboczych

- Śledzeniem statusu (Open → In progress → Blocked → Done)

Dodaj krótki pack kontekstowy do każdego zadania: która metryka się zmieniła, kiedy to się zaczęło, ostatni znany zdrowy okres i ostatnie zdarzenia produktowe. To skraca korespondencję i przyspiesza pierwszy kontakt.

Integruj tam, gdzie zespoły już pracują

Nie zmuszaj wszystkich do nowej karty. Wpychaj zadania i notatki do istniejących systemów i pobieraj rezultaty z powrotem do aplikacji.

Typowe miejsca docelowe to CRM i narzędzia supportu (zob. /integrations/crm). Utrzymuj workflow dwukierunkowy: jeśli zadanie zostanie zamknięte w CRM, odwzoruj to w panelu zdrowia.

Mierz realizację (i pokaż ją)

Automatyzacja powinna poprawiać jakość reakcji, nie tylko ich ilość. Śledź:

- Time-to-contact od alertu do pierwszego kontaktu

- Notatki resolucji (co zrobiono i dlaczego)

- Tagi wyniku (Recovered, Ongoing risk, Product issue, Customer downsized)

Przeglądaj te metryki co miesiąc, aby dopracować playbooki, ulepszyć trasowanie i zidentyfikować, które działania naprawdę korelują z odzyskaniem użycia.

Prototypuj szybciej z Koder.ai (opcjonalnie)

Jeśli chcesz szybko przejść od specyfikacji do działającego narzędzia wewnętrznego, platforma vibe-codingowa jak Koder.ai może pomóc prototypować dashboard, widoki kont i workflow alertów przez czat — potem iterować zachowanie prawdziwego produktu z mniejszym narzutem. Ponieważ Koder.ai potrafi generować aplikacje full-stack (React na web, usługi Go z PostgreSQL) i wspiera snapshoty/rollback oraz eksport kodu źródłowego, to praktyczny sposób na walidację modelu danych, reguł trasowania i flow UI przed dłuższym wdrożeniem.

Często zadawane pytania

Co powinienem użyć jako główną metrykę „użycia” do wykrywania spadków?

Rozpocznij od jednej głównej metryki wartości, którą trudno podrobić i która jest silnie powiązana z intencją odnowienia (np. wykonane kluczowe akcje, wywołania API, aktywne miejsca). Wyjaśnij ją jednym zdaniem, a potem dodawaj metryki pomocnicze dla diagnozy (użycie funkcji, sesje, czas w produkcie).

Na jakim poziomie jednostki klienta aplikacja powinna dokonywać punktacji i wysyłać alerty?

Najlepiej alertować wobec jednego, spójnego podmiotu — zwykle konto/workspace w B2B. Użyj subskrypcji, jeśli jedna firma ma wiele planów, lub podkohorty (np. dział) jeśli adopcja bardzo się różni w obrębie dużego konta. Wybór determinuje agregację, przypisanie właściciela i interpretację dashboardów.

Jak zdefiniować, co liczy się jako „znaczący” spadek użycia?

Praktyczny punkt wyjścia to jasny, oparty na regułach próg, np. zmiana tydzień-do-tygodnia (np. -40% vs priorytetowa średnia 4 tygodni). Następnie dodaj zabezpieczenia:

- Minimalna aktywność bazowa (unikaj małych mianowników)

- Okna potwierdzenia (utrzymanie się spadku przez 2–3 dni / 1–2 tygodnie)

- Okresy łaski przy onboardingu, zmianach planu lub świętach

Jakie źródła danych są najważniejsze dla sygnałów ryzyka rezygnacji?

Zacznij od zdarzeń produktowych + biling/subskrypcje, bo one definiują dostarczaną wartość i ryzyko odnowienia. Dodaj CRM dla kontekstu właściciela/segmentu oraz dane wsparcia/incydentów by wyjaśniać spadki (wzrost zgłoszeń, awarie). Utrzymaj początkowy zestaw mały, aby łatwiej zapewnić jakość danych.

Jak uniknąć błędnych joinów i niezgodnych kont między systemami?

Użyj jednego głównego klucza grupującego, np. account_id/tenant_id, w każdym systemie i utrzymuj warstwę mapowania tożsamości, która łączy:

- identyfikatory kont/workspace

- identyfikatory użytkowników (z historią, jeśli użytkownicy przenoszą się)

- identyfikatory subskrypcji/planów powiązane z okresami bilingowymi

Jeśli identyfikatory nie są spójne, joiny zawodzą, a alerty tracą zaufanie szybko.

Dlaczego warto agregować zdarzenia do metryk dziennych zamiast zapytywać surowe zdarzenia?

Wstępnie obliczaj dzienne snapshoty, aby dashboardy i punktacja nie pytały o surowe zdarzenia przy każdym widoku. Typowe tabele:

account_daily_metrics(aktywni użytkownicy, sesje, kluczowe akcje)account_feature_daily(feature_key, usage_count)

To poprawia wydajność, obniża koszty i przyspiesza analizę „co się zmieniło?”.

Jak sprawić, by alerty i oceny zdrowia były zrozumiałe (nie czarna skrzynka)?

Utwórz dedykowany store risk_signals zawierający:

- typ sygnału i ciężkość

- okno ewaluacji i znacznik czasu

- dowody (baseline, delta, progi, przyczyniające się czynniki)

Dzięki temu każdy flag jest audytowalny i zespoły wiedzą dlaczego konto zostało oznaczone.

Czy zacząć od ML do wykrywania anomalii, czy od prostych reguł?

Zacznij od regułowej punktacji, bo jest odczytywalna i łatwa do uzgodnienia między CS/Sales/Product. Połącz wiele ważonych sygnałów (spadek użycia, niepowodzenia płatności, redukcja miejsc, wzrost zgłoszeń) i rozdziel:

- wskaźniki wiodące (ostatnia zmiana)

- wskaźniki opóźnione (długoterminowe ryzyko)

Przekształć wyniki liczbowo w pasma (Healthy/Watch/At risk) z domyślnymi akcjami i SLA.

Jak zapobiec zmęczeniu alertami i spamowi powiadomień?

Wprowadź trasowanie i deduplikację od początku:

- Trasuj wg właściciela konta i segmentu (CSM, leadership dla kluczowych)

- Wysyłaj sygnały techniczne do engineering/on-call

- Deduplikuj grupując powtarzające się alerty i stosując okna chłodzenia

Dołącz kontekst (metryka, baseline, delta) i link bezpośredni /accounts/{account_id}, aby alert był od razu wykonalny.

Jakie podstawy bezpieczeństwa i prywatności wdrożyć dla aplikacji monitorującej ryzyko rezygnacji?

Wprowadź minimalizację danych i RBAC:

- Przechowuj agregaty i minimalne identyfikatory jeśli to możliwe

- Użyj RBAC, aby zespoły widziały tylko to, co potrzebne

- Dodaj logi audytu dla eksportów/zmian konfiguracyjnych

- Preferuj pobieranie PII na żądanie z CRM zamiast kopiowania

- Zdefiniuj retencję (np. surowe zdarzenia 30–90 dni, agregaty 12–24 miesiące)

Bądź też gotów na żądania usunięcia/anonimizacji i utrzymuj wewnętrzne polityki zgodne z praktyką (np. /privacy, /security).