28 sie 2025·8 min

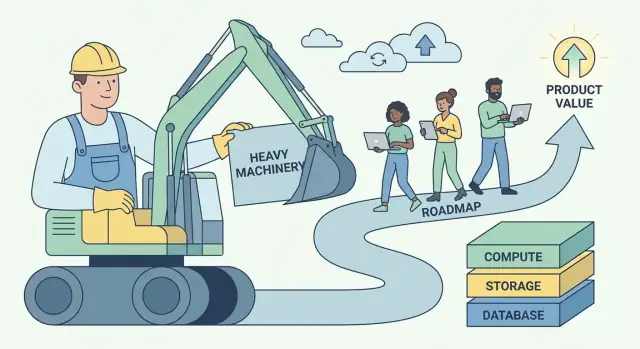

Playbook Andy’ego Jassy’ego dla AWS: jak przemienić ciężką pracę w wartość

Jak Andy Jassy ukształtował AWS wokół „niezróżnicowanej ciężkiej pracy” i przekształcił to w powtarzalny model budowy skalowalnych biznesów i platform programistycznych.

Co naprawdę znaczy „niezróżnicowana ciężka praca"

„Niezróżnicowana ciężka praca" to prosta idea z ostrym brzegiem: to praca, którą musisz wykonać, by uruchomić oprogramowanie, ale która nie sprawia, że klienci wybierają właśnie ciebie.

Obejmuje zadania takie jak provisionowanie serwerów, łatanie baz danych, rotacja poświadczeń, skonfigurowanie monitoringu, obsługa failoveru, skalowanie zasobów i ściganie incydentów produkcyjnych wywołanych przez „instalacje” zamiast produktu. Te prace są realne, ważne i często pilne — ale rzadko tworzą unikalne doświadczenie dla użytkowników.

Definicja prostym językiem

Jeśli zadanie jest:

- konieczne (nie możesz go uniknąć, jeśli chcesz niezawodności)

- powtarzalne (każdy zespół robi podobną wersję)

- bez przewagi konkurencyjnej (klienci nie zapłacą więcej dlatego, że ty to zrobiłeś sam)

…to jest to niezróżnicowana ciężka praca.

Dlaczego wyrażenie trafiło do budowniczych i szefów

Budowniczowie usłyszeli w tym ulgę: pozwolenie, by przestać traktować operacyjną harówkę jak odznakę honoru. Jeśli wszyscy wymyślają na nowo te same skrypty deploymentu i runbooki na alarm, to nie jest kunszt — to zmarnowany fokus.

Szefowie usłyszeli dźwignię: ta kategoria pracy jest kosztowna, słabo skalowalna z liczbą osób i generuje ryzyko. Redukcja tej pracy poprawia marże, niezawodność i szybkość jednocześnie.

Wzorzec biznesowy wskazywany przez tę ideę

AWS spopularyzowało powtarzalny plan działania:

- Usuń trudy przez przekształcenie kruchych, zespołowych operacji w usługę.

- Ustandaryzuj wspólne elementy, by jakość była konsekwentna.

- Skaluj przez automatyzację i współdzieloną infrastrukturę.

- Reinwestuj oszczędności w lepsze produkty i szybsze dostarczanie.

To jest większe niż infrastruktura chmurowa — to „myślenie platformowe” zastosowane w każdym biznesie programowym.

Czego się spodziewać po tym artykule

Przełożymy koncepcję na praktyczne sygnały, które dostrzeżesz we własnym produkcie i zespole, pokażemy, jak zarządzane usługi i wewnętrzne platformy pakują operacje jako produkt, i omówimy rzeczywiste kompromisy (kontrola, koszt, lock‑in). Otrzymasz ramy decyzyjne, by wybrać, co budować, a co kupić — oraz jak zamienić niezróżnicowaną pracę w wartościowy efekt skali.

Główne spostrzeżenie Andy’ego Jassy: klienci chcą budować, nie niańczyć

Andy Jassy był jednym z liderów, którzy przekształcili wewnętrzne możliwości infrastruktury Amazona w to, co stało się AWS. Jego zadanie nie polegało jedynie na „sprzedawaniu serwerów przez internet.” Polegało na zauważeniu powtarzalnego problemu klientów i zapakowaniu rozwiązania, które da się skalować dla tysięcy zespołów.

Prawdziwy ból: operacje kradną uwagę od produktu

Większość zespołów programistycznych nie budzi się z radością, by łatać systemy operacyjne, przydzielać pojemność, rotować klucze czy przywracać system po awarii dysku. Robią to, bo muszą — inaczej aplikacja nie działa.

Kluczowe spostrzeżenie Jassy’ego brzmiało: wiele tej pracy jest konieczne, ale niezróżnicowalne. Jeśli prowadzisz sklep internetowy, aplikację fintech lub narzędzie HR, klienci cenią twoje funkcje: szybsze finalizowanie zakupów, lepsze wykrywanie oszustw, płynniejsze onboardingi. Rzadko nagradzają za perfekcyjnie skalibrowaną flotę serwerów.

Dlatego „niańczenie” infrastruktury staje się podatkiem:

- Zjada czas, który mógłby iść na nowe funkcje.

- Zmusza zespoły do zatrudniania umiejętności, na których nie chcą się specjalizować.

- Zwiększa ryzyko, bo każda firma musi na nowo nauczyć się tych samych lekcji operacyjnych.

Dlaczego timing był ważny

Ta idea pojawiła się w momencie, gdy wymagania rosły z każdej strony:

- Skala internetowa uczyniła ruch nieprzewidywalnym; planowanie pod szczyt było drogie.

- Startupy musiały działać szybko bez budowania zespołu DC.

- IT w korporacjach czuło presję dostarczania szybciej przy zachowaniu bezpieczeństwa i zgodności.

Zasada nie brzmiała „przenieś wszystko do chmury.” Była prostsza: usuń powtarzalne obciążenia operacyjne, aby klienci mogli przeznaczyć więcej energii na to, co ich wyróżnia. Ten zwrot — czas i uwaga z powrotem na budowanie — stał się fundamentem biznesu platformowego.

Jak rozpoznać ciężką pracę we własnym produkcie i zespole

Pierwszym krokiem jest rozdzielenie pracy koniecznej (potrzebnej, by produkt wyglądał wiarygodnie) od różnicowania (powodów, dla których klienci wybierają ciebie).

Prace konieczne nie są „nieistotne”. Często są kluczowe dla niezawodności i zaufania. Ale rzadko same w sobie tworzą przewagę — zwłaszcza gdy konkurenci mogą osiągnąć ten sam poziom.

Typowe sygnały „ciężkiej pracy”

Jeśli nie wiesz, co należy do kubełka niezróżnicowanego, szukaj pracy która jest:

- konieczna, powtarzalna i niepodlegająca negocjacji

- kosztowna gdy zawiedzie, ale większości użytkowników jest niewidoczna gdy działa

- rozwiązywana w podobny sposób w wielu firmach

W zespołach programistycznych często obejmuje to:

- Zarządzanie serwerami lub klastrami

- Łatanie zabezpieczeń i aktualizacje zależności

- Kopie zapasowe i ćwiczenia DR

- Autoskalowanie i planowanie pojemności

- Podstawowy monitoring, logowanie i alertowanie

- Rotacje on‑call dla przewidywalnych trybów awarii

Żadne z tych działań nie jest „złe”. Pytanie brzmi, czy wykonywanie ich samodzielnie jest częścią wartości twojego produktu — czy tylko ceną wejścia.

Najprostsny test: czy klienci za to zapłacą?

Praktyczna reguła:

„Czy klienci zapłaciliby ci specjalnie za to, czy tylko oczekiwaliby, że to będzie wliczone?”

Jeśli odpowiedź brzmi „będą tylko zirytowani, jeśli tego zabraknie”, najpewniej masz do czynienia z niezróżnicowaną ciężką pracą.

Drugi test: jeśli jutro usunąłbyś tę pracę przyjmując usługę zarządzaną, czy twoi najlepsi klienci nadal ceniliby cię za to, co zostanie? Jeśli tak, znalazłeś kandydatę do oddelegowania, automatyzacji lub uprzedmiotowienia.

„Niezróżnicowane” zmienia się w zależności od rynku

To, co jest niezróżnicowane w jednej firmie, może być kluczowym IP w innej. Dostawca baz danych może wyróżniać się na backupach i replikacji. Produkt fintech prawdopodobnie nie powinien. Nie chodzi o kopiowanie czyichś granic — chodzi o ustalenie własnych na podstawie tego, co klienci naprawdę nagradzają.

Gdy mapujesz roadmapę i prace operacyjne przez tę soczewkę, zaczynasz widzieć, gdzie czas, talent i uwaga są zużywane tylko po to, by stać w miejscu.

Dlaczego ta idea tworzy ogromną wartość biznesową

„Niezróżnicowana ciężka praca” to nie tylko trik produktywności. To model biznesowy: weź problem, który wiele firm musi rozwiązać, ale na którym nikt nie chce się wyróżniać, i przekształć go w usługę, za którą chętnie zapłacą.

Skomodytyzowane problemy napędzają platformę

Najlepsze kandydatury to konieczności o niskiej strategicznej unikalności: provisionowanie serwerów, łatanie baz, rotacja poświadczeń, skalowanie kolejek, zarządzanie backupami. Każdy zespół tego potrzebuje, większość woli tego nie budować, a „właściwa odpowiedź" jest szeroko podobna.

Ta kombinacja tworzy przewidywalny rynek: duży popyt, powtarzalne wymagania i jasne metryki sukcesu (uptime, latency, zgodność, czas odzyskiwania). Platforma może ustandaryzować rozwiązanie i ciągle je ulepszać.

Korzyści skali: rozkładanie kosztów stałych na wielu klientów

Doskonałość operacyjna ma duże koszty stałe — SRE, specjaliści ds. bezpieczeństwa, dyżury, audyty, narzędzia do incydentów i monitoring 24/7. Gdy każda firma buduje to osobno, koszty się duplikują tysiące razy.

Platforma rozkłada te inwestycje stałe na wielu klientów. Koszt na klienta maleje wraz z adopcją, a jakość może wzrastać, bo dostawca może uzasadnić głębszą specjalizację.

Pętla niezawodności: specjalizacja zwiększa uptime i bezpieczeństwo

Gdy zespół usługowy obsługuje ten sam komponent dla wielu klientów, widzi więcej edge case’ów, szybciej wykrywa wzorce i buduje lepszą automatyzację. Incydenty stają się wejściem: każda awaria wzmacnia system, ulepsza playbooki i zaostrza zabezpieczenia.

Bezpieczeństwo korzysta podobnie. Dedykowane zespoły mogą inwestować w modelowanie zagrożeń, ciągłe łatanie i kontrole zgodności, co byłoby trudne do utrzymania dla pojedynczego zespołu produktowego.

Siła cenowa: rozliczenie według użycia + zaufanie + koszty zmiany (ostrożnie)

Platformy często zyskują siłę cenową dzięki modelom opłat proporcjonalnym do użycia: klienci płacą w zależności od wartości, jaką konsumują, i mogą zacząć od małego. Z czasem zaufanie staje się wyróżnikiem — niezawodność i bezpieczeństwo czynią usługę „domyślnie bezpieczną”.

Koszty zmiany rosną w miarę pogłębiania integracji, ale najzdrowsza wersja to ta zarobiona, nie wymuszona: lepsza wydajność, lepsze narzędzia, przejrzyste rozliczenia i mniej incydentów. To powoduje odnowienia mimo istnienia alternatyw. (Dla pakowania i monetyzacji zobacz /pricing.)

Wzorzec AWS: od prymitywów do zarządzanych usług

AWS nie wygrało, oferując „serwery w internecie”. Wygrało, wielokrotnie biorąc trudny problem operacyjny, rozbijając go na prostsze bloki konstrukcyjne, a potem ponownie łącząc te bloki w usługi, gdzie AWS prowadzi pracę day‑2 za ciebie.

Powtarzalna drabina: prymityw → usługa → usługa zarządzana → platforma

Pomyśl o tym jak o drabinie dojrzałości:

- Prymitw: Surowe składniki, które możesz sam złożyć (VM, dyski, sieci)

- Usługa: Bardziej opiniotwórcze API wokół możliwości (object storage, load balancing)

- Usługa zarządzana: AWS obsługuje skalowanie, łatanie, backupy i odzyskiwanie po awarii (bazy danych, kolejki)

- Platforma: Portfolio, gdzie usługi komponują się czysto, ze wspólną tożsamością, rozliczeniami, monitoringiem i politykami

Każdy krok usuwa decyzje, utrzymanie i „co jeśli to zawiedzie o 3 rano?” z obowiązków klienta.

Przykłady AWS (mapowanie konceptualne)

AWS zastosowało ten sam wzorzec w kluczowych kategoriach:

-

Compute: Zaczynając od maszyn wirtualnych (EC2). Przechodząc do wyższych poziomów, gdzie deployment i skalowanie stają się domyślne (np. zarządzane kontenery/serwerless). Klient skupia się na kodzie i zamiarach pojemności, nie na opiece nad hostami.

-

Storage: Od wolumenów i systemów plików do object storage (S3). Abstrakcja przesuwa się z „zarządzaj woluminami” do „put/get obiektów”, podczas gdy trwałość, replikacja i skalowanie stają się problemem AWS.

-

Bazy danych: Od „zainstaluj bazę na VM” do zarządzanych baz (RDS, DynamoDB). Backupy, łatanie, repliki tylko do odczytu i failover przestają być niestandardowym runbookiem i stają się konfiguracją.

-

Messaging: Od ręcznie robionych kolejek i workerów do zarządzanych mechanizmów messagingowych (SQS/SNS). Semantyka dostarczenia, retry, i tunning przepustowości zostają ustandaryzowane, więc zespoły budują workflowy zamiast infrastruktury.

Dlaczego abstrakcje redukują obciążenie poznawcze

Usługi zarządzane zmniejszają obciążenie poznawcze na dwa sposoby:

- Mniej elementów do rozważenia. Twój diagram architektury kurczy się z „instancje + skrypty + cron + alerty + backupy” do „usługa + ustawienia”.

- Mniej trybów awarii, za które musisz odpowiadać. Nadal projektujesz odporność, ale już nie odpowiadasz za mechanikę łatania, clusteringu i rutynowego odzyskiwania.

Efekt to szybsze wdrożenie, mniej bespoke runbooków i bardziej spójne operacje między zespołami.

Lista kontrolna do wykorzystania (użyj w swoim produkcie)

- Co klienci budują, co jest konieczne, ale niezróżnicowalne?

- Czy możesz zamienić ich powtarzalne runbooki w jedno, stabilne API?

- Które zadania możesz ustawić jako domyślne (backupy, skalowanie, aktualizacje), zamiast jako opcję?

- Czy „ostre krawędzie" schowane są za sensownymi limitami i strażnikami?

- Czy wiele zespołów może to wykorzystywać bez wiedzy eksperckiej?

- Czy to komponuje się z resztą twojego systemu (tożsamość, monitoring, billing, polityki)?

Opakowywanie operacji jako produktu

Spraw, by budowanie się zwróciło

Zarabiaj kredyty, dzieląc się tym, co zbudujesz z Koder.ai lub polecając współpracownika.

Użyteczny sposób czytania AWS jest taki: nie sprzedaje tylko technologii — sprzedaje operacje. „Produkt" to nie tylko endpoint API — to wszystko, co potrzebne, by bezpiecznie, przewidywalnie i na skali uruchomić daną funkcję.

API vs. samoobsługa vs. pełne zarządzanie

API daje bloki konstrukcyjne. Możesz provisionować zasoby, ale nadal projektujesz strażniki, monitorujesz awarie, obsługujesz aktualizacje i odpowiadasz „kto co zmienił?”.

Samoobsługa dodaje warstwę, z której klienci mogą korzystać bez ticketów: konsola, szablony, sensowne wartości domyślne i automatyczne provisionowanie. Klient nadal odpowiada za większość prac day‑2, ale jest to mniej manualne.

Pełne zarządzanie to sytuacja, w której dostawca bierze na siebie bieżące obowiązki: łatanie, skalowanie, backupy, failover i wiele klas reakcji na incydenty. Klienci skupiają się na konfiguracji czego chcą, a nie jak to utrzymać.

„Nudne” funkcje, których klienci nie mogą się pozbyć

Funkcje, na których ludzie polegają każdego dnia, rzadko są efektowne:

- IAM i uprawnienia: kto może co robić i jak audytowany jest dostęp

- Rozliczenia i widoczność kosztów: budżety, faktury, tagi i alerty

- Limity i rate limits: zabezpieczenia przed wpadkami — i jasne oczekiwania

To nie są poboczne zadania. To część obietnicy, za którą klienci płacą.

Operacje jako cecha pierwszorzędna

To, co sprawia, że usługa zarządzana wydaje się „prawdziwa”, to pakiet operacyjny: jasna dokumentacja, przewidywalne kanały wsparcia i explicite limity usług. Dobra dokumentacja zmniejsza obciążenie wsparcia, ale ważniejsze — redukuje niepokój klienta. Opublikowane limity i procesy dla kwot przekształcają niespodzianki w znane ograniczenia.

Gdy opakujesz operacje jako produkt, nie tylko wysyłasz funkcje — wysyłasz pewność.

Projekt organizacyjny, który sprawia, że platformy działają

Platforma udaje się lub nie mniej na diagramach architektury, a bardziej na projekcie organizacyjnym. Jeśli zespoły nie mają jasnych klientów, zachęt i pętli zwrotnej, „platforma” zamienia się w backlog opinii.

Wewnętrzne zespoły jako pierwsi klienci (dogfooding)

Najszybszy sposób, by platforma pozostała w prawdzie, to uczynienie zespołów wewnętrznych pierwszymi — i najsłyszalniejszymi — klientami. To oznacza:

- Zespoły platformowe wysyłają do wewnętrznych zespołów przez te same interfejsy i dokumentację, które zobaczą zewnętrzni użytkownicy.

- Adaptacja jest zdobywana (przez użyteczność), nie narzucana (przez politykę).

- Tickety wsparcia, przeglądy incydentów i decyzje roadmapowe traktują zespoły wewnętrzne jak prawdziwych klientów, z jasnymi SLA.

Dogfooding wymusza jasność: jeśli własne zespoły omijają platformę, zewnętrzni też to zrobią.

Centralny kontra federowany model platformy

Pojawiają się dwa wzorce organizacyjne:

Centralny zespół platformowy: jeden zespół odpowiada za rdzeń (CI/CD, tożsamość, obserwowalność, runtime, prymitywy danych). Dobre dla spójności i efektów skali, ale ryzyko stanie się wąskim gardłem.

Model federowany: mały zespół centralny ustala standardy i współdzielone prymitywy, podczas gdy zespoły domenowe posiadają „kawałki platformy” (np. platforma danych, platforma ML). To zwiększa szybkość i dopasowanie do domeny, ale wymaga silnego zarządzania, by uniknąć fragmentacji.

Metryki, które się liczą (i pułapki platformy)

Przydatne metryki platformy to wyniki, nie aktywność:

- Lead time to production (jak szybko zespoły mogą wypuścić)

- Dostępność i liczba incydentów usług platformowych

- Koszt na workload (unit economics, nie całkowity spend)

Powszechne pułapki to niezgodne zachęty (platforma oceniana po liczbie funkcji, nie po adopcji), nadprojektowanie (budowanie na hipotetyczną skalę) i sukces mierzony mandatem zamiast dobrowolnym użyciem.

Pętla rozwoju platformy

Przestań robić konfigurację

Zamień powtarzalne ustawienia i okablowanie na działającą aplikację w pojedynczym czacie.

Platformy rosną inaczej niż produkty jednorazowe. Ich przewaga to nie tylko „więcej funkcji” — to pętla zwrotna, gdzie każdy nowy klient ułatwia prowadzenie platformy, jej ulepszanie i staje się trudniejszy do zignorowania.

Pętla w prostych słowach

Więcej klientów → więcej realnych danych z użycia → wyraźniejsze wzorce, co się psuje, co jest wolne, co myli → lepsze domyślne ustawienia i automatyzacja → lepsza usługa dla wszystkich → więcej klientów.

AWS skorzystało, bo zarządzane usługi zamieniają operacyjną harówkę w współdzielną, powtarzalną zdolność. Gdy te same problemy pojawiają się w tysiącach zespołów (monitoring, łatanie, skalowanie, backupy), dostawca może naprawić raz i rozprowadzić poprawkę do wszystkich klientów.

Dlaczego standaryzacja przyspiesza innowację

Standaryzacja często jest przedstawiana jako „mniej elastyczności”, ale dla platform to mnożnik prędkości. Gdy infrastruktura i operacje stają się spójne — jeden zestaw API, jedno podejście do tożsamości, jeden sposób obserwacji — budowniczowie przestają wymyślać podstawy na nowo.

Odzyskany czas przekłada się na wyższy poziom innowacji: lepsze doświadczenia produktowe, szybsze eksperymenty i nowe możliwości budowane na platformie (nie obok niej). Standaryzacja też zmniejsza obciążenie poznawcze zespołów: mniej decyzji, mniej trybów awarii, szybsze wdrożenia.

Długoterminowy zakład: kumulacja na skali

Małe ulepszenia kumulują się, gdy są stosowane do milionów żądań i tysięcy klientów. 2% spadek liczby incydentów, lepszy algorytm autoskalowania czy klarowniejsza konfiguracja domyślna nie pomaga tylko jednej firmie — podnosi bazę platformy.

Jak usunięcie ciężkiej pracy przekłada się na szybsze dostarczanie

Usunięcie niezróżnicowanej ciężkiej pracy to nie tylko oszczędność godzin — to zmiana zachowań zespołów. Gdy praca „utrzymania świateł” maleje, roadmapy przestają być zdominowane przez zadania konserwacyjne (łatanie serwerów, rotacja kluczy, niańczenie kolejek) i zaczynają odzwierciedlać zakłady produktowe: nowe funkcje, lepsze UX, więcej eksperymentów.

Efekty drugiego rzędu, które się kumulują

Mniej trudu powoduje reakcję łańcuchową:

- Onboarding jest prostszy. Nowi inżynierowie mogą wdrażać się w dniach zamiast poznawać labirynt internalnych runbooków.

- Incydenty spadają — i są prostsze. Mniej bespoke systemów to mniej dziwnych trybów awarii i mniej eskalacji o 3 w nocy.

- Wydania stają się rutynowe. Zespoły częściej wypuszczają, bo deployment, rollback i monitoring są ustandaryzowane.

Szybkość kontra chaos: wypuszczanie kontra gaszenie pożarów

Prawdziwa szybkość to stałe tempo małych, przewidywalnych wydań. Chaotyczność to ruch bez postępu: pilne poprawki, nagłe prace infra i „szybkie” zmiany, które generują więcej długu.

Usunięcie ciężkiej pracy minimalizuje chaotyczność, eliminując kategorie pracy, które wielokrotnie przerywają plan. Zespół, który wcześniej poświęcał 40% czasu na reakcję, może przekierować tę pojemność na funkcje — i utrzymać to.

Praktyczne przykłady SaaS

Autentykacja: Zamiast utrzymywać przechowywanie haseł, przepływy MFA, sesje i audyty zgodności samodzielnie, użyj zarządzanego dostawcy tożsamości. Efekt: mniej incydentów bezpieczeństwa, szybsze wdrożenia SSO i mniej czasu na aktualizację bibliotek auth.

Płatności: Oddeleguj przetwarzanie płatności, obsługę podatków/VAT i wykrywanie oszustw do wyspecjalizowanego dostawcy. Efekt: szybsza ekspansja na nowe regiony, mniej niespodzianek z chargebackami i mniej inżynierskiego czasu w krawędziach.

Obserwowalność: Ustandaryzuj zarządzany stos logów/metryk/trasowania zamiast domowych dashboardów. Efekt: szybsze debugowanie, jaśniejsza odpowiedzialność podczas incydentów i pewność częstszego wdrażania.

Wzorzec jest prosty: gdy operacje stają się produktem, który konsumujesz, czas inżynieryjny wraca do budowania tego, za co klienci naprawdę płacą.

Kompromisy: lock‑in, kontrola i koszty

Usuwanie niezróżnicowanej ciężkiej pracy to nie darmowy obiad. Zarządzane usługi w stylu AWS często wymieniają codzienny wysiłek na silniejsze powiązanie, mniej możliwości dostrajania i rachunki, które mogą zaskakiwać.

Trzy największe kompromisy

Lock‑in dostawcy. Im bardziej polegasz na proprietarnych API (kolejki, polityki IAM, silniki workflow), tym trudniej się potem przenieść. Lock‑in nie zawsze jest zły — może być ceną za szybkość — ale powinien być wybierany świadomie.

Utrata kontroli. Usługi zarządzane zmniejszają twoją zdolność do dostrajania wydajności, wyboru dokładnych wersji czy debugowania głębokich problemów infra. Gdy nastąpi awaria, możesz czekać na harmonogram dostawcy.

Niespodzianki kosztowe. Model zużyciowy nagradza efektywne użycie, ale może ukarać wzrost, „gadatliwe” architektury i domyślne ustawienia „ustaw i zapomnij”. Zespoły często odkrywają koszty już po wdrożeniu.

Kiedy budowanie ma sens

Budowanie (lub self‑hosting) może być racjonalne, gdy masz unikalne wymagania (specjalne opóźnienia, niestandardowe modele danych), ogromną skalę, przy której ekonomika jednostkowa się odwraca, lub ograniczenia zgodności/rezydencji danych, których zarządzane usługi nie spełniają.

Strażniki, które utrzymają szybkość bez pułapki

Zaprojektuj granice serwisów: otocz wywołania dostawcy własnym interfejsem, by móc wymienić implementacje.

Utrzymuj plan przenoszalności: dokumentuj, co byłoby najtrudniejsze do migracji i miej „minimum wykonalnej ścieżki wyjścia" (nawet jeśli jest powolna).

Dodaj monitorowanie kosztów wcześnie: budżety, alerty, tagowanie i regularne przeglądy największych wydatków.

Macierz decyzyjna do skopiowania

| Pytanie | Preferuj zarządzanie | Preferuj budować/self‑host |

|---|---|---|

| Czy to jest wyróżnik dla klientów? | Nie | Tak |

| Czy możemy tolerować limity/opiniotwórcze zachowanie dostawcy? | Tak | Nie |

| Czy potrzebujemy specjalnej zgodności/kontroli? | Nie | Tak |

| Czy szybkość wejścia na rynek jest priorytetem? | Tak | Nie |

| Czy koszt jest przewidywalny przy naszym profilu użycia? | Tak | Nie |

Praktyczne ramy zastosowania wzorca w każdym biznesie programowym

Zdeleguj day‑2 busywork

Pozwól Koder.ai zająć się wdrożeniem i hostingiem, abyś mógł skupić się na produkcie.

Nie musisz prowadzić hyperskalowej chmury, aby zastosować plan „usuń niezróżnicowaną ciężką pracę”. Każdy zespół programowy — SaaS, platformy wewnętrzne, produkty danych, nawet narzędzia obsługujące heavy support — ma powtarzalne prace, które są kosztowne, podatne na błędy i nie są prawdziwym wyróżnikiem.

Krok po kroku (od trudu do produktu)

-

Wypisz powtarzalne trudy: Zanotuj powtarzające się zadania utrzymania — ręczne deploymenty, triage ticketów, backfill danych, prośby o dostęp, przekazy incydentów, kruche skrypty, checklisty "wiedzy plemiennej".

-

Skwantyfikuj: Dla każdego elementu oszacuj częstotliwość, czas poświęcany i koszt błędów. Prosty scoring działa: godziny/tydzień + surowość pomyłek + liczba dotkniętych zespołów. To zmienia rozmyty ból w uporządkowany backlog.

-

Ustandaryzuj workflow: Zanim zautomatyzujesz, zdefiniuj „jedną najlepszą drogę”. Stwórz szablon, golden path lub minimalny zestaw wspieranych opcji. Redukcja wariacji często daje największy zysk.

-

Automatyzuj i zapakuj: Zbuduj samoobsługowe narzędzia (API, UI, runbooki jako kod) i traktuj je jak produkt: jasne posiadanie, wersjonowanie, dokumentacja i model wsparcia.

Jedna współczesna odmiana tego podejścia to platformy „vibe‑coding”, które przekształcają powtarzalne szkieletowanie i day‑1 setup w kierowane workflow. Na przykład Koder.ai pozwala zespołom tworzyć web, backend i aplikacje mobilne z interfejsu czatowego (React na web, Go + PostgreSQL na backendzie, Flutter na mobile), a następnie eksportować kod źródłowy lub deployować/hostować — przydatne, gdy wąskim gardłem jest przejście od pomysłu do solidnej bazy bez ponownego powtarzania tych samych ustawień projektu.

Zacznij od jednego workflow (i udowodnij pętlę)

Wybierz pojedynczy, wysokoczęstotliwościowy workflow, gdzie sukces jest mierzalny — deploymenty, potoki danych lub narzędzia wsparcia to dobre kandydaty. Celuj w szybkie zwycięstwo: mniej kroków, mniej stron, mniej akceptacji, szybsze przywracanie.

Sekwencjonowanie: co zrobić najpierw

- Niezawodność najpierw: Uczyń proces spójnym i bezpiecznym.

- Funkcje potem: Dodawaj funkcje, których naprawdę żądają użytkownicy.

- Optymalizacja na końcu: Strojenie kosztu i wydajności po ustabilizowaniu użycia.

Najważniejsze wnioski i następne kroki

Powtarzalna lekcja z strategii AWS Andy’ego Jassy’ego jest prosta: wygrywasz, czyniąc wspólną pracę niewidoczną. Gdy klienci (lub zespoły wewnętrzne) przestają tracić czas na setup, łatanie, skalowanie i niańczenie incydentów, mogą poświęcić ten czas na to, co ich naprawdę wyróżnia — funkcje, doświadczenia i nowe zakłady.

Wniosek do zapamiętania

„Niezróżnicowana ciężka praca" to nie tylko „trudna praca”. To praca, którą wiele zespołów powtarza, która musi być wykonana, by działać niezawodnie, ale która rzadko zasługuje na unikalne uznanie rynkowe. Zamiana tej pracy w produkt — szczególnie usługę zarządzaną — tworzy wartość podwójnie: obniżasz koszty operacji i zwiększasz tempo dostarczania.

Wybierz jedną rzecz do usunięcia w tym kwartale

Nie zaczynaj od wielkiego przepisania platformy. Zacznij od jednego powtarzalnego bólu, który pojawia się w ticketach, na stronach on‑call lub jako przepełnienie sprintu. Dobre kandydaty:

- Ustawienie środowiska, które różni się między zespołami

- Ręczne wydania i rollbacki

- Powtarzające się przeglądy bezpieczeństwa dla tych samych wzorców

- Domyślne ustawienia skalowania/monitoringu, które każdy odtwarza po swojemu

Wybierz jedno, zdefiniuj „gotowe” prostym językiem (np. „nowa usługa może wdrożyć się bezpiecznie w 15 minut”) i wypuść najmniejszą wersję, która eliminuje powtarzalną pracę.

Powiązane lektury wewnętrzne

Jeśli chcesz więcej praktycznych wzorów dotyczących myślenia platformowego i decyzji build vs. buy, przejrzyj /blog. Jeśli oceniasz, co ustandaryzować vs. co oferować jako wewnętrzną (lub zewnętrzną) płatną funkcję, /pricing może pomóc w kształtowaniu pakietów i poziomów.

Następny krok: prosty backlog platformy

W tym tygodniu zrób trzy rzeczy: zrób audyt gdzie czas przepływa na powtarzalną pracę ops, ustal priorytety według częstotliwości × ból × ryzyko, i stwórz prosty backlog platformy z 3–5 elementami, które można dostarczyć stopniowo.