17 cze 2025·4 min

Co AI zastępuje w pracy programistów (a czego nie)

Praktyczne rozróżnienie: które obowiązki programistów AI może przejąć, gdzie głównie wspiera ludzi, a które zadania wciąż wymagają pełnej odpowiedzialności w realnych zespołach.

Praktyczne rozróżnienie: które obowiązki programistów AI może przejąć, gdzie głównie wspiera ludzi, a które zadania wciąż wymagają pełnej odpowiedzialności w realnych zespołach.

Rozmowy o tym, co „AI zrobi z programistami”, szybko sie komplikują, bo często mylimy narzędzia z odpowiedzialnościami. Narzędzie może wygenerować kod, podsumować ticket lub zasugerować testy. Odpowiedzialność to to, za co zespół nadal odpowiada, gdy sugestia jest błędna.

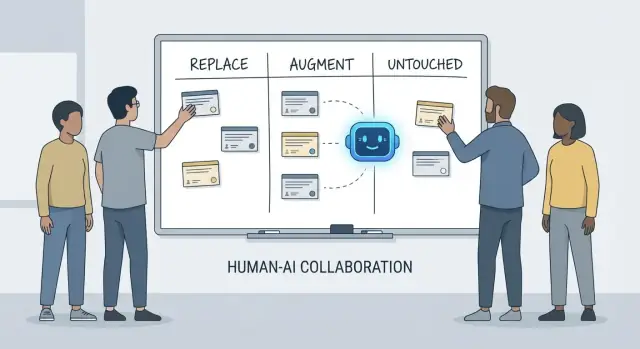

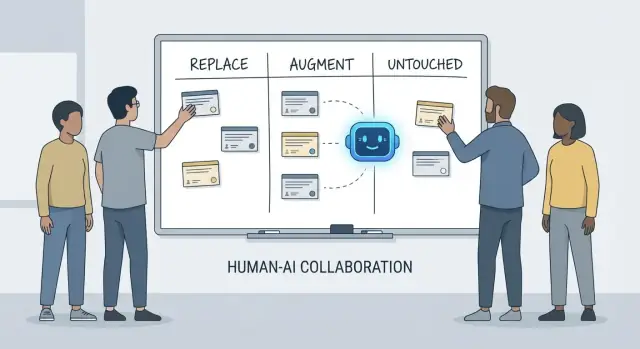

Ten artykuł używa prostego schematu — replace, augment, untouched — aby opisać codzienną pracę w prawdziwych zespołach z terminami, kodem spadkowym, incydentami produkcyjnymi i interesariuszami oczekującymi wiarygodnych rezultatów.

Replace oznacza, że AI może wykonać zadanie end-to-end większość czasu przy jasnych zabezpieczeniach, a rola człowieka przesuwa się do nadzoru i losowych kontroli.

Przykłady to zwykle prace o ograniczonym zakresie: generowanie boilerplate, tłumaczenie kodu między językami, szkicowanie powtarzalnych testów czy przygotowanie pierwszej wersji dokumentacji.

Replace nie znaczy „brak ludzkiej odpowiedzialności”. Jeśli wynik psuje produkcję, wycieka dane lub narusza standardy, odpowiedzialność nadal leży po stronie zespołu.

Augment oznacza, że AI przyspiesza lub uszczelnia pracę programisty, ale nie kończy jej wiarygodnie bez ludzkiego osądu.

To częsty przypadek w profesjonalnym inżynieringu: dostaniesz użyteczne szkice, alternatywne podejścia, szybkie wyjaśnienia lub shortlistę prawdopodobnych błędów — ale programista nadal decyduje, co jest poprawne, bezpieczne i odpowiednie dla produktu.

Untouched oznacza, że rdzeń odpowiedzialności pozostaje prowadzony przez ludzi, bo wymaga kontekstu, kompromisów i rozliczalności, które trudno sprowadzić do promptu.

Pomyśl o: negocjowaniu wymagań, wybieraniu ograniczeń systemowych, obsłudze incydentów, ustalaniu poziomów jakości i podejmowaniu decyzji, gdzie nie ma jedynej „właściwej” odpowiedzi.

Narzędzia zmieniają się szybko. Odpowiedzialności zmieniają się wolniej.

Więc zamiast pytać „Czy AI może napisać ten kod?”, zapytaj „Kto odpowiada za rezultat?” Takie ujęcie utrzymuje oczekiwania przyziemne wobec dokładności, niezawodności i rozliczalności — rzeczy ważniejszych niż imponujące dema.

Kiedy ludzie pytają, co AI „zastępuje” w developmentcie, mają często na myśli zadania: napisać funkcję, wygenerować testy, opracować dokumentację. Zespoły jednak nie wypuszczają zadań — wypuszczają rezultaty. Tu właśnie liczą się odpowiedzialności programistów.

Praca programisty zwykle obejmuje więcej niż samo pisanie kodu:

Te odpowiedzialności rozciągają się na cały lifecycle — od „co powinniśmy zbudować?” po „czy to bezpieczne?” i „co się dzieje o 3 w nocy, gdy coś się zepsuje?”.

Każda odpowiedzialność to w praktyce wiele małych decyzji: które przypadki brzegowe się liczą, które metryki oznaczają zdrowie systemu, kiedy ciąć zakres, czy poprawka jest bezpieczna do wypuszczenia, jak wytłumaczyć kompromis interesariuszom. AI może pomóc wykonać kawałki tej pracy (szkic kodu, propozycja testów, podsumowanie logów), ale odpowiedzialność to posiadanie wyniku.

Rozbiory często pojawiają się na granicach przekazań:

Gdy własność jest niejasna, praca wpada w luki.

Przydatne jest mówienie o odpowiedzialnościach jako o prawach decyzyjnych:

AI może przyspieszyć wykonanie. Prawa decyzyjne — i rozliczalność za wyniki — nadal muszą mieć ludzkie nazwisko obok.

Asystenci kodowania AI są naprawdę użyteczni, gdy praca jest przewidywalna, niskoryzykowna i łatwa do weryfikacji. Myśl o nich jak o szybkim młodszym koledze: świetnym w tworzeniu pierwszej wersji, ale wciąż wymagającym jasnych instrukcji i dokładnej kontroli.

W praktyce niektóre zespoły coraz częściej używają platform „vibe-coding” (jak Koder.ai) do przyspieszania tych zastępowalnych kawałków: generowanie szkieletów, łączenie CRUD-ów i przygotowanie wstępnych szkiców UI i backendu z czatu. Klucz pozostaje ten sam: zabezpieczenia, review i jasna własność.

Dużo czasu programistów idzie na tworzenie szkieletów projektów i łączenie elementów. AI często może wygenerować:

Zabezpieczeniem tu jest spójność: upewnij się, że pasuje do istniejących konwencji i nie wprowadza nowych wzorców lub zależności.

Gdy zmiana jest głównie mechaniczna — zmiana nazw symboli w całej bazie, reformat, aktualizacja prostego użycia API — AI może przyspieszyć rutynową pracę.

Nadal jednak traktuj to jak masową edycję: uruchom pełny zestaw testów, przejrzyj dify pod kątem niezamierzonych zmian zachowania i unikaj pozwalania AI na „ulepszanie” rzeczy poza zakresem refaktoru.

AI może szkicować README, komentarze inline i wpisy changelogu na podstawie kodu i notatek commitów. To przyspiesza klarowność, ale może też tworzyć pewne w brzmieniu nieprawdziwe twierdzenia.

Dobra praktyka: używaj AI do struktury i języka, a potem zweryfikuj każde twierdzenie — szczególnie kroki konfiguracji, domyślne ustawienia i przypadki brzegowe.

Dla dobrze określonych, czystych funkcji, AI-generowane testy jednostkowe mogą dać początkowe pokrycie i przypomnieć o przypadkach brzegowych. Zabezpieczeniem jest własność: nadal wybierasz, co się liczy, dodajesz asercje odzwierciedlające rzeczywiste wymagania i upewniasz się, że testy zawodzą z właściwych powodów.

Gdy masz długie wątki Slacka, tickety lub logi incydentów, AI może zamienić je w zwięzłe notatki i działania. Utrzymaj rzetelność, dostarczając pełen kontekst i weryfikując kluczowe fakty, znaczniki czasowe i decyzje przed udostępnieniem.

Asystenci kodowania AI działają najlepiej, gdy wiesz, czego chcesz i potrzebujesz pomocy, by to szybciej wdrożyć. Mogą zredukować czas spędzony na „pisaniu” i ujawnić pomocny kontekst, ale nie likwidują potrzeby własności, weryfikacji i osądu.

Przy jasnej specyfikacji — wejścia, wyjścia, przypadki brzegowe i ograniczenia — AI może naszkicować sensowną startową implementację: boilerplate, mapowanie danych, handlery API, migracje lub prosty refaktor. Zysk to momentum: szybko dostajesz coś uruchomialnego.

Złapanie jest takie, że kod pierwszej wersji często pomija subtelne wymagania (semantyka błędów, ograniczenia wydajności, kompatybilność wsteczna). Traktuj to jak szkic stażysty: użyteczny, ale nie autorytatywny.

Gdy wybierasz podejście (np. caching vs. batching, optimistic vs. pessimistic locking), AI może zaproponować alternatywy i wypisać kompromisy. To przydatne przy burzy mózgów, ale kompromisy muszą być sprawdzone względem realiów twojego systemu: kształtu ruchu, wymagań spójności danych, ograniczeń operacyjnych i konwencji zespołu.

AI dobrze tłumaczy nieznany kod, wskazuje wzorce i wyjaśnia „co to robi” prostym językiem. Połączone z narzędziami wyszukiwania może pomóc odpowiedzieć „Gdzie X jest używane?” i wygenerować listę miejsc wpływu: call sites, konfiguracje i testy do sprawdzenia.

Oczekuj praktycznych ulepszeń jakości życia: czytelniejsze komunikaty o błędach, małe przykłady i gotowe fragmenty do wklejenia. Redukują one tarcie, ale nie zastępują dokładnego review, lokalnych uruchomień i ukierunkowanych testów — szczególnie przy zmianach wpływających na użytkowników lub system produkcyjny.

AI może pomóc napisać i dopracować wymagania, ale nie może wiarygodnie zdecydować, co powinniśmy zbudować ani dlaczego to się liczy. Zrozumienie produktu opiera się na kontekście: celach biznesowych, bólu użytkownika, ograniczeniach organizacyjnych, przypadkach brzegowych i koszcie zrobienia błędu. Te informacje są w rozmowach, historii i rozliczalności — rzeczy, które model może podsumować, ale nie naprawdę posiąść.

Wczesne prośby często brzmią: „Uprość onboarding” lub „Zredukuj tickety supportu.” Praca programisty polega na przetłumaczeniu tego na jasne wymagania i kryteria akceptacji.

To tłumaczenie jest głównie pracą ludzką, bo zależy od zadawania pytań i osądu:

AI może zasugerować metryki lub szkic kryteriów akceptacji, ale nie będzie wiedzieć, które ograniczenia są realne, chyba że ktoś je poda — i nie skrytykuje sprzecznych wymagań.

Praca nad wymaganiami to miejsce, gdzie pojawiają się niewygodne kompromisy: czas vs. jakość, szybkość vs. utrzymywalność, nowe funkcje vs. stabilność. Zespoły potrzebują osoby, która wyraźnie pokaże ryzyka, zaproponuje opcje i zgra interesariuszy co do konsekwencji.

Dobry spec to nie tylko tekst; to zapis decyzji. Powinien być testowalny i implementowalny, z precyzyjnymi definicjami (wejścia, wyjścia, przypadki brzegowe i tryby awarii). AI może pomóc w strukturze dokumentu, ale odpowiedzialność za poprawność — i za stwierdzenie „to niejasne, potrzebujemy decyzji” — pozostaje po stronie ludzi.

Projekt systemu to moment, gdy „co zbudować?” zamienia się w „na czym zbudować i jak się to zachowa, gdy coś pójdzie nie tak?” AI pomoże eksplorować opcje, ale nie przejmie konsekwencji.

Wybór między monolitem, modularnym monolitem, mikroserwisami, serverless czy platformami zarządzanymi nie jest testem z jedną właściwą odpowiedzią. To problem dopasowania: oczekiwanej skali, budżetu, czasu do rynku i umiejętności zespołu.

Asystent może podsumować wzorce i zasugerować referencyjne architektury, ale nie będzie wiedzieć, że w twoim zespole dyżury rotują co tydzień, rekrutacja idzie wolno, albo kontrakt z dostawcą bazy odnawia się w przyszłym kwartale. Te detale często decydują o sukcesie architektury.

Dobra architektura to w większości kompromisy: prostota vs. elastyczność, wydajność vs. koszty, szybkość dziś vs. utrzymywalność później. AI szybko wygeneruje listy zalet/wad, co jest przydatne — zwłaszcza do dokumentowania decyzji.

Czego nie zrobi dobrze, to ustawianie priorytetów, gdy kompromisy bolą. Na przykład: „Akceptujemy nieco wolniejsze odpowiedzi, by utrzymać prostotę i łatwość operacji” — to decyzja biznesowa, nie tylko techniczna.

Definiowanie granic serwisów, kto jest właścicielem danych i co się dzieje przy częściowych awariach wymaga głębokiego kontekstu produktowego i operacyjnego. AI pomoże wypisać tryby awarii (np. „a co jeśli dostawca płatności padnie?”), ale ludzie muszą zdecydować oczekiwane zachowanie, komunikację do klientów i plan rollbacku.

Projektowanie API to projektowanie kontraktu. AI może generować przykłady i wyłapywać niespójności, ale musisz zdecydować o wersjonowaniu, kompatybilności wstecznej i tym, co zamierzasz wspierać długoterminowo.

Może najważniejsza decyzja architektoniczna to powiedzieć „nie” — albo usunąć funkcję. AI nie zmierzy kosztu alternatywnego ani ryzyka politycznego. Zespoły mogą i powinny to robić.

Rozdziela to zadania (co narzędzie może pomóc wykonać) od odpowiedzialności (wyników, za które zespół odpowiada).

Bo zespoły nie wypuszczają „zadań”, tylko wyniki.

Nawet jeśli asystent tworzy kod lub testy, Twój zespół nadal odpowiada za:

„Replace” oznacza ograniczone, weryfikowalne i niskostawkowe prace, gdzie błędy łatwo wykryć.

Dobre kandydatury to m.in.:

Używaj zabezpieczeń, które sprawiają, że błędy są oczywiste i tanie do naprawienia:

Bo „augment” zwykle zawiera ukryte ograniczenia, których model nie wnioskuje niezawodnie:

Traktuj wynik AI jako szkic, który dostosowujesz do swojego systemu, a nie jako autorytatywne rozwiązanie.

Używaj go do generowania hipotez i planu zebrania dowodów, nie do wyciągania wniosków.

Praktyczna pętla:

Jeśli nie możesz zweryfikować sugestii, zakładaj, że jest błędna, dopóki nie udowodnisz inaczej.

AI pomoże Ci zauważyć problemy szybciej, ale ludzie decydują, czy to dopuszczalne do wydania.

Przydatne prompt-y do recenzji:

Następnie zrób ludzką weryfikację intencji, utrzymania i ryzyka wydania (co blokuje wydanie vs. co można zostawić jako follow-up).

AI może szkicować wiele testów, ale nie może wybrać, które pokrycie jest naprawdę istotne.

Ludzie nadal odpowiadają za:

Używaj AI do szkicowania i generowania pomysłów na przypadki brzegowe, ale nie jako właściciela jakości.

Nie do końca — bo te decyzje zależą od kontekstu biznesowego i długoterminowej odpowiedzialności.

AI może:

Ludzie muszą jednak zdecydować:

Nigdy nie wklejaj sekretów ani wrażliwych danych klientów/zdarzeń do promptów.

Praktyczne zasady: