14 lis 2025·8 min

Craig McLuckie i cloud-native: myślenie platformowe wygrywa

Praktyczne spojrzenie na rolę Craiga McLuckiego w przyjęciu cloud-native i jak myślenie platformowe pomogło kontenerom stać się niezawodną infrastrukturą produkcyjną.

Praktyczne spojrzenie na rolę Craiga McLuckiego w przyjęciu cloud-native i jak myślenie platformowe pomogło kontenerom stać się niezawodną infrastrukturą produkcyjną.

Zespoły nie mają problemów, bo nie potrafią uruchomić kontenera. Mają je, ponieważ muszą bezpiecznie uruchomić setki kontenerów, aktualizować je bez przestojów, odzyskiwać działanie, gdy coś się zepsuje, i wciąż dostarczać funkcje zgodnie z harmonogramem.

Historia „cloud-native” w wykonaniu Craiga McLuckiego jest ważna, bo to nie triumfalna opowieść o efektownych demonstracjach. To zapis tego, jak kontenery stały się operowalne w rzeczywistych środowiskach — tam, gdzie zdarzają się incydenty, obowiązują regulacje, a biznes potrzebuje przewidywalnej dostawy.

„Cloud-native” to nie to samo, co „uruchamianie w chmurze”. To podejście do tworzenia i eksploatacji oprogramowania, które pozwala na częste wdrożenia, skalowanie w odpowiedzi na zmiany popytu oraz szybkie naprawy, gdy coś zawiedzie.

W praktyce zwykle oznacza to:

Wczesne adopcje kontenerów wyglądały często jak skrzynka z narzędziami: zespoły brały Dockera, sklejały skrypty i liczyły, że operacje nadążą. Myślenie platformowe odwraca to podejście. Zamiast pozwalać każdemu zespołowi wymyślać własną ścieżkę do produkcji, budujesz wspólne „paved roads” — platformę, która sprawia, że bezpieczny, zgodny z regułami i obserwowalny sposób jest też najprostszym.

Ta zmiana to most od „potrafimy uruchomić kontenery” do „możemy na nich prowadzić biznes”.

To tekst dla osób odpowiedzialnych za rezultaty, nie tylko za diagramy architektury:

Jeśli twoim celem jest niezawodne dostarczanie w skali, ta historia ma praktyczne lekcje.

Craig McLuckie to jedno z najbardziej rozpoznawalnych nazwisk związanych z wczesnym ruchem cloud-native. Często pojawia się w rozmowach o Kubernetesie, Cloud Native Computing Foundation (CNCF) i idei traktowania infrastruktury jak produktu — a nie składu ticketów i wiedzy plemiennej.

Warto być precyzyjnym. McLuckie nie „wynalazł” cloud-native samodzielnie, a Kubernetes nigdy nie był projektem jednej osoby. Kubernetes powstał w zespole w Google, a McLuckie był częścią tego wczesnego wysiłku.

Ludzie często przypisują mu zasługę przekształcenia koncepcji inżynierskiej w coś, co szerszy przemysł mógł faktycznie przyjąć: silniejsze budowanie społeczności, jaśniejsze opakowanie i nacisk na powtarzalne praktyki operacyjne.

Wraz z rozwojem Kubernetesa i ery CNCF przesłanie McLuckiego dotyczyło mniej modnej architektury, a bardziej uczynienia produkcji przewidywalną. To oznacza:

Jeśli słyszałeś terminy takie jak „paved roads”, „golden paths” czy „platform as a product”, krążysz wokół tej samej idei: zmniejszyć obciążenie poznawcze zespołów, sprawiając, że właściwa droga jest najprostszą.

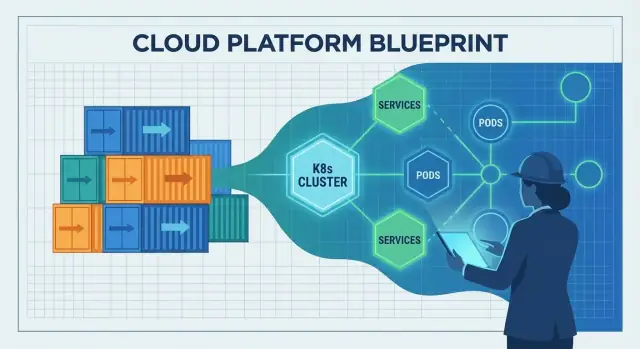

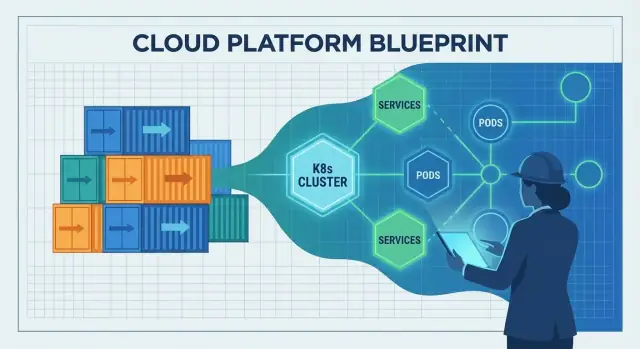

Ten post nie jest biografią. McLuckie jest punktem odniesienia, bo jego praca leży na styku trzech sił, które zmieniły dostarczanie oprogramowania: kontenery, orkiestracja i budowanie ekosystemu. Lekcje tu przedstawione dotyczą tego, dlaczego myślenie platformowe stało się odblokowaniem umożliwiającym uruchamianie kontenerów w prawdziwej produkcji.

Kontenery były ekscytującym pomysłem na długo przed tym, jak etykieta „cloud-native” stała się powszechna. W codziennym rozumieniu kontener to sposób spakowania aplikacji wraz z plikami i bibliotekami, których potrzebuje, aby działać tak samo na różnych maszynach — jak wysyłka produktu w zamkniętym pudełku ze wszystkimi częściami.

Na początku wiele zespołów używało kontenerów do projektów pobocznych, demo i do workflow deweloperskiego. Świetnie nadawały się do szybkiego testowania nowych usług, odpalania środowisk testowych i unikania niespodzianek typu „działa na moim laptopie” przy przekazywaniu pracy.

Ale przejście od garstki kontenerów do systemu produkcyjnego działającego 24/7 to zupełnie inne zadanie. Narzędzia istniały, lecz historia operacyjna była niepełna.

Typowe problemy pojawiały się szybko:

Kontenery pomogły uczynić oprogramowanie przenośnym, ale sama przenośność nie gwarantowała niezawodności. Zespoły wciąż potrzebowały spójnych praktyk wdrożeniowych, jasnego właścicielstwa i strażników operacyjnych — tak by aplikacje konteneryzowane nie działały jednorazowo, lecz przewidywalnie każdego dnia.

Myślenie platformowe to moment, gdy firma przestaje traktować infrastrukturę jako jednorazowy projekt, a zaczyna traktować ją jak wewnętrzny produkt. „Klientami” są deweloperzy, zespoły danych i wszyscy, którzy dostarczają oprogramowanie. Celem produktu nie są kolejne serwery czy więcej YAML-a — to płynniejsza ścieżka od pomysłu do produkcji.

Prawdziwa platforma ma jasną obietnicę: „Jeśli zbudujesz i wdrożysz używając tych ścieżek, otrzymasz niezawodność, bezpieczeństwo i przewidywalne dostarczanie.” Ta obietnica wymaga nawyków produktowych — dokumentacji, wsparcia, wersjonowania i pętli informacji zwrotnej. Wymaga też rozważnego doświadczenia użytkownika: sensownych domyślnych ustawień, paved roads i wyjścia awaryjnego, gdy zespoły naprawdę tego potrzebują.

Standaryzacja eliminuje zmęczenie decyzyjne i zapobiega przypadkowej złożoności. Gdy zespoły dzielą te same wzorce wdrożeń, logowanie i kontrolę dostępu, problemy stają się powtarzalne — a więc rozwiązywalne. Dyżury on-call poprawiają się, bo incydenty wyglądają znajomo. Przeglądy bezpieczeństwa przyspieszają, bo platforma zawiera strażniki zamiast polegać na tym, że każdy zespół je wymyśli.

To nie chodzi o zmuszanie wszystkich do jednej skrzynki. Chodzi o uzgodnienie 80% spraw, które powinny być nudne, aby zespoły mogły poświęcić energię na 20% różnicujących biznes.

Zanim podejścia platformowe się przyjęły, infrastruktura często zależała od specjalistycznej wiedzy: kilka osób wiedziało, które serwery są załatane, jakie ustawienia są bezpieczne i które skrypty są „dobrymi”. Myślenie platformowe zastępuje to powtarzalnymi wzorcami: szablonami, automatycznym provisioningiem i spójnymi środowiskami od deva do produkcji.

Dobrze zrobiona platforma tworzy lepsze zarządzanie przy mniejszej papierkowej robocie. Polityki stają się zautomatyzowanymi kontrolami, zatwierdzenia to audytowalne przepływy, a dowody zgodności generują się podczas wdrożeń — więc organizacja zyskuje kontrolę bez spowalniania wszystkich.

Kontenery ułatwiły spakowanie i wysyłkę aplikacji. Trudna część zaczynała się po wysłaniu: gdzie to uruchomić, jak to utrzymać w zdrowiu i jak się dostosować, gdy zmienia się ruch lub infrastruktura.

To jest luka, którą wypełnił Kubernetes. Przekształcił „kupkę kontenerów” w coś, czym można zarządzać dzień po dniu, nawet gdy serwery zawodzą, odbywają się wydania i skoki zapotrzebowania.

Kubernetes bywa opisywany jako „orkiestracja kontenerów”, ale praktyczne problemy są bardziej konkretne:

Bez orkiestratora zespoły kończą ze skryptami realizującymi te zachowania i ręcznym zarządzaniem wyjątkami — aż skrypty przestaną pasować do rzeczywistości.

Kubernetes spopularyzował pomysł wspólnego control plane: jedno miejsce, gdzie deklarujesz, czego chcesz (np. „uruchom 3 kopie tej usługi”), a platforma ciągle pracuje, by rzeczywistość zbliżała się do tego stanu.

To duża zmiana odpowiedzialności:

Kubernetes nie powstał dlatego, że kontenery były modne. Wyrósł z lekcji zdobytych przy obsłudze dużych flot: traktuj infrastrukturę jako system z pętlami sprzężenia zwrotnego, a nie jako zbiór jednorazowych zadań serwerowych. Ten mindset operacyjny to powód, dla którego stał się mostem od „potrafimy uruchomić kontenery” do „możemy nimi zarządzać niezawodnie w produkcji”.

Cloud-native nie wprowadziło tylko nowych narzędzi — zmieniło rytm codziennego wypuszczania oprogramowania. Zespoły przeszły od „ręcznie konfigurowanych serwerów i runbooków” do systemów sterowanych przez API, automatyzację i deklaratywną konfigurację.

Cloud-native zakłada, że infrastruktura jest programowalna. Potrzebujesz bazy danych, load balancera lub nowego środowiska? Zamiast czekać na ręczną konfigurację, opisujesz, czego chcesz, i pozwalasz automatyzacji to utworzyć.

Kluczowa zmiana to konfiguracja deklaratywna: definiujesz stan pożądany („uruchom 3 kopie tej usługi, wystaw ją na tym porcie, ogranicz pamięć do X”), a platforma pracuje, by ten stan utrzymać. Dzięki temu zmiany są przegladalne, powtarzalne i łatwiejsze do cofnięcia.

Tradycyjne dostarczanie często polegało na poprawianiu żywych serwerów. Z czasem każda maszyna stawała się nieco inna — dryft konfiguracji, który wychodził na jaw podczas incydentu.

Cloud-native pchnął zespoły w stronę immutable deployments: tworzenie artefaktu raz (często obraz kontenera), wdrażanie go, a gdy potrzebna jest zmiana — wdrożenie nowej wersji zamiast modyfikowania tego, co działa. W połączeniu z automatycznymi rolloutami i health checkami to podejście zmniejsza liczbę tajemniczych awarii spowodowanych jednorazowymi poprawkami.

Kontenery ułatwiły pakowanie i uruchamianie wielu małych usług w spójny sposób, co zachęciło do architektur mikroserwisowych. Mikroserwisy z kolei zwiększyły potrzebę spójnych wdrożeń, skalowania i odkrywania usług — obszarów, w których orkiestracja kontenerów się sprawdza.

Kompromis: więcej usług to więcej obowiązków operacyjnych (monitoring, sieć, wersjonowanie, reakcja na incydenty). Cloud-native pomaga zarządzać tą złożonością, ale jej nie eliminuje.

Przenośność poprawiła się, bo zespoły ujednoliciły podstawowe prymitywy wdrożeniowe i API. Jednak „uruchom gdziekolwiek” zwykle wymaga pracy — różnice w bezpieczeństwie, storage, sieci i usługach zarządzanych mają znaczenie. Cloud-native najlepiej rozumieć jako zmniejszanie lock-inu i tarć, a nie ich całkowite usuwanie.

Kubernetes nie rozprzestrzenił się tylko dlatego, że był potężny. Rozprzestrzenił się, bo zyskał neutralne miejsce, jasne zarządzanie i przestrzeń, w której konkurujące firmy mogły współpracować bez jednego dostawcy „opanowującego” reguły.

Cloud Native Computing Foundation (CNCF) stworzyła wspólne zarządzanie: otwarte podejmowanie decyzji, przewidywalne procesy projektowe i publiczne roadmapy. To ma znaczenie dla zespołów stawiających na kluczową infrastrukturę. Gdy zasady są przejrzyste i niezwiązane z modelem biznesowym pojedynczej firmy, adopcja wydaje się mniej ryzykowna — a wkład staje się bardziej atrakcyjny.

Hostując Kubernetesa i projekty pokrewne, CNCF pomogło przekształcić „popularne open-source” w długoterminową platformę z instytucjonalnym wsparciem. Zapewniło:

Przy wielu kontrybutorach (dostawcy chmurowi, startupy, przedsiębiorstwa i niezależni inżynierowie) Kubernetes rozwijał się szybciej i w bardziej realnych kierunkach: sieć, storage, bezpieczeństwo i operacje typu day-2. Otwarte API i standardy ułatwiły integrację narzędzi, co zredukowało lock-in i zwiększyło pewność użycia w produkcji.

CNCF przyspieszyło także eksplozję ekosystemu: service meshes, ingress controllers, narzędzia CI/CD, silniki polityk, stosy obserwowalności i więcej. Ta obfitość to siła — ale generuje też nakładanie się funkcji.

Dla większości zespołów sukces polega na wyborze niewielkiego zestawu dobrze wspieranych komponentów, faworyzowaniu interoperacyjności i jasnym przypisaniu właścicielstwa. Podejście „najlepsze ze wszystkiego” często prowadzi do ciężaru utrzymania, a nie lepszej dostawy.

Kontenery i Kubernetes rozwiązały dużą część pytania „jak uruchamiamy oprogramowanie?”. Nie rozwiązały automatycznie trudniejszego: „jak utrzymujemy je, gdy przyjdą prawdziwi użytkownicy?”. Brakującą warstwą jest niezawodność operacyjna — jasne oczekiwania, wspólne praktyki i system, który czyni właściwe zachowania domyślnymi.

Zespół może szybko wdrażać i wciąż być jedno nieudane wdrożenie od chaosu, jeśli baseline produkcyjny nie jest zdefiniowany. Minimum to:

Bez tego baseline każdy serwis wynajduje własne zasady, a niezawodność staje się kwestią szczęścia.

DevOps i SRE wprowadziły ważne nawyki: odpowiedzialność, automatyzację, mierzoną niezawodność i uczenie się na incydentach. Jednak same nawyki nie skalują się przez dziesiątki zespołów i setki usług.

Platformy czynią te praktyki powtarzalnymi. SRE ustala cele (np. SLO), a platforma daje paved roads, które pomagają je osiągnąć.

Niezawodne dostarczanie zwykle wymaga spójnego zestawu możliwości:

Dobra platforma wbudowuje te domyślne ustawienia w szablony, pipeline'y i polityki runtime: standardowe dashboardy, wspólne reguły alertowe, strażniki wdrożeń i mechanizmy rollbacku. W ten sposób niezawodność przestaje być opcją, a staje się przewidywalnym efektem dostarczania oprogramowania.

Narzędzia cloud-native mogą być potężne i mimo to wydawać się „za dużo” dla większości zespołów produktowych. Inżynieria platformowa istnieje po to, by tę lukę zasypać. Misja jest prosta: zmniejszyć obciążenie poznawcze zespołów aplikacyjnych, by mogły dostarczać funkcje bez zostawania półetatowymi ekspertami od infrastruktury.

Dobry zespół platformowy traktuje infrastrukturę wewnętrzną jak produkt. To oznacza jasnych użytkowników (deweloperów), jasne rezultaty (bezpieczne, powtarzalne dostarczanie) i pętlę informacji zwrotnej. Zamiast przekazywać stos prymitywów Kubernetesa, platforma oferuje opiniotwórcze sposoby budowy, wdrażania i obsługi usług.

Praktyczne pytanie: „Czy deweloper może przejść od pomysłu do działającej usługi bez otwierania tuzina ticketów?” Narzędzia, które skracają ten workflow — zachowując jednocześnie strażniki — są zgodne z celem platformy cloud-native.

Większość platform to zestaw wielokrotnego użytku paved roads, które zespoły mogą wybierać domyślnie:

Celem nie jest ukrywanie Kubernetesa — chodzi o zapakowanie go w sensowne domyślne ustawienia, które chronią przed przypadkową złożonością.

W tym duchu Koder.ai może służyć jako „DX accelerator” dla zespołów, które chcą szybko wystartować wewnętrzne narzędzia lub funkcje produktowe przez chat, a potem eksportować kod, gdy trzeba zintegrować go z bardziej formalną platformą. Dla zespołów platformowych jego tryb planowania i wbudowane snapshots/rollback mogą też odzwierciedlać postawę priorytetu niezawodności, której oczekujesz w produkcyjnych workflow.

Każda paved road to kompromis: więcej spójności i bezpieczniejszych operacji, ale mniej opcji jednorazowych. Zespoły platformowe radzą sobie najlepiej, gdy oferują:

Sukces platformy widać mierzalnie: szybsze wdrożenie nowych inżynierów, mniej bespoke skryptów wdrożeniowych, mniej „śnieżnych” klastrów i wyraźniejsze właścicielstwo przy incydentach. Jeśli zespoły potrafią odpowiedzieć na pytanie „kto jest właścicielem tej usługi i jak ją wdrażamy?” bez spotkania, platforma robi swoje.

Cloud-native może przyspieszyć dostarczanie i uspokoić operacje — ale tylko gdy zespoły są jasne co chcą poprawić. Wiele opóźnień wynika z traktowania Kubernetesa i jego ekosystemu jako celu, a nie środka.

Częsty błąd to przyjęcie Kubernetesa, bo „tak robią nowoczesne zespoły”, bez konkretnego celu, jak krótszy lead time, mniej incydentów czy spójność środowisk. Efekt to dużo pracy migracyjnej bez widocznych korzyści.

Jeśli kryteria sukcesu nie są ustalone z góry, każda decyzja staje się subiektywna: które narzędzie wybrać, ile standaryzować i kiedy platforma jest „gotowa”.

Kubernetes to fundament, nie pełna platforma. Zespoły często szybko dorzucają dodatki — service mesh, wiele ingress controllerów, custom operatory, silniki polityk — bez jasnych granic i właścicielstwa.

Nadcustomizowanie to kolejna pułapka: autorskie wzorce YAML, ręcznie robione szablony i wyjątki, które rozumie tylko ich autor. Złożoność rośnie, onboarding zwalnia, a aktualizacje stają się ryzykowne.

Cloud-native ułatwia tworzenie zasobów — i równie łatwo jest o nich zapomnieć. Rozrost klastrów, nieużywane namespace'y i nadmiernie przydzielone zasoby cicho zwiększają koszty.

Pułapki bezpieczeństwa są równie powszechne:

Zacznij mało: od jednej lub dwóch dobrze ograniczonych usług. Wczesne zdefiniuj standardy (golden paths, zatwierdzone obrazy bazowe, reguły upgrade'u) i trzymaj powierzchnię platformy świadomie ograniczoną.

Mierz wyniki: częstotliwość wdrożeń, lead time, mean time to recovery — i traktuj wszystko, co tych wskaźników nie poprawia, jako opcjonalne.

Nie „adoptujesz cloud-native” jednym ruchem. Zespoły, które odnoszą sukces, podążają za tą samą ideą z epoki McLuckiego: buduj platformę, która sprawi, że właściwy sposób będzie też najprostszym.

Zacznij od małego, potem sformalizuj to, co działa.

Jeśli eksperymentujesz z nowymi workflowami, dobrym wzorcem jest prototypowanie doświadczenia „golden path” end-to-end przed jego standaryzacją. Na przykład zespoły mogą użyć Koder.ai, by szybko wygenerować działającą aplikację web (React), backend (Go) i bazę (PostgreSQL) przez czat, a potem potraktować wynikowy kod jako punkt wyjścia do szablonów platformy i konwencji CI/CD.

Zanim dodasz narzędzie, zapytaj:

Mierz rezultaty, nie użycie narzędzi:

Jeśli chcesz przykładów dobrych pakietów „platform MVP”, zobacz /blog. Dla budżetowania i planowania rolloutu możesz też odnieść się do /pricing.

Wielka lekcja ostatniej dekady jest prosta: kontenery nie „wygrały” dlatego, że były sprytnym opakowaniem. Wygrały, bo myślenie platformowe uczyniło je niezawodnymi — powtarzalne wdrożenia, bezpieczne rollouty, spójne kontrolki bezpieczeństwa i przewidywalne operacje.

Następny rozdział to nie jeden przełomowy tool. To uczynienie cloud-native nudnym w najlepszym sensie: mniej niespodzianek, mniej jednorazowych napraw i płynniejsza ścieżka od kodu do produkcji.

Policy-as-code staje się domyślny. Zamiast ręcznie przeglądać każde wdrożenie, zespoły kodują reguły dotyczące bezpieczeństwa, sieci i zgodności, by strażniki były automatyczne i audytowalne.

Doświadczenie dewelopera (DX) traktowane jak produkt. Oczekuj większego nacisku na paved roads: szablony, samoobsługowe środowiska i jasne golden paths, które zmniejszają obciążenie poznawcze bez ograniczania autonomii.

Prostsze operacje, nie więcej dashboardów. Najlepsze platformy ukryją złożoność: opiniotwórcze domyślne ustawienia, mniej poruszających się części i wzorce niezawodności wbudowane, a nie doklejane.

Postęp cloud-native zwalnia, gdy zespoły gonią za funkcjami zamiast za rezultatami. Jeśli nie potrafisz wyjaśnić, jak nowe narzędzie skraca lead time, obniża liczbę incydentów lub poprawia postawę bezpieczeństwa, prawdopodobnie nie jest priorytetem.

Oceń bieżące bóle w dostawie i przyporządkuj je do potrzeb platformy:

Traktuj odpowiedzi jako backlog platformy — i mierz sukces według rezultatów, które zespoły odczuwają każdego tygodnia.

Cloud-native to podejście do budowania i eksploatacji oprogramowania tak, by można je było często wdrażać, skalować gdy zmienia się zapotrzebowanie i szybko przywracać po awariach.

W praktyce zwykle obejmuje kontenery, automatyzację, mniejsze usługi i standardowe sposoby obserwowalności, zabezpieczeń i zarządzania tym, co działa.

Kontener ułatwia spakowanie aplikacji w przewidywalny sposób, ale sam w sobie nie rozwiązuje trudnych problemów produkcyjnych — takich jak bezpieczne aktualizacje, odkrywanie usług, kontrole bezpieczeństwa i trwała obserwowalność.

Różnica staje się widoczna, gdy przechodzisz z kilku kontenerów do setek działających 24/7.

„Myślenie platformowe” oznacza traktowanie wewnętrznej infrastruktury jak produkt wewnętrzny z jasnymi użytkownikami (deweloperzy) i obietnicą (bezpieczne, powtarzalne dostarczanie).

Zamiast tego, by każdy zespół składał własną ścieżkę do produkcji, organizacja buduje wspólne paved roads (golden paths) z sensownymi domyślnymi ustawieniami i wsparciem.

Kubernetes dostarcza warstwy operacyjnej, która zmienia „kupkę kontenerów” w system, którym można zarządzać na co dzień:

Wprowadza też wspólny , w którym deklarujesz stan pożądany, a system stara się go utrzymać.

Konfiguracja deklaratywna oznacza, że opisujesz co chcesz, zamiast pisać krok po kroku procedury.

Praktyczne korzyści to:

Immutable deployments polegają na tym, że nie poprawiasz na żywo serwerów. Budujesz artefakt raz (często obraz kontenera) i wdrażasz dokładnie ten artefakt.

Aby wprowadzić zmianę, wypuszczasz nową wersję zamiast modyfikować działający system. Pomaga to ograniczyć dryft konfiguracji i ułatwia odtwarzanie oraz cofanie awarii.

CNCF dało Kubernetes neutralne, zarządzane środowisko, co zmniejszyło ryzyko stawiania zakładu na kluczową infrastrukturę.

Pomogło to w:

Baseline produkcyjny to minimalny zestaw możliwości i praktyk, które czynią niezawodność przewidywalną, na przykład:

Bez tego każdy serwis wymyśla własne zasady i niezawodność staje się kwestią szczęścia.

Inżynieria platformowa skupia się na zmniejszeniu obciążenia poznawczego deweloperów przez zapakowanie pierwotnych narzędzi cloud-native w opiniotwórcze domyślne rozwiązania:

Celem nie jest ukrywanie Kubernetesa, lecz ułatwienie najbezpieczniejszej ścieżki.

Typowe pułapki to:

Jak tego unikać: