Dlaczego C nadal ma znaczenie

C to jedna z tych technologii, których większość ludzi nigdy nie dotyka bezpośrednio, a mimo to prawie każdy od nich zależy. Jeśli używasz telefonu, laptopa, routera, samochodu, smartwacha czy nawet ekspresu do kawy z ekranem, istnieje duża szansa, że gdzieś w stosie pojawia się C — uruchamiając urządzenie, komunikując się ze sprzętem lub sprawiając, że działa wystarczająco szybko, by wydawało się „natychmiastowe”.

Dla twórców C pozostaje praktycznym narzędziem, ponieważ łączy rzadkie cechy kontroli i przenośności. Możesz działać bardzo blisko maszyny (zarządzać pamięcią i sprzętem bezpośrednio), a jednocześnie przenieść kod na różne CPU i systemy operacyjne przy stosunkowo niewielkich zmianach. Tego typu kombinacji trudno szukać zamiennika.

Trzy obszary, w których C wciąż dominuje

Największy ślad C widoczny jest w trzech obszarach:

- Systemy operacyjne: jądra, biblioteki rdzenne, sterowniki i narzędzia niskiego poziomu, na których opiera się reszta.\n- Urządzenia wbudowane: małe systemy z ograniczeniami pamięci, zasilania i pamięci masowej, gdzie przewidywalność zachowania ma znaczenie.\n- Miejsca krytyczne dla wydajności: fragmenty większych programów, w których szybkość ma kluczowe znaczenie — ścieżki, gdzie kilka milisekund lub watów robi różnicę.

Nawet gdy aplikacja jest napisana w językach wyższego poziomu, warstwy fundamentu (lub moduły wrażliwe na wydajność) często sięgają do C.

Czego dowiesz się z tego artykułu

Ten tekst łączy kropki między Dennisem Ritchiem, pierwotnymi celami języka C i powodami, dla których pojawia się on w nowoczesnych produktach. Omówimy:

- krótką, czytelną fragmentaryczną historię (w tym wpływ Uniksa),

- decyzje projektowe, które uczyniły C małym, a jednocześnie potężnym,

- gdzie C pasuje dziś — jego mocne strony i wyzwania związane z bezpieczeństwem.

Zakres

Tu chodzi o C konkretnie, nie o „wszystkie języki niskiego poziomu”. C++ i Rust mogą pojawić się do porównania, ale skupiamy się na tym, czym jest C, dlaczego zaprojektowano go w ten sposób i dlaczego zespoły wciąż go wybierają dla rzeczywistych systemów.

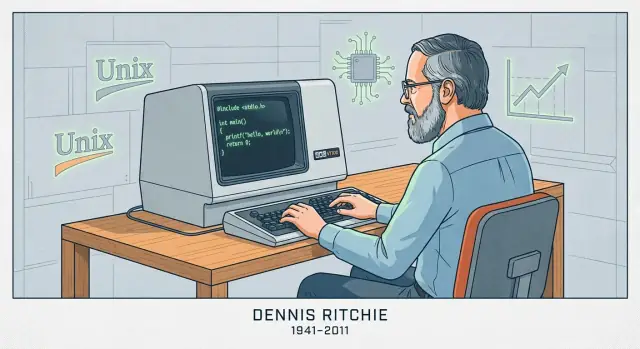

Dennis Ritchie w skrócie

Dennis Ritchie (1941–2011) był amerykańskim informatykiem najbardziej znanym ze swojej pracy w AT&T’s Bell Labs, organizacji badawczej, która odegrała kluczową rolę we wczesnej informatyce i telekomunikacji.

Bell Labs, Unix i nowy rodzaj oprogramowania systemowego

W Bell Labs pod koniec lat 60. i w latach 70. Ritchie współpracował z Kennethem Thompsonem i innymi nad badaniami nad systemami operacyjnymi, które doprowadziły do Uniksa. Thompson stworzył wczesną wersję Uniksa; Ritchie stał się jednym z głównych współtwórców, gdy system ewoluował w coś, co dało się utrzymać, rozwijać i szeroko udostępniać w środowisku akademickim i przemysłowym.

Stworzenie C, by budować realne systemy

Ritchie stworzył też język C, rozwijając pomysły z wcześniejszych języków używanych w Bell Labs. C zaprojektowano z myślą o praktycznym pisaniu oprogramowania systemowego: daje programistom bezpośrednią kontrolę nad pamięcią i reprezentacją danych, a jednocześnie jest czytelniejsze i bardziej przenośne niż pisanie wszystkiego w assemblerze.

Ta kombinacja miała znaczenie, bo Unix ostatecznie został przepisany w C. Nie była to kosmetyczna zmiana — pozwoliła Unixowi łatwiej przenosić się na nowe platformy i rozwijać w czasie. Powstała pętla sprzężenia zwrotnego: Unix dostarczał wymagającego przypadku użycia dla C, a C ułatwiał szersze przyjęcie Uniksa poza jedną maszyną.

Dlaczego para Unix + C stała się wpływowa

Razem Unix i C pomogły zdefiniować „programowanie systemowe”: tworzenie systemów operacyjnych, bibliotek rdzeniowych i narzędzi w języku bliskim maszynie, ale nie związanemu z jednym procesorem. Ich wpływ widać w późniejszych systemach operacyjnych, narzędziach dla programistów i konwencjach, których wielu inżynierów uczy się po dziś dzień — nie z powodu mitu, lecz dlatego, że podejście sprawdziło się w praktyce.

Jak zaprojektowano C: mały, przenośny, blisko maszyny

Wczesne systemy operacyjne były w większości pisane w assemblerze. Dawało to pełną kontrolę nad sprzętem, ale każda zmiana była powolna, podatna na błędy i silnie związana z jednym procesorem. Nawet proste funkcje mogły wymagać stron niskopoziomowego kodu, a przeniesienie systemu na inną maszynę często oznaczało przepisanie dużej części od zera.

Od BCPL do B do C (krótkie streszczenie)

Dennis Ritchie nie wymyślił C w próżni. Wyrosło ono z wcześniejszych, prostszych języków systemowych używanych w Bell Labs.

- BCPL oferował zwięzły styl do pisania narzędzi i oprogramowania systemowego.

- B (stworzony przez Kena Thompsona) adaptował pomysły BCPL do prac nad wczesnym Unixem, ale brakowało mu typów danych i struktury potrzebnych do większych systemów.

- C zachował ducha „małego języka”, dodając funkcje, które uczyniły budowę i utrzymanie Uniksa praktycznym na prawdziwym sprzęcie.

Cel projektowy: cienka warstwa nad maszyną

C stworzono tak, by dobrze mapować na to, co faktycznie robią komputery: bajty w pamięci, arytmetyka na rejestrach i skoki w kodzie. Dlatego proste typy danych, jawny dostęp do pamięci i operatory zbliżone do instrukcji CPU są centralne dla języka. Możesz pisać kod wystarczająco wysokiego poziomu, by zarządzać dużą bazą kodu, ale nadal bezpośrednio kontrolować układ w pamięci i wydajność.

Co oznacza „przenośny” w prostych słowach

„Przenośny” znaczy, że ten sam kod źródłowy C można przenieść na inną maszynę i przy minimalnych zmianach skompilować go tam, uzyskując to samo zachowanie. Zamiast przepisywać system operacyjny dla każdego nowego procesora, zespoły mogły zachować większość kodu i wymienić jedynie niewielkie części zależne od sprzętu. Taka mieszanka — w większości wspólny kod i małe, specyficzne fragmenty — była przełomem, który pomógł Unixowi się rozprzestrzenić.

Główne idee, które czynią C szybkim

Szybkość C to nie magia — to w dużej mierze efekt tego, jak bezpośrednio odwzorowuje on pracę komputera i jak niewiele „dodatkowej pracy” znajduje się między twoim kodem a CPU.

Co produkuje kompilacja

C jest zwykle kompilowane. Piszesz czytelny kod źródłowy, a kompilator tłumaczy go na kod maszynowy: surowe instrukcje, które wykonuje procesor.

W praktyce kompilator tworzy plik wykonywalny (lub pliki obiektowe, które potem są linkowane). Kluczowy punkt: końcowy wynik nie jest interpretowany linia po linii w czasie działania — jest już w formie zrozumiałej dla CPU, co zmniejsza narzut.

Przewidywalna kontrola, niski narzut

C daje proste klocki konstrukcyjne: funkcje, pętle, liczby całkowite, tablice i wskaźniki. Ponieważ język jest mały i jawny, kompilator często może wygenerować prosty kod maszynowy.

Zazwyczaj nie ma obowiązkowego runtime'u wykonującego w tle śledzenie każdego obiektu, wstawianie ukrytych kontroli czy zarządzanie złożonymi metadanymi. Gdy piszesz pętlę, zwykle otrzymujesz pętlę. Gdy odczytujesz element tablicy, zwykle dostajesz bezpośredni dostęp do pamięci. Ta przewidywalność jest jednym z powodów, dla których C dobrze sprawdza się w miejscach wrażliwych na wydajność.

Ręczne zarządzanie pamięcią: kontrola z konsekwencjami

C używa ręcznego zarządzania pamięcią, co oznacza, że program wyraźnie rezerwuje pamięć (np. malloc) i wyraźnie ją zwalnia (np. free). To wynika z potrzeb oprogramowania systemowego, które wymaga drobnej kontroli nad kiedy pamięć jest przydzielana, ile i na jak długo — przy minimalnym narzucie.

Wymiana jest prosta: więcej kontroli to często więcej szybkości i efektywności, ale też większa odpowiedzialność. Jeśli zapomnisz zwolnić pamięć, zwolnisz ją dwa razy lub użyjesz pamięci po jej zwolnieniu, błędy mogą być poważne, a czasem krytyczne pod względem bezpieczeństwa.

C w systemach operacyjnych: jądra, sterowniki i biblioteki rdzeniowe

System operacyjny stoi na granicy między oprogramowaniem a sprzętem. Jądro musi zarządzać pamięcią, planować CPU, obsługiwać przerwania, komunikować się z urządzeniami i udostępniać wywołania systemowe, od których zależy reszta. Te zadania nie są abstrakcyjne — dotyczą czytania i zapisywania określonych miejsc w pamięci, pracy z rejestrami CPU i reagowania na zdarzenia pojawiające się w nieoczekiwanych momentach.

Dlaczego jądra i sterowniki potrzebują niskopoziomowego dostępu

Sterowniki i jądra potrzebują języka, który potrafi wyrazić „zrób dokładnie to” bez ukrytej pracy. W praktyce oznacza to:

- precyzyjną kontrolę nad układem pamięci (struktury zgodne ze sprzętem)

- bezpośrednią manipulację wskaźnikami przy mapowaniu pamięci urządzeń czy budowie tablic stron

- możliwość interakcji z przerwaniami i prymitywami współbieżności

- przewidywalne konwencje wywołań i minimalne wymagania runtime

C dobrze to oddaje, bo jego model opiera się na bajtach, adresach i prostym przepływie sterowania. Nie ma obowiązkowego runtime'u, garbage collectora czy systemu obiektowego, który jądro musiałoby hostować zanim w ogóle się uruchomi.

C jako domyślny wybór dla jąder i bibliotek rdzeniowych

Unix i wczesne prace nad systemami upowszechniły podejście, które współtworzył Ritchie: implementować dużą część OS w przenośnym języku, trzymając krawędź sprzętową cienką. Wiele nowoczesnych jąder nadal stosuje ten wzorzec. Nawet gdy potrzeba assemblera (kod startowy, przełączanie kontekstu), większość implementacji zwykle spoczywa w C.

C dominuje także w bibliotekach systemowych — standardowe biblioteki C, podstawowe komponenty sieciowe i elementy runtime niskiego poziomu, od których często zależą języki wyższego poziomu. Jeśli korzystałeś z Linux, BSD, macOS, Windows lub RTOS, niemal na pewno polegałeś na kodzie w C, nawet jeśli tego nie zauważyłeś.

Dlaczego zespoły nadal ufają C w tym obszarze

Apeal C w pracach nad OS to nie nostalgia, lecz ekonomia inżynieryjna:

- stabilne toolchany: kompilatory, linkery, debugery i profile są dojrzałe i dobrze poznane

- przenośność: ta sama baza kodu może być przeniesiona na nowe CPU i płytki z zarządzalnym wysiłkiem

- jasny model sprzętowy: łatwiej przewidzieć, co wygeneruje kompilator i jak kod zachowa się w rygorystycznych warunkach

Inne języki istnieją — ale C pozostaje punktem odniesienia

Rust, C++ i inne języki są używane w częściach systemów operacyjnych i mogą przynieść korzyści. Mimo to C pozostaje wspólnym mianownikiem: językiem, w którym napisane są liczne jądra, do którego wiele interfejsów niskiego poziomu jest dostosowanych i z którym muszą współdziałać inne języki systemowe.

C w urządzeniach wbudowanych: mały ślad, przewidywalna kontrola

Zbuduj aplikację towarzyszącą urządzeniu

Stwórz aplikację Flutter do diagnostyki, sprawdzania stanu i wsparcia w terenie.

„Wbudowane” zwykle oznacza komputery, o których nie myślimy jako o komputerach: mikrokontrolery w termostatach, głośnikach, routerach, samochodach, urządzeniach medycznych, czujnikach fabrycznych i niezliczonych AGD. Systemy te często wykonują jedno zadanie przez lata, cicho, przy ścisłych ograniczeniach kosztów, energii i pamięci.

Ograniczenia, z którymi żyją zespoły embedded

Wiele celów embedded ma kilobajty (nie gigabajty) RAM i ograniczoną pamięć flash na kod. Niektóre działają na bateriach i muszą spać przez większość czasu. Inne mają wymagania czasu rzeczywistego — jeśli pętla sterowania silnikiem spóźni się o kilka milisekund, sprzęt może zachować się niepoprawnie.

Te ograniczenia kształtują każdą decyzję: jak duży ma być program, jak często się budzi i czy jego timingi są przewidywalne.

Dlaczego C pasuje idealnie

C zwykle produkuje małe binaria z minimalnym narzutem runtime. Nie ma wymaganego wirtualnego maszyny i często można całkowicie uniknąć dynamicznej alokacji. To ma znaczenie, gdy musisz upchnąć firmware w określonej pamięci flash lub zagwarantować, że urządzenie nie „zatrzyma się” niespodziewanie.

Równie ważne jest to, że C ułatwia komunikację ze sprzętem. Układy embedded udostępniają peryferia — piny GPIO, timery, UART/SPI/I2C — przez rejestry mapowane do pamięci. Model C naturalnie się na to mapuje: możesz czytać i zapisywać konkretne adresy, sterować pojedynczymi bitami i robić to bez wielkiej abstrakcji stojącej na drodze.

Wzorce spotykane w projektach

Wiele kodu embedded w C to albo:

- bare-metal: brak systemu operacyjnego, tylko kod startowy, główna pętla i obsługi przerwań,

- na RTOSie: mały system czasu rzeczywistego, gdzie zadania C koordynują się za pomocą kolejek, semaforów i timerów.

W obu przypadkach zobaczysz kod operujący rejestrami sprzętowymi (często oznaczonymi volatile), bufory o stałym rozmiarze i ostrożne sterowanie czasem. Ten styl „blisko maszyny” to dokładnie powód, dla którego C pozostaje domyślnym wyborem dla firmware, które musi być małe, energooszczędne i niezawodne w terminach real-time.

C w oprogramowaniu krytycznym dla wydajności: tam, gdzie szybkość się opłaca

„Krytyczne dla wydajności” to każde miejsce, gdzie czas i zasoby wpływają na produkt: milisekundy wpływają na doświadczenie użytkownika, cykle CPU na koszt serwera, a wykorzystanie pamięci na to, czy program się w ogóle zmieści. W tych obszarach C nadal jest domyślną opcją, bo pozwala kontrolować układ danych w pamięci, harmonogram pracy i to, co kompilator może optymalizować.

Gdzie szybkość C ma znaczenie w praktyce

C często znajduje się w rdzeniu systemów, gdzie praca wykonywana jest przy dużym wolumenie lub pod ścisłymi wymaganiami opóźnień:

- bazy danych i silniki pamięci masowej (indeksowanie, cache, kompresja, wykonanie zapytań)

- kodeki audio/wideo i przetwarzanie obrazów (pętle enkodowania/dekodowania wykonywane miliardy razy)

- sieć (przetwarzanie pakietów, proxy, podstawowe algorytmy TLS, pętle zdarzeń)

- silniki gier (budżet klatek, fizyka, strumieniowanie zasobów)

- fragmenty HPC (jądra numeryczne, wektoryzowane procedury, niestandardowe alokatory pamięci)

Te domeny zwykle nie są „szybkie” wszędzie; mają konkretne wewnętrzne pętle dominujące czas wykonywania.

"Hot path": optymalizuj te 5%, które kosztują 95%

Rzadko ktoś przepisuje cały produkt na C tylko po to, by go przyspieszyć. Zwykle profiluje się, znajduje hot path (mały fragment kodu, gdzie spędza się większość czasu) i optymalizuje go.

C pomaga, bo hot path często ograniczają niskopoziomowe detale: wzorce dostępu do pamięci, zachowanie cache, przewidywanie rozgałęzień i narzut alokacji. Gdy możesz dopracować struktury danych, unikać zbędnych kopii i kontrolować alokacje, przyspieszenia mogą być znaczne — bez zmiany reszty aplikacji.

Współpraca z językami wyższego poziomu: rozszerzenia i FFI

Współczesne produkty są często wielojęzyczne: Python, Java, JavaScript czy Rust dla większości kodu, a C dla krytycznego rdzenia.

Typowe podejścia do integracji:

- rozszerzenia natywne (np. rozszerzenia C dla Pythona, Node-API dla Node)

- FFI (Foreign Function Interface), gdzie język wywołuje skompilowane funkcje C przez stabilne ABI

- biblioteki C jako zależności współdzielone używane przez wiele środowisk

Ten model utrzymuje praktyczność: szybkie iteracje w językach wysokiego poziomu i przewidywalna wydajność tam, gdzie ma to znaczenie. Kosztem jest ostrożność na granicach — konwersje danych, reguły własności i obsługa błędów — bo przekraczanie granicy FFI powinno być wydajne i bezpieczne.

Przenośność i standardy: co sprawia, że C tak dobrze podróżuje

Szybko zwaliduj hot path

Zamień pomysł na gorący punkt wydajności w działające narzędzie zanim zaczniesz optymalizować.

Jednym z powodów, dla których C tak szybko się rozprzestrzeniło, jest to, że się przenosi: ten sam rdzeń języka można zaimplementować na bardzo różnych maszynach, od mikrokontrolerów po superkomputery. Ta przenośność nie jest magią — to efekt wspólnych standardów i kultury pisania zgodnie z nimi.

Jak standardy uczyniły „C” tym samym językiem wszędzie

Wczesne implementacje C różniły się między producentami, co utrudniało dzielenie się kodem. Przełom nastąpił wraz z ANSI C (często C89/C90) i później ISO C (nowsze rewizje jak C99, C11, C17, C23). Nie trzeba pamiętać numerów wersji; ważne, że standard to publiczne porozumienie o działaniu języka i biblioteki standardowej.

Co daje standard C w praktyce

Standard zapewnia:

- spójne reguły języka (typy, operatory, sterowanie)

- bibliotekę standardową ze znanym zachowaniem (I/O, łańcuchy, matematyka, alokacja pamięci)

- bazę, którą autorzy kompilatorów mogą implementować, a zespoły polegać na niej

Dzięki temu kod pisany ze świadomością standardu można często przenieść między kompilatorami i platformami przy zaskakująco niewielkiej ilości zmian.

Gdzie przenośność w praktyce się łamie

Problemy z przenośnością zwykle wynikają z polegania na rzeczach, których standard nie gwarantuje, w tym:

- niezdefiniowane zachowanie: fragmenty kodu, które kompilator może traktować w dowolny sposób (np. odczyt poza granicami tablicy, użycie niezainicjalizowanej wartości)

- założenia co do rozmiarów:

int nie jest obiecane jako 32-bitowy, rozmiary wskaźników się różnią. Jeśli program milcząco zakłada konkretne rozmiary, może zawieść przy zmianie celu.

- platformowe API: wywoływanie funkcji specyficznych dla systemu operacyjnego może być konieczne, ale ogranicza zasięg działania kodu.

Praktyczna wskazówka: pisz „standard-first”, potem stroń

Dobrym domyślnym podejściem jest preferowanie biblioteki standardowej i trzymanie kodu nieprzenośnego w małych, jasno nazwanych wrapperach.

Kompiluj też w trybie wymuszającym przenośność i jednoznaczność, np.:

- wybierając standard (

-std=c11)

- włączając ostrzeżenia (

-Wall -Wextra) i traktując je poważnie

To połączenie — kod zgodny ze standardem oraz restrykcyjne builds — robi więcej dla przenośności niż jakikolwiek „sprytny” trik.

Trudna część: wskaźniki, pamięć i typowe klasy błędów

Moc C jest też jego ostrzem: pozwala pracować blisko pamięci. To duży powód, dla którego C jest szybki i elastyczny, ale też dlaczego początkujący (i zmęczeni eksperci) mogą popełniać błędy, które inne języki blokują.

Wskaźniki wyjaśnione przez „adresy skrzynek”

Wyobraź sobie pamięć programu jako długą ulicę ponumerowanych skrzynek pocztowych. Zmienne to skrzynki, które coś przechowują (np. liczbę całkowitą). Wskaźnik to nie rzecz sama w sobie, a adres zapisany na karteczce, mówiący, którą skrzynkę otworzyć.

To jest przydatne: możesz przekazywać adres zamiast kopiować zawartość skrzynki i wskazywać na tablice, bufory, struktury, a nawet funkcje. Ale jeśli adres jest błędny, otwierasz złą skrzynkę.

Typowe ryzyka

- Buffer overflow: zapis poza końcem bufora (jak upchnięcie zbyt wielu listów do skrzynki #10 i zalanie #11). Może to spowodować awarię programu lub być wykorzystane do ataku.

- Use-after-free: zwolnienie bloku pamięci, a potem użycie wskaźnika, który nadal „pamięta” stary adres — skrzynka mogła zostać przydzielona komuś innemu.

- Przepełnienia całkowitych: arytmetyka, która przechodzi poza zakres i zawija się, co może prowadzić np. do alokacji zbyt małego bufora i późniejszego overflow.

Dlaczego te błędy mają znaczenie

Te problemy objawiają się jako awarie, cicha korupcja danych i luki bezpieczeństwa. W kodzie systemowym — gdzie C jest często używane — takie błędy mogą wpłynąć na wszystko, co stoi powyżej.

Zrównoważony pogląd

C nie jest „domyślnie niebezpieczne”. Jest przyzwalające: kompilator zakłada, że wiesz, co robisz. To świetne dla wydajności i niskiego poziomu kontroli, ale łatwe do niewłaściwego użycia, jeśli nie towarzyszą temu dobre nawyki, przeglądy i narzędzia.

Uczynienie C bezpieczniejszym w praktyce

C daje bezpośrednią kontrolę, ale rzadko wybacza pomyłki. Dobrą wiadomością jest to, że „bezpieczny C” to rzadziej magiczne sztuczki, a częściej zdyscyplinowane nawyki, przejrzyste interfejsy i wykorzystanie narzędzi do nudnych kontroli.

Skalujące techniki defensywne

Zacznij od projektowania API, które utrudnia nieprawidłowe użycie. Preferuj funkcje przyjmujące rozmiary buforów razem ze wskaźnikami, zwracające jawne kody statusu i dokumentujące, kto jest właścicielem pamięci.

Sprawdzanie granic powinno być rutyną, nie wyjątkiem. Jeśli funkcja zapisuje do bufora, powinna walidować długości z góry i szybko kończyć przy błędzie. Dla własności pamięci: miej prostą regułę — jeden alokator, jedna ścieżka free i jasne zasady, kto zwalnia.

Narzędzia: łap błędy zanim trafią do użytkownika

Nowoczesne kompilatory potrafią ostrzegać o ryzykownych wzorcach — traktuj ostrzeżenia jako błędy w CI. Dodaj runtime'owe kontrole podczas rozwoju z sanitizers (address, undefined behavior, leak), by wykrywać zapisy poza granicami, use-after-free, przepełnienia całkowitych i inne typowe pułapki C.

Analiza statyczna i linters pomagają znaleźć problemy, które nie wychodzą w testach. Fuzzing jest szczególnie skuteczny dla parserów i handlerów protokołów: generuje nieoczekiwane wejścia, które często ujawniają błędy buforowania i stany maszyn.

Praktyki przeglądu i testowania

Przegląd kodu powinien świadomie szukać typowych porażek w C: off-by-one, brak NUL-terminatora, mieszanie typów ze znakiem/bez znaku, niekontrolowane wartości zwrotne i ścieżki błędów powodujące wycieki pamięci.

Testy są ważniejsze, gdy język nie chroni: testy jednostkowe są dobre; testy integracyjne lepsze; a testy regresji dla wcześniej znalezionych błędów są najlepsze.

Bezpieczne podzbiory i wytyczne

Jeśli projekt ma surowe wymagania niezawodności lub bezpieczeństwa, rozważ przyjęcie ograniczonego podzbioru C i pisemnych reguł (np. ograniczenie arytmetyki wskaźnikowej, zakaz niektórych wywołań bibliotecznych, wymaganie wrapperów). Klucz to konsekwencja: wybierz zasady, które zespół potrafi egzekwować narzędziami i przeglądami, a nie ideały, które zostaną jedynie zapisane na slajdzie.

C kontra inne języki: dlaczego zespoły wciąż go wybierają

Uruchom panel administracyjny

Stwórz panel administracyjny w React przez chat do przeglądania logów, ustawień i statusu urządzeń.

C znajduje się na nietypowym przecięciu: jest na tyle mały, że da się go zrozumieć w całości, a jednocześnie wystarczająco bliski sprzętowi i granicom OS, by być „klejem”, od którego zależy reszta. Ta kombinacja sprawia, że zespoły sięgają po niego, nawet gdy nowsze języki wyglądają ładniej na papierze.

C kontra C++: różne cele, kłopotliwa kompatybilność, praktyczne mieszanie

C++ dodawał silniejsze mechanizmy abstrakcji (klasy, szablony, RAII), pozostając w dużej mierze źródłowo kompatybilnym z C. Ale „kompatybilne” nie znaczy „identyczne”. C++ ma inne reguły dotyczące konwersji, rozstrzygania przeciążeń, a nawet tego, co jest poprawnym deklarowaniem w brzegu przypadków.

W produktach często miesza się je w praktyczny sposób:

- moduły niskiego poziomu zostają w C dla stabilnych ABI i prostych konwencji wywołań,

- wyższe warstwy korzystają z C++ dla konstrukcji i bezpieczniejszego zarządzania zasobami.

Mostem jest zwykle granica API w C. Kod C++ eksportuje funkcje jako extern \"C\" by uniknąć manglingu nazw, a obie strony porozumiewają się prostymi strukturami danych. Pozwala to na stopniową modernizację bez przepisania wszystkiego.

C kontra Rust (ogólnie): bezpieczeństwo wygrywa, ale są ograniczenia

Obietnica Rust to bezpieczeństwo pamięci bez GC, wspierane silnym narzędziem i ekosystemem pakietów. W projektach greenfield Rust może wyeliminować całe klasy błędów (use-after-free, warunki wyścigu).

Ale adopcja nie jest darmowa. Zespoły mogą być ograniczone przez:

- istniejące biblioteki C, sterowniki czy SDK dostawców

- kompilatory i debugery zwalidowane dla konkretnych platform

- reżimy certyfikacyjne, gdzie dojrzałość narzędzi i dowody mają znaczenie

- inżynierów, którzy będą utrzymywać kod przez dekadę

Rust może współpracować z C, ale granica zwiększa złożoność, a nie każde środowisko embedded czy buildowe jest równie dobrze wspierane.

Ogromna część podstawowego kodu świata jest w C i jego przepisywanie jest ryzykowne i kosztowne. C pasuje też do środowisk, gdzie potrzebne są przewidywalne binaria, minimalne założenia runtime i szeroka dostępność kompilatorów — od małych mikrokontrolerów po popularne CPU.

Wybieraj według ograniczeń, nie trendów

Jeśli potrzebujesz maksymalnego zasięgu, stabilnych interfejsów i sprawdzonych toolchainów, C nadal jest racjonalnym wyborem. Jeśli twoje ograniczenia pozwalają i bezpieczeństwo jest priorytetem, nowszy język może być wart rozważenia. Najlepsza decyzja zwykle zaczyna się od docelowego sprzętu, narzędzi i planu utrzymania, a nie od tego, co jest modne w danym roku.

Jak może wyglądać przyszłość (i jak uczyć się C dziś)

C nie „zniknie”, ale jego środek ciężkości staje się czytelniejszy. Będzie dalej prosperować tam, gdzie kontrola nad pamięcią, timingiem i binariami ma znaczenie — i tracić grunt tam, gdzie ważniejsze są bezpieczeństwo i szybkość iteracji.

Gdzie C pozostanie mocne

C prawdopodobnie zostanie domyślnym wyborem dla:

- jąder i prac niskopoziomowych w OS (schedulery, zarządcy pamięci, systemy plików), gdzie potrzebna jest przewidywalna wydajność i minimalne założenia runtime,

- sterowników i kodu blisko sprzętu, gdzie mapuje się rejestry, obsługuje przerwania i działa w ścisłych ograniczeniach,

- systemów wbudowanych z ograniczonym RAM/flash i wymaganiami real-time,

- bibliotek rdzeniowych i runtime'ów (kompresja, kryptografia, VM-y języków, kodeki multimedialne), gdzie stabilne ABI i szeroka przenośność są cenne.

Te obszary ewoluują powoli, mają ogromne bazy kodu i wynagradzają inżynierów zdolnych myśleć o bajtach, konwencjach wywołań i trybach awarii.

Gdzie C może tracić udział (i dlaczego)

Dla nowego tworzenia aplikacji wiele zespołów woli języki z mocniejszymi gwarancjami bezpieczeństwa i bogatszymi ekosystemami. Błędy pamięci są kosztowne, a współczesne produkty często priorytetyzują szybkie dostarczanie, konkurencyjność i domyślne bezpieczeństwo. Nawet w programowaniu systemowym niektóre nowe komponenty przenoszą się do bezpieczniejszych języków — podczas gdy C pozostaje „fundamentem”, z którym się interfejsują.

Uwaga o współczesnym workflow: C w większym produkcie

Nawet gdy rdzeń niskiego poziomu jest w C, zespoły zwykle potrzebują otaczającego oprogramowania: panelu webowego, serwisu API, portalu zarządzania urządzeniami, narzędzi wewnętrznych czy prostej aplikacji mobilnej do diagnostyki. Warstwa wyższa to często miejsce, gdzie liczy się tempo iteracji.

Jeśli chcesz szybko ruszyć z tymi warstwami bez przebudowy całego pipeline'u, Koder.ai może pomóc: to platforma vibe-coding, gdzie przez chat możesz stworzyć aplikacje webowe (React), backendy (Go + PostgreSQL) i mobilne (Flutter) — przydatne do szybkiego prototypowania panelu administracyjnego, przeglądarki logów czy systemu zarządzania flotą. Tryb planowania i eksport źródeł ułatwiają prototypowanie, a potem przeniesienie kodu tam, gdzie potrzebujesz.

Jak uczyć się C dziś (praktyczna ścieżka)

Zacznij od fundamentów, ale ucz się ich tak, jak profesjonaliści używają C:

- Składnia i model danych: liczby całkowite, tablice, struktury, podstawy wskaźników i ich odwzorowanie w pamięci.

- Narzędzia budowania: kompilacja i linkowanie, organizacja nagłówków, prosty Makefile (później CMake).

- Debugowanie: krokowe śledzenie z gdb/lldb; nauka czytania backtrace'ów.

- Nawyki bezpieczeństwa: kompiluj z ostrzeżeniami, używaj AddressSanitizer/UBSan i pisz małe testy.

Jeśli chcesz więcej artykułów o systemach i ścieżek nauki, przeglądaj /blog.