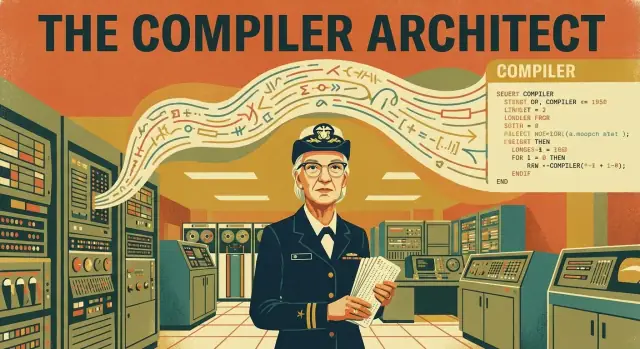

Dlaczego Grace Hopper wciąż ma znaczenie dla tego, jak programujemy

Większość z nas pisze kod oczekując, że będzie czytelny, wielokrotnego użytku i względnie przenośny. Nadajemy zmiennym sensowne nazwy, korzystamy z bibliotek i zakładamy, że nasz program uruchomi się na maszynach, których nigdy nie widzieliśmy. To oczekiwanie nie pojawiło się przypadkiem. Jest wynikiem dużego przesunięcia w podziale pracy między ludźmi a komputerami — a kompilatory są tym mostem.

Kluczowe pytanie: co się zmieniło i dlaczego to było ważne?

Wczesni programiści nie „pisali kodu” tak, jak o tym myślimy dziś. Zarządzali komputerami na poziomie tak szczegółowym i delikatnym, że każda instrukcja przypominała ręczne składanie maszyny. Kluczowe pytanie brzmi:

Jak programowanie przeszło od rzemiosła specyficznego dla sprzętu do praktyki zorientowanej na człowieka, którą zespoły mogą utrzymywać przez dłuższy czas?

Rola Hoppera: sprawić, by maszyna dopasowała się do człowieka

Grace Hopper odegrała w tej zmianie kluczową rolę, bo forsowała radykalną jak na tamte czasy myśl: komputer powinien wykonywać więcej pracy tłumaczenia. Zamiast zmuszać ludzi do pisania długich, podatnych na błędy sekwencji dopasowanych do jednej maszyny, Hopper pomogła zainicjować wczesne prace nad narzędziami przypominającymi kompilatory — systemami, które mogły przekształcać bardziej przyjazne ludziom instrukcje w niskopoziomowe kroki, które komputer rzeczywiście wykonuje.

Jej prace udowodniły, że „tłumaczenie” nie jest luksusem. To przełom w produktywności. Jeśli możesz wyrażać zamiar jaśniej, możesz:

- pisać programy szybciej,

- łatwiej wykrywać błędy,

- udostępniać kod innym,

- aktualizować oprogramowanie bez przepisywania wszystkiego od zera.

Czego dowiesz się z tego artykułu

Przejdziemy przez to, jak wyglądało programowanie przed kompilatorami, czym w praktyce jest kompilator (bez żargonu) i jak prace Hoppera nad A-0 oraz pojawienie się COBOL-a pchnęły oprogramowanie w stronę czytelnych, znormalizowanych języków. Po drodze zobaczysz praktyczne konsekwencje, które wciąż kształtują współczesny rozwój: przenośność, pracę zespołową, długoterminowe utrzymanie i codzienne założenie, że kod powinien być zrozumiały dla ludzi — nie tylko dla maszyn.

Jeśli kiedykolwiek skorzystałeś z czytelnych komunikatów o błędach, przenośnego kodu albo języka zaprojektowanego tak, by czytać go jak instrukcje, żyjesz w świecie, który pomogła zbudować Hopper.

Programowanie przed kompilatorami: ciężka droga

Grace Hopper nie zaczynała z celem "ułatwienia" programowania. Zaczynała tam, gdzie wymagała tego wczesna informatyka: od ograniczeń maszyny. Wykształcona jako matematyczka, w czasie II wojny światowej wstąpiła do US Navy i została przydzielona do pracy przy Harvard Mark I, jednym z pierwszych dużych komputerów elektromechanicznych.

Mark I nie był laptopem, który możesz zrestartować po błędzie — to był zajmujący całą salę zasób, z którego korzystał zespół, planowany starannie i traktowany jak drogi sprzęt laboratoryjny.

Jak wyglądało programowanie bez kompilatorów

Przed kompilatorami programowanie przypominało bardziej podłączanie panelu sterowania niż pisanie tego, co dziś rozpoznalibyśmy jako kod. Instrukcje musiały dokładnie odpowiadać potrzebom sprzętu, często w postaci kodów numerycznych lub bardzo niskopoziomowych operacji. Jeśli chciałeś, by maszyna dodała, porównała lub przesunęła wartości, wyrażałeś to w jej własnym słownictwie — krok po kroku.

Ta praca była:

- ręczna: sam tłumaczyłeś swoją logikę na drobne operacje.

- podatna na błędy: pojedyncza pomyłka w cyfrze lub adresie mogła wszystko zrujnować.

- powolna w zmianach: nawet drobne aktualizacje wymagały sprawdzenia długich łańcuchów instrukcji.

Prawdziwe ograniczenie: czas był drogi

Wczesne komputery były rzadkie, a „czas maszyny” był elementem budżetu. Nie można było swobodnie uruchamiać programu dziesięć razy, by zobaczyć, co się stanie. Zespoły przygotowywały wszystko ostrożnie, podwójnie sprawdzały, a potem czekały na swoją kolej. Każda minuta zmarnowana na uniknione błędy była minutą, w której nie rozwiązywano rzeczywistego problemu.

To ciśnienie ukształtowało myślenie Hoppera: jeśli ludzie poświęcają więcej wysiłku na mówienie językiem maszyny niż na rozwiązanie zadania, wąskie gardło to nie tylko sprzęt — to metoda.

Kod maszynowy, asembler i problem ludzkiego czasu

Przed kompilatorami programiści mówili do komputerów w ich „rodzimym” języku.

Kod maszynowy, prosto

Kod maszynowy to ciąg 0 i 1, które procesor może wykonać bezpośrednio. Każdy wzorzec oznacza coś w rodzaju „dodaj te dwie liczby”, „przesuń tę wartość” lub „skocz do innego kroku”. Jest precyzyjny — i niezwykle trudny dla ludzi do czytania, pisania i debugowania.

Asembler: mały krok ku czytelności

Asembler to kod maszynowy z przyjaznymi nazwami. Zamiast surowych bitów piszesz krótkie słowa jak LOAD, ADD czy JUMP oraz adresy pamięci. Assembler tłumaczy te słowa na dokładne 0 i 1 dla konkretnej maszyny.

Asembler był łatwiejszy niż czysty kod maszynowy, ale nadal zmuszał ludzi do myślenia jak sprzęt: rejestry, lokalizacje pamięci i dokładna kolejność operacji.

Dlaczego wczesne programy były przywiązane do sprzętu

Wczesne komputery nie były wymienne. Różne maszyny miały różne zestawy instrukcji, układy pamięci, a nawet inne sposoby reprezentacji liczb. Program napisany dla jednego procesora często nie mógł uruchomić się na innym.

Oprogramowanie było mniej jak „przepis” a bardziej jak klucz pasujący do jednego zamka.

Kiedy drobne zmiany wymagały dużych przeróbek

Ponieważ programy budowano z niskopoziomowych kroków, „prośba” o zmianę — na przykład dodanie kolumny do raportu, zmiana formatu pliku czy korekta zaokrągleń — mogła rozlać się na cały program.

Jeśli nowa funkcja wymagała dodatkowych instrukcji, mogłeś musieć przearanżować adresy pamięci, zaktualizować cele skoków i sprawdzić każde miejsce, które zakładało stary układ. Czas maszyny był cenny, ale czas ludzki był prawdziwym wąskim gardłem — i był spalany na szczegółach niezwiązanych z problemem biznesowym.

Wielka idea: co robi kompilator

Wczesne komputery były potężne, lecz boleśnie literalne. Potrafiły wykonywać tylko instrukcje wyrażone w ograniczonym zestawie operacji, które rozumiał ich sprzęt. To sprawiało, że programowanie często wyglądało jak pisanie bezpośrednio do maszyny, krok po kroku.

Kompilator odwrócił ten wzorzec pracy: zamiast tego, by ludzie „mówili maszynie”, mogli pisać instrukcje w bardziej przyjaznej formie — a oprogramowanie zajmowało się tłumaczeniem. W praktycznym sensie to program, który pomaga tworzyć programy.

Co właściwie oznacza „kompilowanie”?

Kompilacja to proces zamiany kodu, który ludzie mogą czytać i pisać, w instrukcje maszynowe, które komputer może wykonać. Możesz to porównać do tłumaczenia przepisu na dokładne naciśnięcia przycisków, których potrzebuje robot kuchenny.

Na wysokim poziomie kompilator zazwyczaj:

- czyta twój kod źródłowy (tekst, który napisałeś),

- sprawdza go pod kątem błędów i niespójności,

- tłumaczy na niższy poziom, który maszyna może uruchomić (często tworząc plik wykonywalny lub inny wynik).

Magia nie polega na tym, że komputer nagle „rozumie” język naturalny. Magia polega na tym, że kompilator wykonuje żmudną, podatną na błędy konwersję szybko i spójnie.

Kompilator kontra interpreter (częste nieporozumienie)

Ludzie często mylą kompilatory z interpreterami, bo oba pomagają uruchamiać przyjazny ludziom kod.

Prosty sposób rozróżnienia:

- Kompilator tłumaczy cały program (lub duże jego kawałki) z wyprzedzeniem, produkując coś, co komputer może uruchomić.

- Interpreter uruchamia program, tłumacząc i wykonując go krok po kroku w czasie rzeczywistym.

Oba podejścia mogą wyglądać podobnie z zewnątrz („piszę kod i on działa”), ale różnią się przepływem pracy i kompromisami wydajnościowymi. Dla historii Hoppera kluczowe jest to, że kompilacja sprawiła, iż „pisanie kodu” przestało być zależne od szczegółów sprzętowych, a stało się wyrażaniem zamiaru.

A-0 Hoppera i pierwsze kroki w kierunku kompilatorów

System A-0 Grace Hopper (datowany często na 1952 rok) to jedno z najwcześniejszych narzędzi przypominających kompilator — choć nie wyglądał jak nowoczesne kompilatory tłumaczące pełny, naturalnopodobny język na kod maszynowy.

Co robił A-0 (prosto)

Zamiast pisać każdą instrukcję ręcznie, programista mógł napisać program odwołujący się do wcześniej zbudowanych procedur przez identyfikator. A-0 następnie:

- wyszukiwał żądane procedury w katalogu (liście bibliotek),

- pobierał odpowiednie bloki kodu maszynowego dla tych procedur,

- składał je razem w kompletny program wykonywalny (co dziś nazwalibyśmy linkowaniem).

Programista nie prosił jeszcze komputera o „zrozumienie” kodu podobnego do angielskiego. Prosił go o zautomatyzowanie powtarzalnej, podatnej na błędy pracy montażowej: wybieranie i łączenie znanych bloków budulcowych.

Podprogramy i biblioteki: mniej powtórzeń, mniej błędów

A-0 opierał się na potężnej idei: podprogramach. Jeśli miałeś już przetestowaną procedurę do obsługi wejścia/wyjścia, operacji matematycznych czy przesuwania danych, nie musiałeś jej przepisywać za każdym razem.

To zmieniło codzienną pracę na dwa zasadnicze sposoby:

- Szybkość: zespoły mogły tworzyć nowe programy, ponownie wykorzystując istniejące elementy.

- Niezawodność: używanie sprawdzonych procedur zmniejszało szansę na wprowadzenie nowych błędów przez duplikację.

Zmiana mentalności: programowanie jako ponowne użycie + automatyzacja

Głębszy wpływ A-0 był nie tylko techniczny — był kulturowy. Sugerował, że programowanie może polegać na opisywaniu, co chcesz złożyć z pewnych niezawodnych komponentów, i pozwoleniu narzędziom wykonywać mechaniczną pracę.

To podejście — używaj bibliotek, standaryzuj procedury i automatyzuj tłumaczenie — stało się fundamentem kompilatorów, standardowych języków i współczesnych praktyk tworzenia oprogramowania.

Kod przyjazny ludziom: nacisk na czytelność

Od projektu do wdrożenia

Wdróż i hostuj aplikację bez składania nowego potoku ręcznie.

Wczesni programiści nie walczyli tylko ze sprzętem — walczyli też z wzajemnymi przekonaniami, jak powinno wyglądać „poważne” programowanie. Dla wielu inżynierów poważna praca miała przypominać sprzęt: była zwartą, numeryczną i jednoznaczną. Wszystko, co przypominało zwykły język, wydawało się podejrzanie niedokładne.

Dlaczego kod „po angielsku” brzmiał źle

Grace Hopper argumentowała, że komputery powinny służyć ludziom, a nie odwrotnie. Jej postulaty o czytelniejszej notacji — instrukcjach bliższych terminologii biznesowej niż operacjom sprzętowym — były kontrowersyjne, bo podważały przekonanie, że efektywność wymaga, aby człowiek myślał w kształcie maszyny.

Sceptycy obawiali się, że polecenia przypominające angielski będą niejednoznaczne, ukrywać ważne szczegóły i sprzyjać niedbałości. Hopper odpowiadała praktycznie: większość czasu spędzanego przy programach to nie pisanie instrukcji, lecz ich późniejsze rozumienie.

Czytelność to strategia utrzymania

Czytelny kod nie ma na celu uczynienia programów „łatwymi”; chodzi o to, by były przetrwalne. Gdy kod komunikuje zamiar, zespoły szybciej przeglądają zmiany, wdrażają nowych ludzi bez wielu błędów i diagnozują problemy bez inżynierii wstecznej każdej decyzji.

Ma to znaczenie tym bardziej przez lata. Oprogramowanie żyje dłużej niż role, działy, a czasem nawet pierwotny cel, dla którego zostało stworzone. Ludzkoprzyjazna struktura i nazewnictwo zmniejszają koszt zmian — często największy koszt w oprogramowaniu.

Kompromisy: wydajność, narzędzia i wczesny sceptycyzm

Podejście Hoppera miało ograniczenia. Wczesne kompilatory i narzędzia były niedojrzałe, a kod wysokiego poziomu mógł dawać wolniejsze lub większe programy niż dopracowany ręcznie asembler. Debugowanie też mogło być pośrednie: błędy pojawiały się w wygenerowanym kodzie, a nie w źródle.

Mimo to długoterminowy zysk był jasny: czytelne źródło pozwalało budować większe systemy z większą liczbą ludzi — i utrzymywać je długie lata po wysłaniu pierwszej wersji.

COBOL i przejście ku znormalizowanym językom

COBOL (Common Business-Oriented Language) powstał z prostego celu: uczynić programy czytelnymi dla ludzi zarządzających biznesem, a nie tylko dla osób łączących maszyny. Grace Hopper mocno popierała tę ideę — jeśli kod ma żyć przez lata, przechodzić między zespołami i przetrwać rotację kadry, musi być zrozumiały.

Co próbował osiągnąć COBOL

COBOL zaprojektowano pod kątem przetwarzania danych biznesowych: listy płac, inwentaryzacje, fakturowanie i inne zadania, gdzie „kształt” danych jest równie ważny jak obliczenia. Dlatego COBOL kładł duży nacisk na rekordy, pola i jasne opisy tego, co program robi.

Częścią ambicji była jasność. COBOL przyjął strukturę podobną do angielskiej, aby ktoś przeglądający program mógł zrozumieć zamiar. Nie chodziło o to, by uczynić programowanie „łatwym” — chodziło o to, by uczynić je czytelnym i utrzymywalnym tam, gdzie błąd w systemach biznesowych mógł kosztować bardzo dużo.

Komitety, standardy i dlaczego to miało znaczenie

Prawdziwy przełom COBOL-a to nie tylko składnia. To było przejście do standaryzacji.

Zamiast być związanym z jednym producentem sprzętu czy prywatnym językiem firmy, COBOL kształtował się przez komitety i formalne specyfikacje. Ten proces bywał powolny i polityczny, ale stworzył wspólny cel, który mogło implementować wiele firm.

W praktyce oznaczało to, że organizacje mogły inwestować w COBOL z większą pewnością: materiały szkoleniowe działały dłużej, zatrudnianie było prostsze, a kod miał większe szanse przetrwać zmianę sprzętu.

Standaryzacja zmieniła też oczekiwania. Języki przestały być tylko narzędziami „dołączanymi do maszyny”. Stały się publicznymi umowami — zasadami dotyczącymi tego, jak ludzie piszą instrukcje i jak kompilatory je tłumaczą.

Zrównoważony pogląd: mocne strony i krytyka

Zalety COBOL-a są łatwe do wyjaśnienia: jest jawny, struktury danych są centralne, i wspiera długowieczne systemy biznesowe. Ta trwałość nie jest przypadkowa; to wynik wyborów projektowych faworyzujących czytelność i stabilność.

Krytyka też jest realna. COBOL potrafi być rozwlekły, a jego czytelność może wydawać się sztywna w porównaniu z nowoczesnymi językami. Jednak rozwlekłość często była celowa: kod pokazuje swoje działanie, co pomaga w audytach, konserwacji i przekazywaniu systemu.

COBOL wyznacza punkt zwrotny, gdy języki zaczęły zachowywać się mniej jak osobiste skróty, a bardziej jak infrastruktura kierowana standardami — wspólna, ucząca i zbudowana na przetrwanie.

Z jednej maszyny na wiele: przenośność i standaryzacja

Posiadaj swój kod źródłowy

Zachowaj kontrolę, eksportując kod źródłowy i kontynuując rozwój gdziekolwiek chcesz.

Wczesne programy często były „przywiązane” do konkretnej maszyny. Jeśli zmieniłeś komputer, nie przenosiłeś tylko plików — często przepisywałeś program, bo instrukcje i konwencje były inne. To czyniło oprogramowanie kruche i drogie oraz spowalniało adopcję nowego sprzętu.

Przenośność: prawdziwe „napisz raz, uruchom (prawie) wszędzie”

Kompilatory wprowadziły potężne rozdzielenie: piszesz program w języku wyższego poziomu, a kompilator tłumaczy go na natywne instrukcje konkretnego komputera.

To właśnie oznacza przenośność: ten sam kod źródłowy można zbudować dla różnych maszyn — o ile istnieje odpowiedni kompilator (i unikasz założeń specyficznych dla sprzętu). Zamiast przepisywać system płacowy dla każdej nowej maszyny, organizacje mogły zachować logikę i po prostu rekompilować.

Lepszy sprzęt bez przepisania oprogramowania

Ta zmiana zmieniła ekonomikę ulepszeń sprzętowych. Producenci mogli wypuszczać szybsze lub bardziej zaawansowane maszyny, a klienci nie musieli wyrzucać lat inwestycji w oprogramowanie.

Kompilatory stały się rodzajem „warstwy adaptacyjnej” między stabilnymi potrzebami biznesu a szybko zmieniającą się technologią. Można było zaktualizować procesory, modele pamięci i urządzenia peryferyjne, zachowując intencję aplikacji. Niektóre zmiany nadal wymagały aktualizacji — zwłaszcza dotyczące wejścia/wyjścia — ale rdzeń logiki nie był już związany z jednym zestawem kodów operacyjnych.

Standaryzacja: wspólne języki, wspólne ekosystemy

Przenośność rośnie znacząco, gdy język jest standaryzowany. Zasady sprawiają, że kod napisany dla jednego kompilatora znacznie częściej kompiluje się na innym, zmniejszając uzależnienie od dostawcy i ułatwiając współdzielenie oprogramowania.

To dziedzictwo widać dziś wszędzie:

- aplikacje wieloplatformowe budowane z jednego kodu źródłowego (desktop, mobile, web),

- znormalizowane języki i środowiska wykonawcze, które zachowują przewidywalne zachowanie na różnych systemach,

- duże ekosystemy — biblioteki, narzędzia, i rynki pracy — które istnieją, ponieważ ludzie ufają, że „ten sam kod” będzie mniej więcej znaczył to samo w różnych miejscach.

Dążenie Grace Hopper do przyjaznego ludziom, szeroko używalnego programowania nie było tylko wygodą. Pomogło przekształcić oprogramowanie z instrukcji zależnych od maszyny w przenośny zasób, który mógł przetrwać pokolenia sprzętu.

Jak kompilatory zmieniły pracę i utrzymanie oprogramowania

Kompilatory nie tylko przyspieszyły pisanie — przekształciły organizację pracy nad oprogramowaniem. Gdy kod mógł być pisany w terminach wyższego poziomu (bliższych regułom biznesowym niż instrukcjom sprzętowym), różni ludzie mogli efektywniej się angażować.

Nowe role, wyraźniejsze przekazania

Wczesne projekty często dzieliły pracę na role: analitycy (którzy definiowali, co system ma robić), programiści (którzy tłumaczyli to na kod) i operatorzy (którzy uruchamiali zadania i zarządzali dostępem do maszyny). Dzięki kompilatorom analitycy mogli opisywać przepływy w bardziej ustrukturyzowany, spójny sposób, a programiści poświęcali mniej czasu na „ręczne składanie” instrukcji i więcej na projektowanie logiki odpowiadającej tym przepływom.

Rezultatem było czystsze przekazanie: wymagania → czytelny kod źródłowy → skompilowany program. To sprawiło, że duże projekty były mniej zależne od wąskich specjalistów znających specyfikę jednej maszyny.

Utrzymanie stało się prawdziwym rachunkiem

Gdy oprogramowanie zaczęło żyć latami — nie tygodniami — utrzymanie stało się głównym kosztem. Poprawki, aktualizacje i drobne zmiany polityk sumowały się. Czytelny kod źródłowy uczynił to wykonalnym: ktoś nowy mógł zrozumieć zamiar bez odtwarzania tysięcy niskopoziomowych kroków.

Kompilatory wspierały to, zachęcając do struktury: nazwanych zmiennych, wielokrotnego użycia procedur i przejrzystego przepływu sterowania. Gdy kod sam się tłumaczy, utrzymanie przestaje być archeologią.

Lepsze praktyki testowania i debugowania

Jaśniejsze abstrakcje poprawiły też testowanie i debugowanie. Zamiast ścigać pojedynczą złą instrukcję, zespoły mogły rozumować o funkcjach („to obliczenie błędne przy zwrotach”) i izolować problem do modułu lub funkcji.

Nawet gdy kompilatory produkowały wczesne, niezgrabne błędy, skłaniały do wartościowej dyscypliny: utrzymuj źródło zorganizowane, weryfikuj zachowanie krok po kroku i wprowadzaj zmiany tam, gdzie wyrażono znaczenie — nie tam, gdzie akurat sprzęt przechowuje bity.

Powszechne mity o kompilatorach i „łatwym” programowaniu

Kompilatory tłumaczą instrukcje przyjazne ludziom na instrukcje przyjazne maszynie. Ta zmiana przyspieszyła tworzenie i udostępnianie oprogramowania — ale wykształciła też kilka mitów, które wciąż pojawiają się w rozmowach o kodowaniu.

Mit 1: „Kompilator sprawia, że program jest poprawny”

Kompilator głównie sprawdza, czy twój kod przestrzega reguł języka i daje się przetłumaczyć. Jeśli twoja logika jest błędna, kompilator często bez problemu wygeneruje poprawny technicznie program, który robi coś niezgodnego z twoim zamiarem.

Na przykład kalkulacja płac może się skompilować poprawnie, a mimo to wypłacać złe kwoty z powodu błędnego wzoru, brakującego przypadku brzegowego lub nieprzemyślanej strefy czasowej.

Mit 2: „Języki wysokiego poziomu zapobiegają błędom”

Języki wysokiego poziomu redukują pewne klasy błędów — na przykład mylenie instrukcji CPU czy ręczne zarządzanie pamięcią — ale nie eliminują błędów. Nadal możesz:

- źle obsłużyć wejście i stworzyć luki bezpieczeństwa,

- napisać kod, który działa w „normalnych” przypadkach, ale zawodzi w wyjątkowych,

- zbudować system trudny do zmiany, bo jest niejasny lub niespójny.

Czytelność to wielki zysk, ale czytelność nie równa się poprawności.

Mit 3: „Jeśli to jest czytelne, musi być bezpieczne i wydajne”

Kod może mieć dobre nazwy i być ładnie sformatowany, a mimo to być niebezpieczny (np. ufać wejściu od użytkownika), wolny (np. powtarzające się wywołania do bazy w pętli) lub kruchy (np. ukryte zależności).

Lepsze ujęcie jest takie: czytelny kod ułatwia znalezienie problemów i naprawę ich. Nie gwarantuje, że ich nie ma.

Praktyczne nawyki, które biją mity

Kompilatory są narzędziami, nie nianiami. Niezawodność wciąż wynika z praktyk zespołu:

- Nazewnictwo: wybieraj nazwy wyjaśniające zamiar, nie tylko mechanikę.

- Dokumentacja: zapisz założenia (wejścia, wyjścia, ograniczenia).

- Przeglądy kodu: poproś o drugie oko przed wdrożeniem zmian.

- Testy: automatycznie sprawdzaj zachowanie, by zmiany nie łamały starych obietnic.

Grace Hopper postulowała kod zrozumiały dla ludzi. Najlepszym dokończeniem tego jest łączenie czytelności z dyscypliną, która zapobiega temu, by „łatwe” nie stało się „niedbałe”.

Dziedzictwo kompilatorów w nowoczesnych językach i narzędziach

Zamień zamiar w kod

Opisz aplikację prostym językiem i otrzymaj prawdziwy kod webowy, backendowy lub mobilny do przeglądu.

Główna teza Hoppera była prosta: jeśli możemy opisać pracę w terminach zrozumiałych dla ludzi, komputery powinny zająć się tłumaczeniem. Ten pomysł jest wbudowany w praktycznie każde nowoczesne doświadczenie programistyczne — od pisania w Pythonie czy JavaScripcie po wypuszczanie aplikacji z przemysłowymi łańcuchami kompilacji.

Od „automatycznego programowania” do współczesnych łańcuchów narzędzi

Dziś „kompilator” rzadko jest jednym programem. To potok: parsowanie kodu, sprawdzenie, transformacja, optymalizacja i produkcja czegoś możliwego do uruchomienia (kod maszynowy, bytecode lub zoptymalizowany bundle). Niezależnie czy piszesz w Go, Rust, Swift czy C#, korzystasz z tej samej obietnicy Hoppera: zmniejszyć nudną, powtarzalną pracę ludzką, zachować jasność intencji i pozwolić maszynom wykonywać monotonne tłumaczenie.

To też wyjaśnia, dlaczego rozwój idzie w kierunku wyższych poziomów interfejsu, które wciąż produkują realne systemy do wdrożenia. Na przykład w Koder.ai, opisujesz, co chcesz w interfejsie czatu, a agentowy przepływ pracy pomaga generować i dopracowywać aplikację (web, backend lub mobilną), dalej produkując eksportowalny kod źródłowy. W bardzo Hopperowskim sensie cel jest ten sam: przesunąć wysiłek z nudnego tłumaczenia ku jasnym zamiarom, przeglądalnemu wynikowi i szybszym iteracjom.

Funkcje poprawiające komfort, które dziś uznajemy za oczywiste

Nowoczesne kompilatory nie tylko tłumaczą — uczą i chronią.

Gdy zobaczysz komunikat o błędzie wskazujący dokładną linię i sugerujący poprawkę, to dziedzictwo traktowania programowania jako aktywności ludzkiej, a nie rytuału maszynowego.

Optymalizacja to kolejna cicha korzyść: kompilatory potrafią przyspieszyć lub zmniejszyć rozmiar kodu bez wymuszania ręcznego dopracowywania każdej instrukcji.

Analiza statyczna (często wbudowana w kompilatory lub towarzyszące narzędzia) wykrywa problemy wcześniej — niedopasowania typów, nieosiągalny kod, możliwe błędy null — zanim oprogramowanie trafi do klientów.

Jak to objawia się w codziennej pracy

To wszystko przekłada się na szybsze cykle rozwoju: piszesz jaśniejszy kod, narzędzia wcześniej wykrywają problemy, a buildy produkują przewidywalne wyniki w różnych środowiskach. Nawet jeśli nigdy nie użyjesz słowa „kompilator”, odczuwasz to za każdym razem, gdy twoje IDE podkreśla błąd, budowanie CI zgłasza precyzyjną diagnostykę lub wydanie działa szybciej po aktualizacji toolchainu.

To wizja Hoppera powtarzana w codziennej praktyce.

Najważniejsze wnioski: przesunięcie, które zmieniło oprogramowanie na zawsze

Prace Hoppera nad kompilatorami nie tylko ułatwiły programowanie — zmieniły to, czym oprogramowanie może być. Przed kompilatorami każdy postęp zależał od mozolnej, niskopoziomowej pracy. Po kompilatorach większa część czasu ludzkiego mogła iść na pomysły, reguły i zachowanie, zamiast na tłumaczenie instrukcja po instrukcji.

Co się naprawdę zmieniło — i dlaczego to przetrwało

Dwie zmiany zrobiły różnicę:

- Automatyzacja: kompilator przejął powtarzalne zadanie zamiany znaczących instrukcji na kroki gotowe dla maszyny. To zmniejszyło błędy ręczne i przyspieszyło iteracje.

- Czytelność: kod zbliżył się do języka ludzkiego i logiki biznesowej. Programy stały się dokumentami, które zespoły mogą omawiać, przeglądać i utrzymywać — nie tylko zagadkami, które rozumiał wyłącznie pierwotny autor.

Te korzyści wzmacniały się nawzajem. Gdy kod jest łatwiejszy do odczytania, łatwiej go ulepszać. Gdy tłumaczenie jest zautomatyzowane, zespoły mogą pozwolić sobie na refaktoryzację i dostosowywanie oprogramowania do zmieniających się potrzeb. Dlatego kompilatory nie były jednorazowym trikiem — stały się fundamentem nowoczesnych języków, narzędzi i współpracy.

Główna konkluzja: kompilatory skalują wysiłek ludzki

Kompilator to mniej kwestia „uczynienia programowania łatwym”, a bardziej uczynienia programowania skalowalnym. Pozwala zamiarowi jednej osoby podróżować dalej: przez większe projekty, większe zespoły, dłuższe okresy i więcej maszyn.

Krótkie ćwiczenie dla twojego kodu

Jeśli jutro dołączy ktoś nowy do twojego zespołu, jaka jest jedna mała zmiana, którą możesz wprowadzić, by szybciej zrozumiał twój kod — lepsze nazwy, czytelniejsza struktura czy krótki komentarz wyjaśniający "dlaczego"?