Co oznaczają „koszt, czas i tarcie” w pracy nad oprogramowaniem

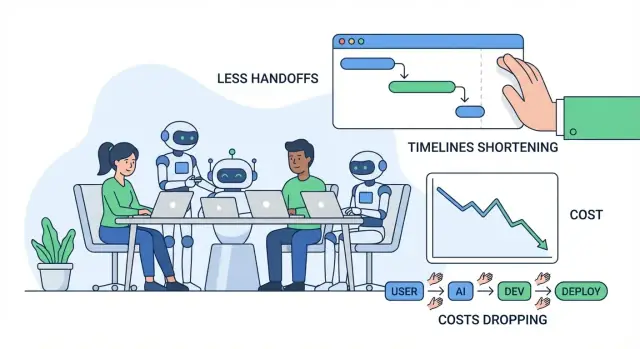

Kiedy mówi się o usprawnieniu dostarczania oprogramowania, zwykle chodzi o trzy rzeczy: koszt, czas i tarcie. Są one powiązane, ale to nie to samo — warto je jasno zdefiniować, zanim porozmawiamy o AI.

Koszt: za co płacisz

Koszt to całkowite wydatki potrzebne, by wypuścić i utrzymać funkcję: pensje i godziny wykonawców, rachunki za chmurę, narzędzia oraz „ukryte” koszty spotkań, koordynacji i naprawiania błędów. Funkcja, która zajmuje dodatkowe dwa tygodnie, nie tylko kosztuje więcej godzin inżynieryjnych — może też opóźnić przychody, zwiększyć obciążenie wsparcia lub zmusić do dłuższego utrzymywania starych systemów.

Czas: od pomysłu do wartości dla klienta

Czas to kalendarzowy okres od „powinniśmy to zbudować” do „klienci mogą z tego korzystać niezawodnie”. Obejmuje rozwój, ale też decyzje, zatwierdzenia, oczekiwanie na przeglądy, środowiska, wyniki QA oraz odpowiedzi od osób z odpowiednim kontekstem.

Tarcie: wysiłek tracony na przeszkody i przerwania

Tarcie to codzienny opór, który sprawia, że praca idzie wolniej niż powinna: niejasne wymagania, wielokrotne wyjaśnienia, przełączanie kontekstu, dublowanie pracy czy długie przekazy między rolami/zespołami.

Większość marnotrawstwa w projektach pojawia się jako przekazania, przeróbki i oczekiwanie. Małe nieporozumienie na początku może zamienić się w przeprojektowanie, polowanie na błędy lub powtarzające się spotkania. Wolna kolejka przeglądów lub brak dokumentacji może zablokować postęp nawet wtedy, gdy wszyscy są „zajęci”.

Co oznacza „narzędzia AI” (a czego nie oznaczają)

W tym artykule narzędzia AI obejmują copiloty kodowe, asystentów czatowych do badań i wyjaśnień, automatyczną analizę wymagań i ticketów, generowanie testów oraz automatyzację przepływów pracy w QA/DevOps.

AI może zmniejszyć wysiłek i przyspieszyć cykle — ale nie usuwa odpowiedzialności. Zespoły nadal potrzebują jasnej własności, zdrowego osądu, kontroli bezpieczeństwa i ludzkiego zatwierdzenia tego, co trafia do produkcji.

Gdzie projekty programistyczne zwykle tracą czas i pieniądze

Większość przekroczeń budżetu nie wynika z „trudnego kodowania”. Wynika z codziennych wąskich gardeł, które się kumulują: niejasne wymagania, ciągłe przełączanie kontekstu, wolne pętle przeglądów i ręczne testowanie wykonywane zbyt późno.

Typowe wąskie gardła (i dlaczego są kosztowne)

Niejasne wymagania generują największe koszty później. Małe nieporozumienie na początku może przemienić się w tydzień przeróbek — zwłaszcza gdy różne osoby różnie interpretują tę samą funkcję.

Przełączanie kontekstu to cichy zabójca produktywności. Inżynierowie przeskakują między ticketami, pytaniami na czacie, spotkaniami i problemami produkcyjnymi. Każde przełączenie ma koszt restartu: ładowanie kodu, historii decyzji i „dlaczego”.

Wolne przeglądy nie tylko opóźniają mergowanie — opóźniają też uczenie się. Jeśli feedback przychodzi po kilku dniach, autor przeszedł do czegoś innego i naprawa zajmuje więcej czasu.

Ręczne testy i późne QA często oznaczają, że problemy są wykrywane, gdy ich naprawa jest najdroższa: po dodaniu kolejnych funkcji lub tuż przed wydaniem.

Ukryte koszty, których ludzie nie uwzględniają

Oczywiste koszty to pensje i opłaty vendorów. Ukryte często bolą bardziej:

- Przeróbki: przepisywanie kodu i przeprojektowywanie przepływów, bo wymagania się zmieniły lub były źle zrozumiane.

- Opóźnienia: oczekiwanie na decyzje, zatwierdzenia, środowiska testowe lub „jedną kluczową osobę”.

- Koszty koordynacji: synchronizacja między produktem, designem, inżynierią, QA, bezpieczeństwem i interesariuszami.

Prosty workflow: pomysł → wydanie (z punktami bólu)

Idea → wymagania → projekt → budowa → przegląd → test → wydanie → monitorowanie

Typowe punkty bólu: wymagania (niejasność), build (przerwania), przegląd (kolejka), test (ręczny wysiłek), wydanie (przekazania), monitorowanie (wolne rozwiązywanie problemów).

Szybka diagnoza: mapowanie tarcia

Spróbuj „mapy tarcia” w 30-minutowej sesji: wypisz każdy krok, a następnie zaznacz (1) gdzie praca czeka, (2) gdzie decyzje stoją w miejscu i (3) gdzie następuje przeróbka. Te obszary to miejsca, w których narzędzia AI często przynoszą najszybsze oszczędności — redukując nieporozumienia, przyspieszając feedback i eliminując powtarzalne prace.

Wspomagane przez AI odkrywanie i wymagania: mniej nieporozumień

Etap discovery to miejsce, gdzie wiele projektów cicho zboczy z kursu: notatki są rozproszone, opinie sprzeczne, a decyzje w głowach ludzi. AI nie zastąpi rozmów z użytkownikami, ale może zmniejszyć „stratę tłumaczenia” między rozmowami, dokumentami a tym, co naprawdę budują inżynierowie.

Zmień nieporządne dane wejściowe w użyteczne wymagania

Zespoły często zbierają stertę notatek z badań — transkrypty wywiadów, tickety wsparcia, fragmenty rozmów sprzedażowych, odpowiedzi z ankiet — i mają problem z szybkim wydobyciem wzorców. Narzędzia AI mogą przyspieszyć ten krok poprzez:

- Streszczanie długich notatek badawczych w spójne wnioski (punkty bólu, cele, obiekcje)

- Grupowanie feedbacku w tematy (np. problemy z onboardingiem kontra brak integracji)

- Szkicowanie początkowych user stories i jobs-to-be-done ze surowych danych

To nie tworzy automatycznie prawdy, ale daje jasny punkt wyjścia, który łatwiej skrytykować, dopracować i uzgodnić.

Określ zakres i kryteria akceptacji wcześniej

Nieporozumienia zwykle wychodzą później jako przeróbki „to nie o to chodziło”. AI pomaga, szybko tworząc pierwsze wersje:

- Granic zakresu (co jest w vs. co jest poza zakresem tej wersji)

- Scenariuszy brzegowych i „a co z…” bazujących na podobnych wzorcach

- Kryteriów akceptacji wystarczająco konkretnych, by je przetestować

Na przykład, jeśli wymaganie mówi „użytkownicy mogą eksportować raporty”, AI może podpowiedzieć zespołowi, by doprecyzował: formaty (CSV/PDF), uprawnienia, zakres dat, zachowanie względem stref czasowych oraz czy eksporty są wysyłane mailem czy pobierane. Uzyskanie tych odpowiedzi wcześniej zmniejsza churn w trakcie developmentu i QA.

Spójna dokumentacja, której się używa

Gdy wymagania żyją w dokumentach, wątkach czatu i ticketach, zespoły płacą stały „podatek przełączania kontekstu”. AI może pomóc utrzymać jedną, czytelną narrację, tworząc i aktualizując:

- Podsumowania spotkań z decyzjami i otwartymi pytaniami

- Dokumenty wymagań i opisy ticketów w spójnym szablonie

- Słowniki terminów domenowych (by „konto”, „workspace” i „org” się nie myliły)

Korzyść to mniej przerwań („co ustaliliśmy?”) i płynniejsze przekazania między produktem, designem, inżynierią i QA.

Zabezpieczenia: waliduj założenia, nie outsourcuj ich

Wyniki AI należy traktować jako hipotezy, nie jako wymagania. Użyj prostych zabezpieczeń:

- Zawsze weryfikuj streszczenia z oryginalnymi źródłami (zwłaszcza cytaty i liczby)

- Oznacz niepewne elementy jako pytania i potwierdź je z użytkownikami i interesariuszami

- Zachowaj własność decyzji w zespole: AI szkicuje, ludzie zatwierdzają

Użyte w ten sposób, wspomagane AI discovery zmniejsza nieporozumienia bez osłabiania odpowiedzialności — obniżając koszt, czas i tarcie, zanim pojawi się pierwszy wiersz kodu.

Szybsze prototypowanie i iteracja projektowa z AI

Prototypowanie to miejsce, gdzie wiele zespołów albo oszczędza tygodnie — albo je traci. AI sprawia, że eksplorowanie pomysłów jest tańsze, więc możesz zweryfikować, czego naprawdę chcą użytkownicy, zanim poświęcisz czas inżynierów na pełną implementację.

Szybkie "pierwsze wersje" ekranów i przepływów

Zamiast zaczynać od pustej strony, możesz użyć AI do wygenerowania:

- Tekstów UI dla przycisków, komunikatów o błędach, kroków onboardingu i stanów pustych (z opcjami tonu: „przyjazny” vs. „formalny”)

- Pomysłów na wireframe jako prostych opisów ekranów (co jest na stronie, co jest główne vs. drugorzędne)

- Przykładowych ścieżek użytkownika: „nowy użytkownik rejestruje się → importuje dane → ustawia cel → otrzymuje przypomnienie”

Te szkice nie są finalnym designem, ale dają zespołowi coś konkretnego do zareagowania. To zmniejsza wymiany typu „myślałem, że chodziło o X” lub „wciąż nie zgadzamy się co do przepływu”.

Szybkie aplikacje demo i proof-of-concept

Do wielu decyzji produktowych nie potrzebujesz kodu produkcyjnego, by się czegoś nauczyć. AI może pomóc złożyć podstawową aplikację demo lub POC, która pokaże:

- Główną interakcję (co użytkownik klika, co widzi dalej)

- Przykładowe dane i realistyczne scenariusze brzegowe

- Prosty „happy path” wystarczający do wewnętrznej oceny lub wywiadów z użytkownikami

Jeśli chcesz pójść dalej niż statyczne makiety, platformy vibe-coding takie jak Koder.ai mogą być przydatne do szybkich iteracji: opisujesz funkcję w interfejsie czatowym, generujesz roboczą wersję aplikacji webowej lub mobilnej (często React na web i Flutter na mobile), a następnie dopracowujesz ją z interesariuszami przed rozpoczęciem pełnego cyklu inżynieryjnego.

Skąd biorą się rzeczywiste oszczędności czasu

Największe oszczędności zwykle nie wynikają z „czasu projektowego”. Pochodzą z uniknięcia pełnych wdrożeń niewłaściwej rzeczy. Gdy prototyp ujawnia niejasności, brak kroków lub niejasną wartość, możesz zmienić kierunek, gdy koszty zmian są jeszcze niskie.

Ważne ostrzeżenie: nie wdrażaj przez pomyłkę kodu prototypowego

Prototypy generowane przez AI często pomijają istotne elementy: kontrole bezpieczeństwa, dostępność, wydajność, obsługę błędów i strukturę łatwą do utrzymania. Traktuj kod prototypowy jako wyrzucalny, chyba że świadomie go wzmacniasz — inaczej ryzykujesz przekształcenie szybkiego eksperymentu w długoterminową pracę do poprawy.

Jeśli zamierzasz przekształcić prototyp w prawdziwą funkcję, wprowadź procesy, które to explicite zaznaczają (np. tryb planowania, snapshoty i rollback). To pomaga zespołom działać szybko bez utraty śledzenia zmian.

Szybsze programowanie z asystentami AI (i gdzie najbardziej pomagają)

Asystenci kodowi są najbardziej wartościowi w mało efektownych częściach developmentu: dojściu od „nic” do działającego punktu startowego oraz usuwaniu pracy powtarzalnej, która spowalnia zespoły. Nie zastępują osądu inżynierskiego — ale mogą skrócić czas między pomysłem a przeglądalnym pull requestem.

Jak zmniejszają czas „przy pustej stronie"

Kiedy zaczynasz nowy endpoint, zadanie lub przepływ UI, pierwsza godzina często idzie na podłączenia, nazewnictwo i kopiowanie wzorców z istniejącego kodu. Asystenci mogą szybko przygotować wstępną strukturę: foldery, podstawowe funkcje, obsługę błędów, logowanie i placeholderowe testy. Dzięki temu inżynierowie poświęcają więcej czasu na logikę produktu i scenariusze brzegowe, a mniej na boilerplate.

Dla zespołów, które chcą pójść dalej niż „asysta w edytorze”, platformy takie jak Koder.ai pakują to w pełny workflow: od specyfikacji w czacie do uruchamialnej aplikacji z backendem (często Go + PostgreSQL), z opcjami eksportu kodu źródłowego i wdrożenia/hostingiem. Praktyczna korzyść to zmniejszenie kosztu koordynacji związanego z „dotarciem do czegoś, co można przejrzeć”.

Zadania, w których najlepiej się sprawdzają

Najlepiej działają na zamkniętych, opartych na wzorcach zadaniach, zwłaszcza gdy baza kodu ma jasne konwencje:

- Scaffolding: nowe trasy/kontrolery, ekrany CRUD, komendy CLI, background jobs, wrappery SDK.

- Refaktory: zmiana nazw i reorganizacja modułów, wyodrębnianie funkcji, stosowanie spójnej obsługi błędów, aktualizacja przestarzałych API.

- Translacje: przenoszenie małych komponentów między językami/ramami (np. Python do TypeScript) z testami potwierdzającymi zachowanie.

- Małe funkcje: dobrze ograniczone dodatki typu filtr, eksport, handler webhooka czy reguła walidacji.

- Narzędzia wewnętrzne: strony admina, skrypty, poprawki danych, generatory raportów — wysoka wartość, niska dbałość o UX.

Wzory promptów, które dają użyteczny kod

Dobre promptu wyglądają mniej jak „napisz funkcję X”, a bardziej jak mini-spec. Zawrzyj:

- Kontekst: co moduł robi, gdzie się znajduje i jakie API go otaczają.

- Ograniczenia: biblioteki, reguły stylu, wymagania wydajnościowe, bezpieczeństwo.

- Przykłady: istniejące podobne pliki lub próbki wejście/wyjście.

- Testy akceptacyjne: scenariusze brzegowe i „done means…” (nawet w prostym języku).

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

Przegląd jest obowiązkowy

Kod wygenerowany przez AI nadal potrzebuje tych samych standardów: code review, przeglądu bezpieczeństwa i testów. Programiści są nadal odpowiedzialni za poprawność, obsługę danych i zgodność — traktuj asystenta jako szybki draft, a nie autorytet.

Redukcja cykli przeglądów i przeróbek dzięki AI

Code review to miejsce, gdzie kumuluje się wiele „ukrytych kosztów”: oczekiwanie na feedback, ponowne wyjaśnianie intencji i naprawianie tych samych kategorii problemów. AI nie zastąpi osądu recenzenta, ale może zmniejszyć czas poświęcany na mechaniczne kontrole i nieporozumienia.

Jak AI pomaga w code review

Dobry workflow AI wspiera recenzentów, zanim ci otworzą PR:

- Streszczanie zmian: Generuje prosty opis po ludzku, co PR robi, jakie pliki zmieniono i jakie zachowanie ma zmienić. To pomaga szybciej się skupić i redukuje komentarze „o co tu chodzi?”.

- Wykrywanie ryzykownych wzorców: Zaznacza typowe źródła bugów — brakujące sprawdzenia null, niebezpieczne parsowanie stringów, kruche logiki czasowe, nieobsłużone błędy lub podejrzane zmiany uprawnień.

- Sugestie testów: Proponuje konkretne przypadki testowe na podstawie diffu („dodaj test dla niepoprawnego wejścia”, „assert dostępu dla roli X”, „pokryj nowy przypadek brzegowy w paginacji”).

Mniej ping-ponga z przeglądami

AI może też poprawić jasność i spójność, co często napędza długie wymiany:

- Tworzy lepsze opisy PR (motywacja, podejście, kompromisy).

- Wymusza spójność nazewnictwa i formatowania, aby uniknąć subiektywnych debat.

- Sugeruje małe refaktory, które upraszczają kod, dzięki czemu recenzenci nie proszą o ogromne przepisywania później.

Praktyczne zasady, które zachowują bezpieczeństwo

Używaj AI do przyspieszenia przeglądu, nie do obniżania standardów:

- Zatwierdzenie człowieka jest obowiązkowe dla każdego PR.

- Dopasuj sugestie AI do style guide i reguł lint.

- Utrzymuj PRy małe i skupione, aby ludzie i AI mogli je łatwo zrozumieć.

Gdzie AI nadal ma problemy

AI jest najsłabsze w logice domenowej i architekturze: reguły biznesowe, przypadki brzegowe związane z rzeczywistymi użytkownikami i kompromisy systemowe wciąż wymagają doświadczenia. Traktuj AI jako pomocnika recenzenta — nie jako recenzenta.

AI w testowaniu i QA: wykrywaj problemy wcześniej przy mniejszym nakładzie ręcznej pracy

Testowanie to miejsce, gdzie małe nieporozumienia zmieniają się w kosztowne niespodzianki. AI nie gwarantuje jakości, ale może usunąć wiele powtarzalnej pracy — dzięki czemu ludzie mają więcej czasu na trudne przypadki, które faktycznie psują produkt.

Automatyczne generowanie testów: zacznij od rzeczywistych ścieżek kodu

Narzędzia AI mogą proponować testy jednostkowe, analizując istniejący kod i identyfikując powszechne ścieżki wykonania ("happy path"), oraz gałęzie, które łatwo pominąć (obsługa błędów, null/empty, retry, timeout). Gdy dostarczysz krótki spec lub kryteria akceptacji, AI może zasugerować przypadki brzegowe bezpośrednio z wymagań — np. wartości graniczne, niepoprawne formaty, sprawdzenia uprawnień i „co jeśli usługa zewnętrzna jest niedostępna?”.

Najlepsze użycie to przyspieszenie: otrzymujesz pierwszy szkic testów szybko, a potem inżynierowie dopracowują asercje, by pasowały do prawdziwych reguł biznesowych.

Szybsze dane testowe, mocki i fixtury

Zaskakującym kosztem w QA jest tworzenie realistycznych danych testowych i podpinanie mocków. AI może pomóc przez:

- Generowanie reprezentatywnych próbek rekordów (w tym „dziwnych” przypadków) zgodnych z zasadami walidacji

- Pisanie mocków/stubów dla usług zewnętrznych z przewidywalnymi odpowiedziami

- Tworzenie wielokrotnego użytku fixtur, które skracają i upraszczają testy

To przyspiesza zarówno testy jednostkowe pisane przez programistów, jak i testy integracyjne, zwłaszcza gdy angażuje się wiele API.

Lepsze raporty o błędach: jaśniejsze, szybsze naprawy

Gdy problemy docierają do QA lub produkcji, AI może poprawić zgłoszenia błędów, zmieniając chaotyczne notatki w uporządkowane kroki reprodukcji oraz wyraźnie oddzielając oczekiwane vs. rzeczywiste zachowanie. Mając logi lub output konsoli, potrafi podsumować wzorce (co zawiodło najpierw, co się powtarza, co koreluje z awarią), dzięki czemu inżynierowie nie tracą pierwszej godziny na zrozumienie zgłoszenia.

Kontrole jakości (nie negocjowalne)

Testy generowane przez AI nadal muszą być:

- Znaczące: asercje powiązane z rzeczywistymi wymaganiami, nie tylko „nie wyrzuca wyjątku”

- Deterministyczne: bez kruchego timing, losowych seedów czy niestabilnych zależności zewnętrznych

- Utrzymywane: traktowane jak kod produkcyjny — przeglądane, dobrze nazwane i aktualizowane wraz ze zmianą zachowania

Użyte w ten sposób AI zmniejsza ręczny wysiłek i pomaga zespołom wychwycić problemy wcześniej — gdy ich naprawa jest najtańsza.

Wydania i operacje: mniej oczekiwania, szybsze rozwiązywanie problemów

Praca przy wydaniu to miejsce, gdzie „małe opóźnienia” się kumulują: niestabilny pipeline, niejasny błąd, brakująca wartość konfiguracyjna lub wolne przekazanie między dev a ops. Narzędzia AI pomagają skrócić czas między „coś się zepsuło” a „wiemy, co robić dalej”.

AI dla CI/CD i DevOps

Nowoczesne systemy CI/CD generują dużo sygnałów (logi buildów, output testów, zdarzenia deployów). AI potrafi streścić ten hałas do krótkiego, wykonalnego widoku: co padło, gdzie pojawiło się po raz pierwszy i co się ostatnio zmieniło.

Może też zasugerować prawdopodobne naprawy w kontekście — np. wskazać niezgodność wersji w obrazie Dockera, błędną kolejność kroków w workflow lub brakującą zmienną środowiskową — bez ręcznego przeglądania setek linii.

Jeśli korzystasz z platformy end-to-end takiej jak Koder.ai do budowy i hostingu, funkcje operacyjne takie jak snapshoty i rollback również mogą zmniejszyć ryzyko wydania: zespoły mogą eksperymentować, wdrażać i szybko cofać zmiany, gdy rzeczywistość odbiega od planu.

Wsparcie przy incydentach: szybsze hipotezy i check-listy

Podczas incydentów najważniejsze są pierwsze 15–30 minut. AI może:

- Szkicować hipotezy przyczyn na podstawie logów, alertów i ostatnich wdrożeń

- Generować checklistę remediacyjną (rollback, wyłączenie flagi, skalowanie, czyszczenie kolejki, weryfikacja połączeń DB)

- Proponować ukierunkowane komendy i zapytania, by potwierdzić lub wyeliminować hipotezy

To zmniejsza obciążenie on-call przez przyspieszenie triage — nie przez zastępowanie ludzi odpowiedzialnych za serwis. Własność, osąd i odpowiedzialność pozostają po stronie zespołu.

Uwaga o bezpieczeństwie (nie pomijaj tego)

AI jest pomocne tylko wtedy, gdy używa się go bezpiecznie:

- Nie wklejaj sekretów (klucze API, tokeny, dane klientów) do promptów — używaj redakcji i zasady najmniejszych uprawnień.

- Traktuj output AI jako sugestie, nie jako zmiany. Code review, zatwierdzenia i zarządzanie zmianami nadal obowiązują.

- Preferuj narzędzia, które działają na zanonimizowanych logach i prowadzą audyt działania dla zgodności.

Dokumentacja i dzielenie się wiedzą: mniej przerwań i przekazań

Dobra dokumentacja to jeden z najtańszych sposobów na zmniejszenie tarcia inżynieryjnego — a mimo to często spada na dalszy plan, gdy terminy robią się napięte. AI pomaga zamienić dokumentację z zadania „na później” w lekką, powtarzalną część codziennej pracy.

Co AI może przyspieszyć (bez zabierania odpowiedzialności)

Zespoły zwykle szybko widzą korzyści w dokumentacji o jasnych wzorcach:

- Dokumentacja API: generowanie opisów endpointów, przykładów request/response i tabel błędów z istniejących specyfikacji lub komentarzy w kodzie.

- Runbooki: szkicowanie krok po kroku playbooków incydentowych („Jeśli X alert, sprawdź Y, potem zrób Z”) na podstawie przeszłych ticketów i postmortem.

- Changelogi i release notes: streszczanie zmergowanych PR-ów do wersji dla klientów i wewnętrznych.

- Przewodniki onboardingowe: tworzenie checklisty „pierwszy tydzień”, przeglądy serwisów i słowniki na podstawie struktury repozytorium i istniejącej dokumentacji.

Kluczowe jest to, że AI tworzy mocny pierwszy szkic; ludzie potwierdzają, co jest prawdziwe, co można bezpiecznie udostępnić i co jest istotne.

Mniej przerwań, mniej wąskich gardeł

Gdy dokumentacja jest przeszukiwalna i aktualna, zespół spędza mniej czasu na odpowiadaniu na powtarzające się pytania typu „Gdzie jest konfiguracja?” lub „Jak uruchomić lokalnie?”. To zmniejsza przełączanie kontekstu, chroni czas skupienia i zapobiega gromadzeniu wiedzy u jednej „osoby oczywistej”.

Dobrze utrzymana dokumentacja też zmniejsza przekazania: nowi członkowie zespołu, QA, wsparcie i interesariusze nietechniczni mogą znaleźć odpowiedzi sami, zamiast czekać na inżyniera.

Praktyczny workflow, który się utrzyma

Prosty wzorzec działa w wielu zespołach:

- Generuj aktualizacje dokumentów z PR-ów (podsumowanie + co się zmieniło + jak to testować)

- Edytuj i weryfikuj ręcznie (dokładność, bezpieczeństwo, dopasowanie do odbiorcy)

- Wersjonuj dokumenty w repo obok kodu, aby zmiany były przeglądane i wypuszczane razem z kodem

Dostępność dla nietechnicznych czytelników

AI może przepisać gęste notatki na jaśniejszy język, dodać spójne nagłówki i ujednolicić strukturę stron. To sprawia, że dokumentacja jest użyteczna poza inżynierią — bez wymagania, by inżynierowie stawali się profesjonalnymi pisarzami.

Pomiar ROI: jak policzyć oszczędności bez zgadywania

ROI robi się niejasne, gdy pytasz tylko „Czy wypuściliśmy szybciej?”. Lepsze podejście to policzyć konkretne źródła kosztów, które AI porusza, a potem porównać baseline do przebiegu z AI dla tego samego workflow.

Zmapuj swoje rzeczywiste źródła kosztów

Zacznij od wypisania kubełków, które faktycznie się ruszają w twoim zespole:

- Godziny inżynieryjne: budowa, przegląd, test, poprawki, przeróbki.

- Wydatki chmurowe: pozostawione środowiska, wolne pipeline, powtarzane uruchomienia testów.

- Subskrypcje narzędzi: miejsca AI, narzędzia testowe, monitoring, narzędzia projektowe.

- Obciążenie wsparcia: obsługa incydentów, triage błędów, tickety klientów.

- Koszt opóźnienia: przesunięte przychody, kary umowne, koszt utraconych okazji.

Proste porównanie baseline vs. z AI

Wybierz jedną funkcję lub sprint i podziel czas na fazy. Potem zmierz dwie wartości na fazę: średnie godziny bez AI vs. z AI, plus nowe koszty narzędzia.

Lekki wzór:

Savings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost

ROI % = Savings / Tool_cost × 100

Nie potrzebujesz idealnego śledzenia — użyj dzienników czasu, czasu cyklu PR, liczby rund przeglądu, współczynnika flaków testów i lead time to deploy jako przybliżeń.

Nie ignoruj „kosztu ryzyka”

AI może też wprowadzić koszty, jeśli jest niezarządzane: ekspozycja bezpieczeństwa, problemy licencyjne/IP, luki zgodności lub obniżona jakość kodu. Oceń je jako oczekiwany koszt:

- Koszt ryzyka = Prawdopodobieństwo × Wpływ (np. przeróbki po znalezieniu luki bezpieczeństwa, czas na naprawę po audycie).

Zacznij od małych kroków, potem skaluj

Zacznij od jednego workflow (np. generowanie testów lub wyjaśnianie wymagań). Uruchom go przez 2–4 tygodnie, zanotuj metryki before/after i dopiero potem rozprzestrzeniając do innych zespołów. To zamienia adopcję AI w mierzalny cykl poprawy, a nie zakup na zasadzie wiary.

Ryzyka i zabezpieczenia: bezpieczeństwo, jakość i zgodność

AI potrafi usunąć wiele mozolnej pracy, ale też wprowadza nowe tryby awarii. Traktuj output AI jak silne autouzupełnianie: przydatne do przyspieszenia, nie jako źródło prawdy.

Kluczowe ryzyka do zaplanowania

Po pierwsze, nieprawidłowe lub niepełne wyniki. Modele mogą brzmieć wiarygodnie, ale pominąć przypadki brzegowe, wymyślić API lub wygenerować kod, który przejdzie tylko happy-path test.

Po drugie, wycieki bezpieczeństwa. Wklejanie sekretów, danych klientów, logów incydentów lub własnego kodu do niezatwierdzonych narzędzi może prowadzić do niezamierzonej ekspozycji. Jest też ryzyko generowania niebezpiecznych wzorców kodowych (słabe uwierzytelnianie, niebezpieczna deserializacja, zapytania podatne na injection).

Po trzecie, licencje/IP. Wygenerowany kod może przypominać chronione fragmenty lub wprowadzać zależności z niekompatybilnymi licencjami, jeśli deweloperzy kopiują bez zastanowienia.

Po czwarte, stronnicze lub niespójne decyzje. AI może wpływać na priorytety, treść lub ocenę w sposób, który niezamierzenie wyklucza użytkowników lub łamie wewnętrzne zasady.

Praktyczne zabezpieczenia, które utrzymują prędkość

Stosuj przegląd człowieka jako regułę, nie sugestię: wymagaj code review dla zmian wygenerowanych przez AI i poproś recenzentów o sprawdzenie bezpieczeństwa, obsługi błędów i testów — nie tylko stylu.

Dodaj lekkie zasady i kontrolę dostępu: tylko zatwierdzone narzędzia, SSO, uprawnienia oparte na rolach oraz jasne zasady, jakie dane można udostępniać.

Prowadź ścieżki audytu: loguj prompt i output w zatwierdzonych środowiskach tam, gdzie to możliwe, i odnotowuj, kiedy AI było używane do wymagań, kodu lub testów.

Podstawy pracy z danymi

Unikaj wysyłania danych wrażliwych (PII, poświadczeń, logów produkcyjnych, kontraktów klientów) do ogólnych narzędzi AI. Wybieraj zatwierdzone środowiska, redakcję i przykłady syntetyczne.

Konkluzja

Wyniki AI to sugestie, nie gwarancje. Z zabezpieczeniami — przeglądy, polityki, kontrola dostępu i śledzenie — możesz osiągnąć zyski prędkości bez poświęcania bezpieczeństwa, jakości czy zgodności.

Praktyczna mapa wdrożeniowa dla zespołów każdej wielkości

Adopcja narzędzi AI działa najlepiej, gdy traktujesz ją jak każdą inną zmianę procesową: zacznij od małego, ustandaryzuj działające elementy i rozbudowuj z jasnymi zabezpieczeniami. Cel nie jest „użyć AI wszędzie” — celem jest usunięcie możliwych do uniknięcia wymian, przeróbek i oczekiwania.

Faza 1: Pilotaż (1–2 tygodnie)

Wybierz jeden zespół i jeden workflow, gdzie błędy są niskiego ryzyka, a oszczędności czasu widoczne (np. pisanie user stories, generowanie przypadków testowych, refaktory małego modułu). Trzymaj zakres wąski i porównuj z normalnym baseline.

Faza 2: Standardy (lekko, nie biurokratycznie)

Zapisz, jak wygląda „dobre użycie AI” dla twojego zespołu.

- Szablony promptów: krótkie, wielokrotnego użytku promptu do typowych zadań (dopieszczenie wymagań, notatki do przeglądu kodu, szkice planów testów).

- Lista kontrolna przeglądu: co ludzie muszą zweryfikować (poprawność, bezpieczeństwo, przypadki brzegowe, zgodność z wymaganiami).

- Lista Do/Nie:

- Do: dostarczaj kontekst, ograniczenia, kryteria akceptacji i przykłady.

- Don’t: nie wklejaj sekretów, poświadczeń produkcyjnych ani danych własnościowych, których nie wolno udostępniać.

Faza 3: Szkolenie (2–4 krótkie sesje)

Naucz ludzi, jak zadawać lepsze pytania i jak walidować wyniki. Skoncentruj się na praktycznych scenariuszach: „zamień niejasne wymaganie w testowalne kryteria akceptacji” lub „wygeneruj plan migracji, a potem sprawdź ryzyka”.

Faza 4: Automatyzacja (tam, gdzie powtarzalność boli)

Gdy zespół zaufa workflow, zautomatyzuj powtarzalne elementy: szkice opisów PR, szkielety testów, notatki wydania i triage ticketów. Zachowaj krok zatwierdzenia człowieka dla wszystkiego, co trafia do produkcji.

Jeśli oceniasz platformy, sprawdź, czy wspierają bezpieczne iteracje (np. tryb planowania, snapshoty i rollback) oraz praktyczne opcje adopcji (jak eksport kodu). To jedna z dziedzin, gdzie Koder.ai została zaprojektowana, by pasować do oczekiwań inżynieryjnych: działać szybko, ale zachować kontrolę.

Faza 5: Ciągłe ulepszanie

Przeglądaj szablony i zasady co miesiąc. Wycofuj promptu, które nie działają i rozszerzaj standardy tylko wtedy, gdy widzisz powtarzające się tryby awarii.

Metryki do śledzenia (by ROI nie był zgadywaniem)

Śledź kilka wskaźników konsekwentnie:

- Czas cyklu (pomysł → wdrożone)

- Czas przeglądu (PR otwarty → zmergowany)

- Wskaźnik defektów (błędy, które uciekły + znalezione w QA)

- % przeróbek (tickety otwarte ponownie, churn, powtarzające się zmiany)

- Satysfakcja zespołu (krótka ankieta pulsowa)

Użyj tej checklisty przy następnym projekcie

Jeśli publikujesz wnioski z pilotażu, warto sformalizować je jako wewnętrzne wytyczne lub publiczne podsumowanie — wiele zespołów zauważa, że dokumentowanie metryk before/after zamienia adopcję AI z eksperymentu w powtarzalną praktykę. (Niektóre platformy, w tym Koder.ai, prowadzą programy, w których zespoły mogą zdobywać kredyty za dzielenie się praktycznymi materiałami lub referowanie innych użytkowników, co może zmniejszyć koszty narzędzia na początku.)