Dlaczego złożoność backendu spowalnia założycieli

„Złożoność backendu” to cała niewidzialna praca potrzebna, by produkt wydawał się prosty: bezpieczne przechowywanie danych, udostępnianie ich przez API, obsługa logowań, wysyłka maili, przetwarzanie płatności, zadania w tle, monitorowanie błędów i utrzymanie stabilności przy rosnącym ruchu.

Dla założycieli i wczesnych zespołów ta praca hamuje moment obrotu, bo wymaga dużych kosztów ustawienia zanim użytkownicy zobaczą wartość. Możesz spędzić dni na debacie o schemacie bazy, podpinaniu uwierzytelnienia lub konfiguracji środowisk — by na podstawie pierwszych klientów dowiedzieć się, że funkcja wymaga zmiany.

Praca backendowa jest także powiązana: mała decyzja produktowa (np. „użytkownicy mogą należeć do wielu zespołów”) może pociągnąć za sobą zmiany w bazie, reguły uprawnień, aktualizacje API i migracje.

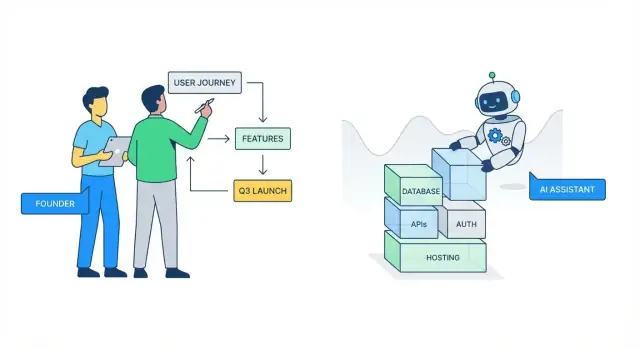

Jak wygląda „abstrakcja przez AI” w praktyce

W praktyce abstrakcja AI oznacza, że opisujesz, czego chcesz, a narzędzia generują lub orkiestrują nudne części:

- szkicowanie endpoints CRUD, walidacja wejścia i podstawowa obsługa błędów

- proponowanie modeli danych i relacji na podstawie funkcji

- generowanie flowów auth (sesje, tokeny) i szkieletów uprawnień

- tworzenie kodu integracyjnego dla popularnych usług (email, płatności, analityka)

Kluczowa korzyść to nie doskonałość — to szybkość dojścia do działającej bazy, którą możesz iterować.

Platformy takie jak Koder.ai idą krok dalej, łącząc workflow oparty na czacie z architekturą agentową: opisujesz rezultat (web, backend lub mobile), a system szkicuje aplikację end-to-end (np. React na web, Go + PostgreSQL na backendzie, Flutter na mobile), dzięki czemu możesz przejść od pomysłu do wdrożalnej bazy bez tygodnia spędzonego na rurkach.

Czego to nie znaczy

AI nie likwiduje potrzeby podejmowania decyzji produktowych i dotyczących ryzyka. Nie zna twoich dokładnych reguł biznesowych, jakie dane musisz przechowywać, jak ścisłe powinny być uprawnienia ani co w twojej domenie oznacza „wystarczająco bezpieczne”. Nie zapobiegnie też wszystkim problemom skalowania czy utrzymania, jeśli podstawowe wybory architektoniczne są kruche.

Ustal oczekiwania: AI pomaga iterować szybciej i unikać inżynierii od pustej strony, ale wciąż to ty odpowiadasz za logikę produktu, kompromisy i ostateczny próg jakości.

Rzeczywisty koszt pracy backendu dla wczesnych zespołów

Wczesne zespoły rzadko „wybierają” pracę backendu — pojawia się ona jako stos koniecznych czynności między pomysłem a czymś, co użytkownicy mogą dotknąć. Pożeraczem czasu nie jest tylko pisanie kodu; to też mentalne obciążenie podejmowania dziesiątek małych, istotnych decyzji zanim zweryfikujesz produkt.

Gdzie czas założyciela znika po cichu

Kilka zadań zjada nadmierną ilość godzin:

- Uwierzytelnianie i uprawnienia: flowy logowania, resetów haseł, role, przypadki brzegowe i „co się stanie jeśli…”.

- Modele danych: decyzje o tabelach/collectionach, relacjach, migracjach i jak zmieniać rzeczy później bez łamania wszystkiego.

- Wdrożenia: środowiska, sekrety, konfiguracja CI/CD i pierwszy incydent „dlaczego prod różni się od lokalnego?”.

- Integracje: webhooks, retry, idempotencja, walidacja sygnatur i mapowanie dziwactw zewnętrznych usług do twojego produktu.

Ukrytym kosztem jest ciągłe przełączanie kontekstu między myśleniem produktowym („co użytkownicy powinni robić?”) a myśleniem infrastrukturalnym („jak bezpiecznie to przechowywać i udostępniać?”). To przełączanie spowalnia postęp, zwiększa błędy i zamienia debugowanie w wielogodzinną odyseję — szczególnie gdy jednocześnie obsługujesz rozmowy sprzedażowe, wsparcie i fundraising.

Jak to spowalnia pętlę uczenia się

Każdy dzień spędzony na okablowaniu podstaw backendu to dzień niezainwestowany w rozmowy z użytkownikami i iterację. To wydłuża cykl buduj–mierz–ucz: wysyłasz później, uczysz się później i ryzykujesz budowanie złej rzeczy z większym wykończeniem.

Tydzień stracony na „tylko konfigurację”

Typowy scenariusz: poniedziałek–wtorek nad auth i tabelami użytkowników, środa nad wdrożeniami i zmiennymi środowiskowymi, czwartek nad integracją płatności lub maili, piątek za webhookiem i szybkim panelem admina. Kończysz tydzień z „rurkami”, nie z funkcją, za którą użytkownicy zapłacą.

Abstrakcja backendu wspomagana AI nie eliminuje odpowiedzialności — ale może odzyskać ten tydzień, żebyś wysyłał eksperymenty szybciej i zachował impet.

Co w praktyce oznacza „abstrakcja” AI

Abstrakcja AI to nie magia — to sposób przesunięcia pracy backendu na wyższy poziom. Zamiast myśleć w kategoriach frameworków, plików i kodu-kleju, opisujesz oczekiwany rezultat („użytkownicy mogą się rejestrować”, „przechowuj zamówienia”, „wyślij webhook po płatności”), a AI pomaga przetłumaczyć intencję na konkretne budulce.

AI jako copilot dla powtarzalnych zadań inżynieryjnych

Duża część pracy backendu jest przewidywalna: okablowanie tras, definiowanie DTO, ustawianie CRUD, walidacja wejścia, generowanie migracji i pisanie tych samych adapterów integracyjnych raz za razem. AI jest najsilniejsze, gdy praca podąża ustalonymi wzorcami i najlepszymi praktykami.

To praktyczna „abstrakcja”: redukcja czasu spędzanego na przypominaniu konwencji i przeszukiwaniu dokumentacji, przy jednoczesnym pozostawieniu ci kontroli nad tym, co jest budowane.

Jak prompt zamienia się w szkielety, konfiguracje i sugestie kodu

Dobry prompt działa jak mini-specyfikacja. Na przykład: „Stwórz serwis Orders z endpointami do tworzenia, listowania i anulowania zamówień. Użyj przejść statusów. Dodaj pola audytu. Zwracaj paginację.” AI może potem zaproponować:

- Szkielet modułu (controllers/services/models)

- Aktualizacje konfiguracji (zmienne środowiskowe, CORS, kolejki, limity rate)

- Migracje i modele danych zgodne z funkcjonalnością

- Przykładowe testy i fragmenty dokumentacji API

Wciąż przeglądasz, dostosowujesz nazwy i decydujesz o granicach — ale koszt pustej strony spada znacząco.

Gdzie AI pomaga najbardziej — i gdzie ma trudności

AI błyszczy przy standardowych komponentach: flowy auth, konwencje REST, zadania w tle, podstawowe cache'owanie i popularne integracje.

Ma trudności, gdy wymagania są nieostre („spraw, by to było skalowalne”), gdy reguły biznesowe są zniuansowane („logika refundu zależy od typu umowy i dat”), oraz w przypadkach brzegowych związanych ze współbieżnością, pieniędzmi i uprawnieniami. W takich sytuacjach najszybszą ścieżką jest najpierw doprecyzować reguły (nawet prostym językiem), a potem poprosić AI o implementację tego konkretnego kontraktu — i zweryfikować go testami.

Szkielety i boilerplate: najszybszy zysk

Założyciele tracą dni na pracę, która nie posuwa produktu do przodu: struktury folderów, kopiowanie wzorców i przenoszenie „hello world” do stanu wdrożalnego. Abstrakcja backendu wspomagana AI jest tu najbardziej wartościowa, bo wynik jest przewidywalny i powtarzalny — idealny do automatyzacji.

Generuj szkielet projektu zgodny z twoją intencją

Zamiast zaczynać od pustego repo możesz opisać, co budujesz („multi-tenant SaaS z REST API, Postgres, zadaniami w tle”) i wygenerować spójną strukturę: serwisy/moduły, routing, warstwa dostępu do bazy, logowanie i konwencje obsługi błędów.

To daje zespołowi wspólny punkt startu i eliminuje wczesne spory „gdzie powinien leżeć ten plik?”.

Endpoints CRUD bez maratonu kopiuj-wklej

Większość MVP potrzebuje tych samych podstaw: create/read/update/delete i prostą walidację. AI może szkieletować te endpoints konsekwentnie — parsowanie żądań, kody statusu i reguły walidacji — żebyś mógł poświęcić czas na logikę produktu (reguły cenowe, kroki onboardingu, uprawnienia), a nie powtarzalny klej.

Praktyczny profit: spójne wzorce ułatwiają przyszłe refaktory. Gdy każdy endpoint przestrzega tych samych konwencji, możesz zmienić zachowanie (np. paginacja czy format błędów) w jednym miejscu i przepchnąć zmiany.

Poprawna konfiguracja i zmienne środowiskowe

Błędne konfiguracje środowisk powodują ukryte opóźnienia: brakujące sekrety, złe URL-e DB, niespójne ustawienia dev/prod. AI może zaproponować sensowne podejście do konfiguracji — szablony env, pliki konfiguracyjne i jasne „co ustawić gdzie” — żeby członkowie zespołu mogli uruchomić projekt lokalnie z mniejszą liczbą przerw.

Redukcja boilerplate między serwisami i modułami

W miarę dodawania funkcji duplikacja rośnie: powtarzające się middleware, DTO, wzorce „service + controller”. AI może wyodrębnić wspólne elementy do helperów i szablonów, utrzymując kod mniejszym i łatwiejszym do nawigacji.

Najlepszy efekt to nie tylko dzisiejsza szybkość — to czytelność kodu, gdy MVP zamienia się w realny produkt.

Pomoc przy modelowaniu danych bez zostawania ekspertem baz danych

Modelowanie danych to miejsce, gdzie wielu założycieli ugrzęźnie: wiesz, co produkt ma robić, ale przełożenie tego na tabele, relacje i ograniczenia może wyglądać jak nauka drugiego języka.

Narzędzia AI mogą zapełnić tę lukę, tłumacząc wymagania produktowe na „pierwszy szkic” schematu, na który możesz szybko zareagować — dzięki czemu spędzasz czas na decyzjach produktowych, a nie na zapamiętywaniu zasad baz danych.

Z wymagań produktowych do encji i relacji

Jeśli opiszesz swoje podstawowe obiekty („użytkownicy mogą tworzyć projekty; projekty mają zadania; zadania mogą być przypisane użytkownikom”), AI może zaproponować uporządkowany model: encje, pola i relacje (one-to-many vs many-to-many).

Wygrana nie polega na tym, że AI jest magicznie poprawne — to, że zaczynasz z konkretną propozycją, którą możesz szybko zweryfikować:

- Czy „Task” należy do jednego „Project” czy może być współdzielony?

- Czy potrzebujesz „Organizations” teraz, czy „Projects” mogą należeć do pojedynczego użytkownika w MVP?

Migracje i seed data — wygenerowane, potem przeglądnięte

Gdy model zostanie zaakceptowany, AI może wygenerować migracje i przykładowe dane do rozwoju lokalnego. Często obejmuje to:

- tworzenie tabel i indeksów

- dodawanie kluczy obcych

- wstawienie kilku realistycznych rekordów przykładowych

Przegląd człowieka jest tu istotny. Sprawdzasz przypadkową utratę danych (np. domyślne destrukcyjne migracje), brakujące ograniczenia lub indeksy na niewłaściwych polach.

Spójne nazewnictwo w schema i kodzie

Dryf nazewnictwa jest cichym źródłem bugów („customer” w kodzie, „client” w bazie). AI może pomóc utrzymać nazwy spójne w modelach, migracjach, payloadach API i dokumentacji — zwłaszcza gdy funkcje ewoluują w trakcie budowy.

Uwaga: schemat nie wybierze twojej strategii produktowej

AI może zasugerować strukturę, ale nie może zdecydować, co optymalizować: elastyczność vs prostota, audytowalność vs szybkość, czy potrzebujesz multi-tenancy później. To decyzje produktowe.

Przydatna zasada: modeluj to, co musisz udowodnić dla MVP i zostaw miejsce na rozszerzenia — bez nadmiernego projektowania od pierwszego dnia.

Uwierzytelnianie i autoryzacja bez bólu głowy

Miej plan awaryjny

Przejmij kontrolę nad pracą dzięki eksportowi kodu, gdy potrzebujesz głębszej personalizacji.

Uwierzytelnianie (kim jest użytkownik) i autoryzacja (co może robić) to jedne z najprostszych miejsc, gdzie wczesne produkty tracą dni. Narzędzia AI pomagają generować „standardowe” części szybko — ale wartość to nie magia bezpieczeństwa, a zaczynanie od sprawdzonych wzorców zamiast wynajdywania koła na nowo.

Szybkie flowy logowania pasujące do powszechnych wzorców

Większość MVP potrzebuje jednego lub kilku z tych flowów:

- Email + hasło z resetem hasła, weryfikacją mailową i ograniczeniem rate limiting.

- OAuth sign-in (Google, Apple, GitHub) z bezpiecznym łączeniem kont.

- Onboarding na zaproszenia dla zespołów (accept invite → ustaw hasło lub OAuth).

AI może szkicować trasy, kontrolery, formularze UI i klej między nimi (wysyłka maili resetu, obsługa callbacków, trzymanie użytkowników). Zysk to szybkość i kompletność: mniej zapomnianych endpointów i mniej niedokończonych przypadków brzegowych.

RBAC: proste, ale łatwe do spieprzenia

RBAC często wystarcza na początek: admin, member, może viewer. Błędy pojawiają się, gdy:

- Role są sprawdzane tylko w niektórych endpointach.

- Logika „właściciela” miesza się z rolami (własność to zwykle oddzielna reguła).

- Ukrywanie elementów w frontendzie traktowane jest jako zabezpieczenie (autoryzacja musi być wymuszana po stronie serwera).

Dobry baseline generowany przez AI zawiera jedną warstwę autoryzacji (middleware/polityki), by nie rozrzucać checków wszędzie.

Sesje vs tokeny (na wysokim poziomie)

- Sesje (cookie-based) są zwykle najprostsze dla aplikacji web: serwer może unieważniać, rotować i chronić je przy pomocy

HttpOnly cookies.

- Tokeny (JWT) bywają wygodne dla mobilnych/API klientów, ale strategia unieważniania i wygasania wymaga przemyślenia.

Jeśli nie jesteś pewien, domyśl się sesji dla browser-first MVP i dodaj wsparcie tokenów, gdy klient naprawdę tego potrzebuje.

Lista kontrolna: bezpieczny przegląd kodu auth wygenerowanego przez AI

- Hasła haszowane nowoczesnym algorytmem (np. bcrypt/argon2), nigdy nie logowane.

- Sprawdzenia autoryzacji po stronie serwera dla każdej chronionej trasy.

- Ustawienia ciasteczek poprawne (

HttpOnly, Secure, sensowne SameSite).

- Callbacki OAuth walidują

state i dozwolone URL-e przekierowań.

- Rate limiting dla endpointów logowania/resetu.

- Brak hardcodowanych sekretów; konfiguracja z env.

- Jasna ścieżka do unieważniania sesji/tokenów i rotacji poświadczeń.

Integracje i webhooki: mniej kodu-kleju, więcej impetu

Integracje to miejsce, gdzie timeliney prostych MVP często się załamują: Stripe, Postmark, Segment, HubSpot. Każda z nich to „tylko API”, aż zaczynasz żonglować schematami auth, retryami, limitami, formatami błędów i półdokumentowanymi przypadkami.

Abstrakcja backendu wspomagana AI pomaga zmienić te jednorazowe prace w powtarzalne wzorce — żebyś tracił mniej czasu na okablowanie, a więcej na decyzję, co produkt ma robić.

Podłączanie popularnych usług bez tygodnia konfiguracji

Największe zyski pochodzą zwykle z typowych integracji:

- Płatności: tworzenie klientów, uruchamianie subskrypcji, obsługa nieudanych płatności

- Email: szablony transakcyjne, zdarzenia deliverability, listy suppressji

- Analityka: spójne nazewnictwo eventów, wiązanie tożsamości użytkownika

- CRM: synchronizacja kont i kontaktów bez duplikowania wszystkiego

Zamiast ręcznego składania SDK, AI może szkicować „nudne, ale konieczne” elementy: zmienne środowiskowe, współdzielone klienty HTTP, typowane modele request/response i rozsądne domyślne timeouty oraz retry.

Webhooki: wygenerowane handlery, mniej utraconych zdarzeń

Webhooks to druga połowa większości integracji — invoice.paid, zdarzenia dostarczenia maili, aktualizacje CRM. Narzędzia abstrakcyjne mogą wygenerować endpointy webhooków i weryfikację sygnatur oraz stworzyć wewnętrzne zdarzenie, którym łatwiej zarządzać (np. PaymentSucceeded).

Kluczowy szczegół: przetwarzanie webhooków powinno być idempotentne. Jeśli Stripe zretryuje to samo zdarzenie, system nie powinien dwukrotnie przydzielać planu. Szkielety AI mogą nakierować cię na przechowywanie ID zdarzenia i bezpieczne ignorowanie duplikatów.

Mapowanie danych między systemami (i gdzie zespoły popełniają błędy)

Większość bugów integracyjnych to różnice w kształcie danych: niezgodne ID, strefy czasowe, pieniądze jako floaty, lub „opcjonalne” pola, których brakuje w produkcji.

Traktuj zewnętrzne ID jako pola pierwszej klasy, zapisuj surowe payloady webhooków do audytu/debugowania i unikaj synchronizowania więcej pól niż faktycznie używasz.

Testuj na stagingu przed produkcją

Używaj kont sandboxowych, oddzielnych kluczy API i stagingowego endpointu webhook. Odtwarzaj nagrane payloady webhooków, by potwierdzić, że handler działa, i zweryfikuj cały workflow (płatność → webhook → baza → mail) zanim przełączysz na live.

Projekt API, który pozostaje spójny z produktem

Wdróż bez detouru DevOps

Przejdź od punktu wyjścia do hostowanej aplikacji bez żonglowania plumbingsami wdrożeniowymi.

Kiedy założyciele mówią „backend nas spowalnia”, często chodzi o API: frontend potrzebuje jednego kształtu danych, backend zwraca inny i wszyscy tracą godziny na dogadywanie się.

AI może zmniejszyć tarcie, traktując API jako umowę — coś, co generujesz, walidujesz i rozwijasz świadomie wraz ze zmianami wymagań produktowych.

Zacznij od kontraktów, nie zgadywania

Praktyczny workflow to poprosić AI o szkic kontraktu API dla funkcji (endpoints, parametry i przypadki błędów) wraz z konkretnymi przykładami request/response. Te przykłady stają się wspólnym odniesieniem w ticketach i PR-ach i utrudniają „interpretacji”.

OpenAPI w obie strony

Jeśli masz już endpointy, AI pomoże wyprowadzić spec OpenAPI z rzeczywistych tras i payloadów, tak by dokumentacja odpowiadała rzeczywistości. Jeśli wolisz projektować najpierw, AI może szkicować trasy, kontrolery i walidatory z pliku OpenAPI. W obu przypadkach masz jedno źródło prawdy, które napędza docs, mocki i generację klientów.

Utrzymuj zgodność frontendu i backendu typowanymi kontraktami

Typowane kontrakty (TypeScript types, modele Kotlin/Swift itd.) zapobiegają cichym dryfom. AI może:

- generować typy klienta z OpenAPI

- sugerować wspólne DTO lub definicje schematów

- wskazywać miejsca, gdzie frontend oczekuje pól, których backend nie zwraca (i odwrotnie)

To tu „szybsze wysyłanie” staje się realne: mniej niespodzianek integracyjnych, mniej ręcznego okablowania.

Unikaj breaking changes podczas ewolucji

W miarę iteracji produktu AI może przeglądać diffy i ostrzegać przed zmianami łamiącymi compatybilność (usunięte pola, zmienione znaczenia, przesunięcia statusów). Może też proponować bezpieczniejsze wzorce: zmiany addytywne, jawne wersjonowanie, okna deprecjacji i warstwy kompatybilności.

Efekt: API ewoluuje wraz z produktem zamiast z nim walczyć.

Testy i debugowanie: szybciej pewność, mniej alarmów

Gdy poruszasz się szybko, najbardziej przerażający moment to wypuszczenie zmiany i odkrycie, że coś innego przestało działać. Testowanie i debugowanie kupuje pewność — ale pisanie testów od zera bywa podatkiem, na który „nie stać” na początku.

AI może zmniejszyć ten podatek, zamieniając to, co już wiesz o produkcie, w powtarzalną siatkę bezpieczeństwa.

Szkicuj testy dla kluczowych flowów

Zamiast dążyć do perfekcyjnego pokrycia, zacznij od kilku podstawowych ścieżek użytkownika, które muszą zawsze działać: rejestracja, checkout, tworzenie rekordu, zapraszanie współpracownika.

AI przyda się do generowania testów:

- happy path (normalny sukces)

- mały zbiór edge case'ów (nieprawidłowe wejście, brak uprawnień, duplikaty)

Wciąż definiujesz, co znaczy „poprawne zachowanie”, ale nie musisz pisać wszystkich asercji ręcznie.

Szybkie generowanie mocków i fixture'ów

Wiele suite'ów testowych zatrzymuje się, bo tworzenie realistycznych danych testowych jest uciążliwe. AI może wygenerować fixture'y dopasowane do twojego modelu (użytkownicy, plany, faktury) i warianty — wygasłe subskrypcje, zablokowane konta, zarchiwizowane projekty — by testować zachowanie bez ręcznego tworzenia dziesiątek rekordów.

Używaj AI jako partnera debugowego

Gdy test pada, AI może podsumować hałaśliwe logi, przetłumaczyć stack trace na prosty język i zasugerować prawdopodobne poprawki („endpoint zwraca 403, bo użytkownik testowy nie ma roli”). Szczególnie pomaga wykrywać rozbieżności między założeniami testu a rzeczywistym API.

Strażnicy jakości, którzy utrzymują dyscyplinę

AI przyspiesza tworzenie, ale nie powinien być jedynym mechanizmem bezpieczeństwa. Zachowaj lekkie strażniki:

- przegląd kodu (nawet 10-minutowa kontrola kolegi)

- CI uruchamiające testy na każdym PR

- minimalny cel pokrycia dla krytycznych modułów, nie dla całego kodu

Praktyczny krok: ustaw folder „core flows” z testami i nie pozwól merge'ować zmian, gdy te testy zawodzą. To eliminuje większość nocnych alarmów.

Automatyzacja DevOps bez potrzeby pełnoetatowego opsa

DevOps to miejsce, gdzie „po prostu wypuść” często zamienia się w nocne czuwania: zawodny deploy, niespójne środowiska i tajemnicze błędy tylko w produkcji.

Narzędzia AI nie zastąpią dobrego osądu inżynieryjnego, ale mogą ugryźć dużą część powtarzalnej konfiguracji, która spowalnia założycieli.

Pułapka wczesnego etapu to niespójna jakość kodu, bo nikt nie miał czasu skonfigurować podstaw. Asystenci AI mogą wygenerować punkt startowy dla CI (GitHub Actions/GitLab CI), dodać zasady lintingu i formatowania oraz upewnić się, że uruchamiają się przy każdym PR.

To oznacza mniej debat o stylu, szybsze przeglądy i mniej drobnych problemów trafiających do main.

Pipeline wdrożeniowy z jasnym podziałem środowisk

Założyciele często deployują od razu na produkcję, aż boli. AI może pomóc szkicując prosty pipeline dev → staging → prod, w tym:

- osobne zmienne środowiskowe i sekrety dla każdego środowiska

- powtarzalny krok build (by staging był zgodny z prod)

- krok ręcznej akceptacji przed produkcją

Celem nie jest złożoność — to redukcja „działa u mnie” i uczynienie wydań rutyną.

Podstawowa obserwowalność: logi, metryki i alerty

Nie potrzebujesz enterprise setupu, by być bezpiecznym. AI może zaproponować minimalny baseline obserwowalności:

- strukturalne logi (by wyszukać po request/ user)

- kilka kluczowych metryk (rate błędów, latencja, głębokość kolejek)

- alerty przy przekroczeniu progów „coś jest nie tak”

To dostarcza szybsze odpowiedzi, gdy klienci zgłaszają problemy.

Co warto zostawić manualnie na początku, by zmniejszyć ryzyko

Automatyzuj powtarzalne elementy, ale zachowaj kontrolę nad decyzjami o wysokim wpływie: dostęp do produkcji, rotacja sekretów, migracje bazy i progi alertów.

AI może sporządzić playbook, ale to ty powinieneś decydować „kto może co” i „kiedy wypychamy”.

Bezpieczeństwo i zgodność: czego AI nie może za ciebie zdecydować

Utrzymaj momentum z rollbackiem

Wprowadzaj zmiany pewnie dzięki snapshotom i rollbackowi, gdy iteracja pójdzie nie tak.

AI może wygenerować kod wyglądający na bezpieczny i nawet wstawić podstawowe zabezpieczenia, ale bezpieczeństwo i compliance to w końcu decyzje produktowe. Zależą od tego, co budujesz, kto tego używa i jakie ryzyka akceptujesz.

Traktuj AI jako akcelerator — nie jako właściciela bezpieczeństwa.

Podstawy bezpieczeństwa, za które odpowiadasz

Zarządzanie sekretami to odpowiedzialność założyciela. Klucze API, kredencjały do bazy, klucze do podpisywania JWT i sekrety webhooków nie powinny nigdy trafić do kodu ani czatów. Używaj zmiennych środowiskowych i zarządzanych magazynów sekretów, i rotuj klucze, gdy ktoś odchodzi lub wystąpi wyciek.

Zasada najmniejszego uprawnienia to drugi niepodważalny punkt. AI może szkicować role i polityki, ale to ty decydujesz, kto co powinien mieć. Prosta zasada: jeśli serwis lub użytkownik nie potrzebuje uprawnienia, nie dawaj mu go. Dotyczy to:

- kont bazy danych (read vs write)

- usług chmurowych (storage, email, kolejki)

- dashboardów admina (unikaj „wszyscy admini” w produkcji)

Przechowywanie PII i decyzje dotyczące dostępu

Jeśli przechowujesz dane osobowe (emaile, telefony, adresy, identyfikatory płatnicze, dane zdrowotne), compliance nie jest odhaczaniem — kształtuje architekturę.

Na wysokim poziomie zdefiniuj:

- co w twojej aplikacji liczy się jako PII i gdzie to jest przechowywane

- kto może to oglądać/eksportować (wsparcie, admini, użytkownicy końcowi)

- jak to jest logowane (unikaj wypisywania PII w logach i trackerach błędów)

- zasady retencji (kiedy usuwasz dane i jak)

AI może pomóc wdrożyć kontrole dostępu do danych, ale nie powie ci, co jest „odpowiednie” dla twoich użytkowników lub wymagań prawnych na twoim rynku.

Skanowanie zależności i podatności

Nowoczesne backendy polegają na paczkach, kontenerach i zewnętrznych usługach. Włącz skanowanie podatności do rutyny:

- włącz alerty zależności w repo

- skanuj obrazy kontenerów w CI

- łatkuj regularnie, zwłaszcza biblioteki auth i crypto

Jasne ostrzeżenie

Nie wypuszczaj kodu backendu wygenerowanego przez AI bez przeglądu. Niech człowiek zweryfikuje flowy uwierzytelniania, sprawdzenia autoryzacji, walidację wejścia i każdy kod mający kontakt z pieniędzmi lub PII przed produkcją.

Kompromisy, strażnice i kiedy iść głębiej

Abstrakcja backendu z AI może wydawać się magiczna — aż trafisz na krawędź. Cel nie polega na unikaniu „prawdziwej inżynierii” na zawsze; chodzi o odroczenie kosztownych prac, dopóki nie uzasadnia ich traction.

Prawdziwe ryzyka, na które warto uważać

Vendor lock-in jest oczywisty: jeśli model danych, auth i workflowy są związane z konwencjami jednej platformy, zmiana później może być kosztowna.

Niejasna architektura to ciche ryzyko: gdy AI generuje serwisy, polityki i integracje, zespoły czasem nie potrafią wyjaśnić, jak przepływa żądanie, gdzie dane są przechowywane i co się dzieje przy błędzie.

Ukryta złożoność ujawnia się przy skali, audytach lub przypadkach brzegowych — limity rate, retry, idempotencja, uprawnienia i migracje nie znikają; po prostu czekają.

Strażnice, które utrzymają cię bezpiecznym (i szybkim)

Miej od początku „escape hatch”:

- Przenośne dane: upewnij się, że możesz eksportować surowe tabele/collectiony i pliki na żądanie.

- Udokumentowane API: traktuj API jak kontrakt produktu — zapisz endpointy, reguły auth i kluczowe przypadki błędów.

- Własny model domeny: nawet jeśli AI szkicuje go, ty decydujesz o nazewnictwie, relacjach i co jest źródłem prawdy.

Jeśli korzystasz z platformy AI-native, priorytetowe niech będą funkcje ułatwiające te strażnice w praktyce — eksport kodu, hosting/ wdrożenia, które możesz kontrolować, oraz snapshoty/rollback przy automatycznych zmianach. (Koder.ai, na przykład, wspiera eksport kodu i snapshoty, by pomagać zespołom szybko działać, zachowując możliwość ucieczki.)

Prosta praktyka: raz w tygodniu napisz krótki „mapę backendu” (jakie serwisy istnieją, czego dotykają i jak uruchomić lokalnie).

Kiedy zatrudnić inżyniera lub konsultanta

Zrób to, gdy którekolwiek z poniższych stanie się prawdą: obsługujesz płatności lub wrażliwe dane, uptime wpływa na przychody, potrzebujesz złożonych uprawnień, migracje są częste lub problemy wydajnościowe się powtarzają.

Praktyczne następne kroki

Zacznij mało: zdefiniuj główne encje, wypisz wymagane integracje i zdecyduj, co musi być audytowalne. Potem porównaj opcje i poziomy wsparcia na /pricing, i zagłęb się w taktyczne przewodniki oraz przykłady w /blog.