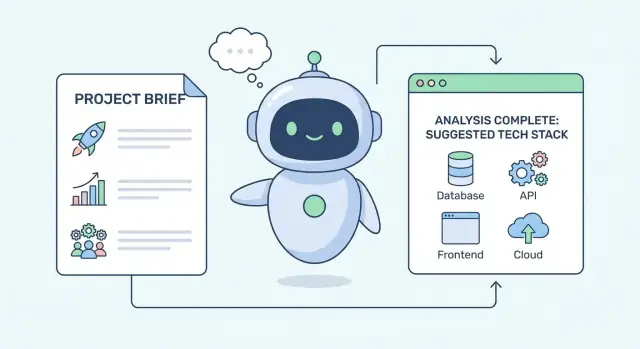

Co oznacza, że AI „wyciąga” stos technologiczny

„Stos technologiczny” to po prostu zestaw elementów, które wybierasz do stworzenia i uruchomienia produktu. W praktyce obejmuje zazwyczaj:

- Frontend: to, co widzi i z czym wchodzi w interakcję użytkownik (UI webowe lub mobilne)

- Backend: logika po stronie serwera i API

- Baza danych: miejsce przechowywania i zapytań o dane

- Hosting/wdrożenie: gdzie działa aplikacja (chmura, on‑prem, platformy zarządzane)

- Narzędzia: monitoring, CI/CD, uwierzytelnianie, analityka, testy i więcej

„Wnioskowanie” to nie czytanie w myślach

Kiedy AI „wyciąga” stos, nie zgaduje twojego ulubionego frameworka. To bardziej uporządkowane rozumowanie: bierze to, co mu powiesz o swojej sytuacji, mapuje to na typowe wzorce inżynieryjne i proponuje opcje stosu, które zwykle działają w podobnych warunkach.

Pomyśl o nim jak o asystencie decyzyjnym, który tłumaczy ograniczenia na implikacje techniczne. Na przykład „musimy wystartować za 6 tygodni” zwykle oznacza wybór dojrzałych frameworków, usług zarządzanych i mniej komponentów customowych.

Główne ograniczenia, na które patrzy AI

Większość rekomendacji zaczyna się od kilku praktycznych ograniczeń:

- Skala i wydajność: oczekiwani użytkownicy, skoki ruchu, cele latencji, wolumen danych

- Szybkość wejścia na rynek: terminy, MVP kontra długoterminowa platforma, częstotliwość iteracji

- Umiejętności zespołu i rekrutacja: co deweloperzy już znają i co łatwo zatrudnić

- Budżet: budować czy kupić, wydatki chmurowe, licencje, koszty operacyjne

- Zgodność i bezpieczeństwo: rezydencja danych, wymagania audytowe, szyfrowanie, kontrola dostępu

Ustalanie oczekiwań

Rekomendacje AI najlepiej traktować jako listy skrócone z opisem kompromisów, a nie ostateczne odpowiedzi. Dobre wyniki wyjaśniają dlaczego dany stos pasuje (i gdzie zawodzi), proponują alternatywy i wskazują ryzyka do weryfikacji z zespołem — bo to ludzie wciąż podejmują decyzje i ponoszą za nie odpowiedzialność.

Dane wejściowe, które AI wykorzystuje do sugestii stosu

AI nie „zgaduje” stosu z jednego promptu. Działa jak rozmówca: zbiera sygnały, waży je i proponuje kilka realistycznych opcji — każdą optymalizowaną pod inne priorytety.

Wymagania produktu i doświadczenia użytkownika

Najważniejsze są to, co produkt ma robić i jak użytkownik ma się czesać z niego korzystając. Typowe sygnały:

- Cele produktu (walidacja MVP kontra platforma długoterminowa)

- Kluczowe funkcje (współpraca w czasie rzeczywistym, wyszukiwanie, płatności, przetwarzanie plików)

- Oczekiwana liczba użytkowników i krzywa wzrostu

- Potrzeby dotyczące latencji i responsywności (np. „musi wydawać się natychmiastowe”)

- Wrażliwość danych i oczekiwania zgodności (PII, HIPAA, SOC 2)

Te szczegóły kierują wyborami jak „renderowanie po stronie serwera vs. SPA”, „relacyjna vs. dokumentowa baza” czy „przetwarzanie kolejkowe vs. API synchroniczne”.

Kontekst i ograniczenia wokół budowy

Rekomendacje poprawiają się, gdy podasz sytuację projektu, nie tylko listę funkcji:

- Systemy istniejące do integracji (ERP/CRM, provider tożsamości, hurtownia danych)

- Preferowani dostawcy lub zobowiązania chmurowe (AWS/GCP/Azure, konkretne usługi zarządzane)

- Środowisko wdrożeniowe (Kubernetes, serverless, on‑prem)

- Harmonogram i sekwencja wydań (jednorazowy launch vs. etapowy rollout)

Twarde ograniczenie (np. „musi działać on‑prem”) może wykluczyć silnych kandydatów.

Sygnały zespołu wpływające na utrzymywalność

Decyzje o stosie udają się lub zawodzą w zależności od tego, kto będzie je budował i obsługiwał. Przydatne informacje to: aktualne języki, podobne projekty w przeszłości, dojrzałość operacyjna (monitoring/on‑call) i realia rekrutacyjne na twoim rynku.

Jak powinien wyglądać wynik

Dobra odpowiedź AI to nie jeden „idealny stos”. To 2–4 kandydatów, każdy z:

- Wyjaśnieniem, dlaczego pasuje do ograniczeń

- Kluczowymi kompromisami i ryzykami

- Czym zweryfikować kolejno (benchmarki, przegląd bezpieczeństwa, spike)

Jeśli chcesz wzoru do dzielenia się tymi danymi, zobacz wymagania dotyczące wyboru stosu technologicznego.

Z ograniczeń do wymagań: krok tłumaczenia

Zanim AI zaproponuje stos, musi przetłumaczyć to, co mówisz, na to, czego faktycznie potrzebujesz do budowy. Większość briefów zaczyna się od mglistych celów — „szybko”, „skalowalnie”, „tanie”, „bezpieczne”, „łatwe w utrzymaniu”. To użyteczne sygnały, ale nie są jeszcze wymaganiami.

Zamieniaj niejasne cele w mierzalne cele

AI zwykle konwertuje przymiotniki na liczby, progi i założenia operacyjne. Na przykład:

- „Szybka aplikacja” → p95 czasu odpowiedzi (np. <300ms dla kluczowych działań), budżet czasu ładowania strony i akceptowalna latencja w szczycie

- „Musimy wysłać szybko” → rytm wydań (tygodniowo vs miesięcznie), czas do pierwszej wersji i tolerancja długu technicznego

- „Skalowalna” → oczekiwana liczba użytkowników, maks. żądań na sekundę, tempo wzrostu i wolumen danych przez 6–18 miesięcy

Gdy cele są policzalne, rozmowa o stosie przestaje być opinią, a staje się zbiorem kompromisów.

Oddziel twarde ograniczenia od preferencji

Ważna część tłumaczenia polega na klasyfikacji wejść:

- Twarde ograniczenia (must‑have): potrzeby zgodności, rezydencja danych, istniejące umowy z dostawcami, wymagane integracje, cele dostępności

- Preferencje (nice‑to‑have): „użyj mikrousług”, „użyj modnego frameworka”, „unikać vendor lock‑in” (chyba że jest to wymóg umowny)

Rekomendacje są tak dobre, jak to sortowanie. „Must” zawęża opcje; „pref” wpływa na ranking.

Zapytaj, co brakuje (i dlaczego to ważne)

Dobre AI wskaże brakujące szczegóły i zada krótkie, wysokowpływowe pytania, np.:

- Jakie są wasze najbardziej obciążone workflowy i okna szczytowe?

- Jaki jest budżet na operacje (ludzie + narzędzia), nie tylko chmura?

- Jakie umiejętności są już w zespole i kogo realistycznie możecie zatrudnić?

- Które dane są wrażliwe i jakie audyty mają zastosowanie?

Zbuduj jednostronicowy profil ograniczeń

Efektem tego kroku jest zwięzły „profil ograniczeń”: mierzalne cele, must‑have i otwarte pytania. Ten profil kieruje późniejszymi decyzjami — od wyboru bazy po wdrożenie — bez wiązania się z jednym narzędziem zbyt wcześnie.

Jak wymagania dotyczące skali i szybkości kształtują stos

Gdy AI rekomenduje stos, „skala” i „szybkość” są często pierwszymi filtrami. Te wymagania szybko wykluczają opcje, które mogą działać prototypowo, ale zawiodą przy realnym ruchu.

Co „skala” oznacza w kontekście stosu

AI zwykle rozbija skalę na konkretne wymiary:

- Użytkownicy i wolumen żądań: średnie vs. szczytowe żądania/sek, plus oczekiwania wzrostu

- Rozmiar danych: jak szybko dane się kumulują (logi, eventy, pliki) i jak długo muszą być przechowywane

- Stosunek odczytów do zapisów: produkty nastawione na przeglądanie wymagają innych optymalizacji niż intensywne zapisy

- Wzorce szczytów: „stały ruch cały dzień” jest łatwiejszy niż „10× skoki w piątki” lub kampanie marketingowe

Te sygnały zawężają decyzję o tym, ile można polegać na pojedynczej bazie danych, czy cache jest potrzebny od początku i czy autoskalowanie jest wymaganiem.

Wymagania szybkości: latencja, przepustowość i realtime

Wydajność to nie jedna liczba. AI rozdziela ją na:

- Latencja (jak szybko czuje się pojedyncze żądanie) — wpływa na CDN, cache i projekt API

- Przepustowość (ile żądań/zadań na minutę) — wpływa na load‑balancing i skalowanie horyzontalne

- Zadania w tle (email, przetwarzanie wideo, importy) — kierują stos w stronę kolejek + workerów

- Realtime (chat, obecność, live dashboardy) — często dodaje WebSockets i komponent pub/sub

Jeśli niska latencja jest krytyczna, AI skłoni się ku prostszym ścieżkom requestów, agresywnemu cache’owaniu i dostawie na edge. Jeśli przeważa przepustowość i praca w tle, priorytetem będą kolejki i skalowanie workerów.

Cele niezawodności zaostrzają wybory

Oczekiwania dotyczące dostępności i odzyskiwania są równie ważne jak szybkość. Wyższe cele niezawodności zwykle przesuwają rekomendacje w stronę:

- Usług zarządzanych (bazy, kolejki) aby zmniejszyć ryzyko operacyjne

- Redundancji między strefami/regionami

- Jasnych procedur backup/restore i workflowów incident response

Wyższa skala + rygorystyczna szybkość + silniejsze wymogi niezawodności przyspieszają wprowadzenie cache’owania, przetwarzania asynchronicznego i infrastruktury zarządzanej wcześniej w cyklu życia produktu.

Jak umiejętności zespołu i czas do rynku kierują rekomendacjami

Zwaliduj opcje stosu prototypami

Przetestuj dwie ścieżki stosu, generując prototypy i porównując kompromisy.

Rzadko rekomendacje optymalizują tylko „najlepszą technologię”. Najsilniejszym sygnałem jest zazwyczaj: co zespół potrafi zbudować, wypuścić i utrzymać bez zatrzymania projektu.

Znajomość bije teoretyczne „najlepsze”

Jeśli deweloperzy dobrze znają framework, AI zwykle go faworyzuje — nawet jeśli alternatywa nieco lepiej wypada w benchmarkach. Znane narzędzia skracają debaty projektowe, przyspieszają code review i zmniejszają ryzyko błędów.

Przykład: zespół z dużym doświadczeniem w React dostanie rekomendacje oparte na React (Next.js, Remix) zamiast „gorętszego” frontendu. To samo dotyczy backendu: zespół Node/TypeScript może być skierowany ku NestJS lub Express zamiast zmiany języka, która dodałaby miesiące nauki.

Czas do rynku popycha ku sprawdzonym domyślnym rozwiązaniom

Gdy priorytetem jest szybki launch, AI częściej poleca:

- Dojrzałe frameworki z silnymi konwencjami (mniej decyzji architektonicznych)

- Szablony/startery pokrywające auth, routing i wdrożenie

- Usługi zarządzane, które eliminują kroki konfiguracji i utrzymania

Dlatego „nudne” wybory pojawiają się często: mają przewidywalną ścieżkę do produkcji, dobrą dokumentację i wiele rozwiązanych problemów.

To też miejsce, gdzie narzędzia przyspieszające (tzw. vibe‑coding) mogą być naprawdę użyteczne: np. Koder.ai pozwala zespołom przejść od wymagań do działającego szkieletonu web/server/mobile przez interfejs czatu, jednocześnie utrzymując konwencjonalny stos pod spodem (React dla web, Go + PostgreSQL dla backendu/danych, Flutter dla mobile). Użyte rozsądnie, przyspieszają prototypy i pierwsze wydania, nie zastępując jednak potrzeby weryfikacji stosu względem ograniczeń.

Obciążenie operacyjne: self‑hosted vs. zarządzane

AI także wnioskuje o zdolnościach operacyjnych. Jeśli nie masz dedykowanego DevOps lub ograniczonej gotowości on‑call, rekomendacje przesuną się ku platformom zarządzanym (managed Postgres, hosted Redis, kolejki zarządzane) i prostszym wdrożeniom.

Szczupły zespół rzadko może pozwolić sobie na pilnowanie klastrów, ręczną rotację sekretów i budowanie monitoringu od zera. Gdy ograniczenia to sugerują, AI będzie promować usługi z wbudowanymi backupami, dashboardami i alertami.

Rekrutacja i onboarding mają znaczenie

Wybory stosu wpływają na przyszły zespół. AI zazwyczaj waży popularność języka, krzywą uczenia się i wsparcie społeczności, bo wpływają one na rekrutację i tempo wdrożenia nowych osób. Szeroko stosowany stack (TypeScript, Python, Java, React) często wygrywa, gdy spodziewasz się wzrostu, pomocy kontraktorów lub częstego onboardingu.

Jeśli chcesz pójść głębiej, jak rekomendacje przekładają się na wybory warstwa‑po‑warstwie, zobacz mapowanie ograniczeń na warstwy stosu.

Logika decyzji: ważenie kompromisów i priorytetów

Rekomendacje nie są „dobrymi praktykami” skopiowanymi ze szablonu. Zwykle wynik to scoring opcji względem zadeklarowanych ograniczeń, a następnie wybór kombinacji, która najlepiej spełnia to, co dziś jest najważniejsze — nawet jeśli nie jest idealna.

Zamiana kompromisów na uporządkowane wybory

Większość decyzji w stosie to kompromisy:

- Elastyczność vs. prostota: konfigurowalność i możliwość obsługi nietypowych workflowów kontra większy koszt utrzymania i onboarding

- Koszt vs. kontrola: usługi zarządzane zmniejszają pracę operacyjną, ale ograniczają tuning i mogą zwiększyć zależność od dostawcy

- Szybkość vs. bezpieczeństwo: szybkie wdrożenie może oznaczać mniej elementów i mniejszą optymalizację; „bezpieczeństwo” faworyzuje większe testowanie i sprawdzone komponenty

AI zwykle przedstawia to jako punkty zamiast debat. Jeśli mówisz „wypuszczamy za 6 tygodni z małym zespołem”, prostota i szybkość dostają wyższe wagi niż długoterminowa elastyczność.

Ważone ograniczenia: co dziś ma największe znaczenie

Praktyczny model to lista kontrolna z wagami: czas do rynku, umiejętności zespołu, budżet, zgodność, oczekiwany ruch, potrzeby latencji, wrażliwość danych i realia rekrutacyjne. Każdy komponent stosu (framework, baza, hosting) dostaje punkty za dopasowanie.

Dlatego ten sam pomysł produktowy może dawać inne odpowiedzi — wagi się zmieniają wraz z priorytetami.

Wielotorowość: ścieżka MVP vs. ścieżka skalowania

Dobre rekomendacje często proponują dwie ścieżki:

- MVP: minimalizuj złożoność i obciążenie operacyjne; wybierz mainstreamowe narzędzia, które zespół może od razu wypuścić

- Scale‑up: zaplanuj drogę migracji (np. dodanie cache’a, podział serwisów, wprowadzenie kolejek) gdy użycie to uzasadni

„Wystarczająco dobre” z explicite założeniami

AI może uzasadnić decyzje „wystarczająco dobre” przez wyraźne podanie założeń: oczekiwana liczba użytkowników, akceptowalny downtime, które funkcje są nieprzenośne i co można odłożyć. Klucz to przejrzystość — jeśli założenie jest błędne, od razu wiesz, które części stosu trzeba przemyśleć.

Mapowanie ograniczeń na warstwy stosu (od frontendu po dane)

Przydatne spojrzenie na rekomendacje to postrzeganie ich jako mapowanie „warstwa po warstwie”. Zamiast losowo wymieniać narzędzia, model zwykle najpierw tłumaczy każde ograniczenie (szybkość, umiejętności, zgodność, harmonogram) na wymagania dla frontendu, backendu i warstwy danych — i dopiero potem proponuje konkretne technologie.

Frontend: web vs. mobile (i co UI musi robić)

AI zaczyna od wyjaśnienia gdzie użytkownicy wchodzą w interakcję: przeglądarka, iOS/Android czy oba.

Jeśli SEO i szybkie ładowanie stron mają znaczenie (strony marketingowe, marketplace’y, produkty contentowe), wybory webowe skłaniają się ku frameworkom wspierającym renderowanie po stronie serwera i dobre budżety wydajności.

Jeśli tryb offline jest kluczowy (prace w terenie, podróże, sieci niestabilne), rekomendacja przesuwa się w stronę aplikacji mobilnej (lub dobrze zaprojektowanego PWA) z lokalnym magazynowaniem i synchronizacją.

Jeśli UI wymaga realtime (współpraca, trading dashboardy, obsługa live), ograniczeniem staje się „efektywne pushowanie aktualizacji”, co wpływa na zarządzanie stanem, WebSockets i obsługę eventów.

Backend: monolit vs. mikrousługi, API i praca w tle

Dla produktów we wczesnej fazie AI często preferuje modularny monolit: jedna jednostka do wdrożenia, jasne granice wewnętrzne i prosty API (REST lub GraphQL). Ograniczeniem jest czas do rynku i mniejsza liczba elementów ruchomych.

Mikrousługi pojawiają się, gdy ograniczenia wymagają niezależnego skalowania, ścisłej izolacji lub wielu zespołów pracujących równolegle.

Przetwarzanie w tle to kolejny ważny krok mapowania. Jeśli masz maile, przetwarzanie wideo, generowanie raportów, ponawianie płatności czy integracje, AI zwykle dodaje wzorzec kolejka + worker, aby API użytkownika pozostało responsywne.

Warstwa danych: wybierz najprostszą bazę, która wystarczy, a potem dodaj „specjalistów”

Bazy relacyjne są zwykle sugerowane, gdy potrzebujesz transakcji, raportów i spójnych reguł biznesowych.

Bazy dokumentowe lub key‑value pojawiają się, gdy ograniczeniem jest elastyczny schemat, bardzo wysoki zapis lub szybkie odczyty.

Wyszukiwanie (filtrowanie, ranking, tolerancja literówek) często traktowane jest jako osobne wymaganie; AI doda silnik wyszukiwania tylko wtedy, gdy zapytania do bazy przestaną spełniać oczekiwania UX.

Integracje: nie wymyślaj koła na nowo

Gdy ograniczenia obejmują płatności, uwierzytelnianie, analitykę, messaging czy powiadomienia, rekomendacje zwykle faworyzują sprawdzone usługi i biblioteki zamiast budowania wszystkiego od zera — bo niezawodność, zgodność i koszty utrzymania są równie ważne jak funkcje.

Baza danych, cache i messaging: typowe rozumowanie AI

Zgraj zespół wokół budowy

Zaangażuj współpracowników wcześnie, aby uzgodnić ograniczenia, zakres i pierwszy release.

Kiedy AI rekomenduje bazę danych lub dodaje cache i kolejki, zwykle reaguje na trzy rodzaje ograniczeń: jak spójne muszą być dane, jak skokowy jest ruch i jak szybko zespół musi wysłać bez tworzenia nadmiernego narzutu operacyjnego.

Relacyjna baza danych kontra alternatywy

Relacyjna baza (np. Postgres, MySQL) to często domyślny wybór, gdy potrzebujesz jasnych relacji (użytkownicy → zamówienia → faktury), silnej spójności i bezpiecznych aktualizacji wieloetapowych (np. „obciąż kartę, potem utwórz subskrypcję, potem wyślij potwierdzenie”). AI wybiera relacyjne systemy, gdy wymagania wspominają o:

- raportach i zapytaniach ad‑hoc dla finansów/operacji

- migracjach i ewoluujących schematach

- transakcjach i gwarancjach „bez podwójnego obciążenia”

Alternatywy pojawiają się, gdy ograniczenia się przesuwają. Baza dokumentowa może być proponowana dla szybko zmieniających się, zagnieżdżonych danych (bloki treści, katalogi produktów). Magazyn key‑value lub wide‑column może się pojawić, gdy potrzebujesz ultraniskich opóźnień przy bardzo dużej skali i prostych wzorcach dostępu.

Cache i kolejki: kiedy mają znaczenie

Cache (często Redis lub zarządzany cache) rekomendowany jest, gdy powtarzalne odczyty mogłyby obciążyć DB: popularne strony produktu, dane sesji, limitowanie szybkości, feature flags. Jeśli ograniczeniem są „skoki ruchu” lub „p95 musi być niski”, dodanie cache może dramatycznie zmniejszyć obciążenie bazy.

Kolejki i zadania w tle są proponowane, gdy praca nie musi skończyć się w czasie żądania użytkownika: wysyłka maili, generowanie PDF, synchronizacja z zewnętrznymi systemami, przetwarzanie plików. To poprawia niezawodność i utrzymuje responsywność podczas skoków.

Przechowywanie plików i zdarzeń

Dla plików przesyłanych przez użytkowników i generowanych assetów AI zwykle wybiera object storage (S3‑style), bo jest tańszy, skalowalny i odciąża bazę. Jeśli system musi rejestrować strumienie zdarzeń (kliknięcia, update’y, sygnały IoT), może zaproponować event stream (Kafka/PubSub‑style) do obsługi wysokoprzepustowego, uporządkowanego przetwarzania.

Bezpieczeństwo danych: ograniczenia wymuszające „nudne, ale bezpieczne” wybory

Gdy pojawiają się wymagania zgodności, audytowalności lub RTO/RPO, rekomendacje zwykle zawierają automatyczne backupy, testowane odzyskiwanie, narzędzia migracyjne i silniejszą kontrolę dostępu (zasada najmniejszych uprawnień, zarządzanie sekretami). Im więcej „nie możemy stracić danych”, tym bardziej AI będzie faworyzować usługi zarządzane i sprawdzone wzorce.

Wdrożenie, bezpieczeństwo i ograniczenia operacyjne

Rekomendacja stosu to nie tylko „jaki język i baza”. AI wnioskuje też, jak uruchomić produkt: gdzie hostować, jak wypuszczać aktualizacje, jak obsługiwać incydenty i jakie zabezpieczenia zbudować wokół danych.

Chmura i hosting: zarządzane vs. kontenery vs. serverless

Gdy ograniczenia podkreślają szybkość i mały zespół, AI często faworyzuje platformy zarządzane (PaaS), bo zmniejszają robotę operacyjną: automatyczne patchowanie, prostsze rollbacks i wbudowane skalowanie. Jeśli potrzebujesz większej kontroli (niestandardowe sieci, specjalne runtime’y, wiele usług z wewnętrzną komunikacją), bardziej prawdopodobne są kontenery (często z Kubernetes lub prostszym orchestrator).

Serverless jest sugerowany, gdy ruch jest skokowy lub pragniesz płacić głównie za czas wykonywania kodu. Dobre rekomendacje jednak wskazują kompromisy: debugowanie jest trudniejsze, cold starty mogą wpływać na latencję użytkownika, a koszty rosną, jeśli funkcje zaczynają działać stale.

Bezpieczeństwo i zgodność

Gdy wspominasz PII, logi audytowe lub rezydencję danych, AI zwykle rekomenduje:

- Silne kontrola tożsamości (zasada najmniejszych uprawnień, MFA)

- Szyfrowanie w tranzycie i spoczynku

- Centralne logowanie audytowe dla krytycznych akcji

- Przechowywanie i backupy region‑locked, gdy dane muszą pozostać w lokalizacji

To nie porada prawna — to praktyczne podejście do zmniejszenia ryzyka i ułatwienia przeglądów.

Obserwowalność: co znaczy „gotowy na skalę”

„Gotowy na skalę” często oznacza: ustrukturyzowane logi, podstawowe metryki (latencja, wskaźnik błędów, saturacja) i alertowanie powiązane z wpływem na użytkownika. AI może zalecić standardowe trio — logging + metrics + tracing — aby odpowiedzieć na pytania: Co się zepsuło? Kto jest dotknięty? Co się zmieniło?

Koszty: przewidywalne wydatki kontra pay‑per‑use

AI rozważa, czy wolisz przewidywalne miesięczne koszty (zarezerwowane zasoby, zarządzane DB rozmiarowane z wyprzedzeniem) czy płacenie za użycie (serverless, autoscaling). Dobre rekomendacje wyraźnie wskazują ryzyka „niespodziewanych rachunków": głośne logi, nieograniczone zadania w tle i egress danych, oraz proponują proste limity i budżety do kontroli wydatków.

Trzy przykładowe scenariusze i sugerowane stosy

Wystartuj z własną domeną

Opublikuj projekt na własnej domenie, gdy będzie gotowy dla prawdziwych użytkowników.

Rekomendacje AI zwykle formułuje się jako „najlepsze dopasowanie do tych ograniczeń”, a nie jedną poprawną odpowiedź. Poniżej trzy typowe scenariusze, pokazane jako Opcja A / Opcja B z explicite założeniami.

Przykład 1: Mały zespół, krótki termin, umiarkowana skala

Założenia: 2–5 inżynierów, potrzeba wypuścić za 6–10 tygodni, ruch stały, ale nie ogromny (np. 10k–200k użytkowników/miesiąc), ograniczona zdolność operacyjna.

Opcja A (szybkość przede wszystkim, mniej elementów):

Typowa sugestia: React/Next.js (frontend), Node.js (NestJS) lub Python (FastAPI) (backend), PostgreSQL (baza) i platforma zarządzana typu Vercel + managed Postgres. Uwierzytelnianie i e‑mail to często opcje „kup”, by skrócić czas budowy (Auth0/Clerk, SendGrid).

Jeśli twoim głównym ograniczeniem jest czas i chcesz uniknąć sklejenia wielu starterów, platforma taka jak Koder.ai może pomóc szybko postawić frontend React i backend Go + PostgreSQL z poziomu czatu, z opcją eksportu kodu i wdrożenia — przydatne dla MVP, gdzie nadal chcesz mieć ścieżkę przejęcia projektu.

Opcja B (dopasowane do zespołu, dłuższy horyzont):

Jeśli zespół ma mocne kompetencje w jednej ekosystemie, rekomendacje często sugerują standaryzację: Rails + Postgres lub Django + Postgres, plus minimalna kolejka (zarządzany Redis) tylko jeśli zadania w tle są konieczne.

Przykład 2: Produkt o dużym ruchu i niskiej latencji

Założenia: skokowy ruch, ostre wymagania czasowe, przewaga odczytów, globalni użytkownicy.

Opcja A (wydajność z użyciem sprawdzonych rozwiązań):

AI zwykle dodaje warstwy: CDN (Cloudflare/Fastly), cache edge dla statycznych zasobów, Redis dla gorących odczytów i limitów, oraz kolejkę jak SQS/RabbitMQ dla pracy asynchronicznej. Backend może przejść w stronę Go/Java dla przewidywalnej latencji, zachowując PostgreSQL z replikami do odczytu.

Opcja B (zachowaj stack, optymalizuj krawędzie):

Jeśli czas i rekrutacja zniechęcają do zmiany języka, rekomendacja to zostawić backend i zainwestować w strategię cache’owania, przetwarzanie w kolejkach i indeksowanie bazy przed pisaniem nowego kodu.

Przykład 3: Dane regulowane lub wrażliwe

Założenia: wymagania zgodności (HIPAA/SOC 2/GDPR‑like), audyty, ścisła kontrola dostępu, logi audytowe.

Opcja A (dojrzałe usługi zarządzane):

Typowe wybory: AWS/Azure z KMS, prywatnymi sieciami, rolami IAM, centralnym logowaniem i zarządzanymi bazami z funkcjami audytowymi.

Opcja B (self‑host dla kontroli):

Gdy rezydencja danych lub zasady dostawcy tego wymagają, AI może zaproponować Kubernetes + PostgreSQL z ostrzejszymi kontrolami operacyjnymi — zwykle z ostrzeżeniem, że to zwiększa koszty utrzymania.

Ograniczenia, ryzyka i jak weryfikować rekomendacje AI

AI może zaproponować spójnie brzmiący stos, ale wciąż zgaduje na podstawie częściowych sygnałów. Traktuj wynik jako ustrukturyzowaną hipotezę — nie klucz odpowiedzi.

Powszechne ograniczenia

Po pierwsze, wejście często jest niekompletne. Jeśli nie określisz wolumenu danych, konkurentnej równoczesności, wymogów zgodności, celów latencji czy integracji, rekomendacja wypełni luki założeniami.

Po drugie, ekosystemy szybko się zmieniają. Model może zasugerować narzędzie, które niedawno było „best practice”, ale zostało zdeprecjonowane, przejęte, inaczej wycenione albo straciło wsparcie od dostawcy.

Po trzecie, część kontekstu trudno zakodować: polityka wewnętrzna, istniejące umowy z dostawcami, dojrzałość on‑call, rzeczywisty poziom doświadczenia zespołu czy koszt migracji później.

Ryzyko uprzedzenia popularnością (popularity‑bias) i jak mu zaradzić

Wiele AI faworyzuje szeroko omawiane narzędzia. Popularne nie jest złe, ale może ukryć lepsze dopasowanie w specyficznych przypadkach (regulacje, ograniczony budżet, nietypowe obciążenia).

Przeciwdziałaj temu, jasno formułując ograniczenia:

- „Nie możemy zatrudnić wyspecjalizowanego personelu ops w tym roku.”

- „Dane muszą pozostać w regionie i być audytowalne.”

- „Potrzebujemy przewidywalnych kosztów bardziej niż maksymalnej wydajności.”

Jasne ograniczenia zmuszają rekomendację do uzasadnienia kompromisów zamiast polegania na znanych nazwach.

Kroki walidacji, które zmniejszają kosztowne błędy

Zanim się zobowiążesz, wykonaj lekkie checki celujące w realne ryzyka:

- Zbuduj mały prototyp dla najbardziej ryzykownej ścieżki (auth, płatności, realtime)

- Przetestuj obciążenie wcześnie z realistycznymi wzorcami, nie tylko syntetycznymi benchmarkami

- Oszacuj koszty (compute, storage, egress, zarządzane usługi) dziś i na 6–12 miesięcy

- Przeprowadź przegląd bezpieczeństwa: model zagrożeń, przetwarzanie danych, granice IAM, zarządzanie sekretami i zgodność

Używaj AI bezpiecznie: miej pisemne uzasadnienie

Poproś AI o krótką "kartę decyzyjną": cele, ograniczenia, wybrane komponenty, odrzucone alternatywy i warunki, które wymusiłyby zmianę. Zachowanie tej argumentacji przyspiesza przyszłe dyskusje i ułatwia migracje.

Jeśli korzystasz z narzędzia przyspieszającego budowę (w tym czatowych platform jak Koder.ai), stosuj tę samą dyscyplinę: zdefiniuj założenia na początku, weryfikuj wcześnie cienki fragment produktu i używaj zabezpieczeń jak snapshoty/rollback oraz eksport źródła, by szybkość nie oznaczała utraty kontroli.