Dlaczego kod generowany przez AI i automatyczne testy pasują do siebie

Logika aplikacji napisana z pomocą AI oznacza, że „działające” części twojego kodu są szkicowane przez asystenta: nowe funkcje, drobne elementy, refaktoryzacje, obsługa przypadków brzegowych, a nawet przepisywanie istniejących modułów. Ty nadal decydujesz, co zbudować, ale pierwsza wersja implementacji często pojawia się szybciej — i czasem zawiera założenia, których nie zauważysz od razu.

Automatyczne generowanie testów to odpowiadająca zdolność po stronie weryfikacji. Zamiast pisać każdy test ręcznie, narzędzia mogą proponować przypadki testowe i asercje na podstawie kodu, specyfikacji lub wzorców wyuczonych z poprzednich błędów. W praktyce może to wyglądać tak:

- „Biorąc pod uwagę sygnaturę tej funkcji i gałęzie, oto testy pokrywające typowe wejścia, granice i ścieżki błędów.”

- „Oto testy regresji, które odtwarzają awarię, którą widzieliśmy w produkcji.”

Kluczowe oczekiwanie: wygenerowane testy nie są od razu „dobre”

Wygenerowany test może wprowadzać w błąd: może asercją potwierdzać obecne zachowanie, nawet jeśli jest ono błędne, albo pominąć reguły produktowe, które żyją w głowach ludzi i komentarzach do ticketów. Dlatego przegląd ludzki jest ważny. Ktoś musi potwierdzić, że nazwa testu, konfiguracja i asercje odzwierciedlają rzeczywisty zamiar — a nie tylko to, co kod robi dzisiaj.

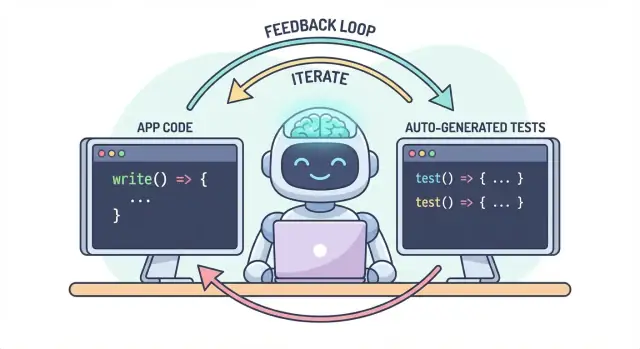

Jeden workflow, dwa wyjścia

Główna idea jest prosta: kod i testy powinny ewoluować razem jako jeden workflow. Jeśli AI pomaga szybko zmieniać logikę, automatyczne generowanie testów pomaga równie szybko utrwalić zamierzone zachowanie — tak aby kolejna zmiana (ludzka lub AI) miała jasną, wykonalną definicję „wciąż poprawne”.

W praktyce podejście „sparowanego wyniku” jest łatwiejsze w utrzymaniu, gdy twój flow deweloperski jest już oparty na czacie. Na przykład w Koder.ai (platforma vibe-coding do budowy aplikacji webowych, backendowych i mobilnych przez czat) naturalne jest traktowanie „funkcji + testów” jako jednego rezultatu: opisujesz zachowanie, generujesz implementację, a potem w tej samej konwersacji generujesz i przeglądasz testy przed wdrożeniem.

Problem: szybsze pisanie kodu może oznaczać szybsze błędy

Kod generowany przez AI może wydawać się supermocą: funkcje pojawiają się szybko, boilerplate znika, a refaktoryzacje, które kiedyś zajmowały godziny, mogą się odbyć zanim twoja kawa wystygnie. Ale prędkość zmienia profil ryzyka. Gdy kod jest łatwiejszy do stworzenia, łatwiej też wprowadzić błędy — czasem subtelne.

Typowe tryby awarii logiki generowanej przez AI

Asystenty AI dobrze radzą sobie z generowaniem „rozsądnych” implementacji, ale rozsądne nie znaczy poprawne dla twojej konkretnej domeny.

Przypadki brzegowe są pierwszą ofiarą. Logika wygenerowana przez AI często obsługuje ścieżkę szczęśliwą, a potem ma problemy z warunkami granicznymi: puste wejścia, niuanse stref czasowych, zaokrąglanie, wartości null, zachowanie retry, czy stany „to nigdy nie powinno się zdarzyć”, które jednak występują w produkcji.

Błędne założenia to kolejny częsty problem. Asystent może wywnioskować wymagania, które nie zostały podane („użytkownicy zawsze są uwierzytelnieni”, „ID są numeryczne”, „to pole zawsze istnieje”), albo zastosować znajomy wzorzec, który nie pasuje do reguł twojego systemu.

Ciche regresje bywają najdroższe. Prosisz o małą zmianę, asystent przepisuje fragment logiki i coś innego przestaje działać — bez oczywistych błędów. Kod nadal się kompiluje, UI nadal się ładuje, ale reguła cenowa, kontrola uprawnień lub konwersja danych jest teraz lekko nieprawidłowa.

Dlaczego testowanie ręczne nie nadąża za szybszym kodem

Gdy zmiany w kodzie przyspieszają, testowanie ręczne staje się wąskim gardłem i hazardem. Albo spędzasz więcej czasu na klikanie (spowalniając dostarczanie), albo testujesz mniej (zwiększając liczbę ucieczek). Nawet zdyscyplinowane zespoły QA nie są w stanie ręcznie objąć wszystkich wariantów, gdy zmiany są częste i szerokie.

Co gorsza, ręczne kontrole trudno powtarzać konsekwentnie. Żyją w czyjejś pamięci lub na checkliście i łatwo je pominąć, gdy terminy się zbliżają — dokładnie wtedy, gdy ryzyko jest najwyższe.

Testy jako sieć bezpieczeństwa i narzędzie komunikacji

Automatyczne testy tworzą trwałą siatkę bezpieczeństwa: zamieniają oczekiwania na wykonywalne warunki. Dobry test mówi: „Dając te wejścia i ten kontekst, oczekujemy tego rezultatu.” To nie tylko weryfikacja; to komunikacja dla przyszłego ciebie, współpracowników i nawet asystenta AI.

Gdy testy istnieją, zmiany przestają być przerażające, bo informacja zwrotna jest natychmiastowa. Zamiast odkrywać problemy podczas code review, na stagingu lub od klientów, znajdujesz je w ciągu kilku minut od zmiany.

Wykrywanie problemów wcześniej zmniejsza konieczność przeróbek

Im wcześniej wykryty błąd, tym taniej go naprawić. Testy skracają pętlę sprzężenia zwrotnego: ujawniają niezgodności założeń i pominięte przypadki brzegowe, gdy intencja jest jeszcze świeża. To zmniejsza przeróbki, unika poprawiania na bieżąco i zapobiega, by szybkość AI zamieniła się w cykliczne poprawki generowane przez AI.