05 cze 2025·8 min

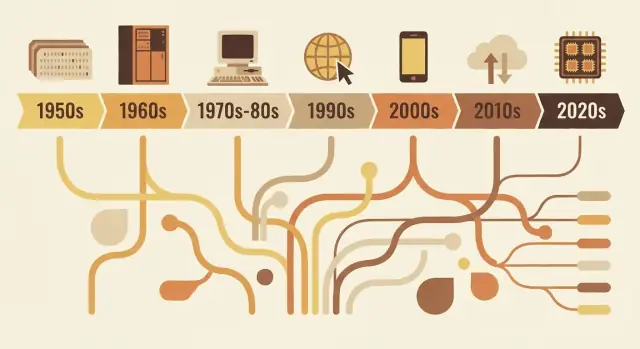

Jak języki programowania odzwierciedlają potrzeby swojej epoki

Od FORTRAN-a po Rust — języki odzwierciedlają priorytety swoich epok: ograniczenia sprzętowe, bezpieczeństwo, web i praca zespołowa. Zobacz, jak wybory projektowe odpowiadają na realne problemy.

Dlaczego języki wyglądają tak, jak wyglądają

Języki programowania nie są po prostu „lepszymi” czy „gorszymi” wersjami siebie nawzajem. To reakcje projektowe na problemy, które trzeba było rozwiązać w danym momencie rozwoju informatyki.

Co właściwie obejmuje „projekt języka”

Mówiąc o projekcie języka, mamy na myśli więcej niż tylko wygląd kodu. Język to zbiór decyzji, takich jak:

- Składnia: jak wyrażasz pomysły (słowa kluczowe, interpunkcja, czytelność)

- Typy: czy wartości mają zadeklarowane rodzaje (i jak surowo język to sprawdza)

- Model pamięci: kto zarządza pamięcią i jakie istnieją gwarancje bezpieczeństwa

- Model wykonania: kompilowany vs interpretowany, zachowanie czasu wykonania, kompromisy wydajności

- Biblioteka standardowa + narzędzia: pakiety, systemy budowania, debugery, formatery i sposób, w jaki zespoły dostarczają oprogramowanie

Te wybory grupują się wokół ograniczeń epoki: skromny sprzęt, wysoki koszt cykli obliczeniowych, brak funkcji systemu operacyjnego, a później ogromne zespoły, globalne sieci i zagrożenia bezpieczeństwa.

Główna myśl

Języki odzwierciedlają swoją epokę. Wczesne języki priorytetowały wyciskanie wartości z przeliczonych maszyn. Później dominowała przenośność, bo oprogramowanie musiało działać na wielu systemach. W miarę wzrostu projektów języki stawiały na strukturę, abstrakcję i narzędzia, żeby utrzymać duże bazy kodu zrozumiałe. Najnowsze wymagania — współbieżność, wdrożenia w chmurze i bezpieczeństwo — wymusiły kolejne kompromisy.

Ten artykuł pokazuje reprezentatywne przykłady — nie jest to pełna chronologia rok po roku. Zobaczysz, jak kilka wpływowych języków ucieleśnia potrzeby swoich czasów i jak idee są powtarzane i udoskonalane.

Dlaczego to ma znaczenie przy wyborze narzędzi dzisiaj

Zrozumienie „dlaczego” stojącego za językiem pomaga przewidzieć jego mocne strony i ślepe punkty. Ułatwia odpowiedzi na pytania: Czy język jest zoptymalizowany pod ścisłą wydajność, szybkie iteracje, utrzymanie w dużym zespole czy bezpieczeństwo? Przy decyzji, czego się uczyć lub czego użyć w projekcie, kontekst ma taką samą praktyczną wagę jak lista funkcji.

Wczesne ograniczenia obliczeniowe, które ukształtowały wszystko

Wczesne języki programowania były kształtowane bardziej przez fizykę i budżety niż przez gust. Maszyny miały niewiele pamięci, magazynowanie było skąpe, a CPU powolne w porównaniu z dzisiejszymi standardami. To wymuszało kompromisy: każda dodatkowa funkcja, każdy dłuższy rozkaz i każda warstwa abstrakcji miały realny koszt.

Mało pamięci, drogie cykle

Jeśli masz przestrzeń tylko na mały program i mały zbiór danych, projektujesz języki i narzędzia, które utrzymują programy kompaktowe i przewidywalne. Wczesne systemy skłaniały programistów ku prostemu przepływowi sterowania i minimalnemu wsparciu czasu wykonania. Nawet „miłe do posiadania” cechy — bogate łańcuchy znaków, dynamiczne zarządzanie pamięcią czy wysokopoziomowe struktury danych — mogły być niepraktyczne, bo wymagały dodatkowego kodu i księgowości stanu.

Przetwarzanie wsadowe i długie pętle sprzężenia zwrotnego

Wiele wczesnych programów było uruchamianych w partiach. Przygotowywałeś zadanie (często z kart perforowanych), wysyłałeś je i czekałeś. Jeśli coś poszło nie tak, mogłeś się dowiedzieć dopiero później — po zakończeniu lub niepowodzeniu zadania.

Ta długa pętla sprzężenia zmianiała priorytety:

- Programy musiały działać poprawnie za pierwszym razem, bo ponowne uruchomienia były kosztowne.

- Debugowanie było wolniejsze, więc deweloperzy opierali się na starannym planowaniu i konwencjach.

- Narzędzia i interaktywna eksploracja nie były doświadczeniem domyślnym.

Dlaczego czytelność i komunikaty o błędach nie były priorytetem

Gdy czas maszynowy był cenny, a interfejsy ograniczone, języki nie optymalizowały przyjaznych diagnoz czy jasności dla początkujących. Komunikaty o błędach często musiały być krótkie, niekiedy zagadkowe, i skupione na pomocy operatorowi w zlokalizowaniu problemu na karcie lub w wydruku.

Nauka i matematyka napędzały wczesne funkcje

Dużą część wczesnych zastosowań komputerów stanowiły zadania naukowe i inżynierskie: obliczenia, symulacje i metody numeryczne. Dlatego wczesne cechy języków koncentrowały się na efektywnych operacjach arytmetycznych, tablicach i sposobie wyrażania wzorów, który dobrze mapował się na sprzęt — i na sposób pracy naukowców na papierze.

FORTRAN, COBOL i języki stworzone do określonych zadań

Niektóre wczesne języki nie próbowały być uniwersalne. Zostały zbudowane, by rozwiązywać wąską klasę problemów wyjątkowo dobrze — bo komputery były drogie, czas był limitowany, a „wystarczająco dobry do wszystkiego” często oznaczał „świetny w niczym”.

FORTRAN: obliczenia numeryczne, szybkość i praca naukowca

FORTRAN (FORmula TRANslation) był skierowany prosto do obliczeń inżynierskich i naukowych. Jego główną obietnicą było praktyczne ułatwienie: pozwolić ludziom pisać programy mocno osadzone w matematyce bez ręcznego pisania każdego szczegółu w asemblerze.

To kształtowało jego projekt. Skłaniał się ku operacjom numerycznym i obliczeniom tablicowym oraz kładł nacisk na wydajność. Prawdziwą innowacją nie była tylko składnia — to pomysł, że kompilator może wygenerować kod maszynowy na tyle wydajny, by naukowcy mu ufali. Gdy twoim podstawowym zadaniem są symulacje czy tabele balistyczne, skrócenie czasu wykonania to nie luksus, lecz różnica między wynikami dziś a za tydzień.

COBOL: rekordy biznesowe, czytelność i raportowanie

COBOL celował w inny świat: instytucje rządowe, banki, ubezpieczenia, listy płac i inwentaryzację. To problemy „rekordów i raportów” — dane strukturalne, przewidywalne przepływy pracy i duże wymagania audytowe.

Dlatego COBOL preferował angielsko-podobny, rozbudowany styl, który ułatwiał przegląd i utrzymanie programów w dużych organizacjach. Definicje danych były pierwszoplanową troską, bo oprogramowanie biznesowe żyje i umiera w zależności od tego, jak dobrze modeluje formularze, konta i transakcje.

Co oznacza „blisko domeny”

Oba języki ilustrują zasadę: słownictwo powinno odzwierciedlać pracę. FORTRAN mówi językiem matematyki i obliczeń. COBOL mówi językiem rekordów i procedur. Ich popularność ujawnia priorytety epoki: nie abstrakcyjne eksperymenty, lecz wydajna realizacja zadań — czy to szybsze obliczenia, czy czytelne przetwarzanie danych biznesowych.

Era systemów: przenośność i kontrola (C, Unix)

Pod koniec lat 60. i w latach 70. komputery stawały się tańsze i powszechniejsze — ale wciąż bardzo różne. Jeśli pisałeś oprogramowanie dla jednej maszyny, przenoszenie go na inną często wymagało przepisywania dużych fragmentów ręcznie.

Ból programowania w asemblerze pchnął języki w górę

Dużo ważnego oprogramowania pisano w asemblerze, co dawało maksymalną wydajność i kontrolę, ale miało wysoką cenę: każdy CPU miał własny zestaw instrukcji, kod był trudny do czytania, a drobne zmiany mogły oznaczać dni uważnych poprawek. Ten ból stworzył zapotrzebowanie na język, który byłby „blisko sprzętu”, ale nie wiązałby cię z jednym procesorem.

Główny cel C: przenośny kod systemowy

C powstał jako praktyczny kompromis. Zaprojektowano go do pisania systemów operacyjnych i narzędzi — przede wszystkim Uniksa — przy zachowaniu przenośności między sprzętami. C dał programistom:

- Niewielki, prosty zestaw cech, które można było skompilować na wielu maszynach

- Bezpośredni dostęp do pamięci przez wskaźniki

- Możliwość pisania niskopoziomowego kodu bez powrotu do asemblera dla każdego detalu

Przepisywanie Uniksa na C jest znanym przykładem: system operacyjny mógł podróżować na nowy sprzęt znacznie łatwiej niż system napisany wyłącznie w asemblerze.

Dlaczego ręczne zarządzanie pamięcią było akceptowalne

C oczekiwał, że programista sam będzie zarządzał pamięcią (alokował ją, zwalniał, unikał błędów). Dziś brzmi to ryzykownie, ale wtedy pasowało do priorytetów epoki. Maszyny miały ograniczone zasoby, systemy operacyjne potrzebowały przewidywalnej wydajności, a programiści często pracowali bardzo blisko sprzętu — czasem znając dokładny układ pamięci, którego potrzebowali.

Trwały kompromis

C był zoptymalizowany pod kątem szybkości i kontroli — i te cele osiągnął. Kosztem była bezpieczeństwo i łatwość użycia: przepełnienia bufora, awarie i subtelne błędy stały się powszechnymi zagrożeniami. W tamtej epoce ryzyko to często uważano za dopuszczalny koszt za przenośność i wydajność.

Utrzymywanie dużych programów: struktura i typy

W miarę jak programy rosły od małych, jednofunkcyjnych narzędzi do produktów obsługujących firmy, pojawił się nowy problem: nie tylko „czy to działa?”, ale „czy utrzymamy to działające przez lata?”. Wczesny kod często ewoluował przez łatki i skoki goto, tworząc „spaghetti code”, trudny do czytania, testowania i bezpiecznej zmiany.

Co miało naprawić programowanie strukturalne

Programowanie strukturalne promowało prostą ideę: kod powinien mieć czytelną formę. Zamiast skoków do dowolnych linii, stosowano dobrze zdefiniowane bloki — if/else, while, for i switch — aby przepływ sterowania był przewidywalny.

Ta przewidywalność była ważna, bo debugowanie to w dużej mierze odpowiadanie na pytanie „jak wykonanie tu trafiło?”. Gdy przepływ jest widoczny w strukturze, mniej błędów kryje się w szczelinach.

Wzrost zespołów i długowiecznych baz kodu

Gdy oprogramowanie stało się pracą zespołową, utrzymywalność stała się problemem społecznym równie mocno co technicznym. Nowi członkowie zespołu musieli rozumieć kod, którego nie napisali. Menedżerowie potrzebowali szacunków zmian. Firmy potrzebowały pewności, że aktualizacje nie zepsują wszystkiego.

Języki odpowiedziały, zachęcając do konwencji skalujących poza pamięć jednej osoby: spójne granice funkcji, jaśniejsze okresy życia zmiennych i sposoby organizacji kodu w pliki i biblioteki.

Dlaczego typy, moduły i zakresy zyskały na wartości

Typy nabrały znaczenia, bo działają jak „wbudowana dokumentacja” i wykrywacz wczesnych błędów. Jeśli funkcja oczekuje liczby, a dostaje tekst, silny system typów może to złapać zanim dotrze do użytkowników.

Moduły i zasięgi ograniczały zasięg wpływu zmian. Ukrywając szczegóły i eksponując stabilne interfejsy, zespoły mogły refaktoryzować wnętrza bez przepisywania całego programu.

Ruchy projektowe wspierające komponowanie

Typowe ulepszenia obejmowały:

- Mniejsze, dobrze nazwane funkcje wykonujące jedno zadanie

- Skoping leksykalny, aby uniknąć przypadkowych interakcji między zmiennymi

- Lepsze wzorce komponowania (przekazywanie funkcji/danych w czysty sposób zamiast polegać na stanie globalnym)

Razem te zmiany przesunęły języki w stronę kodu łatwiejszego do czytania, przeglądania i bezpiecznej ewolucji.

Obiekty i biznes: dlaczego OOP stało się mainstreamem

Zamień koncepcje w dema

Stwórz działające demo, aby zweryfikować wymagania z zespołem.

Programowanie obiektowe (OOP) nie „wygrało”, bo było jedynym dobrym pomysłem — wygrało, bo pasowało do tego, co wiele zespołów próbowało budować: długowieczne oprogramowanie biznesowe utrzymywane przez wiele osób.

Co obiecywało OOP

OOP dawało klarowną opowieść o złożoności: przedstaw program jako zbiór „obiektów” z jasnymi odpowiedzialnościami.

Enkapsulacja (ukrywanie detali) brzmiała jak praktyczny sposób na zapobieganie przypadkowemu psuciu. Dziedziczenie i polimorfizm obiecywały ponowne użycie: napisz ogólną wersję raz, specjalizuj później i podłącz różne implementacje pod ten sam interfejs.

Dlaczego GUI i aplikacje biznesowe to napędzały

W miarę jak oprogramowanie desktopowe i interfejsy graficzne rosły, deweloperzy potrzebowali sposobów na zarządzanie wieloma współdziałającymi komponentami: oknami, przyciskami, dokumentami, menu i zdarzeniami. Myślenie obiektowe i komunikacja przez wiadomości mapowały się naturalnie na te interaktywne elementy.

Jednocześnie systemy korporacyjne rosły w domenach jak bankowość, ubezpieczenia, inwentaryzacja i HR. Środowiska te ceniły spójność, współpracę zespołową i bazy kodu, które mogły ewoluować przez lata. OOP spełniało potrzebę organizacyjną: dzieliło pracę na moduły przypisane różnym zespołom, wymuszało granice i standaryzowało sposób dodawania funkcji.

Gdzie pomagało — a gdzie powodowało bałagan

OOP jest użyteczne, gdy tworzy stabilne granice i komponenty wielokrotnego użytku. Staje się uciążliwe, gdy programiści nadmiernie modelują wszystko, tworząc głębokie hierarchie klas, „obiekty-boga” lub wzorce stosowane głównie dlatego, że są modne. Zbyt wiele warstw może sprawić, że prosta zmiana przypomina wypełnianie dokumentów.

Trwały wpływ

Nawet języki, które nie są „czystym OOP”, zapożyczyły jego domyślne podejścia: struktury podobne do klas, interfejsy, modyfikatory dostępu i wzorce projektowe. Duża część współczesnej składni mainstreamowej nadal odzwierciedla skupienie tej epoki na organizowaniu dużych zespołów wokół dużych baz kodu.

Era Javy: przenośność, bezpieczeństwo i skala korporacyjna

Java pojawiła się wraz z konkretnym boomem oprogramowania: dużymi, długowiecznymi systemami biznesowymi rozproszonymi po mieszance serwerów, systemów operacyjnych i sprzętu od różnych dostawców. Firmy chciały przewidywalnych wdrożeń, mniej awarii i zespołów, które mogły rosnąć bez konieczności przepisywania wszystkiego co kilka lat.

Co rozwiązała JVM: przenośność z zarządzanym środowiskiem

Zamiast kompilować bezpośrednio do instrukcji konkretnej maszyny, Java kompiluje do bajtkodu uruchamianego na Java Virtual Machine (JVM). JVM stała się „warstwą standardową”, na której mogły polegać przedsiębiorstwa: wysyłasz ten sam artefakt aplikacji i uruchamiasz go na Windows, Linux czy Unix z minimalnymi zmianami.

To istota „pisz raz, uruchamiaj wszędzie”: nie gwarancja braku niuansów platformowych, ale praktyczny sposób zmniejszenia kosztów i ryzyka wsparcia wielu środowisk.

Bezpieczne domyślne ustawienia, które zmniejszały awarie produkcyjne

Java uczyniła bezpieczeństwo cechą podstawową, a nie opcjonalną dyscypliną.

Garbage collection zredukował kategorię błędów pamięci (wiszące wskaźniki, podwójne zwolnienia), powszechnych w środowiskach bez zarządzania. Sprawdzanie granic tablic zapobiegało odczytom lub zapisom poza strukturami danych. W połączeniu z surowszym systemem typów, te wybory miały zmieniać katastrofalne awarie w przewidywalne wyjątki — łatwiejsze do odtworzenia, zalogowania i naprawy.

Dlaczego pasowało do realiów przedsiębiorstw

Przedsiębiorstwa ceniły stabilność, narzędzia i zarządzanie: ustandaryzowane procesy budowania, silne wsparcie IDE, obszerne biblioteki i środowisko uruchomieniowe, które można monitorować i zarządzać. JVM umożliwiła też bogaty ekosystem serwerów aplikacyjnych i frameworków, które ujednolicały rozwój w dużych zespołach.

Kompromisy: narzut, strojenie, złożoność

Korzyści Javy nie były darmowe. Zarządzane środowisko dodaje czas startu i narzut pamięciowy, a garbage collector może generować skoki opóźnień, jeśli nie jest odpowiednio skonfigurowany. Ekosystem z czasem narósł w złożoność — warstwy frameworków, konfiguracje i modele wdrożeń wymagające specjalistycznej wiedzy.

Mimo to dla wielu organizacji układ okazał się korzystny: mniej niskopoziomowych awarii, łatwiejsze wdrażanie między platformami i wspólne środowisko uruchomieniowe skalujące się wraz z wielkością biznesu i bazy kodu.

Języki skryptowe i nacisk na produktywność

Buduj przez rozmowę, nie przez kodowanie

Zamień pomysł w działającą aplikację przez rozmowę, bez sklejania narzędzi.

Pod koniec lat 90. i w latach 2000 wiele zespołów nie pisało systemów operacyjnych — łączyli bazy danych, budowali strony internetowe i automatyzowali wewnętrzne procesy. Wąskie gardło przesunęło się z surowej wydajności CPU na czas programisty. Szybsze sprzężenie zwrotne i krótsze cykle wydań uczyniły pytanie „jak szybko możemy to zmienić?” priorytetem.

Dlaczego szybkie iteracje stały się priorytetem

Aplikacje webowe rozwijały się w dniach, nie latach. Firmy chciały nowe strony, raporty i integracje oraz szybkie poprawki bez pełnego cyklu kompilacja–link–wdrożenie. Języki skryptowe pasowały do tego rytmu: edytujesz plik, uruchamiasz go i widzisz wynik.

To też zmieniło, kto mógł tworzyć oprogramowanie. Administratorzy systemów, analitycy i małe zespoły mogli wypuszczać użyteczne narzędzia bez głębokiej wiedzy o zarządzaniu pamięcią czy systemach budowania.

Dynamiczne typowanie i podejście „baterie w zestawie”

Języki takie jak Python i Ruby skłaniały się ku dynamicznemu typowaniu: możesz wyrazić pomysł mniejszą liczbą deklaracji i ceremoniału. W połączeniu z silnymi bibliotekami standardowymi sprawiło to, że typowe zadania były „jednym importem”:\n

- przetwarzanie tekstu i obsługa plików\n- HTTP, e-mail i podstawowe sieci\n- dostęp do baz danych i formaty danych (CSV, JSON, XML)

To podejście „baterie w zestawie” sprzyjało eksperymentowaniu i pozwalało automatyzacjom rosnąć w pełnoprawne aplikacje.

Python, Ruby i PHP jako praktyczne odpowiedzi

Python stał się wyborem dla automatyzacji i programowania ogólnego, Ruby przyspieszył rozwój webowy (szczególnie dzięki frameworkom), a PHP zdominował wczesny serwerowy web, ponieważ można go było łatwo osadzić w stronach i wdrożyć niemal wszędzie.

Kompromisy: szybkość, błędy czasu wykonywania, praktyki skalowania

Te same cechy, które zwiększały produktywność, wprowadzały koszty:

- wolniejsze wykonanie w porównaniu z językami kompilowanymi

- więcej błędów wykrywanych dopiero w czasie uruchomienia

- skalowanie wymagało dyscypliny: testów, przeglądów kodu, linterów i konwencji

Innymi słowy, języki skryptowe zoptymalizowały szybkość zmian. Zespoły nauczyły się „odpłacać” za niezawodność narzędziami i praktykami — co przygotowało grunt pod współczesne ekosystemy, gdzie oczekuje się zarówno szybkości dewelopera, jak i jakości oprogramowania.

JavaScript i boom przeglądarkowy

Przeglądarka stała się niespodziewanym „komputerem” dostarczanym milionom użytkowników. To jednak nie była czysta karta: była to piaskownica, uruchamiana na nieprzewidywalnym sprzęcie i musiała pozostać responsywna podczas renderowania oraz oczekiwania na sieć. To środowisko ukształtowało rolę JavaScriptu bardziej niż jakakolwiek abstrakcyjna wizja idealnego języka.

Platforma z nietypowymi ograniczeniami

Przeglądarki wymagały, by kod był dostarczany natychmiast, uruchamiany bezpiecznie obok nieufnej zawartości i utrzymywał interaktywność strony. To pchnęło JavaScript w stronę szybkiego startu, dynamicznego zachowania i API ściśle powiązanych ze stroną: kliknięcia, wejścia, timery i później żądania sieciowe.

Dlaczego „wszędzie” wygrało z „idealnym”

JavaScript wygrał głównie dlatego, że już był obecny. Jeśli chciałeś zachowania w przeglądarce, JavaScript był domyślną opcją — bez instalacji, bez zgód, bez oddzielnego środowiska. Konkurencyjne pomysły mogły wyglądać ładniej na papierze, ale nie mogły przebić przewagi dystrybucyjnej: „działa na każdej stronie”.

Sterowanie zdarzeniami z konieczności

Przeglądarka jest z natury reaktywna: użytkownicy klikają, strony przewijają się, odpowiedzi z sieci przychodzą w nieprzewidywalnym czasie. Styl oparty na zdarzeniach (callbacki, zdarzenia, promise'y) odpowiada tej rzeczywistości. Zamiast programu uruchamianego od początku do końca, duża część kodu webowego to „czekaj na coś, potem reaguj”, co dobrze pasuje do UI i pracy sieciowej.

Długofalowe efekty: ekosystemy i kompatybilność wstecz

Sukces stworzył studnię grawitacyjną. Powstały ogromne ekosystemy frameworków i bibliotek, a pipeline budowania stał się kategorią produktu: transpile, bundlery, minifikatory i menedżery pakietów. Jednocześnie obietnica kompatybilności wstecz na webie oznaczała, że stare decyzje przetrwały — więc współczesny JavaScript często przypomina warstwy nowych narzędzi zaprojektowanych tak, by współistnieć z ograniczeniami przeszłości.

Współbieżność i rzeczywistość wielordzeniowa

Przez długi czas szybsze komputery oznaczały jedno: twój program działa szybciej bez zmiany kodu. Ten układ się zepsuł, gdy procesory osiągnęły limity ciepła i energii i zaczęły dodawać rdzenie zamiast podnosić częstotliwość. Nagle uzyskanie większej wydajności często wymagało robienia więcej rzeczy jednocześnie.

Dlaczego wielordzeniowość uczyniła współbieżność nieuniknioną

Współczesne aplikacje rzadko wykonują jedno, izolowane zadanie. Obsługują wiele żądań, rozmawiają z bazami danych, renderują UI, przetwarzają pliki i czekają na sieci — a użytkownicy oczekują natychmiastowej reakcji. Wielordzeniowy sprzęt umożliwił uruchamianie pracy równolegle, ale też uwydatnił ból, gdy język czy runtime zakładały „jeden główny wątek, jeden przepływ”.

Co języki dodały, żeby pomóc

Wczesna współbieżność opierała się na wątkach systemowych i blokadach. Wiele języków udostępniało je bezpośrednio, co działało — ale przenosiło złożoność na codziennych programistów.

Nowsze projekty próbują ułatwić typowe wzorce:

- Wątki z bezpieczniejszymi prymitywami: lepsze mutexy, pule wątków i jaśniejsze modele pamięci.

- async/await: sposób pisania nieblokującego kodu, który nadal czyta się jak sekwencyjny.

- Kanały i przekazywanie wiadomości: „dziel dane przez komunikację” (wzorce stylu CSP) redukują błędy związane ze współdzielonym stanem.

Serwery i systemy rozproszone zmieniły domyślne założenia

Wraz z przejściem oprogramowania do usług zawsze działających, „normalny” program stał się serwerem obsługującym tysiące współbieżnych żądań. Języki zaczęły optymalizować pod obciążenia I/O, wsparcie anulowania/timeouts i przewidywalną wydajność pod obciążeniem.

Pułapki, które języki starają się zapobiec

Błędy współbieżności są często rzadkie i trudne do odtworzenia. Projekt języka coraz częściej dąży do zapobiegania:

- Warunkom wyścigu (dwie jednostki pracy aktualizują ten sam stan nieprzewidywalnie)

- Zakleszczeniom (zadania czekają na siebie nawzajem w nieskończoność)

- Głodzeniu (niektóre zadania nigdy nie dostają czasu procesora)

Wielka zmiana: współbieżność przestała być tematem zaawansowanym i stała się oczekiwaniem podstawowym.

Współczesne priorytety: bezpieczeństwo, prostota i narzędzia (Go, Rust)

Iteruj bez obaw

Zapisuj postępy za pomocą snapshotów i przywracaj bez obaw podczas eksperymentów.

W latach 2010 wielu zespołów nie miało problemu z wyrażaniem algorytmów — miały problem z utrzymaniem usług bezpiecznych, stabilnych i łatwych do zmiany przy ciągłej presji wdrożeń. Dwa problemy wyróżniały się: błędy bezpieczeństwa spowodowane przez problemy z pamięcią oraz hamulec inżynieryjny wynikający ze zbyt złożonych stosów i niespójnych narzędzi.

Naprawianie powtarzających się błędów

Duża część wysokowaznych podatności dalej wynika z problemów z bezpieczeństwem pamięci: przepełnienia bufora, use-after-free i subtelne niezdefiniowane zachowania widoczne tylko w niektórych buildach lub maszynach. Projektowanie języków współczesnych coraz częściej traktuje je jako niedopuszczalne „pistoletowe spusty”, a nie tylko błąd programisty.

Rust jest najczystszą odpowiedzią. Jego reguły własności i pożyczania to swego rodzaju układ: piszesz kod zgodny z surowymi sprawdzeniami czasu kompilacji, a w zamian otrzymujesz silne gwarancje bezpieczeństwa pamięci bez garbage collectora. To czyni Rust atrakcyjnym dla kodu systemowego, który historycznie żył w C/C++ — usług sieciowych, komponentów embedded, bibliotek krytycznych wydajnościowo — tam, gdzie ważne są zarówno bezpieczeństwo, jak i szybkość.

Prostota i usługi jako domyślne obciążenie

Go przyjmuje niemal odwrotne podejście: ogranicz zestaw cech języka, żeby utrzymać bazy kodu czytelnymi i przewidywalnymi w dużych zespołach. Jego projekt odzwierciedla świat usług długotrwałych, API i infrastruktury chmurowej.

Standardowa biblioteka Go i wbudowane prymitywy współbieżności (goroutines, kanały) wspierają rozwój usług bezpośrednio, a szybki kompilator i prosty model zależności zmniejszają codzienne tarcie.

Doświadczenie dewelopera jako cecha

Narzędzia przestały być „opcjonalnymi dodatkami” i stały się częścią obietnicy języka. Go znormalizował to podejście przez gofmt i kulturę standardowego formatowania. Rust poszedł podobną drogą z rustfmt, clippy i mocno zintegrowanym narzędziem budowania (cargo).

W środowisku „ciągłego dostarczania” ta historia narzędzi coraz częściej wykracza poza kompilatory i lintery ku wyższym przepływom pracy: planowaniu, scaffoldingu i szybszym pętlom iteracyjnym. Platformy takie jak Koder.ai odzwierciedlają tę zmianę, pozwalając zespołom budować aplikacje webowe, backend i mobilne przez interfejs czatowy — a potem eksportować źródła, wdrażać i cofać przez snapshoty, gdy trzeba. To kolejny przykład historycznego wzorca: narzędzia, które najszybciej się rozprzestrzeniają, to te, które upraszczają najbardziej powszechną pracę epoki i zmniejszają liczbę błędów.

Gdy formatery, lintery i systemy budowania stają się elementami pierwszorzędnymi, zespoły poświęcają mniej czasu na spory o styl i rozwiązywanie niespójnych środowisk — a więcej na wypuszczanie niezawodnego oprogramowania.

Co dzisiejsze problemy sugerują o językach jutra

Języki programowania nie „wygrywają”, bo są perfekcyjne. Wygrywają, gdy czynią najczęstszą pracę epoki tańszą, bezpieczniejszą lub szybszą — zwłaszcza w połączeniu z odpowiednimi bibliotekami i nawykami wdrożeniowymi.

AI, praca z danymi i siła ekosystemów

Wielkim czynnikiem popularności języków dziś jest to, gdzie leży praca: potoki danych, analityka, uczenie maszynowe i automatyzacja. Dlatego Python rośnie nie tylko przez składnię, ale przez ekosystem: NumPy/Pandas do danych, PyTorch/TensorFlow do ML, notebooki do eksploracji i ogromną społeczność tworzącą wielokrotne bloki konstrukcyjne.

SQL to cichszy przykład tego samego efektu. Nie jest modny, ale wciąż jest domyślnym interfejsem do danych biznesowych, bo pasuje do zadania: zapytania deklaratywne, przewidywalne optymalizatory i szeroka kompatybilność między narzędziami i dostawcami. Nowe języki często integrują SQL zamiast go zastępować.

Tymczasem wydajnościowo ciężkie AI popycha narzędzia GPU do przodu. Coraz częściej widzimy pierwszorzędne wsparcie dla wektoryzacji, batchowania i akceleracji sprzętowej — czy to przez ekosystemy CUDA, MLIR i stosy kompilatorów, czy języki ułatwiające wiązanie z tymi środowiskami.

Co może kształtować przyszłe projekty języków

Kilka nacisków prawdopodobnie wpłynie na „następną epokę” języków i większe aktualizacje:

- Weryfikacja i poprawność: silniejsze systemy typów, bezpieczniejsza współbieżność i narzędzia dowodzące własności zamiast jedynie testów.

- Prywatność i polityka: lepsze wsparcie dla zarządzania danymi, audytowalności i ograniczeń wokół danych wrażliwych.

- Zużycie energii i efektywność: języki i środowiska wykonawcze ułatwiające pisanie szybkiego kodu bez ręcznego mikrozarządzania.

Praktyczne podsumowanie

Wybierając język, dopasuj go do swoich ograniczeń: doświadczenia zespołu, dostępności kandydatów, bibliotek, na których polegasz, celów wdrożeniowych i wymagań niezawodności. „Dobry” język to często taki, który sprawia, że twoje najczęstsze zadania stają się nudne — a błędy łatwiejsze do zapobieżenia i zdiagnozowania.

Jeśli potrzebujesz ekosystemu opartego na frameworkach, wybierz dla ekosystemu; jeśli potrzebujesz poprawności i kontroli, wybierz dla bezpieczeństwa i wydajności. Dla rozszerzonej listy kontrolnej decyzji zobacz /blog/how-to-choose-a-programming-language.