Dlaczego MySQL stał się fundamentem wczesnego internetu

MySQL został bazą wybieraną wczesnego internetu z prostego powodu: odpowiadał potrzebom stron — przechowywać i pobierać strukturalne dane szybko, działać na skromnym sprzęcie i być prostym w obsłudze dla małych zespołów.

Był przystępny. Dało się go szybko zainstalować, łączyć z popularnymi językami i uruchomić serwis bez zatrudniania dedykowanego administratora baz danych. To połączenie „wystarczającej wydajności” i niskich kosztów operacyjnych uczyniło go domyślnym wyborem dla startupów, projektów hobbystycznych i rosnących firm.

Co „skala” znaczy w tym kontekście

Gdy mówi się, że MySQL „skalował”, zwykle chodzi o mieszankę:

- Wzrost ruchu: więcej równoczesnych użytkowników i zapytań na sekundę.

- Wzrost danych: tabele rosną z tysięcy wierszy do milionów czy miliardów.

- Oczekiwania niezawodności: pozostawać online mimo awarii, wdrożeń i problemów sprzętowych.

- Ograniczenia kosztów: osiągnąć powyższe bez budżetu klasy enterprise.

Wczesne firmy internetowe potrzebowały nie tylko szybkości; chciały przewidywalnej wydajności i dostępności przy kontrolowanych wydatkach.

Główne dźwignie, do których wrócimy

Historia skalowania MySQL to opowieść o praktycznych kompromisach i powtarzalnych wzorcach:

- Projekt schematu i zapytań (co przechowujesz, jak łączysz, czego unikasz)

- Indeksy (różnica między „działa w dewelopmencie” a „działa w produkcji”)

- Caching (nie uderzać w bazę przy każdym odświeżeniu strony)

- Replikacja i repliki odczytowe (rozproszyć ruch odczytów)

- Sharding/partyjowanie (dzielenie danych, gdy jedna baza nie daje rady)

Zakres artykułu

To przegląd wzorców, których zespoły używały, by utrzymać MySQL przy dużym ruchu webowym — nie jest to pełny podręcznik MySQL. Celem jest wyjaśnienie, jak baza pasowała do potrzeb sieci i dlaczego te same pomysły pojawiają się w wielkoskalowych systemach dziś.

Era LAMP: jak prostota pomogła MySQL się rozpowszechnić

Przełom MySQL był ściśle związany z rosnącą popularnością hostingu współdzielonego i małych zespołów szybko budujących aplikacje webowe. Nie chodziło tylko o to, że MySQL był „wystarczający” — on pasował do sposobu, w jaki wczesny web był wdrażany, zarządzany i finansowany.

Dlaczego LAMP pasował do wczesnego hostingu

LAMP (Linux, Apache, MySQL, PHP/Perl/Python) działał, bo zgadzał się z domyślną konfiguracją serwera, na którą większość osób mogła sobie pozwolić: pojedyncza maszyna Linux z serwerem webowym i bazą obok siebie.

Dostawcy hostingu mogli templatować to środowisko, automatyzować instalacje i oferować je tanio. Deweloperzy mogli zakładać ten sam baseline niemal wszędzie, redukując niespodzianki przy przenoszeniu z lokalnego środowiska na produkcję.

Prostota jako strategia dystrybucji

MySQL był prosty w instalacji, uruchomieniu i podłączeniu. Mówił znajomym SQL, miał prosty klient wiersza poleceń i dobrze integrował się z popularnymi językami i frameworkami tamtych lat.

Równie ważny był model operacyjny: jeden główny proces, kilka plików konfiguracyjnych i zrozumiałe tryby awarii. To sprawiało, że ogólni administratorzy systemów (a często sami deweloperzy) mogli prowadzić bazę bez specjalistycznego szkolenia.

Koszt, dostępność i momentum społeczności

Bycie open source usuwało barierę licencyjną. Projekt studencki, forum hobbystyczne i mały sklep mogły używać tego samego silnika co większe firmy.

Dokumentacja, listy dyskusyjne i później poradniki online budowały impet: więcej użytkowników oznaczało więcej przykładów, narzędzi i szybsze rozwiązywanie problemów.

Wczesne obciążenia, które MySQL obsługiwał dobrze

Większość wczesnych stron była nastawiona na odczyty i dość prosta: fora, blogi, strony CMS i małe katalogi e‑commerce. Te aplikacje zwykle potrzebowały szybkich odczytów po ID, najnowszych wpisów, kont użytkowników i prostego filtrowania — dokładnie tego, co MySQL umiał efektywnie obsłużyć na skromnym sprzęcie.

Wczesne naciski skalowania: więcej użytkowników, więcej odczytów, więcej zapisów

Wczesne wdrożenia MySQL często zaczynały się jako „jeden serwer, jedna baza, jedna aplikacja”. To działało dla forum czy małej firmowej strony — dopóki aplikacja nie stała się popularna. Odwiedziny strony przeradzały się w sesje, sesje w stały ruch i baza przestała być cichym komponentem zaplecza.

Dlaczego odczyty zwykle dominowały

Większość aplikacji webowych była (i nadal jest) nastawiona na odczyty. Strona główna, lista produktów czy profil mogą być wyświetlane tysiące razy na jedną zmianę. Ta nierównowaga kształtowała wczesne decyzje skalujące: jeśli przyspieszysz odczyty — albo unikniesz trafiania do bazy dla odczytów — możesz obsłużyć znacznie więcej użytkowników bez przebudowy całej architektury.

Z drugiej strony: nawet aplikacje odczytowe mają kluczowe zapisy. Rejestracje, zakupy, komentarze i zmiany administracyjne nie mogą zostać utracone. W miarę wzrostu ruchu system musi radzić sobie jednocześnie z falą odczytów i zapisy, które muszą się powieść.

Pierwsze ból punktowe, które zespoły odczuwały

Przy większym ruchu problemy stały się widoczne w prostych słowach:

- Wolne zapytania: strona, która ładowała się natychmiast, teraz "zawieszała się", gdy zapytanie typu raportowego skanowało zbyt wiele wierszy.

- Blokady tabel: we wczesnych konfiguracjach zapisy mogły blokować odczyty (i odwrotnie), tworząc korki.

- Ograniczona pamięć RAM: indeksy i gorące dane nie mieściły się w pamięci, więc serwer częściej trafiał na dysk — znacznie wolniej.

Wczesne rozdzielanie obowiązków

Zespoły uczyły się separować odpowiedzialności: aplikacja zajmuje się logiką biznesową, cache absorbuje powtarzające się odczyty, a baza koncentruje się na poprawnym przechowywaniu i niezbędnych zapytaniach. Ten model mentalny przygotował grunt pod późniejsze kroki, takie jak tuning zapytań, lepsze indeksowanie i skalowanie przez repliki.

Silniki przechowywania: duży punkt zwrotny dla niezawodności

Unikalną cechą MySQL jest to, że nie jest to „jeden silnik” pod maską. To serwer bazodanowy, który może korzystać z różnych silników przechowywania.

Czym jest silnik przechowywania

Silnik przechowywania to część, która decyduje jak wiersze są zapisywane na dysku, jak utrzymywane są indeksy, jak działają blokady i co się dzieje po awarii. Twoje SQL może wyglądać identycznie, ale to silnik determinuje, czy baza zachowuje się jak szybki notatnik, czy jak księga bankowa.

MyISAM vs InnoDB (różnice po ludzku)

Przez długi czas wiele instalacji MySQL używało MyISAM. Był prosty i często szybki dla stron nastawionych na odczyty, ale miał kompromisy:

- Blokady: MyISAM stosuje często blokady na poziomie tabeli. Jeden zapis może blokować inne operacje bardziej niż się spodziewasz.

- Awarie: po nieczystym zamknięciu tabele MyISAM mogły wymagać naprawy i tracić ostatnie zmiany.

- Transakcje: MyISAM nie wspiera transakcji, więc nie masz gwarancji "wszystko albo nic" przy wieloetapowych aktualizacjach.

InnoDB odwrócił te założenia:

- Blokady: blokady na poziomie wiersza zmniejszają blokowanie przy wielu użytkownikach aktualizujących różne wiersze.

- Odzyskiwanie po awarii: lepsza trwałość i automatyczne odzyskiwanie.

- Transakcje: pełne wsparcie transakcji, co czyni zachowanie aplikacji bardziej przewidywalnym.

Dlaczego InnoDB stał się domyślny w produkcji

Wraz ze zmianą aplikacji od prostych odczytów do obsługi logowań, koszyków, płatności i wiadomości, poprawność i odzyskiwalność stały się równie ważne jak szybkość. InnoDB umożliwił skalowanie bez strachu, że restart lub skok ruchu skazi dane lub zatrzyma całą tabelę.

Praktyczny wniosek: wybór silnika wpływa na wydajność i bezpieczeństwo. To nie tylko zaznaczenie w konfiguracji — model blokad, zachowanie przy awarii i gwarancje aplikacji zależą od tego wyboru.

Indeksy i projekt zapytań: pierwszy mnożnik skalowania

Zanim pojawiły się shardy, repliki czy skomplikowany caching, wiele wczesnych sukcesów MySQL wynikało z jednej konsekwentnej zmiany: uczynienia zapytań przewidywalnymi. Indeksy i projekt zapytań były pierwszym „mnożnikiem”, ponieważ zmniejszały ilość danych, które MySQL musiał przeczytać dla pojedynczego żądania.

Indeksy B-tree: szybkie wyszukiwania vs skany pełnej tabeli

Większość indeksów MySQL opiera się na drzewach B-tree. Myśl o nich jak o uporządkowanym katalogu: MySQL może skoczyć we właściwe miejsce i odczytać mały, ciągły fragment danych. Bez właściwego indeksu serwer często wraca do skanowania wiersz po wierszu. Przy niskim ruchu to tylko wolniej; przy skali to mnoży obciążenie — więcej CPU, więcej I/O dysku, więcej czasu blokad i wyższe opóźnienia dla wszystkich.

Antywzorce zapytań, które szkodzą przy skali

Kilka wzorców regularnie powodowało „działało w stagingu” awarie:

SELECT *: pobiera niepotrzebne kolumny, zwiększa I/O i może zniweczyć korzyści indeksów pokrywających.- Prowadzące wildcardy:

WHERE name LIKE '%shoe' nie wykorzysta normalnego indeksu B-tree efektywnie.

- Funkcje na indeksowanych kolumnach:

WHERE DATE(created_at) = '2025-01-01' często uniemożliwia użycie indeksu; lepiej stosować filtry zakresowe jak created_at >= ... AND created_at < ....

Uczyń EXPLAIN i slow logs codziennymi narzędziami

Dwa nawyki skalowały lepiej niż jedno sprytne rozwiązanie:

- Uruchamiaj

EXPLAIN, aby zweryfikować, że używasz zamierzonego indeksu i nie skanujesz tabeli.

- Obserwuj slow query log, by łapać regresje w miarę wdrażania funkcji, a nie tygodnie później.

Indeksy powinny odpowiadać realnym funkcjom

Projektuj indeksy wokół zachowań produktu:

- Wyszukiwanie: rozważ full‑text lub strategie prefixowe zamiast wildcardów.

- Feedy: indeksy złożone jak

(user_id, created_at) przyspieszają pobieranie „najnowszych elementów”.

- Checkout: unikalne indeksy na identyfikatorach zamówień/payments zapobiegają duplikatom i przyspieszają wyszukiwania.

Dobre indeksowanie to nie „więcej indeksów”, lecz kilka właściwych, które odpowiadają krytycznym ścieżkom odczytu/zapisu.

Skalowanie pionowe vs poziome: co zmieniają i dlaczego

Generuj API przyjazne raportowaniu

Twórz endpointy, które trzymają ciężkie zapytania z dala od primary i łatwo je dostosowują później.

Gdy produkt z MySQL zaczyna zwalniać, kluczowa decyzja to skalować w górę (pionowo) czy na zewnątrz (poziomo). Rozwiązują różne problemy i zmieniają życie operacyjne w różny sposób.

Skalowanie pionowe: ruch „większe pudło”

Skalowanie pionowe to dodanie MySQL większych zasobów na jednej maszynie: szybsze CPU, więcej RAM, lepszy dysk.

To często działa zadziwiająco dobrze, bo wiele wąskich gardeł jest lokalnych:

- CPU: złożone zapytania, sortowania, joiny mogą wykorzystywać wszystkie rdzenie.

- I/O: wolne dyski i losowe odczyty/zapisy dominują, gdy dane nie mieszczą się w pamięci.

- Buffer pool/pamięć: w InnoDB więcej RAM trzyma gorące dane i indeksy w pamięci, redukując odwołania do dysku.

- Limity połączeń: zbyt wiele równoczesnych połączeń może przeciążyć wątki i pamięć.

Skalowanie pionowe to zwykle najszybsze zwycięstwo: mniej elementów do koordynacji, prostsze tryby awarii i mniej zmian w aplikacji. Minusem jest sufit — zawsze istnieje granica i upgrade’y mogą wymagać przestojów lub ryzykownych migracji.

Skalowanie poziome: „więcej pudeł”, więcej koordynacji

Skalowanie poziome dodaje maszyny. Dla MySQL zwykle oznacza to:

- Dzielenie odczytów na repliki

- Dzielenie zapisów przez podział danych (sharding) lub restrukturyzację workflowów

To trudniejsze, bo wprowadza problemy koordynacyjne: opóźnienia replikacji, zachowanie przy failover, kompromisy dotyczące spójności i więcej narzędzi operacyjnych. Aplikacja musi też wiedzieć, z którym serwerem rozmawiać (albo potrzebny jest warstwa proxy).

Ustalanie oczekiwań: nie skacz od razu do sharding

Większość zespołów nie potrzebuje sharding jako pierwszego kroku. Zacznij od zrozumienia, gdzie spędza się czas (CPU vs I/O vs blokady), napraw wolne zapytania i indeksy oraz dopasuj pamięć i storage. Skalowanie poziome ma sens, gdy jedna maszyna nie jest w stanie obsłużyć twojego tempa zapisów, rozmiaru magazynu lub wymagań dostępności — nawet po solidnym tuningu.

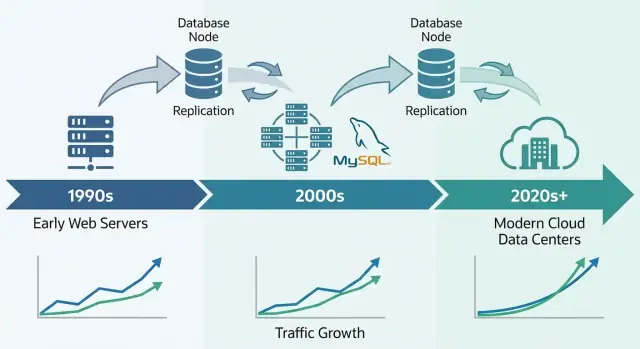

Replikacja i repliki odczytowe: praktyczne skalowanie odczytów

Replikacja to jeden z najbardziej praktycznych sposobów radzenia sobie z wzrostem: zamiast zmuszać jedną bazę do wszystkiego, kopiujesz jej dane na inne serwery i rozkładasz pracę.

Replikacja prosto: primary i repliki

Wyobraź sobie primary (czasami "master") jako bazę akceptującą zmiany — INSERTy, UPDATEy, DELETEy. Jedna lub więcej replik (dawniej "slave") ciągle pobiera te zmiany i je stosuje, utrzymując kopię niemal w czasie rzeczywistym.

Aplikacja może wtedy:

- Wysyłać zapisy do primary

- Wysyłać wiele odczytów do replik

Ten wzorzec stał się popularny, bo ruch webowy zwykle rośnie w kierunku odczytów szybciej niż zapisów.

Do czego używano replik odczytowych

Repliki służyły nie tylko do szybszego serwowania stron. Pomagały też izolować prace, które mogłyby spowolnić główną bazę:

- Skalowanie odczytów: strony produktów, feedy, wyniki wyszukiwania

- Analizy i raportowanie: długie zapytania na replicy zamiast blokowania primary

- Kopie zapasowe: robienie dumpów lub backupów z repliki, by nie obciążać produkcji

Kompromisy, które trzeba zaakceptować

Replikacja nie jest darmowym obiadem. Najczęstszy problem to opóźnienie replikacji — repliki mogą być kilka sekund (lub więcej) za primary w czasie szczytu.

To stawia pytanie na poziomie aplikacji: read‑your‑writes consistency. Jeśli użytkownik zaktualizuje profil i zaraz potem czytasz z repliki, może zobaczyć stare dane. Wiele zespołów rozwiązuje to czytaniem z primary dla „świeżych” widoków lub używając krótkiego okna "czytaj z primary po zapisie".

Replikacja to nie to samo co failover

Replikacja kopiuje dane; nie gwarantuje automatycznie bycia online przy awarii. Failover — promocja repliki, przekierowanie ruchu i zapewnienie, że aplikacja ponownie się połączy bezpiecznie — to oddzielna zdolność wymagająca narzędzi, testów i procedur operacyjnych.

Podstawy wysokiej dostępności: być online mimo awarii

Testuj scenariusze skali wcześnie

Poproś Koder.ai o modelowanie ruchu, wymagań dotyczących spójności i zachowań awaryjnych przed startem.

Wysoka dostępność (HA) to praktyki utrzymujące aplikację działającą, gdy serwer bazy padnie, łącze sieciowe przestanie działać lub trzeba przeprowadzić konserwację. Cele są proste: skrócić przestoje, uczynić konserwację bezpieczną i sprawić, by odzyskiwanie było przewidywalne, a nie improwizowane.

Najpopularniejsze wzorce HA

Wczesne wdrożenia MySQL zwykle zaczynały od jednego primary. HA dodawało zwykle drugą maszynę, aby awaria nie oznaczała długiego przestoju.

- Primary–standby (active–passive): jeden serwer obsługuje ruch; standby czeka gotowy do przejęcia.

- Klastry wielowęzłowe: wiele węzłów współpracuje, aby utrzymać usługę, zwykle z ostrzejszymi regułami zapisu.

- Automatyczny failover: monitoring wykrywa awarię primary i promuje standby, aktualizując cel połączenia aplikacji.

Automatyzacja pomaga, ale podnosi poprzeczkę: zespół musi ufać logice detekcji i zapobiegać „split brain” (dwóm serwerom myślącym, że są primary).

RPO i RTO prostym językiem

Dwa wskaźniki pomagają podejmować decyzje:

- RPO (Recovery Point Objective): ile danych możesz sobie pozwolić stracić. Jeśli replika jest 10 s za primary, twoje RPO to ~10 s.

- RTO (Recovery Time Objective): jak długo możesz być niedostępny. To czas detekcji, promocji i ponownego połączenia aplikacji.

Podstawy operacyjne, które sprawiają, że HA działa

HA to nie tylko topologia — to praktyka.

Kopie zapasowe muszą być rutynowe, ale kluczowe są testy odtwarzania: czy potrafisz odzyskać serwer szybko i pod presją?

Zmiany schematu też mają znaczenie. Duże alteracje tabel mogą blokować zapisy lub spowalniać zapytania. Bezpieczniejsze podejścia to wykonywanie zmian w oknach niskiego ruchu, używanie narzędzi do online schema change i zawsze plan wycofania.

Dobrze przeprowadzona HA zamienia awarie z nagłych wypadków w zaplanowane, przećwiczone zdarzenia.

Strategie cache’owania, które utrzymywały MySQL szybkim pod ruchem webowym

Cache był jednym z najprostszych sposobów, dzięki którym zespoły utrzymywały MySQL responsywnym przy rosnącym ruchu. Idea jest prosta: obsługuj powtarzające się żądania z czegoś szybszego niż baza i trafiaj do MySQL tylko wtedy, gdy naprawdę trzeba. Dobrze zrobione cache zmniejsza obciążenie odczytów dramatycznie i sprawia, że skoki ruchu wyglądają jak łagodne wzrosty, a nie gwałtowne szturmy.

Typowe warstwy cache

Cache aplikacyjny/obiektowy trzyma „kawałki” danych, o które kod często pyta — profile użytkowników, szczegóły produktów, uprawnienia. Zamiast wykonywać to samo SELECT setki razy na minutę, aplikacja pobiera obiekt po kluczu.

Cache stron lub fragmentów przechowuje renderowany HTML (całe strony lub części jak sidebar). To szczególnie efektywne dla serwisów z treścią, gdzie wielu odwiedzających widzi te same strony.

Cache wyników zapytań przechowuje wynik konkretnego zapytania (lub jego uogólnioną wersję). Nawet jeśli nie używasz cache na poziomie SQL, możesz cachować „wynik tego endpointu” za pomocą klucza reprezentującego żądanie.

Technicznie zespoły używały pamięciowych key/value store'ów, cache HTTP lub wbudowanego cache w frameworki. Ważniejsze od narzędzia są spójne klucze, TTL (czas wygaśnięcia) i jasne zasady odpowiedzialności.

Trudna część: unieważnianie cache

Cache wymienia świeżość na szybkość. Niektóre dane mogą być lekko nieaktualne (newsy, liczniki odsłon). Inne nie mogą (sumy w koszyku, uprawnienia). Zazwyczaj wybiera się między:

- Wygaszeniem czasowym (proste, dopuszcza krótką nieświeżość)

- Unieważnianiem zdarzeniowym (dokładniejsze, trudniejsze do poprawnego zaimplementowania)

Jeśli unieważnianie zawiedzie, użytkownicy mogą widzieć nieaktualne treści. Jeśli będzie zbyt agresywne, tracisz korzyści i baza znów zostaje obciążona.

Dlaczego wygładza skoki

Gdy ruch rośnie, cache absorbuje powtarzające się odczyty, a MySQL skupia się na „prawdziwej pracy” (zapisy, cache missy, złożone zapytania). To redukuje kolejki, zapobiega kaskadowym spowolnieniom i daje czas na bezpieczne skalowanie.

Sharding i partycjonowanie: gdy jedna baza to za mało

Nadejdzie moment, gdy „większy sprzęt” i staranne tuningi przestaną wystarczać. Jeśli jedna instancja MySQL nie daje rady z wolumenem zapisów, rozmiarem danych lub oknami konserwacji, zaczynasz myśleć o rozdzieleniu danych.

Partycjonowanie vs sharding (i dlaczego się różnią)

Partycjonowanie dzieli jedną tabelę na mniejsze części w obrębie tej samej instancji MySQL (np. według daty). Ułatwia usuwanie starych danych, archiwizację i niektóre zapytania, ale nie pozwala przekroczyć limitów CPU, RAM i I/O tej jednej maszyny.

Sharding dzieli dane pomiędzy wiele serwerów MySQL. Każdy shard trzyma podzbiór wierszy, a aplikacja (lub warstwa routingu) decyduje, gdzie wysłać żądanie.

Kiedy sharding staje się konieczny

Sharding pojawia się zwykle, gdy:

- Zapisy saturują primary nawet po indeksach, tuningu i cache

- Wzrost storage powoduje, że backupy, restore i zmiany schematu trwają zbyt długo

- "Noisy neighbor" powoduje nieprzewidywalne opóźnienia dla wszystkich

Typowe klucze shardowania

Dobry klucz shardowania równomiernie rozkłada ruch i trzyma większość żądań na jednym shardzie:

- user_id: często dla aplikacji konsumenckich; trzyma dane użytkownika razem

- tenant_id: idealne dla SaaS; silna izolacja między klientami

- geografia: przydatne dla latencji i rezydencji danych, ale może tworzyć hotspoty

Rzeczywiste koszty

Sharding zamienia prostotę na skalę:

- Zapytania między shardami są trudniejsze (często fan‑out + agregacja)

- Transakcje między shardami są ograniczone; wiele zespołów przechodzi na wzorce "eventual consistency"

- Migracje i rebalansowanie są operacyjnie ciężkie (przenoszenie zakresów, aktualizacja routingu)

Podejście etapowe (zanim się zobowiążesz)

Zacznij od cachingu i replik odczytowych, aby zdjąć presję z primary. Następnie izoluj najcięższe tabele/obciążenia (czasem przez podział na funkcje lub serwisy). Dopiero potem przejdź do sharding — najlepiej tak, by móc dodawać shardy stopniowo, zamiast przebudowywać wszystko naraz.

Operacje w skali: monitoring, utrzymanie i incydenty

Wdróż bez dodatkowych narzędzi

Buduj i hostuj aplikację na Koder.ai, a gdy będziesz gotowy dodaj własną domenę.

Prowadzenie MySQL dla ruchomego produktu to mniej kwestia funkcji, a więcej dyscypliny operacyjnej. Większość awarii nie zaczyna się dramatycznym zdarzeniem — zaczyna się od małych sygnałów, których nikt nie powiązał na czas.

Co zespoły rzeczywiście monitorują

Przy skali „wielka czwórka” sygnałów przewiduje problemy najwcześniej:

- Opóźnienie zapytań (p50/p95/p99): rosnące ogony są ważniejsze niż średnie

- Blokady i oczekiwania na blokady: skoki mogą wskazywać gorące wiersze, brak indeksów lub długie transakcje

- Opóźnienie replikacji: lag zamienia skalowanie odczytów w nieświeże odczyty i może pogorszyć failover

- Wzrost zajętości dysku i presja I/O: dysk może się zapełnić, ale to I/O często psuje działanie wcześniej

Dobry dashboard daje kontekst: ruch, wskaźniki błędów, liczba połączeń, hit rate buffer pool i top zapytania. Cel to zauważyć zmianę — nie zapamiętywać "normalne".

Dlaczego wolne zapytania wychodzą tylko pod prawdziwym obciążeniem

Wiele zapytań wygląda dobrze w staging i nawet na produkcji w ciche godziny. Pod obciążeniem baza zachowuje się inaczej: cache przestają pomagać, współbieżne żądania wzmacniają blokady, a lekko nieefektywne zapytanie może wywołać więcej odczytów, większe tabele tymczasowe lub cięższe sortowania.

Dlatego zespoły polegają na slow query log, digestach zapytań i histogramach z produkcji, zamiast na jednorazowych benchmarkach.

Konserwacja bez niespodzianek

Bezpieczne praktyki zmian są nudne celowo: wykonuj migracje w małych partiach, dodawaj indeksy minimalizując blokady, weryfikuj plany zapytań i miej realistyczne rollbacky (czasem rollback to "zatrzymaj rollout i przełącz się na failover"). Zmiany powinny być mierzalne: latency, lock waits i replication lag przed/po.

Podstawy postępowania przy incydencie: diagnoza, łagodzenie, zapobieganie

Podczas incydentu: potwierdź wpływ, zidentyfikuj głównego winowajcę (zapytanie, host, tabela), a potem złagodź skutki — ogranicz ruch, zabij zbędne zapytania, dodaj tymczasowy indeks lub przemieść odczyty/zapisy. Po incydencie zapisz ustalenia, dodaj alerty dla wczesnych sygnałów i zautomatyzuj poprawkę, żeby problem nie wrócił.

Dlaczego MySQL wciąż napędza ogromne systemy

MySQL pozostaje domyślnym wyborem dla wielu nowoczesnych systemów, bo pasuje do codziennych danych aplikacji: dużo małych odczytów i zapisów, wyraźne granice transakcji i przewidywalne zapytania. Dlatego nadal sprawdza się w OLTP‑owych produktach jak SaaS, e‑commerce, marketplace'y i platformy multi‑tenant — szczególnie gdy modelujesz dane wokół rzeczywistych encji biznesowych i trzymasz transakcje krótkimi.

Nowoczesny MySQL wygląda inaczej niż "stary MySQL"

Ekosystem MySQL korzysta dziś z lat wyciągniętych lekcji w postaci lepszych domyślnych ustawień i bezpieczniejszych praktyk operacyjnych. W praktyce zespoły polegają na:

- InnoDB jako standardowym silniku przechowywania z dobrym odzyskiwaniem i transakcjami

- Ulepszonych funkcjach wydajności (lepsze optymalizatory, szybsze opcje replikacji, bardziej przewidywalna współbieżność)

- Obserwowalności łatwiejszej do włączenia: slow query logs, performance_schema, eksportery metryk i dashboardy pokazujące wąskie gardła

- Automatyzacji zmian schematu, backupów i failover — dzięki czemu skalowanie nie zależy od heroicznej pracy ręcznej

Managed MySQL zmniejsza ciężar operacyjny

Wiele firm uruchamia dziś MySQL przez usługi zarządzane, gdzie dostawca robi rutynowe rzeczy: patchowanie, automatyczne backupy, szyfrowanie, odzyskiwanie do punktu w czasie i typowe kroki skalowania (większe instancje, repliki, wzrost storage). Nadal odpowiadasz za schemat, zapytania i wzorce dostępu do danych — ale spędzasz mniej czasu na oknach konserwacji i ćwiczeniach przywracania.

Wprowadzanie tych wzorców do nowoczesnego wdrożenia aplikacji

Jednym z powodów, dla których "playbook skalowania MySQL" nadal ma sens, jest to, że rzadko jest to wyłącznie problem bazy — to problem architektury aplikacji. Wybory takie jak separacja odczytów/zapisów, klucze cache i ich unieważnianie, bezpieczne migracje i plany rollback działają najlepiej, gdy są zaprojektowane razem z produktem, a nie doklejone w trakcie incydentu.

Jeśli budujesz nowe usługi i chcesz zakodować te decyzje od początku, workflow typu vibe‑coding może pomóc. Na przykład Koder.ai potrafi wziąć specyfikację w prostym języku (encje, oczekiwany ruch, wymagania spójności) i wygenerować szkic aplikacji — zwykle React na froncie i usługi w Go — pozostawiając Ci kontrolę nad warstwą danych. Tryb Planning, snapshoty i rollback są przydatne podczas iteracji nad schematami i wdrożeniami bez zamieniania każdej migracji w ryzykowne wydarzenie.

Jeśli chcesz poznać plany Koder.ai (Free, Pro, Business, Enterprise), zobacz cennik.

Wybór MySQL dzisiaj (checklista zaczynająca od wymagań)

Wybierz MySQL, gdy potrzebujesz: silnych transakcji, modelu relacyjnego, dojrzałych narzędzi, przewidywalnej wydajności i szerokiego rynku pracy.

Rozważ alternatywy, gdy potrzebujesz: ogromnego rozproszenia zapisów z elastycznymi schematami (niektóre systemy NoSQL), globalnie spójnych zapisów wieloregionowych (wyspecjalizowane bazy rozproszone) lub obciążeń analitycznych (hurtownie kolumnowe).

Praktyczny wniosek: zacznij od wymagań (latencja, spójność, model danych, tempo wzrostu, umiejętności zespołu), a potem wybierz najprostszy system, który je spełnia — a często nadal będzie to MySQL.