Co oznacza „iteracja” — i gdzie pasuje AI

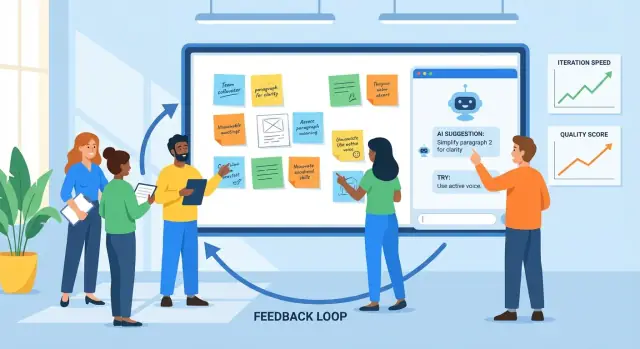

Iteracja to praktyka tworzenia czegoś, zbierania informacji zwrotnej, ulepszania tego i powtarzania cyklu. Widzisz ją w projektowaniu produktu (wypuszczasz funkcję, obserwujesz użycie, poprawiasz), w marketingu (testujesz komunikat, uczysz się, przepisujesz) i w pisaniu (szkic, przegląd, edycja).

Informacja zwrotna to każdy sygnał, który mówi, co działa, a co nie: komentarze użytkowników, zgłoszenia do supportu, raporty błędów, odpowiedzi w ankietach, notatki interesariuszy — nawet własne odczucia po skorzystaniu z produktu. Ulepszenie to to, co zmieniasz w oparciu o te sygnały, od drobnych poprawek po większe przebudowy.

Dlaczego krótsze cykle mają znaczenie

Krótsze cykle feedbacku zwykle prowadzą do lepszych efektów z dwóch powodów:

- Jakość poprawia się szybciej: wychwytujesz nieporozumienia i defekty wcześnie, zanim rozprzestrzenią się po kolejnych stronach, ekranach czy wydaniach.

- Szybkość rośnie bez zgadywania: spędzasz mniej czasu na dyskusjach w abstrakcie, a więcej na uczeniu się z realnych dowodów.

Dobry rytm iteracji to nie „działaj szybko i łam rzeczy”. To „rób małe kroki i ucz się szybko”.

Gdzie AI pomaga (a gdzie nie)

AI jest użyteczne w pętli, gdy jest dużo informacji i trzeba je przetworzyć. Może:

- podsumowywać feedback z wielu źródeł w tematy

- wyłapywać powtarzające się skargi, mylące sformułowania lub brakujące detale

- proponować alternatywne wersje (tekst, układy, sformułowania zadań) do rozważenia

- działać jako druga para oczu pod kątem klarowności, tonu i spójności

Ale AI nie zastąpi kluczowych decyzji. Nie zna twoich celów biznesowych, ograniczeń prawnych ani tego, co dla twoich użytkowników oznacza „dobrze”, chyba że to zdefiniujesz. Może pewnie sugerować zmiany, które są niezgodne z marką, ryzykowne lub oparte na błędnych założeniach.

Ustalaj oczekiwania jasno: AI wspiera ocenę. To twój zespół decyduje, co priorytetować, co zmieniać, czym jest sukces — i weryfikuje poprawki z prawdziwymi użytkownikami i twardymi danymi.

Podstawowa pętla feedbacku: praktyczny model

Iteracja jest łatwiejsza, gdy wszyscy stosują ten sam cykl i wiedzą, co oznacza „zrobione”. Praktyczny model to:

draft → feedback → revise → check → ship

Zespoły często utkną, bo jeden krok jest wolny (przeglądy), nieuporządkowany (feedback rozrzucony po narzędziach) albo niejednoznaczny (co dokładnie trzeba zmienić?). Jeśli używać AI celowo, można zredukować tarcie na każdym etapie.

Krok 1: Draft (dotrzyj do wersji nadającej się do przeglądu)

Celem nie jest perfekcja, tylko solidna pierwsza wersja, na którą inni mogą zareagować. Asystent AI może pomóc w przygotowaniu konspektu, wygenerowaniu alternatyw albo wypełnieniu braków, żeby szybciej osiągnąć „do przeglądu”.

Gdzie pomaga najbardziej: przekształcanie luźnego briefu w uporządkowany szkic oraz przygotowanie kilku opcji (np. trzy nagłówki, dwa przepływy onboardingu) do porównania.

Krok 2: Feedback (zbierz i skondensuj)

Feedback zwykle przychodzi w formie długich komentarzy, wątków czatu, notatek z rozmów i zgłoszeń do supportu. AI przydaje się do:

- podsumowywania powtarzających się motywów (co ludzie ciągle wspominają)

- grupowania feedbacku według tematów (cennik, onboarding, ton, błędy)

- wyodrębniania pytań i elementów „koniecznych do naprawy” vs. „mile widzianych”

Wąskie gardło, które usuwasz: wolne czytanie i niekonsekwentna interpretacja tego, co recenzenci mieli na myśli.

Krok 3: Revise (zamień reakcje w zmiany)

Tutaj zespoły tracą czas na przeróbki: niejasny feedback prowadzi do edycji, które nie zadowalają recenzenta, i pętla się powtarza. AI może zaproponować konkretne poprawki, przedstawić zmienioną kopię albo wygenerować drugą wersję, która wprost adresuje najważniejsze tematy z feedbacku.

Krok 4: Check (jakość przed wypuszczeniem)

Przed wydaniem użyj AI jako drugiej pary oczu: czy nowa wersja wprowadza sprzeczności, brakujące kroki, złamane wymagania lub dryf tonu? Celem nie jest „zatwierdzenie” pracy przez AI, lecz wychwycenie oczywistych problemów wcześnie.

Krok 5: Ship z jednym źródłem prawdy

Iteracja przyspiesza, gdy zmiany żyją w jednym miejscu: ticket, dokument lub opis PR, który zapisuje (1) podsumowanie feedbacku, (2) decyzje i (3) co się zmieniło.

AI może pomagać utrzymywać to „jedno źródło prawdy” przez tworzenie notatek z aktualizacji i dopasowywanie kryteriów akceptacji do najnowszych decyzji. W zespołach, które budują i wdrażają oprogramowanie bezpośrednio (nie tylko dokumenty), platformy takie jak Koder.ai mogą dodatkowo skrócić ten etap, łącząc planowanie, implementację i deployment — dzięki czemu narracja „co się zmieniło” pozostaje blisko faktycznego wydania.

Zbieranie feedbacku: co AI potrafi dobrze przetworzyć

AI poprawi tylko to, co jej podasz. Dobra wiadomość: większość zespołów już ma dużo feedbacku — po prostu rozrzuconego po różnych miejscach i zapisane w różnych stylach. Twoim zadaniem jest zbierać go konsekwentnie, aby AI mogło go podsumować, znaleźć wzorce i pomóc zdecydować, co zmienić dalej.

Wejścia feedbacku, które działają szczególnie dobrze

AI jest najsilniejsze przy chaotycznych, tekstowo-gęstych wejściach, w tym:

- komentarze użytkowników (w aplikacji, na forach, w czacie)

- zgłoszenia do supportu i transkrypty czatu

- odpowiedzi otwarte w ankietach

- recenzje w sklepach i marketplace'ach

- notatki ze spotkań sprzedażowych/CS

- raporty błędów i prośby o funkcje od zespołów wewnętrznych

Nie potrzebujesz perfekcyjnego formatowania. Ważne jest uchwycenie oryginalnych słów i niewielkiej ilości metadanych (data, obszar produktu, plan itp.).

Od „stosu cytatów” do tematów i punktów bólu

Po zebraniu AI może pogrupować feedback w tematy — zamieszanie z fakturowaniem, tarcie w onboardingu, brakujące integracje, wolne działanie — i pokazać, co pojawia się najczęściej. To ważne, bo najgłośniejszy komentarz nie zawsze oznacza najczęstszy problem.

Praktyczne podejście: poproś AI o:

- listę tematów z krótkimi etykietami

- reprezentatywne cytaty dla każdego tematu (żebyś mógł to sprawdzić)

- sygnały częstotliwości (np. „wspomniane w 18 ticketach w tym tygodniu”)

- wskazówki o wpływie (kogo to dotyczy i co blokuje)

Zachowanie kontekstu, żeby insighty były przydatne

Feedback bez kontekstu może prowadzić do ogólnych wniosków. Dołącz lekkie kontekstowe pola przy każdym elemencie, takie jak:

- persona lub typ klienta (nowy użytkownik, administrator, power user)

- cel użytkownika („eksportować raport”, „zaprosić współpracowników”)

- ograniczenia (urządzenie, region, plan, wymagania zgodności)

Nawet kilka spójnych pól sprawia, że grupowanie i podsumowania AI są znacznie bardziej użyteczne.

Prywatność i podstawy przetwarzania danych

Przed analizą usuń dane wrażliwe: imiona, e-maile, numery telefonów, adresy, dane płatnicze i wszystko poufne z notatek z rozmów. Preferuj minimalizację danych — udostępniaj tylko to, co jest potrzebne do zadania — i przechowuj eksporty surowe bezpiecznie. Jeśli korzystasz z narzędzi stron trzecich, potwierdź zasady zespołu dotyczące przechowywania i trenowania oraz ogranicz dostęp do zbioru danych.

Przekształcanie surowego feedbacku w jasne, wykonalne insighty

Surowy feedback to zwykle kupa niepasujących do siebie wejść: bilety supportu, recenzje, odpowiedzi w ankietach, notatki sprzedażowe i wątki Slack. AI przydaje się, bo potrafi przeczytać „chaotyczny” język na dużą skalę i pomóc przerobić go na krótką listę tematów, nad którymi rzeczywiście można pracować.

1) Od porozrzucanych komentarzy do kategorii

Zacznij od podania AI partii feedbacku (po usunięciu danych wrażliwych) i poproś o pogrupowanie elementów w spójne kategorie, takie jak onboarding, wydajność, cennik, zamieszanie w UI, błędy i prośby o funkcje. Celem nie jest perfekcyjna taksonomia — to wspólna mapa, której zespół może używać.

Praktyczny output może wyglądać tak:

- Kategoria: Zamieszanie przy onboardingu

- Co użytkownicy próbują zrobić: Połączyć konto, zaimportować dane

- Zaobserwowane blokady: „Nie mogłem znaleźć przycisku importu”, „Nie wiedziałem, czy się wykonało”

2) Dodaj priorytety prostym rubrykiem

Gdy feedback jest pogrupowany, poproś AI o propozycję oceny priorytetu według rubryki, którą możesz przeglądnąć:

- Wpływ: Jak bardzo to wpływa na sukces użytkownika lub przychody?

- Częstotliwość: Jak często pojawia się w źródłach?

- Wysiłek: Jak trudna jest naprawa (czas, zależności)?

- Ryzyko: Jakie jest prawdopodobieństwo złamania czegoś lub problemów z zgodnością/wsparciem?

Możesz to trzymać lekkie (Wysoki/Średni/Niski) lub numerować (1–5). Kluczowe jest to, że AI robi pierwszy szkic, a ludzie potwierdzają założenia.

3) Podsumuj bez tracenia niuansów (trzymaj dowody)

Podsumowania stają się niebezpieczne, gdy wymazują „dlaczego”. Użyteczny wzór to: podsumowanie tematu + 2–4 reprezentatywne cytaty. Na przykład:

„Połączyłem Stripe, ale nic się nie zmieniło — czy zsynchronizowało się?”

„Kreator konfiguracji pominął krok i nie wiedziałem, co dalej robić.”

Cytaty zachowują ton emocjonalny i kontekst — i zapobiegają traktowaniu wszystkich problemów jako identycznych.

4) Uważaj na uprzedzenia: głośne nie zawsze znaczy powszechne

AI może przecenić dramatyczny język lub powtarzających się komentujących, jeśli tego nie nakierujesz. Poproś, żeby oddzieliło:

- Sygnały oparte na wolumenie (ile unikalnych użytkowników to wspomina)

- Sygnały oparte na ciężkości (jak poważny jest problem, gdy występuje)

Potem sprawdź to z danymi użycia i segmentacją. Skarga od power userów może być bardzo ważna — albo dotyczyć niszowego workflow. AI pokaże wzorce, ale nie zdecyduje, co „reprezentuje twoich użytkowników” bez twojego kontekstu.

Używanie AI do generowania wersji, nie tylko „odpowiedzi”

Miej kontrolę nad rezultatem

Utrzymaj tempo bez uzależnienia — eksportuj kod źródłowy, kiedy będziesz gotów.

Dobry sposób myślenia o narzędziu AI to generator wersji. Zamiast prosić o jedną „najlepszą” odpowiedź, poproś o kilka wiarygodnych szkiców, które możesz porównać, połączyć i dopracować. To podejście daje kontrolę i przyspiesza iterację.

To jest szczególnie przydatne przy iterowaniu nad interfejsami produktu (przepływy onboardingu, teksty w UI, sformułowania speców). Na przykład, jeśli budujesz narzędzie wewnętrzne lub prostą aplikację klienta w Koder.ai, możesz użyć tego samego podejścia „wygeneruj wiele wersji” do eksplorowania różnych ekranów, przepływów i wymagań w trybie planowania, zanim się zobowiążesz — a potem polegać na migawkach i rollbackie, aby utrzymać szybkość bez ryzyka.

Daj ograniczenia, żeby warianty były porównywalne

Jeśli poprosisz „napisz to dla mnie”, często dostaniesz ogólnik. Lepiej: zdefiniuj ramy, żeby AI mogło eksplorować opcje w ich obrębie.

Wypróbuj określenie:

- Odbiorca + cel: „Nowi użytkownicy decydujący, czy się zapisać” vs. „Istniejący klienci potrzebujący uspokojenia”.

- Ton: przyjazny, bezpośredni, formalny, lekko żartobliwy (wybierz jeden).

- Długość: np. „120–150 słów” lub „maksymalnie 3 punty”.

- Format: e-mail, hero na stronie, FAQ, notka wydawnicza.

- Fakty do zachowania: ceny, daty, gwarancje, ograniczenia produktu.

- Czego unikać: zabronione twierdzenia, wrażliwe sformułowania, wzmianki o konkurencji.

Z ograniczeniami możesz generować „Wersja A: zwięzła”, „Wersja B: bardziej empatyczna”, „Wersja C: bardziej konkretna”, bez utraty trafności.

Generuj wiele opcji, potem wybierz (lub połącz)

Poproś o 3–5 alternatyw na raz i sprecyzuj różnice: „Każda wersja powinna mieć inną strukturę i linię otwierającą.” To tworzy realny kontrast, który pomaga zauważyć, czego brakuje i co rezonuje.

Praktyczny workflow:

- Wygeneruj 3–5 wersji.

- Wybierz najsilniejsze części (otwarcie z A, dowody z C, CTA z B).

- Poproś AI, żeby połączyło je w jeden szkic, zachowując niezmienione fakty, które muszą pozostać.

Szybka lista kontrolna: co powinien zawierać „dobry szkic”

Zanim wyślesz szkic do przeglądu lub testowania, upewnij się, że zawiera:

- jasny cel (co czytelnik ma zrobić/zrozumieć)

- kluczowe fakty zachowane i spójne

- konkretny, wiarygodny powód, żeby się zainteresować (korzyść + dowód)

- jedno główne wezwanie do działania

- prosty język, minimalny żargon

- brak niepodpartych obietnic lub mglistych superlatyw

Użyte w ten sposób AI nie zastępuje oceny — przyspiesza poszukiwanie lepszej wersji.

AI jako recenzent: wykrywaj problemy wcześnie

Przed wypuszczeniem szkicu — specu produktu, notki wydawniczej, artykułu pomocy czy strony marketingowej — narzędzie AI może być szybką „pierwszą recenzją”. Celem nie jest zastąpienie ludzkiej oceny; chodzi o wykrycie oczywistych problemów, żeby zespół skupiał się na trudnych decyzjach, a nie na podstawowym sprzątaniu.

Co AI robi dobrze przy recenzji

Recenzje wspomagane AI są szczególnie przydatne do:

- Jasności: wykrywanie długich zdań, niejasnych terminów albo brakującego kontekstu dla nowego czytelnika.

- Spójności: sprawdzanie nazewnictwa (etykiety funkcji, wielka litera), powtórzeń twierdzeń i sprzeczności między sekcjami.

- Tonu: dostosowanie głosu do odbiorcy (przyjazny, bezpośredni, formalny) i wskazanie sformułowań, które mogą brzmieć defensywnie lub mgliście.

- Kompletności: wskazywanie brakujących kroków, przypadków brzegowych, prerekwizytów czy „co dalej”.

Praktyczne polecenia do recenzji, które możesz powtórzyć

Wklej szkic i poproś o konkretny rodzaj krytyki. Na przykład:

- „Przejrzyj pod kątem luk: jakie pytania nadal miałby użytkownik po pierwszym kontakcie?”

- „Wykryj założenia: co zakładam o produkcie, użytkowniku lub workflow?”

- „Uprość: przeredaguj każde zdanie powyżej 25 słów, zachowując sens.”

- „Sprawdź niespójności: wypisz terminy używane w różnych znaczeniach.”

Krytyka z perspektywy ról, żeby poszerzyć feedback

Szybki sposób na rozszerzenie perspektywy to poprosić model o recenzję z punktu widzenia różnych ról:

- „Jako klient, co wydaje się mylące lub ryzykowne?”

- „Jako support, jakie tickety to wygeneruje?”

- „Jako PM, jakich kryteriów akceptacji brakuje?”

- „Jako dział prawny/zgodności, jakie obietnice trzeba doprecyzować?”

Kontrola bezpieczeństwa: zweryfikuj fakty

AI może pewnie skrytykować sformułowanie, a jednocześnie się mylić w szczegółach produktu. Traktuj elementy faktograficzne — ceny, dostępność funkcji, zabezpieczenia, terminy — jako wymagające weryfikacji. Zwyczaj dodawania źródeł (linków do dokumentów, ticketów, decyzji) pomaga, żeby ostateczna wersja odzwierciedlała rzeczywistość, a nie sensowną zgadywankę.

Przekształcanie feedbacku w edycje, zadania i kryteria akceptacji

Surowy feedback rzadko nadaje się od razu do wdrożenia. Jest zwykle emocjonalny („to nie pasuje”), mieszany („lubię to, ale…”) albo niedoprecyzowany („zrób to czytelniejsze”). AI może pomóc przetłumaczyć to na zadania, które zespół faktycznie wykona — przy zachowaniu oryginalnego komentarza, żeby potem uzasadnić decyzje.

Prosty szablon, który AI może wypełnić

Poproś narzędzie AI o przepisanie każdego fragmentu feedbacku według struktury:

Problem → Dowód → Proponowana zmiana → Metrika sukcesu

- Problem: Co nie działa?

- Dowód: Co użytkownik powiedział/zrobił? Dołącz cytat, odniesienie do zrzutu ekranu lub znacznik rozmowy.

- Proponowana zmiana: Co zmienisz (po jednym wniosku na element).

- Metrika sukcesu: Jak stwierdzisz, że to się poprawiło (jakościowo lub ilościowo).

To wymusza jasność bez „wynajdywania” nowych wymagań.

Zmienianie niejasnych notatek w zakres prac

Przykładowy feedback:

„Strona checkoutu jest myląca i zajmuje za dużo czasu.”

Wersja AI (edytowana przez ciebie):

- Problem: Użytkownicy nie rozumieją kolejnych kroków i porzucają proces checkoutu.

- Dowód: 6 z 20 ankietowanych pytało „co jest dalej?”; analityka pokazuje 38% spadek między Shipping → Payment (10–20 grudnia).

- Proponowana zmiana: Dodaj wskaźnik postępu w 3 krokach i zmień etykietę głównego przycisku z „Continue” na „Przejdź do płatności”.

- Metrika sukcesu: Zmniejszyć spadek między Shipping → Payment z 38% do ≤30% w ciągu 2 tygodni.

Następnie przerabiasz to na zadanie z granicami:

Zadanie: Dodać wskaźnik postępu + zaktualizować etykietę przycisku na checkout.

Poza zakresem: Zmiana dostawców płatności, przebudowa całego layoutu checkoutu, przepisanie całej treści produktu.

Kryteria akceptacji (zrób je testowalnymi)

Użyj AI do szkicowania kryteriów akceptacji, potem je doprecyzuj:

- Wskaźnik postępu pojawia się na mobilce i desktopie.

- Kroki odzwierciedlają aktualny stan (Shipping, Payment, Review).

- Etykieta przycisku zaktualizowana na ekranach Shipping i Payment.

- Brak zmian w cenach, podatkach ani procesie płatności.

Trzymaj feedback śledzalny

Zawsze zapisuj:

- oryginalny feedback (cytat/link/ticket)

- zadanie przekształcone przez AI

- ostateczną decyzję i jej uzasadnienie

Taka śledzalność chroni odpowiedzialność, zapobiega „AI tak powiedziało” i przyspiesza przyszłe iteracje, bo widać, co się zmieniło i dlaczego.

Testowanie usprawnień: eksperymenty, które AI może przyspieszyć

Ułatw rollback

Zachowaj stabilną wersję przed większymi zmianami, żeby łatwo porównywać i szybko przywracać.

Iteracja staje się realna, gdy przetestujesz zmianę względem mierzalnego wyniku. AI może pomóc zaprojektować małe, szybkie eksperymenty — bez zamieniania każdej poprawki w tygodniowy projekt.

Praktyczny szablon to:

- Hipoteza: Jeśli zmienimy X, to Y się poprawi, ponieważ Z.

- Warianty: Wersja A (aktualna) vs. Wersja B (jedna zamierzona zmiana).

- Metrika sukcesu: Jedna liczba, po której zdecydujesz (open rate, activation rate, współczynnik konwersji, czas do pierwszej wartości).

- Odbiorcy + czas trwania: Kto zobaczy i jak długo.

Możesz poprosić AI o 3–5 kandydackich hipotez opartych na tematach z feedbacku (np. „użytkownicy mówią, że konfiguracja jest myląca”), a ono przeredaguje je w testowalne stwierdzenia z jasnymi metrykami.

Szybkie przykłady, które AI może wygenerować (i które możesz testować)

Tematy e-maili (metryka: open rate):

- A: „Twój cotygodniowy raport jest gotowy”

- B: „3 wnioski z twojego tygodnia (2 minuty czytania)”

Wiadomość onboardingu (metryka: completion rate kroku 1):

- A: „Witaj! Skonfiguruj konto.”

- B: „Witaj — dodaj pierwszy projekt i zobacz wyniki w 5 minut.”

Mikrokopia przycisku (metryka: CTR):

- A: „Wyślij”

- B: „Zapisz i kontynuuj”

AI jest przydatne, bo szybko generuje wiele realistycznych wariantów — różnych tonów, długości i propozycji wartości — dzięki czemu możesz wybrać jedną klarowną zmianę do testowania.

Zasady: spraw, żeby test był czytelny

Szybkość jest super, ale eksperymenty muszą być interpretable:

- Zmiana jednej zmiennej na raz, jeśli możliwe. Jeśli przepisałeś nagłówek i przycisk i layout, nie dowiesz się, co zadziałało.

- Miej kontrolę. Zawsze zachowaj Wersję A.

- Zdefiniuj metrykę przed sprawdzeniem wyników. Inaczej łatwo „znaleźć” zwycięstwo przypadkiem.

Mierz wyniki, nie wrażenia

AI może powiedzieć, co „brzmi lepiej”, ale to użytkownicy decydują. Użyj AI do:

- sugerowania progów sukcesu (np. „wdrążymy B, jeśli CTR wzrośnie o 5%+”)

- tworzenia szablonu podsumowania wyników

- przełożenia wniosków na kolejną hipotezę

Dzięki temu każdy test uczy — nawet gdy nowa wersja przegrywa.

Mierzenie wyników i uczenie się z każdego cyklu

Iteracja działa tylko wtedy, gdy potrafisz stwierdzić, czy ostatnia zmiana naprawdę pomogła. AI może przyspieszyć etap „pomiar → nauka”, ale nie zastąpi dyscypliny: jasnych metryk, czystych porównań i zapisanych decyzji.

Wybieraj metryki zgodne z celem

Wybierz mały zestaw liczb, które będziesz sprawdzać w każdym cyklu, pogrupowanych według celu:

- Konwersja: rejestracje, start triala, zakończenie checkoutu, CTR kluczowego CTA

- Retencja: powrót 7/30 dni, churn, powtarzalne zakupy, ponowne użycie funkcji

- Czas do wykonania: czas onboardingowy, time-to-first-value, czas rozwiązania w support

- Wskaźnik błędów / jakość: nieudane zgłoszenia, raporty błędów, zwroty, liczba defektów QA

- Satysfakcja: CSAT, NPS, oceny aplikacji, sentyment w zgłoszeniach supportu

Klucz to konsekwencja: jeśli zmieniasz definicje metryk co sprint, liczby niczego cię nie nauczą.

Pozwól AI podsumować wyniki — i wskazać, gdzie coś się zmieniło

Gdy masz wyniki eksperymentu, dashboardy lub wyeksportowane CSV, AI przydaje się do przekształcenia ich w narrację:

- podsumowanie, co się poruszyło (a co nie) w prostym języku

- wyróżnienie istotnych segmentów: nowi vs. powracający, typ urządzenia, źródło ruchu, region, plan, power users vs. casual

- wskazanie zaskakujących korelacji, które warto głębiej zbadać (np. konwersja wzrosła globalnie, ale spadła na mobilnym Safari)

Praktyczne polecenie: wklej tabelę wyników i poproś asystenta o (1) akapit podsumowujący, (2) największe różnice między segmentami, (3) pytania follow-up do walidacji.

Unikaj fałszywej pewności

AI może sprawić, że wyniki zabrzmią definitywnie, nawet gdy tak nie jest. Nadal musisz sprawdzać:

- Wielkość próby: Małe próbki często pokazują szum.

- Sezonowość i wydarzenia zewnętrzne: Święta, promocje, awarie, wzmianki w mediach.

- Wiele jednoczesnych zmian: Jeśli zmieniły się trzy rzeczy, nie wiadomo, która zadziałała.

Prowadź lekki dziennik nauki

Po każdym cyklu zapisz krótką notatkę:

- Co się zmieniło (link do ticketu lub dokumentu)

- Co się stało (metryki + istotne segmenty)

- Co przypuszczamy, że to znaczy (najlepsze wyjaśnienie)

- Co spróbujemy dalej (jedno konkretne follow-up)

AI może sporządzić szkic wpisu, ale to zespół zatwierdza wnioski. Z czasem ten dziennik staje się pamięcią organizacji — przestajesz powtarzać te same eksperymenty i zaczynasz mnożyć zwycięstwa.

Uczynienie procesu powtarzalnym: workflowy, które skalują

Testuj z realnymi użytkownikami

Wystaw iterację przed prawdziwymi użytkownikami dzięki hostingowi i niestandardowym domenom.

Szybkość jest miła, ale to konsekwencja sprawia, że iteracja się kumuluje. Celem jest przekształcenie „powinniśmy to poprawić” w rutynę, którą zespół może uruchomić bez bohaterstwa.

Lekkość w workflowach, które działają

Skalowalna pętla nie potrzebuje ciężkiego procesu. Kilka małych zasad bije skomplikowany system:

- Cotygodniowy przegląd (30–60 min): Wybierz 1–3 rzeczy do poprawy, przejrzyj zmiany z ostatniego tygodnia i zdecyduj, co testować dalej. Przynieś podsumowania przygotowane przez AI (tematy, top skargi, pojawiające się ryzyka), żeby spotkanie było konkretne.

- Change log: Prowadź notatkę, co się zmieniło, dlaczego i czego oczekujesz. Prosty dokument wystarczy; ważna jest konsekwencja.

- Decision notes: Dla istotnych zmian zapisz decyzję w pięciu liniach: kontekst, rozważane opcje, decyzja, właściciel, data. AI może to zredagować z notatek ze spotkania, ale wy potwierdzacie treść.

Szablony promptów + wielokrotnego użytku checklisty

Traktuj prompty jak zasoby. Przechowuj je we wspólnym folderze i wersjonuj jak inne materiały.

Utrzymuj małą bibliotekę:

- Szablony promptów do powtarzalnych zadań (podsumuj feedback, zaproponuj warianty, przeredaguj dla tonu, wygeneruj kryteria akceptacji).

- Checklisty jakości (jasność, kompletność, zgodność, głos marki, dostępność). Poproś AI o uruchomienie checklisty i wskazanie luk, potem człowiek weryfikuje.

Prosta konwencja pomaga: „Zadanie + Odbiorca + Ograniczenia” (np. „Notka wydawnicza — nietechniczna — 120 słów — dołączenie ryzyk”).

Dodaj krok zatwierdzający dla wrażliwych treści

Dla wszystkiego, co wpływa na zaufanie lub odpowiedzialność — ceny, zapisy prawne, porady medyczne/finansowe — użyj AI do szkiców i oznacz ryzyka, ale wymagaj imiennego zatwierdzenia przed publikacją. Uczyń ten krok widocznym, żeby nie został pominięty pod presją czasu.

Nazewnictwo wersji, które zapobiega chaosowi

Szybkie iteracje tworzą bałagan plików, jeśli nie etykietujesz. Użyj przewidywalnego wzoru:

FeatureOrDoc_Scope_V#_YYYY-MM-DD_Owner

Przykład: OnboardingEmail_NewTrial_V3_2025-12-26_JP.

Kiedy AI generuje opcje, trzymaj je pod tą samą wersją (V3A, V3B), żeby każdy wiedział, co porównywano i co rzeczywiście wypuszczono.

Typowe pułapki, kontrole bezpieczeństwa i odpowiedzialne użycie

AI może przyspieszyć iterację, ale też szybko przyspieszyć błędy. Traktuj je jak potężnego współpracownika: pomocnego, szybkiego, ale czasem pewnego siebie i błędnego.

Typowe błędy (i jak ich unikać)

Nadmierne zaufanie do AI. Modele potrafią generować przekonujące teksty, podsumowania czy „insighty”, które nie odpowiadają realiom. Wypracuj zwyczaj weryfikacji wszystkiego, co może wpływać na klientów, budżet lub decyzje.

Niejednoznaczne prompty dają niejasne rezultaty. Jeśli wejście to „ulepsz to”, dostaniesz ogólnik. Sprecyzuj odbiorcę, cel, ograniczenia i co oznacza „lepiej” (krótsze, jaśniejsze, on‑brand, mniej ticketów, większa konwersja).

Brak metryk, brak nauki. Iteracja bez mierzenia to tylko zmiana. Zdecyduj z góry, co będziesz śledzić (activation, time-to-first-value, churn, tematy NPS, wskaźnik błędów) i porównuj przed/po.

Obsługa danych: chroń użytkowników i firmę

Nie wklejaj danych osobowych, klientów ani poufnych informacji do narzędzi, chyba że organizacja jasno to zatwierdziła i znasz polityki retencji/trenowania.

Praktyczna zasada: udostępniaj minimum potrzebne.

- Usuń imiona, e-maile, numery telefonów, adresy, identyfikatory zamówień i notatki z danymi wrażliwymi.

- Najpierw podsumuj wewnętrznie, a potem poproś model o pracę na podstawie podsumowania.

- Jeśli potrzebujesz analizować prawdziwy feedback, zanonimizuj go najpierw i przechowuj oryginał w zatwierdzonym systemie.

Halucynacje: weryfikuj fakty i źródła

AI może wymyślać liczby, cytaty, szczegóły funkcji czy źródła. Gdy dokładność ma znaczenie:

- Poproś o założenia i niepewności („Czego nie jesteś pewien?”).

- Żądaj linków do źródeł pierwotnych tylko wtedy, gdy możesz je samodzielnie zweryfikować.

- Sprawdzaj przeciw dokumentom, analytics, changelogowi lub systemowi supportu.

„Przed wypuszczeniem” — lista kontrolna

Przed opublikowaniem zmiany wspomaganej AI zrób krótki przegląd:

- Cel i metryka zdefiniowane (jak wygląda sukces).

- PII/konfiden-cjalne dane usunięte z promptów i logów.

- Fakty zweryfikowane (twierdzenia, liczby, polityki, cytaty).

- Przypadki brzegowe przejrzane (dostępność, ton, uwagi prawne/zgodności).

- Zatwierdzenie ludzkie od odpowiedniego właściciela (PM, support, prawo, marka).

- Plan rollbacku na wypadek, gdy zmiana działa gorzej.

Stosowane w ten sposób AI pozostaje mnożnikiem dobrego osądu — nie jego zamiennikiem.