Co naprawdę oznacza „najlepszy język backendu"

„Najlepszy język backendu" to zazwyczaj skrót myślowy od „najlepiej dopasowany do tego, co buduję, z ludźmi i ograniczeniami, które mam”. Język może być idealny dla jednego typu obciążenia backendu, a zupełnie niepasujący do innego — nawet jeśli jest popularny, szybki czy lubiany przez zespół.

Zacznij od zdefiniowania rzeczywistego celu

Zanim porównasz backend Node.js z backendem Python czy backendem Java (i tak dalej), nazwij zadanie, które ma wykonywać twój backend:

- API dla mobilnych/web: przewidywalne opóźnienia, przejrzyste wzorce tworzenia API, dobra obserwowalność

- Aplikacje webowe: szybkie iteracje, templating, zadania backgroundowe, integracje

- Mikroserwisy: spójność operacyjna, narzędzia do wdrożeń, silne kontrakty między usługami

- Usługi przetwarzające dużo danych: batchowanie, streaming, zachowanie pamięci, integracje z bazami i kolejkami

- Systemy czasu rzeczywistego: model współbieżności, backpressure, WebSockets, architektura zdarzeniowa

Różne cele przesuwają wagę kryteriów między wydajnością a produktywnością. Język, który przyspiesza dostarczanie funkcji dla API CRUD, może spowolnić pracę przy systemach wysokoprzepustowych lub o niskich opóźnieniach.

Wyjaśnij ograniczenia, które przewyższają „techniczne najlepsze”

Wybór języka backendu często zależy bardziej od ograniczeń niż od cech technicznych:

- Harmonogram: Czy możesz wdrożyć w tygodniach, czy to wieloletnia platforma?

- Umiejętności zespołu: Czy macie dziś kompetencje do backendu w Go/.NET, czy to będzie projekt szkoleniowy?

- Hosting i ops: Container-first? Serverless? Środowiska tylko Windows? Ograniczenia kosztowe?

- Zgodność i bezpieczeństwo: potrzeby audytowe, polityki zależności, tempo łatek

- Istniejący kod: biblioteki do ponownego użycia, współdzielone modele, monorepo, punkty integracji

Ustal właściwe oczekiwania

Nie ma jednego najlepszego języka backendu w 2026 roku — są tylko kompromisy. Ruby on Rails może wygrywać szybkością budowy produktu, Go prostotą operacyjną, Java dojrzałym ekosystemem i narzędziami dla przedsiębiorstw, a Node.js dopasowaniem do pełnego stosu JavaScript i obsługą realtime.

Po przeczytaniu tego przewodnika powinieneś umieć wybrać język z pewnością, dopasowując go do obciążenia, ograniczeń i długoterminowego utrzymania — nie na podstawie hype’u czy rankingów.

Główne kryteria do użycia przed porównaniem języków

Wybór języka backendu mniej polega na „co jest najlepsze”, a bardziej na tym, co optymalizuje twoje konkretne rezultaty. Zanim porównasz backend Node.js z backendem Python, lub backend Java z backendem Go, jawnie określ kryteria — inaczej będziesz debatować o preferencjach zamiast podjąć decyzję.

Praktyczny zestaw kryteriów decyzyjnych

Zacznij od krótkiej listy, którą da się naprawdę ocenić:

- Time-to-market: jak szybko zespół może wypuścić stabilne API, iterować i poprawiać błędy.

- Wydajność w runtime: opóźnienia i przepustowość przy przewidywanym obciążeniu — nie mikrobenchmarki.

- Model współbieżności: jak język radzi sobie z wieloma jednoczesnymi żądaniami, zadaniami backgroundowymi, streamingiem i I/O.

- Stabilność i dojrzałość: częstotliwość wydań, kompatybilność wsteczna i to, jak często „małe aktualizacje” stają się dużymi projektami.

Dodaj wymagania specyficzne dla domeny (np. funkcje realtime, intensywne przetwarzanie danych czy surowe wymagania zgodności) jako dodatkowe kryteria.

Całkowity koszt posiadania (TCO) przewyższa „szybkość dewelopera” samą w sobie

TCO to połączony koszt budowy i utrzymania systemu:

- Szybkość rozwoju: scaffolding, frameworki i ile boilerplate’u trzeba utrzymać.

- Operacje: obserwowalność, złożoność wdrożeń, ślad runtime, obciążenie on-call.

- Zatrudnianie i wdrożenie: dostępność talentów dla .NET, Go, Ruby on Rails itp.

- Utrzymanie: czytelność, testowalność, mechanizmy bezpieczeństwa i koszty refaktorów przez lata.

Język szybki do prototypowania może stać się kosztowny, jeśli prowadzi do częstych incydentów lub trudnego do zmiany kodu.

Ukryte ograniczenia, które cicho decydują za ciebie

Niektóre ograniczenia są nie do negocjacji — warto je ujawnić wcześnie:

- Usługi dostawcy/chmury: pierwszorzędne SDK, stosy uwierzytelniania, zarządzane kolejki, runtime’y serverless.

- Standardy korporacyjne: zatwierdzone runtime’y, polityki bezpieczeństwa i wymagania audytowe.

- Systemy legacy: istniejące biblioteki JVM/.NET lub współdzielony kod z innymi zespołami.

Waż kryteria na podstawie priorytetów biznesowych

Nie traktuj każdego kryterium jednakowo. Jeśli testujesz rynek, nadaj większą wagę time-to-market. Jeśli budujesz platformę wewnętrzną na długie lata, większą wagę daj utrzymaniu i stabilności operacyjnej. Prosta punktowa karta z wagami utrzymuje rozmowę w granicach i ułatwia uzasadnianie kompromisów dla rozwoju API i nie tylko.

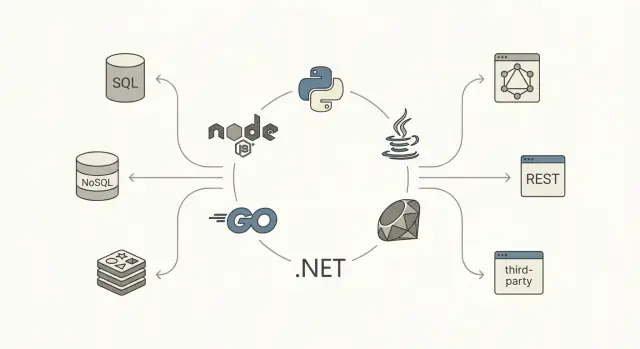

Zacznij od obciążenia backendu i architektury

Zanim porównasz składnię czy benchmarki, zapisz, co twój backend ma robić i jak będzie ukształtowany. Języki wydają się „najlepsze”, kiedy pasują do rzeczywistego obciążenia i architektury, które budujesz.

Zmapuj typy obciążeń

Większość backendów to mieszanka, ale dominująca praca ma znaczenie:

- CRUD APIs (typowe aplikacje produktowe): request/response, walidacje, auth, odczyty/zapisy do bazy.

- Zadania CPU-bound: przetwarzanie obrazów/wideo, ciężkie transformacje, szyfrowanie, logika rekomendacji, złożone raporty.

- Usługi I/O-bound: chat, bramki, agregatory, webhooki, dużo oczekiwania na bazy i zewnętrzne wywołania.

- Streaming i realtime: ingest zdarzeń, pipeline’y logów, usługi websocket, analityka niemal w czasie rzeczywistym.

Jeśli system jest głównie I/O-bound, priorytetem są prymitywy współbieżności, narzędzia asynchroniczne i ergonomia, a nie surowa szybkość. Jeśli jest CPU-bound, priorytet to przewidywalna wydajność i łatwość równoległego wykonywania zadań.

Zrozum potrzeby ruchu i niezawodności

Kształt ruchu zmienia presję na język:

- Ruch skokowy (launchy marketingowe, sprzedaż biletów): szybkie cold starty, zachowanie autoscalingu i efektywność zasobów.

- Stały wysokoprzepustowy ruch: utrzymana wydajność, zachowanie pamięci i dojrzałość obserwowalności.

Zwróć też uwagę na globalne oczekiwania dotyczące latencji i SLA. SLA 99.9% z ostrymi wymaganiami p95 popycha w stronę dojrzałych runtime’ów, solidnych narzędzi i sprawdzonych wzorców wdrożeniowych.

Bądź konkretny względem danych i integracji

Udokumentuj ścieżkę danych:

- SQL vs NoSQL, wymagania transakcyjne i potrzeby spójności.

- Warstwy cache’owania (Redis/memcached), repliki do odczytu i pipeline’y analityczne.

Na koniec wymień integracje: zewnętrzne API, messaging/kolejki (Kafka, RabbitMQ, SQS) i zadania backgroundowe. Jeśli praca asynchroniczna i konsumenci kolejek są kluczowi, wybierz język/ekosystem, w którym workerzy, retry, idempotencja i monitoring są pierwszorzędne — nie dodatkiem.

Wydajność i współbieżność: co ma znaczenie w praktyce

Wydajność to nie jedna liczba. Dla backendów zwykle rozbija się na latencję (jak szybko kończy się pojedyncze żądanie), przepustowość (ile żądań na sekundę) i zużycie zasobów (CPU, pamięć i czasem I/O). Język i runtime wpływają na wszystkie trzy — głównie przez to, jak planują pracę, zarządzają pamięcią i obsługują blokujące operacje.

Latencja vs przepustowość (i dlaczego p95 ma znaczenie)

Język, który wydaje się szybki w mikrobenchmarkach, może dawać złe tail latency (p95/p99) pod obciążeniem — często z powodu kontencji, blokujących wywołań lub presji pamięci. Jeśli usługa jest I/O-heavy (DB, cache, HTTP), największe zyski pochodzą z redukcji czekania i poprawy współbieżności, a nie z ułamków milisekund w obliczeniach.

Modele współbieżności, które rzeczywiście poczujesz

Różne ekosystemy promują różne podejścia:

- Async I/O (pętla zdarzeń): popularne w Node.js i coraz bardziej w Pythonie/.NET/Java. Świetne dla I/O o dużej współbieżności, ale praca CPU musi być oddelegowana, żeby nie blokować pętli.

- Wątki / pule wątków: klasyczne w Javie i .NET (dostępne też w innych językach). Prostota mentalna, ale trzeba pilnować saturacji puli, blokujących wywołań i kosztów przełączeń kontekstu.

- Goroutines: lekkie współbieżne zadania w Go, łatwe do uruchamiania w dużej liczbie, ale nadal trzeba rozumieć punkty blokowania, współdzielony stan i backpressure.

- Aktorzy / przekazywanie komunikatów: spotykane z Akka (JVM), Orleans (.NET) i podobnymi wzorcami. Pomaga izolować stan i upraszcza współbieżność, kosztem większej ceremonii architektonicznej.

Garbage collector i zachowanie pamięci

Runtime’y z zarządzaniem pamięcią zwiększają produktywność, ale tempo alokacji i wzrost sterty mogą wpływać na tail latency przez pauzy GC lub dodatkową pracę CPU dla kolekcji. Nie musisz być ekspertem od GC — wystarczy wiedzieć, że „więcej alokacji” i „większe obiekty” mogą stać się problemem wydajnościowym, zwłaszcza na dużą skalę.

Praktyczne wnioski: benchmarkuj krytyczne ścieżki

Zanim podejmiesz decyzję, zaimplementuj (lub zaprototypuj) kilka reprezentatywnych endpointów i zmierz:

- p50/p95/p99 latencję przy realistycznym obciążeniu

- przepustowość przy akceptowalnym poziomie błędów

- profile CPU/pamięci w szczycie

Traktuj to jako eksperyment inżynieryjny, a nie zgadywanie. Mieszanka I/O, obliczeń i współbieżności w twoim obciążeniu sprawi, że „najszybszy” język backendu w praktyce może wyglądać inaczej.

Ekosystem, frameworki i dopasowanie narzędzi

Przetestuj rzeczywiste obciążenie

Zwaliduj uwierzytelnianie, CRUD i zadania backgroundowe za pomocą jednej cienkiej, pionowej ścieżki.

Język backendu rzadko wygrywa samą składnią. Doświadczenie dnia codziennego kształtuje ekosystem: jak szybko wystartujesz usługę, ewoluujesz schematy, zabezpieczysz endpointy, przetestujesz zmiany i bezpiecznie wydasz.

Frameworki i „standardowe ścieżki”

Szukaj frameworków odpowiadających twojemu stylowi (minimalne vs baterie-w-zestawie) i architekturze (monolit, modularny monolit, mikroserwisy). Zdrowy ekosystem zwykle ma przynajmniej jedną szeroko stosowaną „domyślną” opcję i solidne alternatywy.

Zwróć uwagę na mało efektowne elementy: dojrzałe ORM-y lub budowniczych zapytań, niezawodne migracje, biblioteki auth, walidacja wejścia i narzędzia do zadań backgroundowych. Jeśli te części są rozproszone lub przestarzałe, zespoły często odtwarzają podstawy i akumulują niespójne wzorce w usługach.

Zarządzanie zależnościami i kadencja wydań

Najlepszy menedżer pakietów to ten, którym zespół potrafi przewidywalnie operować. Oceń:

- Jak zależności są przypinane i blokowane (powtarzalne buildy)

- Advisories bezpieczeństwa i narzędzia audytowe

- Dyscyplina SemVer w popularnych bibliotekach

- Ergonomia aktualizacji (breaking changes, deprecations, przewodniki migracyjne)

Sprawdź też kadencję wydań języka i frameworka. Szybkie wydania są świetne — jeśli organizacja nadąża. W środowiskach regulowanych lub przy wielu usługach rytm LTS może zmniejszyć ryzyko operacyjne.

Obserwowalność i debugowanie w produkcji

Nowoczesne backendy potrzebują pierwszorzędnej obserwowalności. Upewnij się, że ekosystem ma dojrzałe opcje dla logowania strukturalnego, metryk (Prometheus/OpenTelemetry), śledzenia rozproszonego i profilowania.

Praktyczny test: czy da się od „p95 latencja wzrosła” dojść do konkretnego endpointu, zapytania lub wywołania zależności w ciągu kilku minut? Języki z dobrymi integracjami profilowania i trace’owania oszczędzają znaczną ilość czasu inżynierskiego w ciągu roku.

Dopasowanie operacyjne: kontenery, serverless i usługi długotrwałe

Ograniczenia operacyjne powinny wpływać na wybór języka. Niektóre runtime’y błyszczą w kontenerach z małymi obrazami i szybkim startupem; inne sprawdzają się w długotrwałych usługach o przewidywalnym zużyciu pamięci. Jeśli rozważasz serverless, cechy typu cold-start, limity pakowania i zarządzanie połączeniami mają znaczenie.

Zanim się zobowiążesz, zbuduj cienką pionową ścieżkę i wdroż ją tak, jak zamierzasz uruchamiać (np. w Kubernetes lub funkcji). To często bardziej pouczające niż czytanie listy funkcji frameworka.

Utrzymanie, bezpieczeństwo i doświadczenie deweloperskie

Utrzymanie to mniej „piękny kod”, a bardziej szybkość, z jaką zespół może zmienić zachowanie bez łamania produkcji. Wybór języka wpływa na to przez system typów, narzędzia i powszechne praktyki w ekosystemie.

Typowanie statyczne vs dynamiczne: refaktory i niezawodność

Języki silnie typowane (Java, Go, C#/.NET) zwykle ułatwiają bezpieczne refaktory, ponieważ kompilator działa jak dodatkowy recenzent. Zmieniasz pole, sygnaturę funkcji lub dzielisz moduł i dostajesz natychmiastową informację o problemach w całej bazie kodu.

Języki dynamiczne (Python, Ruby, vanilla JavaScript) mogą być bardzo produktywne, ale poprawność opiera się bardziej na konwencjach, pokryciu testami i runtime checks. Jeśli wybierzesz ten kierunek, pomocne jest „typowanie stopniowe”: TypeScript dla Node.js albo adnotacje typów plus narzędzie sprawdzające (mypy/pyright) dla Python. Klucz to konsekwencja — połowiczne typowanie może być gorsze niż skrajności.

Kontrakty API: DTO, schematy i OpenAPI

Systemy backendowe zawodzą na granicach: formaty request/response, payloady zdarzeń i mapowania bazodanowe. Utrzymywalny stos jawnie określa kontrakty.

OpenAPI/Swagger to powszechna baza dla API HTTP. Wiele zespołów łączy to z walidacją schematów i DTO, żeby uniknąć „stringly-typed” API. Przykłady w praktyce:

- Node.js: OpenAPI + Zod/Joi do walidacji; DTO przez typy TypeScript

- Python: FastAPI + Pydantic models

- Java: Bean Validation + generowane DTO z OpenAPI

- .NET: FluentValidation + silne DTO + generacja OpenAPI

Wsparcie generowania kodu ma znaczenie: generowanie klientów/serwerów/DTO redukuje dryft i ułatwia onboardowanie.

Kultura testów i narzędzia

Ekosystemy różnią się, jak naturalnie testowanie wpisuje się w workflow. Node często używa Jest/Vitest z szybkim feedbackiem. Pytest w Pythonie jest ekspresyjny i świetny w fixture’ach. JUnit/Testcontainers w Javie jest mocny dla testów integracyjnych. W Go wbudowany pakiet testing zachęca do prostych testów, a .NET ma xUnit/NUnit dobrze zintegrowane z IDE i CI. RSpec w Ruby ma opiniotwórczą i czytelną kulturę.

Praktyczna zasada: wybierz ekosystem, w którym najłatwiej dla twojego zespołu uruchamiać testy lokalnie, mockować zależności i pisać testy integracyjne bez ceremonii.

Umiejętności zespołu, rynek zatrudnienia i długoterminowe utrzymanie

Wybór języka backendu to także decyzja personalna. Język, który „na papierze” jest najlepszy, może stać się kosztowny, jeśli nie możesz zatrudnić, wdrożyć i zatrzymać ludzi, którzy go obsłużą.

Dopasuj język do zespołu, który masz naprawdę

Sporządź inwentaryzację mocnych stron: nie tylko kto potrafi pisać kod, ale kto potrafi debugować produkcję, stroić wydajność, ustawiać CI, prowadzić incydenty i szybko przeglądać PR-y.

Prosta zasada: preferuj języki, które zespół potrafi obsługiwać, nie tylko pisać. Jeśli rotacja na on-callie już teraz cierpi z powodu słabej obserwowalności, wdrożenia lub błędów współbieżności, wprowadzenie nowego runtime’u lub paradygmatu może zwiększyć ryzyko.

Dostępność kandydatów: region i seniority mają znaczenie

Rynki zatrudnienia różnią się znacznie w zależności od geografii i poziomu doświadczenia. Możesz znaleźć wiele juniorów Node.js lub Python lokalnie, ale mniej starszych inżynierów z głębokim strojem JVM lub doświadczeniem z Go — albo odwrotnie, w zależności od regionu.

Przy ocenie „dostępności” sprawdź:

- Lokalnie vs zdalnie: Czy możesz rekrutować zdalnie w odpowiednich strefach czasowych, czy wymagana jest kooperacja na miejscu?

- Rozkład seniority: Czy potrzebujesz seniorów do prowadzenia i mentoringu, czy głównie mid-leveli do skalowania dostarczania?

- Konkurencyjne zapotrzebowanie: Jeśli wszyscy w okolicy szukają tych samych profili, spodziewaj się dłuższego czasu rekrutacji i wyższych kosztów.

Krzywa uczenia się i czas wdrożenia

Nawet doświadczeni inżynierowie potrzebują czasu, by być efektywnymi w nowym ekosystemie: idiomy, frameworki, praktyki testowe, zarządzanie zależnościami i narzędzia wdrożeniowe. Szacuj wdrożenie w tygodniach, nie dniach.

Pytania praktyczne:

- Czy nowy zatrudniony może wypuścić bezpieczną, reviewowaną zmianę w pierwszych dwóch tygodniach?

- Czy macie wewnętrzne szablony (skeletony serwisów, logowanie, auth, CI), które zmniejszają wariancję?

- Czy wystarczy doświadczonych reviewerów, by utrzymać wysoką jakość podczas ramp-upu?

Długoterminowe utrzymanie (2–3 lata naprzód)

Optymalizacja pod początkową prędkość może się zemścić, jeśli zespół nie lubi utrzymywać stosu. Weź pod uwagę kadencję aktualizacji, churn frameworków i przyjemność pisania testów, refaktoryzowania i śledzenia błędów.

Jeśli spodziewasz się rotacji, priorytetuj czytelność, przewidywalne narzędzia i szeroką bazę osoby trzymającej — bo „własność” trwa dłużej niż pierwsze wydanie.

Szybkie porównanie: Node.js, Python, Java, Go, .NET, Ruby

Zdecyduj za pomocą scorecard

Zamień wymagania na jasny plan budowy, zanim zobowiążesz się do języka.

Node.js

Node.js błyszczy w API I/O-heavy, chatcie, narzędziach współpracy i funkcjach realtime (WebSockets, streaming). Popularny stos to TypeScript + Express/Fastify/NestJS, często z PostgreSQL/Redis i kolejkami.

Typowe pułapki to praca CPU blokująca event loop, rozrost zależności i niespójne typowanie, jeśli zostaniesz przy czystym JavaScripcie. Gdy wydajność ma znaczenie, deleguj ciężkie obliczenia do workerów/usług i stosuj rygorystyczny TypeScript + linting.

Python

Python jest liderem produktywności, szczególnie dla backendów związanych z danymi, analityką, ML, ETL i automatyzacją. Frameworki dzielą się typowo między Django (batteries-included) i FastAPI (nowoczesny, typed, API-first).

Wydajność jest zwykle „wystarczająca” dla wielu systemów CRUD, ale gorące ścieżki mogą stać się kosztowne przy skali. Typowe strategie: async I/O dla współbieżności, cache’owanie, przenoszenie obliczeń do wyspecjalizowanych usług lub użycie szybszych runtime’ów/rozszerzeń tam, gdzie uzasadnione.

Java

Java pozostaje mocnym wyborem dla systemów enterprise: dojrzałe narzędzia JVM, przewidywalna wydajność i głęboki ekosystem (Spring Boot, Quarkus, Kafka, narzędzia obserwowalności). Dojrzałość operacyjna to kluczowa przewaga — zespoły wiedzą, jak to wdrażać i utrzymywać.

Typowe zastosowania: API o wysokiej przepustowości, złożone domeny i środowiska regulowane, gdzie stabilność i długoterminowe wsparcie mają znaczenie.

Go

Go pasuje do mikroserwisów i usług sieciowych, gdzie priorytetem są współbieżność i prostota. Goroutines ułatwiają wykonywanie wielu zadań jednocześnie, a standardowa biblioteka jest praktyczna.

Koszty: mniej frameworków „batteries-included” niż w Javie/.NET, możesz napisać więcej elementów infrastruktury samodzielnie (choć dla wielu to zaleta).

.NET

Nowoczesne .NET (ASP.NET Core) jest doskonałe dla API enterprise, z mocnymi narzędziami (Visual Studio, Rider), świetną wydajnością i dobrą parytetem Windows/Linux. Typowy stos to ASP.NET Core + EF Core + SQL Server/PostgreSQL.

Ruby

Ruby on Rails wciąż jest jednym z najszybszych sposobów na wypuszczenie dopracowanego produktu webowego. Skalowanie osiąga się często przez wyciąganie ciężkich zadań do background jobów i usług.

Kosztem jest surowa przepustowość na instancję; zwykle skalujesz horyzontalnie i wcześniej inwestujesz w cache i kolejki zadań.

Typowe scenariusze i języki, które często pasują

Rzadko jest jeden „najlepszy” język — jest najlepsze dopasowanie do konkretnego obciążenia, zespołu i profilu ryzyka. Oto wzorce i języki, które zwykle do nich pasują.

Start-upy, które szybko chcą wypuścić produkt (MVP → product-market fit)

Jeśli liczy się tempo iteracji i zatrudnianie ogólnych specjalistów, często wybiera się Node.js i Python. Node.js błyszczy, gdy zespół chce współdzielić TypeScript między frontendem i backendem i gdy rozwój API jest głównie I/O-bound. Python jest silny dla produktów związanych z danymi, skryptami i gdy planowana jest integracja z analityką lub ML.

Ruby on Rails wciąż jest świetnym „fabrykantem funkcji”, gdy zespół zna Rails i buduje konwencjonalną aplikację webową z wieloma CRUD-ami i panelami administracyjnymi.

API o wysokiej przepustowości i usługi wymagające współbieżności

Dla usług, gdzie kluczowa jest latencja, przepustowość i przewidywalne użycie zasobów, Go jest częstym wyborem: szybki start, prosty model współbieżności i łatwa konteneryzacja. Java i .NET też są doskonałe, zwłaszcza gdy potrzebujesz dojrzałego profilowania, strojenia JVM/CLR i bibliotek sprawdzonych w systemach rozproszonych.

Jeśli spodziewasz się długotrwałych połączeń (streaming, websockets) lub dużego fan-out, priorytetem jest zachowanie runtime’u pod obciążeniem i narzędzia operacyjne, a nie mikrobenchmarki.

Narzędzia wewnętrzne i automatyzacja biznesowa

Dla narzędzi wewnętrznych koszt dewelopera często przewyższa koszt compute. Python, Node.js i .NET (szczególnie w organizacjach mocno związanych z Microsoft) zwykle wygrywają dzięki szybkiemu dostarczaniu, bogatym bibliotekom i łatwej integracji z istniejącymi systemami.

Środowiska regulowane i enterprise

W ustawieniach wymagających zgodności (audytowalność, kontrola dostępu, długie cykle wsparcia) Java i .NET zwykle są najbezpieczniejsze: dojrzałe praktyki bezpieczeństwa, ustalone wzorce rządzenia i przewidywalne opcje LTS. Ma to znaczenie, gdy „kto może zatwierdzić zależność?” jest tak samo ważne jak wydajność vs produktywność.

Monolit vs mikroserwisy (i wybór języka)

Monolit zwykle korzysta z jednego głównego języka, by utrzymać prostotę onboardingu i utrzymania. Mikroserwisy mogą uzasadniać większą różnorodność — ale tylko, gdy zespoły są naprawdę autonomiczne, a platformowe narzędzia (CI/CD, obserwowalność, standardy) są silne.

Rzeczywistość poliglotyczna: kiedy dwa języki są rozsądne

Pragmatyczny podział jest częsty: np. Java/.NET/Go dla core API i Python dla pipeline’ów danych. Unikaj poliglotyzmu „z preferencji” zbyt wcześnie; każdy nowy język mnoży pracę przy incydentach, przeglądach bezpieczeństwa i odpowiedzialności.

Praktyczne ramy decyzyjne i macierz punktowa

Udostępnij działające demo

Udostępnij działający demo, gdy będziesz gotów, pod własną domeną.

Wybór języka jest łatwiejszy, gdy traktujesz go jak decyzję produktową: zdefiniuj ograniczenia, oceń opcje, a potem zwaliduj małym PoC. Cel to nie „idealny” wybór, a uzasadniony, który możesz wytłumaczyć zespołowi i przyszłym zatrudnionym.

Krok 1: Oddziel must-have od nice-to-have

Zacznij od dwóch list:

- Wymagania niezbędne: np. konkretne ograniczenia chmury/runtime, zgodność, zespół musi wypuścić w 8 tygodni, musi obsługiwać gRPC, musi działać w ograniczeniu pamięci.

- Przyjemne do posiadania: np. „najlepsze DX”, „największy ekosystem”, „najładniejsza składnia”.

Jeśli język nie spełnia must-have, odpada — bez dalszej dyskusji. To zapobiega paraliżowi analitycznemu.

Krok 2: Użyj prostej karty oceny (wagi + skala 1–5)

Stwórz krótką macierz i trzymaj się jej dla wszystkich kandydatów.

| Kryterium | Waga (%) | Ocena (1–5) | Wynik ważony |

|---|

| Dopasowanie wydajności i współbieżności | 20 | | |

| Ekosystem i biblioteki (DB, auth, kolejki) | 20 | | |

| Produktywność dewelopera | 15 | | |

| Zatrudnianie i długoterminowe utrzymanie | 15 | | |

| Dopasowanie operacyjne (wdrożenia, obserwowalność) | 15 | | |

| Bezpieczeństwo i poprawność (typy, narzędzia) | 15 | | |

Jak obliczać: Wynik ważony = Waga × Ocena. Sumuj wyniki dla każdego języka. Trzymaj się ~5–7 kryteriów, żeby liczby miały sens.

Krok 3: Wykonaj PoC odzwierciedlający realną pracę

Checklist PoC (time-box 1–3 dni na język):

- Jeden endpoint API (walidacja + obsługa błędów)

- Uwierzytelnianie (JWT/session/OAuth — cokolwiek faktycznie użyjecie)

- CRUD w bazie + migracja

- Zadanie backgroundowe / konsument kolejki

- Podstawowe logowanie, metryki i trace

- Wdrożenie do docelowego środowiska (kontener/serverless/VM)

Krok 4: Zdefiniuj cele PoC

Ustal wcześniej, co oznacza „dobrze”:

- Cel latencji: np. p95 < 150ms dla reprezentatywnego endpointu

- Czas wdrożenia: np. < 10 minut od czystego checkoutu do produkcyjnego deployu

- Wskaźnik błędów: np. < 0.1% w małym teście obciążeniowym z realistycznymi błędami

- Szybkość deweloperska: czas wdrożenia checklisty PoC + liczba trudnych miejsc

Wprowadź wyniki PoC z powrotem do macierzy i wybierz opcję z najlepszym łącznym wynikiem i najmniejszym ryzykiem względem must-have.

Pułapki do uniknięcia i jak zabezpieczyć wybór na przyszłość

Najczęściej źle wybiera się język, gdy decyzja pochodzi z zewnątrz — co jest trendy, co chwaliły prezentacje konferencyjne albo co wygrało pojedynczy benchmark.

Nie optymalizuj pod hype (ani pod jeden wykres)

Mikrobenchmark rzadko odzwierciedla realne wąskie gardła: zapytania do bazy, zewnętrzne API, serializacja czy opóźnienia sieci. Traktuj twierdzenia „najszybszy” jako punkt wyjścia, nie werdykt. Zweryfikuj przez cienkie PoC odwzorowujące wzorce dostępu do danych, rozmiary payloadów i profil współbieżności.

Uważaj na niedopasowania operacyjne

Wiele zespołów wybiera język, który wygląda produkcyjnie w kodzie, a potem płaci cenę w produkcji:

- Złożoność asynchroniczna: niektóre stosy ułatwiają kod nieblokujący; inne wymagają dyscypliny, żeby uniknąć deadlocków, starvationu wątków czy spaghettiego async.

- Strojenie GC i zachowanie pamięci: runtime’y zarządzane mogą być świetne, ale trzeba umieć konfigurować rozmiary sterty, zachowanie pauz i obserwowalność.

- Ograniczenia wdrożeniowe: kontenery, cold starts, obrazy bazowe, narzędzia buildowe mogą sprawić, że „proste” wdrożenia staną się kosztowne.

Jeśli organizacja nie wspiera modelu operacyjnego, sam język jej nie uratuje.

Plan migracji jak produkt, nie jak rewrite

Zabezpieczenie przyszłości często oznacza nie stawianie wszystkiego na jedną kartę. Preferuj inkrementalną migrację:

- Nowe funkcje zaczynaj jako małe usługi (lub moduły), trzymając rdzeń stabilny.

- Używaj wzorca strangler: kieruj specyficzne endpointy lub ścieżki do nowej implementacji i rozszerzaj stopniowo.

- Trzymaj kontrakty (OpenAPI/JSON Schema/Protobuf) jako źródło prawdy, żeby zmniejszyć dryft między językami.

Checklist i następne kroki

- Zdefiniuj top 3 ograniczenia (latencja, przepustowość, koszty, zgodność, zatrudnianie).

- Prototypuj z realnymi ścieżkami danych, potem testuj obciążeniowo.

- Zweryfikuj gotowość operacyjną: CI/CD, monitoring, response na incydenty, strojenie runtime.

- Wybierz ścieżkę migracji (inkrementalna > rewrite) i zablokuj kontrakty API.

- Przeprowadź pilotaż 60–90 dni, potem ustandaryzuj konwencje i narzędzia.