Co budujesz i dlaczego ma to znaczenie

Flaga funkcji (zwane też „feature toggle”) to proste narzędzie, które pozwala włączać lub wyłączać funkcjonalność produktu bez wysyłania nowego kodu. Zamiast wiązać wydanie z deployem, oddzielasz „kod został wdrożony” od „funkcja jest aktywna”. Ta niewielka zmiana wpływa na to, jak bezpiecznie — i jak szybko — możesz dostarczać zmiany.

Dlaczego zespoły korzystają z flag funkcji

Zespoły używają flag, bo zmniejszają ryzyko i zwiększają elastyczność:

- Wdrażanie etapowe: włącz zmianę dla 1% użytkowników, obserwuj problemy, potem rozszerz.

- Eksperymenty: pokazuj wariant A vs B różnym grupom i porównuj wyniki.

- Awaryjne wyłączenie (kill switch): natychmiast wyłącz problematyczną funkcję, gdy coś nie działa.

Wartość operacyjna jest prosta: flagi dają szybki, kontrolowany sposób reakcji na zachowanie w produkcji — błędy, regresje wydajności lub negatywne opinie użytkowników — bez czekania na pełny cykl redeployu.

Co pomoże Ci zbudować ten przewodnik

Ten przewodnik przeprowadzi cię przez budowę praktycznej aplikacji webowej do zarządzania flagami i wdrożeniami z trzema głównymi częściami:

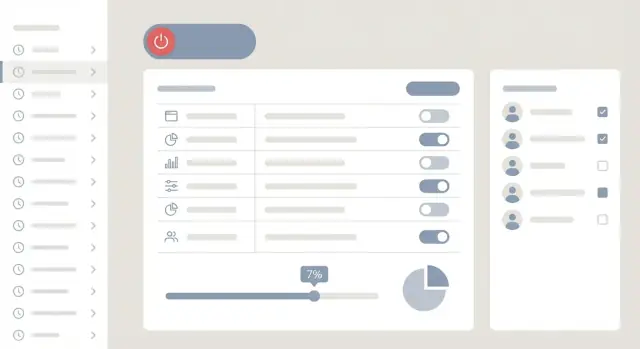

- Panel administracyjny dla osób nietechnicznych, gdzie można tworzyć flagi, definiować odbiorców i uruchamiać/zatrzymywać wdrożenia.

- Backend API do przechowywania konfiguracji flag, egzekwowania uprawnień i serwowania wartości flag do aplikacji.

- Lekka ścieżka ewaluacji (przez SDK lub proste wywołanie API) w aplikacjach, która decyduje, którzy użytkownicy widzą który wariant.

Celem nie jest ogromna platforma korporacyjna, lecz klarowny, utrzymywalny system, który możesz wdrożyć przed zespołem produktowym i ufać mu w produkcji.

Jeśli chcesz szybko prototypować takie narzędzie wewnętrzne, workflow z generacją kodu w czacie może pomóc. Na przykład, zespoły często używają Koder.ai do wygenerowania pierwszej działającej wersji panelu w React i API w Go/PostgreSQL z opisanej specyfikacji, a potem iterują nad silnikiem reguł, RBAC i wymaganiami audytu w trybie planowania, zanim wyeksportują kod źródłowy.

Określ wymagania i przypadki użycia

Zanim zaprojektujesz ekrany lub napiszesz kod, ustal, dla kogo system jest i co oznacza „sukces”. Narzędzia do flag często zawodzą nie dlatego, że silnik reguł jest zły, lecz dlatego, że workflow nie odpowiada temu, jak zespoły wdrażają i wspierają oprogramowanie.

Kto będzie z tego korzystać (i czego potrzebują)

Inżynierowie chcą szybkich, przewidywalnych kontrolek: utwórz flagę, dodaj reguły targetowania i wdrażaj bez redeployu. Product managerowie potrzebują pewności, że wydania można etapować i planować, z jasnym widokiem, kogo one dotyczą. Support i operacje potrzebują bezpiecznego sposobu reagowania na incydenty — najlepiej bez alarmowania inżynierii — poprzez szybkie wyłączenie ryzykownej funkcji.

Dobry dokument wymagań wymienia te persony i akcje, które powinny mieć prawo wykonywać (i których nie powinny mieć).

Funkcje obowiązkowe

Skoncentruj się na wąskim rdzeniu, który umożliwia stopniowe wdrożenie i rollback:

- Tworzenie i zarządzanie flagami (włącz/wyłącz, warianty, opisy, właściciele)

- Definiowanie reguł targetowania (kto dostaje funkcję)

- Procentowe wdrożenia (np. 1% → 10% → 50% → 100%)

- Harmonogramowanie (start/stop w określonych godzinach, z jasnością stref czasowych)

To nie są „miłe dodatki” — to cechy, które sprawiają, że narzędzie do wdrożeń jest warte użycia.

Funkcje „miłe do posiadania” (planować, nie blokować)

Zapisz je teraz, ale nie buduj jako pierwszych:

- Eksperymenty i testy A/B

- Szablony typowych flag (kill switch, dostęp beta)

- Masowe edycje dla dużych wdrożeń (wiele flag, wiele środowisk)

Zdefiniuj, co znaczy „bezpieczne”

Spisz wymagania bezpieczeństwa jako konkretne reguły. Typowe przykłady: zatwierdzenia zmian w produkcji, pełna audytowalność (kto zmienił co, kiedy i dlaczego) oraz szybka ścieżka rollback dostępna nawet w czasie incydentu. Ta „definicja bezpiecznego” poprowadzi późniejsze decyzje o uprawnieniach, tarciu w UI i historii zmian.

Architektura wysokiego poziomu (prosta i praktyczna)

System flag jest najłatwiejszy do zrozumienia, gdy oddzielisz „zarządzanie flagami” od „ewaluacji”. Dzięki temu panel administracyjny może być przyjazny i bezpieczny, a aplikacje otrzymują szybkie, niezawodne odpowiedzi.

Podstawowe komponenty

Na wysokim poziomie potrzebujesz czterech bloków:

- UI administracyjne (dashboard): miejsce, gdzie tworzy się flagi, definiuje reguły targetowania, planuje wdrożenia i włącza kill switch.

- Flag API (control plane): uwierzytelnione endpointy, z których korzysta panel do odczytu/zapisu flag, środowisk, segmentów i zatwierdzeń.

- Serwis ewaluacji + SDK (data plane): komponent, do którego odwołują się aplikacje, aby ustalić „czy ta flaga jest włączona dla tego użytkownika teraz?”.

- Magazyn danych: przechowuje definicje flag, reguły, segmenty i historię audytu.

Prosty model mentalny: panel aktualizuje definicje flag; aplikacje konsumują skomplikowany snapshot tych definicji do szybkiej ewaluacji.

Jak aplikacje powinny pytać o flagi

Masz na ogół dwa wzorce:

Ewaluacja po stronie serwera (zalecana dla większości flag). Twój backend pyta warstwę ewaluacji/SDK, przekazując obiekt user/context, a potem podejmuje decyzję. To trzyma reguły i wrażliwe atrybuty poza klientem i ułatwia zapewnienie spójnego zachowania.

Ewaluacja po stronie klienta (stosować selektywnie). Klient web/mobile pobiera wstępnie przefiltrowaną, podpisaną konfigurację (tylko to, co klient może znać) i ewaluje lokalnie. To może zmniejszyć obciążenie backendu i poprawić responsywność UI, ale wymaga surowszej higieny danych.

Monolit kontra małe serwisy

Na start modułowy monolit jest zazwyczaj najbardziej praktyczny:

- Jedna aplikacja backendowa z wyraźnymi modułami: Auth/RBAC, Flags, Segments, Audit i „Publish config”.

- Jedna baza danych.

- Jedna jednostka do deployu.

W miarę wzrostu użycia, pierwsze co zwykle dzielisz to ścieżka ewaluacji (dużo odczytów) od ścieżki administracyjnej (dużo zapisów). Możesz zachować ten sam model danych, a potem wprowadzić dedykowany serwis ewaluacji.

Utrzymywanie niskich opóźnień: cache i lokalna ewaluacja

Sprawdzenia flag są na gorących ścieżkach, więc optymalizuj odczyty:

- Push lub polling snapshotów: SDK przechowują lokalny cache konfiguracji, odświeżany co N sekund lub przez streaming.

- Ewaluacja lokalna: gdy config jest w cache, większość sprawdzeń to wywołania funkcji w procesie.

- Użyj CDN/edge do dostarczania konfiguracji (dla klienta) i szybkiego cache (dla serwera), aby nie pytać bazy danych przy każdym żądaniu.

Celem jest spójne zachowanie nawet podczas częściowych awarii: jeśli panel jest niedostępny, aplikacje powinny dalej ewaluować używając ostatniego znanego dobrego snapshotu.

Model danych dla flag, segmentów i środowisk

Sukces systemu flag zależy od modelu danych. Jeśli będzie zbyt luźny, nie da się audytować zmian ani bezpiecznie cofać. Jeśli będzie zbyt sztywny, zespoły go ominą. Celuj w strukturę wspierającą jasne wartości domyślne, przewidywalne targetowanie i historię, której można ufać.

Podstawowe encje

Flag to przełącznik na poziomie produktu. Utrzymaj go stabilnym przez:

key (unikalny, używany przez SDK, np. new_checkout)name i description (dla ludzi)type (boolean, string, number, JSON)archived_at (soft delete)

Variant reprezentuje wartość, jaką flaga może zwrócić. Nawet flagi boolean zyskują na explicite wariantach (on/off), bo standaryzuje to raportowanie i wdrożenia.

Environment oddziela zachowanie wg kontekstu: dev, staging, prod. Modeluj to explicite, aby jedna flaga mogła mieć różne reguły i domyślne ustawienia w każdym środowisku.

Segment to zapisany definicja grupy (np. „Beta testers”, „Internal users”, „High spenders”). Segmenty powinny być wielokrotnie używalne przy wielu flagach.

Reguły, priorytety i fallbacki

To właśnie w regułach kryje się większość złożoności, więc traktuj je jako rekordy pierwszej klasy.

Praktyczne podejście:

FlagConfig (dla flag + environment) przechowuje default_variant_id, stan enabled i wskaźnik do aktualnej published rewizji.Rule należy do rewizji i zawiera:

priority (mniejsza liczba wygrywa)conditions (tablica JSON jak porównania atrybutów)serve (stały wariant, lub procentowy podział między wariantami)

fallback to zawsze default_variant_id w FlagConfig, gdy żadna reguła nie pasuje.

To upraszcza ewaluację: załaduj opublikowaną rewizję, posortuj reguły po priorytecie, dopasuj pierwszą pasującą, w przeciwnym razie domyślny.

Wersjonowanie: draft vs. published

Traktuj każdą zmianę jako nową FlagRevision:

status: draft lub publishedcreated_by, created_at, opcjonalny comment

Publikacja to atomowa akcja: ustaw FlagConfig.published_revision_id na wybraną rewizję (per environment). Drafty pozwalają zespołom przygotować zmiany bez wpływu na użytkowników.

Historia audytu i rollback

Dla audytu i rollbacku przechowuj dziennik dodający wpisy (append-only):

AuditEvent: kto zmienił co, kiedy, w którym środowiskubefore/after snapshoty (lub JSON patch) odnoszące się do identyfikatorów rewizji

Rollback staje się „ponowne opublikowanie starszej rewizji” zamiast ręcznego rekonstruowania ustawień. To szybsze, bezpieczniejsze i łatwe do wyjaśnienia osobom nietechnicznym w widoku historii panelu.

Targetowanie i reguły segmentacji

Targetowanie to część „kto dostaje co” w systemie flag. Dobrze zrobione pozwala bezpiecznie wdrażać: najpierw wewnętrznym użytkownikom, potem konkretnej klasie klientów, potem regionowi — bez redeployu.

Co można targetować (atrybuty użytkownika)

Zacznij od małego, spójnego zestawu atrybutów, które aplikacje mogą niezawodnie wysyłać przy każdej ewaluacji:

- Role: admin, staff, member (dobry do wdrożeń wewnętrznych)

- Plan: free, pro, enterprise (przydatne dla funkcji płatnych)

- Region: kraj/rynek lub strefa przetwarzania danych

- Wersja aplikacji: by nie włączać funkcji dla przestarzałych klientów

Trzymaj atrybuty nudnymi i przewidywalnymi. Jeśli jedna aplikacja wysyła plan=Pro, a inna plan=pro, reguły zachowają się nieoczekiwanie.

Segmenty: zapisywane grupy

Segmenty to wielokrotnego użytku grupy jak „Beta testers”, „EU customers” czy „All enterprise admins”. Implementuj je jako zapisane definicje (nie statyczne listy), żeby członkostwo mogło być obliczane na żądanie:

- Segmenty oparte na regułach: „plan = enterprise AND role = admin”

- Jawne listy allow/deny (opcjonalne): przydatne dla „VIP customers” lub rolloutów sterowanych przez support

Aby utrzymać szybkość ewaluacji, cache’uj wyniki przynależności do segmentu na krótki czas (sekundy/minuty), kluczując po środowisku i użytkowniku.

Logika reguł i precedencja

Zdefiniuj jasną kolejność ewaluacji, żeby wyniki były wytłumaczalne w panelu:

- Twarde nadpisania (np. deny/allow listy)

- Reguły targetowania (w kolejności, first match wins)

- Fall-through (domyślnie wyłączone lub domyślnie rollout)

Obsługuj grupy AND/OR i typowe operatory: equals, not equals, contains, in list, greater/less than (dla wersji lub atrybutów numerycznych).

Uwaga dotycząca prywatności

Minimalizuj dane osobowe. Preferuj stabilne, nie-PII identyfikatory (np. wewnętrzne ID użytkownika). Gdy musisz przechowywać identyfikatory dla allow/deny list, przechowuj hashowane ID tam, gdzie to możliwe, i unikaj kopiowania e-maili, imion czy surowych adresów IP do systemu flag.

Strategie wdrożeń: procenty, warianty, harmonogramy, kill switch

Build your flag tool fast

Describe your flag dashboard and APIs in chat and get a working app to iterate on.

To dzięki wdrożeniom system flag daje realną wartość: możesz udostępniać zmiany stopniowo, porównywać opcje i szybko zatrzymać problemy — bez redeployu.

Procentowe wdrożenia (i dlaczego spójne bucketing jest ważne)

Procentowe wdrożenie to „włącz dla 5% użytkowników”, potem zwiększaj, gdy rośnie zaufanie. Kluczowy detal to deterministyczne bucketing: ten sam użytkownik powinien konsekwentnie pozostawać w (lub poza) wdrożeniem między sesjami.

Użyj deterministycznego hasha stabilnego identyfikatora (np. user_id lub account_id) do przypisania bucketu 0–99. Jeśli zamiast tego będziesz losować użytkowników przy każdym żądaniu, ludzie będą „przeskakiwać” między doświadczeniami, metryki będą zaszumione, a support nie będzie w stanie odtworzyć problemów.

Zastanów się też świadomie nad jednostką bucketingu:

- W oparciu o użytkownika dobre dla aplikacji konsumenckich.

- W oparciu o konto/tenant zapobiega sytuacji, w której różni użytkownicy tej samej firmy widzą sprzeczne zachowania.

Warianty: boolean i multivariant

Zacznij od flagi boolean (włącz/wyłącz), ale planuj warianty multivariate (np. control, new-checkout-a, new-checkout-b). Multivariate jest niezbędne do testów A/B, eksperymentów z treścią i stopniowych zmian UX.

Twoje reguły zawsze powinny zwracać pojedynczą, rozstrzygniętą wartość przy ewaluacji, z jasnym porządkiem priorytetów (np. eksplicytne nadpisania > reguły segmentów > procentowe wdrożenie > domyślne).

Harmonogramowanie: czasy startu/końca, kroki rampy i strefy czasowe

Harmonogramowanie pozwala zespołom zsynchronizować wydania bez konieczności ręcznego przełączania:

- Czas rozpoczęcia / zakończenia (auto‑wyłączenie po terminie)

- Kroki rampy (np. 1% → 10% → 25% → 50% w określonych odstępach)

- Strefy czasowe (przechowuj czasy w UTC, ale pokazuj i edytuj w strefie użytkownika)

Traktuj harmonogramy jako część konfiguracji flagi, tak aby zmiany były audytowalne i możliwe do przejrzenia przed wdrożeniem.

Zachowanie kill switch (w tym awarie)

Kill switch to awaryjne „force off”, które nadpisuje wszystko. Zrób z niego element pierwszej klasy z najszybszą ścieżką w UI i API.

Zdecyduj, co się dzieje podczas awarii:

- Jeśli serwis flag nie jest osiągalny, SDK powinny zastosować ostatni znany dobry config (cache), a potem bezpieczny default.

- Dla ryzykownych funkcji wybierz domyślnie zachowanie „closed” (wyłączone).

Udokumentuj to jasno, aby zespoły wiedziały, co aplikacja zrobi, gdy system flag będzie zdegradowany. Dla więcej informacji zobacz /blog/testing-deployment-and-governance.

API i integracja SDK z aplikacjami

Twoja aplikacja webowa to tylko połowa systemu. Druga połowa to sposób, w jaki kod produktu czyta flagi bezpiecznie i szybko. Czyste API plus małe SDK dla każdej platformy (Node, Python, mobile itd.) utrzymują integrację spójną i zapobiegają tworzeniu własnych, niestandardowych rozwiązań przez każdy zespół.

Read API (szybkie, przyjazne dla cache)

Aplikacje będą wywoływać endpointy odczytu znacznie częściej niż zapisu, więc najpierw je zoptymalizuj.

Typowe wzorce:

GET /api/v1/environments/{env}/flags — lista wszystkich flag dla środowiska (często filtrowana do „enabled” tylko)GET /api/v1/environments/{env}/flags/{key} — pobierz pojedynczą flagę po kluczuGET /api/v1/environments/{env}/bootstrap — pobierz flagi + segmenty potrzebne do lokalnej ewaluacji

Zadbaj, aby odpowiedzi były przyjazne dla cache (ETag lub pole updated_at), i aby payloady były małe. Wiele zespołów obsługuje też ?keys=a,b,c dla pobrań batchowych.

Write API (walidowane, z uwzględnieniem workflow)

Endpointy zapisu powinny być rygorystyczne i przewidywalne:

POST /api/v1/flags — utwórz (waliduj unikalność klucza, zasady nazewnictwa)PUT /api/v1/flags/{id} — zaktualizuj draft config (walidacja schematu)POST /api/v1/flags/{id}/publish — wypromuj draft do środowiskaPOST /api/v1/flags/{id}/rollback — przywróć do ostatniej znanej dobrej wersji

Zwracaj jasne błędy walidacji, żeby panel mógł wyjaśnić, co trzeba poprawić.

Odpowiedzialności SDK (nie rób niczego wymyślnego)

Twoje SDK powinno obsługiwać cache z TTL, retry/backoff, timeouty i fallback offline (serwuj ostatnie wartości z cache). Powinno też wystawiać jedno wywołanie „evaluate”, aby zespoły nie musiały rozumieć Twojego modelu danych.

Zapobieganie manipulacji klienta

Jeśli flagi wpływają na ceny, uprawnienia lub zachowania krytyczne dla bezpieczeństwa, unikaj zaufania do klienta browser/mobile. Preferuj ewaluację po stronie serwera lub używaj podpisanych tokenów (server wydaje podpisany „snapshot flag”, który klient może czytać, ale nie sfałszować).

UX panelu administracyjnego (przyjazny dla osób nietechnicznych)

Keep control with source export

Export the source code when you are ready to review, extend, and own the system long term.

System flag działa tylko wtedy, gdy ludzie ufają mu na tyle, by używać go podczas prawdziwych wydań. Panel administracyjny buduje to zaufanie: czytelne etykiety, bezpieczne domyślne ustawienia i zmiany łatwe do przeglądu.

Lista flag: szybko znajdź to, czego potrzebujesz

Zacznij od prostego widoku listy flag, który obsługuje:

- Wyszukiwanie po nazwie, kluczu, właścicielu lub tagu

- Filtry po statusie (on/off), typie (boolean/multi) i „ostatnio zmienione”

- Wyraźny selektor środowiska (Dev / Staging / Prod), który jest dobrze widoczny

Uczyń „aktualny stan” czytelnym na pierwszy rzut oka. Na przykład pokaż On for 10%, Targeting: Beta segment lub Off (kill switch active) zamiast samej zielonej kropki.

Edytor flag: prowadź użytkownika przez bezpieczne zmiany

Edytor powinien wyglądać jak formularz prowadzony, a nie techniczny ekran konfiguracyjny.

Zawiera:

- Konstruktor reguł z opisem w języku potocznym (np. „Jeśli country to US” AND „Plan to Pro”)

- Suwak rolloutu (0–100%) z jasnym wyjaśnieniem, co się stanie

- Panel podglądu pokazujący przykładowych użytkowników, którzy pasują do aktualnych reguł (lub „Dlaczego ten użytkownik pasuje”)

Jeśli wspierasz warianty, wyświetl je jako przyjazne dla ludzi opcje („Nowy checkout”, „Stary checkout”) i waliduj, czy ruch się zgadza.

Operacje masowe bez masowych błędów

Zespoły będą potrzebować masowego włączania/wyłączania i „kopiowania reguł do innego środowiska”. Dodaj zabezpieczenia:

- Potwierdzenia podsumowujące wpływ („To włączy 12 flag w Production”)

- Podglądy dry-run dla operacji kopiowania

- Jasne wskazówki dotyczące cofania, gdzie to możliwe

Zabezpieczenia: spraw, aby bezpieczna ścieżka była łatwa

Używaj ostrzeżeń i wymaganych notatek dla ryzykownych działań (edycje w Production, duże skoki procentowe, toggle kill switch). Pokaż podsumowanie zmian przed zapisaniem — co się zmieniło, gdzie i kogo to dotknie — by osoby nietechniczne mogły pewnie zatwierdzać.

Bezpieczeństwo, role i zatwierdzenia

Bezpieczeństwo to miejsce, gdzie narzędzia do flag zyskują zaufanie — albo zostają zablokowane przez zespół bezpieczeństwa. Ponieważ flagi mogą natychmiast zmieniać doświadczenia użytkowników (i czasem łamać produkcję), traktuj kontrolę dostępu jako funkcję pierwszej klasy.

Uwierzytelnianie: jak użytkownicy logują się

Zacznij od e-mail + hasło dla prostoty, ale planuj oczekiwania enterprise.

- SSO/OAuth: obsłuż Google/Microsoft OAuth wcześnie, a SAML/SCIM później jeśli spodziewasz się większych organizacji.

- Email + hasło: jeśli to oferujesz, przechowuj hasła z nowoczesnym haszowaniem (np. Argon2/bcrypt), wymuszaj MFA tam, gdzie to możliwe, i dodaj ograniczenia częstotliwości logowania.

Autoryzacja: role i dostęp do środowisk

Czysty model to RBAC + uprawnienia na poziomie środowiska.

- Admin: zarządza ustawieniami org, użytkownikami, integracjami i uprawnieniami.

- Editor: tworzy i zmienia flagi, segmenty i reguły (ale niekoniecznie w produkcji).

- Viewer: dostęp tylko do odczytu.

Następnie zakresuj tę rolę per środowisko (Dev/Staging/Prod). Na przykład ktoś może być Editor w Staging, ale tylko Viewer w Prod. To zapobiega przypadkowym zmianom w produkcji, a jednocześnie utrzymuje szybkość pracy w innych środowiskach.

Zatwierdzenia dla zmian w produkcji (zalecane)

Dodaj opcjonalny workflow zatwierdzeń dla edycji w produkcji:

- Wymagaj zatwierdzenia, gdy zmiana dotyczy Prod targeting, procentowego rolloutu lub stanu kill switch.

- Zapisuj kto poprosił, kto zatwierdził i co się zmieniło.

- Pozwól na awaryjne nadpisania dla on-call adminów, ale zawsze loguj je.

Zarządzanie sekretami i kluczami SDK

Twoje SDK będą potrzebować poświadczeń do pobierania wartości flag. Traktuj je jak klucze API:

- Oddzielne klucze na środowisko (nie używaj kluczy Dev w Prod).

- Przechowuj tylko hash/części klucza do wyświetlania; pokaż pełny klucz raz przy tworzeniu.

- Wspieraj rotację i natychmiastowe unieważnianie.

- Ogranicz zakres kluczy do odczytu ewaluacji, gdy to możliwe.

Dla lepszej śledzalności powiąż ten rozdział z projektem dziennika audytu w /blog/auditing-monitoring-alerts.

Audyt, monitoring i alerty

Gdy flagi kontrolują realne doświadczenia użytkowników, pytanie „co się zmieniło?” staje się kwestią produkcyjną, nie papierkową. Audyt i monitoring zmieniają narzędzie z panelu przełączników w system operacyjny, któremu zespół może zaufać.

Dziennik audytu: kto, co, kiedy i dlaczego

Każda akcja zapisu w panelu administracyjnym powinna emitować zdarzenie audytu. Traktuj to jako append-only: nigdy nie edytuj historii — dodaj nowy event.

Przechwyć istotne informacje:

- Actor: user ID, email, rola i (jeśli dotyczy) nazwa tokena API

- Action: utworzył/zmienił/usunął flagę, zmienił targetowanie, rozpoczął rollout, włączył kill switch

- Scope: klucz flagi, środowisko, segment i dotknięte reguły

- Diff: before/after (czytelne dla ludzi)

- Powód: wymagane pole „note” dla ryzykownych działań (np. włączenie w produkcji)

- Kontekst: znacznik czasu, IP, user agent, request ID

Uczyń ten log łatwym do przeglądania: filtruj po fladze, środowisku, aktorze i zakresie czasowym. Link „kopiuj link do tej zmiany” jest niezwykle przydatny w wątkach incydentów.

Metryki: udowodnij, co robią flagi

Dodaj lekką telemetrię wokół ewaluacji flag (odczyty SDK) i wyników decyzji (który wariant został podany). Przynajmniej śledź:

- odczyty/ewaluacje per flaga/środowisko

- rozkład wariantów w czasie

- liczby włączeń/wyłączeń i zmian reguł

- wskaźniki błędów i latencji dla usług zależnych od flag

To pomaga zarówno w debugowaniu („czy użytkownicy faktycznie otrzymują wariant B?”), jak i w zarządzaniu („które flagi są martwe i można je usunąć?”).

Alertowanie: szybko wykrywaj regresje

Alerty powinny łączyć zdarzenie zmiany z sygnałem wpływu. Praktyczna reguła: jeśli flaga została włączona (lub zwiększona) i błędy rosną wkrótce potem, zaalarmuj kogoś.

Przykładowe warunki alertów:

- Wzrost error rate o X% w ciągu 10 minut od kroku rollout

- Błąd jednego wariantu znacząco odbiega od pozostałych

- Błędy pobierania konfiguracji (SDK nie może pobrać config) przekraczają próg

Widoki operacyjne do codziennego użytku

Stwórz prosty obszar „Ops” w panelu:

- Niedawne zmiany (z dziennika audytu)

- Aktywne rollouty (aktualny procent, podział wariantów, następny zaplanowany krok)

- Wydarzenia zaplanowane (nadchodzące rampy, wygaszenia, planowane wyłączenia)

Te widoki zmniejszają niepewność podczas incydentów i sprawiają, że rollouty wydają się kontrolowane, a nie ryzykowne.

Niezawodność, wydajność i podstawy skalowania

Reduce risky production flips

Implement production guardrails like approvals and required change notes without heavy process.

Flagi funkcji są na krytycznej ścieżce każdego żądania, więc niezawodność to cecha produktu, nie szczegół infrastruktury. Cel jest prosty: ewaluacja flag powinna być szybka, przewidywalna i bezpieczna, nawet gdy części systemu są zdegradowane.

Warstwy cache (i kiedy ich używać)

Zacznij od cache w pamięci w SDK lub serwisie edge, aby większość ewaluacji nigdy nie trafiała do sieci. Trzymaj cache niewielki i kluczowany po środowisku + wersji zestawu flag.

Dodaj Redis, gdy potrzebujesz wspólnych, niskolatentnych odczytów między wieloma instancjami aplikacji (i aby odciążyć główną bazę). Redis przydaje się też do przechowywania „aktualnego snapshotu flag” per środowisko.

CDN pomaga tylko wtedy, gdy wystawiasz endpoint z flagami do publicznego cache (co często nie jest bezpieczne). Jeśli używasz CDN, preferuj podpisane, krótkotrwałe odpowiedzi i unikaj cache’owania czegokolwiek specyficznego dla użytkownika.

Strategia spójności: polling vs streaming

Polling jest prostszy: SDK pobiera najnowszy snapshot co N sekund z kontrolą ETag/version, aby nie pobierać niezmienionych danych.

Streaming (SSE/WebSockets) daje szybszą propagację dla rolloutów i kill switchy. Jest świetny dla dużych zespołów, ale wymaga więcej uwagi operacyjnej (limity połączeń, logika reconnect, regionalny fanout). Praktyczny kompromis to polling domyślnie z opcjonalnym streamingiem dla środowisk wymagających natychmiastowości.

Ograniczenia szybkości i ochrona przed hot-loopami

Chroń API przed błędną konfiguracją SDK (np. polling co 100ms). Wymuszaj minimalne interwały po stronie serwera na podstawie klucza SDK i zwracaj czytelne błędy.

Zabezpiecz też bazę danych: upewnij się, że ścieżka odczytu opiera się na snapshotach, a nie na „ewaluacji reguł przez zapytania do tabel użytkowników”. Ewaluacja flag nigdy nie powinna uruchamiać kosztownych joinów.

Odzyskiwanie po awarii i bezpieczne domyślne ustawienia

Twórz kopie zapasowe głównej bazy i przeprowadzaj drille przywracania regularnie (nie tylko backupy). Przechowuj niemodyfikowalną historię snapshotów flag, żeby móc szybko cofnąć zmiany.

Zdefiniuj bezpieczne domyślne na czas awarii: jeśli serwis flag nie jest osiągalny, SDK powinny wrócić do ostatniego znanego poprawnego snapshotu; jeśli go brak, domyślnie ustaw „off” dla ryzykownych funkcji i udokumentuj wyjątki (np. flagi krytyczne dla rozliczeń).

Testowanie, wdrażanie i bieżące zarządzanie

Wdrożenie systemu flag to nie „wdróż i zapomnij”. Ponieważ kontroluje zachowanie produkcyjne, chcesz wysokiego poziomu pewności co do ewaluacji reguł, workflow zmian i ścieżek rollback — oraz lekkiego procesu governance, aby narzędzie pozostało bezpieczne wraz z rosnącą adopcją.

Testy: skup się na poprawności i przewidywalności

Zacznij od testów, które zabezpieczają podstawowe obietnice flagowania:

- Testy jednostkowe dla ewaluacji reguł i stabilności bucketingu: weryfikuj logikę targetowania (segmenty, operatory, precedencja) i upewnij się, że procentowe wdrożenia są stabilne względem użytkownika (te same dane wejściowe → ten sam wariant), nawet gdy dodajesz nowe flagi.

- Testy integracyjne dla publish/rollback i kontroli uprawnień: uruchom prawdziwe API + DB: utwórz draft, poproś o zatwierdzenie, opublikuj, potem zrób rollback. Potwierdź, że role mogą/nie mogą wykonywać akcji i że zapisy audytu są tworzone dla każdej zmiany.

Praktyczna wskazówka: dodaj „golden” przypadki testowe dla złożonych reguł (wiele segmentów, fallbacki, sprzeczne warunki), aby regresje były oczywiste.

Praktyki stagingowe odzwierciedlające rzeczywiste użycie

Uczyń staging bezpiecznym polem do prób:

- Zasiej znane segmenty (np. testerzy wewnętrzni, beta customers) i utrzymuj je stabilne.

- Stwórz syntetycznych użytkowników pokrywających edge case’y (brakujące atrybuty, nietypowe locale, nowe konta).

- Uruchom canary samego systemu flag: włącz SDK/ewaluację najpierw dla niewielkiego zestawu usług, potem rozszerzaj.

Lista kontrolna deploymentu i bieżące zarządzanie

Przed wydaniami produkcyjnymi używaj krótkiej listy kontrolnej:

- Migracje schematu są backward-compatible (stare SDK nadal działają).

- Ścieżki kill switch są testowane end-to-end.

- Alerty skonfigurowane na spike błędów i błędy pobierania konfiguracji.

- Dokumentacja aktualna (/docs) i oczekiwania supportowe jasne (/pricing).

Dla governance trzymaj to prosto: określ, kto może publikować do produkcji, wymagaj zatwierdzeń dla flag o dużym wpływie, przeglądaj przestarzałe flagi co miesiąc i ustawiaj pole „data wygaśnięcia”, aby tymczasowe rollouty nie żyły wiecznie.

Jeśli budujesz to jako platformę wewnętrzną, pomaga standaryzacja zgłoszeń zmian. Niektóre organizacje używają Koder.ai do szybkiego stworzenia panelu administracyjnego i iterowania nad workflow (zatwierdzenia, podsumowania audytu, UX rollbacku) w czacie, a potem eksportu kodu do pełnego przeglądu bezpieczeństwa i długoterminowego utrzymania.