19 paź 2025·8 min

Jak zbudować aplikację webową do monitorowania pokrycia automatyzacją

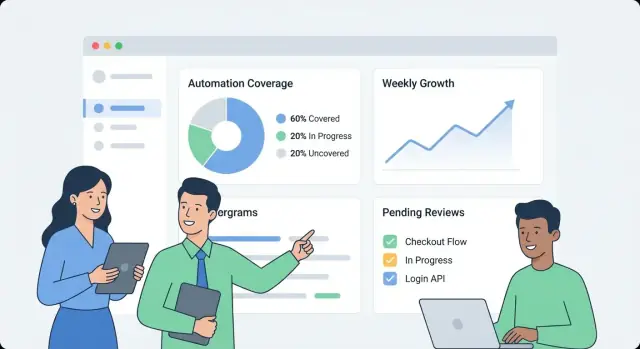

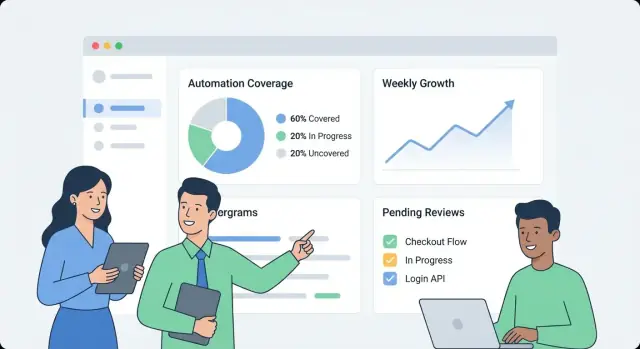

Dowiedz się, jak zaprojektować i zbudować aplikację webową śledzącą pokrycie automatyzacją wewnętrzną: metryki, model danych, integracje, UX pulpitu i alerty.

Dowiedz się, jak zaprojektować i zbudować aplikację webową śledzącą pokrycie automatyzacją wewnętrzną: metryki, model danych, integracje, UX pulpitu i alerty.

Zanim cokolwiek zbudujesz, zapisz, co „pokrycie automatyzacją” znaczy w twojej organizacji. W przeciwnym razie pulpit stanie się zbiorem niepowiązanych liczb, które różne zespoły interpretują inaczej.

Zacznij od wyboru jednostek, które będziesz mierzyć. Typowe opcje to:

Wybierz jedną definicję główną dla v1, a następnie zanotuj typy drugorzędne, które możesz dodać później. Bądź explicite w kwestii przypadków granicznych, jak „półautomatyczne” kroki, które nadal wymagają zatwierdzeń.

Różne odbiorstwa zadają inne pytania:

Zapisz 5–10 „najważniejszych pytań” i potraktuj je jako wymagania produktowe.

Zdefiniuj główne cele: widoczność (co istnieje), priorytetyzacja (co zautomatyzować następne), odpowiedzialność (kto za to odpowiada) i śledzenie trendów (czy to się poprawia).

Ustal jasne granice dla v1. Przykłady: „Nie ocenimy jeszcze jakości,” „Nie będziemy mierzyć zaoszczędzonego czasu,” albo „Uwzględniamy tylko testy uruchamiane w CI, nie lokalne skrypty.”

Na koniec określ, jak wygląda sukces: stałe przyjęcie (aktywni użytkownicy tygodniowo), wysoka świeżość danych (np. aktualizacje w ciągu 24 godzin), mniej martwych punktów (pokrycie zmapowane dla wszystkich krytycznych systemów) i mierzalne działania (właściciele przypisani i luki kurczące się miesiąc do miesiąca).

Zanim zaczniesz mierzyć pokrycie automatyzacją, musisz wiedzieć, gdzie faktycznie znajdują się "dowody automatyzacji". W większości organizacji automatyzacja jest rozproszona po narzędziach przyjętych w różnych momentach przez różne zespoły.

Zacznij od pragmatycznej inwentaryzacji, która odpowie: Jakie sygnały udowadniają, że aktywność jest zautomatyzowana i skąd możemy je pobrać?

Typowe źródła obejmują pipeline’y CI (zadania build/test), frameworki testowe (wyniki unit/integration/E2E), narzędzia workflow (zatwierdzenia, wdrożenia, przejścia w ticketach), runbooki (skrypty i udokumentowane procedury) oraz platformy RPA. Dla każdego źródła zanotuj identyfikator, na którym będziesz łączyć dane później (repo, nazwa usługi, środowisko, zespół) oraz „dowód”, który będziesz przechowywać (uruchomienie zadania, raport testów, reguła automatyzacji, wykonanie skryptu).

Następnie wypisz systemy ewidencyjne, które definiują, co „powinno istnieć”: hosting repo, tracker zadań i CMDB/katalog usług. Te źródła zazwyczaj dostarczają autorytatywnej listy usług, właścicieli i krytyczności — niezbędnych do obliczania pokrycia zamiast jedynie liczenia aktywności.

Dopasuj każde źródło do najmniej kruchej metody ingestowania:

Zanotuj limity szybkości, metody uwierzytelniania (PAT, OAuth, konta serwisowe), okna retencji oraz znane problemy z jakością danych (zmienione nazwy usług, niespójne nazewnictwo, brak właścicieli).

Na koniec zaplanuj ocenę niezawodności źródła dla każdego konektora (i opcjonalnie dla każdej metryki), aby użytkownicy widzieli, czy liczba jest „wysokiego zaufania” czy „najlepszy wysiłek”. To zapobiega fałszywej precyzji i pomaga priorytetyzować poprawki konektorów później.

Użyteczny pulpit pokrycia zaczyna się od modelu danych, który oddziela to, co ma być zautomatyzowane, od tego, co faktycznie było uruchomione ostatnio. Jeżeli to pomieszasz, liczby mogą wyglądać dobrze nawet jeśli automatyzacja jest przeterminowana.

Zacznij od tych elementów budulcowych:

Wybierz jeden poziom raportowania i się go trzymaj:

Możesz wspierać wiele widoków później, ale pierwsza wersja powinna mieć jeden poziom „źródła prawdy”.

Używaj ID, które przetrwają refaktory:

Traktuj nazwy wyświetlane jako edytowalne, a nie jako identyfikatory.

Praktyczny wzorzec:

To pozwala odpowiedzieć: „Co powinno być pokryte?”, „Co twierdzi, że to pokrywa?” i „Co faktycznie zostało uruchomione?”

Zapisuj:

last_seen_at (asset nadal istnieje)last_run_at, last_failure_atlast_reviewed_at (ktoś potwierdził, że roszczenie jest nadal ważne)Pola świeżości umożliwiają wyróżnienie elementów „pokrytych, ale przeterminowanych” bez sporu.

Jeżeli twoja metryka pokrycia jest nieostra, każdy wykres stanie się przedmiotem dyskusji. Zacznij od wyboru jednej głównej metryki dla podsumowań kierowniczych, potem dodaj rozbicia dla zespołów.

Większość organizacji wybiera jedną z poniższych:

Możesz pokazywać wszystkie trzy, ale jawnie określ, która jest „nagłówkową” liczbą.

Spisz jasne reguły, aby zespoły punktowały elementy spójnie:

Utrzymuj reguły mierzalne. Jeśli dwie osoby nie mogą ocenić tego samego elementu w ten sam sposób, doprecyzuj definicję.

Używaj małych skal całkowitych (1–5) dla wejść takich jak ryzyko, wpływ biznesowy, częstotliwość uruchomień i oszczędzony czas. Przykład: weight = risk + impact + frequency.

Nie licz elementu jako „zautomatyzowanego”, chyba że ma dowód, np.:

To przekształca pokrycie z samodzielnie zgłaszanych roszczeń w obserwowalny sygnał.

Umieść zasady punktacji i przykłady na jednej wspólnej stronie (odwołaj ją w panelu). Spójna interpretacja to to, co daje zaufanie do trendów.

Wewnętrzna aplikacja do monitorowania pokrycia powinna być „nudna w najlepszym sensie": łatwa w obsłudze, łatwa do zmiany i jasna co do źródła liczb. Prosty kształt „API + baza danych + pulpit” zwykle bije rozproszony system, dopóki naprawdę go nie potrzebujesz.

Wybierz stack, który twój zespół już wspiera. Typowy baseline to:

Jeśli chcesz przyspieszyć wersję wewnętrzną, podejście „vibe-coding” może się sprawdzić: na przykład Koder.ai może pomóc wygenerować dashboard React oraz backend w Go + PostgreSQL z strukturalnej specyfikacji, a potem pozwolić zespołowi iterować przez czat, zachowując pełny eksport kodu i normalne wdrożenie.

Nawet w „prostym” systemie rozdziel odpowiedzialności:

Użyj tabel relacyjnych dla kanonicznych encji (zespoły, usługi, automatyzacje, dowody, właściciele). Dla trendów (uruchomienia w czasie, pokrycie po tygodniach) trzymaj:

Jeżeli wiele zespołów będzie współdzieliło aplikację, dodaj pola org_id/team_id wcześnie. To umożliwia uprawnienia i unika bolesnych migracji, gdy kierownictwo poprosi o „jeden pulpit, ale segmentowany”.

Uruchamiaj dev/staging/prod i zdefiniuj, jak dane się przemieszczają:

Dla dodatkowych wskazówek o projektowaniu użyteczności pulpitu zobacz przewodnik projektowania pulpitu.

Panel pokrycia szybko staje się źródłem prawdy, więc kontrola dostępu i obsługa danych są tak samo ważne jak wykresy. Zacznij prosto, ale zaprojektuj tak, aby bezpieczeństwo mogło być zaostrzone bez dużych przepisań.

Jeżeli firma ma SSO, zintegruj je od pierwszego dnia (OIDC jest często najłatwiejsze; SAML bywa powszechny w większych organizacjach). Jeśli potrzebujesz szybkiego wewnętrznego uruchomienia, możesz zacząć za istniejącym proxy uwierzytelniającym, które injektuje nagłówki tożsamości, a potem przełączyć się na natywne SSO.

Niezależnie od drogi, normalizuj tożsamość do stabilnego klucza użytkownika (email może się zmienić). Przechowuj minimalny profil użytkownika i pobieraj członkostwo w grupach/zespołach na żądanie, jeśli to możliwe.

Zdefiniuj mały zestaw ról i trzymaj autoryzację spójną w UI i API:

Preferuj uprawnienia zakresowe (po zespole/usłudze) zamiast „superużytkowników”. Zmniejsza to ryzyko i unika wąskich gardeł.

Dowody pokrycia często zawierają linki do logów CI, ticketów incydentów lub wewnętrznych dokumentów. Ogranicz dostęp do tych URLi i surowych logów. Przechowuj tylko to, co potrzebne do weryfikacji (np. ID buildu, znacznik czasu i krótkie podsumowanie) zamiast kopiować całe logi do bazy danych.

Każda ręczna edycja roszczeń pokrycia lub metadanych powinna tworzyć rekord audytu: kto zmienił co, kiedy i dlaczego (powód w formie tekstu). Wreszcie, ustaw politykę retencji dla historii uruchomień i dowodów — określ jak długo je przechowywać i wdroż bezpieczne czyszczenie, aby stare rekordy można było usuwać bez psucia bieżących kalkulacji pokrycia.

Pulpit pokrycia odniesie sukces, gdy ktoś odpowie na trzy pytania w mniej niż minutę: Jak sobie radzimy? Co się zmienia? Co powinniśmy naprawić dalej? Projektuj UX wokół tych decyzji, nie źródeł danych.

Zrób pierwszy ekran prostym przeglądem:

Utrzymuj etykiety w języku zrozumiałym („Zautomatyzowane niedawno” jest lepsze niż „Evidence recency”), i unikaj zmuszania czytelników do interpretowania statusów technicznych.

Z dowolnego podsumowania pozwól użytkownikom kliknąć stronę usługi/procesu, która odpowie "co" i "przez co":

Projektuj każdy wiersz/kartę tak, by zawierała „dlaczego liczba wygląda tak, a nie inaczej”: link do dowodu, właściciel, ostatni status uruchomienia i jasny następny krok („Ponów zadanie”, „Przypisz właściciela”, „Dodaj brakujący dowód”).

Oferuj filtry mapujące na sposób pracy organizacji:

Trzymaj stan filtrów widoczny i możliwy do udostępnienia (parametry w URL), aby ktoś mógł wysłać link typu „Prod + Tier-1 + ostatnie 14 dni” do interesariusza.

Używaj krótkich definicji inline, nie długiej dokumentacji:

Integracje to moment, w którym twoja aplikacja staje się realna. Celem nie jest odwzorowanie wszystkich funkcji CI czy narzędzi testowych — chodzi o wyciągnięcie spójnego zestawu faktów: co się uruchomiło, kiedy, co pokrywało i kto jest właścicielem.

Zacznij od systemów, które już generują sygnały automatyzacji: CI (GitHub Actions, GitLab CI, Jenkins), runner’y testowe (JUnit, pytest) i narzędzia jakości (raporty coverage, linters, skany bezpieczeństwa).

Konektor powinien pobierać (lub otrzymywać przez webhook) minimalny payload:

Trzymaj konektory idempotentne: powtarzane pobrania nie powinny tworzyć duplikatów.

Niektóre luki w pokryciu są celowe (stare systemy, ograniczenia zewnętrzne, zawieszone inicjatywy). Udostępnij lekką rekordację „wyjątku”, która wymaga:

To zapobiega trwałym martwym punktom i utrzymuje widoki kierownicze w zgodzie z rzeczywistością.

Różne źródła rzadko zgadzają się co do identyfikatorów: jedno mówi „payments-service”, inne „payments”, a trzecie używa slug repo.

Stwórz reguły normalizujące dla:

Zrób to wcześnie; każda metryka zależy od tej normalizacji.

Wprowadź tabele aliasów (np. service_aliases, repo_aliases) mapujące wiele zewnętrznych nazw na jedną kanoniczną encję. Gdy przychodzi nowe dane, najpierw dopasuj do kanonicznych ID, potem do aliasów.

Jeśli nowa nazwa nie pasuje, generuj sugestie scalania (np. „payments-api” wygląda jak „payments-service”) dla administratora do zatwierdzenia.

Zaplanuj cyklicne zadanie, które sprawdza najnowszy znacznik czasu uruchomienia per źródło i flaguje wszystko przeterminowane (np. brak uruchomień CI przez 7 dni). Eksponuj to w UI, aby niskie pokrycie nie było mylone z brakującymi danymi.

Pulpit jest przydatny, ale alerty i lekkie workflowy zamieniają obserwacje w stałą poprawę. Cel jest prosty: powiadomić właściwe osoby we właściwym czasie z wystarczającym kontekstem do działania.

Zacznij od małego zestawu alertów o wysokim sygnale:

Każdy alert powinien prowadzić bezpośrednio do odpowiedniego widoku szczegółowego (np. strona usługi — widok szczegółowy pokrycia lub strona zespołu — widok właścicieli), aby nie tracić czasu na poszukiwanie kontekstu.

Unikaj jednego progu dla wszystkich. Pozwól zespołom ustawiać reguły takie jak:

To utrzymuje sygnały znaczące i zmniejsza zmęczenie alertami.

Wysyłaj alerty do istniejących kanałów (email, Slack), i dołącz: co się zmieniło, dlaczego to ważne i kto jest właścicielem. Obok alertów realtime dodaj cotygodniowe podsumowanie obejmujące:

Traktuj alerty jak zadania: pozwól na potwierdzenie, przypisanie i status (otwarte/triaged/rozwiązane). Krótka ścieżka komentarzy („naprawiono w PR #1234”) sprawia, że raportowanie jest wiarygodne i zapobiega cichemu powrotowi problemów.

Pulpit monitorujący wydaje się szybki, gdy API odpowiada na pytania, których UI naprawdę potrzebuje — bez zmuszania przeglądarki do składania dziesiątek zapytań. Zacznij od minimalistycznego, dashboard-first API, potem dodaj zadania w tle, które prekomputują kosztowne rzeczy.

Skup się na pierwszej wersji na ekranach kluczowych:

GET /api/services (filtry jak zespół, język, tier)GET /api/services/{id}/coverage (ogólny wynik + kluczowe rozbicia)GET /api/services/{id}/evidence?status=passed&since=...PATCH /api/services/{id}Projektuj odpowiedzi tak, aby dashboard mógł się wyrenderować natychmiast: w jednym payloadzie zwracaj nazwę usługi, właściciela, ostatni czas dowodu i aktualny wynik, zamiast wymagać dodatkowych zapytań.

Listy i tabele drill-down powinny być zawsze paginowane (limit + cursor). Dla często wywoływanych endpointów dodaj cache na warstwie API (lub wspólny cache) kluczowany filtrem i zakresem dostępu wywołującego.

Dla wszystkiego, co wymaga skanowania dużych ilości dowodów (np. „pokrycie według zespołu”), prekomputuj rollupy w zadaniu nocnym. Przechowuj rollupy w osobnej tabeli (lub w widoku materializowanym), aby odczyty były proste i przewidywalne.

Trendy są najprostsze, gdy przechowujesz dziennie snapshoty:

GET /api/services/{id}/trend?days=90.Snapshoty unikają przeliczania historycznych metryk przy każdym ładowaniu strony i ułatwiają wykresowanie „świeżości”.

Wygodne onboarding masowy to:

POST /api/import/services (upload CSV)GET /api/export/services.csvNa koniec wymuszaj walidację przy zapisie: wymagany owner, dozwolone wartości statusu i sensowne znaczniki czasowe (brak „przyszłych” dowodów). Odrzucanie złych danych wcześnie zapobiega powolnym i mylącym poprawkom później — szczególnie gdy rollupy zależą od spójnych danych.

Pulpit pokrycia jest użyteczny tylko wtedy, gdy ludzie mu ufają. Traktuj wdrożenie i operacje jako część produktu: przewidywalne wydania, jasne sygnały zdrowia i proste odzyskiwanie, gdy coś się zepsuje.

Dla aplikacji wewnętrznej optymalizuj niskie koszty utrzymania i szybkie iteracje.

Jeśli używasz platformy takiej jak Koder.ai do przyspieszenia rozwoju, skorzystaj z eksportu kodu źródłowego i workflowów wdrożeniowych wcześnie, żeby wewnętrzna aplikacja nadal stosowała standardowe praktyki promocji, przeglądu i rollbacku.

Nie potrzebujesz skomplikowanego stosu, żeby uzyskać wiarygodne sygnały.

Skonfiguruj automatyczne backupy bazy i politykę retencji pasującą do potrzeb.

Udokumentuj runbooki na:

Niewielka dyscyplina operacyjna zapobiega temu, by „pokrycie” stało się domysłem.

Aplikacja monitorująca pomaga tylko wtedy, gdy zespoły jej ufają i z niej korzystają. Traktuj wdrożenie jak premierę produktu: zacznij od małego zakresu, określ jasne właścicielstwo i wprowadź regularny rytm aktualizacji.

Utrzymuj onboarding lekki i powtarzalny:

Dobry cel to „pierwszy widok dashboardu w 30 minut”, a nie tygodniowa konfiguracja.

Ustal dwa rytmy:

Wyniki pokrycia mogą stać się polityczne, jeśli zasady zmieniają się bez ostrzeżenia. Wyznacz małą grupę zarządzającą (często Eng Productivity + Security/Quality), która może:

Publikuj zmiany w prostym changelogu.

Śledź adopcję kilkoma prostymi metrykami: aktywni użytkownicy, śledzone usługi i zgodność świeżości (ile usług ma aktualne dowody). Używaj tych wskaźników do kierowania iteracją: lepsze ważenie, bogatsze typy dowodów i dodatkowe konektory — zawsze priorytetyzując zmiany, które zmniejszają pracę ręczną zespołów.

Jeżeli zdecydujesz się dzielić wewnętrzne wnioski publicznie, rozważ ustandaryzowanie notatek z budowy i szablonów: zespoły używające Koder.ai mogą też zdobywać kredyty, tworząc treści o swoim workflowie lub polecając innych użytkowników, co może pomóc finansować dalsze iteracje narzędzi wewnętrznych.

Pokrycie automatyzacją to to, co organizacja uzna za „pracę wykonaną automatycznie” w przeciwieństwie do ręcznej. Aby uniknąć nieporozumień, wybierz jednostkę podstawową dla wersji v1 (na przykład: procesy, wymagania/kontrole, zestawy testów lub runbooki) i zapisz jasne zasady dla przypadków granicznych, np. „częściowo zautomatyzowane” kroki, które nadal wymagają zatwierdzeń.

Dobra definicja to taka, w której dwie osoby oceniłyby dany element tak samo.

Zacznij od zapisania 5–10 „najważniejszych pytań”, na które użytkownicy muszą uzyskać odpowiedź, i traktuj je jako wymagania produktu. Typowe przykłady:

Różne grupy (QA, Ops, kierownictwo) potrzebują innych perspektyw, więc zdecyduj, kogo wersja v1 ma priorytetowo obsłużyć.

Zrób inwentaryzację, gdzie znajdują się dowody automatyzacji i jakie źródła zawierają autorytatywną listę tego, co powinno istnieć.

Bez systemu ewidencyjnego można policzyć aktywność, ale nie da się wiarygodnie obliczyć pokrycia, bo nie zna się pełnego zbioru celów.

Wybierz metodę ingestowania najmniej podatną na błędy dla każdego źródła:

Dokumentuj też ograniczenia konektorów (limit szybkości, auth, okna retencji), aby użytkownicy rozumieli świeżość danych i poziom zaufania.

Oddziel zamiary, roszczenia i dowody, żeby metryki nie wyglądały na „zielone”, gdy automatyzacja jest przeterminowana.

Praktyczny model:

Używaj pól świeżości i reguł dowodu.

Typowe pola:

last_seen_at (asset nadal istnieje)last_run_at, last_failure_atlast_reviewed_at (ktoś potwierdził, że roszczenie nadal obowiązuje)Wymuszaj regułę np. „liczy się jako zautomatyzowane tylko jeśli jest N udanych uruchomień w ciągu ostatnich 30 dni”. To oddziela „istnieje” od „działa ostatnio”.

Wybierz jedną metrykę nagłówkową i zapisz zasady punktacji.

Typowe opcje nagłówkowe:

Utrzymuj proste wagi (np. skala 1–5) i dokumentuj, co znaczy „zautomatyzowane / częściowo zautomatyzowane / ręczne” z konkretnymi przykładami.

Normalizuj identyfikatory wcześnie i obsługuj zmiany nazw explicite.

Praktyczne kroki:

service_aliases, repo_aliases) mapujące zewnętrzne nazwy na kanoniczne ID.Dzięki temu unikniesz duplikatów i zachowasz spójność trendów historycznych przy reorganizacjach lub zmianach nazw.

Zacznij od SSO (OIDC/SAML), jeśli jest dostępne, lub tymczasowo użyj wewnętrznego proxy auth, które wstrzykuje nagłówki tożsamości. Zdefiniuj mały zestaw ról i trzymaj uprawnienia spójne w UI i API:

Przechowuj minimalne dowody wrażliwe: lepiej trzymać ID buildu, znaczniki czasowe i krótkie streszczenie niż kopiować pełne logi. Audytuj ręczne zmiany (kto/co/kiedy/ dlaczego) i zdefiniuj retencję dla historii uruchomień.

Rób alerty działające i unikaj ogólnego hałasu.

Typy alertów o wysokim sygnale:

Pozwól zespołom ustawiać progi (różne okna „stale” i reguły powiadomień). Dodaj deep linki do widoków szczegółowych i obsługuj potwierdzanie/przypisywanie/status, aby zamykać sprawy.

Dodaj własność (zespół/osoba) i stabilne identyfikatory, aby zmiany nazw nie psuły historii.