Zdefiniuj cele, pytania i miary sukcesu

Zanim zaczniesz cokolwiek śledzić, ustal, co „adopcja funkcji” faktycznie znaczy dla Twojego produktu. Jeśli pominiesz ten krok, zbierzesz dużo danych — i wciąż będziecie się spierać na spotkaniach, co one „znaczą”.

Zdefiniuj „adopcję” prostym językiem

Adopcja zwykle nie jest pojedynczym momentem. Wybierz jedną lub więcej definicji, które pasują do tego, jak dostarczana jest wartość:

- Użycie: użytkownik wypróbowuje funkcję przynajmniej raz (dobre przy nowych wdrożeniach).

- Powtórne użycie: użytkownik korzysta z niej ponownie w określonym oknie czasowym (dobre dla działań tworzących nawyk).

- Osiągnięta wartość: użytkownik osiąga rezultat, który funkcja miała umożliwić (często najlepszy sygnał).

Przykład: dla „Zapisanych Wyszukiwań” adopcja może oznaczać utworzył zapisane wyszukiwanie (użycie), uruchomił je 3+ razy w 14 dni (powtórne) oraz otrzymał alert i kliknął dalej (osiągnięta wartość).

Wypisz decyzje, które ma wspierać śledzenie

Twoje śledzenie powinno odpowiadać na pytania prowadzące do działania, takie jak:

- Co powinniśmy ulepszyć, bo jest używane, ale nie dostarcza wartości?

- Co powinniśmy usunąć, bo dodaje złożoność przy niskiej adopcji?

- Co powinniśmy promować, bo zwiększa retencję lub konwersje?

Zapisz je jako stwierdzenia decyzyjne (np. „Jeśli aktywacja spada po wydaniu X, wycofujemy zmiany w onboarding’u.”).

Zidentyfikuj interesariuszy i sposób użycia raportów

Różne zespoły potrzebują różnych widoków:

- Product (PM): adopcja według segmentu, wpływ po wydaniu, kamienie wartości.

- Growth/Marketing: efekt kampanii, lejki konwersji, ponowne angażowanie.

- Support/Success: które funkcje korelują z mniejszą liczbą zgłoszeń lub lepszymi odnowieniami.

- Engineering: zdrowie instrumentacji, zmiany wolumenu zdarzeń, markery wydań.

Ustal miary sukcesu i rytm przeglądu

Wybierz niewielki zestaw metryk do przeglądu co tydzień, oraz lekką kontrolę po wydaniu po każdej deployacji. Zdefiniuj progi (np. „wskaźnik adopcji ≥ 25% wśród aktywnych użytkowników w 30 dni”), aby raporty napędzały decyzje, a nie dyskusje.

Zmapuj dane, których potrzebujesz: użytkownicy, funkcje, zdarzenia, rezultaty

Zanim cokolwiek zinstrumentujesz, zdecyduj, jakie „byty” opisze Twój system analityczny. Jeśli dobrze dobierzesz te encje, raporty pozostaną zrozumiałe, nawet gdy produkt się zmieni.

Zacznij od podstawowych encji

Zdefiniuj każdą encję prostym językiem, a potem zamień na ID, które przechowasz:

- User: osoba korzystająca z aplikacji (może zaczynać anonimowo, potem się uwierzytelnia).

- Account / workspace: płacący klient lub kontener zespołu, do którego należy wielu użytkowników.

- Session: wizytę ograniczoną czasowo (użyteczne dla zaangażowania i debugowania; opcjonalne).

- Feature: nazwana funkcjonalność, dla której chcesz mierzyć adopcję (często grupa zdarzeń, nie pojedynczy klik).

- Event: akcja lub zdarzenie systemowe, które możesz zarejestrować (np.

project_created, invite_sent).

- Outcome: kamień milowy wartości, który chcesz, by użytkownicy/konta osiągnęli (np. „pierwszy udostępniony raport”, „aktywowana subskrypcja”).

Zapisz minimalne właściwości, których potrzebujesz dla każdego zdarzenia: user_id (lub anonymous_id), account_id, timestamp i kilka istotnych atrybutów (plan, rola, urządzenie, feature flag itp.). Unikaj wrzucania wszystkiego „na wypadek”.

Wybierz widoki adopcji, które będziesz wspierać

Dopasuj kąty raportowania do celów produktu:

- Lejki (krok po kroku aktywacja)

- Kohorty (grupy wg daty rejestracji, planu, kanału)

- Retencja (czy wracają i powtarzają kluczowe akcje?)

- Ścieżki (częste sekwencje przed/po kamieniu)

- Time-to-first-value (jak długo do pierwszej znaczącej wartości)

Projekt zdarzeń powinien ułatwiać te obliczenia.

Bądź konkretny co do zakresu: tylko web najpierw, czy web + mobile od początku. Śledzenie cross-platformowe jest najprostsze, jeśli wcześnie zunifikujesz nazwy zdarzeń i właściwości.

Na koniec ustal niepodważalne cele: akceptowalny wpływ na wydajność strony, opóźnienie ingestu (jak świeże muszą być dashboardy) i czas ładowania dashboardu. Te ograniczenia będą prowadzić wybory dotyczące śledzenia, przechowywania i zapytań.

Zaprojektuj schemat śledzenia zdarzeń, który pozostanie spójny

Dobry schemat śledzenia to mniej „śledź wszystko”, a bardziej przewidywalność zdarzeń. Jeśli nazwy zdarzeń i właściwości będą dryfować, dashboardy się zepsują, analitycy przestaną ufać danym, a inżynierowie będą wahać się przed instrumentacją nowych funkcji.

Zacznij od jasnej konwencji nazewniczej

Wybierz prosty, powtarzalny wzorzec i trzymaj się go. Popularny wybór to verb_noun:

viewed_pricing_pagestarted_trialenabled_featureexported_report

Stosuj konsekwentnie jedną formę czasową i unikaj synonimów (clicked, pressed, tapped) chyba że naprawdę znaczą różne rzeczy.

Zdefiniuj wymagane właściwości ("kontrakt")

Każde zdarzenie powinno mieć mały zestaw wymaganych właściwości, aby później móc segmentować, filtrować i joinować wiarygodnie. Minimum:

user_id (nullable dla anonimowych, ale obecne gdy znane)account_id (jeśli produkt jest B2B/multi-seat)timestamp (generowany po stronie serwera jeśli to możliwe)feature_key (stabilny identyfikator, np. "bulk_upload")plan (np. free, pro, enterprise)

Te pola znacznie ułatwiają śledzenie adopcji i analitykę zachowań, bo nie musisz zgadywać, co brakuje w danym zdarzeniu.

Pozwól na właściwości opcjonalne — ostrożnie

Pola opcjonalne dodają kontekst, ale łatwo je przedobrzyć. Typowe przykłady:

device, os, browserpage, referrerexperiment_variant (lub ab_variant)

Trzymaj nazwy kluczy i formaty wartości spójne między zdarzeniami i dokumentuj dozwolone wartości, gdy to możliwe.

Wersjonuj schemat i napisz specyfikację instrumentacji

Zakładaj, że schemat będzie ewoluował. Dodaj event_version (np. 1, 2) i podnoś ją przy zmianie znaczenia lub wymaganych pól.

Na koniec napisz specyfikację instrumentacji, która wymienia każde zdarzenie, moment wywołania, wymagane/opcjonalne właściwości i przykłady. Trzymaj ten dokument w kontroli źródła obok aplikacji, żeby zmiany schematu były przeglądane jak kod.

Rozwiąż problem tożsamości: anonimowi, zalogowani i widoki na poziomie konta

Jeśli model tożsamości jest niestabilny, metryki adopcji będą zaszumione: lejki nie będą się zgadzać, retencja będzie wyglądać gorzej niż w rzeczywistości, a „aktywni użytkownicy” będą zawyżeni przez duplikaty. Cel to wspierać jednocześnie trzy widoki: anonimowych odwiedzających, zalogowanych użytkowników i aktywność kont/workspace.

Anonimowi vs zidentyfikowani użytkownicy (kiedy łączyć)

Zacznij każde urządzenie/sesję od anonymous_id (cookie/localStorage). W momencie uwierzytelnienia powiąż tę anonimową historię z user_id.

Łącz tożsamości, gdy użytkownik udowodni własność konta (udane logowanie, weryfikacja magic link, SSO). Unikaj łączenia na słabych sygnałach (np. wpisany adres e-mail) chyba że wyraźnie oznaczysz to jako „pre-auth”.

Logowanie, wylogowanie i przełączanie kont bez łamania metryk

Traktuj przejścia auth jako zdarzenia:

login_success (zawiera user_id, account_id i aktualny anonymous_id)logoutaccount_switched (z account_id → account_id)

Ważne: nie zmieniaj anonymous cookie przy wylogowaniu. Jeśli je rotujesz, pogrubisz sesje i zawyżysz unikalnych użytkowników. Zamiast tego zachowaj stabilne anonymous_id, ale przestań dołączać user_id po wylogowaniu.

Zasady łączenia tożsamości (i jak unikać podwójnego liczenia)

Zdefiniuj reguły łączenia jasno:

- Merge użytkowników: preferuj stabilne wewnętrzne

user_id. Jeśli musisz mergować po e-mailu, rób to po stronie serwera i tylko dla zweryfikowanych adresów. Zachowaj ślad audytu.

- Merge kont: używaj stabilnego

account_id/workspace_id generowanego przez system, nie mutowalnej nazwy.

Przy łączeniu zrób tabelę mapowań (stare → nowe) i stosuj ją konsekwentnie w zapytaniach lub przez backfill. To zapobiega pojawianiu się „dwóch użytkowników” w kohortach.

Przechowuj stabilne klucze

Przechowuj i wysyłaj:

anonymous_id (stabilny dla przeglądarki/urządzenia)user_id (stabilny dla osoby)account_id (stabilny dla workspace)

Dzięki tym trzem kluczom możesz mierzyć zachowanie przed logowaniem, adopcję na poziomie użytkownika i adopcję na poziomie konta bez podwójnego liczenia.

Wybierz śledzenie po stronie klienta vs serwera (i mieszaj je)

Miejsce, gdzie śledzisz zdarzenia, zmienia to, na ile możesz ufać danym. Zdarzenia przeglądarkowe mówią, co ludzie próbowali zrobić; zdarzenia serwerowe mówią, co faktycznie się wydarzyło.

Śledzenie po stronie klienta (przeglądarka)

Używaj go do interakcji UI i kontekstu, który masz tylko w przeglądarce. Typowe przykłady:

- Widoki stron/ekranów, kliknięcia przycisków, zmiany zakładek, otwieranie/zamykanie modalów

- „Obejrzano funkcję” (np. otwarcie strony ustawień)

- Kontekst klienta: URL, referrer, UTM, typ urządzenia, rozdzielczość ekranu, język

Batchuj zdarzenia, by ograniczyć ruch sieciowy: kolekcjonuj w pamięci, wypuszczaj co N sekund albo po N zdarzeniach, oraz flushuj przy visibilitychange/ukryciu strony.

Śledzenie po stronie serwera (API i zadania)

Używaj go dla zdarzeń reprezentujących ukończony rezultat lub akcje krytyczne dla rozliczeń/bezpieczeństwa:

- Funkcja włączona/wyłączona zapisana poprawnie

- Zaproszenie zaakceptowane, płatność zakończona, eksport wygenerowany

- Zadania backgroundowe: sync zakończony, raport dostarczony, e-mail wysłany

Śledzenie serwerowe jest zwykle dokładniejsze, bo nie blokują go ad blockery, przeładowania strony czy niestabilne połączenie.

Rekomendowane podejście: domyślnie hybrydowe

Praktyczny wzorzec: śledź intencję w kliencie i sukces na serwerze.

Na przykład emituj feature_x_clicked_enable (klient) i feature_x_enabled (serwer). Następnie wzbogacaj zdarzenia serwera kontekstem z klienta, przekazując lekki context_id (lub request ID) z przeglądarki do API.

Niezawodność: retry, backoff, buforowanie offline

Dodaj odporność tam, gdzie zdarzenia najczęściej znikają:

- Klient: zachowaj małą kolejkę w

localStorage/IndexedDB, retry z wykładniczym backoffem, limit prób i deduplikację po event_id.

- Serwer: retry przy błędach przejściowych, użyj wewnętrznej kolejki i zapewnij idempotencję, aby retry nie powodował podwójnego zliczania.

Ten miks daje bogaty kontekst behawioralny bez rezygnacji z zaufanych metryk adopcji.

Zaplanuj architekturę systemu: ingest, storage i zapytania

Szybciej opracuj schemat zdarzeń

Zamień schemat zdarzeń i wymagane właściwości w endpointy, tabele i dokumentację w jednym miejscu.

Aplikacja analityczna do adopcji funkcji to głównie pipeline: rejestruj zdarzenia niezawodnie, przechowuj je tanio i zapytuj wystarczająco szybko, by ludzie ufali wynikom.

Główne komponenty (i dlaczego są ważne)

Zacznij od prostego, separowalnego zestawu usług:

- Collector endpoint: mała usługa HTTP przyjmująca zdarzenia (z przeglądarki, mobile, backendu). Trzymaj ją szybką i minimalistyczną — waliduj podstawy, dodaj znacznik czasu po stronie serwera i zwracaj szybko.

- Queue/stream: buforuje skoki ruchu i odplątuje ingest od przetwarzania (Kafka, Kinesis, Pub/Sub, SQS).

- Workers: konsumują stream, wzbogacają, deduplikują, egzekwują schemat i kierują dane do store.

- Analytics store: zoptymalizowany do dużych, dopisywanych zdarzeń (ClickHouse, BigQuery, Snowflake, Redshift).

- API: udostępnia spójne endpointy zapytań dla dashboardów (lejki, kohorty, retencja) i uprawnień.

- UI: pulpity i narzędzia eksploracji; trzymaj je oddzielnie, żeby móc zmieniać storage/logikę zapytań bez przepisywania frontend.

Jeśli chcesz szybko prototypować wewnętrzną aplikację analityczną, platforma vibe-codingowa jak Koder.ai może pomóc postawić UI dashboardu (React) i backend (Go + PostgreSQL) z chat-driven spec — użyteczne do uzyskania pierwszego „working slice” przed utwardzeniem pipeline.

Storage: surowe zdarzenia vs agregaty

Używaj dwóch warstw:

- Append-only raw events dla audytu i reprocessingu. Traktuj to jako źródło prawdy.

- Aggregaty/materialized views dla szybkości (DAU, aktywni użytkownicy funkcji, liczniki kroków lejka). Widoki materializowane są przydatne, gdy te same zapytania są wykonywane stale.

Real-time vs batch (wybierz zależnie od decyzji)

Wybierz świeżość, której zespół rzeczywiście potrzebuje:

- Near real-time (sekundy/minuty) jeśli monitorujesz launchy, dropy onboardingu lub outage’y.

- Codzienny batch do raportów trendów, tygodniowej adopcji i podsumowań dla zarządu — tańszy i prostszy.

Wiele zespołów stosuje oba: real-time liczniki do „co się dzieje teraz” oraz nocne joby przeliczające kanoniczne metryki.

Plan skalowania: partycjonowanie i wzrost

Projektuj skalowalnie wcześnie przez partycjonowanie:

- Po czasie (dziennie/miesięcznie) aby zapytania były ograniczone i polityki retencji proste.

- Po koncie/tenant by wspierać uprawnienia B2B i wydajność.

- Opcjonalnie po typie zdarzenia jeśli kilka zdarzeń generuje ogromny wolumen.

Planuj retencję (np. 13 miesięcy surowych zdarzeń, dłużej dla agregatów) i ścieżkę replay, aby naprawiać błędy przez reprocessing zamiast łatać dashboardy.

Modelowanie danych dla zdarzeń i szybkich zapytań analitycznych

Dobra analityka zaczyna się od modelu, który szybko odpowiada na typowe pytania (lejki, retencja, użycie funkcji) bez robienia z każdego zapytania projektu inżynierskiego.

Wybierz strategię dwóch warstw bazy danych

Większość zespołów najlepiej radzi sobie z dwoma magazynami:

- Relacyjna DB (Postgres/MySQL) dla „stabilnych” metadanych, które zmieniają się rzadko: użytkownicy, konta, definicje funkcji, kontrola dostępu i konfiguracja.

- Columnar/warehouse (ClickHouse/BigQuery/Snowflake) dla wysokowolumenowych zdarzeń, gdzie potrzebujesz szybkich skanów i agregacji.

To rozdzielenie utrzymuje bazę produktu lekką, a zapytania analityczne tańsze i szybsze.

Zdefiniuj podstawowe tabele (i trzymaj je nudnymi)

Praktyczne minimum wygląda tak:

- raw_events: jeden wiersz na zdarzenie (event_name, timestamp, user_id/anonymous_id, session_id, account_id, properties JSON, source).

- users: profil użytkownika + bieżące identyfikatory.

- accounts: encja firmy/organizacji do rollupów B2B.

- feature_catalog: kanoniczna lista funkcji (key, display_name, category, lifecycle status).

- sessions: granice sesji (start/end, device, referrer) dla analizy zachowań.

- aggregates: prekomputowane metryki dzienne/tygodniowe (np. DAU, feature_active_users, liczniki kroków lejka).

W magazynie denormalizuj to, co często zapytujesz (np. skopiuj account_id do zdarzeń), aby uniknąć kosztownych joinów.

Kontroluj koszty i szybkość przez retencję + partycjonowanie

Partycjonuj raw_events po czasie (dziennie jest powszechne) i opcjonalnie po workspace/app. Stosuj retencję według typu zdarzenia:

- Przechowuj kluczowe zdarzenia dłużej (miesiące/lata).

- Wygaszaj hałaśliwe zdarzenia debugowe szybko.

To zapobiega „nieskończonemu wzrostowi” będącemu cichym problemem analityki.

Wbuduj kontrole jakości danych w model

Traktuj kontrole jakości jako część modelowania, nie późniejszego sprzątania:

- Brak wymaganych właściwości (np. feature_key).

- Złe znaczniki czasu (daty z przyszłości, problemy z parsowaniem stref czasowych).

- Duplikaty zdarzeń (retries, podwójna instrumentacja).

Przechowuj wyniki walidacji (lub tabelę odrzuconych zdarzeń), aby monitorować zdrowie instrumentacji i naprawiać problemy zanim dashboardy odpłyną.

Oblicz metryki adopcji: lejki, kohorty, retencja i ścieżki

Planuj śledzenie we właściwy sposób

Użyj Trybu Planowania, aby odwzorować golden events, właściwości i kontrole QA przed instrumentacją.

Gdy zdarzenia płyną, kolejnym krokiem jest przekształcenie surowych kliknięć w metryki odpowiadające na pytanie: „Czy ta funkcja naprawdę się adoptuje i przez kogo?” Skoncentruj się na czterech widokach, które współdziałają: lejki, kohorty, retencja i ścieżki.

Lejki: adopcja jako sekwencja (nie pojedynczy klik)

Zdefiniuj lejek dla każdej funkcji, aby widzieć, gdzie użytkownicy odpadają. Praktyczny wzorzec:

- Discovery → użytkownik widzi punkt wejścia funkcji (przycisk, menu, banner)

- First use → pierwsza znacząca interakcja (np.

feature_used)

- Repeat use → drugie użycie w rozsądnym oknie (np. 7 dni)

- Value action → rezultat potwierdzający wartość (eksport utworzony, automatyzacja włączona, raport udostępniony)

Trzymaj kroki lejka powiązane ze zdarzeniami, którym ufasz. Jeśli „first use” może się wydarzyć na kilka sposobów, traktuj go jako krok z warunkami OR (np. import_started OR integration_connected).

Kohorty: porównuj podobnych z podobnymi

Kohorty pomagają mierzyć poprawę w czasie bez mieszania starych i nowych użytkowników. Typowe kohorty:

- Nowi użytkownicy wg tygodnia (tydzień rejestracji)

- Użytkownicy aktywowani (osiągnęli event aktywacji)

- Zatrzymani użytkownicy (wrócili i zrobili coś znaczącego)

- Power users (wysoka częstotliwość lub zaawansowane akcje)

Śledź wskaźniki adopcji w każdej kohorcie, aby zobaczyć, czy ostatnie onboarding lub zmiany UI pomagają.

Retencja: „czy wracają i dalej używają?”

Retencja jest najbardziej użyteczna, gdy powiążesz ją z funkcją, nie tylko „otwarciami aplikacji”. Zdefiniuj ją jako powtarzanie kluczowego zdarzenia funkcji (lub value action) w Dniu 7/30. Śledź też „czas do drugiego użycia” — często bardziej czuły niż surowa retencja.

Segmentacja i ścieżki: kto adoptuje i jak tam dochodzą

Rozbij metryki po wymiarach, które wyjaśniają zachowanie: plan, rola, branża, urządzenie, kanał pozyskania. Segmenty często pokazują, że adopcja jest silna w jednej grupie, a bliska zeru w innej.

Dodaj analizę ścieżek, aby znaleźć typowe sekwencje przed i po adopcji (np. użytkownicy adoptujący często odwiedzają pricing, potem docs, potem podłączają integrację). Użyj tego do poprawy onboardingu i usuwania martwych punktów.

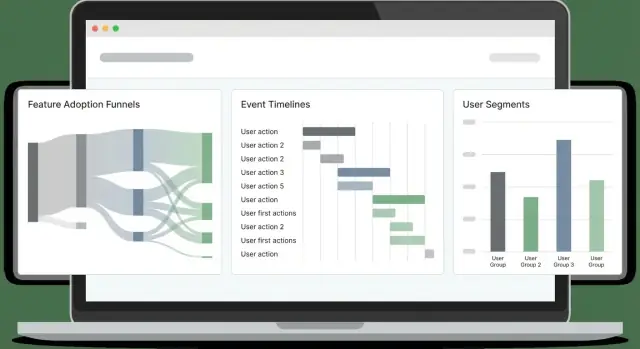

Buduj dashboardy, z których ludzie będą rzeczywiście korzystać

Dashboardy zawodzą, gdy próbują służyć wszystkim jednym „master view”. Zamiast tego zaprojektuj kilka skupionych stron odpowiadających decyzjom różnych osób i spraw, aby każda strona odpowiadała na jasne pytanie.

Zacznij od stron dedykowanych odbiorcom

Przegląd dla zarządu powinien być szybkim checkiem zdrowia: trend adopcji, aktywni użytkownicy, top funkcje i istotne zmiany od ostatniego wydania. Głębsza strona funkcji dla PM i inżynierów: gdzie użytkownicy zaczynają, gdzie odpadają i które segmenty zachowują się inaczej.

Prosta struktura, która działa:

- Overview: trend adopcji, trend retencji i kilka kluczowych KPI

- Feature page: lejek, retencja kohortowa i częstotliwość użycia dla danej funkcji

- Segment explorer: porównania planów, regionów lub rozmiarów workspace

Ułatw eksplorację (bez bałaganu)

Dodaj wykresy trendów dla „co się dzieje”, podziały segmentów dla „kto” i drill-down dla „dlaczego”. Drill-down powinien pozwalać kliknąć słupek/punkt i zobaczyć przykładowych użytkowników lub workspace (ze stosownymi uprawnieniami), aby zespoły mogły potwierdzić wzorce i sprawdzić rzeczywiste sesje.

Utrzymuj filtry spójne między stronami, żeby użytkownicy nie musieli uczyć się nowych kontrolerów. Najbardziej użyteczne filtry do śledzenia adopcji:

- Zakres dat

- Plan / tier

- Atrybuty workspace/konta (rozmiar, branża)

- Region

- Wersja aplikacji (lub kanał wydania)

Udostępnianie, eksporty i zapisane widoki

Dashboardy stają się częścią workflow, gdy ludzie mogą udostępniać dokładnie to, co widzą. Dodaj:

- Eksport do CSV do szybkiej analizy w arkuszach

- Udostępnij ze zapisywanym widokiem (filtry + stan wykresu + wybrany segment)

- Opcjonalne zaplanowane podsumowania e-mail/Slack odwołujące się do zapisanego widoku

Jeśli budujesz to w aplikacji analitycznej, rozważ stronę /dashboards z „Przypiętymi” zapisanymi widokami, aby interesariusze zawsze trafiali na kilka istotnych raportów.

Dodaj alerty, wykrywanie anomalii i markery wydań

Dashboardy są świetne do eksploracji, ale zespoły zwykle dowiadują się o problemach, gdy klient się skarży. Alerty odwracają to: dowiadujesz się o awarii w ciągu minut, a możesz związać ją z tym, co się zmieniło.

Ustal reguły alertów odpowiadające realnym awariom

Zacznij od kilku wysokosygnałowych alertów chroniących podstawowy flow adopcji:

- Nagły spadek first use (np. zdarzenia „Feature X: first_use” na godzinę w dół o 40% vs baseline). Często oznacza regresję UI, zmianę uprawnień lub błąd w instrumentacji.

- Skok błędów (błędy klienta, API 4xx/5xx lub zdarzenia

feature_failed). Ustal zarówno progi absolutne, jak i proporcje (błędy na 1000 sesji).

- Brak zdarzeń po wydaniu (liczba zdarzeń spada prawie do zera). Łapie szybko zepsutą instrumentację — szczególnie po refaktorach.

Trzymaj definicje alertów czytelnymi i w kontroli źródła (np. prosty plik YAML w repo), aby nie stały się wiedzą plemienną.

Wykrywanie anomalii: najpierw prosto

Podstawowe wykrywanie anomalii może być skuteczne bez zaawansowanego ML:

- Porównuj bieżące wartości do średniej kroczącej (np. ostatnie 7 dni, ta sama godzina dnia).

- Dodaj świadomość sezonowości tam, gdzie to istotne (dni robocze vs weekendy, godziny pracy vs noc).

- Ustal minimalny próg wolumenu, aby metryki o niskim ruchu nie spamowały.

Markery wydań: oś czasu „co się zmieniło?”

Dodaj strumień markerów wydań bezpośrednio do wykresów: deploye, rollout flag, zmiany cen, poprawki onboardingu. Każdy marker powinien zawierać timestamp, właściciela i krótki opis. Gdy metryki się zmieniają, natychmiast zobaczysz potencjalne przyczyny.

Routing, godziny ciszy i odpowiedzialność

Wysyłaj alerty na e-mail i kanały typu Slack, ale wspieraj godziny ciszy i eskalację (ostrzeżenie → page) dla poważnych problemów. Każdy alert potrzebuje właściciela i linku do runbooka (nawet krótkiego /docs/alerts), opisującego pierwsze kroki w diagnostyce.

Prywatność, zgoda i kontrola dostępu

Prototypuj ingest w kilka godzin

Zbuduj usługę kolektora i podstawowy interfejs potoku z wykorzystaniem specyfikacji prowadzonej przez chat z Koder.ai.

Dane analityczne szybko stają się danymi osobowymi, jeśli nie będziesz ostrożny. Traktuj prywatność jako część projektu śledzenia, nie jako późniejsze zagadnienie prawne: zmniejsza to ryzyko, buduje zaufanie i zapobiega bolesnym przeróbkom.

Zgoda: zbieraj tylko to, na co użytkownicy się zgodzili

Szanuj wymogi zgody i pozwól użytkownikom rezygnować tam, gdzie to potrzebne. Praktycznie oznacza to, że warstwa śledzenia powinna sprawdzać flagę zgody przed wysłaniem zdarzeń i móc przerwać śledzenie w połowie sesji, jeśli użytkownik zmieni decyzję.

Dla regionów ze ścisłymi przepisami rozważ „consent-gated” funkcje:

- Ładuj biblioteki analityczne dopiero po zgodzie (nie tylko „przestań wysyłać”).

- Przechowuj decyzję o zgodzie z timestampem i wersją, żeby móc udokumentować, co użytkownik zaakceptował.

- Zapewnij prosty interfejs preferencji w ustawieniach aplikacji.

Minimalizuj wrażliwe dane (i trzymaj je poza zdarzeniami)

Minimalizuj wrażliwe dane: unikaj surowych e-maili w zdarzeniach; używaj hashowanych/nieprzezroczystych ID. Ładunek zdarzenia powinien opisywać zachowanie (co się stało), a nie tożsamość (kto to zrobił). Jeśli musisz powiązać zdarzenia z kontem, wysyłaj wewnętrzne user_id/account_id i trzymaj mapowanie w bazie z odpowiednimi zabezpieczeniami.

Unikaj też zbierania:

- Pol tekstowych (często zawierają przypadkowe dane osobowe)

- Pełnych URL-i, które mogą zawierać tokeny lub parametry

- Czegokolwiek, co nie chciałbyś mieć na zrzucie ekranu

Bądź transparentny: dokumentacja i czytelna strona prywatności

Dokumentuj, co zbierasz i dlaczego; udostępnij czytelną stronę prywatności. Stwórz lekki „słownik śledzenia”, który wyjaśnia każde zdarzenie, jego cel i okres retencji. W UI produktu podlinkuj do /privacy i trzymaj tekst czytelny: co śledzisz, czego nie śledzisz i jak zrezygnować.

Kontrola dostępu: ogranicz kto widzi dane na poziomie użytkownika

Wprowadź RBAC, żeby tylko uprawnione zespoły miały dostęp do danych na poziomie użytkownika. Większość osób potrzebuje tylko agregatów; surowe widoki zdarzeń zachowaj dla wąskiej grupy (np. data/product ops). Dodaj logi audytu dla eksportów i lookupów użytkowników oraz ustal limity retencji, aby stare dane wygasały automatycznie.

Dobrze zaprojektowane kontrole prywatności nie spowolnią analizy — sprawią, że system będzie bezpieczniejszy, czytelniejszy i łatwiejszy w utrzymaniu.

Plan rollout, QA i długoterminowa konserwacja

Wdrażanie analityki jest jak wdrożenie funkcji: zacznij od małego, weryfikowalnego wydania, potem iteruj. Traktuj pracę nad śledzeniem jako kod produkcyjny z właścicielami, przeglądami i testami.

Zacznij od małego zestawu „golden events”

Zacznij od ograniczonego zestawu golden events dla jednej części funkcjonalnej (np.: Feature Viewed, Feature Started, Feature Completed, Feature Error). Powinny one bezpośrednio odpowiadać na pytania, które zespół zadaje cotygodniowo.

Świadome ograniczenie zakresu pozwala szybko walidować jakość i nauczyć się, jakie właściwości rzeczywiście są potrzebne (plan, rola, źródło, wariant funkcji) przed skalowaniem.

Waliduj śledzenie w staging i produkcji

Użyj checklisty przed uznaniem śledzenia za „gotowe”:

- Zdarzenie wywołuje się raz (brak podwójnego śledzenia przy refresh, retry lub zmianie routingu SPA)

- Wymagane właściwości obecne i zgodne typem

- PII wykluczone lub poprawnie zamaskowane

- Zdarzenia docierają w oczekiwanym opóźnieniu

- Tożsamości łączą się poprawnie (anonymous → zalogowany)

Dodaj przykładowe zapytania do uruchamiania w staging i produkcji. Przykłady:

- „Count events by name in the last 30 minutes” (wykrywa brak/dodatkowe zdarzenia)

- „Top 20 property values for

feature_name” (wyłapuje literówki typu Search vs search)

- „Completion rate = Completed / Started by app version” (wykrywa regresje po wydaniu)

Workflow QA instrumentacji dla każdego release

Uczyń instrumentację częścią procesu wydania:

- Zmiana śledzenia w tym samym PR co zmiana UI/API

- Reviewer sprawdza nazwy zdarzeń/właściwości ze schematem

- QA weryfikuje zdarzenia w staging z testowym kontem

- Release note zawiera zmiany w śledzeniu (nowe zdarzenia, zmienione nazwy pól)

Długoterminowa konserwacja (schemat, backfilly, dokumentacja)

Planuj zmiany: deprecjonuj zdarzenia zamiast je usuwać, wersjonuj właściwości gdy zmienia się ich znaczenie i planuj okresowe audyty.

Gdy dodajesz nowe wymagane pole lub poprawiasz błąd, zdecyduj czy potrzebny jest backfill (i udokumentuj okno czasowe, gdy dane będą częściowe).

Na koniec trzymaj lekki przewodnik śledzenia w dokumentacji i podlinkuj go z dashboardów oraz szablonów PR. Dobry punkt startowy to krótka checklist typu /blog/event-tracking-checklist.