10 lis 2025·8 min

Jak zbudować stronę dla dziennika eksperymentów produktowych

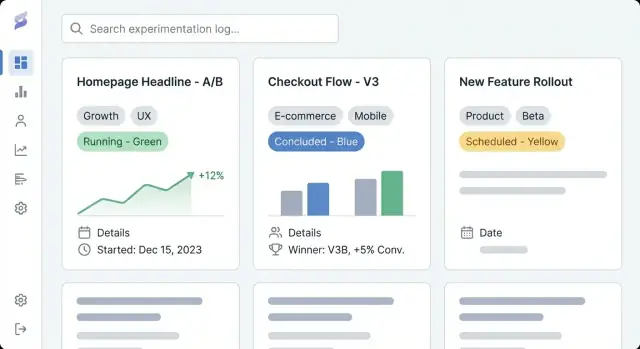

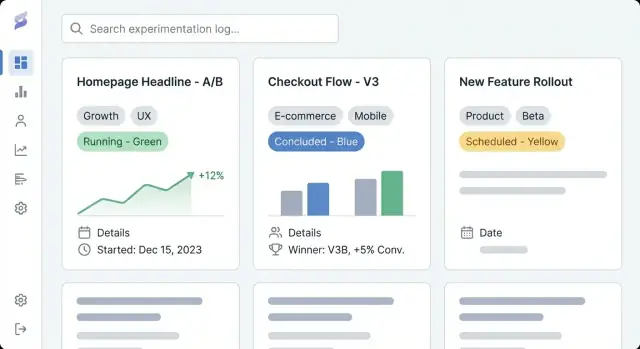

Dowiedz się, jak zaplanować, zaprojektować i uruchomić stronę dokumentującą eksperymenty produktowe z spójnymi wpisami, tagowaniem, wyszukiwaniem i czytelnymi wynikami.

Dowiedz się, jak zaplanować, zaprojektować i uruchomić stronę dokumentującą eksperymenty produktowe z spójnymi wpisami, tagowaniem, wyszukiwaniem i czytelnymi wynikami.

Strona z dziennikiem eksperymentów produktowych to wspólne miejsce do dokumentowania każdego eksperymentu, jaki prowadzi zespół — testów A/B, prób cenowych, zmian w onboardingu, flag funkcji, eksperymentów mailowych, a nawet "nieudanych" pomysłów, które mimo wszystko czegoś nauczyły. Myśl o niej jak o repozytorium eksperymentów połączonym z dziennikiem wniosków produktowych: zapis tego, co próbowano, dlaczego to zrobiono, co się wydarzyło i jaka została podjęta decyzja.

Wiele zespołów ma już fragmenty śledzenia eksperymentów porozrzucane po dokumentach, dashboardach i czatach. Dedykowana strona do śledzenia eksperymentów zbiera te artefakty w jedno, nawigowalne archiwum.

Praktyczne korzyści to:

Ten przewodnik skupia się na tym, jak zbudować stronę, która sprawia, że dokumentowanie eksperymentów jest proste w tworzeniu i użyteczne. Omówimy planowanie struktury i nawigacji, zdefiniowanie modelu danych wpisu eksperymentu (by wpisy były spójne), tworzenie czytelnych szablonów stron, konfigurację tagowania i wyszukiwania dla szybkiego odnajdywania oraz wybór podejścia do implementacji (CMS vs aplikacja custom).

Na końcu będziesz mieć jasny plan na stronę dokumentacji testów A/B, która wspiera codzienną pracę produktową — rejestrując hipotezy, metryki i raportowanie wyników oraz decyzje w sposób przeszukiwalny, wiarygodny i użyteczny w dłuższej perspektywie.

Zanim wybierzesz narzędzia lub zaprojektujesz szablony eksperymentów, wyjaśnij, po co ta strona istnieje i kogo obsługuje. Dziennik eksperymentów produktowych jest użyteczny tylko wtedy, gdy odpowiada sposobowi, w jaki zespoły faktycznie podejmują decyzje.

Spisz 2–4 mierzalne rezultaty dla repozytorium eksperymentów. Typowe definicje sukcesu to:

Te cele powinny wpływać na wszystko później: jakie pola wymagane będą w każdym wpisie, jak rygorystyczny będzie workflow i jak zaawansowane musi być tagowanie i wyszukiwanie.

Wypisz główne grupy odbiorców i co muszą zrobić w dzienniku wniosków produktowych:

Prosty sposób walidacji: zapytaj każdą grupę „Jakie pytanie chcesz mieć odpowiedziane w 30 sekund?” i upewnij się, że szablony eksperymentów oraz układ strony na to odpowiadają.

Zdecyduj wcześnie, czy Twój CMS dla dzienników eksperymentów ma być:

Jeśli wybierzesz dostęp mieszany, określ, co można udostępniać publicznie (np. brak surowych metryk, zanonimizowane segmenty, brak nazw funkcji przed wydaniem) i kto zatwierdza publikację. To zapobiega przeróbkom, gdy zespół będzie chciał dzielić się wnioskami na zewnątrz.

Dziennik eksperymentów działa tylko wtedy, gdy ludzie mogą znaleźć właściwy eksperyment w mniej niż minutę. Zanim wybierzesz narzędzia lub zaprojektujesz ekrany, zdecyduj, jak ktoś będzie przeglądał stronę, gdy nie wie dokładnie, czego szuka.

Ogranicz główną nawigację do kilku przewidywalnych elementów. Praktyczny punkt wyjścia to:

Jeśli „Metrics” wydaje się obciążające, możesz najpierw linkować do niej z Experiments i rozwinąć później.

Zdecyduj o głównym „kształcie” przeglądania. Większość dzienników wniosków produktowych działa najlepiej z jednym widokiem podstawowym, a resztą obsługiwaną przez filtry:

Wybierz ten, którego interesariusze już używają w rozmowach. Wszystko inne może być tagami (np. platforma, motyw hipotezy, segment, typ eksperymentu).

Uczyń URL-e czytelnymi i stabilnymi, aby można je było udostępniać w Slacku i ticketach:

/experiments/2025-12-checkout-free-shipping-thresholdDodaj breadcrumbs, np. Experiments → Checkout → Free shipping threshold, aby uniknąć martwych końców i ułatwić szybki przegląd.

Wypisz, co opublikujesz w dniu uruchomienia, a co później: ostatnie eksperymenty, najważniejsze playbooki, podstawowy glosariusz metryk i strony zespołów. Priorytetyzuj wpisy, do których będą się często odwoływać (testy o dużym wpływie, kanoniczne szablony eksperymentów i definicje metryk używane w raportowaniu wyników).

Użyteczny dziennik eksperymentów to nie tylko lista linków — to baza wiedzy. Model danych to „kształt” tej bazy: co przechowujesz, jak wpisy się łączą i które pola muszą być obecne, aby eksperymenty były porównywalne w czasie.

Zacznij od niewielkiego zestawu typów treści, które odpowiadają rzeczywistej pracy zespołów:

Oddzielenie tych elementów zapobiega sytuacji, w której każdy eksperyment wymyśla nowe nazwy metryk lub chowa decyzje w swobodnym tekście.

Uczyń "minimalny żywotny wpis" prostym do wypełnienia. Co najmniej wymagaj:

Opcjonalne, ale często przydatne pola to grupy docelowe, alokacja ruchu, typ testu (A/B, wielowymiarowy) oraz linki do ticketów lub projektów.

Wyniki to miejsce, gdzie dzienniki często się rozpadają — ustandaryzuj je:

Jeśli pozwalasz na załączniki, trzymaj spójne miejsce na zrzuty ekranu, aby czytelnicy wiedzieli, gdzie szukać.

Modeluj relacje jawnie, aby odkrywanie i raportowanie działały później:

Ustandaryzuj statusy, aby sortowanie i dashboardy były sensowne: proposed, running, concluded, shipped, archived. To zapobiega rozmyciu stanu przez „done”, „complete” i „finished”.

Dobre szablony zamieniają „czyjeś notatki” w wspólny zapis, który cała firma może szybko przejrzeć, zaufać mu i ponownie wykorzystać. Celem jest spójność bez poczucia wypełniania biurokratycznego formularza.

Zacznij od informacji, których czytelnik potrzebuje, by zdecydować, czy chce czytać dalej.

/docs/...) i primary metric.Strona indeksu powinna zachowywać się jak dashboard. Dodaj filtry dla statusu, zespołu, taga, zakresu dat i platformy; sortowanie po ostatnio zaktualizowane, dacie rozpoczęcia i (jeśli możesz to policzyć) wpływie; oraz pola do szybkiego skanowania jak status, właściciel, daty i jednolinijkowy wynik.

Stwórz jeden domyślny szablon oraz opcjonalne warianty (np. „test A/B”, „test cenowy”, „eksperyment onboardingowy”). Prefilluj nagłówki, przykładowy tekst i pola wymagane, aby autorzy nie zaczynali od pustej strony.

Użyj układu jednokolumnowego, dużych odstępów między wierszami i czytelnej typografii. Trzymaj kluczowe fakty w przyklejonym bloku podsumowania (jeśli ma to sens) i pozwól tabelom przewijać się poziomo, by wyniki były czytelne na telefonach.

Dziennik eksperymentów jest użyteczny tylko wtedy, gdy ludzie szybko znajdą relewantne wnioski. Tagowanie i taksonomia zamieniają zbiór stron w coś, co można przeglądać, filtrować i ponownie wykorzystywać.

Zdefiniuj kilka grup tagów, które odpowiadają naturalnemu sposobowi wyszukiwania zespołu. Praktyczna baza to:

Ogranicz liczbę wymiarów. Zbyt wiele wymiarów komplikuje filtrowanie i zachęca do niespójnego tagowania.

Niekontrolowane tagi szybko stają się „signup”, „sign-up” i „registration” jednocześnie. Stwórz kontrolowane słownictwo:

Proste podejście to strona „rejestru tagów” utrzymywana przez zespół (np. /experiment-tags) oraz lekka weryfikacja podczas tworzenia wpisu eksperymentu.

Tagi świetnie nadają się do odkrywania, ale niektóre atrybuty powinny być polami strukturalnymi, aby zachować spójność:

Pola strukturalne napędzają niezawodne filtry i dashboardy, podczas gdy tagi chwytają niuanse.

Pomóż czytelnikom przechodzić między powiązanymi pracami. Dodaj sekcje takie jak Related experiments (ta sama funkcja lub metryka) oraz Similar hypotheses (ta sama założenie testowane gdzie indziej). Na początku mogą to być linki manualne, a później można zasugerować sąsiadów automatycznie na podstawie współdzielonych tagów.

Ta decyzja ustala pułap możliwości twojego dziennika eksperymentów. CMS pozwala szybko publikować, podczas gdy aplikacja custom może zamienić log w ściśle zintegrowany system wspierający podejmowanie decyzji.

CMS jest dobrą opcją, gdy główne potrzeby to spójna, czytelna dokumentacja testów A/B z lekką strukturą.

Użyj CMS, jeśli chcesz:

Typowy wzorzec: headless CMS (treść w CMS, prezentowana przez stronę) połączony ze statycznym generatoriem strony. To utrzymuje repozytorium eksperymentów szybkie, łatwe w hostingu i przyjazne dla osób nietechnicznych.

Aplikacja custom ma sens, gdy log musi łączyć się bezpośrednio z danymi produktowymi i narzędziami wewnętrznymi.

Rozważ aplikację custom, jeśli potrzebujesz:

Jeśli chcesz szybko prototypować, platforma vibe-coding taka jak Koder.ai może być praktycznym skrótem: opisujesz model danych (experiments, metrics, decisions), szablony stron i workflow w czacie, a otrzymujesz działającą aplikację React + Go + PostgreSQL z wdrożeniem/hostingiem, możliwością eksportu źródła oraz snapshotami/rollbackem dla bezpiecznych zmian.

Bądź jawny, gdzie przechowywane są dane eksperymentu.

Zapisz to wcześnie — inaczej zespoły skończą z duplikatami w dokumentach, arkuszach i narzędziach, a dziennik przestanie być zaufany.

Twój dziennik eksperymentów nie potrzebuje egzotycznych technologii. Najlepszy stack to taki, którym zespół potrafi bezpiecznie zarządzać, utrzymywać i rozwijać bez nadmiernego tarcia.

Strona statyczna (prebudowane strony) często jest najprostszym wyborem: szybka, tania w hostingu i niska w utrzymaniu. Dobrze sprawdza się, gdy eksperymenty są głównie do czytania, a aktualizacje odbywają się przez CMS lub pull requesty.

Aplikacja renderowana po stronie serwera sprawdzi się, gdy potrzebujesz silniejszej kontroli dostępu, dynamicznych filtrów lub widoków per-zespół bez skomplikowanej logiki po stronie klienta. Łatwiej też egzekwować uprawnienia po stronie serwera.

Single-page app (SPA) może dawać responsywne filtrowanie i dashboardy, ale dodaje złożoność dotyczącą SEO, uwierzytelniania i czasu pierwszego załadowania. Wybierz SPA tylko jeśli naprawdę potrzebujesz interakcji aplikacyjnych.

Jeśli budujesz aplikację custom, zdecyduj też, czy chcesz konwencjonalnego pipeline'u buildowego, czy przyspieszonego podejścia. Na przykład Koder.ai może wygenerować rdzeń aplikacji (React UI, Go API, schemat PostgreSQL) z pisemnej specyfikacji, co jest przydatne przy iteracji szablonów i workflow z wieloma interesariuszami.

Priorytetem powinny być niezawodność (czas pracy, monitoring, alerty) i kopie zapasowe (automatyczne, testowane przywracanie). Zachowaj separację środowisk: przynajmniej staging do testowania zmian taksonomii, szablonów i zasad uprawnień przed produkcją.

Większość zespołów ostatecznie potrzebuje SSO (Okta, Google Workspace, Azure AD), plus role (viewer, editor, admin) i obszary prywatne dla wrażliwych wniosków (przychody, dane użytkowników, notatki prawne). Zaplanuj to wcześnie, by nie przebudowywać później.

Używaj cache'owania (CDN i cache przeglądarki), utrzymuj lekkie strony i optymalizuj media (kompresowane obrazy, lazy loading gdzie sensowne). Szybkość strony ma znaczenie — ludzie nie będą korzystać z dziennika, który działa wolno, zwłaszcza gdy próbują znaleźć test podczas spotkania.

Dziennik staje się naprawdę użyteczny, gdy ludzie mogą znaleźć „ten jeden test” w kilka sekund — bez znajomości dokładnego tytułu.

Wyszukiwanie wbudowane (w CMS lub bazie aplikacji) wystarcza, gdy masz kilka setek eksperymentów, mały zespół i proste potrzeby jak przeszukiwanie tytułów, podsumowań i tagów. Jest prostsze w utrzymaniu i unika dodatkowej konfiguracji dostawcy.

Zewnętrzna usługa wyszukiwania (np. Algolia/Elastic/OpenSearch) ma sens przy tysiącach wpisów, gdy potrzebujesz błyskawicznych wyników, tolerancji literówek i synonimów (np. „checkout” = „purchase”) lub zaawansowanego rankingu wyników. Przydaje się też, gdy treści pochodzą z różnych źródeł (docs + log + wiki).

Samo wyszukiwanie to za mało. Dodaj filtry odpowiadające rzeczywistym decyzjom:

Umożliw łączenie filtrów (np. „Concluded + Last 90 days + Growth team + Activation metric”).

Zapisane widoki zamieniają powtarzające się pytania w jedno kliknięcie:

Pozwól zespołom przypinać udostępnione widoki do nawigacji i daj możliwość zapisu widoków prywatnych.

W wynikach wyszukiwania pokaż krótki fragment: hipoteza, wariant, odbiorcy i nagłówek wyniku. Podświetl dopasowane słowa w tytule i streszczeniu oraz wyświetl kilka kluczowych pól (status, owner, primary metric), aby użytkownicy nie musieli otwierać wielu stron, by znaleźć właściwy eksperyment.

Świetny system śledzenia eksperymentów to nie tylko strony i tagi — to wspólny proces. Jasna odpowiedzialność i lekki workflow zapobiegają niedokończonym wpisom, brakującym wynikom i „tajemniczym decyzjom” miesiące później.

Zacznij od decyzji, kto może tworzyć, edytować, zatwierdzać i publikować wpisy eksperymentów. Prosty model działa dla większości zespołów:

Utrzymuj uprawnienia zgodne z decyzją o poziomie dostępu (publiczny vs wewnętrzny vs ograniczony). Jeśli wspierasz prywatne eksperymenty, wymagaj jawnego właściciela dla każdego wpisu.

Zdefiniuj krótką checklistę, którą każdy eksperyment musi spełnić przed publikacją:

Ta lista może być obowiązkową sekcją formularza w szablonach eksperymentu.

Traktuj wpisy jak żywe dokumenty. Włącz historię wersji i wymagaj krótkich notatek o zmianach przy istotnych aktualizacjach (naprawa metryki, korekta analizy, odwrócenie decyzji). To utrzymuje zaufanie i ułatwia audyty.

Określ wcześniej, jak przechowywać wrażliwe informacje:

Governance nie musi być ciężka — musi być tylko jawna.

Dziennik eksperymentów jest użyteczny, gdy ludzie go znajdują, ufają mu i ponownie wykorzystują. Lekka analityka pomaga dostrzec, gdzie log działa, a gdzie cicho zawodzi — bez zamieniania serwisu w narzędzie inwigilacji.

Zacznij od kilku praktycznych sygnałów:

Jeśli narzędzie analityczne to wspiera, wyłącz logowanie IP i unikaj identyfikatorów na poziomie użytkownika. Preferuj agregowane raporty na poziomie stron.

Metryki użycia nie powiedzą, czy wpisy są kompletne. Dodaj kontrole "zdrowia treści", które raportują stan repozytorium:

Może to być prosty cotygodniowy raport z CMS/bazy danych lub skrypt, który flaguje wpisy. Celem jest uwidocznienie braków, by właściciele mogli je poprawić.

Wypisy eksperymentów rzadko powinny zawierać dane osobowe. Unikaj:

Linkuj do zagregowanych dashboardów zamiast osadzać surowe dane i przechowuj wrażliwe analizy w zatwierdzonych systemach.

Wyniki testów A/B łatwo jest błędnie zinterpretować poza kontekstem. Dodaj krótkie zastrzeżenie w szablonie eksperymentu (i/lub stopce) informujące, że:

To utrzymuje log w uczciwym kontekście i zmniejsza nieprawidłowe przenoszenie wniosków.

Dobry dziennik eksperymentów nie jest "gotowy" w momencie uruchomienia. Rzeczywista wartość pojawia się, gdy zespoły mu ufają, utrzymują go aktualnym i potrafią odnaleźć wnioski po sześciu miesiącach.

Większość zespołów zaczyna od arkuszy, decków lub porozrzucanych dokumentów. Wybierz mały pilotaż (np. eksperymenty z ostatniego kwartału) i zmapuj pola źródłowe na nowy szablon.

Jeśli to możliwe, importuj hurtowo: wyeksportuj arkusze do CSV, a następnie użyj skryptu lub importera CMS, aby stworzyć wpisy w nowym formacie. Dla dokumentów migracja najpierw obejmuje kluczowe pola podsumowujące (cel, zmiana, wyniki, decyzja) i link do oryginalnego pliku jako materiał dodatkowy.

Przeprowadź jedną rundę skoncentrowaną na spójności, nie na perfekcji. Typowe problemy do wyłapania:

To także dobry moment, by uzgodnić wymagane pola dla wpisów oznaczonych jako ukończone.

Zanim ogłosisz start, sprawdź:

Ustal lekką rutynę: comiesięczne porządki (zastane szkice, brakujące wyniki) i kwartalny przegląd taksonomii (łączenie tagów, dodawanie kategorii przemyślanie).

Gdy podstawy są stabilne, rozważ integracje: automatyczne łączenie eksperymentów z issue trackerami lub pobieranie kontekstu analitycznego, aby każdy wpis wskazywał na dokładny dashboard użyty do raportowania wyników.

Jeśli ewoluujesz w kierunku aplikacji custom, możesz iterować w "trybie planowania" najpierw — spisując workflowy, wymagane pola i reguły zatwierdzania — a potem je wdrażać. Platformy takie jak Koder.ai wspierają iteracyjny cykl buduj-i-udoskonalaj (z wdrożeniami, snapshotami i rollback), dzięki czemu log może dojrzewać bez ciężkiego przebudowywania.

Serwis do zapisywania eksperymentów produktowych to wspólne, przeszukiwalne repozytorium do dokumentowania testów (A/B, eksperymenty cenowe, zmiany w onboarding, rollouty z flagami funkcji, testy maili). Każdy wpis opisuje, co było testowane, dlaczego, co się stało i jaka zapadła decyzja — dzięki temu wnioski nie gubią się w dokumentach, dashboardach czy wątkach czatu.

Rozpocznij od zdefiniowania 2–4 mierzalnych rezultatów, na przykład:

Te cele powinny wpływać na wymagane pola, rygor workflow oraz stopień zaawansowania taksonomii i wyszukiwania.

Wypisz główne grupy odbiorców i pytanie, na które każda grupa chce znać odpowiedź w 30 sekund. Typowe potrzeby:

Wybierz jeden z trzech modeli:

Jeśli wybierasz model mieszany, zdefiniuj, co można publikować publicznie (np. brak surowych metryk, zanonimizowane segmenty) i kto zatwierdza publikację, aby uniknąć przeróbek później.

Utrzymaj prostą, przewidywalną górną nawigację, na przykład:

Wybierz jedną główną oś przeglądania (obszar produktu, etap lejka lub zespół), a resztę obsłuż filtrami i tagami.

Upewnij się, że każdy wpis ma minimalny zestaw pól wymaganych:

Dla wyników ustandaryzuj:

Praktyczna kolejność sekcji:

Użyj niewielkiej liczby grup tagów odzwierciedlających sposób wyszukiwania, np.:

Zapobiegaj rozrostowi tagów kontrolowanym słownictwem (zasady nazewnictwa, kto może tworzyć nowe tagi, krótkie opisy tagów). Trzymaj kluczowe atrybuty jak , i jako pola strukturalne, nie swobodny tekst.

Wybierz CMS, jeśli głównym celem jest spójna dokumentacja, uprawnienia i podstawowe tagowanie z przyjaznym edytorem dla PM-ów i designerów.

Rozważ aplikację custom, jeśli potrzebujesz głębokich integracji (feature flags, narzędzia analityczne, hurtownia danych, ticketing), zaawansowanego wyszukiwania/zapisanych widoków, reguł workflow (wymagane pola, zatwierdzenia) lub automatycznego pobierania wyników.

Niezależnie od wyboru, zapisz, gdzie jest "source of truth" (CMS vs baza danych/aplikacja), aby uniknąć duplikacji i sprzecznych wpisów.

Zacznij od prostego zestawu narzędzi do wyszukiwania:

W wynikach listy pokaż krótki fragment wyniku (hipoteza, wariant, odbiorcy, headline outcome) oraz kluczowe pola (status, owner, primary metric), by użytkownik mógł ocenić, czy kliknąć dalej.

Następnie zaprojektuj szablony i układ stron tak, aby te odpowiedzi były od razu widoczne.

To zamienia "notatki" w porównywalne zapisy na przestrzeni czasu.

To sprawia, że strony są łatwe do szybkiego przeglądu, a jednocześnie zachowują szczegóły.