24 lis 2025·8 min

Jak zbudować stronę internetową z techniczną macierzą porównawczą

Dowiedz się, jak zaplanować, zaprojektować i zbudować stronę internetową z techniczną macierzą porównawczą: jasne kryteria, ocenianie, filtry i strony przyjazne SEO.

Dowiedz się, jak zaplanować, zaprojektować i zbudować stronę internetową z techniczną macierzą porównawczą: jasne kryteria, ocenianie, filtry i strony przyjazne SEO.

Macierz porównawcza ma sens tylko wtedy, gdy pomaga podjąć decyzję. Zanim zaprojektujesz tabele, filtry czy zasady oceniania, ustal kto będzie korzystał z serwisu i jaką decyzję chce podjąć. To zapobiega częstemu błędowi: stworzeniu pięknej siatki, która odpowiada na pytania, których nikt nie zadaje.

Różne grupy odbiorców inaczej rozumieją „porównanie funkcji”:

Wybierz główną grupę dla pierwszej wersji. Możesz wspierać użytkowników drugorzędnych, ale domyślne widoki, terminologia i priorytety powinny odpowiadać grupie głównej.

Zapisz konkretne decyzje, jakie macierz ma umożliwiać. Przykłady:

Te decyzje wpływają na to, które kryteria zostaną wyróżnione jako filtry, które będą „szczegółami”, a które można pominąć.

Unikaj ogólnych celów typu „zwiększyć zaangażowanie”. Wybierz metryki, które odzwierciedlają postęp decyzji:

„Ocena techniczna” może obejmować wiele wymiarów. Uzgodnij, co jest najważniejsze dla użytkowników, np.:

Udokumentuj te priorytety prostym językiem. Będą one Twoją gwiazdą przewodnią przy późniejszych wyborach: model danych, zasady oceniania, UX i SEO.

Model danych decyduje o tym, czy macierz pozostanie spójna, możliwa do przeszukania i łatwa do aktualizacji. Zanim zaprojektujesz ekrany, ustal, jakie „obiekty” porównujesz, co mierzysz i jak będziesz przechowywać dowody.

Większość serwisów porównawczych potrzebuje kilku bloków budulcowych:

Modeluj kryteria jako obiekty wielokrotnego użytku i przechowuj każdą wartość dostawcy/produktu jako osobny rekord (często „assessment” lub „criterion result”). Dzięki temu dodasz nowych dostawców bez duplikowania listy kryteriów.

Unikaj pakowania wszystkiego w zwykły tekst. Wybierz typ pasujący do sposobu filtrowania i porównywania:

Zdecyduj też, jak reprezentować „Unknown”, „Not applicable” i „Planned”, żeby puste pola nie czytano jako „Nie”.

Kryteria ewoluują. Przechowuj:

Utwórz pola (lub osobną tabelę) dla komentarzy wewnętrznych, szczegółów negocjacyjnych i poziomu pewności recenzenta. Strony publiczne powinny pokazywać wartość i dowód; widoki wewnętrzne mogą zawierać szczere konteksty i zadania follow-up.

Serwis z macierzą porównawczą działa, gdy odwiedzający potrafią przewidzieć, gdzie coś się znajduje i jak to znaleźć. Wybierz architekturę informacji odzwierciedlającą, jak ludzie oceniają opcje.

Zacznij od prostej, stabilnej taksonomii, która nie będzie zmieniana co kwartał. Myśl kategoriami „obszarów problemowych”, a nie nazwami dostawców.

Przykłady:

Utrzymuj płytkie drzewo (zazwyczaj 2 poziomy wystarczą). Jeśli potrzebujesz więcej niuansów, użyj tagów lub filtrów (np. „Open-source”, „SOC 2”, „Self-hosted”) zamiast głębokiej struktury. To ułatwia przeglądanie i zapobiega duplikatom treści.

Projektuj serwis wokół kilku powtarzalnych szablonów:

Dodaj strony wspierające, które zmniejszają niepewność i budują wiarygodność:

Ustal zasady URL wcześnie, żeby później nie trzeba było tworzyć bałaganu przekierowań. Dwa popularne wzorce:

/compare/a-vs-b (lub /compare/a-vs-b-vs-c dla wielokrotnego)/category/ci-cdUtrzymuj URL krótkie, małymi literami i spójne. Używaj kanonicznej nazwy produktu (lub stabilnego slug), żeby to samo narzędzie nie pojawiło się jako /product/okta i /product/okta-iam.

Na koniec ustal, jak filtrowanie i sortowanie wpływają na URL. Jeśli chcesz udostępniać widoki z filtrami, zaplanuj czysty sposób z query stringami (np. ?deployment=saas&compliance=soc2) i spraw, by strona bazowa działała bez parametrów.

Macierz pomaga, gdy zasady są spójne. Zanim dodasz kolejnych dostawców lub kryteria, zablokuj „matematykę” i znaczenie każdego pola. To zapobiega niekończącym się dyskusjom („Co mieliśmy na myśli przez wsparcie SSO?”) i sprawia, że wyniki są obronne.

Zacznij od kanonicznej listy kryteriów i traktuj ją jak spec produktu. Każde kryterium powinno mieć:

Unikaj bliskich duplikatów typu „Compliance” vs „Certifications”, chyba że rozróżnienie jest wyraźne. Jeśli potrzebujesz wariantów (np. „Encryption at rest” i „Encryption in transit”), zrób z nich odrębne kryteria z własnymi definicjami.

Oceny są porównywalne tylko wtedy, gdy wszyscy używają tej samej skali. Napisz instrukcje oceniania dopasowane do kryterium:

Zdefiniuj, co oznacza każdy punkt. Na przykład „3” może znaczyć „spełnia wymaganie z ograniczeniami”, a „5” to „pełne spełnienie z zaawansowanymi opcjami i udokumentowanymi wdrożeniami”. Określ też, kiedy dopuszczalne jest „N/A”.

Wagowanie zmienia przekaz macierzy, więc wybierz celowo:

Jeżeli wspierasz wagi użytkownika, ustal ograniczenia (np. wagi muszą sumować się do 100 lub używaj presetów niskiego/średniego/wysokiego).

Braki danych są nieuniknione. Udokumentuj regułę i stosuj ją wszędzie:

Takie polityki czynią macierz uczciwą, powtarzalną i godną zaufania w miarę wzrostu.

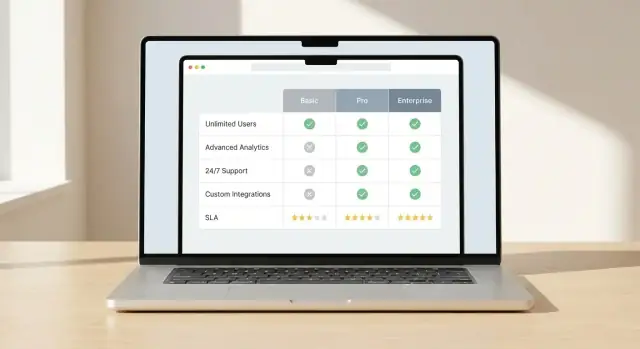

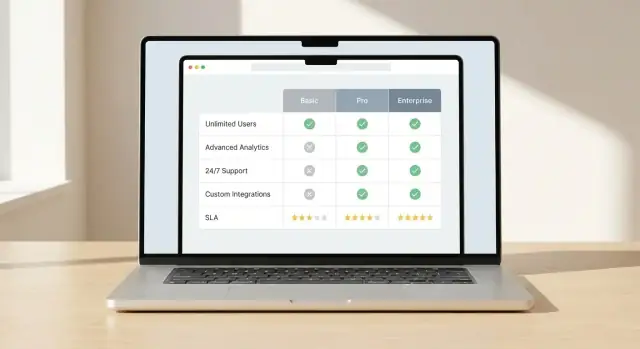

Interfejs porównania udaje się wtedy, gdy czytelnik szybko zobaczy, co się naprawdę różni. Wybierz główny widok porównania i zestaw wskazówek wizualnych, które sprawią, że kontrasty będą od razu widoczne.

Wybierz jeden wzorzec i projektuj wszystko wokół niego:

Spójność ma znaczenie. Jeśli użytkownicy nauczą się, jak widoczne są różnice w jednym miejscu, te same zasady powinny obowiązywać wszędzie.

Nie zmuszaj ludzi do skanowania każdej komórki. Użyj wyróżnień:

Utrzymaj prostą i dostępną semantykę kolorów: jeden kolor „lepsze”, jeden „gorsze” i stan neutralny. Nie polegaj tylko na kolorze — dodaj ikony lub krótkie etykiety.

Długie macierze są normalne w ocenie technicznej. Uczyń je użytecznymi:

Użytkownicy mobilni nie tolerują drobnych siatek. Zapewnij:

Gdy różnice są łatwe do zauważenia, użytkownicy ufają macierzy i wracają do niej.

Macierz wydaje się szybka, gdy ludzie mogą zawęzić listę i zobaczyć istotne różnice bez długiego przewijania. Filtry, sortowanie i widoki obok siebie są kluczowymi interakcjami.

Zacznij od niewielkiego zestawu filtrów odpowiadających rzeczywistym pytaniom oceny, nie tylko temu, co łatwo przechować. Przydatne filtry:

Projektuj filtry tak, by można je było łączyć. Pokaż liczbę dopasowań podczas filtrowania i wyraźnie jak wyczyścić filtry. Jeśli niektóre filtry są wzajemnie wykluczające, zapobiegaj ustawieniom skutkującym „0 wyników” zamiast pozostawić użytkownika w niejasności.

Sortowanie powinno odzwierciedlać zarówno obiektywne, jak i specyficzne dla odbiorcy priorytety. Zaproponuj kilka opcji:

Jeśli pokazujesz „najlepszy wynik”, wyświetlaj, co ten wynik oznacza (ogólny vs. wynik kategorii) i pozwól użytkownikom zmienić widok ocen. Unikaj ukrytych domyślnych ustawień.

Pozwól użytkownikom wybrać mały zestaw (zwykle 2–5) i porównać je w stałym układzie kolumnowym. Przyklej najważniejsze kryteria u góry i pogrupuj resztę w sekcje zwijalne, by zmniejszyć przytłoczenie.

Uczyń porównanie możliwym do udostępnienia przez link, który zachowuje wybory, filtry i sortowanie. To pozwala zespołom przeglądać tę samą shortlistę bez jej odtwarzania.

Eksporty są użyteczne do wewnętrznych przeglądów, zakupów i dyskusji offline. Jeśli Twoi użytkownicy tego potrzebują, oferuj CSV (do analizy) i PDF (do udostępniania). Eksportuj wybrane elementy, kryteria, znaczniki czasu i notatki o ocenach, aby plik nie wprowadzał w błąd przy późniejszym przeglądaniu.

Użytkownicy skorzystają z macierzy tylko wtedy, gdy jej zaufają. Jeśli strony podają mocne twierdzenia bez pokazywania źródeł lub dat weryfikacji, odbiorcy uznają je za stronnicze lub nieaktualne.

Traktuj każdą komórkę jak oświadczenie, które wymaga dowodu. Dla faktów (limity w planach, dostępność API, certyfikaty) przechowuj pole „source” obok wartości:

W UI pokaż źródło w sposób niezaśmiecający: mała etykieta „Source” w dymku lub rozszerzalny wiersz działa dobrze.

Dodaj metadane odpowiadające na pytania: „Jak świeża jest ta informacja?” i „Kto za nią odpowiada?”.

Dołącz datę „Last verified” dla każdego produktu (opcjonalnie dla każdego kryterium) oraz „Owner” (zespół lub osoba) odpowiedzialna za przegląd. To szczególnie ważne dla szybko zmieniających się elementów, jak funkcje, integracje czy warunki SLA.

Nie wszystko jest binarne. Dla subiektywnych kryteriów (łatwość konfiguracji, jakość wsparcia) lub niekompletnych danych pokaż poziomy pewności:

To zapobiega fałszywej precyzji i zachęca do zagłębienia się w notatki.

Na stronie produktu umieść mały changelog przy kluczowych zmianach (ceny, główne funkcje, postura bezpieczeństwa). Dzięki temu czytelnicy szybko zobaczą, co się zmieniło, a wracający interesariusze nie porównują przeterminowanych informacji.

Macierz działa tylko wtedy, gdy jest aktualna. Zanim opublikujesz pierwszą stronę, ustal, kto może zmieniać dane, jak te zmiany są weryfikowane i jak utrzymasz spójność ocen w setkach lub tysiącach wierszy.

Wybierz „źródło prawdy” dla danych macierzy:

Kluczowe jest nie tyle narzędzie, ile możliwość niezawodnej aktualizacji przez zespół bez łamania macierzy.

Traktuj zmiany jak wydania produktu, a nie przypadkowe edycje.

Praktyczny workflow:

Jeśli spodziewasz się częstych aktualizacji, wprowadź lekkie konwencje: prośby o zmianę, pole „powód aktualizacji” i harmonogramy przeglądów (miesięczne/kwartalne).

Walidacja zapobiega cichej erozji jakości macierzy:

Ręczna edycja nie skaluje się. Jeśli masz wielu dostawców lub częste źródła danych, zaplanuj:

Gdy workflow jest jasny i wymuszony, macierz pozostaje godna zaufania — a zaufanie sprawia, że użytkownicy działają.

Macierz wygląda prosto, ale doświadczenie zależy od tego, jak pobierasz, renderujesz i aktualizujesz mnóstwo ustrukturyzowanych danych bez opóźnień. Celem jest szybkie ładowanie stron i łatwość publikowania zmian przez zespół.

Wybierz model w zależności od częstotliwości zmian i interaktywności macierzy:

Tabele szybko rosną (wielu dostawców × wiele kryteriów). Zaplanuj wydajność wcześnie:

Wyszukiwanie powinno obejmować nazwy dostawców, alternatywne nazwy i kluczowe etykiety kryteriów. Dla relewantności indeksuj:

Zwracaj wyniki, które prowadzą użytkownika bezpośrednio do wiersza dostawcy lub sekcji kryterium, a nie tylko do ogólnego widoku wyników.

Śledź zdarzenia pokazujące zamiary i tarcia:

Dołącz aktywne filtry i identyfikatory porównywanych dostawców w payloadzie zdarzeń, aby wiedzieć, które kryteria napędzają decyzje.

Jeśli chcesz szybko wypuścić serwis porównań — bez tygodni pracy nad szkieletem, ekranami CRUD i podstawowym UX tabel — platforma typu vibe-coding taka jak Koder.ai może być praktycznym skrótem. Możesz opisać encje (produkty, kryteria, dowody), wymagane workflowy (przegląd/akceptacja) i kluczowe strony (hub kategorii, strona produktu, strona porównania) w czacie, a potem iterować nad wygenerowaną aplikacją.

Koder.ai jest szczególnie użyteczny, jeśli Twój docelowy stack pasuje do jego domyślnych ustawień: React na web, Go na backendzie z PostgreSQL, oraz opcjonalne Flutter, jeśli chcesz później mobilnego companiona do „zapisanych porównań”. Możesz też eksportować kod źródłowy, używać snapshotów/rollbacków podczas dopracowywania logiki ocen i wdrażać na własnych domenach, gdy będziesz gotowy do publikacji.

Strony porównań często są pierwszym punktem kontaktu dla użytkowników o wysokim zamiarze („X vs Y”, „najlepsze narzędzia do…”, „porównanie funkcji”). SEO działa najlepiej, gdy każda strona ma jasny cel, stabilny URL i treść rzeczywiście unikalną.

Nadaj każdej stronie porównawczej własny tytuł i H1 odpowiadający intencji:

Otwórz krótkim podsumowaniem: dla kogo jest to porównanie, co jest porównywane i jakie są główne różnice. Dodaj zwięzłą sekcję werdyktu (nawet jeśli to „najlepsze dla X, najlepsze dla Y”), żeby strona nie wyglądała jak generyczna tabela.

Dane strukturalne mogą poprawić widoczność w wynikach wyszukiwania, gdy odzwierciedlają widoczną treść.

Unikaj upychania na stronę schematu dla każdego typu lub dodawania pól, których nie możesz udokumentować dowodami. Konsekwencja i dokładność są ważniejsze niż ilość.

Filtrowanie i sortowanie mogą generować wiele niemal identycznych URL-i. Zdecyduj, co indeksować, a co nie:

Pomóż wyszukiwarkom i użytkownikom nawigować jak podczas oceny:

Używaj opisowych anchorów („porównaj model cenowy”, "funkcje bezpieczeństwa") zamiast powtarzalnego „kliknij tutaj”.

W dużych macierzach SEO zależy od tego, czego nie indeksujesz.

Uwzględniaj w sitemapie tylko wartościowe strony (huby, kluczowe produkty, wyselekcjonowane porównania). Trzymaj cienkie, automatycznie generowane kombinacje poza indeksacją i monitoruj statystyki crawl, aby roboty spędzały czas na stronach pomagających użytkownikom podejmować decyzje.

Macierz działa tylko wtedy, gdy jest dokładna, łatwa w użyciu i godna zaufania. Traktuj uruchomienie jako początek cyklu: testuj, wydawaj, ucz się i aktualizuj.

Przeprowadzaj testy użyteczności koncentrujące się na rzeczywistym rezultacie: czy użytkownicy szybciej i pewniej podejmują decyzje? Mierz:

UI porównań często nie spełnia podstaw dostępności. Przed uruchomieniem sprawdź:

Sprawdź najpierw najczęściej oglądane produkty i najważniejsze kryteria. Potem testuj przypadki brzegowe:

Ustal oczekiwania wewnętrzne i publiczne: dane się zmieniają.

Określ, jak użytkownicy mogą zgłaszać błędy lub sugerować aktualizacje. Oferuj prosty formularz z kategoriami (błąd danych, brakująca funkcja, problem UX) i ustal cele reakcji (np. potwierdzenie w 2 dni robocze). Z czasem to stanie się najlepszym źródłem informacji, co naprawić jako następne.

Zacznij od zdefiniowania głównej grupy odbiorców i konkretnej decyzji, którą mają podjąć (shortlista, zastąpienie systemu, RFP, weryfikacja wymagań). Następnie wybierz kryteria i domyślne ustawienia UX, które pasują do ograniczeń tej grupy.

Dobre wewnętrzne pytanie kontrolne: czy użytkownik może przejść od strony głównej do uzasadnionej shortlisty szybko, bez konieczności poznawania całego systemu oceniania?

Traktuj każdą komórkę jak tezę, którą trzeba udokumentować. Przechowuj dowody przy wartości (odniesienie do dokumentacji, notatka z wydania, wewnętrzny test) i pokazuj je w interfejsie np. w dymkach lub rozwijanych notatkach.

Pokaż także:

Użyj podstawowych encji, które utrzymają porównania spójne:

Modeluj kryteria jako obiekty wielokrotnego użytku i przechowuj każdą wartość produktu osobno, aby dodawanie nowych dostawców nie wymagało duplikowania listy kryteriów.

Wybieraj typy danych zgodne z tym, jak ludzie będą filtrować i porównywać:

Zdefiniuj jawne stany dla Unknown, Not applicable i Planned, aby puste komórki nie były interpretowane jako „Nie”.

Użyj niewielkiego zestawu powtarzalnych szablonów:

Wspieraj wiarygodność i jasność stronami takimi jak metodologia, słownik terminów i formularz kontaktowy / korekt.

Wybierz wzorce URL, które skalują się i są konsekwentne:

/compare/a-vs-b (i -vs-c dla wielokrotnego porównania)/category/ci-cdJeśli wspierasz udostępnialne widoki z filtrami, utrzymaj stabilną stronę bazową i stosuj query stringi (np. ?deployment=saas&compliance=soc2). Zaplanuj też canonical, aby unikać duplikatów SEO z filtrów i sortowań.

Napisz rubrykę dla każdego kryterium i wybierz styl oceniania, który pasuje:

Udokumentuj, jak nieznane wartości wpływają na sumy (0 vs neutralnie vs wyłączone) i stosuj tę regułę konsekwentnie w całym serwisie.

Wagi zmieniają opowieść, więc wybierz świadomie:

Jeśli umożliwiasz wagi użytkownika, dodaj ograniczenia (np. suma wag = 100, presety niskie/średnie/wysokie).

Projektuj pod szybkość dojścia do shortlisty:

Rozważ eksport CSV/PDF, jeśli zespół potrzebuje dokumentów do przetargu lub offline; dołącz daty i notatki o ocenach, aby pliki nie wprowadzały w błąd.

Typowe dźwignie wydajności dla dużych macierzy:

Praktyczne podejście: hybrydowe renderowanie — prebuduj stabilne strony i ładuj interaktywne dane macierzy przez API, dzięki czemu UI pozostaje szybki, a dane łatwe do aktualizacji.

Zacznij od testów użyteczności skupionych na wyniku: czy użytkownicy decydują szybciej i z większą pewnością? Daj uczestnikom realistyczny scenariusz (np. „wybierz najlepszą opcję dla zespołu 50-osobowego z wysokimi wymaganiami bezpieczeństwa”) i mierz: