Co wyjaśnia ta historia (ponad profil założyciela)

To nie biografia Jay’a Chaudhry’ego. To praktyczna opowieść o tym, jak Zscaler pomógł przekształcić bezpieczeństwo korporacyjne — i dlaczego jego wybory (techniczne i komercyjne) miały znaczenie.

Dowiesz się dwóch rzeczy równolegle:

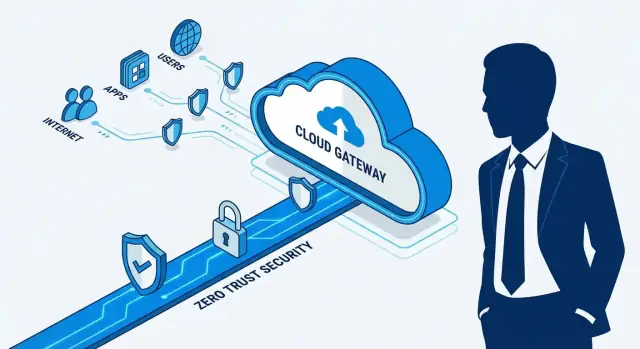

- Modelu bezpieczeństwa: jak działa „zero trust”, gdy aplikacje i użytkownicy są rozproszeni po usługach chmurowych, biurach i domach.

- Modelu biznesowego: jak firma bezpieczeństwa jest przyjmowana przez duże przedsiębiorstwa, które działają powoli, kupują przez partnerów i unikają ryzykownych migracji.

Co oznacza „nowoczesne bezpieczeństwo przedsiębiorstwa” (prostym językiem)

Nowoczesne bezpieczeństwo przedsiębiorstwa to zestaw kontroli pozwalających pracownikom bezpiecznie korzystać z internetu i aplikacji wewnętrznych, bez założenia, że coś jest bezpieczne tylko dlatego, że jest „wewnątrz” sieci firmowej. Chodzi mniej o budowanie większego muru wokół data center, a bardziej o sprawdzanie kto się łączy, do czego się łączy i czy połączenie powinno być dozwolone — za każdym razem.

Trzy filary, do których wrócimy

- Dostawa z chmury: funkcje bezpieczeństwa przenoszą się z pudełek na miejscu do usługi, która może skalować się globalnie.

- Zero trust: dostęp opiera się na tożsamości, kontekście i polityce — nie na położeniu sieciowym.

- Dystrybucja: bezpieczeństwo przedsiębiorstwa rozprzestrzenia się przez realia zakupowe: partnerów kanałowych, incumbentów i powtarzalne wdrożenia.

Co wyniesiesz

Po lekturze będziesz w stanie w jednym zdaniu wyjaśnić główny zakład Zscaler, rozpoznać, gdzie zero trust zastępuje myślenie ery VPN-ów i zobaczyć, dlaczego strategia dystrybucji może mieć takie samo znaczenie jak projekt produktu.

Jay Chaudhry w skrócie: perspektywa założyciela

Jay Chaudhry to seryjny przedsiębiorca najbardziej znany jako założyciel i CEO Zscaler, firmy, która pomogła przesunąć bezpieczeństwo korporacyjne z „chronienia sieci firmowej” do „bezpiecznego dostępu do użytkowników i aplikacji, gdziekolwiek się znajdują”. Przed Zscaler budował i sprzedawał kilka startupów bezpieczeństwa, co dało mu pierwsze miejsce, by obserwować, jak szybko zmienia się zachowanie atakujących i IT w przedsiębiorstwach.

Problem, za którym poszedł

Skupienie Chaudhry’ego z Zscaler było proste: w miarę jak praca i aplikacje przemieszczały się poza sieć korporacyjną (w kierunku internetu publicznego i usług chmurowych), stary model kierowania wszystkiego przez centralne data center w celu inspekcji zaczął się rozpadać.

Ta zmiana stworzyła dla zespołów IT bolesny kompromis:

- Jeśli wymusisz, by cały ruch wracał przez siedzibę, wydajność cierpi, a użytkownicy omijają kontrole.

- Jeśli pozwolisz użytkownikom łączyć się bezpośrednio z aplikacjami chmurowymi, widoczność i egzekwowanie polityk słabnie.

Punkt wyjścia Zscaler był prosty: bezpieczeństwo musi podążać za użytkownikiem, a nie za budynkiem.

Wizja prowadzona przez założyciela, która ukształtowała kategorię

Wyróżniało się to, jak wizja produktowa kierowana przez założyciela wpłynęła na strategię firmy od początku:

- Chmura jako priorytet zamiast wysyłania urządzeń, które klienci musieli utrzymywać.

- Egzekwowanie polityk w skali przez umieszczanie inspekcji bliżej punktów, gdzie użytkownicy się łączą.

- Jasny punkt widzenia architektoniczny: zmniejszanie zaufania domyślnego, ciągłe weryfikowanie dostępu i traktowanie internetu i chmury jako środowiska domyślnego.

To nie był marketingowy dodatek; kierowało to decyzjami produktowymi, partnerstwami i tym, jak Zscaler wyjaśniał „dlaczego” konserwatywnym nabywcom enterprise. Z czasem ta klarowność pomogła przekształcić „bezpieczeństwo dostarczane z chmury” i „zero trust” z idei w pozycje budżetowe — coś, co duże firmy mogły kupić, wdrożyć i ustandaryzować.

Dlaczego stary model perymetru przestał działać

Przez lata bezpieczeństwo przedsiębiorstwa budowano wokół prostej idei: trzymaj „dobre rzeczy” wewnątrz sieci firmowej i postaw mur wokół nich. Ten mur to zwykle stos urządzeń on‑prem — firewalle, proxy webowe, systemy IPS — ustawione w kilku data center. Pracownicy zdalni łączyli się przez VPN, który w praktyce „rozszerzał” sieć wewnętrzną tam, gdzie się znajdowali.

Stary model w praktyce

Gdy większość aplikacji była w data center firmy, to działało całkiem nieźle. Ruch webowy i aplikacyjny przepływał przez te same wąskie gardła, gdzie zespoły bezpieczeństwa mogły inspektować, logować i blokować.

Ale model zakładał dwie rzeczy, które zaczęły przestawać być prawdą:

- Użytkownicy głównie przebywali w biurach na zarządzanych sieciach.

- Aplikacje były głównie wewnątrz perymetru.

Dlaczego się złamał: roaming, SaaS i otwarty internet

W miarę jak pracownicy stawali się bardziej mobilni, a adopcja SaaS przyspieszyła, wzorce ruchu uległy odwróceniu. Ludzie w kawiarniach potrzebowali szybkiego dostępu do Office 365, Salesforce i dziesiątek narzędzi przeglądarkowych — często bez dotykania data center firmy.

Aby utrzymać egzekwowanie polityk, wiele firm „backhaulowało” ruch: wysyłano żądania internetowe i SaaS przez HQ, inspektowano je, a potem odsyłano na zewnątrz. Skutek był przewidywalny: wolna wydajność, niezadowoleni użytkownicy i rosnąca presja na tworzenie obejść w kontrolach.

Pierwsze bóle zespołów bezpieczeństwa

Złożoność wzrosła (więcej urządzeń, więcej reguł, więcej wyjątków). VPN-y stały się przeciążone i ryzykowne, gdy dawały szeroki dostęp sieciowy. Każde nowe biuro czy akwizycja oznaczały kolejną dostawę sprzętu, więcej planowania pojemności i kruchą architekturę.

Ta luka — potrzeba spójnego bezpieczeństwa bez wymuszania wszystkiego przez fizyczny perymetr — stworzyła przestrzeń dla bezpieczeństwa dostarczanego z chmury, które mogło podążać za użytkownikiem i aplikacją, a nie budynkiem.

Bezpieczeństwo dostarczane z chmury: kluczowy zakład

Definiujący zakład Zscaler był prosty w słowach, ale trudny do wykonania: dostarczać bezpieczeństwo jako usługę chmurową, pozycjonowaną blisko użytkowników, zamiast jako pudełka w sieci firmy.

W tym kontekście „bezpieczeństwo w chmurze” nie oznacza tylko ochrony serwerów chmurowych. Oznacza, że samo zabezpieczenie działa w chmurze — więc użytkownik w oddziale, w domu lub na urządzeniu mobilnym łączy się z pobliskim punktem obecności (PoP), a polityka jest tam egzekwowana.

Co znaczy inspekcja „inline” (bez żargonu)

„Inlining” to jak skierowanie ruchu przez punkt kontrolny bezpieczeństwa w drodze do celu.

Gdy pracownik odwiedza stronę lub aplikację chmurową, jego połączenie jest najpierw kierowane przez usługę. Usługa inspektuje to, co może (zgodnie z polityką), blokuje ryzykowne miejsca, skanuje zagrożenia, a potem przekazuje dozwolony ruch dalej. Celem jest to, by użytkownicy nie musieli „być w sieci firmowej”, aby mieć ochronę na poziomie korporacyjnym — bezpieczeństwo podąża za użytkownikiem.

Dlaczego to atrakcyjne dla przedsiębiorstw

Bezpieczeństwo dostarczane z chmury zmienia codzienność zespołów IT i bezpieczeństwa:

- Prostsze wdrożenie: mniej urządzeń do wysyłki, montażu i utrzymania w każdej lokalizacji.

- Szybsze aktualizacje: ochrony można aktualizować centralnie, bez czekania na cykle aktualizacji on‑prem.

- Spójna polityka: jeden zestaw reguł dla biur, pracowników zdalnych i wielu chmur.

Model ten także pasuje do tego, jak firmy faktycznie pracują teraz: ruch często idzie bezpośrednio do SaaS i internetu publicznego, a nie „przez centralę”.

Kompromisy (bez marketingu)

Wstawienie stron trzecich inline rodzi realne obawy, które zespoły muszą rozważyć:

- Zaufanie i przetwarzanie danych: co jest inspektowane, logowane, odszyfrowywane (jeśli w ogóle) i jak długo jest przechowywane.

- Różnice w widoczności: niektóre zespoły tęsknią za „widokiem pudełkowym”, nawet jeśli pulpity poprawiają sytuację.

- Zależność od usługi: awarie lub problemy regionalne mogą szybko stać się problemem biznesowym.

Kluczowy zakład to więc nie tylko aspekt techniczny — to zaufanie operacyjne, że dostawca chmurowy potrafi egzekwować polityki niezawodnie, przejrzyście i w skali globalnej.

Zero Trust wyjaśnione dla nietechnicznych czytelników

Zero trust to prosta zasada: nigdy nie zakładaj, że coś jest bezpieczne tylko dlatego, że jest „wewnątrz sieci firmy”. Zamiast tego zawsze weryfikuj kto to jest, na jakim urządzeniu pracuje i czy powinien mieć dostęp do konkretnej aplikacji lub danych — zawsze, gdy ma to znaczenie.

Przesunięcie: z „dostępu do sieci” na „dostęp do aplikacji”

Tradycyjne myślenie o VPN to jak nadanie komuś przepustki, która otwiera cały budynek po przejściu przez drzwi. Po połączeniu VPN wiele systemów traktuje użytkownika jako „wewnętrznego”, co może odsłonić więcej niż zamierzono.

Zero trust odwraca ten model. To bardziej jak przyznanie komuś dostępu do jednego pokoju na jedno zadanie. Nie „dołączasz szeroko do sieci”; masz dostęp tylko do aplikacji, do której jesteś zatwierdzony.

Proste, codzienne przykłady

Kontraktor potrzebuje dostępu do narzędzia do zarządzania projektami na dwa miesiące. Z zero trust może otrzymać dostęp tylko do tej jednej aplikacji — bez przypadkowego uzyskania ścieżki do systemów płac czy narzędzi administracyjnych.

Pracownik używa prywatnego laptopa (BYOD) w podróży. Polityki zero trust mogą wymagać silniejszych mechanizmów logowania lub zablokować dostęp, jeśli urządzenie jest przestarzałe, niezaszyfrowane lub wykazuje ślady kompromitacji.

Praca zdalna staje się łatwiejsza do zabezpieczenia, ponieważ decyzja o bezpieczeństwie podąża za użytkownikiem i aplikacją, a nie za fizyczną siecią biura.

Czym zero trust nie jest

Zero trust to nie pojedynczy produkt, który kupujesz i „włączasz”. To podejście do bezpieczeństwa wdrażane za pomocą narzędzi i polityk.

Także nie oznacza „nie ufaj nikomu” w wrogi sposób. W praktyce oznacza to, że zaufanie jest zdobywane ciągle przez weryfikację tożsamości, stan urządzenia i zasadę najmniejszych uprawnień — dzięki czemu błędy i naruszenia nie rozprzestrzeniają się automatycznie.

Wysoki poziom mapy podejścia Zscaler

Zaplanować budowę przed kodem

Najpierw zaplanuj mapę użytkowników, aplikacji i reguł, potem wygeneruj aplikację, gdy przepływ będzie jasny.

Zscaler najłatwiej zrozumieć jako chmurowy „punkt kontroli”, który znajduje się między ludźmi a tym, do czego próbują się dostać. Zamiast ufać granicy sieci firmowej, ocenia każde połączenie na podstawie tego, kim jest użytkownik i jak wygląda kontekst, a potem stosuje odpowiednią politykę.

Podstawowe elementy budowy

Większość wdrożeń można opisać czterema prostymi elementami:

- Użytkownicy: pracownicy, kontraktorzy, partnerzy — każda tożsamość logująca się.

- Aplikacje i destynacje: publiczne strony (SaaS, web) i aplikacje prywatne (systemy wewnętrzne).

- Polityki: reguły typu „finanse mają dostęp do płac”, „blokuj ryzykowne uploady plików” lub „wymagaj silniejszych sprawdzeń poza siecią”.

- Egzekwowanie w chmurze: usługa bezpieczeństwa w chmurze stosuje te polityki blisko miejsca, gdzie użytkownicy się łączą, zamiast odsyłać ruch do jednego data center.

Dwa pasy: bezpieczeństwo internetu vs. dostęp do prywatnych aplikacji

Koncepcyjnie Zscaler dzieli ruch na dwa pasy:

- Internet/SaaS (Secure Web Gateway): chroni przeglądanie i użycie aplikacji chmurowych — filtrowanie, inspekcja i kontrola tego, co opuszcza i wchodzi do sesji użytkownika.

- Dostęp do aplikacji prywatnych: zapewnia połączenia specyficzne dla aplikacji wewnętrznych bez umieszczania użytkownika „w sieci” jak w tradycyjnym VPN.

To rozdzielenie ma znaczenie: jeden pas dotyczy bezpiecznego korzystania z internetu; drugi — precyzyjnego dostępu do systemów wewnętrznych.

„Tożsamość + kontekst” bez żargonu

Decyzje nie opierają się na zaufanym adresie IP biura. Opierają się na sygnałach, takich jak kim jest użytkownik, stan urządzenia (zarządzane vs niezrządzane, załatanie vs przestarzałe) oraz skąd/jak się łączy.

Jak to przekłada się na rezultaty

Dobrze wykonane, podejście to zmniejsza powierzchnię ataku, ogranicza ruch boczny w razie problemu i upraszcza model kontroli dostępu — szczególnie gdy praca zdalna i stosy aplikacji cloud-first stają się domyślne.

Secure Web Gateway: strona internetowa opowieści

Gdy mówimy o „bezpieczeństwie enterprise”, często wyobrażamy sobie aplikacje prywatne i sieci wewnętrzne. Jednak duża część ryzyka leży po stronie otwartego internetu: pracownicy przeglądają strony, klikają linki w mailach, korzystają z narzędzi przeglądarkowych lub wysyłają pliki do aplikacji webowych.

Secure Web Gateway (SWG) to kategoria narzędzi stworzona, by uczynić codzienne korzystanie z internetu bezpieczniejszym — bez konieczności przepychania ruchu każdego użytkownika przez centralę.

Jaki problem rozwiązuje SWG

Najprościej: SWG działa jako kontrolowany punkt między użytkownikami a publicznym webem. Zamiast ufać temu, co urządzenie osiąga, brama stosuje polityki i inspekcję, aby organizacje zmniejszały ekspozycję na złośliwe strony, ryzykowne pobrania i przypadkowe wycieki danych.

Typowe zabezpieczenia to:

- Filtrowanie URL: zezwalaj/odmawiaj według kategorii, reputacji lub polityki

- Blokowanie malware: zatrzymuj znane złe pliki, podejrzane skrypty i miejsca phishingowe

- Kontrole danych: wykrywaj i zapobiegaj wysyłaniu wrażliwych danych do niezatwierdzonych miejsc

Dlaczego chmurowy SWG przyspieszył wraz z SaaS i mobilnymi użytkownikami

Przełom nastąpił, gdy praca przestała odbywać się w stałych biurach, a przeniosła się w stronę SaaS, przeglądarek i urządzeń mobilnych. Jeśli użytkownicy i aplikacje są wszędzie, odsyłanie ruchu do jednego perymetru firmowego dodaje opóźnień i tworzy martwe punkty.

SWG dostarczany z chmury odpowiada nowej rzeczywistości: polityka podąża za użytkownikiem, ruch można inspektować bliżej miejsca połączenia, a zespoły bezpieczeństwa uzyskują spójną kontrolę w głównym biurze, oddziałach i pracy zdalnej — bez traktowania internetu jako wyjątku.

Zastępowanie myślenia VPN podejściem zorientowanym na aplikacje

VPN-y powstały w czasach, gdy „bycie w sieci” równało się „możliwości dotarcia do aplikacji”. Ten model psuje się, gdy aplikacje żyją w wielu chmurach, SaaS i coraz mniejszej liczbie systemów on‑prem.

Dostęp do aplikacji prywatnych bez odsłaniania sieci

Dostęp zorientowany na aplikację odwraca domyślność. Zamiast umieszczać użytkownika w sieci wewnętrznej (i liczyć, że polityki segmentacji zadziałają), użytkownik łączy się tylko z konkretną aplikacją.

Konceptualnie działa to jak pośredniczone połączenie: użytkownik udowadnia, kim jest i do czego ma prawo, a potem tworzona jest krótka, kontrolowana ścieżka do tej aplikacji — bez publikowania wewnętrznych zakresów IP w internecie i bez dawania szerokiej „wewnętrznej” widoczności.

Dlaczego segmentacja aplikacji jest często lepsza niż segmentacja sieci

Segmentacja sieci jest potężna, ale w realnych organizacjach krucha: fuzje, płaskie VLANy, legacyjne aplikacje i wyjątki mają tendencję do narastania. Segmentacja aplikacji jest łatwiejsza do zrozumienia, ponieważ odpowiada intencjom biznesowym:

- Użytkownicy finansów mogą dotrzeć do aplikacji finansowej.

- Kontraktorzy mają dostęp do jednego narzędzia projektowego.

- Administratorzy mają dostęp do konsol uprzywilejowanych — z silniejszymi kontrolami.

To zmniejsza zaufanie domyślne i sprawia, że polityki dostępu są czytelne: można je audytować według aplikacji i grup użytkowników zamiast śledzenia tras i podsieci.

Typowa ścieżka adopcji

Większość zespołów nie zastępuje VPN z dnia na dzień. Praktyczne wdrożenie zwykle wygląda tak:

- Zacznij od jednej aplikacji wewnętrznej, która powoduje ból związany z VPN (help desk, portal deweloperski, narzędzie HR).

- Rozszerz do jednego działu, potem do kolejnych aplikacji.

- Zachowaj VPN jako plan awaryjny w trakcie przejścia, potem stopniowo ograniczaj jego użycie.

Wyniki biznesowe, które możesz zmierzyć

Gdy dostęp zorientowany na aplikację jest dobrze wdrożony, korzyści pojawiają się szybko: mniej zgłoszeń związanych z VPN, jaśniejsze reguły dostępu, które zespół bezpieczeństwa i IT potrafi wyjaśnić, oraz lepsze doświadczenie użytkownika — szczególnie dla pracowników zdalnych i hybrydowych, którzy po prostu chcą, żeby aplikacja działała bez „łączenia się z siecią”.

Dystrybucja: jak bezpieczeństwo enterprise rzeczywiście się skaluje

Wspieraj dystrybucję narzędziami

Stwórz portale dla partnerów lub SI, które ułatwią zarządzanie wdrożeniami enterprise.

Świetne produkty bezpieczeństwa nie stają się automatycznie standardami enterprise. W praktyce „dystrybucja” w bezpieczeństwie to zestaw dróg, którymi dostawca dociera do decyzji zakupowych i potrafi wygrać oraz skutecznie wdrożyć w dużych organizacjach — często przez inne firmy.

Co obejmuje „dystrybucja” naprawdę

W bezpieczeństwie dystrybucja zwykle obejmuje:

- Partnerów kanałowych i resellerów, którzy wprowadzają produkt, łączą go z innymi narzędziami i pomagają przebrnąć przez zakup.

- Integratorów systemów (SI) i dostawców usług zarządzanych (MSP), którzy projektują wdrożenia, łączą tożsamość i sieć oraz prowadzą operacje day‑2.

- Sojusze technologiczne (dostawcy tożsamości, endpointów, platform chmurowych), które ułatwiają wdrożenia i zwiększają pewność nabywców.

To nie są opcjonalne dodatki. To rury, które łączą dostawcę z budżetami, decydentami i zdolnością wdrożeniową.

Dlaczego kanał ma większe znaczenie, niż się spodziewasz

Duże przedsiębiorstwa kupują ostrożnie. Partnerzy dostarczają:

- Zaufanie i weryfikację („wdrożyliśmy to wcześniej”)

- Pomoc we wdrożeniu, gdy zespoły wewnętrzne są obciążone

- Zasięg zakupowy poprzez zatwierdzone listy dostawców i istniejące umowy

- Pokrycie geograficzne i branżowe bez budowania ogromnego bezpośredniego zespołu sprzedaży wszędzie

Dla platformy takiej jak Zscaler adopcja często zależy od rzeczywistej pracy migracyjnej — przenoszenia użytkowników z wzorców legacy VPN, integracji tożsamości i strojenia polityk. Partnerzy mogą sprawić, że ta zmiana będzie wykonalna.

Jak chmura zmienia sposób sprzedaży

Dostawa z chmury przesuwa biznes z jednorazowych instalacji do subskrypcji, ekspansji i odnówień. To zmienia dystrybucję: partnerzy nie są już tylko „domykaczami transakcji”. Mogą być ciągłymi partnerami wdrożeniowymi, których incentywy pokrywają się z wynikami klienta — jeśli program jest dobrze zaprojektowany.

Na co zwrócić uwagę (dla zespołów oceniających dostawców)

Przyjrzyj się uważnie incentywom dla partnerów, jakości enablementu partnerów (szkolenia, playbooki, wsparcie we wspólnej sprzedaży) i temu, jak czytelne są przekazania do customer success po podpisaniu umowy. Wiele wdrożeń nie udaje się nie dlatego, że produkt jest słaby, lecz dlatego, że podział odpowiedzialności między dostawcą, partnerem i klientem jest niejasny.

Czas kategorii: chmura, praca zdalna oraz SASE/SSE

Zakupy bezpieczeństwa rzadko zaczynają się od „potrzebujemy lepszego bezpieczeństwa”. Zwykle zaczynają się od zmiany sieci, która łamie stare założenia: więcej aplikacji przenosi się do SaaS, oddziały przechodzą na SD‑WAN, albo praca zdalna staje się trwała. Gdy ruch już nie przepływa przez centralę, model „chroń wszystko w centrali” zamienia się w wolne połączenia, chaotyczne wyjątki i martwe punkty.

Dlaczego timing kategorii miał znaczenie

Zscaler często pojawia się w tych samych rozmowach co SASE i SSE, bo te etykiety opisują zmianę w sposobie dostarczania bezpieczeństwa:

- SSE (Security Service Edge), mówiąc prosto: kontrolki bezpieczeństwa dostarczane z chmury, aby użytkownicy mieli spójną ochronę, gdziekolwiek są.

- SASE (Secure Access Service Edge): ta sama idea plus część sieciowa (zwykle SD‑WAN), tak by łączność i bezpieczeństwo były planowane razem.

Prawdziwy „przekład korzyści” to nie akronim — to prostsze operacje: mniej pudełek on‑prem, łatwiejsze aktualizacje polityk i bardziej bezpośredni dostęp do aplikacji bez odsyłania ruchu przez data center.

Praktyczna lista kontrolna: kiedy zespoły oceniają te rozwiązania

Firma zwykle rozważa podejścia typu SSE/SASE, gdy:

- Migracja do chmury zwiększa ruch do internetu i SaaS znacząco

- Wdrożenie SD‑WAN zmienia trasowanie oddziałów i ujawnia luki w istniejących kontrolach

- Pojawiają się chroniczne problemy z pojemnością VPN i doświadczeniem użytkownika (szczególnie dla kontraktorów)

- Polityki bezpieczeństwa różnią się między biurami, bo narzędzia są wdrażane site‑by‑site

- Zespół potrzebuje szybszego onboardingu dla nowych lokalizacji, przejęć lub użytkowników zdalnych

- Audyty wymagają klarownej widoczności, kto, kiedy i skąd uzyskał dostęp do której aplikacji

Gdy te czynniki się pojawiają, kategoria „przychodzi” naturalnie — bo sieć już się zmieniła.

Realia wdrożeniowe: co decyduje o powodzeniu

Zamień naukę na kredyty

Podziel się tym, co zbudujesz z Koder.ai i zdobądź kredyty w ramach programu treści.

Kupienie platformy Zero Trust to zwykle łatwa część. Sprawienie, by zadziałała w rozdrobnionych sieciach, z odziedziczonymi aplikacjami i prawdziwymi ludźmi, to miejsce, gdzie projekty odnoszą sukces albo zatrzymują się.

Najczęstsze przeszkody adopcyjne

Legacyjne aplikacje to powtarzający się winowajca. Starsze systemy mogą zakładać „wewnątrz sieci = zaufane”, opierać się na statycznych listach IP albo psuć się, gdy ruch jest inspektowany.

Inne tarcia są ludzkie: zarządzanie zmianą, przeprojektowanie polityk i dyskusje o tym, „kto za co odpowiada”. Przejście od szerokiego dostępu sieciowego do precyzyjnych reguł na poziomie aplikacji wymusza dokumentowanie, jak praca naprawdę przebiega — i to może ujawnić długo ignorowane luki.

Interesariusze, których warto zaangażować wcześnie

Wdrożenia idą płynniej, gdy bezpieczeństwo nie próbuje działać samodzielnie. Przygotuj się na współpracę z:

- Zespołami bezpieczeństwa i sieci (kierowanie ruchem, decyzje dotyczące segmentacji)

- IT/help deskiem (stan urządzeń, onboarding, wsparcie użytkownika)

- Compliance/ryzykiem (logowanie, przetwarzanie danych, oczekiwania audytowe)

- Właścicielami aplikacji biznesowych (co jest krytyczne, co może się popsuć, co się wkrótce zmienia)

Strategia pilota zmniejszająca ryzyko

Zacznij od grupy o niskim ryzyku (np. jednego działu lub podzbioru kontraktorów) i zdefiniuj metryki sukcesu z góry: mniej zgłoszeń związanych z VPN, szybszy dostęp do aplikacji, mierzalne zmniejszenie odsłoniętej powierzchni ataku lub lepsza widoczność.

Przeprowadzaj pilota iteracyjnie: migruj jedną kategorię aplikacji naraz, dostrajaj polityki, potem rozszerzaj. Cel to szybkie uczenie się bez przekształcania całej firmy w środowisko testowe.

Realia operacyjne: praca po wdrożeniu (day‑2)

Zaplanuj logowanie i rozwiązywanie problemów od pierwszego dnia: gdzie są logi, kto może je przeszukiwać, jak długo są przechowywane i jak alerty łączą się z reakcją na incydenty. Jeśli użytkownicy nie mogą łatwo uzyskać pomocy, gdy „aplikacja jest zablokowana”, zaufanie spada szybko — nawet jeśli model bezpieczeństwa jest poprawny.

Przyspieszaczem, który często się sprawdza, są wewnętrzne narzędzia: proste portale do zgłaszania wyjątków, przeglądów dostępu, inwentaryzacji aplikacji, śledzenia wdrożeń i raportowania. Zespoły coraz częściej budują te lekkie „klejące” aplikacje samodzielnie zamiast czekać na roadmapę dostawcy. Platformy takie jak Koder.ai pomagają prototypować i wdrażać te wewnętrzne narzędzia webowe szybko przez chat‑driven workflow — przydatne, gdy potrzebujesz dashboardu w React z backendem w Go/PostgreSQL i szybkich iteracji w miarę dojrzewania polityk i procesów.

Ryzyka i kompromisy do rozważenia (bez hype'u)

Przeniesienie kontroli bezpieczeństwa z urządzeń, które posiadasz, do platformy chmurowej może uprościć operacje — ale zmienia też to, na co stawiasz. Dobra decyzja to nie „Zero Trust kontra legacy”, lecz zrozumienie nowych trybów awarii.

Ryzyko koncentracji (jeden dostawca, wiele funkcji)

Jeśli jedna platforma zapewnia bezpieczeństwo webowe, dostęp do aplikacji prywatnych, egzekwowanie polityk i logowanie, redukujesz rozproszenie narzędzi — ale też koncentrujesz ryzyko. Spór kontraktowy, zmiana cen czy luka produktowa może mieć szerszy zasięg niż przy rozdzieleniu funkcji między różne narzędzia.

Zależność od wydajności i dostępności

Bezpieczeństwo chmurowe dodaje extra hop między użytkownikami a aplikacjami. Kiedy działa dobrze, użytkownicy tego nie zauważają. Gdy region ma awarię, problem z routingiem lub pojemnością, „bezpieczeństwo” może wyglądać jak „internet nie działa”. To mniej kwestia pojedynczego dostawcy, a bardziej polegania na stałej łączności.

Błędna konfiguracja wciąż jest największym ryzykiem

Zero Trust nie jest magiczną tarczą. Źle sformułowane polityki (zbyt przyzwalające, zbyt restrykcyjne lub niespójne między grupami) mogą zwiększyć ekspozycję lub przerywać pracę. Im bardziej elastyczny silnik polityk, tym więcej dyscypliny potrzeba.

Jak nabywcy redukują te ryzyka

Fazowe wdrożenia pomagają: zacznij od jasnego przypadku użycia (np. podzbiór użytkowników lub jedna kategoria aplikacji), mierz opóźnienia i wyniki dostępu, potem rozszerzaj. Definiuj polityki prostym językiem, wdrażaj monitorowanie i alertowanie wcześnie oraz planuj redundancję (trasowanie multi‑regionowe, dostęp awaryjny „break‑glass” i udokumentowane ścieżki awaryjne).

Rzeczywiste zarządzanie, które ma znaczenie

Wiedź, jakie typy danych chronisz (regulowane vs ogólne), dopasuj kontrole do wymogów zgodności i zaplanuj cykliczne przeglądy dostępu. Cel to nie kupowanie ze strachu — to sprawienie, by nowy model zawodził bezpiecznie i przewidywalnie.

Najważniejsze wnioski: co zespoły i założyciele mogą skopiować

1) Jasna teza produktowa bije długą listę funkcji

Powtarzalna lekcja Zscaler to koncentracja: przenieś egzekwowanie polityk do chmury i spraw, by dostęp był prowadzony przez tożsamość. Przy ocenie dostawców (lub tworzeniu produktu) zadaj proste pytanie: „Jaki jest jeden zakład architektoniczny, który upraszcza wszystko inne?” Jeśli odpowiedź brzmi „to zależy”, spodziewaj się, że złożoność pojawi się później w koszcie, czasie wdrożenia i wyjątkach.

2) Jasność kategorii to strategia wzrostu

„Zero trust” zadziałał, bo przekładał się na praktyczną obietnicę: mniej domyślnego zaufania, mniej sieciowej instalacji i lepsza kontrola, gdy aplikacje przeniosły się poza on‑prem. Dla zespołów oznacza to kupowanie wyników, nie buzzwordów. Zapisz oczekiwane rezultaty (np. „brak ruchu przychodzącego”, „najmniejsze uprawnienia do aplikacji”, „spójna polityka dla użytkowników zdalnych”) i dopasuj je do konkretnych możliwości do przetestowania.

3) Partnerzy skalują bezpieczeństwo enterprise szybciej niż samodzielna sprzedaż

Bezpieczeństwo przedsiębiorstwa rozprzestrzenia się przez sieci zaufania: resellerów, GSI, MSP i rynki chmurowe. Założyciele mogą skopiować to, tworząc produkt gotowy dla partnerów — jasne pakiety, przewidywalne marże, playbooki wdrożeniowe i wspólne metryki. Liderzy bezpieczeństwa też powinni korzystać z partnerów: użyj ich do zarządzania zmianą, integracji tożsamości i migracji etapowych zamiast próbować przeszkolić każdy wewnętrzny zespół.

4) Praktyczne wskazówki dla liderów bezpieczeństwa rozważających chmurę/zero trust

Zacznij od jednego, wysokiego wolumenu przypadku użycia (często dostęp do internetu lub jedna krytyczna aplikacja), mierz przed/po i rozszerzaj.

Kluczowe pytania wdrożeniowe:

- Co jest „źródłem prawdy” dla tożsamości (i członkostwa w grupach)?

- Jak poradzicie sobie z legacy aplikacjami, kontraktorami i BYOD?

- Jaki jest plan odpowiedzialności za polityki: bezpieczeństwo, sieć czy współdzielone?

5) Praktyczne wskazówki dla założycieli dotyczące dystrybucji i tworzenia kategorii

Nie sprzedawaj tylko „bezpieczeństwa” — sprzedawaj ścieżkę migracji. Zwycięska historia to zwykle: ból → najprostszy pierwszy krok → wymierne zwycięstwo → ekspansja. Zbuduj onboarding i raportowanie, które uwidaczniają wartość w 30–60 dni.

Jednym z wzorców przyjaznych założycielowi jest uzupełnienie produktu o szybkie do zbudowania aplikacje towarzyszące (workflowy ocen, trackery migracji, kalkulatory ROI, portale partnerów). Jeśli chcesz je tworzyć bez odbudowy pełnego legacy pipeline’u deweloperskiego, Koder.ai jest zaprojektowany do „vibe‑kodowania” pełnostackowych aplikacji z chatu — przydatne, by szybko wprowadzić narzędzia wewnętrzne lub klienta do produkcji, a potem iterować wraz z rozwojem dystrybucji.

Jeśli chcesz pójść głębiej, zobacz wpisy zero-trust-basics i sase-vs-sse-overview. Pomysły na pakowanie oferty znajdziesz w sekcji pricing.