18 gru 2025·8 min

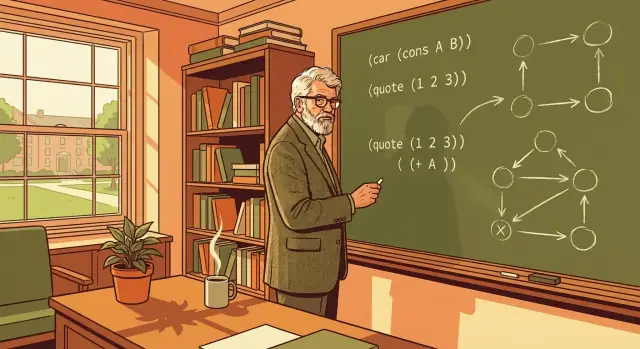

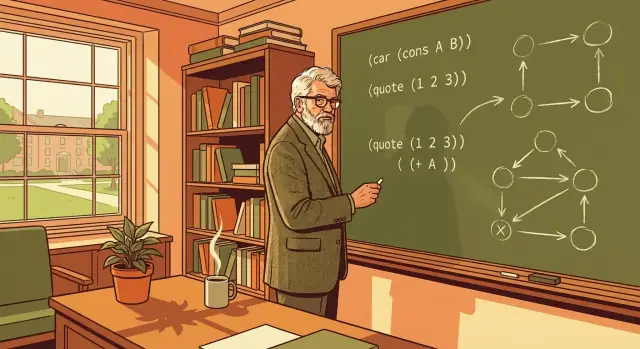

John McCarthy, Lisp i korzenie symbolicznego projektowania AI

Poznaj, jak symboliczne podejście Johna McCarthy’ego i pomysły projektowe Lispa — listy, rekurencja i garbage collection — wpłynęły na AI i współczesne programowanie.

Poznaj, jak symboliczne podejście Johna McCarthy’ego i pomysły projektowe Lispa — listy, rekurencja i garbage collection — wpłynęły na AI i współczesne programowanie.

To nie jest muzealny przegląd „starego AI”. To praktyczna lekcja historii dla każdego, kto tworzy oprogramowanie — programistów, liderów technicznych i ludzi budujących produkty — ponieważ pomysły Johna McCarthy’ego ukształtowały nasze myślenie o tym, do czego służą języki programowania.

Lisp to nie tylko nowa składnia. To zakład, że oprogramowanie może manipulować ideami (nie tylko liczbami) i że wybory w projektowaniu języka mogą przyspieszyć badania, iteracje produktowe i całe ekosystemy narzędziowe.

Użyteczny sposób czytania spuścizny McCarthy’ego to postawienie pytania, które nadal jest istotne: jak bezpośrednio możemy zamienić intencję w system wykonywalny — bez topienia się w boilerplate, tarciach czy przypadkowej złożoności? To pytanie rozbrzmiewa od REPL-a Lispa aż do współczesnych przepływów „chat→aplikacja”.

John McCarthy jest pamiętany nie tylko za współtworzenie pola badań AI, ale za upieranie się przy specyficznym rodzaju AI: systemach, które potrafią manipulować ideami, a nie tylko liczyć odpowiedzi. W połowie lat 50. zorganizował Dartmouth Summer Research Project (gdzie zaproponowano termin „sztuczna inteligencja”) i później wpływał na prace w MIT i Stanfordzie. Jednak jego najtrwalszym wkładem może być pytanie, które ciągle zadawał: co jeśli samo rozumowanie można wyrazić jako program?

Wiele wczesnych sukcesów informatycznych było numerycznych: tabele balistyczne, symulacje inżynierskie, optymalizacja i statystyka. Te problemy dobrze pasowały do arytmetyki.

McCarthy celował w coś innego. Ludzkie rozumowanie często operuje pojęciami typu „jeśli”, „ponieważ”, „należy do”, „jest rodzajem” i „wszystkie rzeczy spełniające te warunki”. To nie są naturalnie reprezentowane jako wartości zmiennoprzecinkowe.

Podejście McCarthy’ego traktowało wiedzę jako symbole (nazwy, relacje, kategorie) i rozumowanie jako regułowe przekształcenia tych symboli.

Wysokopoziomowy sposób zobrazowania: podejścia numeryczne odpowiadają na „ile?”, podczas gdy podejścia symboliczne starają się odpowiedzieć „czym to jest?” i „co wynika z tego, co wiemy?”.

Jeśli wierzysz, że rozumowanie da się uczynić programowalnym, potrzebujesz języka, który wygodnie reprezentuje wyrażenia takie jak reguły, stwierdzenia logiczne i zagnieżdżone relacje — i potrafi je potem przetworzyć.

Lisp powstał z myślą o tym celu. Zamiast wciskać idee w sztywne, gotowe struktury danych, Lisp uczynił naturalnym reprezentowanie kodu i wiedzy w podobnym kształcie. Ten wybór nie był tylko akademickim stylem — był praktycznym mostem między opisywaniem myśli a wykonywaniem procedury, co dokładnie było celem McCarthy’ego dla AI.

Kiedy McCarthy i early AI badacze mówili „symboliczne”, nie mieli na myśli tajemniczej matematyki. Symbol to po prostu etykieta z sensem: nazwa jak customer, słowo jak hungry, albo znacznik IF i THEN. Symbole są ważne, bo pozwalają programowi pracować z pomysłami (kategoriami, relacjami, regułami), a nie tylko z surowymi liczbami.

Prosty sposób wyobrażenia: arkusze kalkulacyjne są świetne, gdy świat to kolumny i arytmetyka. Systemy symboliczne są lepsze, gdy świat to reguły, kategorie, wyjątki i struktura.

W wielu programach różnica między 42 a "age" to nie tylko typ danych — to to, za co wartość stoi. Symbol daje coś, co możesz porównywać, przechowywać i łączyć, nie tracąc znaczenia.

To ułatwia naturalne reprezentowanie rzeczy typu „Paryż jest miastem” albo „jeśli bateria jest słaba, znajdź ładowarkę”.

Aby cokolwiek użytecznego zrobić z symbolami, potrzebujesz struktury. Lisp spopularyzował bardzo prostą strukturę: listę. Lista to po prostu uporządkowany zbiór elementów, a elementy mogą same być listami. Z tą jedną ideą możesz reprezentować zdania, formy i wiedzę w kształcie drzewa.

Oto maleńki przykład koncepcyjny (w stylu Lisp):

(sentence (subject robot) (verb needs) (object power))

Czyta się niemal jak angielski: zdanie złożone z podmiotu, orzeczenia i dopełnienia. Ponieważ jest zbudowane strukturalnie, program może wybrać (subject robot) albo zastąpić (object power) czymś innym.

Gdy informacja jest w strukturach symbolicznych, klasyczne zadania AI stają się osiągalne:

IF wzorzec pasuje, THEN wyciągnij coś nowego.Kluczowa zmiana polega na tym, że program nie tylko liczy; manipuluje znaczącymi kawałkami wiedzy w formie, którą może badać i przekształcać.

Decyzje projektowe Lispa nie pozostały tylko w akademii. Wpłynęły na to, jak ludzie budują narzędzia i jak szybko mogą eksplorować pomysły:

Te cechy sprzyjają ekosystemom, gdzie eksperymentowanie jest tanie, prototypy szybciej stają się produktami, a zespoły mogą adaptować się do zmieniających się wymagań.

Lisp zaczął się od bardzo praktycznego problemu projektowego: jak pisać programy, które potrafią pracować z symbolami równie naturalnie, jak z liczbami?

McCarthy nie próbował stworzyć „lepszego kalkulatora”. Chciał języka, w którym wyrażenie takie jak (is (parent Alice Bob)) można przechować, zbadać, przekształcić i rozważyć tak samo łatwo, jak (+ 2 3).

Priorytetem było ułatwienie reprezentacji i manipulacji informacją symboliczną. Doprowadziło to do skupienia na listach i strukturach drzewiastych, bo dobrze odwzorowują one rzeczy, które ludzie już używają do wyrażania znaczenia: zdania, reguły logiczne, zagnieżdżone kategorie i relacje.

Innym celem było utrzymanie małego i spójnego jądra języka. Gdy język ma mniej „szczególnych przypadków”, spędzasz mniej czasu na zapamiętywaniu reguł i więcej na komponowaniu pomysłów. Lisp postawił na mały zestaw klocków, które można łączyć w większe abstrakcje.

Kluczowy wgląd brzmiał: programy i dane mogą dzielić ten sam typ struktury. Mówiąc prościej: jeśli twoje dane to zagnieżdżone listy, program też może być zagnieżdżoną listą.

To oznacza, że możesz:

Lisp popularyzował też sposób myślenia: języki nie muszą być uniwersalnym rozwiązaniem. Mogą być projektowane wokół domeny problemu — jak rozumowanie, przeszukiwanie i reprezentacja wiedzy — i nadal wpływać na programowanie ogólnego przeznaczenia przez dekady.

S-ekspresje (skrót od symbolic expressions) to znak rozpoznawczy Lispa: pojedynczy, spójny sposób reprezentowania kodu i danych jako zagnieżdżonych list.

Na pierwszy rzut oka S-ekspresja to po prostu nawiasy wokół elementów — niektóre elementy to atomy (nazwy, liczby), inne to listy. Zasada „listy w listach” to sedno.

Ponieważ struktura jest jednolita, programy w Lispie są zbudowane z tych samych elementów aż do podstaw. Wywołanie funkcji, fragment konfiguracji czy część struktury programu mogą być wyrażone jako lista.

Ta spójność przynosi natychmiastowe korzyści:

Nawet jeśli nigdy nie piszesz w Lispie, to ważna lekcja projektowa: gdy system buduje się z jednego lub dwóch przewidywalnych kształtów, spędzasz mniej czasu na walkę z wyjątkami, a więcej na budowaniu.

S-ekspresje sprzyjają kompozycji, bo małe, czytelne kawałki naturalnie łączą się w większe. Gdy program to „tylko zagnieżdżone listy”, łączenie pomysłów często oznacza wkładanie jednej expresji w drugą lub składanie list z części wielokrotnego użytku.

To popycha w stronę stylu modułowego: piszesz małe operacje, które robią jedną rzecz, a potem układasz je razem, aby wyrazić większą intencję.

Oczywistą wadą jest obcość. Dla wielu nowicjuszy składnia pełna nawiasów wygląda dziwnie.

Jednak zaletą jest przewidywalność: gdy zrozumiesz zasady zagnieżdżania, możesz niezawodnie widzieć strukturę programu — tak samo mogą to robić narzędzia. Ta klarowność jest dużym powodem, dla którego S-ekspresje miały konsekwencje daleko poza Lispem.

Rekursję najłatwiej zrozumieć metaforą sprzątania zabałaganionego pokoju przez tworzenie mniejszych „pokoi”. Nie próbujesz rozwiązać wszystkiego naraz. Bierzesz jedną rzecz, odkładasz ją na miejsce, potem powtarzasz tę samą akcję na pozostałej części. Kroki są proste; siła wynika z powtarzania ich, aż nie zostanie nic do zrobienia.

Lisp korzysta z tej idei, bo wiele jego danych naturalnie jest zbudowanych z list: lista ma „pierwszy element” i „resztę”. Ten kształt idealnie pasuje do myślenia rekurencyjnego.

Aby przetworzyć listę, obsługujesz pierwszy element, potem stosujesz tę samą logikę do reszty listy. Gdy lista jest pusta — przerywasz. To czysty moment „nic do zrobienia”, który sprawia, że rekurencja wydaje się dobrze zdefiniowana, a nie tajemnicza.

Wyobraź sobie, że chcesz sumę listy liczb.

To wszystko. Definicja czyta się jak zwykły angielski, a struktura programu odzwierciedla pomysł.

Symboliczne AI często reprezentuje wyrażenia jako struktury drzewiaste (operator z podwyrażeniami). Rekursja to naturalny sposób „przejścia” po tym drzewie: oceń lewą część tak samo, jak prawą, i rób tak dalej, aż dojdziesz do prostej wartości.

Te wzorce pomogły ukształtować późniejsze programowanie funkcyjne: małe funkcje, jasne przypadki bazowe i transformacje danych, które łatwo rozumieć. Nawet poza Lispem nawyk dzielenia pracy na „zrób jeden krok, potem powtórz dla reszty” prowadzi do czyściejszego kodu i mniejszej ilości ukrytych efektów ubocznych.

Wczesni programiści często zarządzali pamięcią ręcznie: przydzielanie miejsca, śledzenie, kto jest „właścicielem”, i pamięć, aby zwolnić ją we właściwym momencie. Ta praca nie tylko spowalnia rozwój — tworzy specyficzną klasę błędów trudnych do odtworzenia i łatwych do wypuszczenia: wycieki, które cicho pogarszają wydajność, oraz wiszące wskaźniki, które powodują awarie długo po pierwotnym błędzie.

John McCarthy wprowadził garbage collection dla Lispa, aby pozwolić programistom skupić się na znaczeniu, a nie na księgowości.

Na wysokim poziomie GC automatycznie znajduje kawałki pamięci, które nie są już osiągalne z uruchomionego programu — wartości, których nic już nigdy nie użyje — i odzyskuje to miejsce.

Zamiast pytać „czy zwolniliśmy każdy obiekt dokładnie raz?”, GC zmienia pytanie na „czy ten obiekt jest wciąż dostępny?”. Jeśli program nie może go osiągnąć, uznaje się go za śmieć.

W pracach symbolicznych programy w Lispie często tworzą wiele krótkotrwałych list, drzew i wyników pośrednich. Ręczne zarządzanie pamięcią zamieniłoby eksperymentowanie w ciągłą walkę o sprzątanie zasobów.

GC zmienia codzienne doświadczenie:

Kluczową ideą jest to, że cecha języka może być mnożnikiem zespołu: mniej godzin spędzonych na debugowaniu tajemniczych uszkodzeń oznacza więcej czasu na ulepszanie logiki.

Wybór McCarthy’ego nie pozostał w Lispie. Wiele późniejszych systemów przyjęło GC (i jego warianty), ponieważ kompromis często się opłaca: Java, C#, Python, środowiska JavaScript i Go opierają się na garbage collection, aby uczynić rozwój na dużą skalę bezpieczniejszym i szybszym — nawet gdy wydajność jest priorytetem.

W Lispie wyrażenie to fragment kodu zapisany w spójnym kształcie (często lista). Ewaluacja to proces decydowania, co to wyrażenie znaczy i co produkuje.

Na przykład, gdy piszesz coś w stylu „dodaj te liczby” albo „wywołaj tę funkcję z tymi wejściami”, evaluator podąża za kilkoma prostymi regułami, aby zamienić wyrażenie w wynik. Pomyśl o nim jak o sędzim języka: decyduje, co dalej robić, w jakiej kolejności i kiedy przestać.

Kluczowy ruch McCarthy’ego to nie tylko wymyślenie nowej składni — to utrzymanie „silnika znaczenia” kompaktowego i regularnego. Gdy evaluator zbudowany jest z kilku jasnych reguł, dzieją się dwie dobre rzeczy:

Ta spójność jest jednym z powodów, dla których Lisp stał się polem eksperymentów dla symbolicznego AI: badacze mogli szybko testować nowe reprezentacje i struktury sterowania, bez czekania na zespół kompilatora.

Makra to sposób Lispa na automatyzację powtarzalnych kształtów kodu, nie tylko powtarzalnych wartości. Tam, gdzie funkcja pozwala uniknąć powielania obliczeń, makro pozwala uniknąć powielania struktur — typowych wzorców jak „zrób X, ale też zaloguj” albo „zdefiniuj mini-język dla reguł”.

Praktyczny efekt jest taki, że Lisp może rozwijać nowe wygody od wewnątrz. Wiele współczesnych narzędzi powtarza tę ideę — systemy szablonów, generatory kodu czy metaprogramowanie — bo wspierają ten sam cel: szybsze eksperymenty i wyraźniejsza intencja.

Jeśli ciekawi cię, jak to podejście wpłynęło na codzienne przepływy pracy, zobacz: /blog/the-repl-and-fast-feedback-loops.

Ogromna część atrakcyjności Lispa to nie tylko język — to sposób, w jaki z nim pracujesz. Lisp spopularyzował REPL: Read–Eval–Print Loop. W codziennych słowach to jak rozmowa z komputerem. Wpisujesz wyrażenie, system je wykonuje natychmiast, wypisuje wynik i czeka na kolejny wpis.

Zamiast pisać cały program, kompilować go, uruchamiać, a potem szukać, co się popsuło, możesz próbować pomysłów krok po kroku. Definiujesz funkcję, testujesz ją kilkoma wejściami, poprawiasz i testujesz jeszcze raz — wszystko w kilka sekund.

Ten rytm sprzyja eksperymentom, co było bardzo ważne przy wczesnych pracach nad AI, gdy często nie wiedziało się z góry, które podejście zadziała.

Szybkie informacje zwrotne zamieniają „duże zakłady” w „małe sprawdzenia”. Dla badań ułatwia eksplorację hipotez i inspekcję wyników pośrednich.

Dla prototypowania produktu obniża koszt iteracji: możesz szybko zweryfikować zachowanie na realnych danych, zauważyć edge-case’y wcześniej i dopracować funkcje bez oczekiwania na długie cykle budowania.

To też wyjaśnia, dlaczego narzędzia o agresywnym kompresowaniu pętli informacji są atrakcyjne: na przykład Koder.ai używa interfejsu czatu (z architekturą agentową pod spodem), aby zamienić intencję produktu w działający kod webowy, backendowy lub mobilny — często sprawiając, że pętla „spróbuj → popraw → spróbuj” jest bliższa REPL-owi niż tradycyjnemu pipeline’owi.

Pomysł REPL pojawia się dziś w:

Różne narzędzia, ta sama zasada: skróć dystans między myśleniem a obserwacją.

Zespoły najbardziej korzystają z workflowów podobnych do REPL-a, gdy eksplorują niepewne wymagania, budują funkcje oparte na danych, projektują API lub debugują trudną logikę. Jeśli praca wymaga szybkiego uczenia się — o użytkownikach, danych czy edge-case’ach — interaktywne sprzężenie to nie luksus, to mnożnik wartości.

Lisp nie „wygrał” przez to, że stał się dominującą składnią dnia codziennego. Wygrał przez zaszczepienie pomysłów, które cicho stały się normą w wielu ekosystemach.

Koncepcje, które Lisp traktował jako domyślne — funkcje jako wartości, szerokie użycie operacji wyższego rzędu, preferencja komponowania małych części — pojawiają się powszechnie. Nawet języki zupełnie różne od Lispa zachęcają teraz do transformacji typu map/filter, nawyków niemutowalności i myślenia podobnego do rekurencji (często wyrażanego przez iteratory lub foldy).

Kluczowa zmiana mentalna: traktuj transformacje danych jako pipeline’y i zachowanie jako coś, co można przekazywać.

Lisp ułatwił reprezentowanie programów jako danych. Ten sposób myślenia widać dziś w pracy z AST (abstract syntax trees) w kompilatorach, formatterach, linterach i generatorach kodu. Gdy pracujesz z AST, robisz bliskiego kuzyna „kod jako dane”, nawet jeśli struktury to obiekty JSON, typowane węzły czy grafy bajt-kodów.

To samo podejście symboliczne napędza praktyczną automatyzację: formaty konfiguracji, systemy szablonów i pipeline’y buildów opierają się na strukturach, które narzędzia mogą badać, przekształcać i walidować.

Współczesne języki z rodziny Lisp (w szerokim sensie: współczesne lispy i narzędzia inspirowane Lispiem) wciąż wpływają na projektowanie wewnętrznych DSL-i — małych, ukierunkowanych mini-języków do testów, wdrożeń, przetwarzania danych czy UI.

Poza Lispem systemy makr, biblioteki metaprogramowania i ramy generowania kodu dążą do tego samego: rozszerzaj język, aby lepiej pasował do problemu.

Pragmatyczne podsumowanie: preferencje składni się zmieniają, ale trwałe idee — struktura symboliczna, kompozycyjne funkcje i rozszerzalność — wciąż przynoszą korzyści przez dekady.

Reputacja Lispa huśta się między „genialny” a „nieczytelny”, często na podstawie drugorzędnych wrażeń, a nie codziennego doświadczenia. Prawda jest bardziej zwyczajna: Lisp podejmuje wybory, które są potężne w odpowiednim kontekście i niewygodne w innych.

Dla nowicjuszy jednolita składnia Lispa może wyglądać jak oglądanie „wnętrza” programu zamiast wypolerowanej powierzchni. Ten dyskomfort jest realny, zwłaszcza jeśli przyzwyczajony jesteś do języków, w których składnia wizualnie oddziela konstrukcje.

Historycznie jednak struktura Lispa to też sens: kod i dane mają ten sam kształt, co ułatwia transformacje, generowanie i analizę programu. Z dobrym wsparciem edytora (indentyfikacja, nawigacja strukturalna) kod w Lispie często czyta się bardziej po kształtach niż po liczeniu nawiasów.

Powszechne stereotypy mówią, że Lisp jest z natury wolny. Historycznie niektóre implementacje miały problemy w porównaniu do języków niskiego poziomu, a dynamiczne cechy mogą dodawać narzut.

Ale nie można traktować „Lispa” jako jednego profilu wydajności. Wiele systemów Lisp od dawna wspiera kompilację, deklaracje typów i poważne optymalizacje. Bardziej użyteczne pytanie brzmi: ile kontroli potrzebujesz nad układem pamięci, przewidywalnymi opóźnieniami lub surową przepustowością — i czy dana implementacja Lispa adresuje te potrzeby?

Inna uczciwa krytyka to dopasowanie do ekosystemu. W zależności od dialektu Lispa i domeny, biblioteki, narzędzia i pula kandydatów mogą być mniejsze niż w mainstreamowych stosach. To może mieć większe znaczenie niż elegancja języka, jeśli szybko wysyłasz produkt z szerokim zespołem.

Zamiast oceniać Lispa przez stereotypy, oceń jego podstawowe idee niezależnie: jednolita struktura, interaktywne rozwijanie i makra jako narzędzie do budowania domenowych abstrakcji. Nawet jeśli nigdy nie wdrożysz Lispa produkcyjnie, te koncepcje mogą ostudzić twoje myślenie o projektowaniu języków i o tym, jak piszesz kod w dowolnym języku.

McCarthy nie zostawił nam tylko historycznego języka — zostawił zbiór nawyków, które wciąż sprawiają, że oprogramowanie łatwiej się zmienia, tłumaczy i rozszerza.

Wol preferuj proste jądra od efektownych powierzchni. Mały zestaw ortogonalnych bloków jest łatwiejszy do nauczenia i trudniejszy do zepsucia.

Utrzymuj jednorodne kształty danych. Gdy wiele rzeczy dzieli tę samą reprezentację (jak listy/drzewa), narzędzia stają się prostsze: drukarki, debugery, serializatory i transformery można wielokrotnie używać.

Traktuj programy jak dane (i dane jak programy), gdy to pomaga. Jeśli możesz inspekcjonować i przekształcać struktury, zbudujesz bezpieczniejsze refaktory, migracje i generatory kodu.

Automatyzuj nudne rzeczy. Garbage collection to klasyczny przykład, ale szersza nauka to: inwestuj w automatyzację, która zapobiega całym klasom błędów.

Optymalizuj pętle sprzężenia. Interaktywna ewaluacja (w stylu REPL) zachęca do małych eksperymentów, szybkiej weryfikacji i lepszej intuicji co do zachowania.

Traktuj rozszerzalność jako cel projektowy. Makra Lispa to jedna odpowiedź; w innych ekosystemach mogą to być wtyczki, szablony, DSL-y lub transformacje w czasie kompilacji.

Zanim wybierzesz bibliotekę lub architekturę, weź prawdziwą funkcję — powiedzmy „reguły rabatowe” albo „trasowanie zgłoszeń” — i narysuj ją jako drzewo. Potem przepisz to drzewo jako zagnieżdżone listy (lub JSON). Zapytaj: jakie są węzły, jakie liście i jakie transformacje będą potrzebne?

Nawet bez Lispa możesz przyjąć sposób myślenia: buduj reprezentacje podobne do AST, używaj generowania kodu tam, gdzie łączysz monotonne elementy, i standaryzuj pipeline’y data-first (parse → transform → evaluate). Wiele zespołów osiąga korzyści, po prostu robiąc reprezentacje pośrednie jawnie.

Jeżeli podoba ci się zasada REPL, a jesteś w mainstreamowym stacku, możesz też przenieść ducha do narzędzi: ciasne pętle iteracji, migawek/rollbacków i explicite planowanie przed wykonaniem. Koder.ai, na przykład, zawiera tryb planowania oraz migawki i rollback, aby utrzymać szybkie iteracje w bezpiecznych ramach — operacyjny rezonans idei Lispa „zmieniaj szybko, ale miej kontrolę”.

Wpływ McCarthy’ego trwa: programowanie staje się potężniejsze, gdy czynimy samo rozumowanie programowalnym — i utrzymamy ścieżkę od pomysłu do systemu wykonywalnego tak bezpośrednią, jak to możliwe.

Symboliczne myślenie reprezentuje bezpośrednio pojęcia i relacje (np. „klient”, „jest rodzajem”, „zależy od”, „jeśli… to…”), a następnie stosuje reguły i przekształcenia do tych reprezentacji.

Jest najprzydatniejsze, gdy problem jest pełen struktury, wyjątków i znaczenia (silniki reguł, planowanie, kompilatory, konfiguracje, logika przepływów), a nie tylko arytmetyki.

McCarthy forsował ideę, że rozumowanie można wyrazić jako programy — nie tylko obliczenia.

Ta perspektywa wpłynęła na:

Listy to minimalny, elastyczny sposób reprezentacji „rzeczy złożonych z części”. Ponieważ elementy listy mogą być same listami, naturalnie powstają struktury drzewiaste.

To ułatwia:

S-ekspresje dają jednolity kształt dla kodu i danych: zagnieżdżone listy.

Ta jednolitość upraszcza systemy, ponieważ:

Makro służy do automatyzacji powtarzalnych kształtów kodu, nie tylko obliczeń.

Użyj makr, gdy chcesz:

Jeśli potrzebujesz jedynie wielokrotnego użycia logiki, zwykła funkcja jest zazwyczaj lepsza.

Garbage collection (GC) automatycznie odzyskuje pamięć, która nie jest już osiągalna, co zmniejsza pewne klasy błędów (wiszące wskaźniki, podwójne zwolnienia).

Szczególnie przydatne, gdy program często tworzy krótkotrwałe struktury (listy/drzewa/AST), bo pozwala prototypować i refaktoryzować bez projektowania ręcznego schematu własności pamięci.

REPL skraca pętlę „pomyśl → spróbuj → obserwuj”. Możesz zdefiniować funkcję, uruchomić ją, poprawić i od razu przetestować.

Aby uzyskać podobne korzyści poza Lispem:

Related reading: /blog/the-repl-and-fast-feedback-loops

Wiele współczesnych narzędzi przejęło podstawowe idee:

map/filter, kompozycja)Nawet jeśli nigdy nie wdrożysz Lispa, prawdopodobnie korzystasz z nawyków inspirowanych Lispiem na co dzień.

Typowe kompromisy to:

Praktyczne podejście: oceniaj dopasowanie do domeny i ograniczeń, nie stereotypów.

Wypróbuj to ćwiczenie (10 minut):

Często pokazuje to, gdzie „kod-jako-dane”, silniki reguł lub konfiguracje przypominające DSL uproszczą system.