Co oznacza „łatwiej wymienić” w prawdziwych projektach

„Łatwiej wymienić” rzadko oznacza usunięcie całej aplikacji i zaczęcie od zera. W zespołach wymiana zachodzi na różnych poziomach, a znaczenie „przepisać” zależy od tego, co dokładnie podmieniasz.

Wymiana kontra przepisywanie: co naprawdę jest na stole

Zamiana może oznaczać:

- Moduł (reguły rozliczeń, generowanie PDF, szablony e-mail)

- Usługę (API rekomendacji, worker działający w tle)

- Powierzchnię front-endu (strona, obszar funkcji albo cały UI)

- Pełne przepisanie aplikacji (rzadkie, kosztowne, czasem konieczne)

Kiedy ktoś mówi, że baza kodu jest „łatwiejsza do przepisania”, zwykle ma na myśli, że możesz zrestartować jedną wycinkę bez rozpaczliwego rozplątywania reszty, utrzymać działanie biznesu i stopniowo migrować.

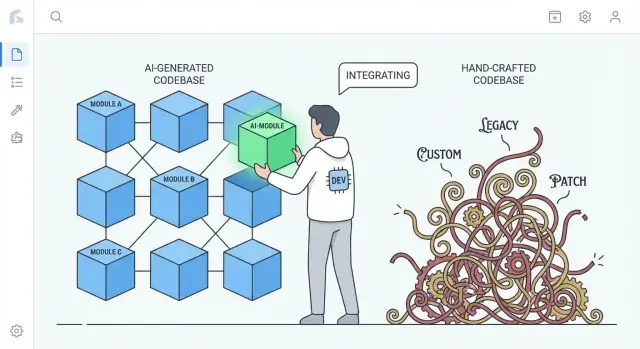

Rzeczywiste porównanie: kod AI kontra mocno dopasowany ręcznie kod

To nie jest twierdzenie „kod AI jest lepszy”. Chodzi o typowe tendencje.

- Mocno dopasowany, ręcznie pisany kod gromadzi unikalne wzorce, sprytne abstrakcje i jednorazowe „frameworki wewnątrz aplikacji”. To może być świetne, ale też tworzy prywatny ekosystem, który rozumie tylko kilka osób.

- Kod generowany przez AI częściej opiera się na znajomych domyślnych ustawieniach: popularnych bibliotekach, konwencjonalnej warstwiezacji i wzorcach widocznych w wielu przykładach referencyjnych.

Ta różnica ma znaczenie przy przepisywaniu: kod, który stosuje powszechnie rozumiane konwencje, często da się zastąpić inną konwencjonalną implementacją przy mniejszych negocjacjach i bez niespodzianek.

Ustalaj oczekiwania: kod AI może być chaotyczny

Kod generowany przez AI może być niespójny, powtarzalny lub słabo przetestowany. „Łatwiej wymienić” nie oznacza, że jest czyściejszy — oznacza raczej, że jest często mniej „specjalny”. Jeśli podsystem zbudowano z powszechnych składników, jego podmiana może przypominać wymianę standardowej części, a nie reverse-engineering maszyny na zamówienie.

Wstęp: dlaczego standaryzacja obniża koszty przejścia

Główna idea jest prosta: standaryzacja obniża koszty zmiany. Gdy kod składa się ze rozpoznawalnych wzorców i jasnych szwów, możesz go regenerować, refaktoryzować lub przepisywać kawałkami bez obawy o ukryte zależności. Poniższe sekcje pokazują, jak to działa w strukturze, własności, testach i codziennej pracy inżynierskiej.

Standardowe wzorce zmniejszają koszt rozpoczęcia od nowa

Praktyczną zaletą kodu generowanego przez AI jest to, że często domyślnie używa powszechnych, rozpoznawalnych wzorców: znajome układy folderów, przewidywalne nazewnictwo, konwencje frameworków oraz „podręcznikowe” podejścia do routingu, walidacji, obsługi błędów i dostępu do danych. Nawet jeśli kod nie jest perfekcyjny, zwykle jest czytelny w podobny sposób jak wiele tutoriali i projektów startowych.

Znajomość góruje nad oryginalnością, gdy trzeba przepisać

Przepisywania są kosztowne głównie dlatego, że ludzie muszą najpierw zrozumieć, co istnieje. Kod zgodny z dobrze znanymi konwencjami skraca ten czas „dekodowania”. Nowi inżynierowie mogą odnieść to, co widzą, do znanych modeli mentalnych: gdzie jest konfiguracja, jak przepływają żądania, jak powiązane są zależności i gdzie umieszczać testy.

Dzięki temu szybciej można:

- zidentyfikować szwy do wymiany (moduły, usługi, endpointy)

- odtworzyć zachowanie w nowej implementacji

- porównać stare i nowe rozwiązanie obok siebie bez tłumaczenia między stylami

Z kolei mocno ręcznie zbudowane bazy kodu często odzwierciedlają bardzo osobisty styl: unikalne abstrakcje, własne mini-frameworki, sprytne „kleje” lub wzorce specyficzne dla domeny, które mają sens tylko w kontekście historii projektu. Te wybory mogą być eleganckie — ale zwiększają koszt restartu, bo przepisywanie musi najpierw poznać światopogląd autora.

Konwencje można wymusić w obu przypadkach

To nie jest magia zarezerwowana dla AI. Zespoły mogą (i powinny) wymuszać strukturę i styl przy pomocy szablonów, linterów, formatterów i narzędzi do scaffoldingu. Różnica polega na tym, że AI ma tendencję do bycia „generycznym domyślnie”, podczas gdy systemy pisane przez ludzi mogą dryfować w stronę rozwiązań na miarę, chyba że konwencje są aktywnie utrzymywane.

Mniej bespoke „kleju” może oznaczać mniej ukrytych zależności

Dużo bólu przy przepisywaniu nie pochodzi z „głównej” logiki biznesowej. Pochodzi od bespoke glue — niestandardowych helperów, domowych micro-frameworków, trików metaprogramowania i jednorazowych konwencji, które po cichu łączą wszystko razem.

Co liczy się jako „bespoke glue”?

Bespoke glue to rzeczy, które nie są częścią produktu, a mimo to bez nich produkt nie działa. Przykłady: niestandardowy kontener wstrzykiwania zależności, własna warstwa routingu, magiczna klasa bazowa auto-rejestrująca modele, helpery mutujące globalny stan „dla wygody”. Często zaczyna się to jako oszczędność czasu, a kończy jako wymagana wiedza dla każdej zmiany.

Dlaczego unikalny klej zwiększa sprzężenie (i ryzyko przepisu)

Problem nie polega na tym, że klej istnieje — lecz że staje się niewidzialnym sprzężeniem. Gdy klej jest specyficzny dla zespołu, często:

- Tworzy ukryte zależności (coś działa tylko dlatego, że helpery wykonują się w określonej kolejności)

- Rozsiewa założenia po plikach (nazewnictwo staje się zachowaniem)

- Sprawia, że „proste” refaktory są ryzykowne (zmień klej, złam wszystko)

Podczas przepisywania ten klej trudno poprawnie odtworzyć, bo zasady rzadko są zapisane. Odkrywasz je, kiedy coś przestaje działać w produkcji.

Dlaczego kod AI zwykle unika ekstremalnej pomysłowości

Wyjścia AI często skłaniają się ku standardowym bibliotekom, powszechnym wzorcom i jawnemu wiązaniu zależności. Rzadziej wygeneruje micro-framework, jeśli prosty moduł lub obiekt serwisowy wystarczy. Ta powściągliwość może być zaletą: mniej magicznych haków to mniej ukrytych zależności i łatwiejsza wymiana podsystemu.

Kompromis: werbalność zamiast pomysłowości

Wadą jest to, że „prosty” kod bywa bardziej rozwlekły — więcej przekazywanych parametrów, więcej jawnego okablowania, mniej skrótów. Ale rozwlekłość zwykle kosztuje mniej niż tajemnica. Gdy decydujesz się przepisać, chcesz kodu, który łatwo zrozumieć, łatwo usunąć i trudno źle zinterpretować.

Przewidywalna struktura wspiera inkrementalne przepisywania

„Przewidywalna struktura” to mniej kwestia estetyki, bardziej konsekwencji: te same foldery, zasady nazewnictwa i przepływy żądań pojawiają się wszędzie. Projekty generowane przez AI często skłaniają się ku znajomym domyślnym ustawieniom — controllers/, services/, repositories/, models/ — z powtarzalnymi endpointami CRUD i podobną walidacją.

Ta jednolitość ma znaczenie, bo zmienia przepisywanie z przepaści w schody.

Jak wygląda przewidywalność

Wzorce powtarzają się we wszystkich funkcjach:

- Jasne granice folderów (API → service → dostęp do danych)

- Spójne nazewnictwo (

UserService, UserRepository, UserController)

- Podobny przepływ CRUD (list → get → create → update → delete)

- Standardowy „kształt” błędów, logowania i obiektów request/response

Gdy każda funkcja budowana jest podobnie, możesz zastąpić jeden element bez konieczności ciągłego „ponownego uczenia się” systemu.

Podmiana kawałek po kawałku

Inkrementalne przepisywania działają najlepiej, gdy możesz izolować granicę i przebudować za nią. Przewidywalne struktury naturalnie tworzą takie szwy: każda warstwa ma wąskie zadanie, a większość wywołań przechodzi przez niewielki zestaw interfejsów.

Praktyczne podejście to styl „strangler”: utrzymaj publiczne API stabilne i stopniowo podmieniaj wnętrze.

Przykład: podmień warstwę dostępu do danych bez ruszania API

Przypuśćmy, że aplikacja ma kontrolery wywołujące serwis, a serwis wywołuje repozytorium:

OrdersController → OrdersService → OrdersRepository

Chcesz przejść z bezpośrednich zapytań SQL na ORM lub z jednej bazy danych na inną. W przewidywalnej bazie zmianę można ograniczyć:

- Stwórz

OrdersRepositoryV2 (nowa implementacja)

- Zachowaj te same sygnatury metod (

getOrder(id), listOrders(filters))

- Przełącz wiązanie w jednym miejscu (DI lub fabryka)

- Uruchom testy i wypuść feature po feature

Kod kontrolera i serwisu pozostaje w większości nienaruszony.

Kontrast: ręcznie dopracowane architektury

Systemy pieczołowicie projektowane potrafią być doskonałe — ale często kodują unikalne pomysły: custom abstrakcje, sprytne metaprogramowanie lub zachowania przekrojowe ukryte w klasach bazowych. To sprawia, że każda zmiana wymaga głębokiego kontekstu historycznego. Przy przewidywalnej strukturze pytanie „gdzie to zmienić?” zwykle ma prostą odpowiedź, co uczynia małe przepisywania wykonalnymi co tydzień.

Mniejsza „przywiązanie autora” sprawia, że usuwanie jest bardziej akceptowalne

Cichym blokadą w wielu przepisań nie jest kwestia techniczna, a społeczna. Zespoły często ponoszą ryzyko właścicielstwa: tylko jedna osoba naprawdę rozumie system. Kiedy ten ktoś napisał dużą część kodu ręcznie, kod zaczyna wyglądać jak osobisty artefakt: „mój projekt”, „moje sprytne rozwiązanie”, „mój obejściowy sposób, który uratował wydanie”. To przywiązanie czyni usuwanie kosztownym emocjonalnie, nawet gdy ekonomicznie jest zasadne.

Kod generowany przez AI może zmniejszać ten efekt. Ponieważ pierwotny szkic może pochodzić z narzędzia (i często trzyma się znanych wzorców), kod mniej przypomina podpis, a bardziej wymienną implementację. Ludzie chętniej powiedzą: „Podmieńmy ten moduł”, jeśli nie wygląda to jak wymazanie czyjegoś rzemiosła — ani nie podważa czyjegoś statusu w zespole.

Dlaczego to zmienia zachowanie przy przepisywaniu

Gdy przywiązanie autora jest mniejsze, zespoły zwykle:

- Śmielej kwestionują istniejący kod („Czy to nadal najlepsze podejście?”)

- Usuwają duże sekcje bez negocjacji o dumę czy politykę

- Wcześniej wybierają regenerację lub zastąpienie zamiast miesięcy ostrożnego łatania

- Szybciej rozprzestrzeniają wiedzę, bo nikt nie traktuje wnętrza jako „własnego terytorium”

Uwaga praktyczna

Decyzje o przepisywaniu powinny wciąż wynikać z kosztów i rezultatów: terminy dostaw, ryzyko, utrzymywalność i wpływ na użytkownika. „Łatwo usunąć” to przydatna cecha — nie strategia sama w sobie.

Prompt i ślady generacji mogą działać jak dokumentacja

Zacznij od standardowych wzorców

Szkicuj warstwy React, Go i PostgreSQL z przewidywalnymi szwami do inkrementalnych przepisań.

Jedną niedocenioną zaletą kodu generowanego przez AI są wejścia do generacji, które mogą pełnić rolę żywej specyfikacji. Prompt, szablon i konfiguracja generatora mogą opisać intencję prostym językiem: co funkcja ma robić, które ograniczenia są ważne (bezpieczeństwo, wydajność, styl) i co znaczy „gotowe”.

Prompty jako żywe specyfikacje

Gdy zespoły używają powtarzalnych promptów (lub bibliotek promptów) i stabilnych szablonów, tworzą ślad decyzji, które w innym wypadku byłyby domyślne. Dobry prompt może zawierać rzeczy, które przyszły konserwator musiałby zgadywać:

- oczekiwany przepływ użytkownika i przypadki brzegowe

- konwencje nazewnictwa i strukturę folderów

- jak obsługiwać i logować błędy

- co należy przetestować (a co można mockować)

To istotnie różni się od wielu ręcznie zbudowanych kodów, gdzie kluczowe decyzje są rozrzucone po commitach, wiedzy plemiennej i małych, niewypisanych konwencjach.

Ślady generacji pomagają odtworzyć zachowanie

Jeśli zachowasz ślady generacji (prompt + model/wersja + dane wejściowe + kroki post-processingu), przepisywanie nie zaczyna się od pustej kartki. Możesz wykorzystać tę samą checklistę, by odtworzyć zachowanie w czystszej strukturze, a potem porównać wyniki.

W praktyce może to zmienić przepisywanie w: „zregeneruj funkcję X w nowych konwencjach, a potem zweryfikuj parytet”, zamiast: „odtwórz, co funkcja X powinna robić”.

Ważne ostrzeżenie: traktuj prompty jak kod

To działa tylko wtedy, gdy prompty i konfiguracje są zarządzane z tą samą dyscypliną co kod źródłowy:

- wersjonuj je w repozytorium (nie w czyichś notatkach)

- wymagaj przeglądu zmian

- zapisuj, który prompt/konfiguracja wygenerowała które moduły

Bez tego prompty stają się kolejną niedokumentowaną zależnością. Z właściwym zarządzaniem mogą być dokumentacją, której często brakuje w ręcznie pisanych systemach.

Solidne testy zmieniają przepisywanie w rutynową pracę inżynierską

„Łatwiej wymienić” tak naprawdę nie zależy od tego, czy kod napisał człowiek czy asystent. Chodzi o to, czy możesz go zmienić z pewnością, że zachowanie pozostało takie samo. Przepisaowanie staje się rutyną, gdy testy szybko i niezawodnie mówią, że nic się nie zepsuło.

Kod generowany przez AI może tu pomóc — jeśli o to poprosisz. Wiele zespołów prosi o szablonowe testy wraz z funkcjami (podstawowe testy jednostkowe, testy integracyjne „happy-path”, proste mocki). Te testy mogą nie być idealne, ale dają początkową siatkę bezpieczeństwa, której często brakuje w ręcznie tworzonych systemach, gdzie testy były odkładane „na później”.

Priorytetyzuj testy kontraktowe na granicach

Jeśli chcesz wymienialności, skup testy na szwach, gdzie części się spotykają:

- Zewnętrzne API: żądania, odpowiedzi, kody błędów, retry, paginacja

- Adaptery: dostawcy płatności, usługi e-mail, storage, kolejki

- Modele danych: migracje, serializacja, reguły walidacji

Testy kontraktowe utrwalają to, co musi pozostać prawdziwe, nawet jeśli zamienisz implementacje wewnętrzne. Dzięki temu możesz przepisać moduł za API lub wymienić adapter bez ponownego ustalania zachowania biznesowego.

Używaj coverage jako kompas, nie trofeum

Pokrycie testami może wskazywać ryzyka, ale gonienie za 100% często rodzi kruche testy blokujące refaktory. Zamiast tego:

- Dodaj testy tam, gdzie awarie są kosztowne (pieniądze, utrata danych, zaufanie użytkownika)

- Wybieraj kilka testów o wysokim sygnale zamiast wielu płytkich

- Przy przepisywaniu porównuj starą i nową implementację tymi samymi testami kontraktowymi

Dzięki solidnym testom przepisywania przestają być heroicznymi projektami, a stają się serią bezpiecznych, odwracalnych kroków.

Typowe wady kodu AI są często łatwe do wykrycia i odizolowania

Utrzymaj architekturę nudną

Generuj konwencjonalną strukturę, którą możesz przepisywać kawałek po kawałku, bez ponownego uczenia się niestandardowego glue.

Kod generowany przez AI ma tendencję do popełniania przewidywalnych błędów. Często zobaczysz zdublowaną logikę (ten sam helper zaimplementowany trzy razy), „prawie takie samo” gałęzie obsługujące różne przypadki brzegowe lub funkcje rosnące przez dopisywanie poprawek. To nie jest idealne — ale ma jedną zaletę: problemy zwykle są widoczne.

Oczywiste błędy są lepsze niż subtelne, sprytne bugi

Ręcznie dopracowane systemy mogą ukrywać złożoność za sprytnymi abstrakcjami, mikro-optymalizacjami czy silnie sprzężonymi zachowaniami. Te błędy bolą, bo wyglądają na poprawne i przechodzą pobieżne przeglądy.

Kod AI częściej jest po prostu niespójny: parametr jest ignorowany w jednej ścieżce, check walidacyjny istnieje w jednym pliku, a nie w innym, albo styl obsługi błędów zmienia się co kilka funkcji. Te niezgodności rzucają się w oczy podczas przeglądu i analizy statycznej, i łatwiej je odizolować, bo rzadko zależą od głębokich, celowych inwariantów.

Kandydaci do przepisu ujawniają się przez powtórzenia

Powtarzalność to znak. Gdy widzisz tę samą sekwencję kroków pojawiającą się wielokrotnie — parse input → normalize → validate → map → return — znalazłeś naturalny szew do wymiany. AI często „rozwiązuje” nowe żądanie, powielając wcześniejsze rozwiązanie z poprawkami, co tworzy skupiska niemal-duplikatów.

Praktyczne podejście: oznacz każdy powtarzający się fragment jako kandydat do ekstrakcji lub wymiany, szczególnie gdy:

- Pojawia się w 3+ miejscach z drobnymi różnicami

- Różnice dotyczą głównie obsługi edge-case'ów lub komunikatów o błędach

- Kod nie ma jasnego właściciela i ciągle jest łatany

Zasada: skoncentruj powtórzenia w jednym przetestowanym module

Jeśli potrafisz opisać powtarzające się zachowanie jednym zdaniem, prawdopodobnie powinno to być jeden moduł.

Zamień powtarzające się fragmenty na jedną dobrze przetestowaną komponentę (utility, shared service lub funkcja biblioteczna), napisz testy pokrywające oczekiwane przypadki brzegowe, a potem usuń duplikaty. Zmieniasz wiele kruche kopii w jedno miejsce do poprawy — i jedno miejsce do ponownego przepisywania później.

Czytelność i spójność przeważają nad ręcznymi optymalizacjami

Kod generowany przez AI często wybiera czytelność zamiast pomysłowości, jeśli o to poprosisz. Przy właściwych promptach i regułach lintingu zwykle wybierze znajomy przepływ sterowania, konwencjonalne nazewnictwo i „nudne” moduły zamiast nowości. To może dawać większy długoterminowy zysk niż kilka procent szybszego działania osiągniętego ręcznie.

Dlaczego czytelny kod łatwiej przepisać

Przepisywania odnoszą sukces, gdy nowi ludzie szybko budują poprawny model mentalny systemu. Czytelny, spójny kod skraca czas potrzebny na odpowiedź na pytania typu „Gdzie wchodzi to żądanie?” i „Jaki kształt mają dane tutaj?”. Jeśli każdy serwis stosuje podobne wzorce (układ, obsługa błędów, logowanie, konfiguracja), nowy zespół może podmieniać kawałek po kawałku bez ciągłego ponownego uczenia się lokalnych konwencji.

Spójność też zmniejsza strach. Gdy kod jest przewidywalny, inżynierowie mogą usuwać i odbudowywać części z większą pewnością, bo obszar wpływu jest łatwiejszy do zrozumienia.

Kompromis z ręcznymi hackami wydajnościowymi

Silnie zoptymalizowany, ręcznie dopracowany kod bywa trudny do przepisania, bo techniki wydajnościowe przeciekają w całe miejsce: niestandardowe warstwy cache, mikro-optymalizacje, domowe wzorce współbieżności lub ścisłe sprzężenie z konkretnymi strukturami danych. Te wybory mogą być uzasadnione, ale często tworzą subtelne ograniczenia, które wychodzą na jaw dopiero, gdy coś się psuje.

Uwaga: wydajność nadal się liczy — mierz ją

Czytelność nie jest pozwoleniem na wolność. Najpierw zmierz bazę (percentyle latency, CPU, pamięć, koszty). Po wymianie komponentu mierz ponownie. Jeśli wydajność spadnie, optymalizuj konkretną gorącą ścieżkę — bez zamieniania całej bazy w zagadkę.

Regeneracja kontra refaktoryzacja kontra przepisywanie: wybór odpowiedniego resetu

Gdy projekt wspomagany AI zaczyna wydawać się „nie w porządku”, nie musisz od razu robić pełnego przepisu. Najlepszy reset zależy od tego, ile systemu jest niepoprawne w sensie architektury, a ile jest po prostu zabałaganione.

Trzy opcje resetu

Regeneracja oznacza odtworzenie części kodu ze specyfikacji lub promptu — często zaczynając od szablonu — i ponowne podpięcie punktów integracji (route'y, kontrakty, testy). To nie „usuń wszystko”, tylko „przebuduj wycinek z jaśniejszym opisem”.

Refaktoryzacja zachowuje zachowanie, ale zmienia wewnętrzną strukturę: rename, rozdzielenie modułów, uproszczenie warunków, usuwanie duplikacji, poprawa testów.

Przepisanie zamienia komponent lub system na nową implementację, zwykle gdy obecny projekt nie da się uzdrowić bez zmiany zachowania, granic lub przepływów danych.

Kiedy regeneracja się sprawdza

Regeneracja błyszczy przy kodzie głównie boilerplate'owym, gdy wartość leży w interfejsach bardziej niż w sprytnych wnętrznościach:

- Ekrany CRUD i panele admina

- Adaptery API i cienkie warstwy integracyjne

- Scaffolding: routing, serializery, DTO, prosta walidacja, wspólna obsługa błędów

Jeśli spec jest jasny i granica modułu czysta, regeneracja często jest szybsza niż rozplątywanie kolejnych poprawek.

Kiedy regeneracja jest ryzykowna (lub zawodzi)

Bądź ostrożny tam, gdzie kod zawiera wypracowaną wiedzę domenową lub subtelne warunki poprawności:

- reguły biznesowe z wieloma przypadkami brzegowymi

- trudna współbieżność (kolejki, blokady, retry, idempotencja)

- logika compliance (audyt, retencja, prywatność)

W tych obszarach „wystarczająco blisko” może być kosztowne — regeneracja może pomóc, ale tylko jeśli potrafisz udowodnić równoważność silnymi testami i przeglądami.

Bramki przeglądu i małe wdrożenia

Traktuj zregenerowany kod jak nowe zależności: wymagaj przeglądu ludzkiego, uruchom pełny zestaw testów i dodaj testy celowane dla znanych błędów. Wdróż w małych kawałkach — jeden endpoint, jedna strona, jeden adapter — za flagą funkcji lub stopniowo, jeśli to możliwe.

Przydatna zasada domyślna: zregeneruj „powłokę”, zrefaktoryzuj szwy, przepisuj tylko te fragmenty, gdzie założenia ciągle zawodzą.

Ryzyka i zabezpieczenia dla kodu „wymiennego z założenia”

Rozszerz przepisywanie na mobile

Wygeneruj aplikację Flutter z chatu i zachowaj te same konwencje w web i mobile.

„Łatwo wymienić” pozostaje zaletą tylko wtedy, gdy zespoły traktują wymianę jako działanie inżynieryjne, a nie przycisk resetu. Moduły pisane przez AI można podmieniać szybciej — ale też mogą szybciej zawieść, jeśli zaufasz im bardziej niż je zweryfikujesz.

Kluczowe ryzyka do obserwowania

Kod generowany przez AI często wygląda na kompletny, nawet gdy nie jest. To może tworzyć fałszywe zaufanie, zwłaszcza gdy demo happy-path przejdzie.

Drugie ryzyko to brak obsługi edge-case'ów: nietypowe wejścia, timeouty, problemy współbieżności i obsługa błędów, które nie zostały uwzględnione w promptach ani danych przykładowych.

Na końcu jest kwestia licencji/IP. Nawet jeśli ryzyko jest niskie w wielu konfiguracjach, zespoły powinny mieć politykę, skąd akceptowalne są źródła i narzędzia oraz jak śledzić pochodzenie.

Zabezpieczenia, które utrzymają bezpieczeństwo przepisań

Umieść wymianę za tymi samymi bramkami co każda inna zmiana:

- Przegląd kodu z wyraźnym „soczewkowym” podejściem do kodu generowanego: czytelność, tryby awarii, walidacja wejść i logowanie

- Kontrole bezpieczeństwa (SAST, skan zależności, wykrywanie sekretów) i zasada, że kod generowany nie może ich omijać

- Polityki zależności: preferuj niewiele, dobrze znanych bibliotek; przypinaj wersje; unikaj wprowadzania nowego frameworka tylko dlatego, że zasugerował to prompt

- Ślady audytu: przechowuj prompty, wersje modelu/narzędzia i notatki generacji w repo, by zmiany dały się później wytłumaczyć

Udokumentuj granice przed zamianą modułów

Zanim podmienisz komponent, zapisz jego granice i inwarianty: jakie przyjmuje wejścia, co gwarantuje, czego nigdy nie powinien robić (np. „nigdy nie usuwać danych klienta”) oraz oczekiwania wydajnościowe/opóźnienia. Ten „kontrakt” testujesz — niezależnie od tego, kto (albo co) wygenerowało kod.

Lekki checklist

- Zdefiniuj kontrakt modułu (wejścia/wyjścia, inwarianty).

- Dodaj / potwierdź testy dla przypadków brzegowych.

- Uruchom skany bezpieczeństwa i zależności.

- Przejrzyj czytelność i obsługę błędów.

- Zarejestruj metadane promptów/narzędzi.

- Wdróż za flagą i monitoruj.

Praktyczne wnioski i prosty plan na następny tydzień

Kod generowany przez AI jest często łatwiejszy do przepisywania, bo skłania się ku znajomym wzorcom, unika głębokiej „osobistej” personalizacji i szybciej daje się zregenerować przy zmieniających się wymaganiach. Ta przewidywalność obniża społeczne i techniczne koszty usuwania i podmiany części systemu.

Celem nie jest „wyrzucać kod”, ale sprawić, by wymiana kodu była normalną, niskotarciową opcją — wspartej kontraktami i testami.

Kroki działania, które możesz wdrożyć w tym tygodniu

Zacznij od ujednolicenia konwencji, by każdy zregenerowany lub przepisany kod pasował do tego samego wzorca:

- Ustal konwencje: formatowanie, struktura folderów, nazewnictwo, obsługa błędów i kształt API. Opisz to krótko w CONTRIBUTING.md.

- Dodaj testy kontraktowe na granicach: skup się na wejściach/wyjściach modułów i serwisów (endpointy HTTP, komunikaty queue, warstwy dostępu do DB). Testy te powinny przechodzić nawet przy podmianie implementacji.

- Śledź prompt i specyfikacje: przechowuj prompt, notatki wymagań i ślady generacji obok kodu, by przyszłe przepisywania odtwarzały intencję, nie tylko tekst.

Jeśli używasz workflowu vibe-coding, szukaj narzędzi ułatwiających te praktyki: zapisywanie specyfikacji planowania obok repo, przechwytywanie śladów generacji i wsparcie bezpiecznego rollbacku. Na przykład Koder.ai jest zaprojektowany wokół chat-driven generation z snapshotami i rollbackiem, co dobrze pasuje do podejścia „wymienialne z założenia” — zregeneruj wycinek, utrzymaj kontrakt i szybko przywróć, jeśli testy parytetu zawiodą.

Uruchom mały pilotaż „wymiennego modułu"

Wybierz moduł ważny, ale bezpiecznie odizolowany — generowanie raportów, wysyłanie powiadomień albo jednolity obszar CRUD. Zdefiniuj jego publiczny interfejs, dodaj testy kontraktowe, a potem pozwól sobie na regenerację/refaktoryzację/przepisanie wnętrza, aż stanie się nudny. Mierz czas cyklu, liczbę błędów i wysiłek przeglądu; użyj wyników do ustalenia zasad zespołowych.

Aby to urealnić, przechowuj checklistę w wewnętrznym playbooku (lub udostępnij przez /blog) i uczynij trio „kontrakty + konwencje + ślady” wymogiem dla nowej pracy. Jeśli oceniasz wsparcie narzędziowe, opisz, czego potrzebujesz, zanim obejrzysz /pricing.