02 paź 2025·8 min

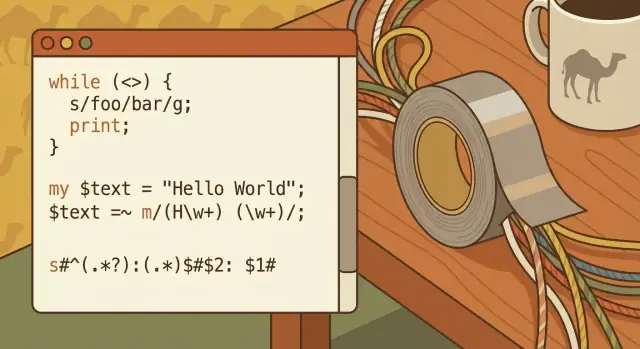

Larry Wall, Perl i podejście „taśmy klejącej” do pracy z tekstem

Jak filozofia „taśmy klejącej” Larry’ego Walla uczyniła Perla narzędziem do automatyzacji webowej — i czego wciąż uczy o praktycznym przetwarzaniu tekstu.

Jak filozofia „taśmy klejącej” Larry’ego Walla uczyniła Perla narzędziem do automatyzacji webowej — i czego wciąż uczy o praktycznym przetwarzaniu tekstu.

„Programowanie taśmą klejącą” to pomysł, że najlepsze narzędzie to często to, które szybko rozwiąże prawdziwy problem — nawet jeśli rozwiązanie nie jest ładne, trwałe ani zaprojektowane jako wielki system.

Nie chodzi o robienie byle jakiej roboty. Chodzi o docenianie pędu, gdy masz do czynienia z nieporządnymi danymi wejściowymi, niekompletnymi specyfikacjami i terminem, któremu nie zależy na elegancji twojego diagramu architektury.

Podejście taśmy klejącej zaczyna się od prostego pytania: Jaka jest najmniejsza zmiana, która sprawi, że ból zniknie? To może być krótki skrypt do przemianowania 10 000 plików, szybki filtr wyciągający linie z błędami z logów albo jednorazowa transformacja, która przerobi chaotyczny eksport na coś, co odczyta arkusz kalkulacyjny.

Ten artykuł używa historii Larry’ego Walla i Perla jako przykładu takiego nastawienia — ale celem nie jest nostalgiczne wspominanie. Chodzi o wyciągnięcie praktycznych lekcji, które nadal mają zastosowanie, gdy pracujesz z tekstem, logami, CSV, fragmentami HTML albo danymi, które w rzeczywistości są stosem niespójnych ciągów znaków.

Jeśli nie jesteś zawodowym programistą, ale regularnie pracujesz z:

…to jesteś idealnym odbiorcą.

Na końcu powinieneś mieć cztery jasne wnioski:

Larry Wall nie zamierzał wynaleźć „sprytnego” języka. Był inżynierem i administratorem systemów, który cały dzień spędzał na ujarzmianiu nieposłusznego tekstu: plików logów, raportów, fragmentów konfiguracji, nagłówków maili i jednorazowych zrzutów danych, które nigdy nie odpowiadały formatowi obiecanemu w dokumentacji.

Już w połowie lat 80. Unix miał świetne narzędzia — sh, grep, sed, awk, potoki i filtry. Ale prawdziwe zadania rzadko mieściły się w jednym uporządkowanym poleceniu. Zaczynałeś od pipeline'u, potem odkrywałeś, że potrzebujesz małej maszyny stanów, lepszego operowania na stringach, wielokrotnego wykorzystania skryptu i sposobu, by to wszystko było czytelne na tyle, żebyś mógł to poprawić za tydzień.

Motywacja Larry’ego była praktyczna: zmniejszyć tarcie pracy „łączeniowej” — niewdzięcznej, ale ciągłej czynności łączenia narzędzi i transformowania tekstu, aż wyjdzie coś użytecznego.

Pierwotnym celem Perla nie było zastąpienie narzędzi Uniksa — chodziło o ułatwienie ich orkiestracji, gdy one-liner zamieniał się w mini program. Zamiast skakać między wieloma narzędziami (każde z własnymi regułami cytowania i przypadkami brzegowymi), Perl dawał jedno miejsce do:

To jest podejście „taśmy klejącej”: nie perfekcja, ale szybkie, trwałe rozwiązanie, które trzyma wszystko razem.

Kultura Perla przyjęła wartości zgodne z codzienną rzeczywistością: pragmatyzm ponad czystość, ekspresywność ponad ceremoniał i słynne „Jest więcej niż jeden sposób, by to zrobić.” To nie były tylko hasła — dawały permisję, by rozwiązać problem stojący przed tobą w najmniej bolesny sposób.

Wczesna popularność Perla może dziś brzmieć tajemniczo. Nie była. Po prostu odpowiadał potrzebom zespołów tamtego czasu: język, który znosił nieczyste wejścia, integrował się z istniejącymi systemami i pozwalał zmęczonemu człowiekowi wysłać działający skrypt zanim zadzwoni kolejny pager.

Wczesne strony nie były napędzane przez frameworki i usługi zarządzane. Często to był serwer WWW + katalog z CGI-skriptami, kilka plików płaskich i może prosty database, który jeszcze nie był „centralny”.

Operacje były ciężkie w logach: logi dostępu, logi błędów, foldery uploadów, skrzynki mailowe przyjmujące zgłoszenia z formularzy i pliki tekstowe, które po cichu stały się bazami danych. Gdy coś się psuło, często diagnozowałeś to przez grepowanie wczorajszych logów i poprawianie skryptu.

Automatyzacja to po prostu: powtarzalne zadanie, które uruchamia się bez ręcznej interwencji.

Zadanie mogło być wyzwalane przez żądanie webowe (ktoś wysłał formularz, kliknął „szukaj”, pobrał raport) albo przez zaplanowane zadanie (cron uruchamia co godzinę rotację logów, przebudowę stron, wysłanie podsumowań).

Nawet małe strony musiały:

Ręczne robienie tego nie tylko marnowało czas — wprowadzało błędy i opóźnienia.

Perl świetnie wpasowywał się między istniejące elementy:

grep, sed, awk, sort) świetne do pojedynczych krokówPerl mógł odczytać żądanie, wykonać polecenia systemowe, przekształcić nieporządny tekst i zapisać HTML lub zaktualizować plik — wszystko w jednym skrypcie. Ta rola „języka-lacza” uczyniła wczesną automatyzację webową praktyczną: łączył części, które same w sobie były użyteczne, ale niewygodne do bezpiecznego i powtarzalnego łańcuchowania.

Perl zdobył reputację „taśmy klejącej”, bo wygodnie mieścił się między klasycznymi narzędziami CLI Uniksa a nowym światem skryptów webowych. Jeśli twoje dane zaczynały się od logów, maili, eksportów CSV lub fragmentów HTML, Perl mógł je złapać, przekształcić i przekazać dalej — nie zmuszając do przejścia na zupełnie nowe środowisko.

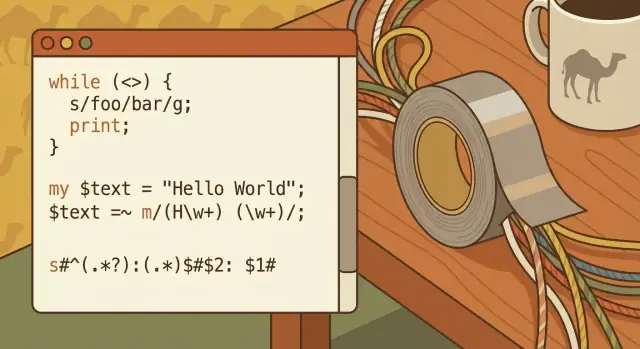

Od razu po wyjęciu z pudełka Perl sprawiał, że manipulacja tekstem była wyjątkowo bezpośrednia:

split, join, replace) odpowiadające realnym zadaniom czyszczeniaTo połączenie oznaczało, że nie potrzebujesz długiego łańcucha narzędzi do codziennego parsowania i edycji.

Unix zachęca do małych, skoncentrowanych programów łączonych ze sobą. Perl mógł być jednym z tych elementów: czytaj ze standardowego wejścia, przetwarzaj tekst i drukuj wynik dla następnego narzędzia w łańcuchu.

Popularny model mentalny to:

read → transform → write

Na przykład: czytaj logi serwera, ujednolić format daty, usunąć szum, a potem zapisać oczyszczony plik — ewentualnie przekazując dalej do sort, uniq lub grep. Perl nie zastępował narzędzi Uniksa; scalał je, gdy kombinacja awk + sed + shell zaczynała być niewygodna.

To samo podejście „skrypt-przed wszystkim” przeniosło się do wczesnego web developmentu. Skrypt Perl mógł przyjmować dane z formularza, przetwarzać je jak każdy inny strumień tekstowy i wypisywać HTML — czyniąc go praktycznym pomostem między narzędziami systemowymi a stronami WWW.

Ponieważ Perl działał na wielu systemach podobnych do Uniksa, zespoły często mogły przenieść ten sam skrypt między maszynami z minimalnymi zmianami — cenne, gdy wdrożenia były proste, ręczne i częste.

Wyrażenia regularne (regex) to sposób opisywania wzorców tekstowych — coś jak „znajdź i zamień”, ale ze regułami zamiast dokładnych słów. Zamiast szukać dosłownego [email protected], regex pozwala powiedzieć „znajdź cokolwiek, co wygląda jak adres e-mail”. Ta jedna zmiana — z dopasowania dokładnego na dopasowanie wzorca — umożliwiła wiele ówczesnej automatyzacji.

Pomyśl o regexie jak o mini-języku do odpowiadania na pytania typu:

Jeśli kiedykolwiek wklejałeś tekst do arkusza i chciałeś, żeby magią rozdzielił się na kolumny — chcesz regex.

Wczesne skrypty webowe żyły z nieporządnych wejść: pola formularzy wpisywanych przez ludzi, logi serwerów i pliki złożone z różnych systemów. Regex umożliwiał szybkie wykonanie trzech wartościowych zadań:

Walidacja wejść (np. „to wygląda jak URL”, „to wygląda jak data”).

Wyodrębnianie pól (np. wyciągnięcie kodu statusu i ścieżki żądania z linii logu).

Przepisywanie treści (np. ujednolicenie numerów telefonów, zamiana starych linków, sanitacja danych użytkownika przed zapisem).

Wsparcie regex w Perlu nie tylko istniało — było zaprojektowane do ciągłego użycia. To idealnie pasowało do nastawienia „taśmy klejącej”: weź niespójny tekst, zastosuj kilka ukierunkowanych reguł i otrzymaj coś na tyle niezawodnego, że można to wysłać w produkcję.

Regex sprawdza się przy „prawie ustrukturyzowanym” tekście, z którym ludzie mają do czynienia na co dzień:

12/26/25 na 2025-12-26 albo rozpoznawanie różnych formatów.Regex jest potężny, ale może stać się nieczytelny. Krótki, sprytny wzorzec może być trudny do przeglądania, debugowania i łatwy do złamania, gdy format wejścia się zmieni.

Podejście utrzymywalne to trzymać wzorce małe, dodawać komentarze (gdzie język pozwala) i woleć dwa jasne kroki zamiast jednego „geniuszowego” wyrażenia, jeśli ktoś inny będzie musiał to poprawić za miesiąc.

One-linery Perla to w istocie maleńkie skrypty: krótkie, jednofunkcyjne polecenia, które możesz uruchomić bezpośrednio w terminalu, żeby przekształcić tekst. Sprawdzą się, gdy potrzebujesz szybkiego oczyszczenia, jednorazowej migracji lub szybkiego sprawdzenia przed pisaniem pełnego programu.

One-liner zwykle czyta ze standardowego wejścia, wprowadza zmianę i drukuje wynik. Na przykład usuwanie pustych linii z pliku:

perl -ne 'print if /\S/' input.txt > output.txt

Albo wyciąganie konkretnych „kolumn” (pól) z tekstu rozdzielonego spacjami:

perl -lane 'print "$F[0]\t$F[2]"' data.txt

A do masowego zmieniania nazw plików Perl może kierować operacjami na plikach z większą kontrolą niż podstawowe narzędzie rename:

perl -e 'for (@ARGV){(my $n=$_)=~s/\s+/_/g; rename $_,$n}' *

(Ten ostatni zamienia spacje na podkreślenia.)

One-linery nadają się, gdy:

Napisz prawdziwy skrypt, gdy:

„Szybko” nie powinno znaczyć „nieśledzalne”. Zapisz linię z historii shellem (lub wklej ją do pliku z notatkami w repozytorium), dołącz przykład przed/po i zanotuj, co i dlaczego zmieniłeś.

Jeśli uruchamiasz ten sam one-liner dwa razy, to sygnał, by opakować go w mały skrypt z nazwą pliku, komentarzami i przewidywalną ścieżką wejścia/wyjścia.

CPAN (Comprehensive Perl Archive Network) to w prostych słowach wspólna półka bibliotek dla Perla: publiczna kolekcja modułów, które każdy może pobrać i użyć.

Zamiast pisać każdą funkcję od zera, małe zespoły mogły sięgnąć po sprawdzony moduł i skupić się na właściwym problemie — wysyłając skrypt, który działał dziś.

Wiele codziennych zadań webowych stało się w zasięgu jednego developera, bo CPAN oferował gotowe elementy, które inaczej zajęłyby dni lub tygodnie. Przykłady:

To miało znaczenie, bo wczesna automatyzacja webowa często była „jeszcze jednym skryptem” dodanym do już zapracowanego systemu. CPAN pozwalał złożyć ten skrypt szybko — i często bezpieczniej — opierając się na kodzie, który już działał w warunkach produkcyjnych.

Kompromis jest realny: zależności to forma zobowiązania.

Dodanie modułów oszczędza czas teraz, ale oznacza konieczność myślenia o kompatybilności wersji, poprawkach bezpieczeństwa i co się stanie, gdy moduł przestanie być utrzymywany. Szybki zysk dziś może stać się zagmatwaną aktualizacją jutro.

Przed poleganiem na module z CPAN, wol preferować te, które są jasno utrzymywane:

Gdy CPAN jest używany rozważnie, jest jedną z najlepszych manifestacji podejścia „taśmy klejącej”: użyj tego, co działa, ruszaj dalej i nie buduj infrastruktury, której nie potrzebujesz.

CGI (Common Gateway Interface) to „po prostu uruchom program” faza internetu. Żądanie trafiało do serwera, serwer uruchamiał twój skrypt Perl, skrypt czytał wejścia (często z zmiennych środowiskowych i STDIN), a potem wypisywał odpowiedź — zwykle nagłówek HTTP i kawałek HTML.

Najprościej skrypt:

name=Sam&age=42)Content-Type: text/html) i potem HTMLTaki model pozwalał szybko wysłać coś użytecznego. Równie szybko można było wysłać coś ryzykownego.

Perl CGI stał się skrótem do praktycznej automatyzacji webowej:

To były często wygrane dla małego zespołu: jeden skrypt, jeden URL, natychmiastowa wartość.

Ponieważ CGI skrypty wykonywały się przy każdym żądaniu, małe błędy się mnożyły:

Szybkość to zaleta, ale tylko z granicami. Nawet szybkie skrypty potrzebują jasnej walidacji, ostrożnego cytowania i przewidywalnych reguł wyjścia — nawyków, które opłacają się zarówno w małym narzędziu administracyjnym, jak i w nowoczesnym endpointzie webowym.

Perl zyskał reputację trudnego do czytania, bo ułatwiał sprytne rozwiązania. Gęsta, pełna interpunkcji składnia, dużo zachowania zależnego od kontekstu i kultura „więcej niż jeden sposób” zachęcały do krótkiego, imponującego kodu. To świetne na szybką poprawkę o 2 w nocy — ale po sześciu miesiącach nawet autor może nie pamiętać, co właściwie robił one-liner.

Problem utrzymaniowy nie polega na tym, że Perl jest wyjątkowo nieczytelny — tylko że Perl pozwala skompresować intencję aż do jej zniknięcia. Częste pułapki to zwarte regexy bez komentarzy, duże użycie zmiennych implicytnych jak $_ i sprytne triki (efekty uboczne, zagnieżdżone operatory warunkowe, magiczne wartości domyślne), które oszczędzają linie, ale kosztują zrozumienie.

Kilka nawyków znacznie poprawi czytelność bez spowalniania pracy:

Społeczność Perla normalizowała proste zabezpieczenia, które później przyjęły inne języki: włącz use strict; i use warnings;, pisz podstawowe testy (chociaż kilka sanity-checków) i dokumentuj założenia komentarzami lub POD.

Te praktyki nie robią kodu „enterprise” — czynią go przetrwalnym.

Szersza lekcja dotyczy każdego języka: pisz tak, by przyszłe ja i współpracownicy mogli to bezpiecznie zmieniać. Najszybszy skrypt to ten, który da się bezpiecznie zmodyfikować, gdy wymagania się zmienią.

Praca z tekstem nie stała się czystsza — po prostu przesunęła się. Możesz nie utrzymywać już skryptów CGI, ale nadal walczysz z eksportami CSV, webhookami SaaS, plikami logów i „tymczasowymi” feedami integracyjnymi, które stają się stałe. Te same praktyczne umiejętności, które czyniły Perla użytecznym, nadal oszczędzają czas (i zapobiegają cichym korupcjom danych).

Większość problemów to nie „trudne parsowanie”, tylko niespójne wejście:

1,234 vs 1.234, daty 03/04/05, nazwy miesięcy w różnych językach.Traktuj każde wejście jak nieufne, nawet gdy pochodzi z „naszego systemu”. Normalizuj wcześnie: wybierz kodowanie (zwykle UTF-8), ujednolić końcówki linii, przytnij oczywisty szum i skonwertuj do spójnego schematu.

Waliduj założenia jawnie: „ten plik ma 7 kolumn”, „ID są numeryczne”, „timestampy są w ISO-8601”. Gdy coś się zepsuje, zakończ wyraźnie i zapisz to, co zobaczyłeś (przykładowy wiersz, numer linii, plik źródłowy).

Gdzie to możliwe, wolisz jasne formaty i prawdziwe parsery zamiast sprytnych splitów. Jeśli masz JSON — parsuj JSON. Jeśli masz CSV — użyj parsera CSV, który rozumie cytowania. Zgadywanie działa do momentu, gdy w nazwisku klienta pojawi się przecinek.

Te umiejętności przydają się w codziennych zadaniach: filtrowaniu logów aplikacji podczas incydentu, czyszczeniu eksportów finansowych, przekształcaniu importów CRM, łączeniu integracji API i jednorazowych migracjach danych, gdzie „prawie dobrze” nadal oznacza „źle”.

Reputacja Perla jako „taśmy klejącej” nie wynikała z bycia niechlujnym — lecz z bycia użytecznym. To dziedzictwo pojawia się za każdym razem, gdy zespół potrzebuje małego skryptu do pogodzenia eksportów, ujednolicenia logów lub przekształcenia stosu półstrukturalnego tekstu w coś, co arkusz lub baza potrafi przetworzyć.

Dziś często domyślnie wybiera się Pythona, Ruby lub JavaScript (Node.js). Ich role się pokrywają: szybka automatyzacja, integracja z innymi systemami i kod-lączenia między narzędziami. Klasyczne zalety Perla to bezpośredni dostęp do systemu operacyjnego, ekspresywne przetwarzanie tekstu i kultura „po prostu zrób to”. Python stawia na czytelność i szeroką bibliotekę standardową; Ruby na ergonomię dewelopera i konwencje webowe; JavaScript na wszechobecność i łatwe wdrożenie tam, gdzie działa Node.

Wiele zadań dziś kształtuje użycie frameworków, stabilnych API, chmurowych usług i lepszego narzędziownia. Zadania, które kiedyś wymagały własnych skryptów, mają teraz zarządzane usługi, hostowane kolejki i gotowe konektory.

Wdrażanie też wygląda inaczej: kontenery, CI i przypinanie zależności są oczekiwane, nie opcjonalne.

Rzeczywisty tekst nadal bywa brudny. Logi lubią zaskakiwać, eksporty mają kreatywne formatowanie, a dane wciąż trzeba ostrożnie przekształcić, by były wiarygodne.

To trwała lekcja Perla: 80% automatyzacji to parsowanie, czyszczenie, walidacja i produkcja przewidywalnego wyjścia.

Najlepszy wybór to zwykle narzędzie, które twój zespół potrafi utrzymać: znajomość języka, zdrowy ekosystem i realne ograniczenia wdrożeniowe (co jest zainstalowane, co bezpieczeństwo dopuszcza, co ops może obsługiwać). Dziedzictwo Perla to nie „zawsze wybieraj Perla” — to „wybierz narzędzie, które pasuje do bałaganu, jaki naprawdę masz”.

Warto też zauważyć, że instynkt „taśmy klejącej” pojawia się w nowoczesnych workflowach wspomaganych AI. Na przykład platforma vibe-codingowa jak Koder.ai może być użyteczna, gdy potrzebujesz szybkiego narzędzia wewnętrznego (np. przeglądarka logów, normalizator CSV, małe UI admina) i wolisz iterować przez chat niż ręcznie budować cały szkielet. Ta sama ostrożność obowiązuje: wysyłaj szybko, ale zostaw wynik czytelnym, testowalnym i łatwym do cofnięcia, jeśli tymczasowa poprawka stanie się kluczową częścią systemu.

To pragmatyczne podejście: użyj najmniejszej skutecznej zmiany, która szybko rozwiąże rzeczywisty problem — zwłaszcza przy nieczystych wejściach i niekompletnych specyfikacjach.

To nie jest wymówka do bycia niedbałym. Część „taśmy klejącej” polega na doprowadzeniu do działającego rezultatu, a następnie dodaniu tylko tyle zabezpieczeń (testy, kopie zapasowe, notatki), by poprawka nie stała się pułapką później.

Stosuj regułę „jeszcze raz”: jeśli wykonujesz tę samą ręczną poprawkę dwa razy, zautomatyzuj ją.

Dobre kandydatury to:

Jeśli zadanie wpływa na dane produkcyjne, dodaj zabezpieczenia (suchy przebieg, kopie zapasowe, walidacja) przed uruchomieniem.

Traktuj one-linery jak malutkie skrypty:

Jeśli polecenie się rozrasta, potrzebujesz obsługi błędów, lub będzie powtarzane — przenieś je do pełnego skryptu z argumentami i jasno określonym wejściem/wyjściem.

Regexy są najlepsze, gdy tekst jest „prawie ustrukturyzowany” (logi, e-maile, identyfikatory, niejednolite separatory) i musisz walidować, wyciągać lub przepisywać wzorce.

Aby zachować czytelność:

Szybka poprawka staje się „na stałe”, gdy jest używana wielokrotnie, zależna od niej są inne procesy lub jest wbudowana w workflow (cron, pipeline, dokumentacja).

Sygnalizatory, że trzeba ją wzmocnić:

Wtedy: dodaj walidację, logowanie, testy i przejrzyste README opisujące założenia.

CPAN może zaoszczędzić dni pracy, ale każda zależność to zobowiązanie.

Praktyczna lista kontrolna przy wyborze modułu:

Planuj wdrożenie: przypnij wersje, udokumentuj kroki instalacji i śledź aktualizacje bezpieczeństwa.

Najważniejsza lekcja z ery CGI: szybkość bez granic tworzy luki bezpieczeństwa.

Jeśli przyjmujesz dane od użytkowników lub systemów zewnętrznych:

Te nawyki działają tak samo w nowoczesnych skryptach, funkcjach serverless i endpointach webowych.

Typowe problemy to:

Normalizuj wcześnie (kodowanie, końcówki linii), waliduj założenia (liczba kolumn, pola obowiązkowe) i przerywaj z ostrym komunikatem podając przykładowy wadliwy wiersz/linijkę.

Zasada: jeśli to prawdziwy format, użyj prawdziwego parsera.

Regex i ad-hocowe splity są dobre do wyciągania wzorców i lekkiego czyszczenia — póki jakiś przypadek brzegowy (np. przecinek w nazwisku) nie zniszczy wyników.

Wybierz narzędzie, które twój zespół potrafi uruchomić i utrzymać w realnych warunkach:

Dziedzictwo Perla to nie „zawsze używaj Perla”, lecz zasada: wybierz narzędzie pasujące do bałaganu, który naprawdę masz, a nie do architektury, którą byś chciał mieć.