03 lis 2025·8 min

Leslie Lamport i systemy rozproszone: czas, porządek, poprawność

Poznaj kluczowe idee Lamporta w systemach rozproszonych — zegary logiczne, porządkowanie, konsensus i poprawność — i dlaczego wciąż kształtują nowoczesną infrastrukturę.

Dlaczego Lamport wciąż ma znaczenie dla współczesnych systemów rozproszonych

Leslie Lamport to jeden z tych nielicznych badaczy, których „teoretyczna” praca pojawia się za każdym razem, gdy wypuszczasz prawdziwy system. Jeśli kiedykolwiek obsługiwałeś klaster bazy danych, kolejkę wiadomości, silnik workflow albo cokolwiek, co ponawia żądania i przetrzymuje awarie, żyłeś w problemach, które Lamport pomógł nazwać i rozwiązać.

To, co sprawia, że jego pomysły trwale się utrzymują, to fakt, że nie są związane z konkretną technologią. Opisują niewygodne prawdy, które pojawiają się za każdym razem, gdy wiele maszyn próbuje działać jak jeden system: zegary się nie zgadzają, sieci opóźniają i gubią wiadomości, a awarie są normalne — nie wyjątkiem.

Trzy motywy, które będziemy stosować

Czas: W systemie rozproszonym pytanie „która jest godzina?” nie jest proste. Zegary fizyczne dryfują, a kolejność zdarzeń, jaką widzisz, może różnić się między maszynami.

Porządkowanie: Gdy nie możesz ufać jednemu zegarowi, potrzebujesz innych sposobów, by mówić, które zdarzenia były pierwsze — i kiedy musisz wymusić tę samą sekwencję dla wszystkich.

Poprawność: „Zwykle działa” to nie projekt. Lamport przesunął pole w stronę jasnych definicji (safety vs. liveness) i specyfikacji, które można przeanalizować, a nie tylko testować.

Czego się spodziewać (bez ciężkiej matematyki)

Skupimy się na koncepcjach i intuicji: problemach, minimalnych narzędziach do jasnego myślenia i tym, jak te narzędzia kształtują praktyczne projekty.

Mapa:

- Dlaczego brak wspólnego zegara oznacza brak jednej, globalnej historii zdarzeń

- Jak kauczalność ("happened-before") prowadzi do zegarów logicznych i znaczników Lamporta

- Kiedy porządek częściowy nie wystarcza i potrzebna jest jedna linia czasu

- Jak konsensus i Paxos wiążą się z ustalaniem porządku

- Dlaczego replikacja maszyny stanowej działa, gdy porządek jest wspólny

- Jak rozmawiać o poprawności w specyfikacjach — i jak narzędzia takie jak TLA+ pomagają

Problem zasadniczy: brak wspólnego zegara, brak jednej rzeczywistości

System jest „rozproszony”, gdy składa się z wielu maszyn, które koordynują się przez sieć, by wykonać jedno zadanie. Brzmi prosto, dopóki nie zaakceptujesz dwóch faktów: maszyny mogą zawodzić niezależnie (awarie częściowe), a sieć może opóźniać, gubić, dublować lub zmieniać kolejność wiadomości.

W jednym programie na jednym komputerze zazwyczaj możesz wskazać „co nastąpiło pierwsze”. W systemie rozproszonym różne maszyny mogą obserwować różne sekwencje zdarzeń — i obie obserwacje mogą być poprawne z ich lokalnego punktu widzenia.

Dlaczego nie można ufać zegarowi globalnemu

Kusi, by rozwiązać koordynację przez oznaczanie wszystkiego znacznikiem czasu. Ale nie ma jednego zegara, na którym można polegać między maszynami:

- Zegary sprzętowe każdego serwera driftują w innym tempie.

- Synchronizacja zegarów (np. NTP) jest najlepszym wysiłkiem, a nie gwarancją.

- Wirtualizacja, obciążenie CPU lub pauzy mogą sprawić, że czas skoczy lub zatrzyma się.

Dlatego „zdarzenie A miało miejsce o 10:01:05.123” na jednym hoście nie porówna się wiarygodnie z „10:01:05.120” na innym.

Jak opóźnienia mieszają rzeczywistość

Opóźnienia sieciowe mogą odwrócić, co myślisz, że widziałeś. Zapis wysłany pierwszy może dotrzeć jako drugi. Ponowienie (retry) może dotrzeć po oryginale. Dwa centra danych mogą przetworzyć „to samo” żądanie w odwrotnej kolejności.

To sprawia, że debugowanie jest wyjątkowo mylące: logi z różnych maszyn mogą się nie zgadzać, a „posortowane według znacznika czasu” mogą tworzyć opowieść, która nigdy się nie wydarzyła.

Rzeczywiste konsekwencje

Gdy zakładasz jedną linię czasu, której nie ma, dostajesz konkretne awarie:

- Podwójne przetworzenie (np. dwukrotnie obciążona płatność po ponowieniach)

- Niespójności (dwaj użytkownicy jednocześnie „sukcesywnie” ubiegają się o ostatni przedmiot)

- Pozorne utraty danych (późniejsze przybywające uaktualnienie nadpisuje nowsze)

Kluczowa intuicja Lamporta zaczyna się tutaj: jeśli nie możesz dzielić czasu, musisz rozumować o porządku inaczej.

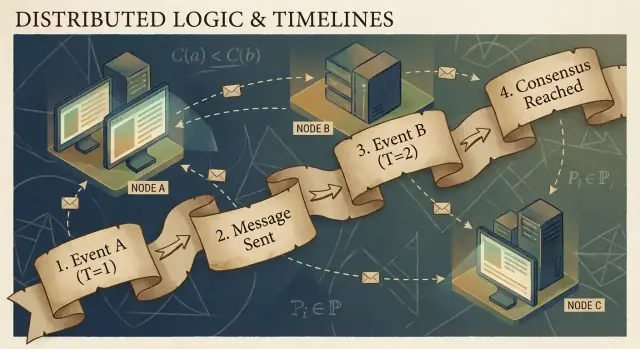

Kausalność i relacja happened-before

Programy rozproszone składają się ze zdarzeń: czegoś, co dzieje się na danym węźle (procesie, serwerze lub wątku). Przykłady: „odebrał żądanie”, „zapisał wiersz”, „wysłał wiadomość”. Wiadomość łączy węzły: jedno zdarzenie to wysłanie, drugie to odebranie.

Kluczowa obserwacja Lamporta jest taka, że w systemie bez niezawodnego wspólnego zegara najbardziej wiarygodną rzeczą, którą możesz śledzić, jest kausalność — które zdarzenia mogły wpłynąć na które inne.

Relacja happened-before (→)

Lamport zdefiniował prostą regułę nazwaną happened-before, zapisywaną jako A → B (zdarzenie A miało miejsce przed zdarzeniem B):

- Kolejność w tym samym procesie: Jeśli A i B występują w tym samym procesie/maszynie, a w tym procesie A występuje przed B, to A → B.

- Kolejność wiadomości: Jeśli A to „wysłanie wiadomości m”, a B to „odebranie wiadomości m”, to A → B.

- Przechodniość: Jeśli A → B i B → C, to A → C.

Ta relacja daje porządek częściowy: mówi, które pary są uporządkowane, ale nie wszystkie.

Konkretny przykład: użytkownik → żądanie → DB → cache

Użytkownik klika „Kup”. To kliknięcie wywołuje żądanie do serwera API (zdarzenie A). Serwer zapisuje wiersz zamówienia w bazie (zdarzenie B). Po zakończeniu zapisu serwer publikuje komunikat „order created” (zdarzenie C), a usługa cache odbiera go i aktualizuje wpis (zdarzenie D).

Tu mamy A → B → C → D. Nawet jeśli zegary się nie zgadzają, struktura wiadomości i programu tworzy rzeczywiste powiązania przyczynowo-skutkowe.

Co naprawdę oznacza „równoległe” (concurrent)

Dwa zdarzenia są równoległe, gdy żadne nie spowodowało drugiego: nie (A → B) i nie (B → A). Równoległość nie znaczy „w tym samym czasie” — znaczy „nie istnieje ścieżka przyczynowa między nimi”. Dlatego dwie usługi mogą każda twierdzić, że „działały pierwsze”, i obie mogą być poprawne, chyba że dodasz regułę porządkowania.

Zegary logiczne: znaczniki Lamporta prostym językiem

Jeśli próbowałeś kiedyś odtworzyć „co było pierwsze” między wieloma maszynami, natrafiłeś na podstawowy problem: komputery nie dzielą perfekcyjnie zsynchronizowanego zegara. Sztuczka Lamporta polega na zaprzestaniu gonitwy za idealnym czasem i zamiast tego śledzeniu porządku.

Pomysł: licznik dołączony do każdego zdarzenia

Znacznik Lamporta to po prostu numer dołączony do każdego znaczącego zdarzenia w procesie (instancji usługi, węzła, wątku — co wybierzesz). Myśl o nim jako o „liczniku zdarzeń”, który daje spójny sposób powiedzenia „to zdarzenie było przed tamtym”, nawet gdy zegary ścienne są niepewne.

Dwie reguły (naprawdę są takie proste)

-

Zwiększ lokalnie: zanim zarejestrujesz zdarzenie (np. „zapis do DB”, „wysłanie żądania”, „dopisek do logu”), zwiększ swój lokalny licznik.

-

Przy odbiorze, weź max + 1: kiedy odbierasz wiadomość zawierającą znacznik nadawcy, ustaw swój licznik na:

max(local_counter, received_counter) + 1

Następnie oznacz zdarzenie odbioru tą wartością.

Te reguły gwarantują, że znaczniki respektują kausalność: jeśli zdarzenie A mogło wpłynąć na zdarzenie B (bo informacja przepłynęła przez wiadomości), to znacznik A będzie mniejszy niż znacznik B.

Co znaczniki Lamporta mogą — i czego nie mogą — powiedzieć

Mogą powiedzieć o porządku przyczynowym:

- Jeśli

TS(A) < TS(B), A mogło mieć miejsce przed B. - Jeśli A spowodowało B (bezpośrednio lub pośrednio), to koniecznie

TS(A) < TS(B).

Nie mogą powiedzieć o czasie rzeczywistym:

- Niższy znacznik nie znaczy „wcześniej w sekundach”.

- Dwa zdarzenia mogą być równoległe i mimo to mieć różne znaczniki z powodu wzorców wiadomości.

Zatem znaczniki Lamporta są świetne do porządkowania, nie do mierzenia latencji czy odpowiadania na pytanie „która była godzina?”.

Praktyczny przykład: porządkowanie wpisów logów między usługami

Wyobraź sobie, że Usługa A wywołuje Usługę B i obie zapisują logi audytu. Chcesz zunifikowany widok logów, który zachowa przyczynowość.

- Usługa A zwiększa licznik, loguje „rozpoczęcie płatności”, wysyła żądanie do B ze znacznikiem 42.

- Usługa B odbiera żądanie z 42, ustawia licznik na

max(local, 42) + 1, powiedzmy 43, i loguje „zweryfikowano kartę”. - B odpowiada ze 44; A odbiera, aktualizuje do 45 i loguje „płatność zakończona”.

Gdy agregujesz logi z obu usług, sortowanie po (lamport_timestamp, service_id) daje stabilną, wytłumaczalną oś czasu, która odpowiada rzeczywistemu łańcuchowi wpływów — nawet jeśli zegary ścienne dryfowały lub sieć opóźniła wiadomości.

Od porządku częściowego do porządku całkowitego: kiedy potrzebujesz jednej linii czasu

Kausalność daje Ci porządek częściowy: niektóre zdarzenia są wyraźnie „przed” innymi (bo łączy je wiadomość lub zależność), ale wiele zdarzeń jest po prostu równoległych. To nie błąd — to naturalny kształt rozproszonej rzeczywistości.

Porządek częściowy: wystarczający dla wielu pytań

Jeżeli debugujesz „co mogło na to wpłynąć?” albo wymuszasz reguły typu „odpowiedź musi następować po żądaniu”, porządek częściowy jest tym, czego potrzebujesz. Wystarczy respektować krawędzie happened-before; wszystko inne traktujesz jako niezależne.

Porządek całkowity: wymagany, gdy system musi wybrać jedną historię

Niektóre systemy nie mogą funkcjonować, jeśli „oba porządki są OK”. Potrzebują jednej sekwencji operacji, szczególnie dla:

- Zapisów do współdzielonego obiektu („ustaw saldo”, „aktualizuj profil”, „dopisz do logu”)

- Poleceń, które muszą być stosowane identycznie wszędzie (replikacja maszyny stanowej)

- Rozwiązywania konfliktów, gdzie „ostatni zapis wygrywa” musi znaczyć to samo dla każdego węzła

Bez porządku całkowitego dwie repliki mogą być „lokalnie poprawne”, a mimo to rozbiec się globalnie: jedna zastosuje A potem B, inna B potem A i dostaniesz różne wyniki.

Jak uzyskać jedną linię czasu?

Wprowadzasz mechanizm, który tworzy porządek:

- Sequencer/leader przypisujący monotonicznie rosnącą pozycję każdemu poleceniu.

- Albo konsensus (np. podejścia w stylu Paxos), aby klaster zgodził się na kolejny wpis w logu nawet przy opóźnieniach i awariach.

Kompromisy, których nie da się uniknąć

Porządek całkowity jest potężny, ale kosztuje:

- Latencja: możesz czekać na koordynację przed zatwierdzeniem.

- Przepustowość: pojedynczy uporządkowany log może stać się wąskim gardłem.

- Dostępność przy awariach: jeśli nie dojdziesz do wystarczającej liczby węzłów do porozumienia, postęp może stanąć, by chronić poprawność.

Wybór projektowy jest prosty do sformułowania: gdy poprawność wymaga jednej wspólnej narracji, płacisz kosztem koordynacji, by ją uzyskać.

Konsensus: uzgadnianie mimo opóźnień i awarii

Dodaj panel kontrolny

Stwórz klienta administracyjnego we Flutterze do przeglądu logów, trace'ów i stanu replik z dowolnego miejsca.

Konsensus to problem polegający na doprowadzeniu wielu maszyn do zgody co do jednej decyzji — jednej wartości do zatwierdzenia, jednego lidera do śledzenia, jednej konfiguracji do aktywowania — mimo że każda maszyna widzi tylko swoje lokalne zdarzenia i wiadomości, które akurat do niej dotarły.

Brzmi prosto, aż przypomnisz sobie, co w systemie rozproszonym jest dozwolone: wiadomości mogą być opóźnione, zduplikowane, zmieniać kolejność lub zaginąć; maszyny mogą się zawieszać i restartować; rzadko otrzymujesz jasny sygnał, że „ten węzeł jest na pewno martwy”. Konsensus dotyczy uczynienia zgody bezpieczną w tych warunkach.

Dlaczego zgoda jest trudna

Jeśli dwa węzły tymczasowo nie mogą się porozumieć (partycja sieci), każda strona może próbować „iść naprzód” sama. Jeśli obie decyzje są różne, możesz skończyć z zachowaniem typu split-brain: dwoma liderami, dwiema różnymi konfiguracjami lub dwoma konkurencyjnymi historiami.

Nawet bez partycji samo opóźnienie powoduje problemy. Zanim węzeł usłyszy o propozycji, inne węzły mogły iść dalej. Bez wspólnego zegara nie możesz polegać na „propozycja A miała miejsce przed propozycją B” tylko dlatego, że A ma wcześniejszy znacznik czasowy — czas fizyczny nie jest tu autorytetem.

Gdzie spotykasz konsensus w systemach produkcyjnych

Może nie nazywasz tego „konsensusem” na co dzień, ale pojawia się w typowych zadaniach infrastrukturalnych:

- Wybór lidera (kto teraz dowodzi?)

- Replikowane logi (jaki jest następny wpis w wspólnej historii?)

- Zmiany konfiguracji (który zestaw węzłów może głosować/zatwierdzać?)

W każdym z tych przypadków system potrzebuje pojedynczego wyniku, do którego wszyscy mogą dojść, lub przynajmniej reguły, która zapobiega uznaniu sprzecznych wyników za ważne.

Paxos jako odpowiedź Lamporta

Paxos Lamporta to podstawowe rozwiązanie problemu „bezpiecznej zgody”. Kluczowa idea nie jest magicznym timeoutem ani idealnym liderem — to zestaw reguł, które gwarantują, że tylko jedna wartość może zostać wybrana, nawet gdy wiadomości są opóźnione, duplikowane lub gdy węzły chwilowo zawodzą.

Paxos oddziela safety („nigdy nie wybrać dwóch różnych wartości”) od progress („w końcu wybrać coś”), co czyni go praktycznym wzorcem: możesz dopracowywać wydajność w warunkach realnych, zachowując rdzeń gwarancji.

Paxos, bez bólu: kluczowa intuicja bezpieczeństwa

Paxos ma reputację nieczytelności, ale część tego wynika z faktu, że „Paxos” to nie jeden prosty algorytm, lecz rodzina wzorców blisko powiązanych, służących osiąganiu zgody, nawet gdy wiadomości są opóźnione, zduplikowane lub gdy maszyny chwilowo zawodzą.

Obsada: proposerzy, acceptorzy i quorum

Pomocny model mentalny rozdziela kto proponuje od kto zatwierdza.

- Proposerzy próbują przeforsować wartość (np. „następny wpis logu to X”).

- Acceptorzy głosują nad propozycjami.

- Quorum to „wystarczająco dużo acceptorów”, by robić postęp — zazwyczaj większość.

Jedna strukturalna myśl: dwie większości zawsze się pokrywają. W tym przecięciu mieszkają gwarancje bezpieczeństwa.

Cel bezpieczeństwa: nigdy nie zdecydować dwóch różnych wartości

Bezpieczeństwo Paxosa można łatwo opisać: gdy system zdecydował wartość, nie wolno mu zdecydować innej — zero split-brain.

Kluczowa intuicja polega na tym, że propozycje mają numery (pomyśl: identyfikatory tury). Acceptorzy obiecują ignorować propozycje o starszych numerach, gdy zobaczą nowszy. A kiedy proposer zaczyna z nowym numerem, najpierw pyta quorum, co już zaakceptowali.

Ponieważ quorumy się pokrywają, nowy proposer usłyszy od przynajmniej jednego acceptora o najbardziej niedawno zaakceptowanej wartości. Reguła brzmi: jeśli ktoś w quorum zaakceptował jakąś wartość, musisz zaproponować tę wartość (albo najnowszą spośród nich). To ograniczenie zapobiega wybraniu dwóch różnych wartości.

Z żywotnością, ogólnie

Żywotność oznacza, że system w końcu zdecyduje coś w rozsądnych warunkach (na przykład stabilny lider się pojawi, a sieć w końcu dostarczy wiadomości). Paxos nie obiecuje szybkości w chaosie; obiecuje poprawność i postęp, gdy sytuacja się uspokoi.

Replikacja maszyny stanowej: poprawność przez wspólny porządek

Zaprojektuj replikowany log

Zaprojektuj prototyp interfejsu API replikowanego logu z UI w React i backendem w Go + PostgreSQL.

Replikacja maszyny stanowej (SMR) to podstawowy wzorzec stojący za wieloma systemami o wysokiej dostępności: zamiast jednej maszyny podejmującej decyzje, uruchamiasz kilka replik, które wszystkie przetwarzają tę samą sekwencję poleceń.

Idea replikowanego logu

W centrum stoi replikowany log: uporządkowana lista poleceń typu „put key=K value=V” lub „transfer $10 z A do B”. Klienci nie wysyłają poleceń do każdej repliki i nie liczą na szczeście. Przesyłają polecenia do grupy, a system zgadza się na jeden porządek tych poleceń, potem każda replika stosuje je lokalnie.

Dlaczego porządek daje poprawność

Jeśli każda replika zaczyna od tego samego stanu początkowego i wykonuje te same polecenia w tej samej kolejności, skończą w tym samym stanie. To rdzenna intuicja bezpieczeństwa: nie próbujesz utrzymać maszyn „zsynchronizowanych” przez czas; robisz je identycznymi przez deterministykę i wspólny porządek.

Dlatego konsensus (np. protokoły w stylu Paxos/Raft) jest często łączony z SMR: konsensus decyduje następny wpis w logu, a SMR zamienia tę decyzję w spójny stan na replikach.

Gdzie to widzisz w praktyce

- Usługi koordynacyjne (np. do konfiguracji i wyboru lidera)

- Bazy danych z replikowanymi logami zapisu przed wykonaniem (write-ahead logs)

- Systemy wiadomości wymagające ścisłego porządku partycji

Praktyczne kwestie, których inżynierowie nie mogą ignorować

Log rośnie bez końca, jeśli go nie zarządzasz:

- Snapshoty: okresowo zapisuj bieżący stan, aby nowe węzły mogły nadrobić zaległości bez odtwarzania całej historii.

- Kompakcja logu: bezpiecznie usuwaj stare wpisy, gdy zostaną odzwierciedlone w snapshotcie i nie są już potrzebne.

- Zmiany członkostwa: dodawanie/usuwanie replik musi być uporządkowane, inaczej różne węzły mogą nie zgadzać się, kto należy do grupy, co prowadzi do split-brain.

SMR nie jest magią; to zdyscyplinowany sposób zamiany „zgody co do porządku” na „zgodę co do stanu”.

Poprawność: safety, liveness i pisanie jasnej specyfikacji

Systemy rozproszone zawodzą w dziwny sposób: wiadomości przychodzą późno, węzły restartują, zegary się nie zgadzają, sieci się dzielą. „Poprawność” to nie uczucie — to zestaw obietnic, które możesz precyzyjnie sformułować, a następnie sprawdzić we wszystkich sytuacjach, włącznie z awariami.

Safety vs. liveness (z konkretnymi przykładami)

Safety oznacza „nic złego się nie dzieje”. Przykład: w replikowanym key-value store nie mogą zostać zatwierdzone dwie różne wartości dla tego samego indeksu logu. Inny przykład: usługa blokad nie może przyznać tej samej blokady dwóm klientom jednocześnie.

Liveness oznacza „coś dobrego w końcu się zdarzy”. Przykład: jeśli większość replik jest dostępna i sieć w końcu dostarcza wiadomości, zapis w końcu się zakończy. Żądanie blokady w końcu otrzyma odpowiedź (nie będzie nieskończonego oczekiwania).

Safety dotyczy zapobiegania sprzecznościom; liveness — unikania trwałych zastoju.

Inwarianty: twoje niepodważalne warunki

Inwariant to warunek, który musi zawsze być spełniony w każdym osiągalnym stanie. Na przykład:

- „Każdy indeks logu ma co najwyżej jedną zatwierdzoną wartość.”

- „Numer termu lidera nigdy nie maleje.”

Jeśli inwariant może zostać złamany podczas awarii, timeoutu, ponowienia czy partycji, to nie był właściwie wymuszony.

Co znaczy „dowód” tutaj

Dowód to argument obejmujący wszystkie możliwe wykonania, nie tylko „normalną ścieżkę”. Rozważasz każdy przypadek: utrata wiadomości, dublowanie, zmiana kolejności; awarie i restarty węzłów; konkurencyjni liderzy; ponawiający się klienci.

Specyfikacje zapobiegają niespodziankom

Jasna specyfikacja definiuje stan, dozwolone akcje i wymagane własności. Zapobiega niejednoznacznościom typu „system powinien być spójny”, które łatwo zamieniają się w sprzeczne oczekiwania. Specyfikacje zmuszają do określenia, co się dzieje podczas partycji, co oznacza „commit” i na co klienci mogą liczyć — zanim produkcja nauczy cię tego brutalnie.

Od teorii do praktyki: modelowanie z TLA+

Jedna z najbardziej praktycznych lekcji Lamporta to pomysł, że protokół rozproszony warto zaprojektować na wyższym poziomie niż kod. Zanim zaczniesz martwić się wątkami, RPC i pętlami retry, możesz zapisać reguły systemu: jakie akcje są dozwolone, jaki stan może się zmieniać i co nigdy nie może się zdarzyć.

Do czego służy TLA+

TLA+ to język specyfikacji i zestaw narzędzi do model-checkingu do opisywania systemów współbieżnych i rozproszonych. Piszesz prosty, matematyczny model systemu — stany i przejścia — plus własności, na których ci zależy (np. „co najwyżej jeden lider” lub „zatwierdzony wpis nigdy nie znika”).

Następnie model checker eksploruje możliwe przeplatania, opóźnienia wiadomości i awarie, by znaleźć kontrprzykład: konkretną sekwencję kroków, która łamie twoją własność. Zamiast debatować o skrajnych przypadkach na spotkaniach, dostajesz wykonalny dowód.

Błąd, który model może wykryć

Weźmy krok „commit” w replikowanym logu. W kodzie łatwo przez przypadek pozwolić, by dwa różne węzły oznaczyły różne wpisy jako zatwierdzone pod tym samym indeksem przy rzadkim zbiegu okoliczności.

Model TLA+ może ujawnić ślad:

- Węzeł A zatwierdza wpis X na indeksie 10 po usłyszeniu od quorum.

- Węzeł B (z nieaktualnymi danymi) również formuje quorum i zatwierdza wpis Y na indeksie 10.

To duplikat commit — naruszenie bezpieczeństwa, które może pojawiać się raz na miesiąc w produkcji, ale w modelu wychodzi szybko przy wyczerpującym przeszukiwaniu. Podobne modele często wykrywają utracone aktualizacje, podwójne wykonania czy „potwierdzenie, ale brak trwałości”.

Kiedy warto modelować

TLA+ jest najbardziej wartościowe dla krytycznej logiki koordynacyjnej: wybór lidera, zmiany członkostwa, przepływy podobne do konsensusu i każdy protokół, gdzie porządek i obsługa awarii się przeplatają. Jeśli błąd mógłby uszkodzić dane lub wymagać ręcznej naprawy, mały model zwykle jest tańszy niż późniejsze debugowanie.

Jeśli budujesz wewnętrzne narzędzia wokół tych idei, praktyczny przebieg pracy to: napisz lekką specyfikację (nawet nieformalną), zaimplementuj system i generuj testy z invariants specyfikacji. Platformy takie jak Koder.ai mogą tu pomóc, przyspieszając pętlę buduj-testuj: możesz opisać zamierzone zachowanie porządkowania/konsensusu w prostym języku, iterować po szkicu usług (frontend React, backend Go z PostgreSQL, albo klient Flutter), i mieć „co nigdy nie powinno się zdarzyć” widoczne podczas wdrażania.

Praktyczne wnioski dla budowy i eksploatacji niezawodnych systemów

Eksperymentuj z konsensusem

Zaprojektuj usługę wyboru lidera i szybko testuj przypadki awarii ze snapshotami i rollbackiem.

Największy dar Lamporta dla praktyków to sposób myślenia: traktuj czas i porządek jako dane, które modelujesz, a nie założenia odziedziczone po zegarze ściennym. Ten sposób myślenia przekłada się na zbiór nawyków, które możesz zastosować od razu.

Przełóż teorię na codzienne praktyki inżynierskie

Jeśli wiadomości mogą być opóźnione, zduplikowane lub przychodzić w złej kolejności, zaprojektuj każdą interakcję tak, by była bezpieczna w tych warunkach.

- Idempotencja domyślnie: niech „zrób to jeszcze raz” będzie nieszkodliwe. Używaj kluczy idempotencji dla płatności, provisioningów i każdego zapisu, który możesz ponawiać.

- Ponawiania z deduplikacją: ponawiania są konieczne, ale bez deduplikacji stworzą podwójne zapisy. Śledź identyfikatory żądań i zapisuj markery „już przetworzone”.

- Dostawa co najmniej raz + efekty dokładnie raz: zaakceptuj, że sieć może dostarczyć dwukrotnie; upewnij się, że zmiany stanu nie będą wykonane dwukrotnie.

Ostrożnie z timeoutami i zegarami

Timeouty to nie prawda; to polityka. Timeout mówi tylko „nie usłyszałem w porę”, nie „druga strona nie zadziałała”. Dwa praktyczne wnioski:

- Nie traktuj timeoutu jako definitywnej awarii. Projektuj ścieżki kompensacji i pojednania.

- Unikaj używania lokalnego czasu zegara do porządkowania zdarzeń między węzłami. Używaj numerów sekwencyjnych, monotonicznych liczników lub jawnych metadanych przyczynowych (np. „to uaktualnienie zastępuje wersję X”).

Obserwowalność, która respektuje kausalność

Dobre narzędzia do debugowania kodują porządek, nie tylko znaczniki czasu.

- Trace ID wszędzie: propaguj identyfikator korelacji/trace przez każdy skok i linię logu.

- Wskazówki przyczynowe w logach: loguj identyfikatory wiadomości, identyfikatory rodzica żądania i „jaką ostatnią wersję uważałem za najnowszą” podczas podejmowania decyzji.

- Deterministyczne odtworzenia: rejestruj wejścia (polecenia), by móc odtworzyć zachowanie i potwierdzić, czy błąd zależy od czasu, czy od logiki.

Pytania projektowe przed wdrożeniem

Zanim dodasz funkcję rozproszoną, wymusz klarowność kilkoma pytaniami:

- Co się stanie, jeśli to samo żądanie zostanie przetworzone dwa razy?

- Jaki porządek naprawdę potrzebujemy (jeśli w ogóle) i gdzie jest on egzekwowany?

- Które awarie są „bezpieczne” (brak złego stanu) vs. „głośne” (widoczne dla użytkownika) vs. „ciche” (ukryte uszkodzenie)?

- Jaka jest ścieżka odtworzenia po częściowej awarii lub partycji sieci?

- Co będziemy logować, by odtworzyć historię happened-before w produkcji?

Te pytania nie wymagają doktoratu — tylko dyscypliny, by traktować porządek i poprawność jako pierwszorzędne wymagania produktowe.

Zakończenie i sugerowane następne kroki

Trwały dar Lamporta to sposób myślenia, gdy systemy nie dzielą zegara i domyślnie nie zgadzają się, „co się wydarzyło”. Zamiast gonić idealny czas, śledzisz kawalność (co mogło wpłynąć na co), reprezentujesz ją przez czas logiczny (znaczniki Lamporta) i — gdy produkt wymaga jednej historii — budujesz zgodę (konsensus), by każda replika zastosowała tę samą sekwencję decyzji.

Ten wątek prowadzi do praktycznego sposobu myślenia inżynierskiego:

Najpierw specyfikuj, potem buduj

Zapisz reguły: co nigdy nie może się zdarzyć (safety) i co w końcu musi się zdarzyć (liveness). Potem implementuj zgodnie ze specyfikacją i testuj system pod kątem opóźnień, partycji, ponowień, dublowania wiadomości i restartów węzłów. Wiele „tajemniczych awarii” to po prostu brakujące stwierdzenia typu „żądanie może być przetworzone dwukrotnie” albo „lider może się zmieniać w każdej chwili”.

Ucz się dalej, krok po kroku

Jeśli chcesz zgłębić temat bez ton formalizmu:

- Przeczytaj „Time, Clocks, and the Ordering of Events in a Distributed System” Lamporta, by przyswoić relację happened-before.

- Przejrzyj „Paxos Made Simple” dla intuicji bezpieczeństwa: gdy wartość zostanie wybrana, przyszły postęp nie może jej podważyć.

- Obejrzyj wprowadzenie do TLA+, a potem zamodeluj mały protokół (usługa blokad lub rejestr dwóch replik) i sprawdź go.

Wypróbuj jedno ćwiczenie praktyczne

Wybierz komponent, za który odpowiadasz, i napisz jednostronicowy „kontrakt awaryjny”: co zakładasz o sieci i pamięci, które operacje są idempotentne i jakie gwarancje porządkowe zapewniasz.

Jeśli chcesz uczynić to ćwiczenie bardziej namacalnym, zbuduj małą usługę „ordering demo”: API przyjmujące polecenia do dopisania do logu, worker stosujący je w tle oraz panel administracyjny pokazujący metadane przyczynowe i ponowienia. Robienie tego na Koder.ai może przyspieszyć iterację — zwłaszcza jeśli chcesz szybkie szkielety, hosting, snapshoty/rollback dla eksperymentów i eksport kodu źródłowego, gdy będziesz gotowy.

Dobrze wykonane, te pomysły redukują awarie, bo mniej zachowań pozostaje niewypowiedzianych. Upraszczają też rozumowanie: przestajesz kłócić się o czas i zaczynasz dowodzić, co porządek, zgoda i poprawność naprawdę znaczą dla twojego systemu.